Heim >Technologie-Peripheriegeräte >KI >Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

Alle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag

- 王林Original

- 2024-06-20 17:43:032660Durchsuche

Am frühen Morgen des 20. Juni, Pekinger Zeit, gab die CVPR 2024, die wichtigste internationale Computer-Vision-Konferenz in Seattle, offiziell die beste Arbeit und andere Auszeichnungen bekannt.

In diesem Jahr wurden insgesamt 10 Arbeiten ausgezeichnet, darunter 2 beste Arbeiten, 2 beste Studentenarbeiten, 2 Nominierungen für die beste Arbeit und 4 Nominierungen für die beste Studentenarbeit.

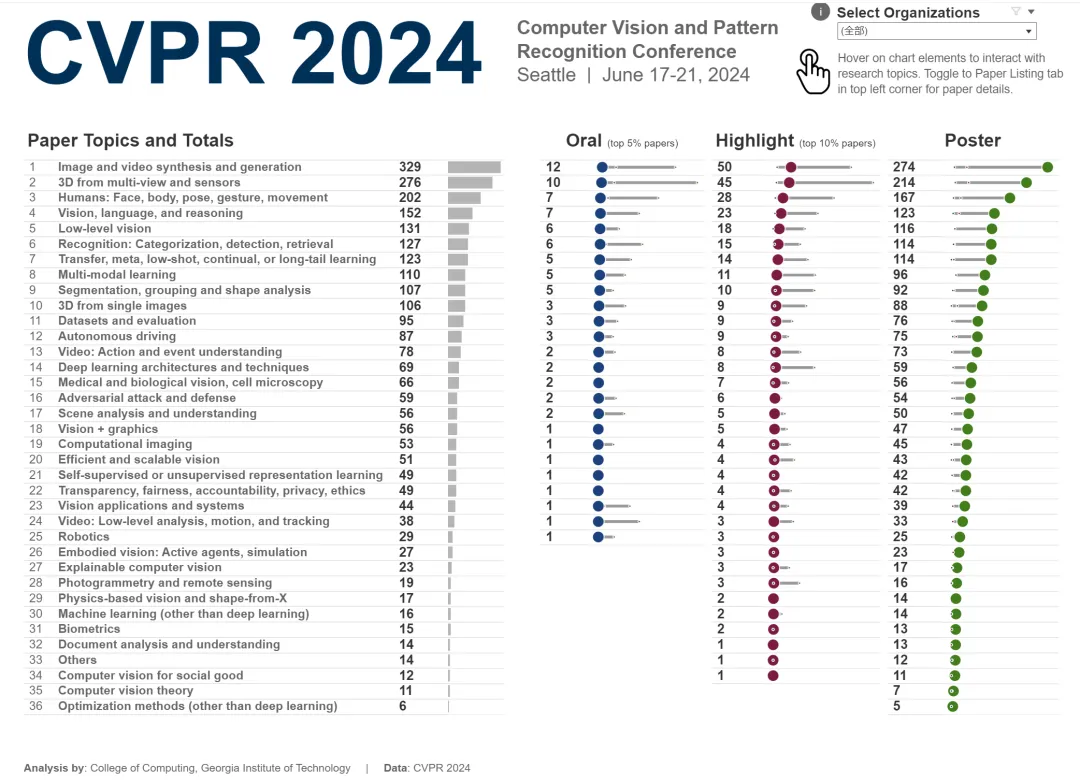

Die Top-Konferenz im Bereich Computer Vision (CV) ist CVPR, an der jedes Jahr zahlreiche Forschungseinrichtungen und Universitäten teilnehmen. Laut Statistik wurden in diesem Jahr insgesamt 11.532 Arbeiten eingereicht, von denen 2.719 angenommen wurden, was einer Annahmequote von 23,6 % entspricht.

Laut der statistischen Analyse der CVPR 2024-Daten des Georgia Institute of Technology befassen sich aus Sicht der Forschungsthemen die meisten Arbeiten mit dem Thema Bild- und Videosynthese und -generierung (Bild- und Videosynthese und -generierung), mit insgesamt 329 Artikel.

Die Gesamtteilnehmerzahl ist in diesem Jahr höher als in den Vorjahren und immer mehr Menschen entscheiden sich für die Offline-Teilnahme.

Bestes Paper

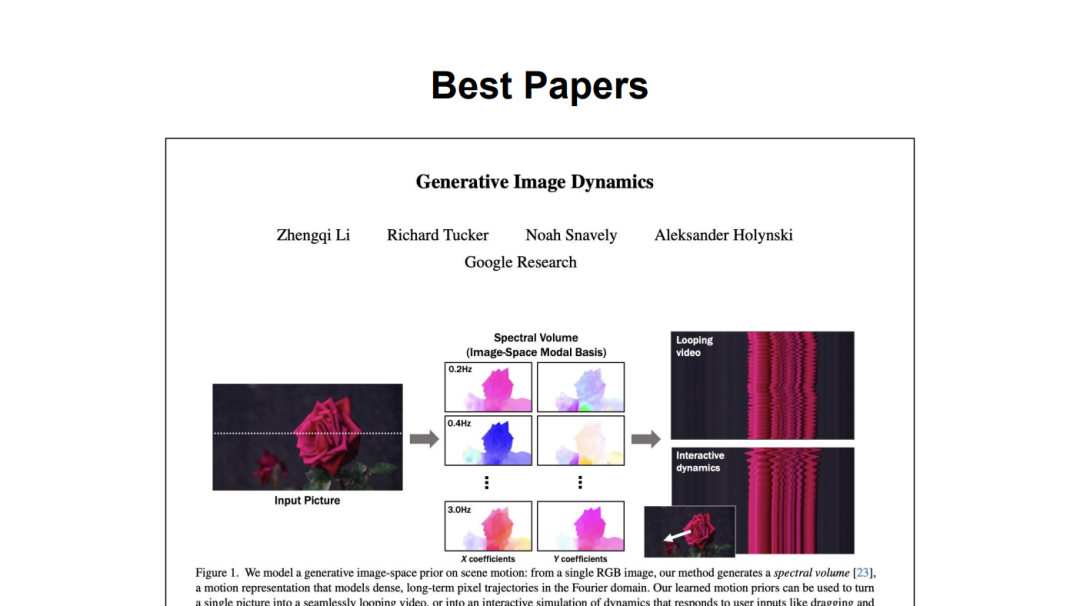

Paper 1: Generative Image Dynamics

Autoren: Zhengqi Li, Richard Tucker, Noah Snavely, Aleksander Holynski

-

Institution: Google Research

Papieradresse : https://arxiv.org/pdf/2309.07906

Zhengqi Li ist wissenschaftlicher Mitarbeiter bei Google DeepMind. Zuvor erhielt er seinen Doktortitel in Informatik von der Cornell University, wo er bei Professor Noah Snavely studierte. Seine Forschung hat mehrere Auszeichnungen erhalten, darunter das Google PhD Fellowship 2020, das Adobe Research Fellowship 2020, CVPR 2019 und CVPR 2023 Best Paper Honors sowie den ICCV 2023 Best Student Paper Award.

Abstract: Diese Studie schlägt eine Bild-Raum-Prioritätsmethode zur Modellierung von Szenenbewegungen vor. Der Prior wird aus einer Sammlung von Bewegungstrajektorien gelernt, die aus realen Videosequenzen extrahiert wurden und die natürliche Schwingungsdynamik von Objekten wie Bäumen, Kleidung usw. darstellen, die sich im Wind wiegen. Die Studie modelliert dichte Langzeitbewegungen im Fourier-Bereich als Spektralvolumen, das sich nach Ansicht des Teams gut für die Vorhersage mit Diffusionsmodellen eignet.

Anhand eines einzelnen Bildes verwendet das in dieser Studie trainierte Modell einen frequenzkoordinierten Diffusionsabtastprozess, um das Spektralvolumen vorherzusagen, das auch in eine Bewegungstextur umgewandelt werden kann, die sich über das gesamte Video erstreckt. Beschreibung Diese Studie kann die Animationsbewegung reduzieren (oben) oder zoomen (unten), indem die Amplitude der Bewegungstextur angepasst wird.

Aufsatz 2: Reichhaltiges menschliches Feedback für die Text-zu-Bild-Generierung

- Institution: Universität of California, San Diego Branch Campus, Google Research, University of Southern California, University of Cambridge, Brandeis University

- Papieradresse: https://arxiv.org/pdf/2312.10240

-

Vom Autor In der Spalte des Papiers können wir sehen, dass viele Chinesen an dieser Forschung teilgenommen haben. Darunter war Youwei Liang Doktorand am Department of Electrical and Computer Engineering der University of California, San Diego ein Bachelor-Student im Hauptfach Informations- und Informatik an der South China Agricultural University; Junfeng kommt von Google. Zuvor schloss er sein Studium an der Tsinghua University ab.

Abstrakt: In jüngster Zeit haben generative Text-zu-Bild-Modelle (T2I) erhebliche Fortschritte gemacht und sind in der Lage, aus Textbeschreibungen hochauflösende Bilder zu generieren. Allerdings leiden viele generierte Bilder immer noch unter Artefakten/Unzuverlässigkeit, sachlicher Inkonsistenz und schlechter Ästhetik.

Inspiriert durch den erfolgreichen Einsatz von Reinforcement Learning mit menschlichem Feedback (RLHF) für große Sprachmodelle bereichert diese Forschung das Feedbacksignal durch:

Markierung nicht vertrauenswürdiger oder falsch ausgerichteter Bildbereiche mit Text;

Paare Kommentieren von Situationen, in denen Wörter in der Textaufforderung sind verzerrt oder fehlen im Bild.

Diese Studie erstellte den 18K-generierten Bilddatensatz RichHF-18K, sammelte umfangreiches menschliches Feedback zu RichHF-18K und trainierte einen multimodalen Transformator, um Feedback automatisch vorherzusagen. Die Studie zeigt, dass vorhergesagtes menschliches Feedback zur Verbesserung der Bilderzeugung genutzt werden kann, beispielsweise durch die Auswahl hochwertiger Trainingsdaten zur Feinabstimmung und Verbesserung generativer Modelle oder durch die Erstellung von Masken zur Reparatur problematischer Bildbereiche. „Bester Paper Zweitplatzierter“ , Boxin Shi. Institutionen: Peking-Universität, Shanghai Jiao Tong-Universität usw

?? Fraser Universität, Toronto University

?? Fraser Universität, Toronto University Papieradresse: https://openaccess.thecvf.com/content/CVPR2024/papers/Charatan_pixelSplat_3D_Gaussian_Splats_from_Image_Pairs_for_Scalable_Generalizable_CVPR_2024_paper.pdf

Beste Studentenarbeit

- Aufsatz 1: BioCLIP : Ein Vision-Grundlagenmodell für den Baum des Lebens

- Autoren: Samuel Stevens, Jiaman Wu, Matthew J. Thompson, Elizabeth G. Campolongo, Chan Hee Song, David Edward Carlyn, Li Dong, Wasila M. Dahdul, Charles Stewart, Tanya Berger -Wolf, Wei-Lun Chao, Yu Su

Institution: Ohio State University, Microsoft Research, University of California, Irvine, Rensselaer Polytechnic Institute

Institution: Ohio State University, Microsoft Research, University of California, Irvine, Rensselaer Polytechnic InstitutePapieradresse: https://arxiv.org/pdf/2311.18803

- Abstrakt : Bilder der natürlichen Welt, die von Kameras von Drohnen bis hin zu persönlichen Mobiltelefonen gesammelt werden, werden zunehmend zu einer reichhaltigen Quelle biologischer Informationen. Es gibt eine explosionsartige Entwicklung rechnerischer Methoden und Werkzeuge, insbesondere Computer Vision, um biologisch relevante Informationen aus wissenschaftlichen und konservierenden Bildern zu extrahieren. Allerdings handelt es sich bei den meisten davon um maßgeschneiderte Methoden, die für bestimmte Aufgaben entwickelt wurden und sich nicht einfach an neue Probleme, Kontexte und Datensätze anpassen oder erweitern lassen. Forscher benötigen dringend ein visuelles Modell für allgemeine biologische Probleme von Organismen auf Bildern.

Um dieses Ziel zu erreichen, kuratierte und veröffentlichte die Forschung TREEOFLIFE-10M, den größten und vielfältigsten ML-fähigen biologischen Bilddatensatz. Auf dieser Grundlage entwickelten die Forscher das Basismodell BIOCLIP, das hauptsächlich zur Konstruktion des Lebensbaums (Baum des Lebens) verwendet wird und dabei die einzigartigen Eigenschaften der Biologie nutzt, die von TREEOFLIFE-10M erfasst werden, d. h. den Reichtum und die Vielfalt der Bilder von Pflanzen, Tiere und Pilze sowie eine Fülle strukturierten biologischen Wissens. Baumdiagramm von 108 Toren in TREEOFLIFE-10M.

Die Forscher führten ein strenges Benchmarking unserer Methode anhand verschiedener feinkörniger biologischer Klassifizierungsaufgaben durch und stellten fest, dass BIOCLIP durchweg eine deutlich bessere Leistung erbrachte als bestehende Basislinien (16 % bis 17 % höher im absoluten Wert).

Die intrinsische Bewertung zeigt, dass BIOCLIP eine hierarchische Darstellung gelernt hat, die mit dem Baum des Lebens übereinstimmt, was seine starke Allgemeingültigkeit offenbart.

Aufsatz 2: Mip-Splatting: Aliasfreies 3D-Gaußsches Splatting

Aufsatzautoren: Zehao Yu, Anpei Chen, Binbin Huang, Torsten Sattler, Andreas Geiger

Institutionen: Universität Tübingen, Tübingen Artificial Intelligence Center, Shanghai University of Science and Technology, Breitning, Tschechische Technische Universität in Prag

Papieradresse: https://arxiv.org/abs/2311.16493

Zusammenfassung: Kürzlich haben 3D-Gaußsche Splattering-Techniken beeindruckende Ergebnisse bei der neuartigen Ansichtssynthese gezeigt und ein hohes Maß an Wiedergabetreue und Effizienz erreicht. Bei einer Änderung der Abtastrate (z. B. durch Änderung der Brennweite oder des Kameraabstands) kann es jedoch zu starken Artefakten kommen.

3D-Gauß-Spritzer funktioniert, indem er ein 3D-Objekt als 3D-Gauß-Funktion darstellt, die auf die Bildebene projiziert wird, gefolgt von einer 2D-Erweiterung im Bildschirmraum, wie in Abbildung (a) dargestellt. Die inhärente Schrumpfungsverzerrung dieser Methode führt dazu, dass die degenerierte 3D-Gauß-Funktion die Abtastgrenze überschreitet, wie durch die δ-Funktion in Abbildung (b) gezeigt, während sie aufgrund des Dilatationsvorgangs ähnlich wie 2D wiedergegeben wird. Bei einer Änderung der Abtastrate (entweder über die Brennweite oder den Kameraabstand) werden jedoch starke Dilatationseffekte (c) und Hochfrequenzartefakte (d) beobachtet.

Das Forschungsteam stellte fest, dass der Grund für dieses Phänomen auf das Fehlen von 3D-Frequenzbeschränkungen und die Verwendung eines 2D-Dilatationsfilters zurückzuführen ist. Um dieses Problem zu lösen, führten sie einen 3D-Glättungsfilter ein, der die Größe von 3D-Gaußschen Grundelementen entsprechend der durch die Eingabeansicht induzierten maximalen Abtastfrequenz einschränkt und so hochfrequente Artefakte beim Vergrößern eliminiert.

Darüber hinaus ersetzte das Autorenteam den 2D-Dilatationsfilter durch einen 2D-Mip-Filter, der den 2D-Boxfilter simuliert und die Aliasing- und Expansionsprobleme effektiv lindert. Die Wirksamkeit dieser Methode verifizierten die Forscher anhand von Auswertungen, darunter Szenarien wie Training an Einzelskalenbildern und Mehrskalentests.

Zweitplatzierter für die beste studentische Arbeit

Papier: SpiderMatch: 3D Shape Matching with Global Optimality and Geometrische Konsistenz

Autor: Paul Roetzer, Florian Bernard

Institution: Universität Bonn

Link: https://openaccess.thecvf.com/content/CVPR2024/papers/Roetzer_SpiderMatch_3D_Shape_Matching_with_Global_Optimality_and_Gemetric_Consistency_CVPR_2024_paper.pdf

Artikel: Bildverarbeitung GNN: Starrheit in Superauflösung brechen

Autor: Yuchuan Tian, Hanting Chen, Chao 024_Papier. pdf

- Artikel: Objekte als Volumen: Eine stochastische Geometrieansicht undurchsichtiger Körper

Autoren: Bailey Miller, Hanyu Chen, Alice Lai, Ioannis Gkioulekas

Autoren: Bailey Miller, Hanyu Chen, Alice Lai, Ioannis Gkioulekas

-

Institution: Carnegie lon Universität

Link: https://arxiv.org/pdf/2312.15406v2

- Artikel: Vergleich der Entscheidungsmechanismen von Transformern und CNNs mittels Erklärungsmethoden

Autor: Mingqi. Jiang , Saeed Khorram, Li Fuxin. Institution: Oregon State University _Papier .pdf

Autor: Mingqi. Jiang , Saeed Khorram, Li Fuxin. Institution: Oregon State University _Papier .pdf

Andere Auszeichnungen

- Die Konferenz gab auch die PAMI TC-Auszeichnungen bekannt, darunter den Longuet-Higgins Award, den Young Investigator Award und den Thomas S. Huang Memorial Award.

- Longuet-Higgins Award

Der Longuet-Higgins Award ist der „Computer Vision Fundamental Contribution Award“, der vom IEEE Computer Society Pattern Analysis and Machine Intelligence (PAMI) Technical Committee beim jährlichen CVPR als Anerkennung verliehen wird der Beiträge zur Computer Vision vor zehn Jahren, die einen erheblichen Einfluss auf die Computer Vision-Forschung hatten. Der Preis ist nach dem theoretischen Chemiker und Kognitionswissenschaftler H. Christopher Longuet-Higgins benannt.

Das preisgekrönte Papier dieses Jahres lautet „Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation“.

Autoren: Ross Girshick, Jeff Donahue, Trevor Darrell und Jitendra Malik

Institution: UC Berkeley

-

Link zum Papier: https://arxiv.org/abs/1311.2524

Young Researcher Awards

Die Young Researcher Awards zielen darauf ab, junge Wissenschaftler anzuerkennen und sie zu ermutigen, weiterhin bahnbrechende Arbeiten zu leisten. Das Auswahlkriterium besteht darin, dass der Empfänger über weniger als 7 Jahre Promotionserfahrung verfügt.

Die diesjährigen Gewinner sind Angjoo Kanazawa (UC Berkeley) und Carl Vondrick (Columbia University).

Außerdem erhielt Katie Bouman (Caltech) eine lobende Erwähnung für den Young Investigator Award.

Thomas Huang Memorial Award

Beim CVPR 2020 genehmigte das PAMITC Awards Committee in Erinnerung an Professor Thomas S. Huang (Huang Xutao) die Einrichtung des Thomas S. Huang Memorial Award als Anerkennung für CV-Forschung , Bildung und Service Forscher, die als Vorbilder gelten. Der Preis wird ab 2021 verliehen. Die Stipendiaten müssen ihren Doktortitel seit mindestens 7 Jahren besitzen, vorzugsweise in der Mitte ihrer Karriere (höchstens 25 Jahre).

Die diesjährige Gewinnerin ist Andrea Vedaldi, Professorin an der Universität Oxford.

Weitere Informationen finden Sie unter: https://media.eventhosts.cc/Conferences/CVPR2024/OpeningRemarkSlides.pdf

Referenzlink:

https://public.tableau .com /views/CVPR2024/CVPRtrends?%3AshowVizHome=no&continueFlag=6a947f6367e90acd982f7ee49a495fe2

Das obige ist der detaillierte Inhalt vonAlle CVPR 2024-Auszeichnungen bekannt gegeben! Fast 10.000 Menschen nahmen offline an der Konferenz teil und ein chinesischer Forscher von Google gewann den Preis für den besten Beitrag. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Zusammenfassung der PHP-Grundkenntnisse (notwendig für Anfänger zum Einstieg)

- Ausführliche Erläuterung des ABP-Einführungs-Tutorials der ABP-Reihe des ASP.NET-Vorlagenentwicklungsframeworks

- Einführung in die persönliche Entwicklung beliebter WeChat-Miniprogramme im Jahr 2018 (mit Code)

- Welche Bücher sollte ich lesen, um mit Java zu beginnen?

- PHP-Grundlagen-Tutorial: Vom Anfänger zum Meister

?? Fraser Universität, Toronto University

?? Fraser Universität, Toronto University  Institution: Ohio State University, Microsoft Research, University of California, Irvine, Rensselaer Polytechnic Institute

Institution: Ohio State University, Microsoft Research, University of California, Irvine, Rensselaer Polytechnic Institute