Heim >Technologie-Peripheriegeräte >KI >Verstehen Sie das LLM-Bewertungsrahmenwerk von Arthur Bench in einem Artikel

Verstehen Sie das LLM-Bewertungsrahmenwerk von Arthur Bench in einem Artikel

- WBOYOriginal

- 2024-06-01 17:57:01480Durchsuche

Hallo Leute, ich bin Luga, heute werden wir über Technologien im Zusammenhang mit dem ökologischen Bereich der künstlichen Intelligenz (KI) sprechen – LLM-Bewertung.

Wie wir alle wissen, ist die LLM-Evaluation ein wichtiges Thema im Bereich der künstlichen Intelligenz. Da LLMs in verschiedenen Szenarien immer häufiger eingesetzt werden, wird es immer wichtiger, ihre Fähigkeiten und Grenzen zu bewerten. Als aufstrebendes LLM-Bewertungstool zielt ArthurBench darauf ab, eine umfassende, faire und wiederholbare Bewertungsplattform für KI-Forscher und -Entwickler bereitzustellen.

1. Herausforderungen für die traditionelle Textbewertung

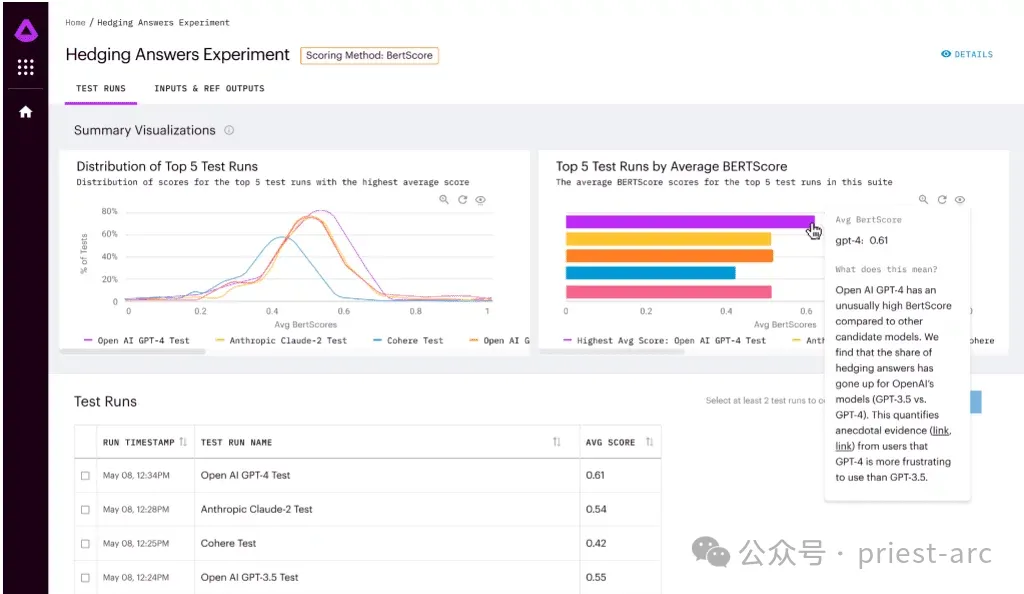

In den letzten Jahren sind traditionelle Textbewertungsmethoden aufgrund der rasanten Entwicklung und Verbesserung großer Sprachmodelle (LLM) in einigen Aspekten möglicherweise nicht mehr anwendbar. Im Bereich der Textbewertung haben wir möglicherweise von einigen Methoden gehört, z. B. von Bewertungsmethoden, die auf „Wortvorkommnissen“ basieren, wie BLEU, und Bewertungsmethoden, die auf „vorab trainierten natürlichen Sprachverarbeitungsmodellen“ basieren, wie z. B. BERTScore. Diese neuen Bewertungsmethoden ermöglichen eine genauere Beurteilung der Qualität und Relevanz von Texten. Beispielsweise bewertet die BLEU-Bewertungsmethode die Übersetzungsqualität anhand des Vorkommensgrads von Standardwörtern, während die BERTScore-Bewertungsmethode die Relevanz von Text anhand der Fähigkeit eines vorab trainierten Verarbeitungsmodells für natürliche Sprache bewertet, die Verarbeitung von Sätzen in natürlicher Sprache zu simulieren. Diese neuen Bewertungsmethoden lösen bis zu einem gewissen Grad einige der Probleme traditioneller Methoden und weisen eine höhere Flexibilität und Genauigkeit auf. Mit der kontinuierlichen Weiterentwicklung und Verbesserung von Sprachmodellen waren diese Methoden in der Vergangenheit jedoch sehr gut, aber mit der Weiterentwicklung der ökologischen Technologie von LLM erweist sie sich als etwas unzureichend und kann die aktuellen Anforderungen nicht vollständig erfüllen.

Mit der rasanten Entwicklung und Verbesserung des LLM stehen wir vor neuen Herausforderungen und Chancen. Die Fähigkeiten und Leistungsniveaus von LLMs nehmen weiter zu, sodass es möglich ist, dass auf Wortvorkommnissen basierende Bewertungsmethoden wie BLEU die Qualität und semantische Genauigkeit von LLM-generiertem Text möglicherweise nicht vollständig erfassen. LLM erzeugt flüssigeren, kohärenteren und semantisch reichhaltigeren Text – Vorteile, die herkömmliche, auf dem Vorkommen von Wörtern basierende Bewertungsmethoden nicht genau messen können.

Bewertungsmethoden für vorab trainierte Modelle (wie BERTScore) können bei der Bewältigung spezifischer Aufgaben vor einigen Herausforderungen stehen. Obwohl vorab trainierte Modelle bei vielen Aufgaben eine gute Leistung erbringen, berücksichtigen sie möglicherweise nicht vollständig die einzigartigen Eigenschaften von LLM und seine Leistung bei bestimmten Aufgaben. Wenn man sich daher ausschließlich auf Bewertungsmethoden verlässt, die auf vorab trainierten Modellen basieren, kann es sein, dass die Fähigkeiten von LLM nicht vollständig bewertet werden.

2. Warum ist eine LLM-Beratungsbewertung erforderlich?

Im Allgemeinen liegen die wertvollsten Aspekte der Verwendung der LLM-Beratungsbewertungsmethode vor allem in „Geschwindigkeit“ und „Sensibilität“.

1. Effizient

Erstens ist die Umsetzung im Allgemeinen schneller. Die Erstellung einer erstmaligen Implementierung einer LLM-gesteuerten Bewertung ist im Vergleich zu dem Arbeitsaufwand, der bei früheren Bewertungsmanagement-Pipelines erforderlich war, relativ schnell und einfach. Für die LLM-gesteuerte Bewertung müssen wir nur zwei Dinge vorbereiten: die Bewertungskriterien in Worten beschreiben und einige Beispiele zur Verwendung in der Eingabeaufforderungsvorlage bereitstellen. Die Verwendung eines LLM für diese Aufgaben ist effizienter als der Arbeitsaufwand und die Datenerfassung, die erforderlich sind, um Ihr eigenes vorab trainiertes NLP-Modell zu erstellen (oder ein vorhandenes NLP-Modell zu verfeinern), um als Schätzer zu dienen. Mit LLM ist die Iteration der Bewertungskriterien viel schneller. Darüber hinaus ist die Iteration der Bewertungskriterien mit LLM viel schneller. Mit LLM können wir iterative Versionen der Bewertungskriterien schneller generieren und mit LLM effizientere Bewertungen durchführen. Mit LLM ist die Iteration der Bewertungskriterien viel schneller. Die Erstellung einer erstmaligen Implementierung einer LLM-gesteuerten Bewertung ist im Vergleich zu dem Arbeitsaufwand, der bei früheren Bewertungsmanagement-Pipelines erforderlich war, relativ schnell und einfach. Für die LLM-gesteuerte Bewertung müssen wir nur zwei Dinge vorbereiten: die Bewertungskriterien in Worten beschreiben und einige Beispiele zur Verwendung in der Eingabeaufforderungsvorlage bereitstellen. Im Vergleich zum Arbeitsaufwand und der Datenerfassung, die erforderlich sind, um Ihr eigenes vorab trainiertes NLP-Modell (oder die Feinabstimmung eines vorhandenen NLP-Modells) zur Verwendung als Schätzer zu erstellen, ist die Verwendung von LLM zur Erfüllung dieser Aufgaben effizienter

2. Sensibilität

Darüber hinaus ist LLM normalerweise empfindlicher. Diese Sensibilität kann positive Aspekte mit sich bringen, LLM kann mit diesen Situationen flexibler umgehen als vorab trainierte NLP-Modelle und die zuvor diskutierten Bewertungsmethoden. Diese Sensibilität kann jedoch auch dazu führen, dass die Ergebnisse der LLM-Bewertung sehr unvorhersehbar werden.

Wie wir bereits besprochen haben, sind LLM-Evaluatoren im Vergleich zu anderen Evaluierungsmethoden sensibler. Es gibt viele verschiedene Möglichkeiten, LLM als Evaluator zu konfigurieren, und sein Verhalten kann je nach gewählter Konfiguration stark variieren. Eine weitere Herausforderung besteht darin, dass LLM-Evaluatoren stecken bleiben können, wenn die Bewertung zu viele Inferenzschritte umfasst oder die gleichzeitige Verarbeitung zu vieler Variablen erfordert.

Aufgrund der Eigenschaften von LLM können seine Bewertungsergebnisse durch unterschiedliche Konfigurationen und Parametereinstellungen beeinflusst werden. Das bedeutet, dass bei der Bewertung von LLMs das Modell sorgfältig ausgewählt und konfiguriert werden muss, um sicherzustellen, dass es sich wie erwartet verhält. Unterschiedliche Konfigurationen können zu unterschiedlichen Ausgabeergebnissen führen. Daher muss der Bewerter einige Zeit und Mühe aufwenden, um die Einstellungen des LLM anzupassen und zu optimieren, um genaue und zuverlässige Bewertungsergebnisse zu erhalten.

Darüber hinaus können Evaluatoren vor einigen Herausforderungen stehen, wenn sie mit Bewertungsaufgaben konfrontiert werden, die komplexe Überlegungen oder die gleichzeitige Verarbeitung mehrerer Variablen erfordern. Dies liegt daran, dass die Argumentationsfähigkeit von LLM bei der Bewältigung komplexer Situationen eingeschränkt sein kann. Das LLM erfordert möglicherweise zusätzliche Anstrengungen zur Bewältigung dieser Aufgaben, um die Genauigkeit und Zuverlässigkeit der Bewertung sicherzustellen.

3. Was ist Arthur Bench?

Arthur Bench ist ein Open-Source-Bewertungstool zum Vergleich der Leistung generativer Textmodelle (LLM). Es kann verwendet werden, um verschiedene LLM-Modelle, Hinweise und Hyperparameter zu bewerten und detaillierte Berichte über die LLM-Leistung bei verschiedenen Aufgaben bereitzustellen.

Zu den wichtigsten Funktionen von Arthur Bench gehören:

- Vergleich verschiedener LLM-Modelle: Mit Arthur Bench kann die Leistung verschiedener LLM-Modelle verglichen werden, einschließlich Modellen von verschiedenen Anbietern, unterschiedlichen Modellversionen und Modellen, die unterschiedliche Trainingsdatensätze verwenden.

- Tipps bewerten: Arthur Bench kann verwendet werden, um die Auswirkungen verschiedener Tipps auf die LLM-Leistung zu bewerten. Eingabeaufforderungen sind Anweisungen, die LLM bei der Textgenerierung unterstützen.

- Hyperparameter testen: Arthur Bench kann verwendet werden, um die Auswirkungen verschiedener Hyperparameter auf die LLM-Leistung zu testen. Hyperparameter sind Einstellungen, die das Verhalten von LLM steuern.

Im Allgemeinen umfasst der Arthur Bench-Workflow hauptsächlich die folgenden Phasen, und die detaillierte Analyse ist wie folgt:

1. Aufgabendefinition

In dieser Phase müssen wir unsere Bewertungsziele klären. Arthur Bench unterstützt Mehrere Eine Vielzahl von Bewertungsaufgaben, darunter:

- Frage und Antwort: Testen Sie die Fähigkeit des LLM, offene, herausfordernde oder mehrdeutige Fragen zu verstehen und zu beantworten.

- Zusammenfassung: Bewerten Sie die Fähigkeit von LLM, wichtige Informationen aus Texten zu extrahieren und prägnante Zusammenfassungen zu erstellen.

- Übersetzung: Untersuchen Sie die Fähigkeit von LLM, präzise und fließend zwischen verschiedenen Sprachen zu übersetzen.

- Codegenerierung: Testen Sie die Fähigkeit von LLM, Code basierend auf Beschreibungen in natürlicher Sprache zu generieren.

2. Modellauswahl

In dieser Phase besteht die Hauptarbeit darin, die Bewertungsobjekte auszuwählen. Arthur Bench unterstützt eine Vielzahl von LLM-Modellen und deckt führende Technologien bekannter Institutionen wie OpenAI, Google AI, Microsoft usw. ab, wie GPT-3, LaMDA, Megatron-Turing NLG usw. Je nach Forschungsbedarf können wir spezifische Modelle zur Evaluierung auswählen.

3. Parameterkonfiguration

Nach Abschluss der Modellauswahl besteht der nächste Schritt darin, eine verfeinerte Steuerung durchzuführen. Um die LLM-Leistung genauer zu bewerten, ermöglicht Arthur Bench Benutzern die Konfiguration von Hinweisen und Hyperparametern.

- Tipp: Leiten Sie LLM in Richtung und Inhalt des generierten Textes, wie etwa Fragen, Beschreibungen oder Anweisungen.

- Hyperparameter: Schlüsseleinstellungen, die das LLM-Verhalten steuern, wie z. B. Lernrate, Anzahl der Trainingsschritte, Modellarchitektur usw.

Durch eine verfeinerte Konfiguration können wir die Leistungsunterschiede von LLM unter verschiedenen Parametereinstellungen eingehend untersuchen und Bewertungsergebnisse mit mehr Referenzwert erhalten.

4. Bewertungslauf

Der letzte Schritt besteht darin, die Aufgabenbewertung mithilfe automatisierter Prozesse durchzuführen. Typischerweise bietet Arthur Bench einen automatisierten Bewertungsprozess, der eine einfache Konfiguration zum Ausführen von Bewertungsaufgaben erfordert. Die folgenden Schritte werden automatisch ausgeführt:

- Rufen Sie das LLM-Modell auf und generieren Sie eine Textausgabe.

- Für spezifische Aufgaben wenden Sie entsprechende Bewertungsindikatoren zur Analyse an.

- Erstellen Sie detaillierte Berichte und präsentieren Sie Auswertungsergebnisse.

4. Arthur Bench-Nutzungsszenarioanalyse

Als Schlüssel zur schnellen, datengesteuerten LLM-Bewertung bietet Arthur Bench hauptsächlich die folgenden Lösungen, insbesondere:

1. Modellauswahl und -verifizierung ist ein entscheidender Schritt auf dem Gebiet der künstlichen Intelligenz und von großer Bedeutung, um die Gültigkeit und Zuverlässigkeit des Modells sicherzustellen. In diesem Prozess spielte Arthur Bench eine entscheidende Rolle. Sein Ziel ist es, Unternehmen einen zuverlässigen Vergleichsrahmen zur Verfügung zu stellen, der ihnen durch den Einsatz konsistenter Metriken und Bewertungsmethoden hilft, fundierte Entscheidungen zwischen den vielen Optionen des großen Sprachmodells (LLM) zu treffen.

Arthur Bench wird sein Fachwissen und seine Erfahrung nutzen, um jede LLM-Option zu bewerten und sicherzustellen, dass konsistente Kennzahlen zum Vergleich ihrer Stärken und Schwächen verwendet werden. Er wird Faktoren wie Modellleistung, Genauigkeit, Geschwindigkeit, Ressourcenanforderungen und mehr berücksichtigen, um sicherzustellen, dass Unternehmen fundierte und klare Entscheidungen treffen können.

Arthur Bench wird sein Fachwissen und seine Erfahrung nutzen, um jede LLM-Option zu bewerten und sicherzustellen, dass konsistente Kennzahlen zum Vergleich ihrer Stärken und Schwächen verwendet werden. Er wird Faktoren wie Modellleistung, Genauigkeit, Geschwindigkeit, Ressourcenanforderungen und mehr berücksichtigen, um sicherzustellen, dass Unternehmen fundierte und klare Entscheidungen treffen können.

Durch die Verwendung konsistenter Metriken und Bewertungsmethoden stellt Arthur Bench Unternehmen einen zuverlässigen Vergleichsrahmen zur Verfügung, der es ihnen ermöglicht, die Vorteile und Einschränkungen jeder LLM-Option vollständig zu bewerten. Dies wird es Unternehmen ermöglichen, fundierte Entscheidungen zu treffen, um die rasanten Fortschritte in der künstlichen Intelligenz zu maximieren und die bestmögliche Erfahrung mit ihren Anwendungen sicherzustellen.

2. Budget- und Datenschutzoptimierung

Bei der Auswahl eines KI-Modells erfordern nicht alle Anwendungen die fortschrittlichsten oder teuersten großen Sprachmodelle (LLM). In einigen Fällen können Missionsanforderungen mithilfe kostengünstigerer KI-Modelle erfüllt werden.

Dieser Ansatz zur Budgetoptimierung kann Unternehmen dabei helfen, trotz begrenzter Ressourcen kluge Entscheidungen zu treffen. Anstatt sich für das teuerste oder modernste Modell zu entscheiden, wählen Sie das richtige Modell basierend auf Ihren spezifischen Anforderungen. Die günstigeren Modelle schneiden in einigen Aspekten möglicherweise etwas schlechter ab als hochmoderne LLMs, aber für einige einfache oder Standardaufgaben kann Arthur Bench dennoch eine Lösung bieten, die den Anforderungen entspricht.

Darüber hinaus betonte Arthur Bench, dass die interne Einführung des Modells eine bessere Kontrolle über den Datenschutz ermöglicht. Bei Anwendungen, die sensible Daten oder Datenschutzprobleme betreffen, ziehen es Unternehmen möglicherweise vor, ihre eigenen intern geschulten Modelle zu verwenden, anstatt sich auf externe LLMs von Drittanbietern zu verlassen. Durch den Einsatz interner Modelle können Unternehmen eine größere Kontrolle über die Datenverarbeitung und -speicherung erlangen und den Datenschutz besser schützen.

3. Übersetzen Sie akademische Benchmarks in die reale Leistung.

Akademische Benchmarks beziehen sich auf Modellbewertungsmetriken und -methoden, die in der akademischen Forschung etabliert sind. Diese Indikatoren und Methoden sind in der Regel spezifisch für eine bestimmte Aufgabe oder Domäne und können die Leistung des Modells in dieser Aufgabe oder Domäne effektiv bewerten.

Akademische Benchmarks spiegeln jedoch nicht immer direkt die Leistung eines Modells in der realen Welt wider. Dies liegt daran, dass Anwendungsszenarien in der realen Welt häufig komplexer sind und die Berücksichtigung weiterer Faktoren erfordern, wie z. B. Datenverteilung, Modellbereitstellungsumgebung usw.

Arthur Bench hilft dabei, akademische Maßstäbe in reale Leistungen umzusetzen. Dieses Ziel wird auf folgende Weise erreicht:

- Bietet einen umfassenden Satz von Bewertungsindikatoren, die mehrere Aspekte der Modellgenauigkeit, Effizienz, Robustheit usw. abdecken. Diese Indikatoren können nicht nur die Leistung des Modells unter akademischen Benchmarks widerspiegeln, sondern auch die potenzielle Leistung des Modells in der realen Welt.

- Unterstützt mehrere Modelltypen und kann verschiedene Modelltypen vergleichen. Dadurch können Unternehmen das Modell auswählen, das am besten zu ihren Anwendungsszenarien passt.

- Bietet visuelle Analysetools, die Unternehmen dabei helfen, die Leistungsunterschiede verschiedener Modelle intuitiv zu verstehen. Dadurch können Unternehmen leichter Entscheidungen treffen.

5. Arthur Bench-Funktionsanalyse

Als Schlüssel zu einer schnellen, datengesteuerten LLM-Bewertung verfügt Arthur Bench über die folgenden Funktionen:

1. Arthur Bench verfügt über einen vollständigen Satz von Bewertungsindikatoren Indikatoren, die alles von der Zusammenfassung aller Qualitätsaspekte bis hin zur Benutzererfahrung abdecken. Er kann diese Scoring-Metriken jederzeit nutzen, um verschiedene Modelle zu bewerten und zu vergleichen. Die kombinierte Verwendung dieser Bewertungsmetriken kann ihm helfen, die Stärken und Schwächen jedes Modells vollständig zu verstehen.

Der Umfang dieser Bewertungsindikatoren ist sehr breit und umfasst unter anderem Zusammenfassungsqualität, Genauigkeit, Sprachkompetenz, grammatikalische Korrektheit, Kontextverständnisfähigkeit, logische Kohärenz usw. Arthur Bench bewertet jedes Modell anhand dieser Kennzahlen und kombiniert die Ergebnisse zu einer umfassenden Bewertung, um Unternehmen dabei zu unterstützen, fundierte Entscheidungen zu treffen.

Darüber hinaus kann Arthur Bench, wenn das Unternehmen spezifische Bedürfnisse oder Bedenken hat, auch benutzerdefinierte Bewertungsmetriken erstellen und hinzufügen, die auf den Anforderungen des Unternehmens basieren. Dies geschieht, um den spezifischen Bedürfnissen des Unternehmens besser gerecht zu werden und sicherzustellen, dass der Bewertungsprozess mit den Zielen und Standards des Unternehmens übereinstimmt.

2. Lokale und cloudbasierte Versionen

2. Lokale und cloudbasierte Versionen

Für diejenigen, die lokale Bereitstellung und autonome Steuerung bevorzugen, können Sie über das GitHub-Repository Zugriff erhalten und Arthur Bench in Ihrer eigenen lokalen Umgebung bereitstellen. Auf diese Weise kann jeder die Bedienung von Arthur Bench vollständig beherrschen, kontrollieren und nach seinen eigenen Bedürfnissen anpassen und konfigurieren.

Andererseits werden für Benutzer, die Komfort und Flexibilität bevorzugen, auch Cloud-basierte SaaS-Produkte bereitgestellt. Sie können sich registrieren, um über die Cloud auf Arthur Bench zuzugreifen und es zu nutzen. Diese Methode macht eine umständliche lokale Installation und Konfiguration überflüssig und ermöglicht Ihnen die sofortige Nutzung der bereitgestellten Funktionen und Dienste.

3. Vollständig Open Source

Als Open-Source-Projekt zeigt Arthur Bench seine typischen Open-Source-Eigenschaften in Bezug auf Transparenz, Skalierbarkeit und Community-Zusammenarbeit. Dieser Open-Source-Charakter bietet den Nutzern eine Fülle von Vorteilen und Möglichkeiten, ein tieferes Verständnis der Funktionsweise des Projekts zu erlangen und es an ihre Bedürfnisse anzupassen und zu erweitern. Gleichzeitig ermutigt die Offenheit von Arthur Bench die Benutzer auch dazu, sich aktiv an der Community-Zusammenarbeit zu beteiligen, mit anderen Benutzern zusammenzuarbeiten und sich weiterzuentwickeln. Dieses offene Kooperationsmodell trägt dazu bei, die kontinuierliche Weiterentwicklung und Innovation des Projekts zu fördern und gleichzeitig einen größeren Wert und mehr Möglichkeiten für die Nutzer zu schaffen.

Kurz gesagt bietet Arthur Bench ein offenes und flexibles Framework, das es Benutzern ermöglicht, Bewertungsindikatoren anzupassen, und das im Finanzbereich weit verbreitet ist. Partnerschaften mit Amazon Web Services und Cohere bringen das Framework weiter voran und ermutigen Entwickler, neue Metriken für Bench zu erstellen und zu Fortschritten im Bereich der Sprachmodellbewertung beizutragen.

Referenz:

[1] https://github.com/arthur-ai/bench- [2] https://neurohive.io/en/news/arthur-bench-framework-for-evaluating- Sprachmodelle/

Das obige ist der detaillierte Inhalt vonVerstehen Sie das LLM-Bewertungsrahmenwerk von Arthur Bench in einem Artikel. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

In Verbindung stehende Artikel

Mehr sehen- Was ist ein Algorithmus für künstliche Intelligenz?

- Vier Merkmale des Zeitalters der künstlichen Intelligenz?

- Verwenden Sie BigDL-LLM, um zig Milliarden Parameter-LLM-Inferenzen sofort zu beschleunigen

- Durch MAmmoT wird LLM zum mathematischen Generalisten: von der formalen Logik bis zu vier arithmetischen Operationen

- Geben Sie alles, um den Kreislauf zu schließen! DriveMLM: LLM perfekt mit autonomer Fahrverhaltensplanung kombinieren!