对抗训练(Adversarial Training)是近年来在深度学习领域引起广泛关注的一种训练方法。它旨在增强模型的鲁棒性,使其能够对抗各种攻击手段。然而,在实际应用中,对抗训练面临着一个重要的问题,即收敛问题。在本文中,我们将讨论收敛问题,并给出一种具体的代码示例来解决这个问题。

首先,让我们来了解一下收敛问题是什么。在对抗训练中,我们通过在训练集中添加对抗样本来训练模型。对抗样本是经过人为修改的样本,它们在人类和模型之间有很大的相似性,但能够欺骗模型的分类器。这使得模型在面对对抗样本时变得更为鲁棒。

然而,由于对抗样本的引入,训练过程变得更加困难。传统的优化方法很难找到一个收敛的解,导致模型无法获得良好的泛化能力。这就是收敛问题。具体而言,收敛问题表现为模型在训练过程中的损失函数无法稳定下降,或者模型在测试集上的表现无法得到明显的提升。

为了解决这个问题,研究者们提出了许多方法。其中,一种常用的方法是通过调整训练过程中的参数来改善模型的收敛性。例如,可以调整学习率、正则化项、训练集的大小等。此外,还有一些方法是专门为对抗训练设计的,如Madry等人提出的PGD(Projected Gradient Descent)算法。

下面,我们将给出一种具体的代码示例,展示如何使用PGD算法来解决收敛问题。首先,我们需要定义一个对抗训练的模型。这个模型可以是任意的深度学习模型,如卷积神经网络(CNN)、循环神经网络(RNN)等。

接下来,我们需要定义一个对抗样本生成器。PGD算法是一种迭代的攻击方法,它通过多次迭代来生成对抗样本。在每一次迭代中,我们通过计算当前模型的梯度来更新对抗样本。具体而言,我们使用梯度上升的方式来更新对抗样本,以使其对模型更具欺骗性。

最后,我们需要进行对抗训练的过程。在每一次迭代中,我们先生成对抗样本,然后使用对抗样本和真实样本进行训练。这样,模型就能够在不断的对抗中逐渐提高其鲁棒性。

下面是一个简单的代码示例,展示了如何使用PGD算法进行对抗训练:

import torch

import torch.nn as nn

import torch.optim as optim

class AdversarialTraining:

def __init__(self, model, eps=0.01, alpha=0.01, iterations=10):

self.model = model

self.eps = eps

self.alpha = alpha

self.iterations = iterations

def generate_adversarial_sample(self, x, y):

x_adv = x.clone().detach().requires_grad_(True)

for _ in range(self.iterations):

loss = nn.CrossEntropyLoss()(self.model(x_adv), y)

loss.backward()

x_adv.data += self.alpha * torch.sign(x_adv.grad.data)

x_adv.grad.data.zero_()

x_adv.data = torch.max(torch.min(x_adv.data, x + self.eps), x - self.eps)

x_adv.data = torch.clamp(x_adv.data, 0.0, 1.0)

return x_adv

def train(self, train_loader, optimizer, criterion):

for x, y in train_loader:

x_adv = self.generate_adversarial_sample(x, y)

logits = self.model(x_adv)

loss = criterion(logits, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

# 定义模型和优化器

model = YourModel()

optimizer = optim.SGD(model.parameters(), lr=0.01, momentum=0.9)

criterion = nn.CrossEntropyLoss()

# 创建对抗训练对象

adv_training = AdversarialTraining(model)

# 进行对抗训练

adv_training.train(train_loader, optimizer, criterion)在上面的代码中,model是我们要训练的模型,eps是生成对抗样本时的扰动范围,alpha是每一次迭代的步长,iterations是迭代次数。generate_adversarial_sample方法用来生成对抗样本,train方法用来进行对抗训练。

通过以上的代码示例,我们可以看到如何使用PGD算法来解决对抗训练中的收敛问题。当然,这只是一种方法,针对不同的问题可能需要根据实际情况进行调整。希望本文能够对你理解和解决收敛问题有所帮助。

以上是对抗训练中的收敛问题的详细内容。更多信息请关注PHP中文网其他相关文章!

我尝试了使用光标AI编码的Vibe编码,这太神奇了!Mar 20, 2025 pm 03:34 PM

我尝试了使用光标AI编码的Vibe编码,这太神奇了!Mar 20, 2025 pm 03:34 PMVibe编码通过让我们使用自然语言而不是无尽的代码行创建应用程序来重塑软件开发的世界。受Andrej Karpathy等有远见的人的启发,这种创新的方法使Dev

如何使用DALL-E 3:技巧,示例和功能Mar 09, 2025 pm 01:00 PM

如何使用DALL-E 3:技巧,示例和功能Mar 09, 2025 pm 01:00 PMDALL-E 3:生成的AI图像创建工具 Generative AI正在彻底改变内容的创建,而Openai最新的图像生成模型Dall-E 3处于最前沿。它于2023年10月发行,建立在其前任Dall-E和Dall-E 2上

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM2025年2月,Generative AI又是一个改变游戏规则的月份,为我们带来了一些最令人期待的模型升级和开创性的新功能。从Xai的Grok 3和Anthropic的Claude 3.7十四行诗到Openai的G

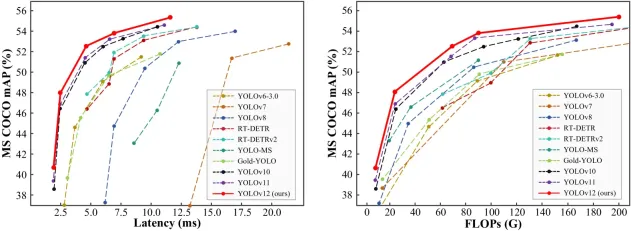

如何使用Yolo V12进行对象检测?Mar 22, 2025 am 11:07 AM

如何使用Yolo V12进行对象检测?Mar 22, 2025 am 11:07 AMYolo(您只看一次)一直是领先的实时对象检测框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了进步,可显着提高准确性

Sora vs veo 2:哪个创建更现实的视频?Mar 10, 2025 pm 12:22 PM

Sora vs veo 2:哪个创建更现实的视频?Mar 10, 2025 pm 12:22 PMGoogle的VEO 2和Openai的Sora:哪个AI视频发电机占据了至尊? 这两个平台都产生了令人印象深刻的AI视频,但它们的优势在于不同的领域。 使用各种提示,这种比较揭示了哪种工具最适合您的需求。 t

Google的Gencast:Gencast Mini Demo的天气预报Mar 16, 2025 pm 01:46 PM

Google的Gencast:Gencast Mini Demo的天气预报Mar 16, 2025 pm 01:46 PMGoogle DeepMind的Gencast:天气预报的革命性AI 天气预报经历了巨大的转变,从基本观察到复杂的AI驱动预测。 Google DeepMind的Gencast,开创性

哪个AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM

哪个AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM本文讨论了AI模型超过Chatgpt,例如Lamda,Llama和Grok,突出了它们在准确性,理解和行业影响方面的优势。(159个字符)

Chatgpt 4 o可用吗?Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用吗?Mar 28, 2025 pm 05:29 PMChatgpt 4当前可用并广泛使用,与诸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和产生连贯的响应方面取得了重大改进。未来的发展可能包括更多个性化的间

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具

WebStorm Mac版

好用的JavaScript开发工具

ZendStudio 13.5.1 Mac

功能强大的PHP集成开发环境

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。