我们常常被教育的做事“三思而后行”,充分运用积累过的经验,现在这句话对AI也有所启发了。

传统的决策AI模型由于遗忘效应的存在不能有效积累经验,但一项由华人主导的研究改变了AI的记忆方式。

新的记忆方式模仿了人类大脑,有效地提高了AI积累经验的效率,从而将AI打游戏的成绩提高了29.9%。

研究团队由六人组成,分别来自米拉-魁北克AI研究院和微软蒙特利尔研究所,其中有四名是华人。

他们将成果命名为的带有记忆的决策Transformer(DT-Mem)。

相比传统的决策模型,DT-Mem适用广泛性更强,模型运算的效率也更高。

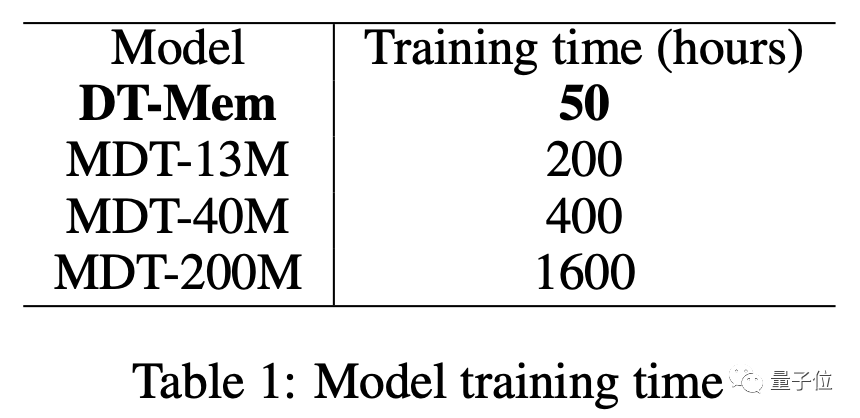

除了应用效果,DT-Mem的训练时间也从最短200小时缩短至50小时。

同时,团队还提出了一种微调方式,让DT-Mem能够适应未训练过的新场景。

微调后的模型,面对没有学习过的游戏,也能拥有不错的表现。

工作机制受到人类启发

传统的决策模型基于LLM进行设计,采用隐性记忆,其性能依赖于数据和计算。

隐性记忆是无意识产生而非刻意记住的,因而也无法有意识地进行调用。

说得通俗一些,就是明明有关内容就存储在那里,但是模型却并不知道它的存在。

隐性记忆的这一特点决定了传统模型存在遗忘现象,导致其工作效率往往不高。

遗忘现象表现为,在学了新的问题解决方式之后,模型可能会将旧的内容忘记,哪怕新旧问题是同一类型。

而人脑采用分布式记忆存储方式,记忆的内容被分散存储在大脑中的多个不同区域。

这种方式有助于有效地管理和组织多种技能,从而减轻遗忘现象。

受此启发,研究团队提出了一个内部工作记忆模块来存储、混合和检索不同下游任务的信息。

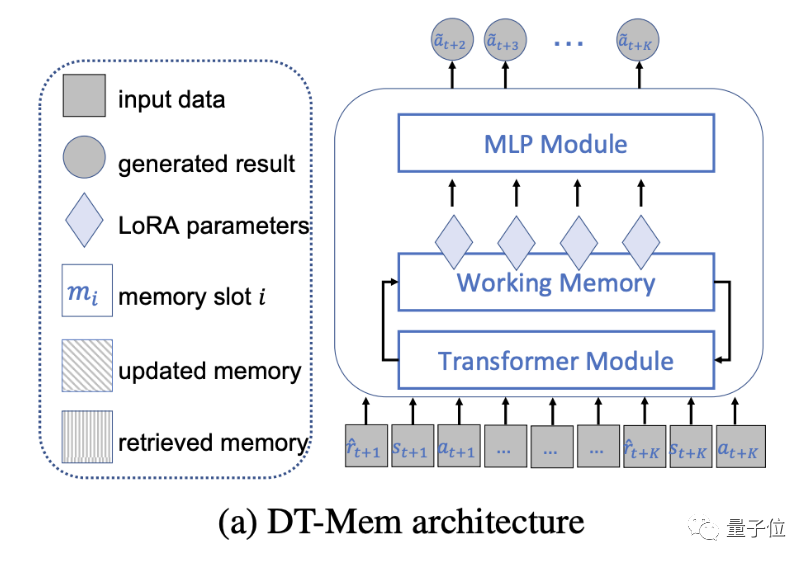

具体而言,DT-Mem由Transformer、记忆模块和多层感知(MLP)模块三部分组成。

DT-Mem的Transformer模仿了GPT-2的架构,但删去了注意力机制后的前馈层。

同时,GPT-2中的MLP模块被拆分成了独立组件,作为DT-Mem的一部分。

在二者之间,研究团队引入了一个工作记忆模块,用于存储和处理中间信息。

这一结构是受到神经图灵机的启发,其中的记忆被用于推断多种算法。

记忆模块分析Transformer输出的信息,并决定其存储位置以及与已有信息的整合方式。

此外,该模块还要考虑这些信息在今后做出决策的过程当中如何使用。

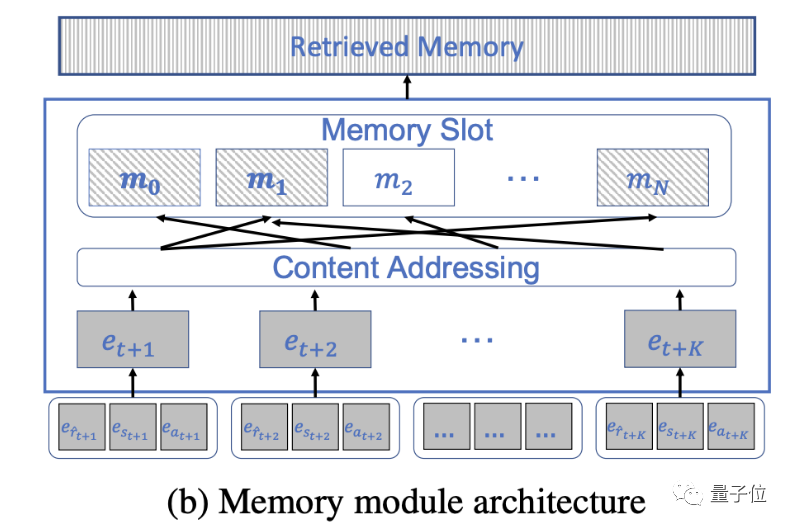

这些任务大概通过五个步骤来完成,记忆模块首先被初始化为一个随机矩阵。

然后是对输入信息的整理,这一步并不是将信息传给Transformer,而是以元组形式存入同一空间。

之后就要确定存储位置。人类通常会将相关的信息存储到同一位置,DT-Mem也是基于这一原理。

最后两步——记忆更新和检索是记忆模块的核心,也是整个DT-Mem中最重要的环节。

记忆更新,即对已有信息进行编辑替换,以确保信息能根据任务需要及时更新。

这一步中DT-Mem会计算擦除和写入两个向量,进而判断如何与已有数据混合。

记忆检索则是对已有信息的访问和恢复,在需要做出决策时及时调取相关有用信息。

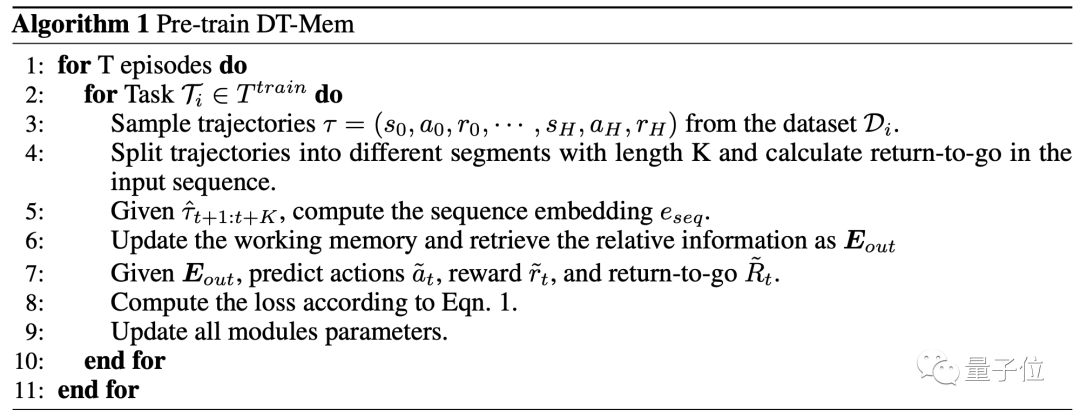

投入实际使用之前,DT-Mem还要经历预训练过程。

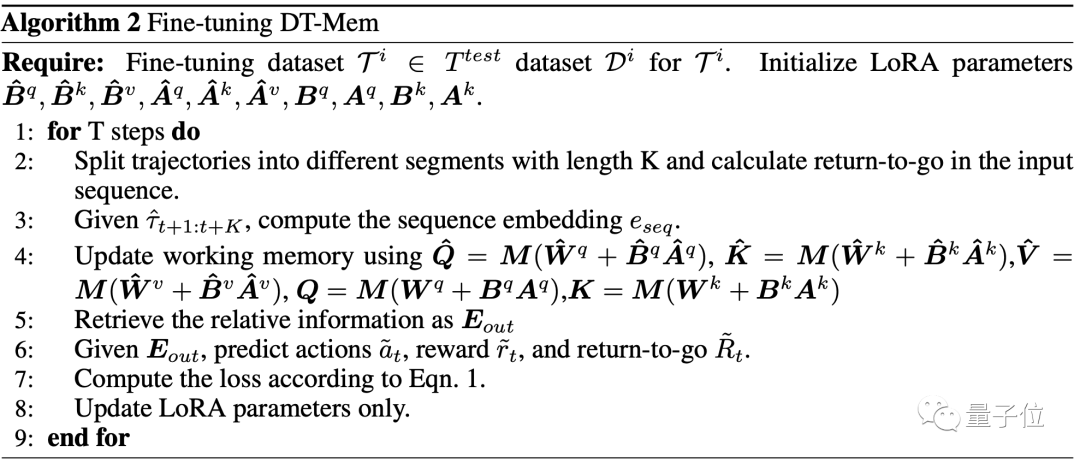

而对于DT-Mem的微调,团队也提出了一种新的方式。

由于使用的是基于任务进行标记的数据,这种微调能够帮助DT-Mem适应新的任务。

这一过程基于低秩适应(LoRA)进行,在已有的矩阵中加入低秩元素。

训练时间最多缩短32倍

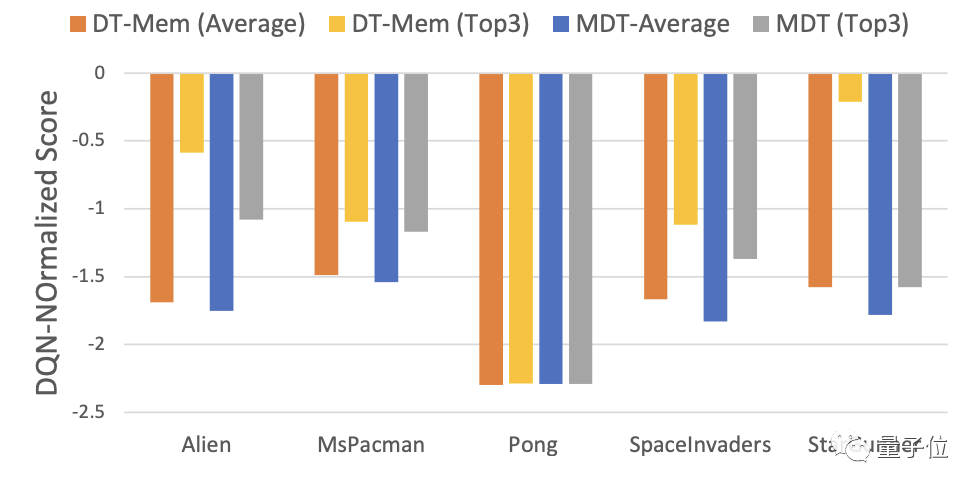

为了测试DT-Mem的决策能力,研究团队让它玩了几款游戏。

游戏一共有5款,全部来自Atari公司。

同时,团队还测试了传统模型M[ulti-game]DT的表现作为参照。

结果,DT-Mem在其中4款游戏里的最好成绩均胜过MDT。

具体而言,DT-Mem比MDT的DQN标准化分数提高了29.9%。

但是,DT-Mem的参数量只有20M,仅是MDT(200M参数)的10%。

这样的表现,说是四两拨千斤一点也不过分。

除了表现优异,DT-Mem的训练效率也完爆MDT。

13M参数量版本的MDT需要200小时进行训练,而20M的DT-Mem却只需要50个小时。

如果和200M的版本相比,训练时间足足缩短了32倍,表现却更优异。

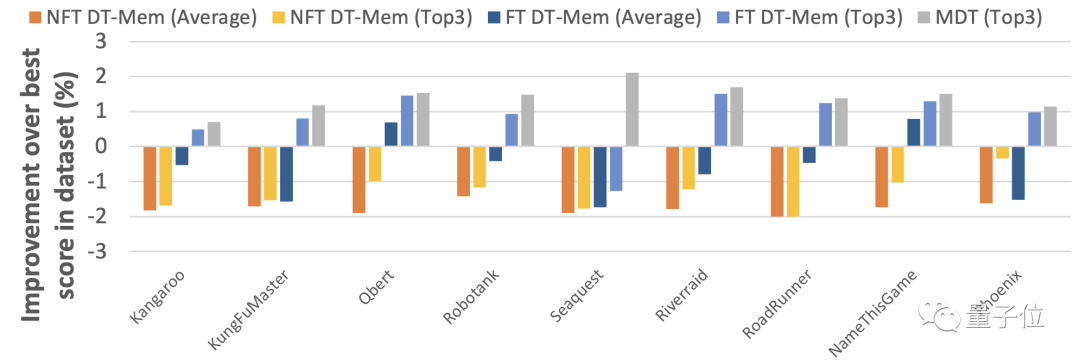

而针对团队提出的微调方式的测试结果也表明,这种微调增强了DT-Mem适应未知情景的能力。

需要说明的是,下表中用来测试的游戏对于MDT来说是已知的,因此MDT的表现在这一轮当中不作为衡量依据。

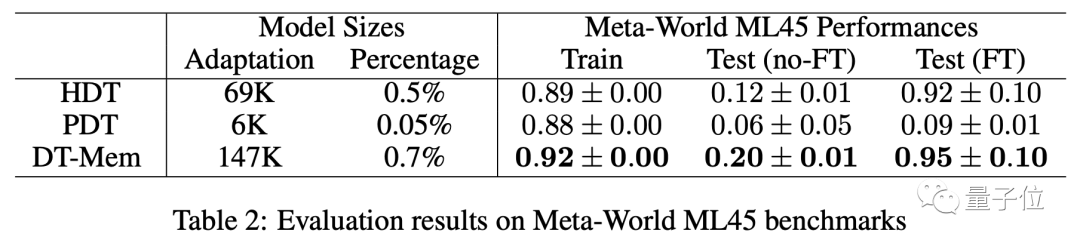

除了玩游戏,团队还使用了Meta-World ML45基准对DT-Mem进行了测试。

这次用作参照的是H[yper]DT和P[romot]DT。

结果显示,未经微调的模型当中,DT-Mem成绩比HDT高出8个百分点。

需要说明的是,这里测试的HDT本身参数量虽然只有69K,但需依赖于2.3M参数量的预训练模型,因此实际的参数量是DT-Mem(147K)的10余倍。

论文地址:https://arxiv.org/abs/2305.16338

以上是AI模仿人脑记忆模式,游戏成绩大涨29.9%的详细内容。更多信息请关注PHP中文网其他相关文章!

拥抱面部是否7B型号奥林匹克赛车击败克劳德3.7?Apr 23, 2025 am 11:49 AM

拥抱面部是否7B型号奥林匹克赛车击败克劳德3.7?Apr 23, 2025 am 11:49 AM拥抱Face的OlympicCoder-7B:强大的开源代码推理模型 开发以代码为中心的语言模型的竞赛正在加剧,拥抱面孔与强大的竞争者一起参加了比赛:OlympicCoder-7B,一种产品

4个新的双子座功能您可以错过Apr 23, 2025 am 11:48 AM

4个新的双子座功能您可以错过Apr 23, 2025 am 11:48 AM你们当中有多少人希望AI可以做更多的事情,而不仅仅是回答问题?我知道我有,最近,我对它的变化感到惊讶。 AI聊天机器人不仅要聊天,还关心创建,研究

Camunda为经纪人AI编排编写了新的分数Apr 23, 2025 am 11:46 AM

Camunda为经纪人AI编排编写了新的分数Apr 23, 2025 am 11:46 AM随着智能AI开始融入企业软件平台和应用程序的各个层面(我们必须强调的是,既有强大的核心工具,也有一些不太可靠的模拟工具),我们需要一套新的基础设施能力来管理这些智能体。 总部位于德国柏林的流程编排公司Camunda认为,它可以帮助智能AI发挥其应有的作用,并与新的数字工作场所中的准确业务目标和规则保持一致。该公司目前提供智能编排功能,旨在帮助组织建模、部署和管理AI智能体。 从实际的软件工程角度来看,这意味着什么? 确定性与非确定性流程的融合 该公司表示,关键在于允许用户(通常是数据科学家、软件

策划的企业AI体验是否有价值?Apr 23, 2025 am 11:45 AM

策划的企业AI体验是否有价值?Apr 23, 2025 am 11:45 AM参加Google Cloud Next '25,我渴望看到Google如何区分其AI产品。 有关代理空间(此处讨论)和客户体验套件(此处讨论)的最新公告很有希望,强调了商业价值

如何为抹布找到最佳的多语言嵌入模型?Apr 23, 2025 am 11:44 AM

如何为抹布找到最佳的多语言嵌入模型?Apr 23, 2025 am 11:44 AM为您的检索增强发电(RAG)系统选择最佳的多语言嵌入模型 在当今的相互联系的世界中,建立有效的多语言AI系统至关重要。 强大的多语言嵌入模型对于RE至关重要

麝香:奥斯汀的机器人需要每10,000英里进行干预Apr 23, 2025 am 11:42 AM

麝香:奥斯汀的机器人需要每10,000英里进行干预Apr 23, 2025 am 11:42 AM特斯拉的Austin Robotaxi发射:仔细观察Musk的主张 埃隆·马斯克(Elon Musk)最近宣布,特斯拉即将在德克萨斯州奥斯汀推出的Robotaxi发射,最初出于安全原因部署了一支小型10-20辆汽车,并有快速扩张的计划。 h

AI震惊的枢轴:从工作工具到数字治疗师和生活教练Apr 23, 2025 am 11:41 AM

AI震惊的枢轴:从工作工具到数字治疗师和生活教练Apr 23, 2025 am 11:41 AM人工智能的应用方式可能出乎意料。最初,我们很多人可能认为它主要用于代劳创意和技术任务,例如编写代码和创作内容。 然而,哈佛商业评论最近报道的一项调查表明情况并非如此。大多数用户寻求人工智能的并非是代劳工作,而是支持、组织,甚至是友谊! 报告称,人工智能应用案例的首位是治疗和陪伴。这表明其全天候可用性以及提供匿名、诚实建议和反馈的能力非常有价值。 另一方面,营销任务(例如撰写博客、创建社交媒体帖子或广告文案)在流行用途列表中的排名要低得多。 这是为什么呢?让我们看看研究结果及其对我们人类如何继续将

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

螳螂BT

Mantis是一个易于部署的基于Web的缺陷跟踪工具,用于帮助产品缺陷跟踪。它需要PHP、MySQL和一个Web服务器。请查看我们的演示和托管服务。

SublimeText3汉化版

中文版,非常好用

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),