作为人工智能的三要素之一,数据的作用举足轻重。

但大家有没有想过:假如有一天,全世界的数据都用完了那咋整?

实际上,提出这个问题的人绝对没有精神问题,因为这一天——可能真的快来了!!!

近日,研究员Pablo Villalobos等人一篇名为《我们会用完数据吗?机器学习中数据集缩放的局限性分析》的论文,发表在了arXiv上。

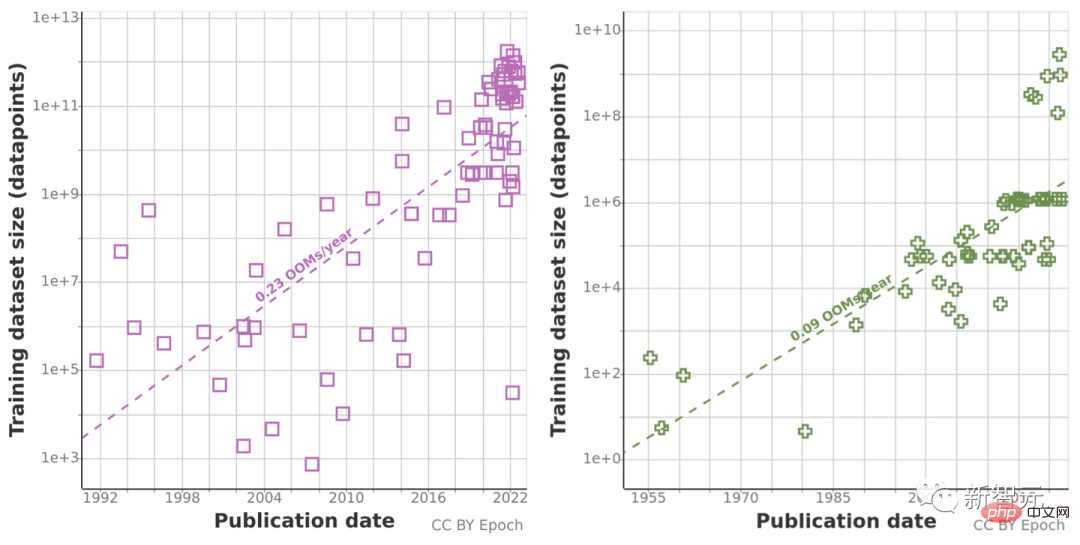

他们根据之前对数据集大小趋势的分析,预测了语言和视觉领域数据集大小的增长,估计了未来几十年可用未标记数据总存量的发展趋势。

他们的研究表明:最早在2026年,高质量语言数据就将全部消耗殆尽!机器学习发展的速度也将因此而放缓。实在不容乐观。

两方法双管齐下,结果不容乐观

这篇论文的研究团队由11名研究员和3位顾问组成,成员遍布世界各地,致力于缩小AI技术发展与AI战略之间的差距,并为AI安全方面的关键决策者提供建议。

Chinchilla是DeepMind的研究人员提出的一种新型预测计算优化模型。

实际上,此前在对Chinchilla进行实验时,就曾有研究员提出「训练数据很快就会成为扩展大型语言模型的瓶颈」。

因此他们分析了用于自然语言处理和计算机视觉的机器学习数据集大小的增长,并使用了两种方法进行推断:使用历史增长率,并为未来预测的计算预算估计计算最佳数据集大小。

在此之前,他们一直在收集有关机器学习输入趋势的数据,包括一些训练数据等,还通过估计未来几十年互联网上可用未标记数据的总存量,来调查数据使用增长。

由于历史预测趋势可能会受过去十年计算量异常增长的「误导」,研究团队还使用了Chinchilla缩放定律,来估计未来几年的数据集大小,提升计算结果的准确性。

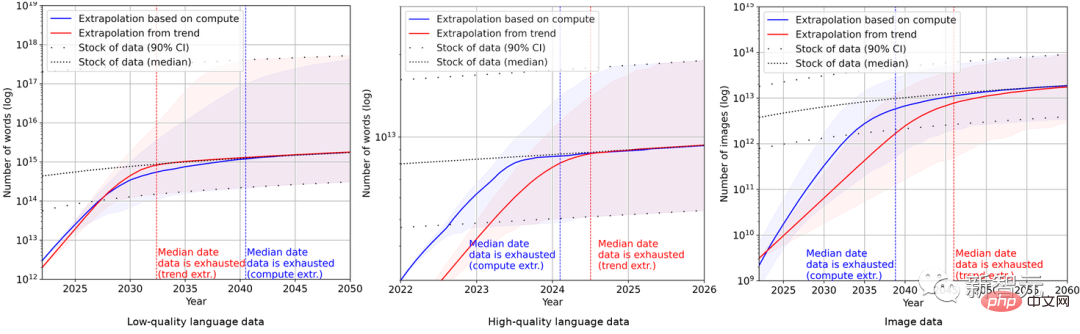

最终,研究人员使用一系列概率模型估计未来几年英语语言和图像数据的总存量,并比较了训练数据集大小和总数据库存的预测,结果如下图所示。

这说明数据集的增长速度将远快于数据存量。

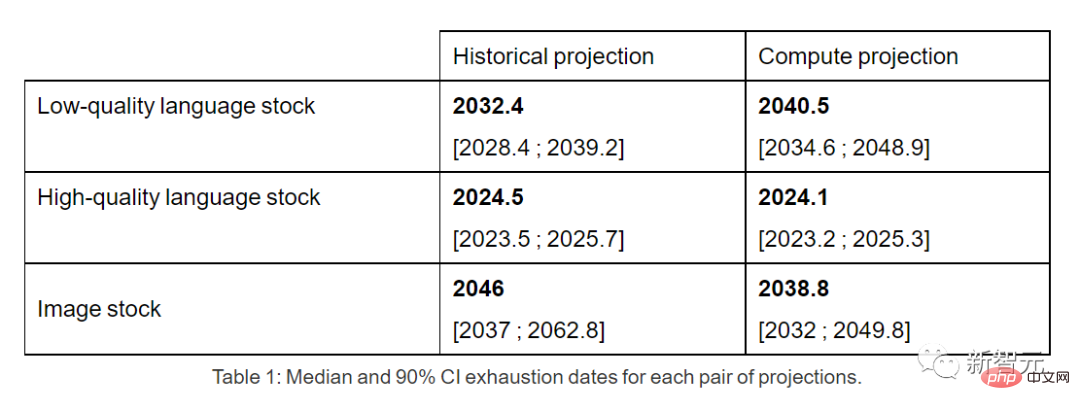

因此,如果当前趋势继续保持下去,数据存量被用光将是不可避免的。下表则显示了预测曲线上每个交叉点的中值耗尽年数。

高质量的语言数据库存最早可能在2026年之前用尽。

相比之下,低质量的语言数据和图像数据情况略好:前者将在2030年至2050年间用光,后者将在2030年至2060年之间。

在论文的最后,研究团队给出结论:如果数据效率没有大幅提高或新的数据来源可用,当前依赖巨大数据集不断膨胀的机器学习模型,它的增长趋势很可能会放缓。

网友:杞人忧天,Efficient Zero了解一下

不过在这篇文章的评论区里,大多数网友却认为作者杞人忧天。

Reddit上,一位名为ktpr的网友表示:

「自我监督学习有啥毛病么?如果任务指定得好,它甚至可以组合扩展数据集大小。」

名为lostmsn的网友则更加不客气。他直言:

「Efficient Zero都不了解一下?我认为作者已经严重脱离时代了。」

Efficient Zero是一种能高效采样的强化学习算法,由清华大学的高阳博士提出。

在数据量有限的情况下,Efficient Zero一定程度上解决了强化学习的性能问题,并在算法通用测试基准Atari Game上获得了验证。

在这篇论文作者团队的博客上,就连他们自己也坦言:

「我们所有的结论都基于不切实际的假设,即当前机器学习数据使用和生产的趋势将继续保持下去,并且数据效率不会有重大提升。」

「一个更加靠谱的模型应该考虑到机器学习数据效率的提高、合成数据的使用以及其他算法和经济因素。」

「因此就实际情况来说,这种分析有严重的局限性。模型的不确定性非常高。」

「不过总体而言,我们仍认为由于缺乏训练数据,到2040年时机器学习模型的扩展有大约有20%的可能性会显著放缓。」

以上是全球优质语言数据存量告急,不容忽视的详细内容。更多信息请关注PHP中文网其他相关文章!

软AI的兴起及其对当今企业的意义Apr 15, 2025 am 11:36 AM

软AI的兴起及其对当今企业的意义Apr 15, 2025 am 11:36 AM软AI(被定义为AI系统,旨在使用近似推理,模式识别和灵活的决策执行特定的狭窄任务 - 试图通过拥抱歧义来模仿类似人类的思维。 但是这对业务意味着什么

为AI前沿的不断发展的安全框架Apr 15, 2025 am 11:34 AM

为AI前沿的不断发展的安全框架Apr 15, 2025 am 11:34 AM答案很明确 - 只是云计算需要向云本地安全工具转变,AI需要专门为AI独特需求而设计的新型安全解决方案。 云计算和安全课程的兴起 在

生成AI的3种方法放大了企业家:当心平均值!Apr 15, 2025 am 11:33 AM

生成AI的3种方法放大了企业家:当心平均值!Apr 15, 2025 am 11:33 AM企业家,并使用AI和Generative AI来改善其业务。同时,重要的是要记住生成的AI,就像所有技术一样,都是一个放大器 - 使得伟大和平庸,更糟。严格的2024研究O

Andrew Ng的新简短课程Apr 15, 2025 am 11:32 AM

Andrew Ng的新简短课程Apr 15, 2025 am 11:32 AM解锁嵌入模型的力量:深入研究安德鲁·NG的新课程 想象一个未来,机器可以完全准确地理解和回答您的问题。 这不是科幻小说;多亏了AI的进步,它已成为R

大语言模型(LLM)中的幻觉是不可避免的吗?Apr 15, 2025 am 11:31 AM

大语言模型(LLM)中的幻觉是不可避免的吗?Apr 15, 2025 am 11:31 AM大型语言模型(LLM)和不可避免的幻觉问题 您可能使用了诸如Chatgpt,Claude和Gemini之类的AI模型。 这些都是大型语言模型(LLM)的示例,在大规模文本数据集上训练的功能强大的AI系统

60%的问题 - AI搜索如何消耗您的流量Apr 15, 2025 am 11:28 AM

60%的问题 - AI搜索如何消耗您的流量Apr 15, 2025 am 11:28 AM最近的研究表明,根据行业和搜索类型,AI概述可能导致有机交通下降15-64%。这种根本性的变化导致营销人员重新考虑其在数字可见性方面的整个策略。 新的

麻省理工学院媒体实验室将人类蓬勃发展成为AI R&D的核心Apr 15, 2025 am 11:26 AM

麻省理工学院媒体实验室将人类蓬勃发展成为AI R&D的核心Apr 15, 2025 am 11:26 AM埃隆大学(Elon University)想象的数字未来中心的最新报告对近300名全球技术专家进行了调查。由此产生的报告“ 2035年成为人类”,得出的结论是,大多数人担心AI系统加深的采用

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

WebStorm Mac版

好用的JavaScript开发工具

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器