不知不觉间,大模型+小样本成为了小样本学习领域的主流打法,在许多的任务背景下,一套通用的思路是先标注小数据样本,再从预训练大模型的基础上使用小数据样本进行训练。尽管如我们所见,大模型在一众小样本学习的任务上都取得了惊人的效果,但是它也自然而然的将一些大模型固有的弊病放置在了小样本学习的聚光灯下。

小样本学习期望模型具有依据少量样本完成自主推理的能力,也就是说理想中的模型应该通过做题而掌握解题思路,从而面对新出现的题可以举一反三。然而大模型+小样本的理想且实用的学习能力,似乎却是靠大模型训练期间储存的大量信息来生生把一道题解设答的过程背诵下来,尽管在各个数据集上神勇无比,但总会给人带来疑惑依照这种方法学习出来的学生真的是一个有潜力的学生吗?

而今天介绍的这篇由 Meta AI 推出的论文,便另辟蹊径的将检索增强的方法应用于小样本学习领域,不仅仅用64个示例便在自然问答数据集(Natural Questions)上取得了42%的正确率,同时还对标大模型 PaLM 将参数量减少了 50 倍(540B—>11B),并且在可解释性、可控性、可更新性等方面上都具有其余大模型所不具备的显著优势。

论文题目:Few-shot Learning with Retrieval Augmented Language Models论文链接:https://arxiv.org/pdf/2208.03299.pdf

检索增强溯源

论文一开始,便向大家抛出了一个问题:“在小样本学习领域,使用巨量的参数去存储信息真的是必要的吗?”,纵观大模型的发展,前仆后继的大模型可以乐此不疲的刷SOTA的原因之一,便是其庞大的参数存储了问题所需的信息。从 Transformer 横空出世以来,大模型一直是 NLP 领域的主流范式,而随着大模型的逐步发展,“大”的问题不断暴露,追问所谓“大”的必要性便相当有意义,论文作者从这个问题出发,给予了这个问题否定的答案,而其方法,便是检索增强模型。

溯源检索增强,其实尽管其技术主要被应用于诸如开放域问答、机器阅读以及文本生成等任务之中,但是检索增强的思想可以一直上溯到 NLP 的 RNN 时代。RNN 模型无法解决数据长期依赖关系的硬伤促使研究者们开始广泛探索解决之道,而我们相当熟悉的 Transformer 便使用 Attention 机制有效解决了这个模型记不住的问题,从而开启了预训练大模型的时代。

而在当时,其实还有另外一条路子,便是 Cached LM,它的核心思想在于,既然 RNN 一上考场就有可能记不住,那么干脆就让 RNN 开卷考试,通过引入 Cache 机制,把训练时预测的词语存在 Cache 中,预测时便可以结合 query 与 Cache 索引两方面的信息来完成任务,从而解决当时 RNN 模型的硬伤。

由此,检索增强技术便走上了一条与大模型依赖参数记忆信息的迥然不同的道路。基于检索增强的模型允许引入不同来源的外部知识,而这些检索源有训练语料、外部数据、无监督数据等多种选择。检索增强模型一般由一个检索器与一个生成器构成,通过检索器根据 query 从外部检索源获得相关知识,通过生成器结合 query 与检索到的相关知识进行模型预测。

归根结底,检索增强模型的目标是期望模型不仅学会记忆数据,同时希望模型学会自己找到数据,这点特性在许多知识密集型的任务中具有极大的优势并且检索增强模型也在这些领域取得了巨大的成功,但是检索增强是否适用于小样本学习却不得而知。回到 Meta AI 的这篇论文,便成功试验了检索增强在小样本学习中的应用,Atlas 便应运而生。

模型结构

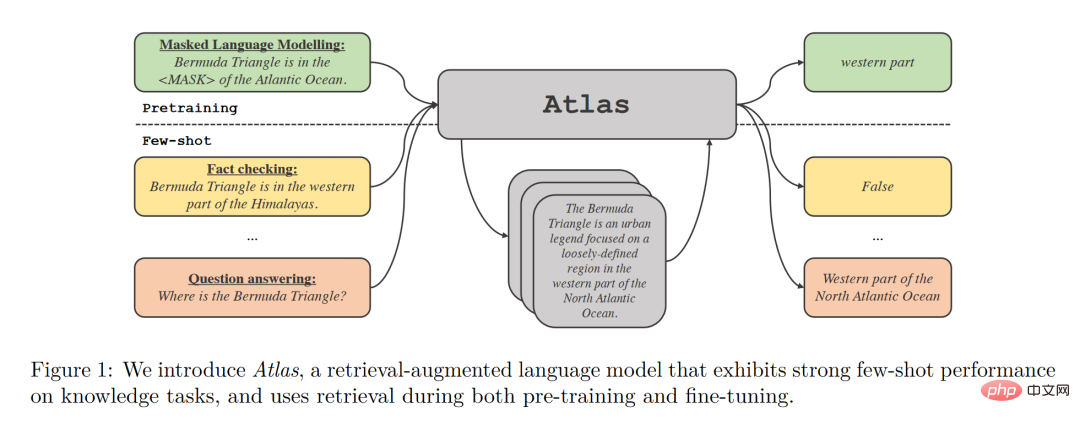

Atlas 拥有两个子模型,一个检索器与一个语言模型。当面对一个任务时,Atlas 依据输入的问题使用检索器从大量语料中生成出最相关的 top-k 个文档,之后将这些文档与问题 query 一同放入语言模型之中,进而产生出所需的输出。

Atlas 模型的基本训练策略在于,将检索器与语言模型使用同一损失函数共同训练。检索器与语言模型都基于预训练的 Transformer 网络,其中:

- 检索器基于 Contriever 设计,Contriever 通过无监督数据进行预训练,使用两层编码器,query 与 document 被独立的编码入编码器中,并通过相应输出的点乘获得 query 与 document 的相似度。这种设计使得 Atlas 可以在没有文档标注的情况下训练检索器,从而显著降低内存需求。

- 语言模型基于 T5 进行训练,将不同文档与 query 相互拼接,由编码器分别独立处理,最后,解码器对于所有检索的段落串联进行 Cross-Attention 得到最后的输出。这种 Fusion-in-Decoder 的方法有利于 Atlas 有效的适应文档数量的扩展。

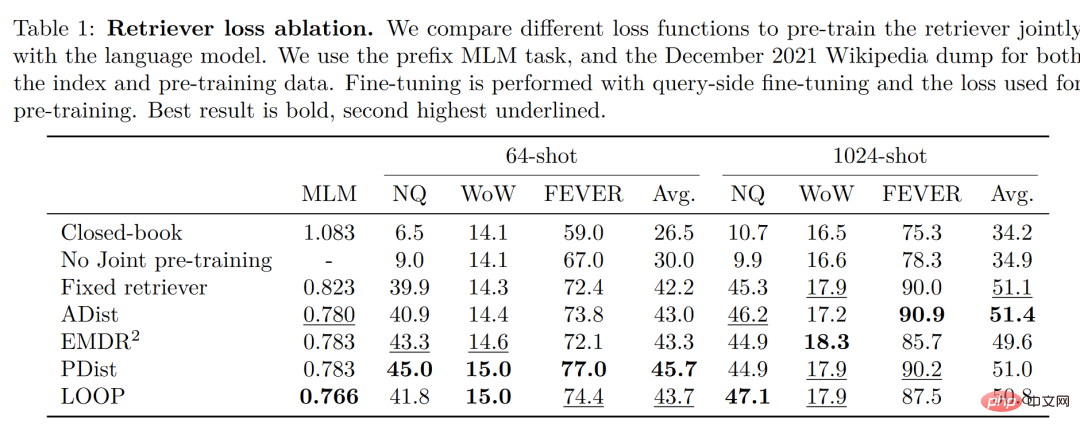

值得注意的是,作者对比试验了四种损失函数以及不做检索器与语言模型联合训练的情况,结果如下图:

可以看出,在小样本环境下,使用联合训练的方法所得到的正确率显著高于不使用联合训练的正确率,因此,作者得出结论,检索器与语言模型的这种共同训练是 Atlas 获得小样本学习能力的关键。

实验结果

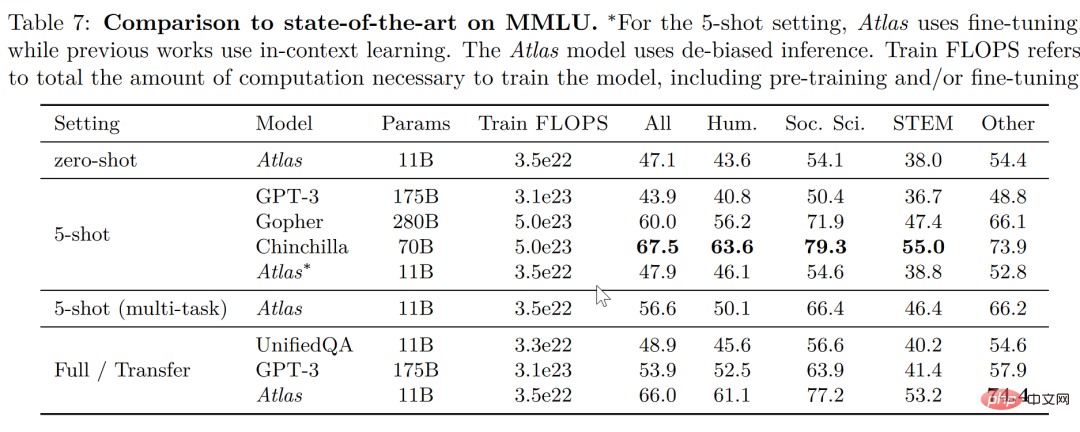

在大规模多任务语言理解任务(MMLU) 中,对比其他模型,Atlas 在参数量只有 11B 的情况下,具有比 15 倍于 Atlas 参数量的 GPT-3 更好的正确率,在引入多任务训练后,在 5-shot 测试上正确率甚至逼近了 25 倍于 Atlas 参数量的 Gopher。

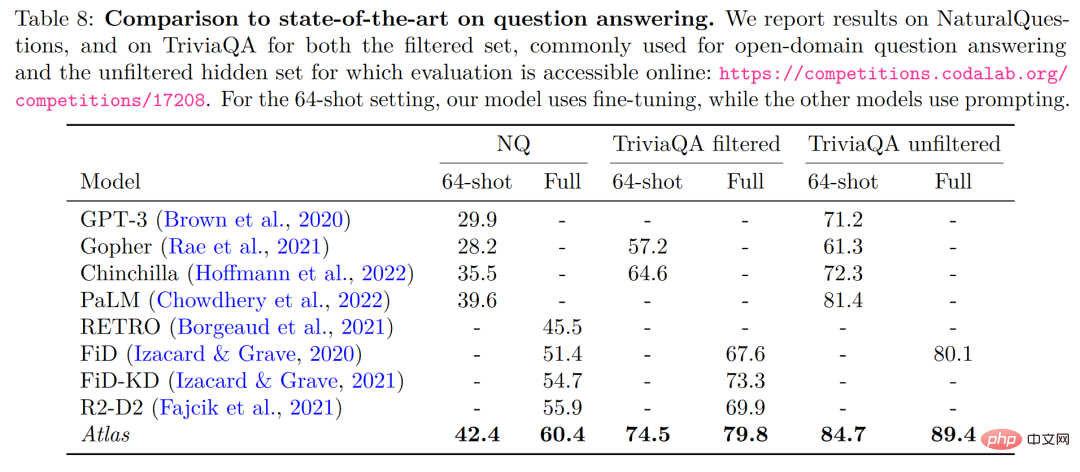

在开放域问答的两个测试数据——NaturalQuestions 以及 TriviaQA 中,对比了 Atlas 与其他模型在 64 个例子上的表现以及全训练集上的表现如下图所示,Atlas 在 64-shot 中取得了新的 SOTA,在 TrivuaQA 上仅用 64 个数据便实现了 84.7% 的准确率。

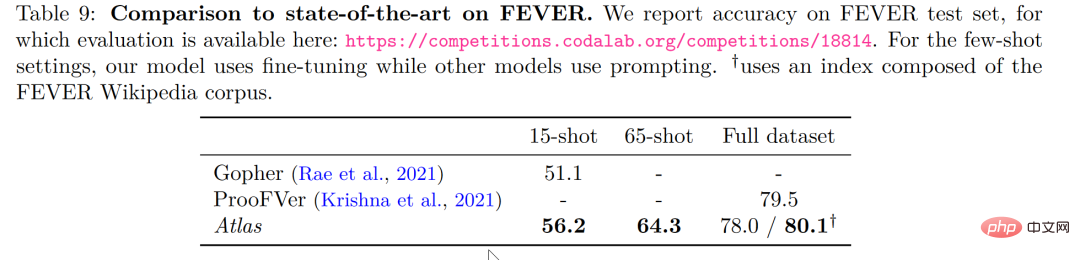

在事实核查任务(FEVER)中,Atlas 在小样本的表现也显著优于参数量数十倍于 Atlas 的 Gopher 与 ProoFVer,在 15-shot 的任务中,超出了 Gopher 5.1%。

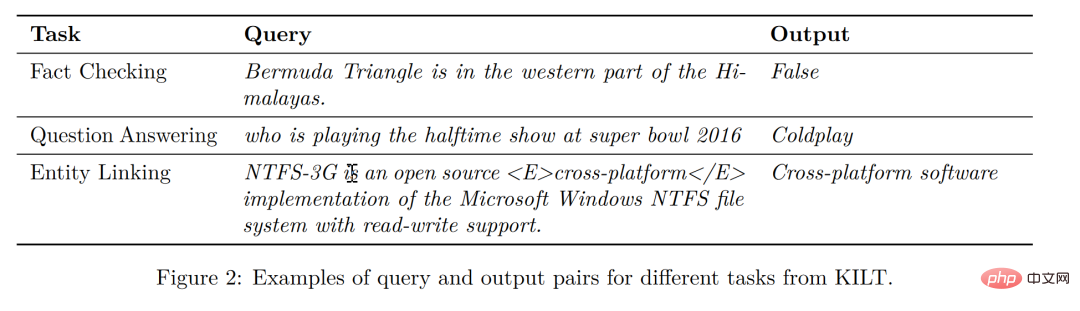

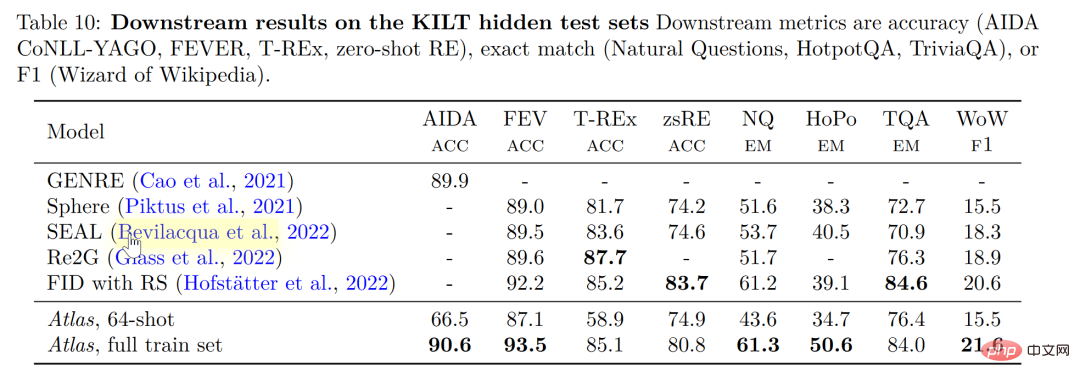

在自家发布的知识密集型自然语言处理任务基准 KILT 上,在一些任务里使用 64 个样本训练的 Atlas 的正确率甚至接近了其他模型使用全样本所获得的正确率,在使用全样本训练 Atlas 后,Atlas 在五个数据集上都刷新了 SOTA。

可解释性、可控性、可更新性

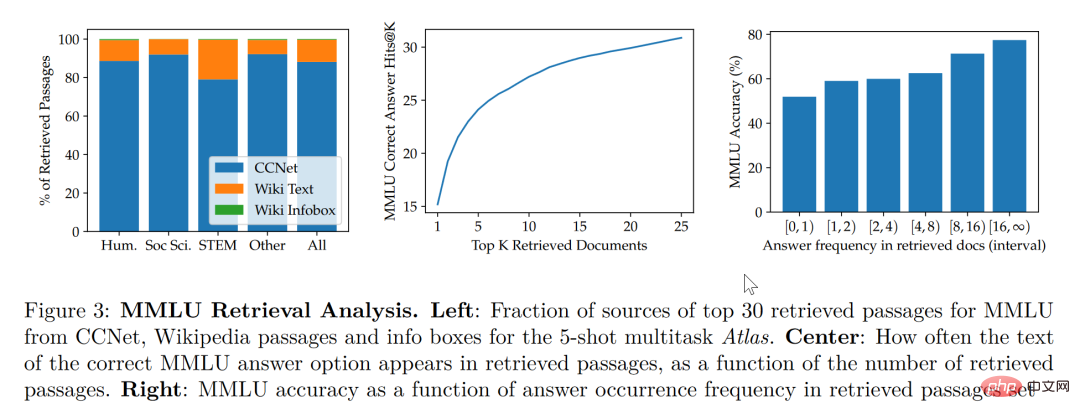

根据这篇论文的研究,检索增强模型不仅兼顾了更小与更好,同时在可解释性方面也拥有其他大模型不具备的显著优势。大模型的黑箱属性,使得研究者很难以利用大模型对模型运行机理进行分析,而检索增强模型可以直接提取其检索到的文档,从而通过分析检索器所检索出的文章,可以获得对 Atlas 工作更好的理解。譬如,论文发现,在抽象代数领域,模型的语料有 73% 借助了维基百科,而在道德相关领域,检索器提取的文档只有3%来源于维基百科,这一点与人类的直觉相符合。如下图左边的统计图,尽管模型更偏好使用 CCNet 的数据,但是在更注重公式与推理的 STEM 领域,维基百科文章的使用率明显上升。

而根据上图右边的统计图作者发现,随着检索出的文章中包含正确答案的次数的升高,模型准确率也不断上升,在文章不包含答案时正确只有 55%,而在答案被提到超过 15 次时,正确率来到了 77%。除此之外,在人为检查了 50 个检索器检索出的文档时,发现其中有 44% 均包含有用的背景信息,显然,这些包含问题背景信息的资料可以为研究者扩展阅读提供很大的帮助。

一般而言,我们往往会认为大模型存在训练数据“泄露”的风险,即有时大模型针对测试问题的回答并非基于模型的学习能力而是基于大模型的记忆能力,也就是说在大模型学习的大量语料中泄露了测试问题的答案,而在这篇论文中,作者通过人为剔除可能会发生泄露的语料信息后,模型正确率从56.4%下降到了55.8%,仅仅下降0.6%,可以看出检索增强的方法可以有效的规避模型作弊的风险。

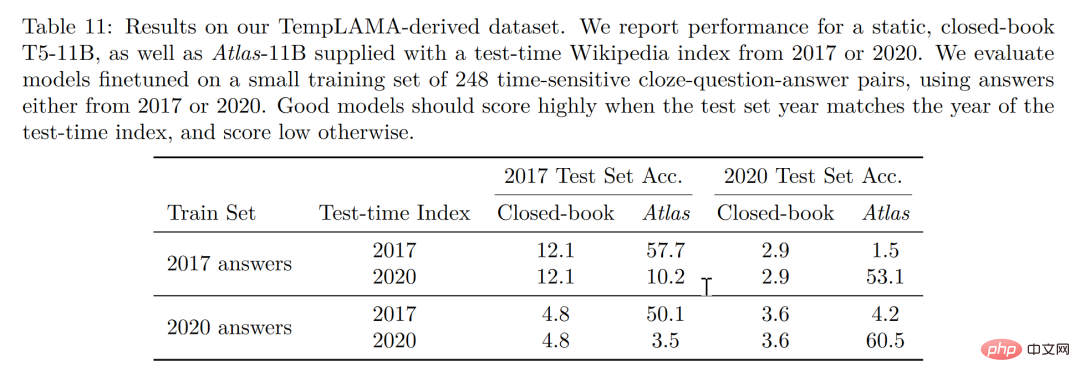

最后,可更新性也是检索增强模型的一大独特优势,检索增强模型可以无需重新训练而只需更新或替换其依托的语料库实现模型的时时更新。作者通过构造时序数据集,如下图所示,在不更新 Atlas 参数的情况下,仅仅通过使用 2020 年的语料库 Atlas 便实现了 53.1% 的正确率,而有趣的是即使是用2020年的数据微调 T5 ,T5 也没有很好的表现,作者认为,原因很大程度上是由于 T5 的预训练使用的数据是 2020 年以前的数据。

结论

我们可以想象有三个学生,一个学生解题只靠死记硬背,一道数学题可以把答案分毫不差的背诵下来,一个学生就靠查书,遇到不会先去翻找资料找到最合适的再一一作答,而最后一个学生则天资聪明,简单的学习一些教科书上的知识便可以自信去考场挥毫泼墨指点江山。

显然,小样本学习的理想是成为第三个学生,而现实却很可能停留在了第一个学生之上。大模型很好用,但“大”绝不是模型最终的目的,回到小样本学习期望模型具有与人类相似的推理判断与举一反三能力的初心,那么我们可以看到,这篇论文是换个角度也好是前进一步也罢,至少是让那个学生可以轻松一点不往脑袋里装那么多可能大量冗余的知识,而可以拎起一本教科书轻装上阵,或许哪怕允许学生开卷考试带着教科书不断翻查,也会比学生生搬硬套死记硬背更接近智能吧!

以上是完爆GPT3、谷歌PaLM!检索增强模型Atlas刷新知识类小样本任务SOTA的详细内容。更多信息请关注PHP中文网其他相关文章!

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PM

烹饪创新:人工智能如何改变食品服务Apr 12, 2025 pm 12:09 PMAI增强食物准备 在新生的使用中,AI系统越来越多地用于食品制备中。 AI驱动的机器人在厨房中用于自动化食物准备任务,例如翻转汉堡,制作披萨或组装SA

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM

Python名称空间和可变范围的综合指南Apr 12, 2025 pm 12:00 PM介绍 了解Python功能中变量的名称空间,范围和行为对于有效编写和避免运行时错误或异常至关重要。在本文中,我们将研究各种ASP

视觉语言模型(VLMS)的综合指南Apr 12, 2025 am 11:58 AM

视觉语言模型(VLMS)的综合指南Apr 12, 2025 am 11:58 AM介绍 想象一下,穿过美术馆,周围是生动的绘画和雕塑。现在,如果您可以向每一部分提出一个问题并获得有意义的答案,该怎么办?您可能会问:“您在讲什么故事?

联发科技与kompanio Ultra和Dimenty 9400增强优质阵容Apr 12, 2025 am 11:52 AM

联发科技与kompanio Ultra和Dimenty 9400增强优质阵容Apr 12, 2025 am 11:52 AM继续使用产品节奏,本月,Mediatek发表了一系列公告,包括新的Kompanio Ultra和Dimenty 9400。这些产品填补了Mediatek业务中更传统的部分,其中包括智能手机的芯片

本周在AI:沃尔玛在时尚趋势之前设定了时尚趋势Apr 12, 2025 am 11:51 AM

本周在AI:沃尔玛在时尚趋势之前设定了时尚趋势Apr 12, 2025 am 11:51 AM#1 Google推出了Agent2Agent 故事:现在是星期一早上。作为AI驱动的招聘人员,您更聪明,而不是更努力。您在手机上登录公司的仪表板。它告诉您三个关键角色已被采购,审查和计划的FO

生成的AI遇到心理摩托车Apr 12, 2025 am 11:50 AM

生成的AI遇到心理摩托车Apr 12, 2025 am 11:50 AM我猜你一定是。 我们似乎都知道,心理障碍包括各种chat不休,这些chat不休,这些chat不休,混合了各种心理术语,并且常常是难以理解的或完全荒谬的。您需要做的一切才能喷出fo

原型:科学家将纸变成塑料Apr 12, 2025 am 11:49 AM

原型:科学家将纸变成塑料Apr 12, 2025 am 11:49 AM根据本周发表的一项新研究,只有在2022年制造的塑料中,只有9.5%的塑料是由回收材料制成的。同时,塑料在垃圾填埋场和生态系统中继续堆积。 但是有帮助。一支恩金团队

AI分析师的崛起:为什么这可能是AI革命中最重要的工作Apr 12, 2025 am 11:41 AM

AI分析师的崛起:为什么这可能是AI革命中最重要的工作Apr 12, 2025 am 11:41 AM我最近与领先的企业分析平台Alteryx首席执行官安迪·麦克米伦(Andy Macmillan)的对话强调了这一在AI革命中的关键但不足的作用。正如Macmillan所解释的那样,原始业务数据与AI-Ready Informat之间的差距

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

Atom编辑器mac版下载

最流行的的开源编辑器

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器