越来越多的工作证明了预训练语言模型(PLM)中蕴含着丰富的知识,针对不同的任务,用合适的训练方式来撬动 PLM,能更好地提升模型的能力。在 Text-to-SQL 任务中,目前主流的生成器是基于语法树的,需要针对 SQL 语法进行设计。

近期,网易互娱 AI Lab 联合广东外语外贸大学和哥伦比亚大学基于预训练语言模型 T5 的预训练方式,提出了两阶段的多任务预训练模型 MIGA。MIGA 在预训练阶段引入三个辅助任务,并将他们组织成统一的生成任务范式,可以将所有的 Text-to-SQL 数据集统一进行训练;同时在微调阶段,MIGA 针对多轮对话中的错误传递问题进行 SQL 扰动,提升了模型生成的鲁棒性。

目前对于 Text-to-SQL 的研究,主流的方法主要是基于 SQL 语法树的 encoder-decoder 模型,可以确保生成的结果一定符合 SQL 语法,但是需要针对 SQL 语法进行特殊设计。最近也有一些关于 Text-to-SQL 的研究是基于生成式语言模型,可以很方便地继承预训练语言模型的知识和能力。

为了降低对基于语法树的依赖,更好地挖掘预训练语言模型的能力,该研究在预训练 T5 模型的框架下,提出了一个两阶段的多任务 Text-to-SQL 预训练模型 MIGA (MultI-task Generation frAmework)。

MIGA 分为两阶段的训练过程:

- 在预训练阶段,MIGA 使用与 T5 相同的预训练范式,额外提出了三个与 Text-to-SQL 相关的辅助任务,从而更好地激发预训练语言模型中的知识。该训练方式可以将所有的 Text-to-SQL 的数据集进行统一,扩充了训练数据的规模;而且也可以灵活地去设计更多有效的辅助任务,进一步发掘预训练语言模型的潜在知识。

- 在微调阶段,MIGA 针对多轮对话和 SQL 中容易存在的错误传递问题,在训练过程中对历史 SQL 进行扰动,使得生成当前轮次的 SQL 效果更加稳定。

MIGA 模型在两个多轮对话 Text-to-SQL 公开数据集上表现优于目前最好的基于语法树的模型,相关研究已经被 AAAI 2023 录用。

论文地址:https://arxiv.org/abs/2212.09278

MIGA 模型细节

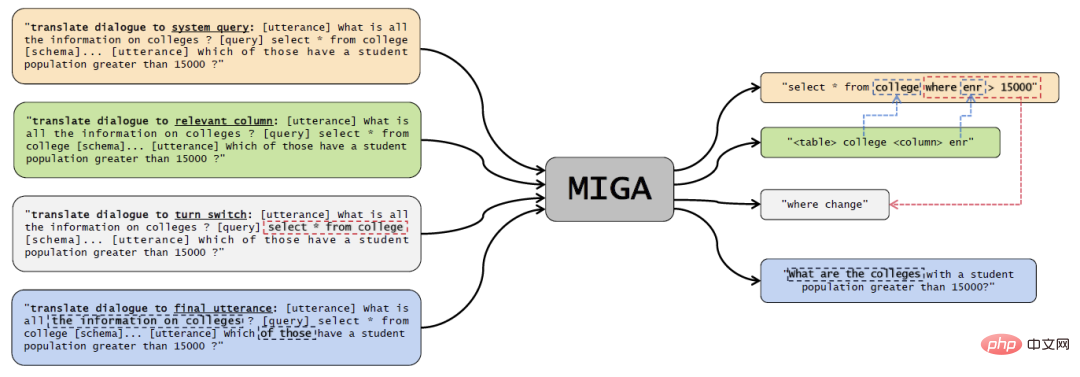

图 1 MIGA 模型图。

多任务预训练阶段

该研究主要参考 T5 的预训练方式,基于已经训练好的 T5 模型,设计了四个预训练任务:

- Text-to-SQL 主任务:上图中的黄色部分,通过设计 Prompt 为”translate dialogue to system query”,然后以一些 special tokens 来将历史对话、数据库信息和 SQL 语句拼接输入到 T5-encoder 中,让 decoder 直接输出对应的 SQL 语句;

- 相关信息预测:上图中的绿色部分,设计 Prompt 为”translate dialogue to relevant column”,T5-encoder 的输入也是与主任务一致,decoder 则需要输出与当前问题相关的数据表和列,目的是加强模型对 Text-to-SQL 的理解;

- 当前轮次的操作预测:上图中的灰色部分,设计 Prompt 为”translate dialogue to turn switch”,这个任务主要是针对多轮对话中的上下文理解进行设计,对比上一轮的对话和 SQL,decoder 需要输出当前对话的目的做了哪些变化,比如图中例子是 where 条件进行了改动;

- 最终对话预测:上图中的蓝色部分,设计 Prompt 为”translate dialogue to final utterance”,目的是为了让模型去更好的理解上下文对话,需要 decoder 输出整个多轮对话下来,最后时刻的 SQL 对应的一句完整问题描述。

通过这样的一个统一的训练方式设计,MIGA 可以通用而又灵活地去处理更多与任务相关的额外任务,而且还有一下优点:

- 参考人类编写 SQL 的步骤,对话文本到 SQL 任务被分解为多个子任务,允许主任务从中学习;

- 训练样本的构造格式与 T5 一致,可以最大限度地发挥预训练 T5 模型对目标任务的潜力;

- 统一的框架允许多个辅助任务的灵活调度。当应用于特定任务时,仅需在特定任务的标记数据中使用相同的训练目标对上面的预训练模型进行微调即可。

在预训练阶段,该研究整合了 Text-to-SQL 数据集 Spider 和对话 Text-to-SQL 数据集 SparC 和 CoSQL 的数据来训练 T5 模型。

微调阶段

在预训练阶段之后,该研究针对目标任务的标注数据,单纯使用 Text-to-SQL 任务来进一步微调模型。该研究在预测当前轮次的 SQL 时,会拼接之前轮次的预测 SQL,在此过程中,为了尽量克服多轮对话和生成中所带来的错误传递问题,该研究提出了 SQL 扰动的方案,对输入数据中的历史轮次 SQL,以 α 概率来进行扰动。SQL 语句的扰动主要以 β 的概率采样相应的 token,然后进行以下其一的扰动:

- 用相同数据表中的列,来随机修改或者新增 SELECT 部分中的列;

- 随机修改 JOIN 条件中的结构,比如交换两个表的位置;

- 修改”*” 所有列为一些其他的列;

- 交换”asc” 和”desc”。

上述的扰动是该研究在实验中统计发现最常见的一些错误传递导致的 SQL 生成错误情况,因此针对这些情况来进行扰动,降低模型关于这方面的依赖。

实验评估

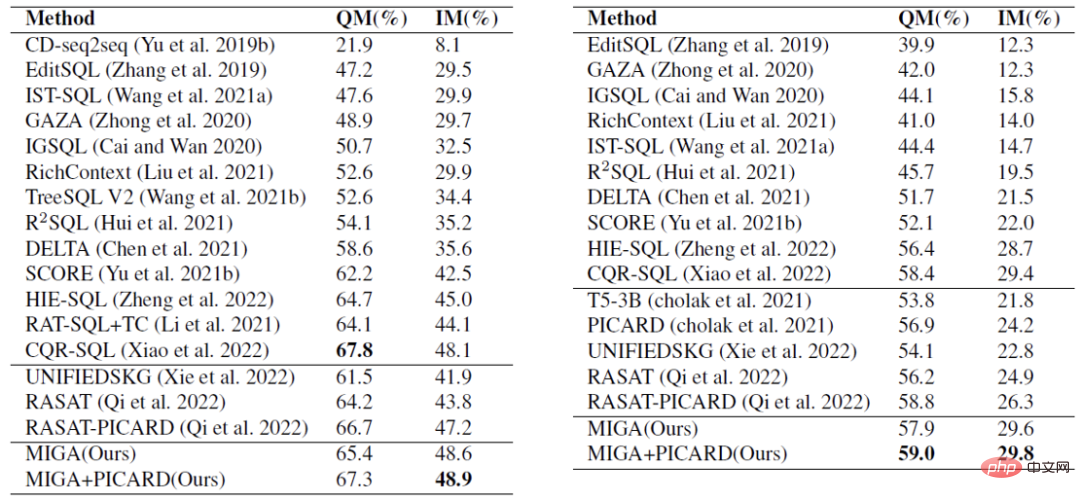

评估数据集为多轮对话 Text-to-SQL:SparC 和 CoSQL。

评估指标为:

- QM:Question Match,表示单轮问题中的生成的 SQL 与标注输出完全匹配的比例;

- IM:Interaction Match,表示多轮对话中整个完整轮次所有生成的 SQL 与标注输出完全匹配的比例。

在表 1 的对比实验中,MIGA 在两个数据集上的 IM 分数,以及 CoSQL 的 QM 分数上,超过了目前最好的多轮对话 Text-to-SQL 模型。而且对比同类型的基于 T5 的方案,MIGA 分别在 IM 上提升了 7.0% 和 QM 上提升了 5.8%。

表 1 对比实验分析,第一部分为树模型,第二部分为基于预训练生成模型。

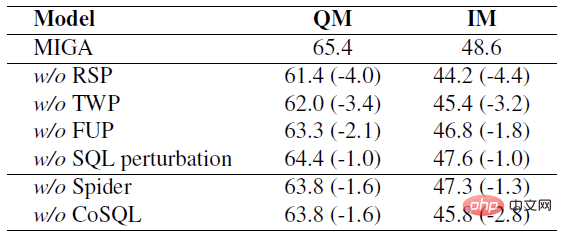

在表 2 的消融实验中,该研究对 MIGA 的两阶段训练过程中的几个任务进行了探索,同时证明了这些任务分别都会对目标任务有不同程度的提升。

表 2 针对 SparC 任务,分别去除各项任务或数据,在指标上都有所降低。

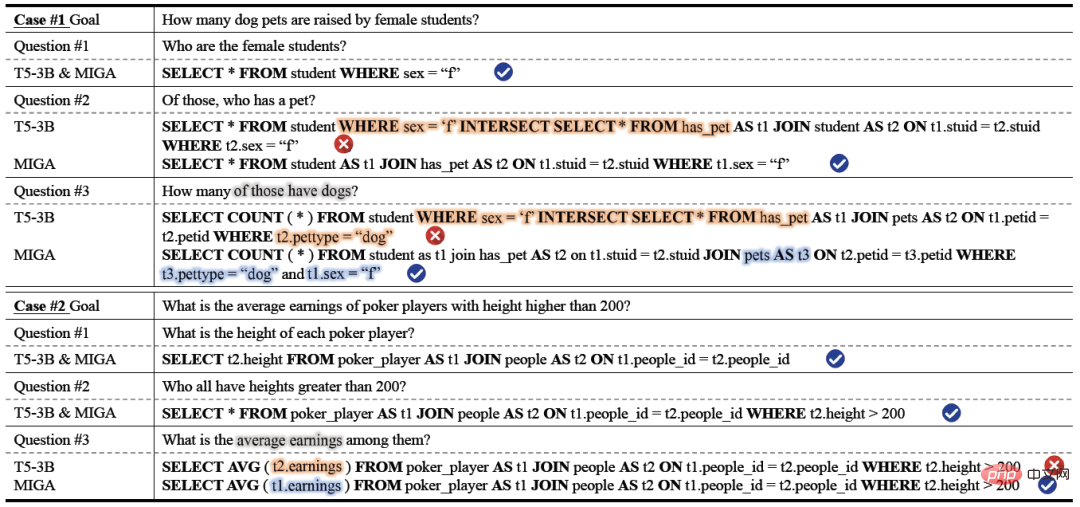

在实际的案例分析结果,MIGA 在生成的稳定性和正确性,对比基于 T5-3B 训练模型更好,可以看到 MIGA 在多表连接操作和列和表格的映射上要优于其他模型。在 Case#1 的 Question#2 中,T5-3B 模型不能为相对复杂的 JOIN 结构(两表连接)生成有效的 SQL,进而导致 Question#3 中更复杂的 JOIN 结构(三表连接)也预测错误。而 MIGA 准确地预测了 JOIN 结构,并较好地维持了之前的条件 t1.sex="f"。在 Case#2 中,T5- 3B 混淆了不同表中的多个列,并将 earnings 误认为是 people 表的列,而 MIGA 可以正确识别该列属于 poker_player 表,并将其链接至 t1。

表 3 案例分析。

结语

网易互娱 AI Lab 针对 Text-to-SQL 提出了一个基于 T5 的两阶段的多任务预训练模型:MIGA。在预训练阶段,MIGA 将 Text-to-SQL 任务分解出了额外三个子任务,并将其统一为序列到序列的生成范式,从而更好地激发预训练 T5 模型。并且在微调阶段引入了 SQL 扰动机制,降低多轮 Text-to-SQL 生成场景下的错误传递带来的影响。

未来,研究团队会进一步探索更多有效的策略来撬动超大语言模型的能力,并且探索更优雅更有效的方式来进一步克服因为错误传递而导致的效果降低问题。

以上是基于T5的两阶段的多任务Text-to-SQL预训练模型MIGA的详细内容。更多信息请关注PHP中文网其他相关文章!

META的新AI助手:生产力助推器还是时间下沉?May 01, 2025 am 11:18 AM

META的新AI助手:生产力助推器还是时间下沉?May 01, 2025 am 11:18 AMMeta携手Nvidia、IBM和Dell等合作伙伴,拓展了Llama Stack的企业级部署整合。在安全方面,Meta推出了Llama Guard 4、LlamaFirewall和CyberSecEval 4等新工具,并启动了Llama Defenders计划,以增强AI安全性。此外,Meta还向10个全球机构(包括致力于改善公共服务、医疗保健和教育的初创企业)发放了总额150万美元的Llama Impact Grants。 由Llama 4驱动的全新Meta AI应用,被设想为Meta AI

80%的Zers将嫁给AI:研究May 01, 2025 am 11:17 AM

80%的Zers将嫁给AI:研究May 01, 2025 am 11:17 AM公司开创性的人类互动公司Joi AI介绍了“ AI-Iatsionship”一词来描述这些不断发展的关系。 Joi AI的关系治疗师Jaime Bronstein澄清说,这并不是要取代人类C

AI使互联网的机器人问题变得更糟。这家耗资20亿美元的创业公司在前线May 01, 2025 am 11:16 AM

AI使互联网的机器人问题变得更糟。这家耗资20亿美元的创业公司在前线May 01, 2025 am 11:16 AM在线欺诈和机器人攻击对企业构成了重大挑战。 零售商与机器人ho积产品,银行战斗帐户收购和社交媒体平台与模仿者的斗争。 AI的兴起加剧了这个问题,Rende

卖给机器人:将创造或破坏业务的营销革命May 01, 2025 am 11:15 AM

卖给机器人:将创造或破坏业务的营销革命May 01, 2025 am 11:15 AMAI代理人有望彻底改变营销,并可能超过以前技术转变的影响。 这些代理代表了生成AI的重大进步,不仅是处理诸如chatgpt之类的处理信息,而且还采取了Actio

计算机视觉技术如何改变NBA季后赛主持人May 01, 2025 am 11:14 AM

计算机视觉技术如何改变NBA季后赛主持人May 01, 2025 am 11:14 AM人工智能对关键NBA游戏4决策的影响 两场关键游戏4 NBA对决展示了AI在主持仪式中改变游戏规则的角色。 首先,丹佛的尼古拉·乔基奇(Nikola Jokic)错过了三分球,导致亚伦·戈登(Aaron Gordon)的最后一秒钟。 索尼的鹰

AI如何加速再生医学的未来May 01, 2025 am 11:13 AM

AI如何加速再生医学的未来May 01, 2025 am 11:13 AM传统上,扩大重生医学专业知识在全球范围内要求广泛的旅行,动手培训和多年指导。 现在,AI正在改变这一景观,克服地理局限性并通过EN加速进步

Intel Foundry Direct Connect 2025的关键要点May 01, 2025 am 11:12 AM

Intel Foundry Direct Connect 2025的关键要点May 01, 2025 am 11:12 AM英特尔正努力使其制造工艺重回领先地位,同时努力吸引无晶圆厂半导体客户在其晶圆厂制造芯片。为此,英特尔必须在业界建立更多信任,不仅要证明其工艺的竞争力,还要证明合作伙伴能够以熟悉且成熟的工作流程、一致且高可靠性地制造芯片。今天我听到的一切都让我相信英特尔正在朝着这个目标前进。 新任首席执行官谭立柏的主题演讲拉开了当天的序幕。谭立柏直率而简洁。他概述了英特尔代工服务的若干挑战,以及公司为应对这些挑战、为英特尔代工服务的未来规划成功路线而采取的措施。谭立柏谈到了英特尔代工服务正在实施的流程,以更以客

AI出了问题吗?现在在那里为此保险May 01, 2025 am 11:11 AM

AI出了问题吗?现在在那里为此保险May 01, 2025 am 11:11 AM全球专业再保险公司Chaucer Group和Armilla AI解决了围绕AI风险的日益严重的问题,已联手引入了新型的第三方责任(TPL)保险产品。 该政策保护业务不利

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

记事本++7.3.1

好用且免费的代码编辑器

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

SublimeText3汉化版

中文版,非常好用

Dreamweaver Mac版

视觉化网页开发工具