arXiv论文“ViP3D: End-to-end Visual Trajectory Prediction via 3D Agent Queries“,22年8月2日上传,清华、上海(姚)期智研究院、CMU、复旦、理想汽车和MIT等的联合工作。

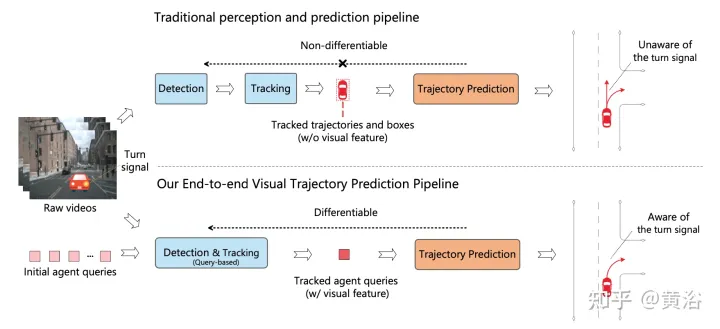

现有的自主驾驶流水线将感知模块与预测模块分开。这两个模块通过人工选择的特征进行通信,如智体框和轨迹作为接口。由于这种分离,预测模块仅从感知模块接收部分信息。更糟糕的是,来自感知模块的错误可能会传播和累积,从而对预测结果产生不利影响。

这项工作提出ViP3D,一种视觉轨迹预测流水线,利用原始视频的丰富信息预测场景中智体的未来轨迹。ViP3D在整个流水线中使用稀疏智体query,使其完全可微分和可解释。此外,提出一种新的端到端视觉轨迹预测任务的评估指标,端到端预测精度(EPA,End-to-end Prediction Accuracy),其在综合考虑感知和预测精度的同时,对预测轨迹与地面真实轨迹进行评分。

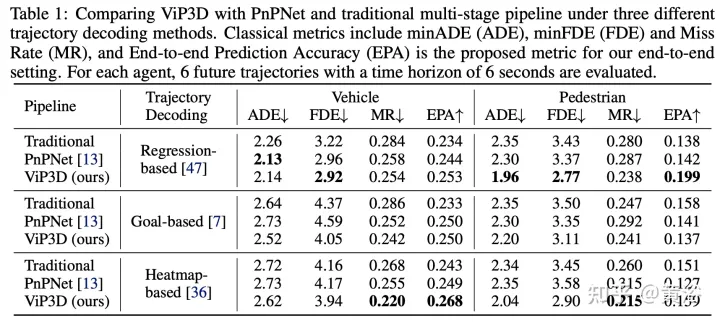

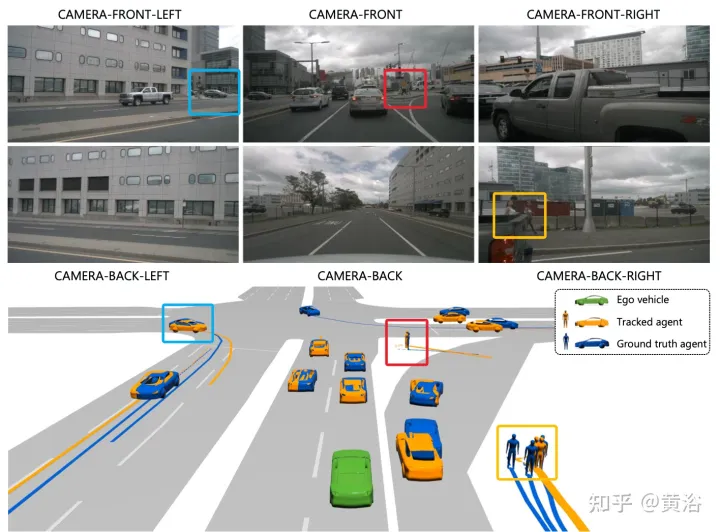

如图是传统多步级联流水线与ViP3D的比较:传统的流水线涉及多个不可微模块,例如检测、跟踪和预测;ViP3D将多视图视频作为输入,以端到端的方式生成预测轨迹,可有效利用视觉信息,比如车辆转向信号。

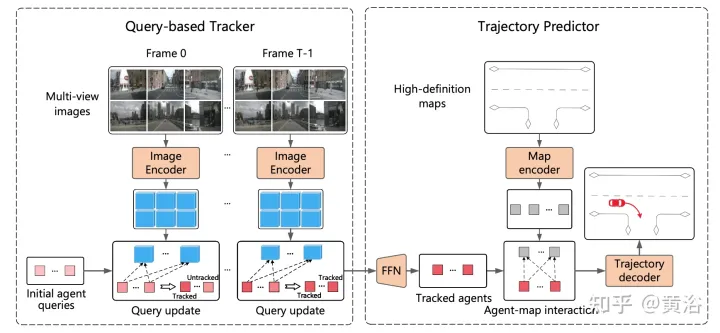

ViP3D旨在以端到端的方式解决原始视频的轨迹预测问题。具体而言,给定多视图视频和高清地图,ViP3D预测场景中所有智体的未来轨迹。

ViP3D的总体流程如图所示:首先,基于查询的跟踪器处理来自周围摄像机的多视图视频,获得有视觉特征所跟踪智体的query。智体query中的视觉特征,捕获智体的运动动力学和视觉特征,以及智体之间的关系。之后,轨迹预测器将跟踪智体的query作为输入,并与HD地图特征相关联,最后输出预测的轨迹。

基于query的跟踪器从环绕摄像机的原始视频中提取视觉特征。具体而言,对于每一帧,按照DETR3D提取图像特征。对于时域特征聚合,按照MOTR(“Motr: End-to-end multiple-object tracking with transformer“. arXiv 2105.03247, 2021)设计了一个基于query的跟踪器,包括两个关键步骤:query特征更新和query监督。智体query会随时间更新,建模智体的运动动力学。

大多数现有的轨迹预测方法可分为三个部分:智体编码、地图编码和轨迹解码。在基于query的跟踪之后,获得被跟踪智体的query,该query可以被视为通过智体编码获得的智体特征。因此,剩下的任务是地图编码和轨迹解码。

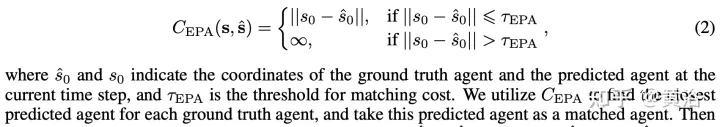

分别将预测和真值智体表示为无序集Sˆ和S,其中每个智体由当前时间步的智体坐标和K个可能的未来轨迹表示。对于每个智体类型c,计算Scˆ和Sc之间的预测精度。将预测智体和真值智体之间的成本定义为:

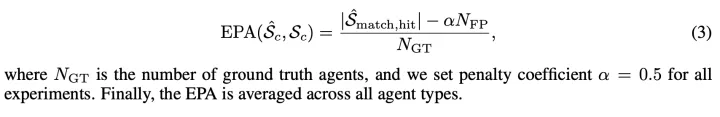

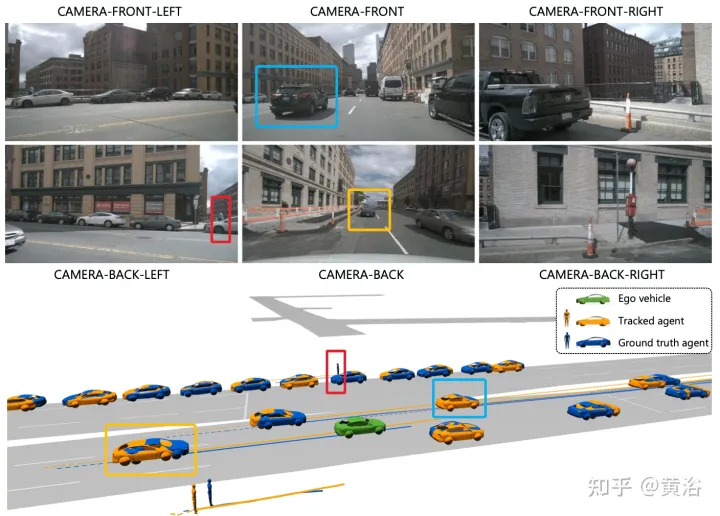

这样Scˆ和Sc之间的EPA定义为:

实验结果如下:

注:这个目标渲染做的不错。

以上是ViP3D: 通过3D智体query实现端到端视觉轨迹预测的详细内容。更多信息请关注PHP中文网其他相关文章!

让我们跳舞:结构化运动以微调我们的人类神经网Apr 27, 2025 am 11:09 AM

让我们跳舞:结构化运动以微调我们的人类神经网Apr 27, 2025 am 11:09 AM科学家已经广泛研究了人类和更简单的神经网络(如秀丽隐杆线虫中的神经网络),以了解其功能。 但是,出现了一个关键问题:我们如何使自己的神经网络与新颖的AI一起有效地工作

新的Google泄漏揭示了双子AI的订阅更改Apr 27, 2025 am 11:08 AM

新的Google泄漏揭示了双子AI的订阅更改Apr 27, 2025 am 11:08 AMGoogle的双子座高级:新的订阅层即将到来 目前,访问Gemini Advanced需要$ 19.99/月Google One AI高级计划。 但是,Android Authority报告暗示了即将发生的变化。 最新的Google P中的代码

数据分析加速度如何求解AI的隐藏瓶颈Apr 27, 2025 am 11:07 AM

数据分析加速度如何求解AI的隐藏瓶颈Apr 27, 2025 am 11:07 AM尽管围绕高级AI功能炒作,但企业AI部署中潜伏的巨大挑战:数据处理瓶颈。首席执行官庆祝AI的进步时,工程师努力应对缓慢的查询时间,管道超载,一个

Markitdown MCP可以将任何文档转换为Markdowns!Apr 27, 2025 am 09:47 AM

Markitdown MCP可以将任何文档转换为Markdowns!Apr 27, 2025 am 09:47 AM处理文档不再只是在您的AI项目中打开文件,而是将混乱变成清晰度。诸如PDF,PowerPoints和Word之类的文档以各种形状和大小淹没了我们的工作流程。检索结构化

如何使用Google ADK进行建筑代理? - 分析VidhyaApr 27, 2025 am 09:42 AM

如何使用Google ADK进行建筑代理? - 分析VidhyaApr 27, 2025 am 09:42 AM利用Google的代理开发套件(ADK)的力量创建具有现实世界功能的智能代理!该教程通过使用ADK来构建对话代理,并支持Gemini和GPT等各种语言模型。 w

在LLM上使用SLM进行有效解决问题-Analytics VidhyaApr 27, 2025 am 09:27 AM

在LLM上使用SLM进行有效解决问题-Analytics VidhyaApr 27, 2025 am 09:27 AM摘要: 小型语言模型 (SLM) 专为效率而设计。在资源匮乏、实时性和隐私敏感的环境中,它们比大型语言模型 (LLM) 更胜一筹。 最适合专注型任务,尤其是在领域特异性、控制性和可解释性比通用知识或创造力更重要的情况下。 SLM 并非 LLMs 的替代品,但在精度、速度和成本效益至关重要时,它们是理想之选。 技术帮助我们用更少的资源取得更多成就。它一直是推动者,而非驱动者。从蒸汽机时代到互联网泡沫时期,技术的威力在于它帮助我们解决问题的程度。人工智能 (AI) 以及最近的生成式 AI 也不例

如何将Google Gemini模型用于计算机视觉任务? - 分析VidhyaApr 27, 2025 am 09:26 AM

如何将Google Gemini模型用于计算机视觉任务? - 分析VidhyaApr 27, 2025 am 09:26 AM利用Google双子座的力量用于计算机视觉:综合指南 领先的AI聊天机器人Google Gemini扩展了其功能,超越了对话,以涵盖强大的计算机视觉功能。 本指南详细说明了如何利用

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好吗?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好吗?Apr 27, 2025 am 09:20 AM2025年的AI景观正在充满活力,而Google的Gemini 2.0 Flash和Openai的O4-Mini的到来。 这些尖端的车型分开了几周,具有可比的高级功能和令人印象深刻的基准分数。这个深入的比较

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

安全考试浏览器

Safe Exam Browser是一个安全的浏览器环境,用于安全地进行在线考试。该软件将任何计算机变成一个安全的工作站。它控制对任何实用工具的访问,并防止学生使用未经授权的资源。

禅工作室 13.0.1

功能强大的PHP集成开发环境

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

SublimeText3汉化版

中文版,非常好用

Atom编辑器mac版下载

最流行的的开源编辑器