如何使用拥抱面部 AI 模型作为 API

- DDD原创

- 2024-11-16 05:21:031060浏览

在本指南中,我将向您展示如何使用 Hugging Face 模型作为 API,并以 Meta LLaMA-3.2-3B-Instruct 为例。该模型专为基于聊天的自动完成而设计,可以有效处理对话式人工智能任务。让我们设置 API 并开始吧!

第1步:选择抱脸模特

- 前往拥抱脸部模型并搜索 Meta LLaMA-3.2-3B-Instruct 或您想要尝试的任何其他模型。

- 进入模型页面后,确认其支持推理 API,这允许其用作 API 端点。

第 2 步:创建 API 令牌

要访问 Hugging Face 的模型 API,您需要 API 令牌。

- 登录您的 Hugging Face 帐户并导航至您的设置 > 访问令牌。

通过选择新令牌创建读取令牌。这样您就可以调用 API 进行推理,而无需修改或管理资源的权限。

安全地保存您的令牌,因为您需要它来进行 API 身份验证。

第 3 步:为您的模型使用推理 API

Hugging Face 提供了无服务器推理 API 来访问预先训练的模型。此服务对免费用户有费率限制,对专业帐户则有增强的配额。

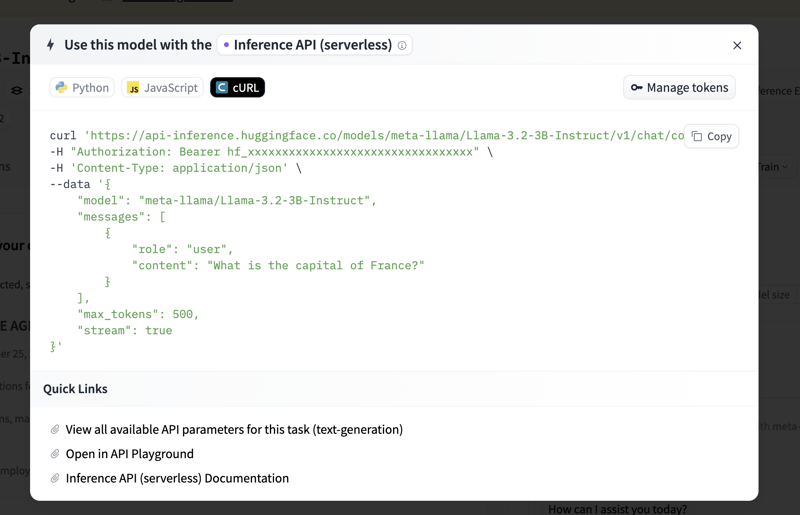

在 Meta LLaMA-3.2-3B-Instruct 模型页面上,单击 Inference API 选项卡。此选项卡提供代码示例和其他 API 使用信息。

您可以找到示例代码来开始。以下是如何设置基本的 Python 脚本来调用模型的 API。

第 4 步:处理费率限制和专业账户优势

对于免费帐户,API 速率限制适用,超过此限制可能会导致请求受到限制。如果您计划广泛使用 API 或需要更快的响应,请考虑使用专业帐户。更多详情请参阅 Hugging Face 的定价页面。

概括

按照这些步骤,您可以通过 API 使用 Meta LLaMA-3.2-3B-Instruct 或任何其他 Hugging Face 模型来执行聊天自动完成、对话式 AI 等任务。此设置非常灵活,允许您将 AI 功能直接集成到您的应用程序中,无论是用于实验还是生产目的。

现在您已准备好使用 Hugging Face 的强大模型来探索和构建!

以上是如何使用拥抱面部 AI 模型作为 API的详细内容。更多信息请关注PHP中文网其他相关文章!

声明:

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系admin@php.cn