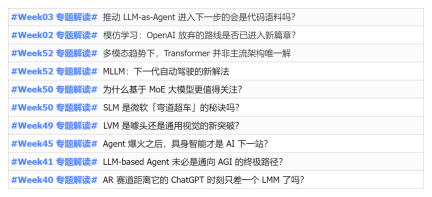

2023年,几乎 AI 的每个领域都在以前所未有的速度进化,同时,AI也在不断地推动着具身智能、自动驾驶等关键赛道的技术边界。多模态趋势下,Transformer 作为 AI 大模型主流架构的局面是否会撼动?为何探索基于 MoE (专家混合)架构的大模型成为业内新趋势?大型视觉模型 (LVM)能否成为通用视觉的新突破?...我们从过去的半年发布的2023年本站PRO会员通讯中,挑选了 10 份针对以上领域技术趋势、产业变革进行深入剖析的专题解读,助您在新的一年里为大展宏图做好准备。本篇解读来自2023年 Week50 业内通讯 ?

日期:12 月 12 日

事件:Mistral AI 开源了基于 MoE(Mixture-of-Experts,专家混合)架构的模型 Mixtral 8x7B,其性能达到 Llama 2 70B 和 GPT-3.5 的水平"的事件进行延展解读。

首先,弄清楚 MoE 是什么及其来龙去脉

1、概念:

MoE(Mixture of Experts)是一种混合模型,由多个子模型(即专家)组成,每个子模型都是一个局部模型,专门处理输入空间的一个子集。MoE 的核心思想是使用一个门控网络来决定每个数据应该被哪个模型去训练,从而减轻不同类型样本之间的干扰。

2、主要构成:

混合专家模型技术(MoE)是由专家模型和门控模型组成稀疏门控制的深度学习技术。MoE 通过门控网络实现任务/训练数据在不同专家模型间的分配,让每个模型专注处理其最擅长的任务,进而实现模型的稀疏性。

① 在门控网络的训练中,每个样本都会被分配到一个或多个专家中;

② 在专家网络的训练中,每个专家都会被训练以最小化其分配给它的样本的误差。

3、MoE 的「前身」:

MoE 的「前身」是集成学习(Ensemble Learning)。集成学习是通过训练练多个模型(基学习器)未解决同一问题,并且将它们的预测结果简单组合(例如投票或平均)。集成学习的主要目标是通过减少过拟合,提高泛化能力,以提高预测性能。常见的集成学习方法包括 Bagging,Boosting 和 Stacking。

4、MoE 历史来源:

① MoE 的根源可以追溯到 1991 年的论文《 Adaptive Mixture of Local Experts》。这个想法与集成方法类似,目的是为由不同子网络组成的系统提供一种监督过程,每个单独的网络或专家都专门处理输入空间的不同区域。通过门控网络确定每个专家的权重。在训练过程中,专家和门控都会被训练。

② 在 2010 年至 2015 年期间,两个不同的研究领域对 MoE 的进一步发展做出了贡献:

一是专家作为组件:在传统的 MoE 设置中,整个系统包括一个门控网络和多个专家。MoEs 作为整个模型已经在支持向量机、高斯过程和其他方法中进行了探索。《Learning Factored Representations in a Deep Mixture of Experts》工作探索了 MoEs 作为更深层网络组件的可能性。这使得模型可以同时变得庞大和高效。

另一个是条件计算:传统的网络通过每一层处理所有输入数据。在这个时期,Yoshua Bengio 研究了根据输入 token 动态激活或停用组件的方法。

③ 由此,人们开始在自然语言处理的背景下探索专家混合模型。在论文《Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer》中通过引入稀疏性,将其扩展到了一个 137B LSTM,从而实现了高规模下的快速推理。

为什么基于 MoE 的大模型值得关注?

1、通常来讲,模型规模的扩展会导致训练成本显著增加,计算资源的限制成为了大规模密集模型训练的瓶颈。为了解决这个问题,基于稀疏 MoE 层的深度学习模型架构被提出。

2、稀疏混合专家模型(MoE)是一种特殊的神经网络架构,可以在不增加推理成本的情况下,为大型语言模型(LLM)增加可学习的参数,而指令调优(instruction tuning)则是一种训练 LLM 遵循指令的技术。

3、MoE+指令微调技术的结合,可大幅度提升语言模型的性能。2023 年 7 月,谷歌、UC 伯克利和 MIT 等机构的研究者发表了论文《Mixture-of-Experts Meets Instruction Tuning: A Winning Combination for Large Language Models》,证明了混合专家模型(MoE)与指令调优的结合能够让大型语言模型(LLM)的性能大幅提升。

① 具体来说,研究者在一组经过指令微调的稀疏混合专家模型 FLAN-MOE 中,使用稀疏激活 MoE,并用 MoE 层替换 Transformer 层的前馈组件,以提供更优的模型容量与计算灵活性;其次,在 FLAN 集合数据集的基础上对 FLAN-MOE 进行微调。

② 研究者基于上述方法研究在没有指令调优的情况下在单个下游任务进行直接微调,在指令调优后对下游任务进行 in-context 少样本或零样本泛化,以及在指令调优后对单个下游任务进行进一步微调等三种实验设置下 LLM 的性能区别。

③ 实验结果表明,如果不使用指令调优,MoE 模型的性能通常不如与之计算能能力相当的密集模型。但当结合指令调优时,情况发生了变化。指令调优后的 MoE 模型(Flan-MoE)在多个任务上的表现超越了更大的密集模型,即使 MoE 模型的计算成本只是密集模型的三分之一。与密集模型相比。MoE 模型从指令调优中获得的性能提升更为显著,因此当考虑计算效率与性能时,MoE 将成为大型语言模型训练的有力工具。

4、此次,发布的 Mixtral 8x7B 模型同样采用了稀疏混合专家网络。

① Mixtral 8x7B 是一个 decoder-only 的模型。前馈模块从 8 组不同的参数中进行选择。在每一层网络中,对于每个 token,路由器网络选择 8 组中的两组(专家),来处理 token 并将其输出累加组合。

② Mixtral 8x7B 模型在大多数基准测试中均匹配或优于 Llama 2 70B 以及 GPT3.5,推理速度快了 6 倍。

MoE 的重要优势:稀疏性是什么?

1、在传统的密集模型中,对于每一个输入都需要在完整的模型中进行计算。在稀疏混合专家模型中,处理输入数据时只有少数专家模型被激活成者使用,而大部分专家模型处于未被激活状态,这种状态便是「稀疏「。而稀疏性是混合专家模型的重要优点,也是提升模型训练和推理过程的效率的关键。

以上是PRO | 为什么基于 MoE 的大模型更值得关注?的详细内容。更多信息请关注PHP中文网其他相关文章!

从摩擦到流:AI如何重塑法律工作May 09, 2025 am 11:29 AM

从摩擦到流:AI如何重塑法律工作May 09, 2025 am 11:29 AM法律技术革命正在获得动力,促使法律专业人员积极采用AI解决方案。 对于那些旨在保持竞争力的人来说,被动抵抗不再是可行的选择。 为什么技术采用至关重要? 法律专业人员

这就是AI对您的看法,对您的了解May 09, 2025 am 11:24 AM

这就是AI对您的看法,对您的了解May 09, 2025 am 11:24 AM许多人认为与AI的互动是匿名的,与人类交流形成了鲜明的对比。 但是,AI在每次聊天期间都会积极介绍用户。 每个单词的每个提示都经过分析和分类。让我们探索AI Revo的这一关键方面

建立蓬勃发展的AI-Ready企业文化的7个步骤May 09, 2025 am 11:23 AM

建立蓬勃发展的AI-Ready企业文化的7个步骤May 09, 2025 am 11:23 AM成功的人工智能战略,离不开强大的企业文化支撑。正如彼得·德鲁克所言,企业运作依赖于人,人工智能的成功也同样如此。 对于积极拥抱人工智能的组织而言,构建适应AI的企业文化至关重要,它甚至决定着AI战略的成败。 西蒙诺咨询公司(West Monroe)近期发布了构建蓬勃发展的AI友好型企业文化的实用指南,以下是一些关键要点: 1. 明确AI的成功模式: 首先,要对AI如何赋能业务有清晰的愿景。理想的AI运作文化,能够实现人与AI系统之间工作流程的自然融合。AI擅长某些任务,而人类则擅长创造力、判

Netflix New Scroll,Meta AI的游戏规则改变者,Neuralink价值85亿美元May 09, 2025 am 11:22 AM

Netflix New Scroll,Meta AI的游戏规则改变者,Neuralink价值85亿美元May 09, 2025 am 11:22 AMMeta升级AI助手应用,可穿戴式AI时代来临!这款旨在与ChatGPT竞争的应用,提供文本、语音交互、图像生成和网络搜索等标准AI功能,但现在首次增加了地理位置功能。这意味着Meta AI在回答你的问题时,知道你的位置和正在查看的内容。它利用你的兴趣、位置、个人资料和活动信息,提供最新的情境信息,这在以前是无法实现的。该应用还支持实时翻译,这彻底改变了Ray-Ban眼镜上的AI体验,使其实用性大大提升。 对外国电影征收关税是对媒体和文化的赤裸裸的权力行使。如果实施,这将加速向AI和虚拟制作的

今天采取这些步骤以保护自己免受AI网络犯罪的侵害May 09, 2025 am 11:19 AM

今天采取这些步骤以保护自己免受AI网络犯罪的侵害May 09, 2025 am 11:19 AM人工智能正在彻底改变网络犯罪领域,这迫使我们必须学习新的防御技巧。网络罪犯日益利用深度伪造和智能网络攻击等强大的人工智能技术进行欺诈和破坏,其规模前所未有。据报道,87%的全球企业在过去一年中都成为人工智能网络犯罪的目标。 那么,我们该如何避免成为这波智能犯罪的受害者呢?让我们探讨如何在个人和组织层面识别风险并采取防护措施。 网络罪犯如何利用人工智能 随着技术的进步,犯罪分子不断寻找新的方法来攻击个人、企业和政府。人工智能的广泛应用可能是最新的一个方面,但其潜在危害是前所未有的。 特别是,人工智

共生舞蹈:人工和自然感知的循环May 09, 2025 am 11:13 AM

共生舞蹈:人工和自然感知的循环May 09, 2025 am 11:13 AM最好将人工智能(AI)与人类智力(NI)之间的复杂关系理解为反馈循环。 人类创建AI,对人类活动产生的数据进行培训,以增强或复制人类能力。 这个AI

AI最大的秘密 - 创作者不了解,专家分裂May 09, 2025 am 11:09 AM

AI最大的秘密 - 创作者不了解,专家分裂May 09, 2025 am 11:09 AMAnthropic最近的声明强调了关于尖端AI模型缺乏了解,引发了专家之间的激烈辩论。 这是一个真正的技术危机,还是仅仅是通往更秘密的道路上的临时障碍

Sarvam AI的Bulbul-V2:印度最佳TTS模型May 09, 2025 am 10:52 AM

Sarvam AI的Bulbul-V2:印度最佳TTS模型May 09, 2025 am 10:52 AM印度是一个多元化的国家,具有丰富的语言,使整个地区的无缝沟通成为持续的挑战。但是,Sarvam的Bulbul-V2正在帮助弥合其高级文本到语音(TTS)T

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

禅工作室 13.0.1

功能强大的PHP集成开发环境

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

VSCode Windows 64位 下载

微软推出的免费、功能强大的一款IDE编辑器

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

PhpStorm Mac 版本

最新(2018.2.1 )专业的PHP集成开发工具