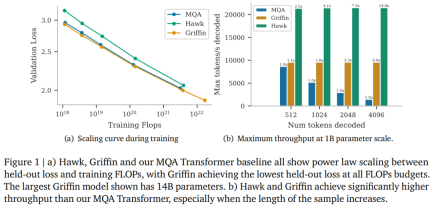

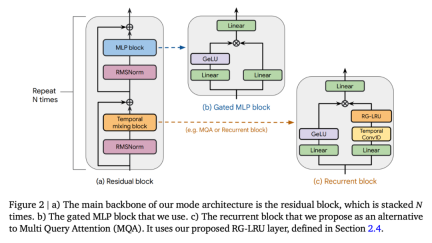

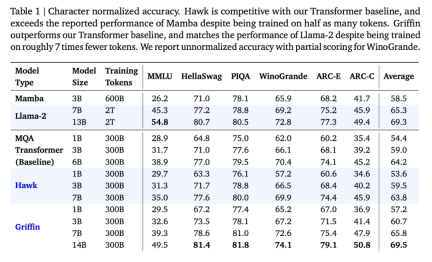

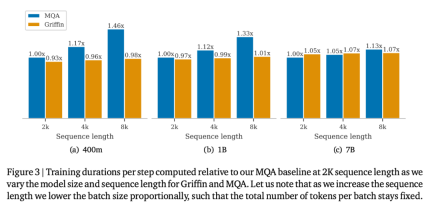

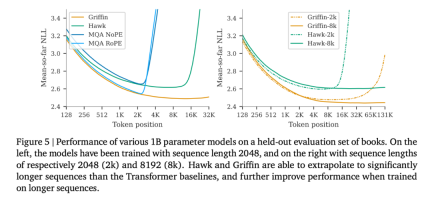

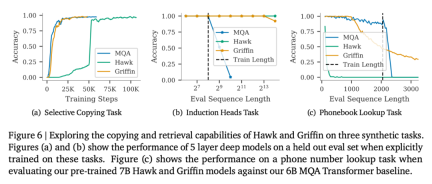

去年 12 月,新架构 Mamba 引爆了 AI 圈,向屹立不倒的 Transformer 发起了挑战。如今,谷歌 DeepMind「Hawk 」和「Griffin 」的推出为 AI 圈提供了新的选择。

论文标题:Griffin: Mixing Gated Linear Recurrences with Local Attention for Efficient Language Models 论文链接:https://arxiv.org/pdf/2402.19427.pdf

来源:https://twitter.com/botev_mg/status/1763489634082795780

来源:https://twitter.com/botev_mg/status/1763489634082795780

以上是RNN效率媲美Transformer,谷歌新架构两连发:同等规模强于Mamba的详细内容。更多信息请关注PHP中文网其他相关文章!

脱衣舞用法教程指南文章May 13, 2025 am 10:43 AM

脱衣舞用法教程指南文章May 13, 2025 am 10:43 AM有关使用distressai创建色情图片/视频的教程:1。打开相应的工具Web链接; 2。单击工具按钮; 3。根据页面提示上传所需的生产内容; 4。保存并享受结果。

![[带AI的吉卜力风格图像]介绍如何使用Chatgpt和版权创建免费图像](https://img.php.cn/upload/article/001/242/473/174707263295098.jpg?x-oss-process=image/resize,p_40) [带AI的吉卜力风格图像]介绍如何使用Chatgpt和版权创建免费图像May 13, 2025 am 01:57 AM

[带AI的吉卜力风格图像]介绍如何使用Chatgpt和版权创建免费图像May 13, 2025 am 01:57 AMOpenAI发布的最新模型GPT-4o,不仅能生成文本,还具备图像生成功能,引发广泛关注。其中最受瞩目的功能便是“吉卜力风格插画”的生成。只需将照片上传至ChatGPT,并给出简单的指令,即可生成宛如吉卜力工作室作品般梦幻的图像。本文将详细解读实际操作流程、效果感受,以及需要注意的错误和版权问题。 OpenAI发布的最新模型“o3”详情请点击此处⬇️ OpenAI o3(ChatGPT o3)详解:特性、定价体系及o4-mini介绍 吉卜力风格文章的英文版请点击此处⬇️ 利用ChatGPT创作吉

解释在地方政府中使用和实施CANTGPT的示例!还介绍了禁止的地方政府May 13, 2025 am 01:53 AM

解释在地方政府中使用和实施CANTGPT的示例!还介绍了禁止的地方政府May 13, 2025 am 01:53 AM作为一种新的交流方法,在地方政府中使用和引入Chatgpt引起了人们的关注。尽管这种趋势在广泛的领域正在发展,但一些地方政府拒绝使用Chatgpt。 在本文中,我们将介绍地方政府中ChatGPT实施的示例。我们将通过各种改革实例,包括支持文件创建和与公民对话,从而探索如何通过各种改革实例来实现地方政府服务的质量和效率提高。 不仅旨在减少员工工作量并改善公民的便利性的地方政府官员,而且都对高级用例感兴趣。

chatgpt中的福卡式风格提示是什么?示例句子的详尽解释!May 13, 2025 am 01:52 AM

chatgpt中的福卡式风格提示是什么?示例句子的详尽解释!May 13, 2025 am 01:52 AM您是否听说过一个名为“福卡斯提示系统”的框架?诸如ChatGpt之类的语言模型非常出色,但是适当的提示对于发挥其潜力至关重要。福卡(Fukatsu)提示是旨在提高输出准确性的最受欢迎的提示技术之一。 本文解释了福卡式风格提示的原理和特征,包括特定的用法方法和示例。此外,我们还引入了其他众所周知的及时模板和有用的技术来及时设计,因此,根据这些设计,我们将介绍C。

什么是chatgpt搜索?解释主要功能,用法和费用结构!May 13, 2025 am 01:51 AM

什么是chatgpt搜索?解释主要功能,用法和费用结构!May 13, 2025 am 01:51 AMCHATGPT搜索:使用创新的AI搜索引擎有效获取最新信息! 在本文中,我们将彻底解释OpenAI提供的新的ChatGpt功能“ ChatGpt搜索”。让我们仔细研究一下功能,用法以及该工具如何根据实时网络信息和直观的易用性来帮助您提高信息收集效率。 chatgpt搜索提供了一种对话互动搜索体验,该体验在舒适,隐藏的环境中回答用户问题,以隐藏广告

易于理解的解释如何在Chatgpt和提示中创建构图!May 13, 2025 am 01:50 AM

易于理解的解释如何在Chatgpt和提示中创建构图!May 13, 2025 am 01:50 AM信息爆炸的现代社会,创作出令人信服的文章并非易事。如何在有限的时间和精力内,发挥创造力,撰写出吸引读者的文章,需要高超的技巧和丰富的经验。 这时,作为革命性的写作辅助工具,ChatGPT 备受瞩目。ChatGPT 利用庞大的数据训练出的语言生成模型,能够生成自然流畅、精炼的文章。 本文将介绍如何有效利用 ChatGPT,高效创作高质量文章的技巧。我们将逐步讲解使用 ChatGPT 的写作流程,并结合具体案例,详细阐述其优缺点、适用场景以及安全使用注意事项。ChatGPT 将成为作家克服各种障碍,

如何使用chatgpt创建图!还解释了插图的加载和插件May 13, 2025 am 01:49 AM

如何使用chatgpt创建图!还解释了插图的加载和插件May 13, 2025 am 01:49 AM使用AI创建图表的有效指南 视觉材料对于有效传达信息至关重要,但是创建它需要大量时间和精力。但是,由于AI技术(例如Chatgpt和dall-e 3)的兴起,图表创建过程正在发生巨大变化。本文使用这些尖端工具提供了有关有效而有吸引力的图创建方法的详细说明。它涵盖了从想法到完成的所有内容,并包含大量信息,可用于创建图表,从可以使用的特定步骤,提示,插件和API以及如何使用图像一代AI“ dall-e 3.”)

易于理解的解释Chatgpt加上定价结构和付款方式!May 13, 2025 am 01:48 AM

易于理解的解释Chatgpt加上定价结构和付款方式!May 13, 2025 am 01:48 AM解锁ChatGPT Plus:费用、支付方式及升级指南 全球瞩目的顶尖生成式AI,ChatGPT已广泛应用于日常生活和商业领域。虽然ChatGPT基本免费,但付费版ChatGPT Plus提供多种增值服务,例如插件、图像识别等,显着提升工作效率。本文将详细解读ChatGPT Plus的收费标准、支付方式及升级流程。 OpenAI最新图像生成技术“GPT-4o图像生成”详情请点击: GPT-4o图像生成详解:使用方法、提示词示例、商业应用及与其他AI的差异 目录 ChatGPT Plus费用 Ch

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3汉化版

中文版,非常好用

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

Dreamweaver CS6

视觉化网页开发工具

Atom编辑器mac版下载

最流行的的开源编辑器