寫在前面&筆者的個人理解

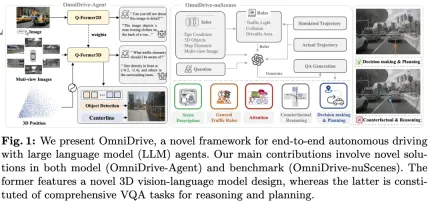

這篇論文致力於解決當前多模態大語言模型(MLLMs)在自動駕駛應用中存在的關鍵挑戰,即將MLLMs從2D理解擴展到3D空間的問題。由於自動駕駛車輛(AVs)需要針對3D環境做出準確的決策,這項擴展顯得格外重要。 3D空間理解對於AV來說至關重要,因為它直接影響車輛做出明智決策、預測未來狀態以及與環境安全互動的能力。

目前的多模態大語言模型(如LLaVA-1.5)通常僅能處理較低解析度的影像輸入(例如),這是由於視覺編碼器的分辨率限制,LLM序列長度的限制。然而,自動駕駛應用需要高解析度的多視角視訊輸入,以確保車輛能在長距離內感知環境並安全決策。 此外,現有的許多2D模型架構難以有效處理這些輸入,因為它們需要大量的運算和儲存資源。 為了解決這些問題,研究人員正在努力開發新的模型架構和儲存資源。

在此背景下,本文提出了全新的3D MLLM架構,並借鑒了Q-Former風格的設計。該架構採用交叉注意力解碼器,將高解析度的視覺資訊壓縮到稀疏查詢中,使其更易於擴展到高解析度輸入。這種架構與視角模型家族(如DETR3D、PETR(v2)、StreamPETR和Far3D)具有相似性,因為它們都利用了稀疏的3D查詢機制。透過對這些查詢附加3D位置編碼並與多視角輸入進行交互,本文的架構實現了3D空間的理解,從而更好地利用了2D影像中的預訓練知識。

除了模型架構的創新,本文也提出了一個更具挑戰性的基準-OmniDrive-nuScenes。此基準涵蓋了一系列需要3D空間理解和長距離推理的複雜任務,並引入了反事實推理基準,以模擬解決方案和軌跡來評估結果。這項基準有效彌補了目前開放式評估中偏向單一專家軌跡的問題,從而避免了在專家軌跡上的過度擬合。

本文介紹了一個全面的端到端自主驅動框架OmniDrive,它在LLM-agent的基礎上提供了一種有效的3D推理和規劃模型,並建立了一個更具挑戰性的基準,推動了自動駕駛領域的進一步發展。具體貢獻如下:

- 提出了一個3D Q-Former架構,適用於各種駕駛相關任務,包括目標偵測、車道偵測、3D視覺定位、決策制定和規劃。

- 引入了OmniDrive-nuScenes基準,這是第一個為解決規劃相關挑戰而設計的QA基準,涵蓋了精確的3D空間資訊。

- 實現了在規劃任務上的最佳表現。

詳解OmniDrive

#整體結構

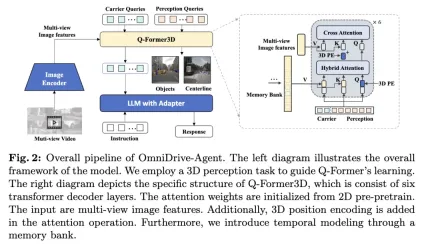

本文提出的OmniDrive -Agent結合了Q-Former和基於查詢的3D感知模型的優點,在多視角圖像特徵中高效獲取3D空間信息,解決自主駕駛中的3D感知與規劃任務。整體架構如圖所示。

- 視覺編碼器:首先,使用共享的視覺編碼器來擷取多視角影像特徵。

- 位置編碼:將擷取的影像特徵與位置編碼一起輸入到Q-Former3D中。

- Q-Former3D模組:其中,表示拼接運算。為了簡潔起見,公式中省略了位置編碼。此步驟後,查詢集合成為互動後的。其中,表示3D位置編碼,是多視角影像特徵。

- 多視角影像特徵擷取:接下來,這些查詢從多視角影像中收集資訊:

- 查詢初始化與自注意力:在Q-Former3D中,初始化偵測查詢和載體查詢,並進行自註意力操作以交換它們之間的資訊:

- 輸出處理:

- #感知任務預測:利用感知查詢預測前景元素的類別和座標。

- 載體查詢對齊與文字產生:載體查詢則透過單層MLP對齊至LLM令牌的維度(如LLaMA中的4096維度),並進一步用於文字產生。

- 載體查詢的作用

#透過該架構設計,OmniDrive-Agent能夠有效率地從多視角圖像中獲取豐富的3D空間信息,並結合LLM進行文本生成,為3D空間感知和自主駕駛提供新的解決方案。

Multi-task and Temporal Modeling

作者的方法受益於多任務學習和時序建模。在多任務學習中,作者可以為每個感知任務整合特定的Q-Former3D模組,並採用統一的初始化策略(請參閱\cref{Training Strategy})。在不同的任務中,載體查詢能夠夠收集不同交通元素的資訊。作者的實現涵蓋了諸如中心線建置和3D目標偵測等任務。在訓練和推理階段,這些模組共享相同的3D位置編碼。 作者的方法透過豐富了諸如中心線建置和3D目標偵測等任務。在訓練和推理階段,這些模組共享相同的3D位置編碼。 作者的方法透過豐富了諸如中心線建置和3D目標偵測等任務。在訓練和推理階段,這些模組共享相同的3D位置編碼。

關於時序建模,作者將具有top-k分類分數的感知查詢儲存在記憶庫中,並逐幀傳播。傳播後的查詢透過交叉注意力與當前幀的感知查詢和載體查詢進行交互,從而擴展模型對視訊輸入的處理能力。

Training Strategy

OmniDrive-Agent的訓練策略分為兩個階段:2D預訓練和3D微調。在初始階段,作者首先在2D影像任務上對多模態大模型(MLLMs)進行預先訓練,以初始化Q-Former和載體查詢。移除偵測查詢後,OmniDrive模型可以被視為一個標準的視覺語言模型,能夠基於圖像生成文字。因此,作者採用LLaVA v1.5的訓練策略與數據,在558K圖文對上預先訓練OmniDrive。在預訓練期間,除Q-Former外,所有參數保持凍結狀態。隨後,使用LLaVA v1.5的指令調優資料集對MLLMs進行微調。在微調過程中,影像編碼器保持凍結,其他參數均可訓練。

在3D微調階段,目標是增強模型的3D定位能力,同時盡可能保留其2D語意理解能力。為此,作者為原始的Q-Former添加了3D位置編碼和時序模組。在這個階段,作者使用LoRA技術以較小的學習率微調視覺編碼器和大語言模型,並以相對較大的學習率訓練Q-Former3D。在這兩個階段中,OmniDrive-Agent的損失計算僅包括文字產生損失,而不考慮BLIP-2中的對比學習和匹配損失。

OmniDrive-nuScenes

為了對駕駛多模態大模型代理程式進行基準測試,作者提出了OmniDrive-nuScenes,這是一個基於nuScenes資料集的新型基準,包含高品質的視覺問答(QA)對,涵蓋了3D領域的感知、推理和規劃任務。

OmniDrive-nuScenes的亮點在於其完全自動化的QA生成流程,該流程使用GPT-4產生問題和答案。類似於LLaVA,作者的流程將3D感知的標註作為上下文資訊提供給GPT-4。在此基礎上,作者進一步利用交通規則和規劃模擬作為額外輸入,幫助GPT-4更能理解3D環境。作者的基準不僅測試模型的感知和推理能力,還透過涉及注意力、反事實推理和開環規劃的長時域問題,挑戰模型在3D空間中的真實空間理解和規劃能力,因為這些問題要求對未來幾秒鐘內的駕駛規劃進行模擬以得出正確答案。

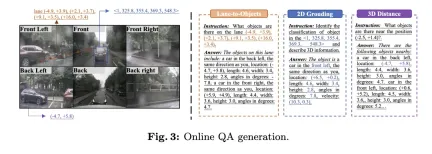

除了用於離線問答的生成流程外,作者還提出了一個在線生成多樣化定位問題的流程。這個流程可以看作是一種隱含的資料增強方式,用來提升模型的3D空間理解和推理能力。

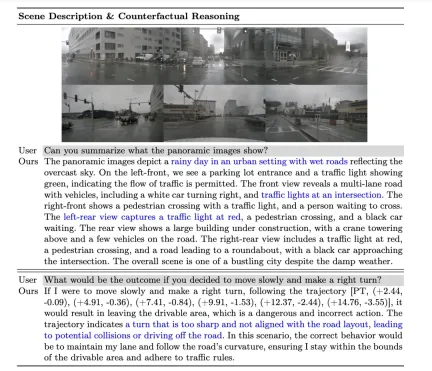

Offline Question-Answering

在離線QA產生流程中,作者使用上下文資訊來產生nuScenes上的QA對。首先,作者使用GPT-4產生場景描述,並將三個視角的前視圖和三個視角的後視圖拼接成兩個獨立的圖像輸入到GPT-4。透過提示輸入,GPT-4可以描述天氣、時間、場景類型等訊息,並辨識各視角的方向,同時避免逐視角描述,而是以相對自車的位置描述內容。

接下來,為了讓GPT-4V更能理解交通元素之間的相對空間關係,作者將物件和車道線的關係表示成類似文件樹的結構,並根據物件的3D邊界框,將其訊息轉換成自然語言描述。

隨後,作者透過模擬不同的駕駛意圖產生軌跡,包括車道保持、左側換道和右側換道,並利用深度優先搜尋演算法將車道中心線連接起來,產生所有可能的行駛路徑。此外,作者對nuScenes資料集中自車軌跡進行了聚類,選取具有代表性的駕駛路徑,並將其作為模擬軌跡的一部分。

最終,透過對離線QA產生流程中的不同情境資訊進行組合,作者能夠產生多種類型的QA對,包括情境描述、注意力對象辨識、反事實推理和決策規劃。 GPT-4可以基於模擬和專家軌跡識別威脅對象,並透過對駕駛路徑的安全性進行推理,給予合理的駕駛建議。

Online Question-Answering

#為了充分利用自動駕駛資料集中的3D感知標註,作者在訓練過程中以在線方式產生大量定位類任務。這些任務旨在加強模型的3D空間理解和推理能力,包括:

- 2D到3D定位:給定特定相機上的2D邊界框,模型需要提供對應物件的3D屬性,包括類別、位置、大小、朝向和速度。

- 3D距離:基於隨機產生的3D座標,識別目標位置附近的交通元素,並提供它們的3D屬性。

- 車道到物件:基於隨機選擇的車道中心線,列出該車道上的所有物件及其3D屬性。

Metrics

OmniDrive-nuScenes資料集涉及場景描述、開環規劃和反事實推理任務。每個任務著重不同的方面,難以使用單一指標進行評估。因此,作者針對不同的任務設計了不同的評量標準。

對於情境描述相關任務(如情境描述和注意力對象選擇),作者採用常用的語言評估指標,包括METEOR、ROUGE和CIDEr來評估句子相似性。在開環規劃任務中,作者使用碰撞率和道路邊界交叉率來評估模型的表現。對於反事實推理任務,作者使用GPT-3.5提取預測中的關鍵字,並將這些關鍵字與真實情況進行比較,以計算不同事故類別的精確率和召回率。

實驗結果

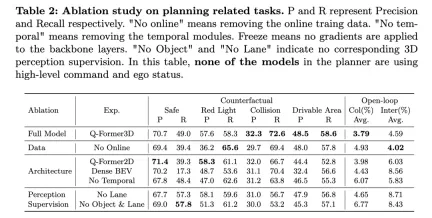

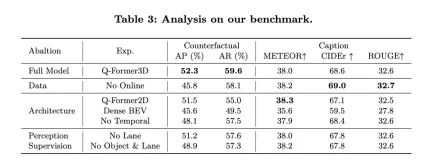

上表展示了規劃相關任務的消融研究結果,包括反事實推理和開環規劃的性能評估。

完整模型,即Q-Former3D,在反事實推理和開環規劃任務上都表現出色。在反事實推理任務中,模型在「紅燈違規」和「可通行區域違規」類別上都展示了較高的精準率和召回率,分別為57.6%/58.3%和48.5%/58.6%。同時,該模型在「碰撞」類別中取得了最高的召回率(72.6%)。在開環規劃任務中,Q-Former3D在平均碰撞率和路界交叉率上都表現出色,分別達到了3.79%和4.59%。

移除線上訓練資料(No Online)後,反事實推理任務中的「紅燈違規」類別召回率有所提高(65.6%),但整體效能略有下降。碰撞和可通行區域違規的精準率和召回率均較完整模型略低,而開環規劃任務的平均碰撞率上升至4.93%,平均路界交叉率下降到4.02%,這反映出在線訓練數據對於提高模型整體規劃效能的重要性。

在架構消融實驗中,Q-Former2D版本在「紅燈違規」類別上取得最高精準率(58.3%)和較高召回率(61.1%),但其他類別的表現不如完整模型,特別是「碰撞」和「可通行區域違規」類別的召回率明顯下降。在開環規劃任務中,平均碰撞率和路界交叉率均高於完整模型,分別為3.98%和6.03%。

採用Dense BEV架構的模型在所有類別的反事實推理任務上表現較好,但召回率整體偏低。開環規劃任務中的平均碰撞率和路界交叉率分別達到了4.43%和8.56%。

當移除時間模組時(No Temporal),模型在反事實推理任務的表現顯著下降,特別是平均碰撞率上升至6.07%,路界交叉率達到5.83%。

在感知監督方面,移除車道線監督(No Lane)後,模型在「碰撞」類別的召回率顯著下降,而反事實推理任務的其他類別和開環規劃任務的指標表現相對穩定。完全移除物體與車道線的3D感知監督(No Object & Lane)後,反事實推理任務各類別的精準率和召回率均有下降,特別是「碰撞」類別的召回率降至53.2%。開環規劃任務中的平均碰撞率和路界交叉率分別升至6.77%和8.43%,顯著高於完整模型。

從上述實驗結果可以看出,完整模型在反事實推理和開環規劃任務中表現優異。線上訓練資料、時間模組以及車道線與物體的3D感知監督對模型性能的提升起到了重要作用。完整模型能夠有效地利用多模態資訊進行高效率的規劃與決策,而消融實驗的結果進一步驗證了這些組件在自動駕駛任務中的關鍵作用。

同時,來看NuScenes-QA的表現:展示了OmniDrive在開環規劃任務中的效能,與其他現有方法進行了比較。結果顯示,OmniDrive (完整版本)在各項指標上均取得了最佳表現,尤其在開環規劃的平均誤差、碰撞率和路界交叉率三個方面均優於其他方法。

OmniDrive 的表現:OmniDrive 模型在1秒、2秒和3秒的預測時間內,L2平均誤差分別為0.14、0.29和0.55米,最終平均誤差僅為0.33米。此外,該模型的平均碰撞率和平均路界交叉率也分別達到了0.30%和3.00%,遠低於其他方法。尤其在碰撞率方面,OmniDrive 在1秒和2秒的預測時間內都實現了零碰撞率,充分展現了其出色的規劃和避障能力。

與其他方法的比較:相較於其他先進的基準模型,例如UniAD、BEV-Planner 和Ego-MLP,OmniDrive 在所有關鍵指標上都表現優異。 UniAD在使用高階指令和自車狀態資訊的情況下,其L2平均誤差為0.46米,而OmniDrive 在相同設定下的誤差較低,為0.33米。同時,OmniDrive 的碰撞率和路界交叉率也比UniAD顯著降低,尤其在碰撞率方面減少了近一半。

與BEV-Planner 相比,OmniDrive 在所有預測時間內的L2誤差均顯著降低,尤其在3秒預測時間內,誤差由0.57公尺降至0.55公尺。同時,在碰撞率和路界交叉率方面,OmniDrive 也優於BEV-Planner ,碰撞率由0.34%降至0.30%,路界交叉率由3.16%降至3.00%。

消融實驗:為了進一步評估OmniDrive架構中的關鍵模組對效能的影響,作者也比較了不同版本的OmniDrive模型的表現。 OmniDrive(不使用高階指令和自車狀態資訊)在預測誤差、碰撞率和路界交叉率方面均明顯遜於完整模型,尤其是在3秒預測時間內的L2誤差達到了2.84米,平均碰撞率高達3.79%。

當僅使用OmniDrive模型(無高階指令和自車狀態資訊)時,預測誤差、碰撞率和路界交叉率有所改善,但與完整模型相比仍有差距。這表明,整合高層級命令和自車狀態資訊對提高模型的整體規劃性能具有顯著作用。

整體而言,實驗結果清楚地展示了OmniDrive 在開環規劃任務上的卓越表現。透過整合多模態資訊、高階指令和自車狀態信息,OmniDrive 在複雜的規劃任務中實現了更精準的路徑預測和更低的碰撞率與路界交叉率,為自主駕駛的規劃與決策提供了強有力的支持。

討論

作者提出的OmniDrive代理和OmniDrive-nuScenes資料集在多模態大模型領域引入了一種新的範式,能夠解決3D環境中的駕駛問題,並為此類模型的評估提供了一個全面的基準。然而,每個新方法和資料集都具有其優點和不足之處。

OmniDrive代理程式提出了兩階段的訓練策略:2D預訓練和3D微調。在2D預訓練階段,透過利用LLaVA v1.5的圖像文字配對資料集預訓練Q-Former和carrier queries,實現了圖像特徵與大型語言模型之間的更好對齊。在3D微調階段,引入了3D位置資訊編碼和時間模組,增強了模型的3D定位能力。透過利用LoRA對視覺編碼器和語言模型進行微調,OmniDrive既保持了對2D語意的理解,也增強了對3D定位的掌握。這樣分階段的訓練策略充分發揮了多模態大模型的潛力,使其在3D駕駛場景中具有更強的感知、推理和規劃能力。另一方面,OmniDrive-nuScenes作為一種全新的基準,專門為評估駕駛大模型的能力而設計。其完全自動化的QA生成流程透過GPT-4產生高品質的問答對,涵蓋了從感知到規劃的不同任務。此外,線上產生的定位任務也為模型提供了隱含的資料增強,幫助其更好地理解3D環境。該資料集的優勢還在於它不僅測試模型的感知和推理能力,還透過長時域問題來評估模型的空間理解和規劃能力。這種全面的基準為未來多模態大模型的研發提供了強而有力的支持。

然而,OmniDrive代理和OmniDrive-nuScenes数据集也存在一些不足之处。首先,由于OmniDrive代理在3D微调阶段需要微调整个模型,训练资源需求较高,使得训练时间和硬件成本显著增加。此外,OmniDrive-nuScenes的数据生成完全依赖GPT-4,虽然保证了问题的质量和多样性,但也导致生成的问题更倾向于自然语言能力强的模型,这可能使模型在基准测试时更依赖于语言特性而非实际驾驶能力。尽管OmniDrive-nuScenes提供了一个全面的QA基准,但其覆盖的驾驶场景仍然有限。数据集中涉及的交通规则和规划模拟仅基于nuScenes数据集,这使得生成的问题难以完全代表现实世界中的各种驾驶场景。此外,由于数据生成流程的高度自动化,生成的问题难免会受到数据偏见和提示设计的影响。

结论

作者提出的OmniDrive代理和OmniDrive-nuScenes数据集为3D驾驶场景中的多模态大模型研究带来了新的视角和评估基准。OmniDrive代理的两阶段训练策略成功地结合了2D预训练和3D微调,使得模型在感知、推理和规划方面均表现出色。OmniDrive-nuScenes作为全新的QA基准,为评估驾驶大模型提供了全面的指标。然而,仍需进一步研究以优化模型的训练资源需求,改进数据集的生成流程,并确保生成的问题能够更准确地代表现实驾驶环境。总体而言,作者的方法和数据集在推进驾驶领域多模态大模型研究方面具有重要意义,为未来的工作奠定了坚实基础。

以上是LLM全搞定! OmniDrive:集3D感知、推理規劃於一體(英偉達最新)的詳細內容。更多資訊請關注PHP中文網其他相關文章!

高維數據的高級矢量索引技術Apr 11, 2025 am 10:16 AM

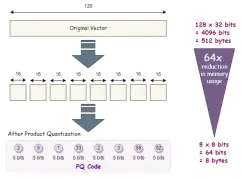

高維數據的高級矢量索引技術Apr 11, 2025 am 10:16 AM高維矢量搜索:掌握高級索引技術 在當今數據驅動的世界中,高維矢量對於推薦系統,圖像識別,自然語言處理(NLP)和異常等應用至關重要

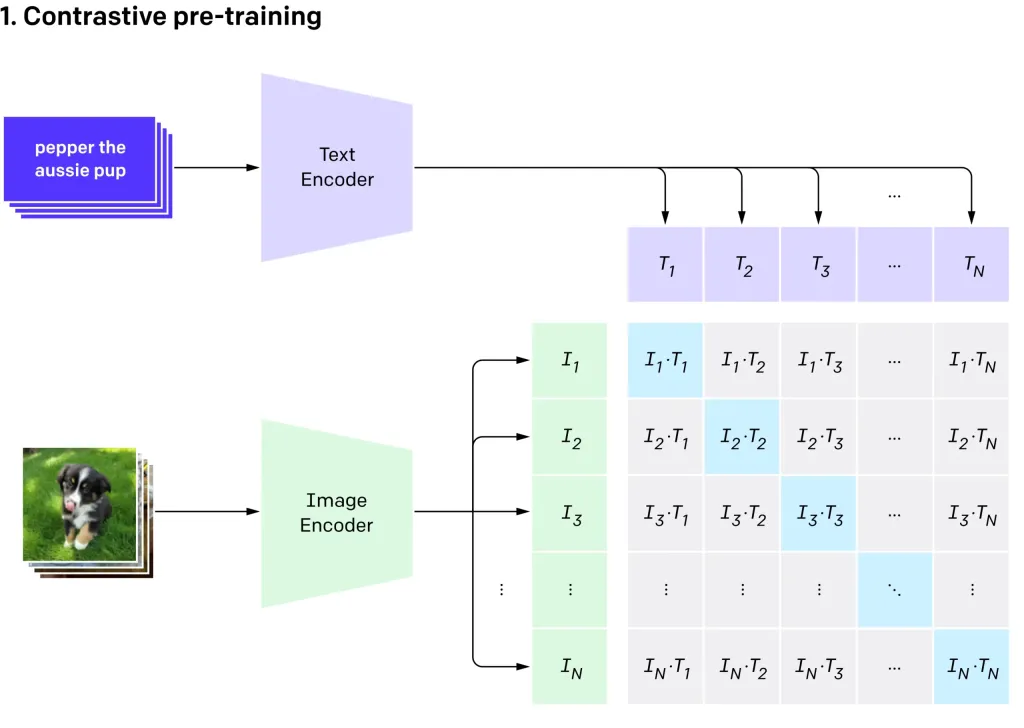

用OpenAI' s剪輯VIT-L14進行零擊圖像分類Apr 11, 2025 am 10:04 AM

用OpenAI' s剪輯VIT-L14進行零擊圖像分類Apr 11, 2025 am 10:04 AMOpenai的剪輯(對比語言 - 圖像預訓練)模型,特別是剪輯VIT-L14變體,代表了多模式學習和自然語言處理的重大進步。 這種強大的計算機視覺系統在Represe上擅長

建立沒有代碼的AI代理的7個步驟-Analytics VidhyaApr 11, 2025 am 10:03 AM

建立沒有代碼的AI代理的7個步驟-Analytics VidhyaApr 11, 2025 am 10:03 AM利用AI代理的功能使用Wordware:無需輕鬆AI代理創建的無代碼平台。 人工智能代理人正在徹底改變我們與計算機互動,自動化任務和簡化決策的方式。 該博客演示瞭如何構建

手機上的LLM:現在和將來的可能性 - 分析VidhyaApr 11, 2025 am 09:58 AM

手機上的LLM:現在和將來的可能性 - 分析VidhyaApr 11, 2025 am 09:58 AM生成AI:下一個智能手機戰場 智能手機行業陷入了激烈的競爭中:整合先進的生成AI的競賽。 從增強用戶互動到提高生產率,賭注很高。蘋果的iPhone 16

在2025年遵循的十大生成AI子列表 - 分析VidhyaApr 11, 2025 am 09:51 AM

在2025年遵循的十大生成AI子列表 - 分析VidhyaApr 11, 2025 am 09:51 AM生成AI:您的10個基本Reddit社區的指南 生成的AI正在迅速發展,新模型不斷出現。 保持更新至關重要,Reddit提供專門針對該領域的充滿活力的社區。本文凸顯了T

AI模型中的主要挑戰和局限性-Analytics VidhyaApr 11, 2025 am 09:44 AM

AI模型中的主要挑戰和局限性-Analytics VidhyaApr 11, 2025 am 09:44 AM介紹 人工智能(AI)已迅速整合到各種工作場所中,這是由於AI研發和開發的大量投資所推動。 AI的應用程序範圍很廣,從虛擬助手等簡單任務到com

處理SQL中的無效值Apr 11, 2025 am 09:37 AM

處理SQL中的無效值Apr 11, 2025 am 09:37 AM介紹 在數據庫的領域中,零值通常會帶來獨特的挑戰。 代表缺失,未定義或未知數據,它們可能使數據管理和分析複雜化。考慮一個缺少客戶反饋或orde的銷售數據庫

如何將Google Gemini集成到Tableau儀表板中?Apr 11, 2025 am 09:27 AM

如何將Google Gemini集成到Tableau儀表板中?Apr 11, 2025 am 09:27 AM利用Google Gemini在Tableau儀表板上的力量:AI驅動的增強 Tableau的強大可視化功能,跨越數據準備(Tableau Prep Builder),數據講故事(Tableau Desktop)和協作共享(TABL)

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver Mac版

視覺化網頁開發工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

WebStorm Mac版

好用的JavaScript開發工具

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)