阿里雲宣布自研 EMO 模型上線通義 App,用照片 + 音頻生成唱歌視頻

- 王林轉載

- 2024-04-26 08:00:381130瀏覽

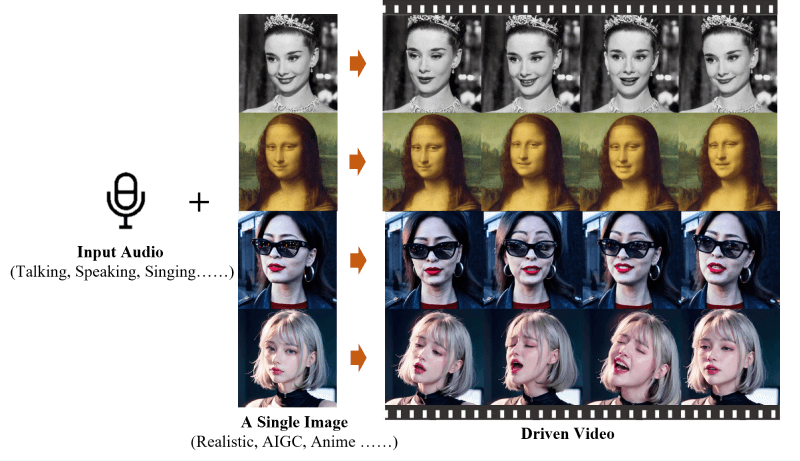

「本站4月25日消息,EMO(Emote Portrait Alive)是一個由阿里巴巴集團智能計算研究院開發的框架,一個音頻驅動的AI肖像視頻生成系統,能夠通過輸入單一的參考圖像和語音音頻,產生具有表現力的面部表情和各種頭部姿勢的視頻。用戶免費使用。透過這項功能,使用者可以在歌曲、熱梗、表情包中任選一款模板,然後透過上傳一張肖像照片就能讓 EMO 合成演唱影片。

本站附EMO 官網入口:

- 官方專案首頁:

- https://humanaigc.github.io/emote-portrait-alive/

- https://arxiv.org/abs/2402.17485

- https://github.com/HumanAIGC/EMO

(模型和原始碼待開源)

- 生成EMO音頻的視頻:EMO能夠根據輸入的音頻(如對話或歌曲)直接生成視頻,無需依賴於預先錄製的視頻片段或3D面部模型。

- 高表現力和逼真度:EMO 產生的影片具有高度的表現力,能夠捕捉並再現人類面部表情的細微差別,包括微妙的微表情,以及與音訊節奏相符的頭部運動。

- 無縫影格轉換:EMO 確保影片畫面之間的轉場自然流暢,避免了臉部扭曲或影格間抖動的問題,從而提高了影片的整體品質。

- 身份保持:透過 FrameEncoding 模組,EMO 能夠在影片產生過程中保持角色身分的一致性,確保角色的外觀與輸入的參考影像保持一致。

- 穩定的控制機制:EMO 採用了速度控制器和臉部區域控制器等穩定控制機制,以增強視訊產生過程中的穩定性,避免視訊崩潰等問題。

- 靈活的視頻長度:EMO 可以根據輸入音頻的長度生成任意時長的視頻,為用戶提供了靈活的創作空間。

- 跨語言和跨風格:EMO 的訓練資料集涵蓋了多種語言和風格,包括中文和英文,以及現實主義、動漫和3D 風格,這使得EMO 能夠適應不同的文化和藝術風格。

- #

以上是阿里雲宣布自研 EMO 模型上線通義 App,用照片 + 音頻生成唱歌視頻的詳細內容。更多資訊請關注PHP中文網其他相關文章!

陳述:

本文轉載於:ithome.com。如有侵權,請聯絡admin@php.cn刪除