Al Agent--大模型時代重要落地方向

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2024-04-15 09:10:011205瀏覽

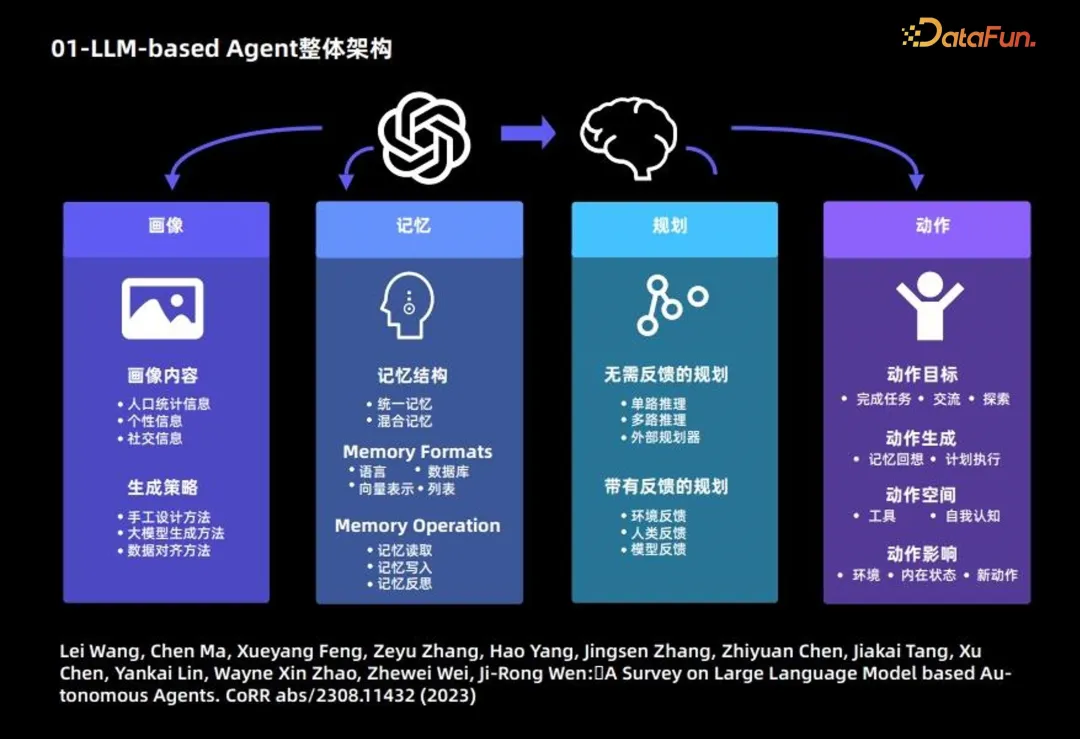

一、LLM-based Agent 整體架構

#大語言模型Agent 的組成,主要分為以下4個模組:

1. 畫像模組:主要描述Agent 的背景資訊

下面介紹畫像模組的主要內容和產生策略。

畫像內容,主要基於 3 種資訊:人口統計資訊、個人資訊和社交資訊。

產生策略:主要採用3 種策略來產生畫像內容:

- 手動設計方法:自行透過指定的方式,將使用者畫像的內容寫入大模型的 prompt 中;適用於 Agent 數量比較少的情況;

- #大模型產生方法:首先指定少量畫像,並將其作為示例,進而使用大語言模型產生更多的畫像;適用於大量 Agent 的情況;

- 資料對齊方法:需要根據事先指定的資料集中人物的背景資訊作為大語言模型的 prompt,進而做對應的預測。

2. 記憶模組:主要目的是記錄Agent 行為,並提供未來Agent 決策支援

記憶結構:

- 統一記憶:只考慮短期記憶,不考慮長期記憶。

- 混合記憶:長期記憶和短期記憶結合。

記憶形式:主要基於以下 4 種形式。

- 語言

- #資料庫

- 向量表示

- 列表

記憶內容:常見以下3 操作:

- #記憶讀取

- 記憶寫入

- #記憶反思

- 無需回饋的規劃:大語言模型在做推理的過程中無需外在環境的回饋。這類規劃進一步細分為三種:基於單路的推理,僅使用一次大語言模型就可以完整輸出推理的步驟;基於多路的推理,借鑒眾包的思想,讓大語言模型生成多個推理路徑,進而確定最佳路徑;借用外部的規劃器。

- 有回饋的規劃:這種規劃方式需要外界環境提供回饋,而大語言模型需要基於環境的回饋進行下一步以及後續的規劃。這類規劃回饋的提供者來自三個面向:環境回饋、人類回饋和模型回饋。

- 4. 動作模組

- #動作目標:有些Agent 的目標是完成某個任務,有些是交流,有些是探索。

動作空間:有些動作空間是工具的集合,有些是基於大語言模型自身知識,從自我認知的角度考慮整個動作空間。

動作影響:包括對環境的影響、對內在狀態的影響,以及對未來新動作的影響。

############以上是Agent 的整體框架,更多內容可參考下述論文:############Lei Wang, Chen Ma, Xueyang Feng, Zeyu Zhang, Hao Yang, Jingsen Zhang, Zhiyuan Chen, Jiakai Tang, Xu Chen, Yankai Lin, Wayne Xin Zhao, Zhewei Wei, Ji-Rong Wen:A Survey on Large Language Model based Autonomous Agents. /2308.11432 (2023)#########################二、LLM-based Agent 重點&困難問題

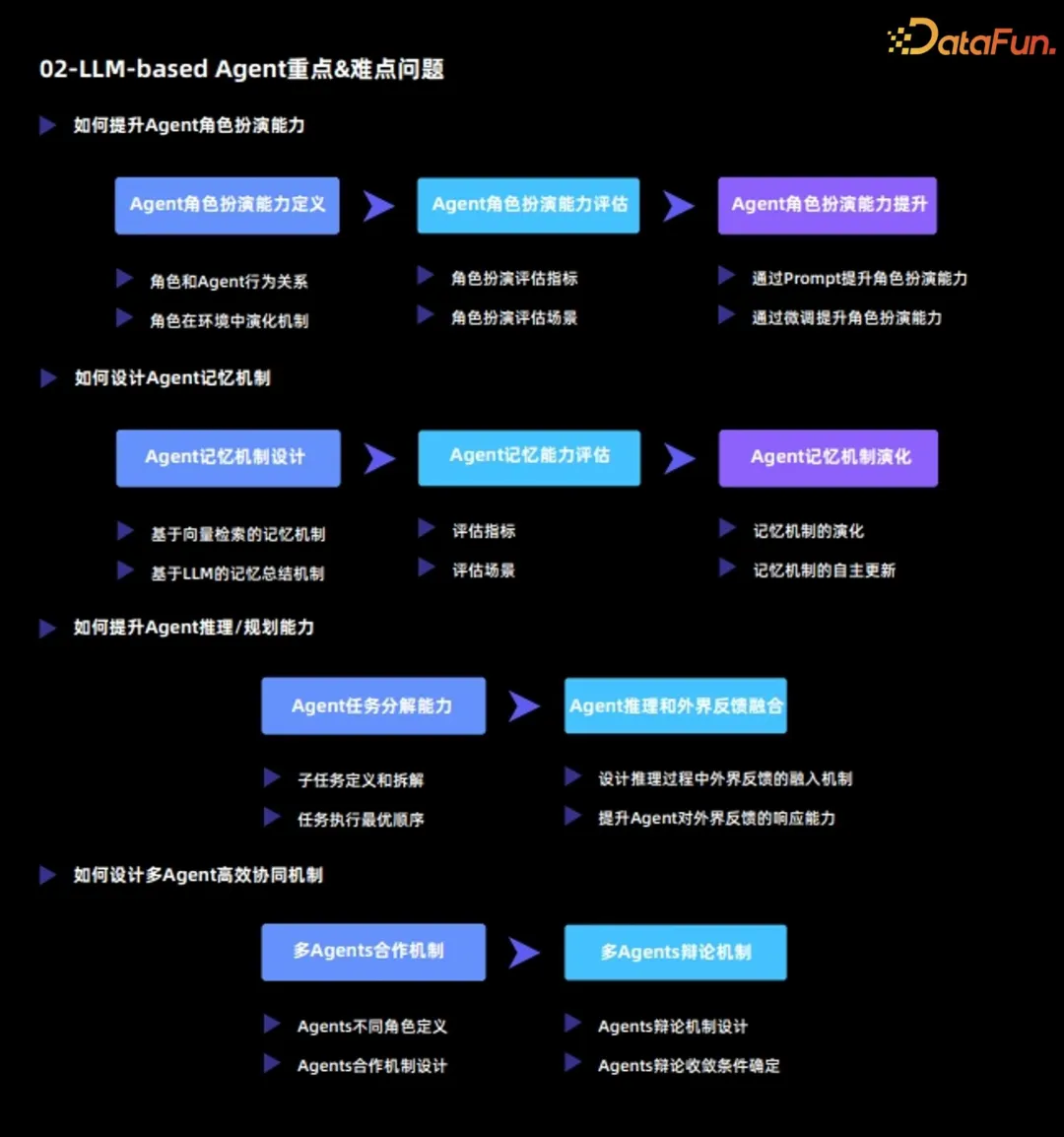

#目前大語言模型Agent 的重點和困難問題主要包括:

1. 如何提升Agent 的角色扮演能力

#Agent 最重要的功能是透過扮演某種角色,來完成特定的任務,或完成各種各樣的模擬,因此Agent 的角色扮演能力至關重要。

(1)Agent 角色扮演能力定義

#Agent 角色扮演能力分為兩個維度:

- 角色與Agent 行為關係

- #角色在環境中演化機制

(2)Agent 角色扮演能力評估

定義了角色扮演能力之後,接下來要對Agent 角色扮演能力,從以下兩個面向進行評估:

- 角色扮演評估指標

- 角色扮演評估場景

(3)Agent 角色扮演能力提升

#在評估的基礎上,需要進一步對Agent 的角色扮演能力進行提升,有以下兩種方法:

- 透過Prompt 提升角色扮演能力:此方法本質是透過設計prompt 來激發原有大語言模型的能力;

- 透過微調提升角色扮演能力:此方法通常是基於外部的數據,重新對大語言模型進行finetune,來提升角色扮演能力。

2. 如何設計Agent 記憶機制

Agent 和大語言模型最大的不同在於,Agent 能夠在環境中不斷進行自我演化和自我學習;而這其中,記憶機制扮演了非常重要的角色。從3 個維度分析Agent 的記憶機制:

##(1)Agent 記憶機制設計

常見有以下兩種記憶機制:

- 基於向量檢索的記憶機制

- #基於LLM 總結的記憶機制

(2)Agent 記憶能力評估

#對Agent 記憶能力的評估,主要需要確定以下兩點:

- 評估指標

- #評估場景

(3)Agent 記憶機制演化

最後需要對Agent 記憶機制演化進行分析,包括:#

- 記憶機制的演化

- #記憶機制的自主更新

3. 如何提升Agent 推理/規劃能力

(1)Agent 任務分解能力

- 子任務定義與拆解

- 任務執行最優順序

# (2)Agent 推理與外界回饋融合

- 設計推理過程中外界回饋的融入機制:讓Agent 和環境形成互相互動的整體;

- 提升Agent 對外界回饋的回應能力:一方面需要Agent 真實應對外界環境,另一方面需要Agent 能夠對外界環境提出問題並尋求解答。

4. 如何設計多Agent 高效率協同機制

(1)多Agents 合作機制

- #Agents 不同角色定義

- #Agents 合作機制設計

#(2)多Agents 辯論機制

#Agents 辯論機制設計

Agents 辯論收斂條件決定

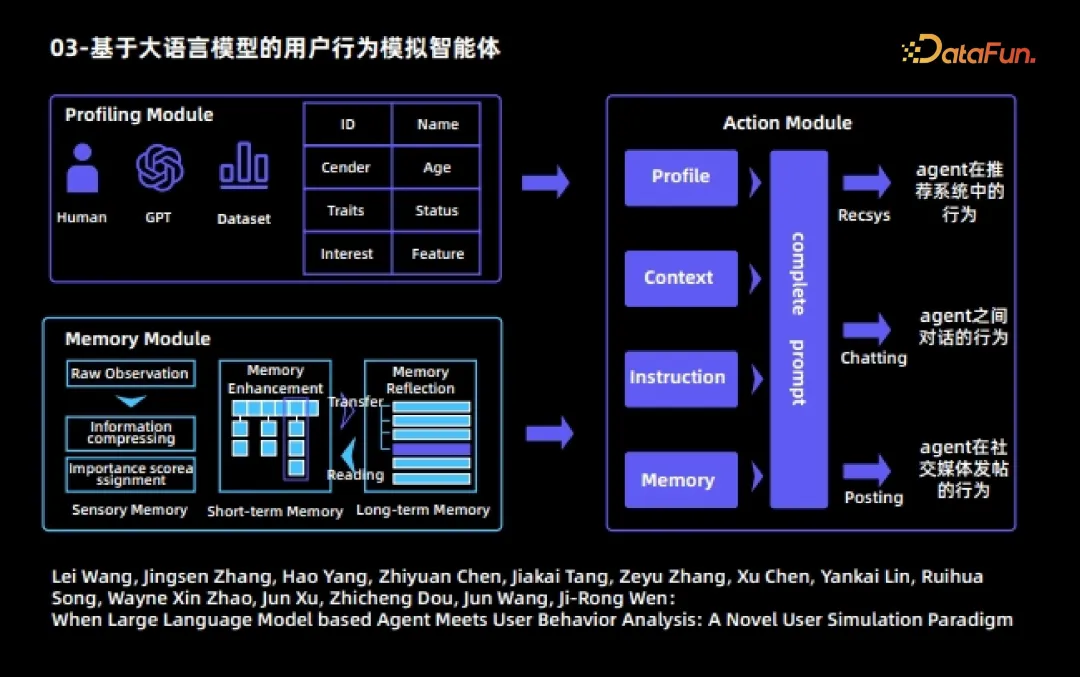

- 三、基於大語言模型的使用者行為模擬智能體

下面會舉出幾個Agent 的實際案例。首先是基於大語言模型的使用者行為模擬智能體。該智能體也是大語言模型智能體與使用者行為分析結合的早期工作。在該工作中,每個Agent 分為三個模組:

- 1. 畫像模組 對不同的Agent 指定不同的屬性,例如ID、姓名、職業、年齡、興趣以及特徵等。

- 2. 記憶模組

- #記憶模組包含三個子模組 (1)感受記憶

(2)短期記憶

- #將客觀觀測到的raw observation 處理後,產生資訊量更高的觀測,將其存放到短期記憶中;

- #短期記憶內容的儲存時間比較短

- (3)長期記憶

- 短期記憶的內容經過反覆的觸發和激活後,會自動傳入到長期記憶中

長期記憶內容的儲存時間比較長

#########長期記憶的內容會根據現有的記憶進行自主的反思以及昇華提煉。 ##################3. 動作模組#############每個Agent 可以執行三個動作:####### ###########Agent 在推薦系統中的行為,包括觀看影片、尋找下一頁、離開推薦系統等;################# #Agent 之間的對話行為;##################Agent 在社群媒體上發佈的行為。 ##################在整個模擬過程中,一個Agent 在每一輪動作中均可自由地、不受外界幹預地選擇三種動作;我們可以看到不同Agent 之間會相互對話,也會在社群媒體或推薦系統中自主地產生各種各樣的行為;透過多輪模擬之後,可以觀察到一些有趣的社會現象,以及使用者在網路上行為的規律。 ############更多內容可參考下述論文:######Lei Wang, Jingsen Zhang, Hao Yang, Zhiyuan Chen, Jiakai Tang, Zeyu Zhang, Xu Chen, Yankai Lin, Ruihua Song, Wayne Xin Zhao, Jun Xu, Zhicheng Dou, Jun Wang, Ji-Rong Wen :When Large Language Model based Agent Meets User Behavior Analysis: A Novel User Simulation Paradigm

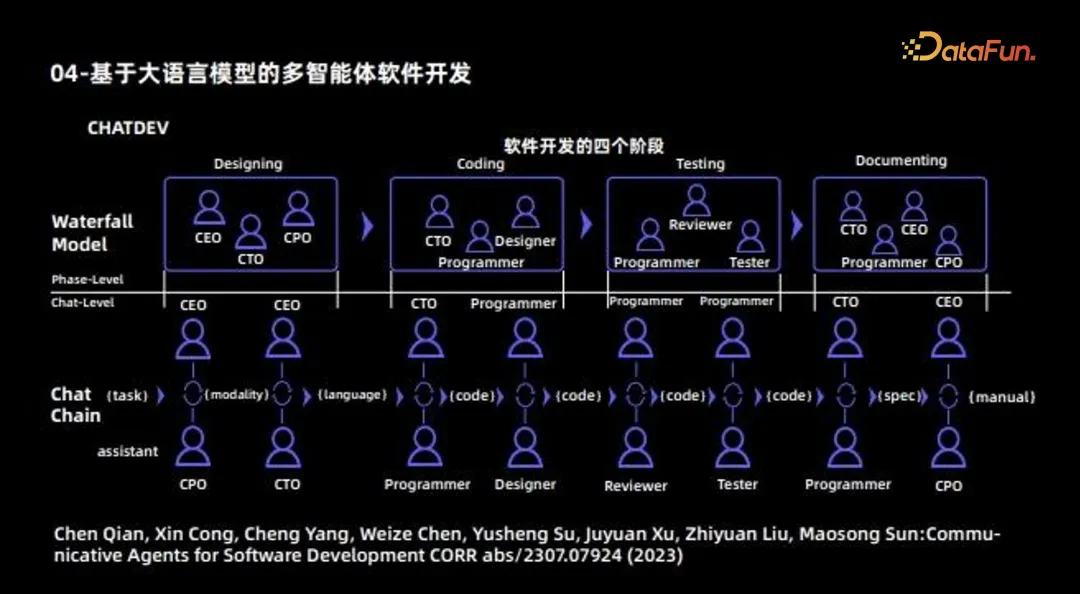

四、基於大語言模型的多智能體軟體開發

下一個Agent 的例子是使用多Agent 進行軟體開發。這篇工作也是早期多Agent 合作的工作,最主要的目的是利用不同 Agent 開發一款完整的軟體。因此可將其視為一個軟體公司,不同的Agent 會扮演不同的角色:一部分Agent 負責設計,包括CEO、CTO、CPO 等角色;一部分Agent 負責編碼,還有一部分Agent 主要負責測試;此外,還會有一部分Agent 負責撰寫文件。這樣,不同 Agent 負責不同的工作;最後再將 Agent 之間的合作機制,透過交流的方式進行協同和更新,最終完成一個軟體完整的開發過程。

-

大語言模型的Agent 目前可以分為兩大方向:#解決特定任務,如MetaGPT、ChatDev、Ghost、DESP 等 -

這類Agent 最終應是一個和人類正確價值觀對齊的“超人”,其中有兩個“限定詞”:

對齊正確的人類價值;

超越常人能力。 模擬現實世界,如Generative Agent、Social Simulation、RecAgent等

這類Agent 所需要的能力,和第一類是完全相反的。

- 讓 Agent 呈現多元的價值觀;

#希望 Agent 盡量符合一般人,而不是超越常人。

此外,大語言模型Agent 目前存在以下兩個痛點:幻覺問題 -

由於Agent 需要跟環境進行不斷交互,因此每個步驟的幻覺都會被累加,即會產生累積效應,讓問題變得更加嚴重;因此大模型的幻覺問題在這裡需要得到進一步的重視。其解決方法包括: 設計高效率的人機協作框架;

以上是Al Agent--大模型時代重要落地方向的詳細內容。更多資訊請關注PHP中文網其他相關文章!