DeepMind終結大模型幻覺?標註事實比人類可靠、還便宜20倍,全開源

- PHPz轉載

- 2024-03-30 18:01:32648瀏覽

大模型的幻覺終於要終結了?

今日,社群媒體平台Reddit上的一則貼文引起網友熱議。貼文討論的是GoogleDeepMind昨日提交的一篇論文《Long-form factuality in large language models(大語言模型的長篇事實性)》,文中提出的方法和結果讓人得出大語言模型幻覺不再是問題了。

我們知道,大語言模型在回應開放式主題的fact-seeking(事實尋求)提問時,通常會產生包含事實錯誤的內容。 DeepMind 針對這一現象進行了一些探索性研究。

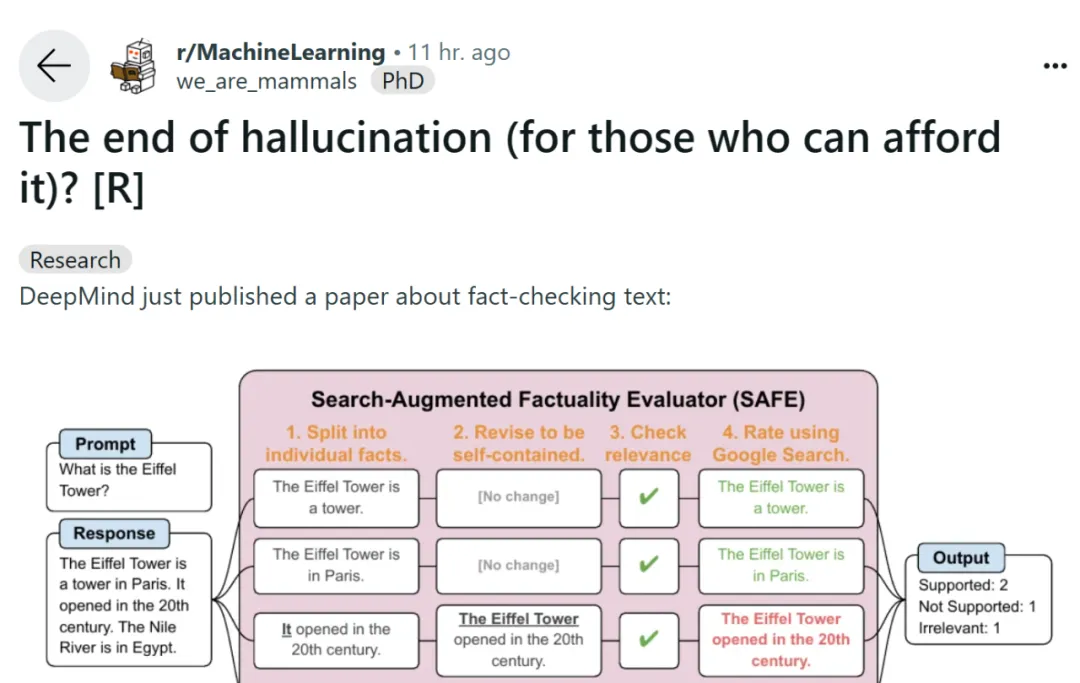

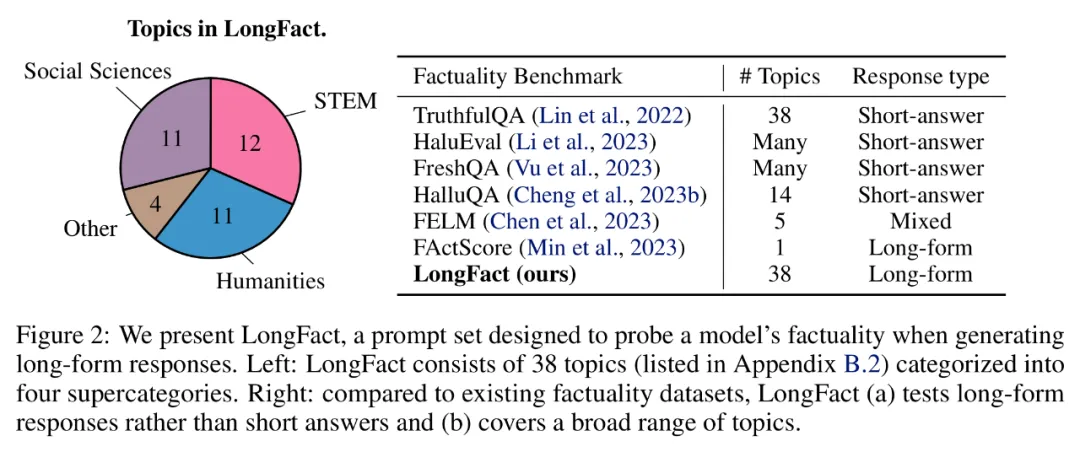

為了對一個模型在開放域的長篇事實性進行基準測試,研究者使用GPT-4 產生LongFact,它是一個包含38個主題、數千個問題的提示集。然後他們提出使用搜尋增強事實評估器(SAFE)來將 LLM 智能體用作長篇事實性的自動評估器。 SAFE 的目的是提高事實可信度評估器的準確性。

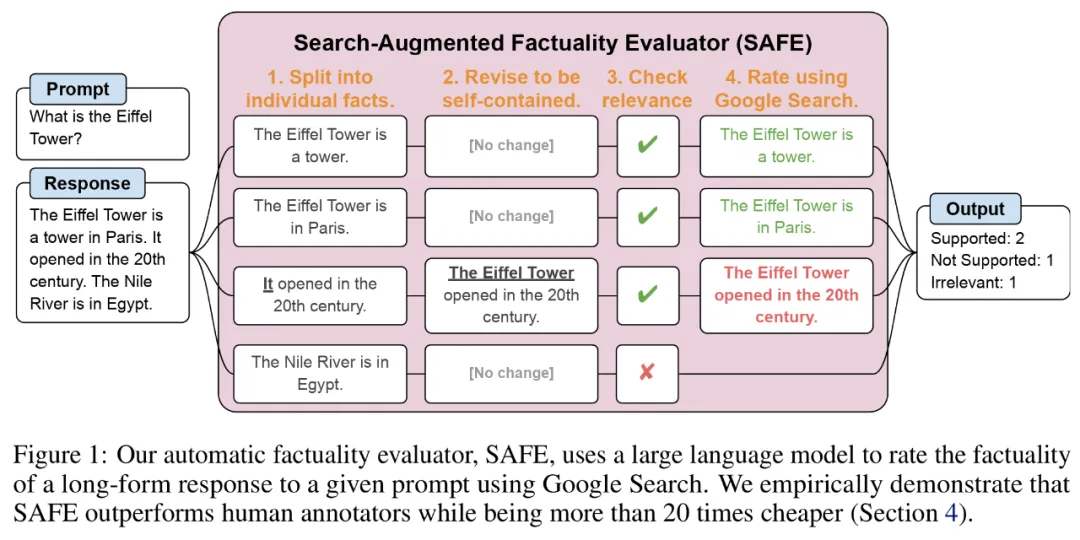

關於SAFE,使用LLM可以更準確地解釋每個實例的準確性。這裡多步驟推理過程包括將搜尋查詢傳送到Google搜尋並確定搜尋結果是否支援某個實例。

論文網址:https://arxiv.org/pdf/2403.18802.pdf

GitHub網址:https://github.com/google-deepmind/long-form-factuality

此外,研究者提出將F1 分數(F1@K)擴展為長篇實踐性的聚合指標。他們平衡了回應中支援的實際的百分比(精度)和所提供事實相對於代表用戶首選回應長度的超參數的百分比(召回率)。

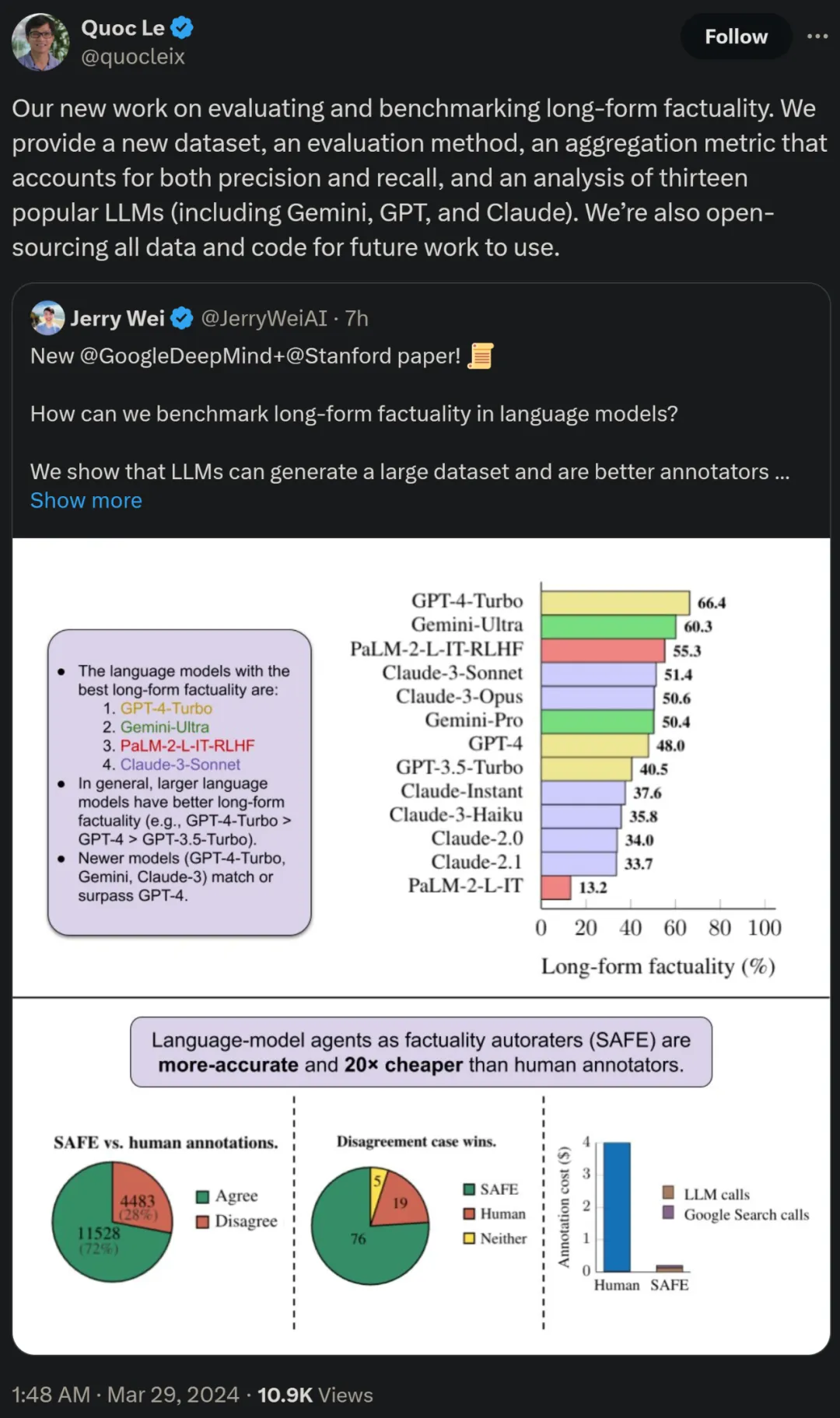

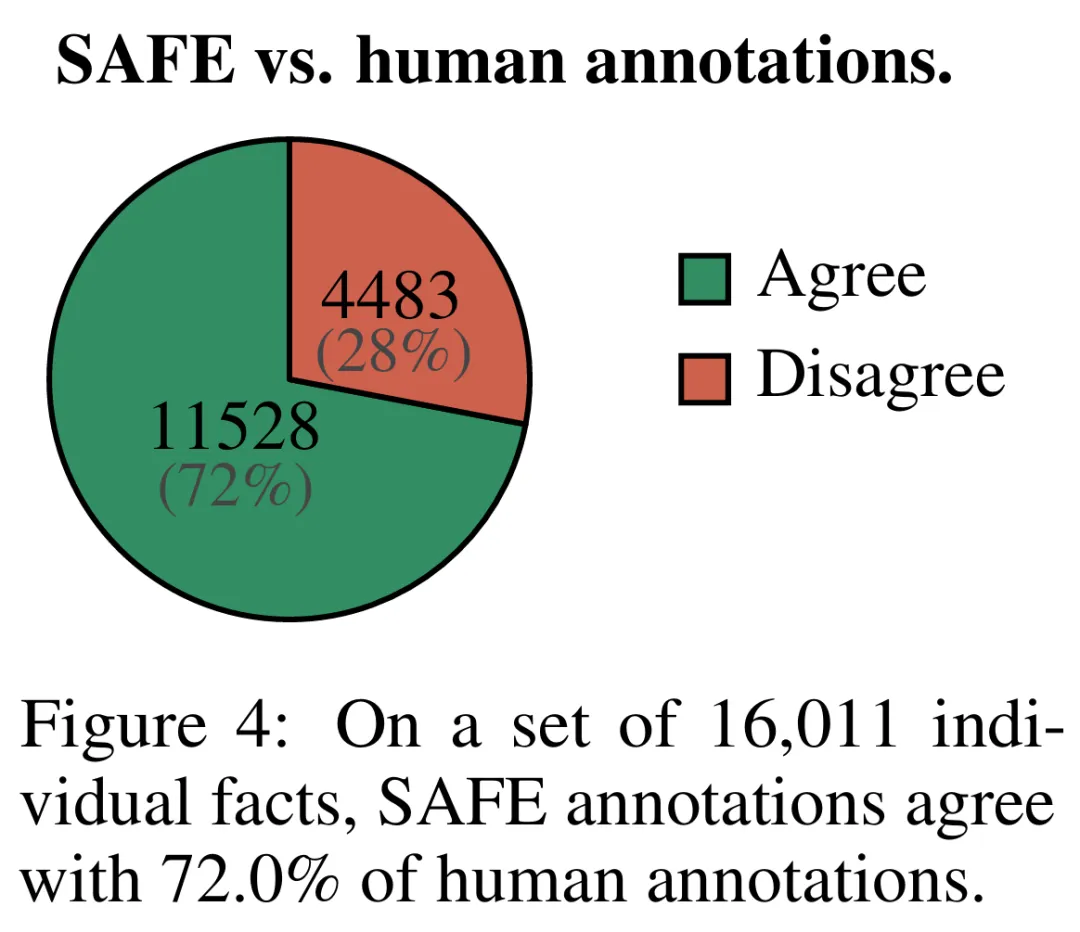

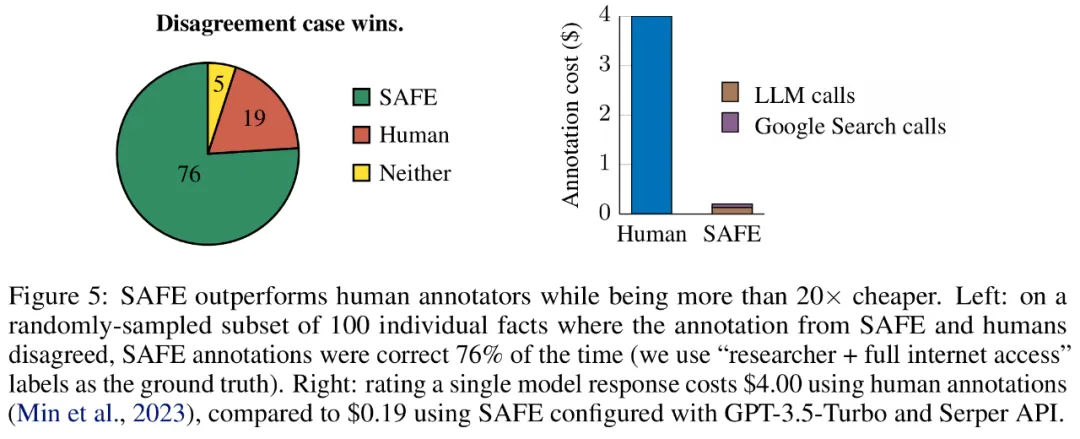

實證結果表明,LLM 智能體可以實現超越人類的評級表現。在一組約 16k 個單獨的事實上,SAFE 在 72% 的情況下與人類註釋者一致,並且在 100 個分歧案例的隨機子集上,SAFE 的贏率為 76%。同時,SAFE 的成本比人類註釋者便宜 20 倍以上。

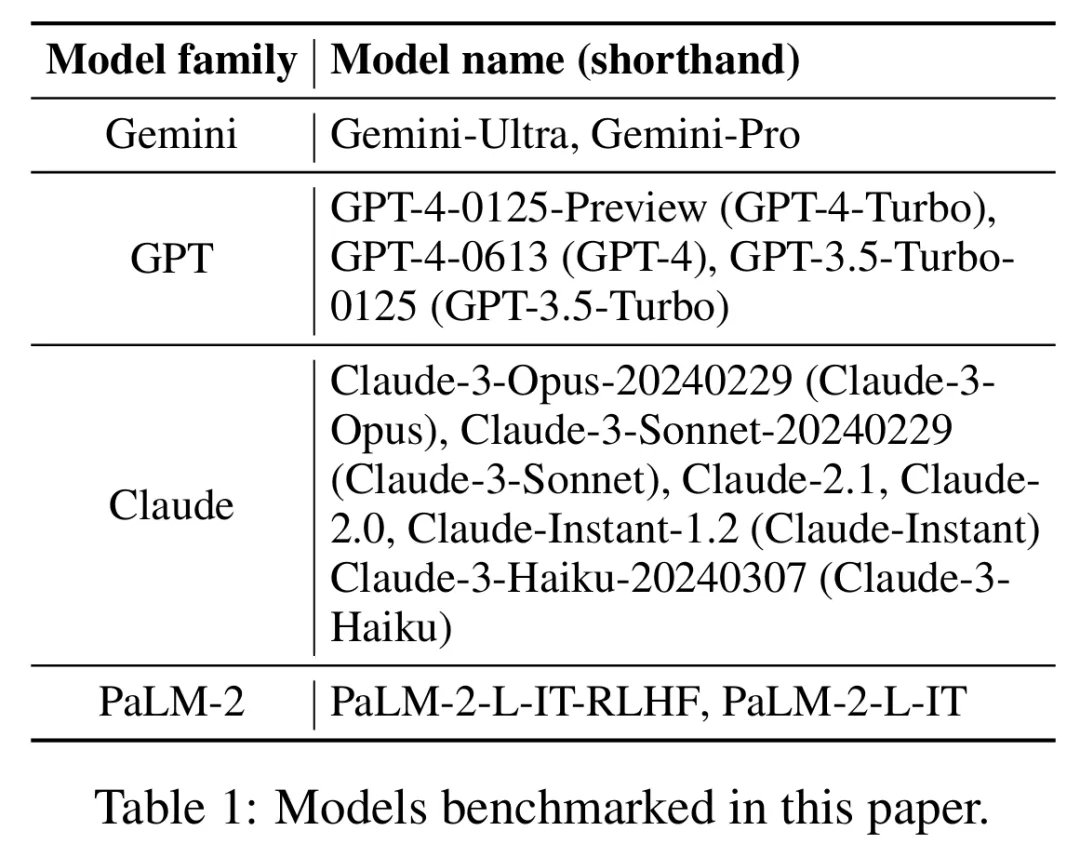

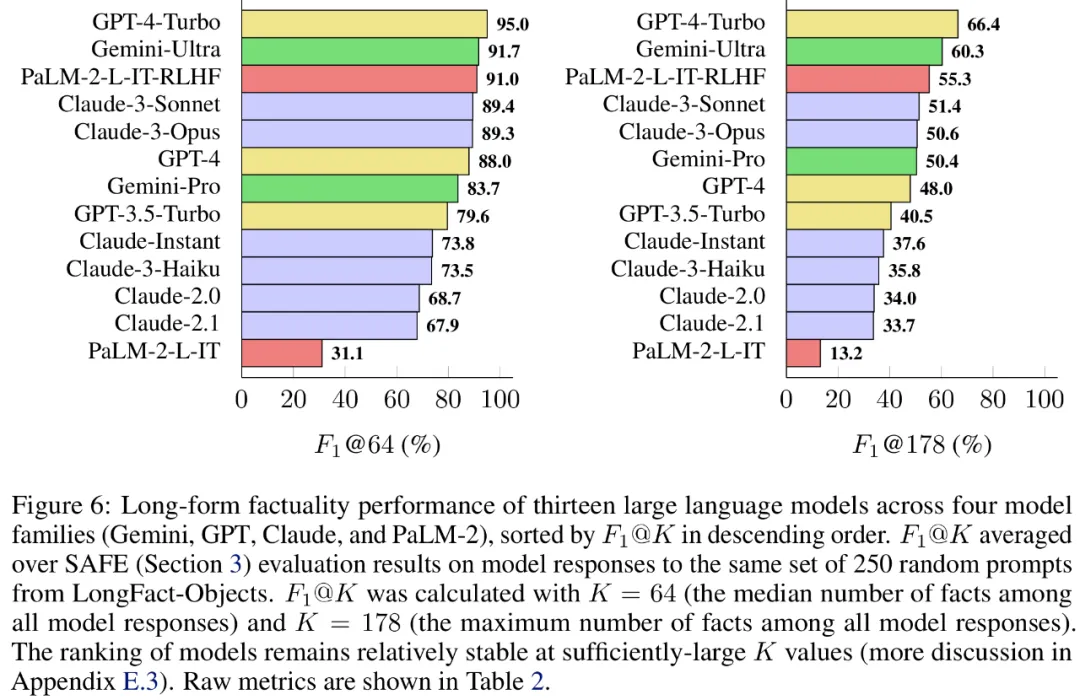

研究者也使用LongFact,對四個大模型系列(Gemini、GPT、Claude 和PaLM-2)的13 種流行的語言模型進行了基準測試,結果發現較大的語言模型通常可以實現更好的長篇事實性。

論文作者之一、Google研究科學家Quoc V. Le 表示,這篇對長篇事實性進行評估和基準測試的新工作提出了一個新資料集、 一種新評估方法以及一種兼顧精確度和召回率的聚合指標。同時所有資料和程式碼將開源以供未來工作使用。

方法概覽

#LONGFACT:使用LLM 產生長篇事實性的多主題基準

首先來看使用GPT-4 產生的LongFact 提示集,包含了2280 個事實尋求提示,這些提示要求跨38 個手動選擇主題的長篇回應。研究者表示,LongFact 是第一個用於評估各領域長篇事實性的提示集。

LongFact 包含兩個任務:LongFact-Concepts 和 LongFact-Objects,根據問題是否詢問概念或物件來區分。研究者為每個主題產生 30 個獨特的提示,每個任務各有 1140 個提示。

SAFE:LLM 智能體作為事實性自動評分者

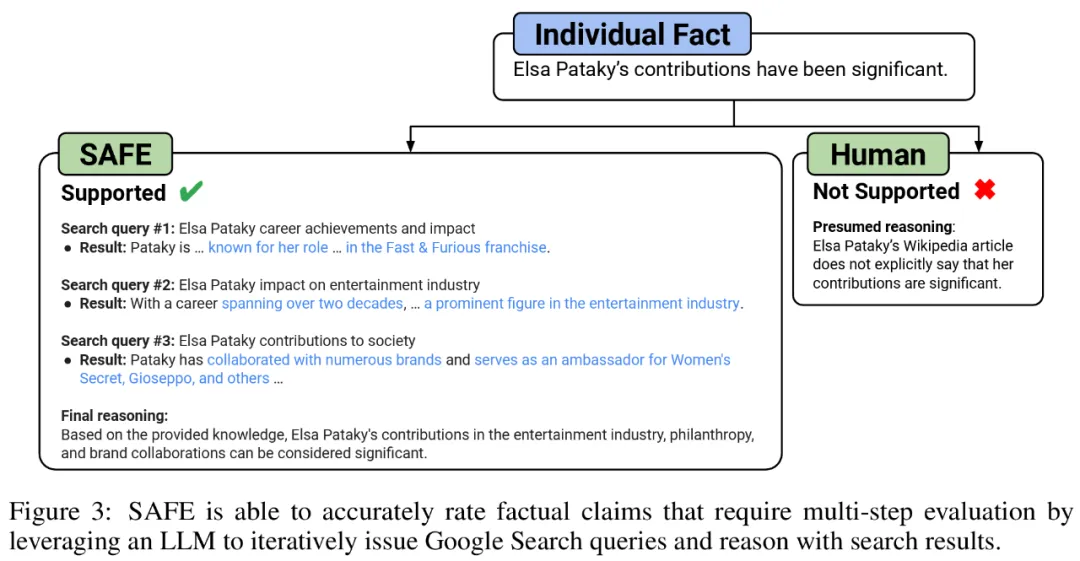

研究者提出了搜尋增強事實評估器(SAFE),它的運作原理如下所示:

a)將長篇的回應拆分為單獨的獨立事實;

b)確定每個單獨的事實是否與回答上下文中的提示相關;

c) Для каждого релевантного факта итеративно введите поисковый запрос Google в многоэтапном процессе и оцените, подтверждают ли результаты поиска этот факт.

Они считают, что ключевым нововведением SAFE является использование языковых моделей в качестве агентов для создания многоэтапных поисковых запросов Google и тщательного анализа того, подтверждают ли результаты поиска факты. На рисунке 3 ниже показан пример цепочки рассуждений.

Чтобы разделить длинный ответ на отдельные независимые факты, исследователи сначала предложили языковой модели разделить каждое предложение в длинном ответе на отдельные факты, а затем измените каждый отдельный факт, чтобы он был независимым, поручив модели заменить неоднозначные ссылки (например, местоимения) правильными объектами, на которые они ссылаются в контексте ответа.

Чтобы оценить каждый независимый факт, они использовали языковую модель, чтобы определить, имеет ли этот факт отношение к подсказке, на которую был дан ответ в контексте ответа, а затем использовали многоэтапный метод для ранжирования. каждому оставшемуся Соответствующие факты оцениваются как «подтвержденные» или «не подтвержденные». Подробности показаны на рисунке 1 ниже.

На каждом этапе модель генерирует поисковый запрос на основе фактов, подлежащих оценке, и ранее полученных результатов поиска. После определенного количества шагов модель выполняет вывод, чтобы определить, подтверждают ли результаты поиска этот факт, как показано на рисунке 3 выше. После того, как все факты оценены, выходными показателями SAFE для данной пары «быстрый ответ» являются количество «подтверждающих» фактов, количество «нерелевантных» фактов и количество «неподтвержденных» фактов.

Результаты экспериментов

#Агент LLM становится лучшим аннотатором фактов, чем люди

Чтобы количественно оценить качество аннотаций, полученных с помощью SAFE, исследователи использовали аннотации, полученные вручную. Данные содержат 496 пар «подсказка-ответ», в которых ответы были вручную разбиты на отдельные факты (всего 16 011 отдельных фактов), и каждый отдельный факт был вручную помечен как поддерживаемый, нерелевантный или неподдерживаемый.

Они напрямую сравнили аннотации SAFE с аннотациями человека для каждого факта и обнаружили, что SAFE согласуется с людьми в 72,0% отдельных фактов, как показано на рисунке 4 ниже. Это показывает, что SAFE достигает эффективности человеческого уровня по большинству отдельных фактов. Затем была проверена подгруппа из 100 отдельных фактов из случайных интервью, для которых аннотации SAFE не соответствовали аннотациям оценщиков-людей.

Исследователи вручную повторно аннотировали каждый факт (открывая доступ к поиску Google, а не только к Википедии, для более подробной аннотации) и использовали эти метки как основная истина. Они обнаружили, что в этих случаях разногласий аннотации SAFE были правильными в 76% случаев, в то время как аннотации, написанные человеком, были правильными только в 19% случаев, что представляет собой коэффициент выигрыша SAFE 4 к 1. Подробности показаны на рисунке 5 ниже.

Здесь цены на два аннотационных плана заслуживают внимания. Стоимость оценки ответа одной модели с использованием человеческих аннотаций составляет 4 доллара США, а стоимость SAFE с использованием GPT-3.5-Turbo и Serper API — всего 0,19 доллара США.

#Бенчмарки серий Gemini, GPT, Claude и PaLM-2

Наконец Исследователи провели обширное тестирование LongFact на 13 крупных языковых моделях из четырех серий моделей (Gemini, GPT, Claude и PaLM-2), представленных в таблице 1 ниже.

В частности, они оценивали каждую модель, используя одно и то же случайное подмножество из 250 запросов в LongFact-Objects, а затем использовали SAFE для получения необработанных показателей оценки ответа каждой модели. Индикатор F1@K для агрегации.

##

Было обнаружено, что, как правило, более крупные языковые модели обеспечивают лучшую фактологичность в полной форме. Как показано на рисунке 6 и в таблице 2 ниже, GPT-4-Turbo лучше, чем GPT-4, GPT-4 лучше, чем GPT-3.5-Turbo, Gemini-Ultra лучше, чем Gemini-Pro, и PaLM-2-L. -IT-RLHF Лучше, чем PaLM-2-L-IT.

以上是DeepMind終結大模型幻覺?標註事實比人類可靠、還便宜20倍,全開源的詳細內容。更多資訊請關注PHP中文網其他相關文章!