Grok-1官宣开源不过半月,新升级的Grok-1.5出炉了。

刚刚,马斯克xAI官宣,128K上下文Grok-1.5,推理能力大幅提升。

并且,很快就会上线。

11天前,Grok-1模型的权重和架构开源,展示了Xai在去年11月之前取得的进展。

Grok-1有3140亿参数,是Llama 2的4倍大,而且采用的是MoE架构,8个专家中2个是活跃专家。

Xai介绍,也就是从那时起,团队改进了最新模型Grok-1.5的推理和解决问题的能力。

OpenAI前开发者关系负责人表示,从xAI重大发布的时间可以看出他们前进的步伐和紧迫感。令人振奋!

128K上下文,Grok-1.5数学推理能力暴涨

根据官方介绍,Grok-1.5改进了推理能力,上下文长度为128K。

Grok-1.5最显著的改进之一是,它在编码和数学相关任务中的表现。

在测试中,Grok-1.5在数学基准上取得50.6%的得分,在GSM8K基准上获得了90%,这两个数学基准涵盖了从小学到高中的各种竞赛问题。

此外,在评估代码生成和解决问题能力的HumanEval基准测试中,Grok-1.5获得了74.1%的高分。

从下图中,与Grok-1相比,可以看出Grok-1.5在数学方面的能力得到大幅提升,GSM8K上从62.9%改进到90,MATH上从23.9%提升到50.6%。

128K长语境理解,扩增16倍

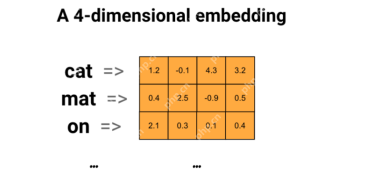

Grok-1.5另一全新特点是,能够在其上下文窗口内处理高达128K token的文本。

这使Grok的内存容量,增加到以前上下文长度的16倍,从而使它能够利用更长的文档中的信息。

此外,新模型还可以处理更长和更复杂的提示,同时在其上下文窗口扩展时仍保持其指令跟随能力。

在Needle In A Haystack(NIAH)评估中,Grok-1.5 展示了强大的检索能力,可检索长度达 128K 字节的上下文中的嵌入文本,并取得了完美的检索结果。

Grok-1.5基础设施

Grok-1.5构建在基于JAX、Rust和Kubernetes的定制分布式训练框架之上。

这个训练堆栈可以让xAI团队能够以最少的投入,大规模构建创意,以及训练新的架构。

在大型计算群集上进行训练LLM的一个主要挑战是,最大限度地提高训练任务的可靠性和正常运行时间。

xAI定制的训练编排器,可确保自动检测有问题的节点,并将其从训练任务剔除。

与此同时,他们还优化了检查点、数据加载和训练任务的重启,以最大限度地减少发生故障时的停机时间。

xAI表示,Grok-1.5很快就會提供給早期測試者,以幫助改進模型。

部落格也預告了Grok-1.5將在未來幾天推出幾個新功能。

最後,xAI還是一如既往地po出了招募資訊。

以上是開源11天,馬斯克再發Grok-1.5!128K代碼擊敗GPT-4的詳細內容。更多資訊請關注PHP中文網其他相關文章!

從技術創新者到醫療保健先驅:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AM

從技術創新者到醫療保健先驅:Geetha Manjunath博士的AI故事Apr 19, 2025 am 11:02 AMNiramai Analytix的創始人兼首席執行官Geetha Manjunath博士的這一集由“領導數據”的劇集。 Manjunath博士擁有AI和Healthcare的25年以上的經驗,並獲得了印度科學學院的博士學位和MBA來回。

用Ollama -Analytics Vidhya簡化本地LLM部署Apr 19, 2025 am 11:01 AM

用Ollama -Analytics Vidhya簡化本地LLM部署Apr 19, 2025 am 11:01 AM利用Ollama本地開源LLMS的力量:綜合指南 運行大型語言模型(LLMS)本地提供無與倫比的控制和透明度,但是設置環境可能令人生畏。 Ollama簡化了這個過程

如何使用Monsterapi微調大語言模型Apr 19, 2025 am 10:49 AM

如何使用Monsterapi微調大語言模型Apr 19, 2025 am 10:49 AM利用微調LLM的功能與Monsterapi:綜合指南 想像一個虛擬助手完美理解並預測您的需求。 由於大型語言模型(LLMS)的進步,這已成為現實。 但是,

5統計測試每個數據科學家都應該知道-Analytics VidhyaApr 19, 2025 am 10:27 AM

5統計測試每個數據科學家都應該知道-Analytics VidhyaApr 19, 2025 am 10:27 AM數據科學的基本統計測試:綜合指南 從數據中解鎖有價值的見解至關重要。 掌握統計測試對於實現這一目標至關重要。這些測試使數據科學家能夠嚴格瓦爾

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM介紹 原始變壓器的引入為當前的大語言模型鋪平了道路。同樣,在引入變壓器模型之後,引入了視覺變壓器(VIT)。喜歡

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AM

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AMLangchain文本拆分器:優化LLM輸入以提高效率和準確性 我們上一篇文章介紹了Langchain的文檔加載程序。 但是,LLM具有上下文窗口大小的限制(以代幣測量)。 超過此限制會截斷數據,comp

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM生成的AI:革命性的創造力和創新 生成的AI通過按下按鈕來創建文本,圖像,音樂和虛擬世界來改變行業。 它的影響跨越視頻編輯,音樂製作,藝術,娛樂,HEA

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM利用嵌入模型的力量來回答高級問題 在當今信息豐富的世界中,立即獲得精確答案的能力至關重要。 本文展示了使用強大的提問(QA)模型

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver Mac版

視覺化網頁開發工具

記事本++7.3.1

好用且免費的程式碼編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。