隨著 Sora 發布成功,影片 DiT 模型引起了廣泛關注和討論。設計穩定的超大規模神經網路一直是視覺生成領域研究的重點。 DiT 模型的成功為影像生成的規模化帶來了新的可能性。

然而,由於視訊資料的高度結構化和複雜性,將 DiT 擴展到視訊生成領域是一項具有挑戰性的任務。由上海人工智慧實驗室的研究團隊和其他機構共同組成的團隊,透過大規模的實驗回答了這個問題。

去年11月,該團隊已經發布了一款名為Latte的自研模型,其技術與Sora有相似之處。 Latte是全球首個開源文生影片DiT,受到了廣泛關注。許多開源框架如Open-Sora Plan (PKU)和Open-Sora (ColossalAI)都在使用和參考Latte的模型設計。

- 開源連結:https://github.com/Vchitect/Latte

- 計畫首頁:https://maxin-cn.github.io/latte_project/

- 論文連結:https:/ /arxiv.org/pdf/2401.03048v1.pdf

#先來看Latte的影片產生效果。

方法介紹

#總的來說,Latte包含兩個關鍵模組:預先訓練的VAE和視頻DiT。在預先訓練的VAE中,編碼器負責將視訊逐幀從像素空間壓縮到潛在空間,而視訊DiT則負責提取token並進行時空建模以對潛在表徵進行處理,最後,VAE解碼器將特徵映射回像素空間以產生視訊。為了獲得最佳的視頻質量,研究者專注於Latte設計中的兩個重要方面,即視頻DiT模型的整體結構設計和模型訓練的最佳實踐細節。

(1)Latte 整體模型結構設計探究

圖1 . Latte 模型結構及其變體

作者提出了4 種不同的Latte 變體(圖1),從時空注意力機制的角度設計了兩種Transformer 模組,同時在每個模組中分別研究了兩種變體(Variant):

1. 單注意力機制模組,每個模組中只包含時間或空間注意力。

- 時空交錯式建模 (Variant 1): 時間模組插入到各個空間模組之後。

- 時空順序式建模 (Variant 2): 時間模組整體置於空間模組之後。

2. 多重註意力機制模組,每個模組中同時包含時間與空間注意力機制(Open-sora所參考變體)。

- 串聯式時空注意力機制 (Variant 3): 時空注意力機制串列建模。

- 並聯式時空注意力機制 (Variant 4): 時空注意力機制並行建模並特徵融合。

實驗顯示(圖2),透過對4 種模型變體設定相同的參數量,變體4 相較於其他三種變體在FLOPS 上有著明顯的差異,因此FVD 上也相對最高,其他3 種變體整體性能類似,變體1 取得了最優異的性能,作者計劃未來在大規模的數據上做更加細緻的討論。

圖2.模型結構 FVD

(2)Latte 模型與訓練細節的最優設計探究(The best practices)

除了模型整體結構設計,作者也探討了其他模型與訓練中影響生成效果的因素。

1.Token 提取:探究了單幀 token(a)和時空 token(b)兩種方式,前者只在空間層面壓縮 token,後者同時壓縮時空資訊。實驗顯示單一影格 token 要優於時空 token(圖 4)。與 Sora 進行比較,作者猜測 Sora 提出的時空 token 是透過視訊 VAE 進行了時間維度的預壓縮,而在隱空間上與 Latte 的設計類似都只進行了單幀 token 的處理。

圖3. Token 擷取方式,(a) 單一畫面token 與(b) 時空token

#圖4. Token 提取FVD

#2. 條件注入模式:探究了(a)S-AdaLN 和(b)all tokens 兩種方式(圖5)。 S-AdaLN 透過 MLP 將條件資訊轉換為歸一化中的變數注入到模型中。 All token 形式將所有條件轉換為統一的 token 作為模型的輸入。實驗證明,S-AdaLN 的方式相較於 all token 對於獲得高品質的結果更有效 (圖 6)。原因是,S-AdaLN 可以使資訊直接注入到每一個模組。而 all token 需要將條件資訊從輸入逐層傳遞到最後,存在著資訊流動過程中的損失。

圖 5. (a) S-AdaLN 和 (b) all tokens。

圖6. 條件注入方式FVD

3. 時空位置編碼:探討了絕對位置編碼與相對位置編碼。 不同的位置編碼對最後影片品質影響很小 (圖 7)。由於生成時長較短,位置編碼的差異不足以影響視訊質量,對於長視訊生成,此因素需要被重新考慮。

圖7.位置編碼方式FVD

4. 模型初始化 :探究使用ImageNet 預訓練參數初始化對模型效能的影響。實驗表明,使用 ImageNet 初始化的模型具有較快的收斂速度,然而,隨著訓練的進行,隨機初始化的模型卻取得了較好的結果 (圖 8)。可能的原因在於 ImageNet 與訓練集 FaceForensics 之間存在著比較大的分佈差異,因此未能對模型的最終結果起到促進作用。而對於文生視訊任務而言,該結論需要被重新考慮。在通用資料集的分佈上,影像與影片的內容空間分佈相似,使用預訓練 T2I 模型對於 T2V 可以起到極大的促進作用。

圖8.初始化參數FVD

#5. 影像視訊聯合訓練:將影片與影像壓縮為統一token 進行聯合訓練,視訊token 負責優化全部參數,影像token 只負責優化空間參數。 聯合訓練對於最終的結果有著顯著的提升 (表2 和表3),無論是圖片FID,還是視頻FVD,通過聯合訓練都得到了降低,該結果與基於UNet 的框架[2 ][3] 是一致的。

6. 模式尺寸:探討了 4 個不同的模式尺寸,S,B,L 和 XL (表 1)。 擴大影片 DiT 規模對於提升生成樣本品質有顯著的幫助 (圖 9)。這個結論也證明了在視訊擴散模型中使用 Transformer 結構對於後續 scaling up 的正確性。

表 1. Latte 不同尺寸模型規模

圖9.模型尺寸FVD

#定性與定量分析

##作者分別在4 個學術資料集(FaceForensics,TaichiHD,SkyTimelapse 以及UCF101)進行了訓練。定性與定量(表 2 和表 3)結果顯示 Latte 均取得了最佳的性能,由此可以證明模型整體設計是具有優異性的。

以上是詳解Latte:去年底上線的全球首個開源文生影片DiT的詳細內容。更多資訊請關注PHP中文網其他相關文章!

高維數據的高級矢量索引技術Apr 11, 2025 am 10:16 AM

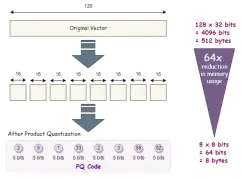

高維數據的高級矢量索引技術Apr 11, 2025 am 10:16 AM高維矢量搜索:掌握高級索引技術 在當今數據驅動的世界中,高維矢量對於推薦系統,圖像識別,自然語言處理(NLP)和異常等應用至關重要

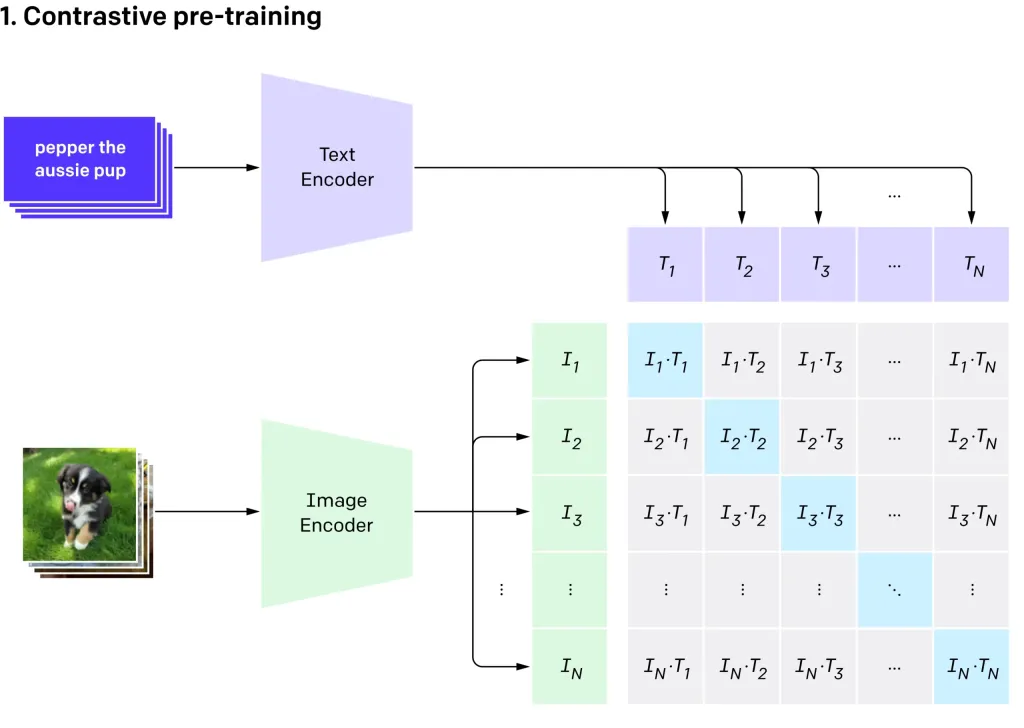

用OpenAI' s剪輯VIT-L14進行零擊圖像分類Apr 11, 2025 am 10:04 AM

用OpenAI' s剪輯VIT-L14進行零擊圖像分類Apr 11, 2025 am 10:04 AMOpenai的剪輯(對比語言 - 圖像預訓練)模型,特別是剪輯VIT-L14變體,代表了多模式學習和自然語言處理的重大進步。 這種強大的計算機視覺系統在Represe上擅長

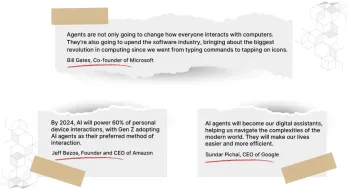

建立沒有代碼的AI代理的7個步驟-Analytics VidhyaApr 11, 2025 am 10:03 AM

建立沒有代碼的AI代理的7個步驟-Analytics VidhyaApr 11, 2025 am 10:03 AM利用AI代理的功能使用Wordware:無需輕鬆AI代理創建的無代碼平台。 人工智能代理人正在徹底改變我們與計算機互動,自動化任務和簡化決策的方式。 該博客演示瞭如何構建

手機上的LLM:現在和將來的可能性 - 分析VidhyaApr 11, 2025 am 09:58 AM

手機上的LLM:現在和將來的可能性 - 分析VidhyaApr 11, 2025 am 09:58 AM生成AI:下一個智能手機戰場 智能手機行業陷入了激烈的競爭中:整合先進的生成AI的競賽。 從增強用戶互動到提高生產率,賭注很高。蘋果的iPhone 16

在2025年遵循的十大生成AI子列表 - 分析VidhyaApr 11, 2025 am 09:51 AM

在2025年遵循的十大生成AI子列表 - 分析VidhyaApr 11, 2025 am 09:51 AM生成AI:您的10個基本Reddit社區的指南 生成的AI正在迅速發展,新模型不斷出現。 保持更新至關重要,Reddit提供專門針對該領域的充滿活力的社區。本文凸顯了T

AI模型中的主要挑戰和局限性-Analytics VidhyaApr 11, 2025 am 09:44 AM

AI模型中的主要挑戰和局限性-Analytics VidhyaApr 11, 2025 am 09:44 AM介紹 人工智能(AI)已迅速整合到各種工作場所中,這是由於AI研發和開發的大量投資所推動。 AI的應用程序範圍很廣,從虛擬助手等簡單任務到com

處理SQL中的無效值Apr 11, 2025 am 09:37 AM

處理SQL中的無效值Apr 11, 2025 am 09:37 AM介紹 在數據庫的領域中,零值通常會帶來獨特的挑戰。 代表缺失,未定義或未知數據,它們可能使數據管理和分析複雜化。考慮一個缺少客戶反饋或orde的銷售數據庫

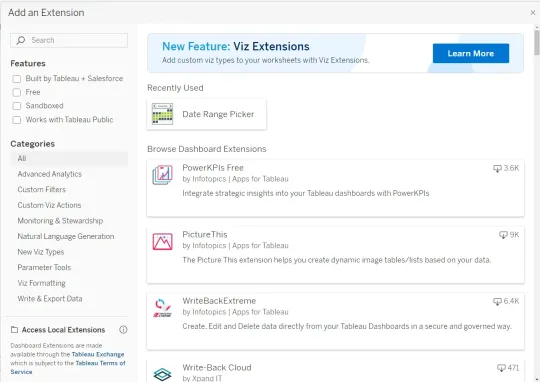

如何將Google Gemini集成到Tableau儀表板中?Apr 11, 2025 am 09:27 AM

如何將Google Gemini集成到Tableau儀表板中?Apr 11, 2025 am 09:27 AM利用Google Gemini在Tableau儀表板上的力量:AI驅動的增強 Tableau的強大可視化功能,跨越數據準備(Tableau Prep Builder),數據講故事(Tableau Desktop)和協作共享(TABL)

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver Mac版

視覺化網頁開發工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

WebStorm Mac版

好用的JavaScript開發工具

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)