追趕Gemini Pro,提升推理、OCR能力的LLaVA-1.6太強了

- PHPz轉載

- 2024-02-01 16:51:29819瀏覽

在去年4月,威斯康辛大學麥迪遜分校、微軟研究院和哥倫比亞大學的研究者們共同發布了LLaVA(Large Language and Vision Assistant)。儘管LLaVA只是用一個小的多模態指令資料集進行訓練,但在一些樣本上展現了與GPT-4非常相似的推理結果。然後在10月,他們推出了LLaVA-1.5,透過對原始LLaVA進行簡單修改,在11個基準測試中刷新了SOTA。這次升級的結果非常令人振奮,為多模態AI助理領域帶來了新的突破。

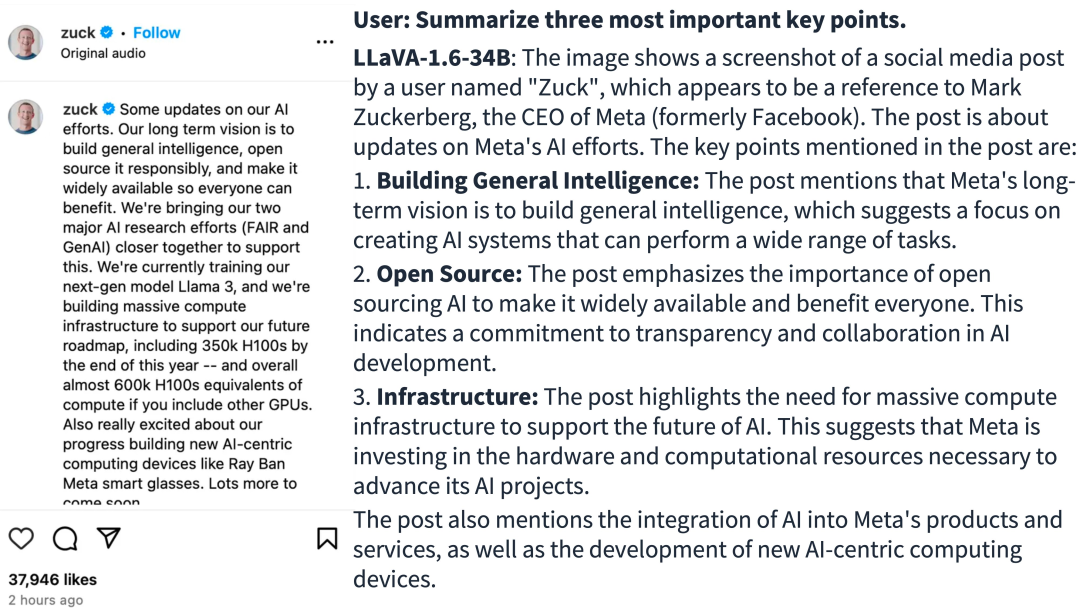

研究團隊宣布推出LLaVA-1.6版本,針對推理、OCR和世界知識的表現進行了主要改進。這版的LLaVA-1.6在多個基準測試中甚至超越了Gemini Pro。

- #demo 位址:https://llava.hliu.cc/

- 專案網址:https://github.com/haotian-liu/LLaVA

與LLaVA-1.5 相比,LLaVA-1.6 有以下幾個改進:

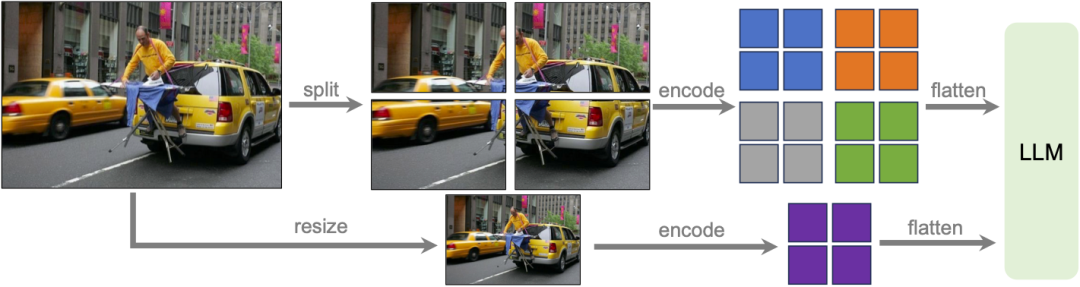

- #將輸入影像解析度提升4 倍,支援三種寬高比,最高可達672x672、336x1344、1344x336 解析度。這使得 LLaVA-1.6 能夠掌握更多的視覺細節。

- 透過改進的視覺指令調整資料混合,LLaVA-1.6 獲得了更好的視覺推理和 OCR 能力。

- 更好的視覺對話,更多場景,涵蓋不同應用。 LLaVA-1.6 掌握了更多世界知識,具備更好的邏輯推理能力。

- 使用 SGLang 進行高效部署和推理。

圖來源:https://twitter.com/imhaotian/status/1752621754273472927

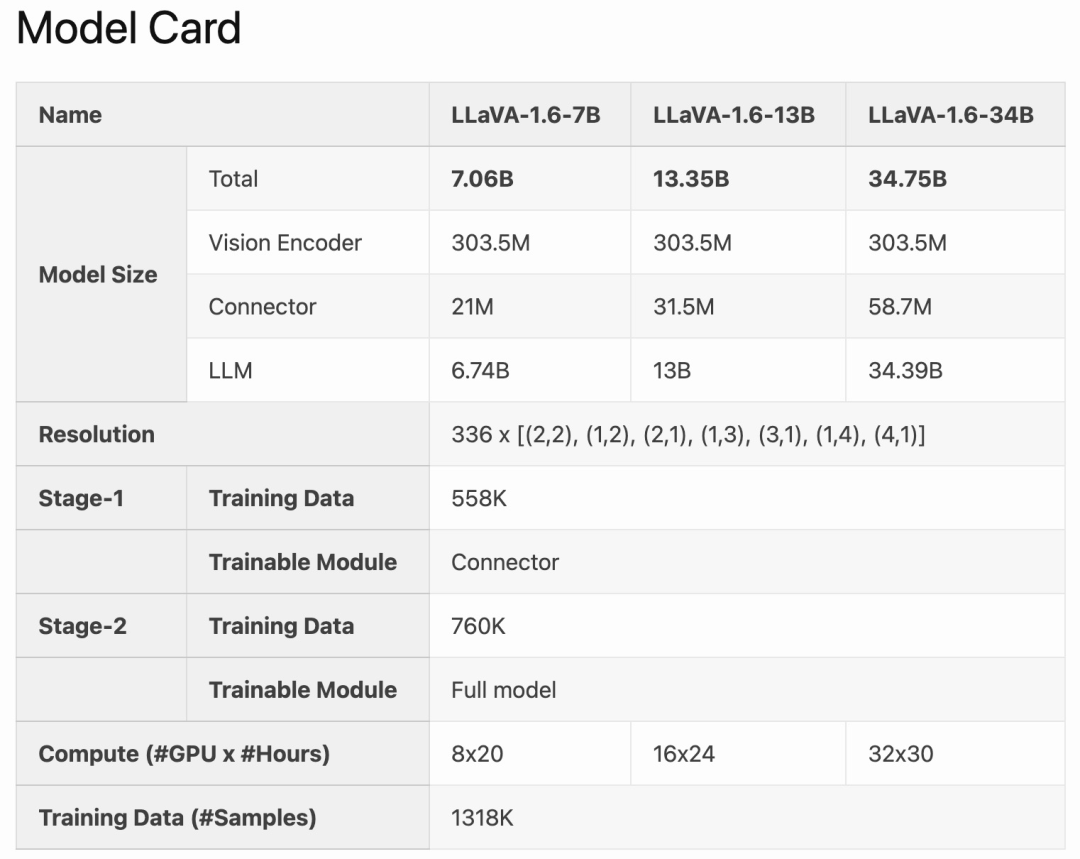

LLaVA-1.6 是在LLaVA-1.5 的基礎上進行了微調和最佳化。它保留了 LLaVA-1.5 的簡潔設計和高效資料處理能力,並繼續使用少於1M的視覺指令調優樣本。透過使用32個A100顯示卡,最大的34B模型在大約1天內完成了訓練。此外,LLaVA-1.6利用了130萬個資料樣本,其計算/訓練資料成本僅為其他方法的100-1000分之一。這些改進使得LLaVA-1.6成為更有效率和經濟實惠的版本。

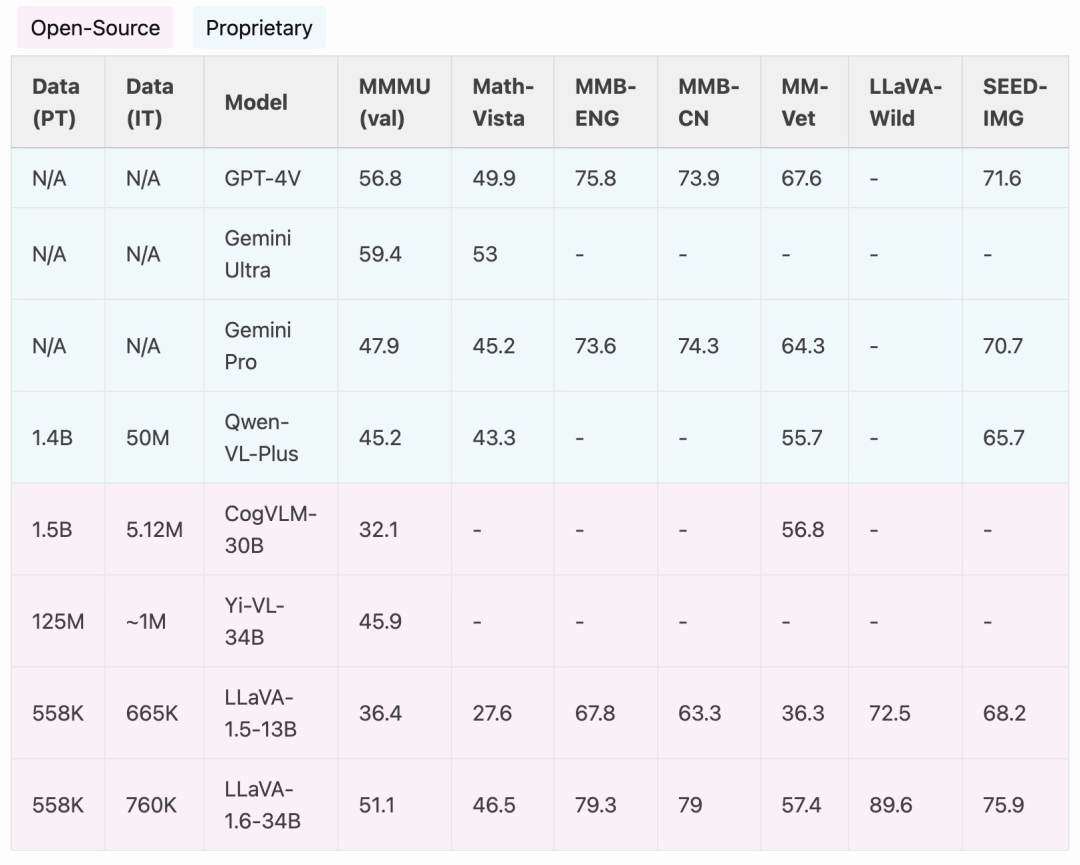

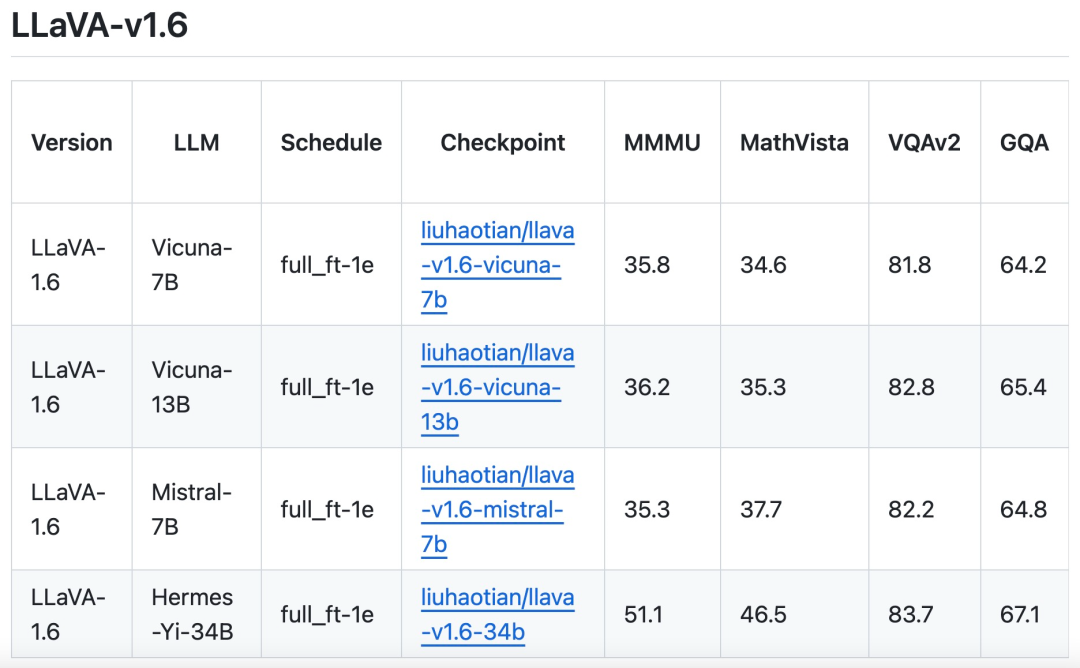

與 CogVLM 或 Yi-VL 等開源 LMM 相比,LLaVA-1.6 實現了 SOTA 效能。與商用產品相比,LLaVA-1.6 在選定的基準測試中可以媲美 Gemini Pro,並且優於 Qwen-VL-Plus。

值得一提的是,LLaVA-1.6 展現出強大的零樣本(zero-shot)中文能力,它在多模態基準MMBench-CN 上取得了SOTA 性能。

方法改進

動態高解析度

##研究團隊以高解析度設計LLaVA-1.6 模型,旨在維持其數據效率。當提供高解析度影像和保留細節的特性時,模型感知影像中複雜細節的能力會顯著提高。它減少了面對低解析度影像時的模型幻覺,也就是猜測想像的視覺內容。

資料混合

高品質的用戶指令數據。 該研究對高品質視覺指令遵循資料的定義取決於兩個主要標準:首先,任務指令的多樣性,確保充分代表現實場景中可能遇到的廣泛使用者意圖,特別是在模型部署階段。其次,回應的優先順序至關重要,旨在徵求有利的用戶回饋。

因此,研究考慮了兩個資料來源:

#現有的GPT-V 資料(LAION-GPT-V 和ShareGPT -4V);

為了進一步促進更多場景下更好的視覺對話,研究團隊收集了一個涵蓋不同應用的小型15K 視覺指令調優資料集,仔細過濾了可能存在隱私問題或可能有害的樣本,並使用GPT-4V 產生響應。

多模態文件 / 圖表資料。 (1) 從訓練資料中刪除 TextCap,因為研究團隊意識到 TextCap 使用與 TextVQA 相同的訓練影像集。這使得研究團隊能夠在評估 TextVQA 時更了解模型的零樣本 OCR 能力。為了維持並進一步提高模型的 OCR 能力,該研究以 DocVQA 和 SynDog-EN 取代了 TextCap。 (2) 借助 Qwen-VL-7B-Chat,研究進一步添加了 ChartQA、DVQA 和 AI2D,以便更好地理解圖表和圖表。

研究團隊也表示除了Vicuna-1.5(7B 和13B),也考慮採用更多LLM 方案,包括Mistral-7B 和Nous-Hermes-2-Yi-34B,以使LLaVA 能夠支援更廣泛的用戶和更多的場景。

以上是追趕Gemini Pro,提升推理、OCR能力的LLaVA-1.6太強了的詳細內容。更多資訊請關注PHP中文網其他相關文章!