近日,作為美國前十名的科技博客,Latent Space對於剛剛過去的NeurIPS 2023大會進行了精選回顧總結。

在NeurIPS會議中,共有3586篇論文被接受,其中6篇獲獎。雖然這些獲獎論文備受關注,但其他論文同樣具備出色的品質和潛力。實際上,這些論文甚至可能預示著AI領域的下一個重大突破。

那就讓我們來一起看看吧!

論文主題:QLoRA: Efficient Finetuning of Quantized LLMs

##論文地址:https://openreview.net/pdf?id=OUIFPHEgJU

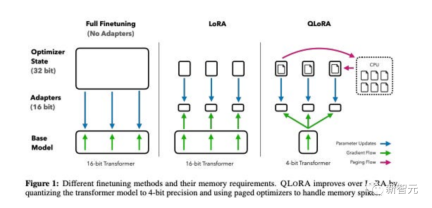

整體而言,QLoRA使得在對大型語言模型進行微調時可以使用更少的GPU記憶體。

他們對一個新模型進行了微調,命名為Guanaco,僅用一個GPU進行了為期24小時的訓練,結果在Vicuna基準測試中表現優於之前的模型。

同時,研究人員也發展了其他方法,如4-bit LoRA量化,其效果相似。

論文題目:DataComp: In search of the next generation of multimodal datasets

#論文網址:https://openreview.net/pdf?id=dVaWCDMBof

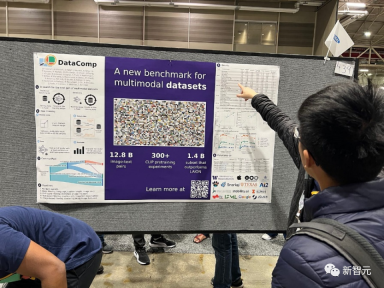

為了解決這個機器學習生態系統中的不足,研究人員引入了DataComp,這是一個圍繞Common Crawl的新候選池中的128億個圖文對進行數據集實驗的測試平台。

使用者可以透過DataComp進行實驗,設計新的過濾技術或精心策劃新的資料來源,並透過執行標準化的CLIP訓練程式碼,以及在38個下游測試集上測試產生的模型,來評估他們的新資料集。

使用者可以透過DataComp進行實驗,設計新的過濾技術或精心策劃新的資料來源,並透過執行標準化的CLIP訓練程式碼,以及在38個下游測試集上測試產生的模型,來評估他們的新資料集。

結果顯示,最佳基準DataComp-1B,允許從頭開始訓練一個CLIP ViT-L/14模型,其在ImageNet上的零樣本準確度達到了79.2%,比OpenAI的CLIP ViT-L/14模型高出3.7個百分點,證明DataComp工作流程可以產生更好的訓練集。

論文題目:Visual Instruction Tuning

##### ####論文地址:#########https://www.php.cn/link/c0db7643410e1a667d5e01868827a9af################在這篇論文中,研究人員提出了首次嘗試使用僅依賴語言的GPT-4來產生多模態語言-影像指令跟隨資料的方法。 ############透過在這個產生的資料上進行指令調整,引入了LLaVA:Large Language and Vision Assistant,這是一個端到端訓練的大型多模態模型,連接了一個視覺編碼器和LLM,用於通用的視覺和語言理解。 ######

早期實驗證明LLaVA展示了令人印象深刻的多模態聊天能力,有時展現出多模態GPT-4在未見過的圖像/指令上的行為,並在合成的多模態指令跟隨資料集上與GPT-4相比取得了85.1%的相對分數。

在對科學問答進行微調時,LLaVA和GPT-4的協同作用實現了92.53%的新的最先進準確性。

論文主題:Tree of Thoughts: Deliberate Problem Solving with Large Language Models

#論文網址:https://arxiv.org/pdf/2305.10601.pdf

語言模式越來越多用於廣泛的任務進行一般性問題解決,但在推理過程中仍受限於標記層級、從左到右的決策過程。這意味著它們在需要探索、策略前瞻或初始決策中起關鍵作用的任務中可能表現不佳。

為了克服這些挑戰,研究人員引入了一種新的語言模型推理框架,Tree of Thoughts(ToT),它在促使語言模型方面推廣了流行的Chain of Thought方法,並允許在一致的文本單元(思想)上進行探索,這些單元作為解決問題的中間步驟。

ToT使語言模型能夠透過考慮多個不同的推理路徑和自我評估選擇來做出刻意的決策,以決定下一步行動,並在必要時展望或回溯以做出全局性的選擇。

實驗證明,ToT顯著提高了語言模型在需要非平凡規劃或搜尋的三個新任務上的問題解決能力:24點遊戲、創意寫作和迷你填字遊戲。例如,在24點遊戲中,雖然使用Chain of Thought提示的GPT-4只解決了4%的任務,但ToT實現了74%的成功率。

論文主題:Toolformer: Language Models Can Teach Themselves to Use Tools

#論文網址:https://arxiv.org/pdf/2302.04761.pdf

語言模式表現出在從少量範例或文字指令中解決新任務方面的顯著能力,尤其是在大規模情境下。然而,令人矛盾的是,它們在基本功能方面(如算術或事實查找),相較於更簡單且規模較小的專門模型,卻表現出困難。

在這篇論文中,研究人員展示了語言模型可以透過簡單的API自學使用外部工具,並實現兩者的最佳結合。

他們引入了Toolformer,他們經過訓練能夠決定要呼叫哪些API、何時呼叫它們、傳遞什麼參數以及如何最佳地將結果合併到未來的token預測中。

這是以自監督的方式完成的,每個API只需要少量演示。他們整合了各種工具,包括計算器、問答系統、搜尋引擎、翻譯系統和日曆等。

Toolformer在與更大模型競爭的時候,在各種下游任務中取得了明顯改善的零樣本效能,而不會犧牲其核心語言建模能力。

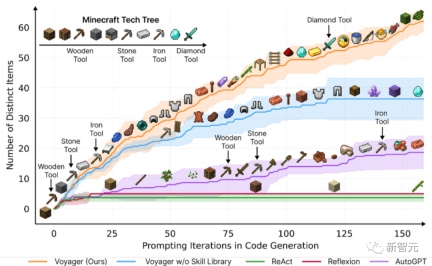

論文主題:Voyager: An Open-Ended Embodied Agent with Large Language Models

論文地址:https://arxiv.org/pdf/2305.16291.pdf

論文介紹了Voyager,這是第一個由大型語言模型(LLM)驅動的,可以在Minecraft中連續探索世界、獲得多樣化技能並進行獨立發現的learning agent。

Voyager包含三個關鍵組成部分:

#自動課程,旨在最大程度地推動探索,

#Растущая библиотека навыков исполняемого кода для хранения и извлечения сложного поведения,

#Новый итеративный механизм подсказок, который объединяет обратную связь от окружающей среды, ошибки выполнения и самопроверку для улучшения процедур .

Voyager взаимодействует с GPT-4 посредством запросов «черного ящика», что позволяет избежать необходимости точной настройки параметров модели.

Основываясь на эмпирических исследованиях, Voyager демонстрирует сильные способности к обучению на протяжении всей жизни в контексте окружающей среды и демонстрирует превосходное мастерство в игре в Minecraft.

Он получает доступ к уникальным предметам, которые в 3,3 раза выше, чем на предыдущем технологическом уровне, путешествует в 2,3 раза дольше и открывает ключевые этапы дерева технологий в 15,3 раза быстрее, чем на предыдущем технологическом уровне.

Но хотя «Вояджер» может использовать приобретенный набор навыков для решения новых задач с нуля в новых мирах Minecraft, другие методы сложнее обобщить.

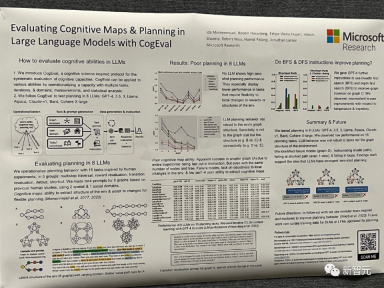

##Название диссертации: Оценка когнитивных карт и планирование в больших языковых моделях с помощью CogEval

Эта статья была первой предложил CogEval — протокол, вдохновленный когнитивной наукой, для систематической оценки когнитивных способностей больших языковых моделей.

Во-вторых, в статье используется система CogEval для оценки восьми LLM (OpenAI GPT-4, GPT-3.5-turbo-175B, davinci-003-175B, Google Bard, Cohere-xlarge - 52.4B, Anthropic Claude-1-52B, LLaMA-13B и Alpaca-7B) возможности когнитивного картирования и планирования. Подсказки к задачам основаны на экспериментах на людях и не присутствуют в обучающем наборе LLM.

Исследования показали, что, хотя LLM демонстрируют очевидные возможности в некоторых задачах планирования с более простой структурой, как только задачи становятся сложными, LLM попадают в «слепые зоны», включая обнаружение неверных траекторий. и застрял в петле.

Эти результаты не подтверждают идею о том, что LLM имеют возможности планирования по принципу «включай и работай». Возможно, что LLM не понимают основную реляционную структуру, лежащую в основе проблемы планирования, то есть когнитивную карту, и имеют проблемы с развертыванием целенаправленных траекторий на основе базовой структуры.

Адрес статьи: https://openreview.net/pdf?id=AL1fq05o7H

Адрес статьи: https://openreview.net/pdf?id=AL1fq05o7H

Автор указал что в настоящее время многие архитектуры сублинейного времени, такие как линейное внимание, вентилируемая свертка и рекуррентные модели, а также модели структурированного пространства состояний (SSM), направлены на решение вычислительной неэффективности Transformer при обработке длинных последовательностей. Однако эти модели не работают так же хорошо, как модели внимания, в таких важных областях, как язык. Авторы полагают, что ключевой слабостью этих

типов является их неспособность выполнять содержательные рассуждения и вносить некоторые улучшения.

Во-первых, простое превращение параметров SSM в функцию входных данных может устранить недостатки его дискретной модальности, позволяя модели выборочно распространять или забывать информацию по измерению длины последовательности в зависимости от текущий токен.

Во-вторых, хотя это изменение не позволяет использовать эффективные свертки, авторы разработали аппаратно-ориентированный параллельный алгоритм в циклическом режиме. Интеграция этих выборочных SSM в упрощенную сквозную архитектуру нейронной сети не требует никакого механизма внимания или даже модуля MLP (Mamba).

Mamba хорошо работает по скорости вывода (в 5 раз быстрее, чем Transformers) и линейно масштабируется в зависимости от длины последовательности, улучшая производительность при работе с реальными данными, длина которых достигает миллионов миллионов.

Являясь основой универсальной модели последовательностей, Mamba достигла самых современных показателей во многих областях, включая язык, аудио и геномику. С точки зрения языкового моделирования модель Mamba-1.4B превосходит модель Transformers того же размера как при предварительном обучении, так и при последующей оценке, а также конкурирует со своей моделью Transformers, вдвое большей по размеру.

Хотя эти статьи не получили наград в 2023 году, такие как Мамба, как техническая модель, которая может произвести революцию в архитектуре языковой модели, еще слишком рано оценивать ее влияние.

Как будет развиваться NeurIPS в следующем году, и как будет развиваться сфера искусственного интеллекта и нейроинформационных систем в 2024 году?Хотя сейчас существуют разные мнения, кто может это гарантировать? давайте подождем и посмотрим.

以上是回顧NeurIPS 2023: 清華ToT推動大型模型成為焦點的詳細內容。更多資訊請關注PHP中文網其他相關文章!

AI遊戲開發通過Upheaval的Dreamer Portal進入其代理時代May 02, 2025 am 11:17 AM

AI遊戲開發通過Upheaval的Dreamer Portal進入其代理時代May 02, 2025 am 11:17 AM動盪遊戲:與AI代理商的遊戲開發徹底改變 Roupheaval是一家遊戲開發工作室,由暴風雪和黑曜石等行業巨頭的退伍軍人組成,有望用其創新的AI驅動的Platfor革新遊戲創作

Uber想成為您的Robotaxi商店,提供商會讓他們嗎?May 02, 2025 am 11:16 AM

Uber想成為您的Robotaxi商店,提供商會讓他們嗎?May 02, 2025 am 11:16 AMUber的Robotaxi策略:自動駕駛汽車的騎車生態系統 在最近的Curbivore會議上,Uber的Richard Willder推出了他們成為Robotaxi提供商的乘車平台的策略。 利用他們在

AI代理玩電子遊戲將改變未來的機器人May 02, 2025 am 11:15 AM

AI代理玩電子遊戲將改變未來的機器人May 02, 2025 am 11:15 AM事實證明,視頻遊戲是最先進的AI研究的寶貴測試理由,尤其是在自主代理商和現實世界機器人的開發中,甚至有可能促進人工通用情報(AGI)的追求。 一個

創業公司工業綜合體VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM

創業公司工業綜合體VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM不斷發展的風險投資格局的影響在媒體,財務報告和日常對話中顯而易見。 但是,對投資者,初創企業和資金的具體後果經常被忽略。 風險資本3.0:範式

Adobe在Adobe Max London 2025更新創意云和螢火蟲May 02, 2025 am 11:13 AM

Adobe在Adobe Max London 2025更新創意云和螢火蟲May 02, 2025 am 11:13 AMAdobe Max London 2025對Creative Cloud和Firefly進行了重大更新,反映了向可訪問性和生成AI的戰略轉變。 該分析結合了事件前簡報中的見解,並融合了Adobe Leadership。 (注意:Adob

Llamacon宣布的所有元數據May 02, 2025 am 11:12 AM

Llamacon宣布的所有元數據May 02, 2025 am 11:12 AMMeta的Llamacon公告展示了一項綜合的AI策略,旨在直接與OpenAI等封閉的AI系統競爭,同時為其開源模型創建了新的收入流。 這個多方面的方法目標bo

關於AI僅僅是普通技術的主張的釀造爭議May 02, 2025 am 11:10 AM

關於AI僅僅是普通技術的主張的釀造爭議May 02, 2025 am 11:10 AM人工智能領域對這一論斷存在嚴重分歧。一些人堅稱,是時候揭露“皇帝的新衣”了,而另一些人則強烈反對人工智能僅僅是普通技術的觀點。 讓我們來探討一下。 對這一創新性人工智能突破的分析,是我持續撰寫的福布斯專欄文章的一部分,該專欄涵蓋人工智能領域的最新進展,包括識別和解釋各種有影響力的人工智能複雜性(請點擊此處查看鏈接)。 人工智能作為普通技術 首先,需要一些基本知識來為這場重要的討論奠定基礎。 目前有大量的研究致力於進一步發展人工智能。總目標是實現人工通用智能(AGI)甚至可能實現人工超級智能(AS

模型公民,為什麼AI值是下一個業務碼May 02, 2025 am 11:09 AM

模型公民,為什麼AI值是下一個業務碼May 02, 2025 am 11:09 AM公司AI模型的有效性現在是一個關鍵的性能指標。自AI BOOM以來,從編寫生日邀請到編寫軟件代碼的所有事物都將生成AI使用。 這導致了語言mod的擴散

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3漢化版

中文版,非常好用

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

Dreamweaver CS6

視覺化網頁開發工具

Dreamweaver Mac版

視覺化網頁開發工具

SublimeText3 Linux新版

SublimeText3 Linux最新版