Stability AI發布了支援本地運行且無需GPU的穩定程式碼3B模型

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2024-01-17 16:03:061050瀏覽

Stability AI最近發表了2024年的首款AI模型,名為Stable Code 3B。這個模型擁有30億參數,專注於輔助程式碼任務。

無需專用 GPU 即可在筆記型電腦上本地運行,同時仍可提供與 Meta 的 CodeLLaMA 7B 等大型模型具有競爭力的性能。

2023 年底,Stability AI 便開始推動更小、更緊湊、更強大模型的發展,例如用於文本生成的 StableLM Zephyr 3B 模型。

2024年初,Stability AI發表了一個重要的語言模型,名為Stable Code 3B。實際上,它的預覽版Stable Code Alpha 3B早在去年八月就已經發布。自那之後,Stability AI一直在不斷改進這項技術。這個新版的Stable Code 3B是專為程式碼補全而設計的,同時也具備多種附加功能。

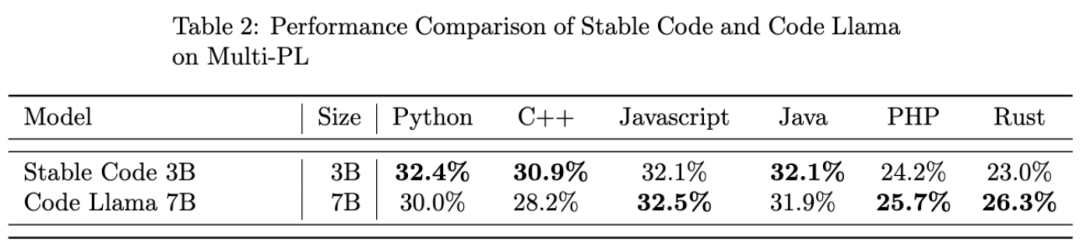

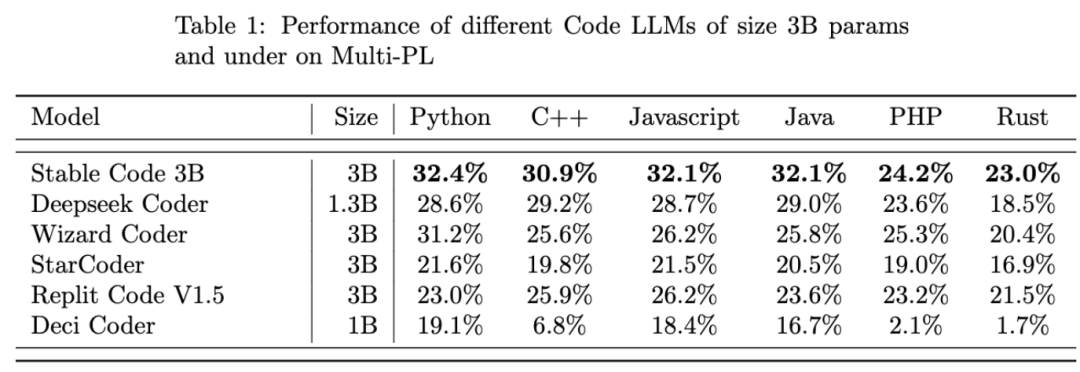

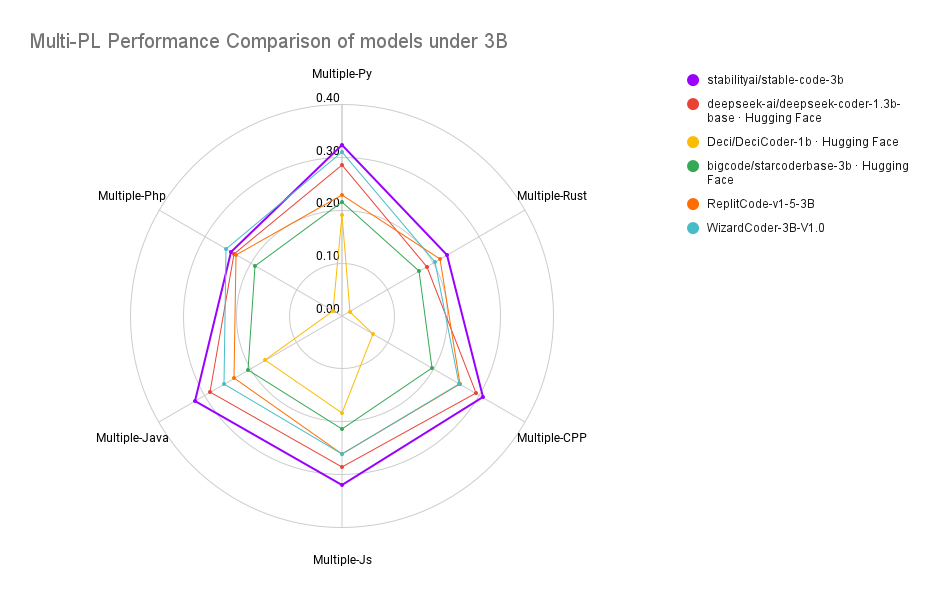

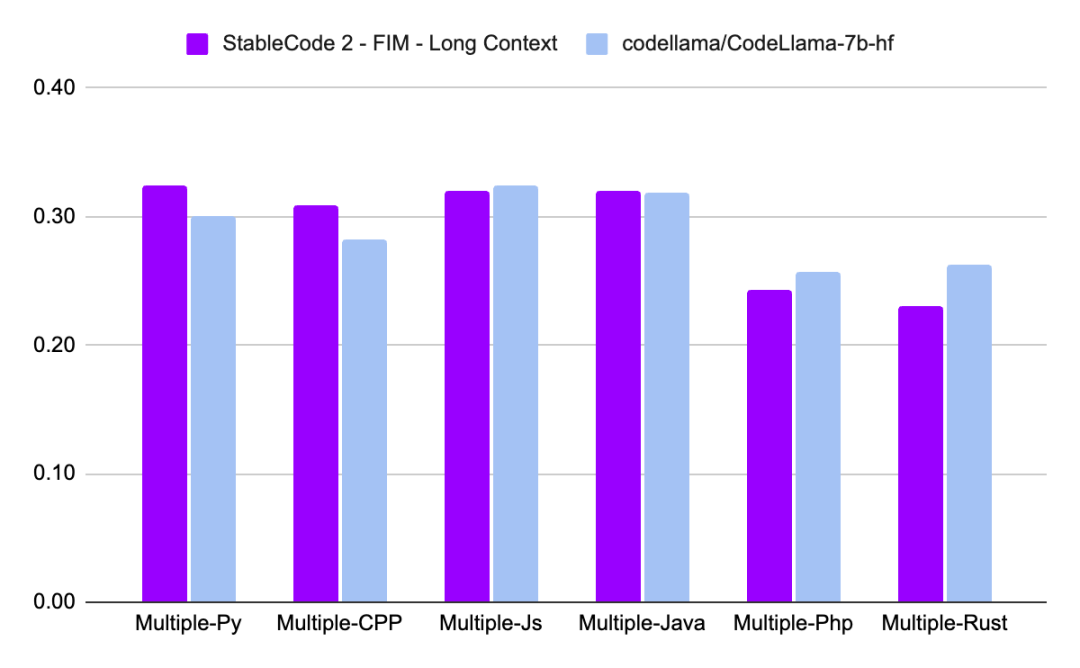

與 CodeLLaMA 7b 相比,Stable Code 3B 大小縮小了 60%,但在程式設計任務上達到了與前者相媲美的效能。

Stable Code 3B 在MultiPL-E 基準上實現了SOTA 性能(與類似大小的模型相比),例如Stable Code 3B 在Python 、C 、JavaScript、Java、PHP 和Rust 程式語言上的效能優於StarCoder。

研究介紹

#Stable Code 3B是以Stable LM 3B為基礎訓練而成,後者訓練token數高達4兆。此外,Stable Code也使用了軟體工程中特定的資料進行訓練。

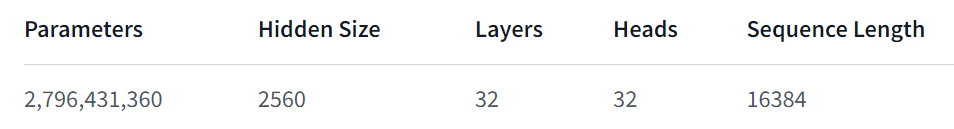

Stable Code 3B 提供了更多的特性,即使跨多種語言也表現良好,還兼具其他優勢,例如支援FIM(Fill in the Middle ,一種新的訓練技巧)功能,還能擴充上下文大小。基礎Stable Code 在多達16,384 個token 序列上進行訓練,遵循與CodeLlama 類似的方法,即採用旋轉嵌入(Rotary Embeddings),這種方法可以選擇性的允許修改多達1,000,000 個旋轉基(rotary base),進一步將模型的上下文長度擴展到100k 個token。

在模型架構方面,Stable Code 3B 模型是純解碼器的transformer,類似於LLaMA 架構,並進行了以下修改:

- #位置嵌入:旋轉位置嵌入應用於頭嵌入維度的前25%,以提高吞吐量;

- Tokenizer:使用GPTNeoX Tokenizer.NeoX 的修改版本,加入特殊token 來訓練FIM 功能,例如< FIM_PREFIX>、

等。

訓練

#訓練資料集

Stable Code 3B 的訓練資料集由HuggingFace Hub 上提供的開源大規模資料集過濾混合組成,包括Falcon RefinedWeb、CommitPackFT、Github Issues、StarCoder,並進一步以數學領域的資料補充訓練。

訓練基礎設施

- #硬體:Stable Code 3B 在Stability AI叢集上使用256 個NVIDIA A100 40GB GPU 進行訓練。

- 軟體:Stable Code 3B 採用gpt-neox 的分支,使用ZeRO-1 在2D 並行性(資料和張量並行)下進行訓練,並依賴flash-attention、SwiGLU 、FlashAttention-2 的旋轉嵌入內核。

最後,我們來看看Stable Code 3B 的效能表現:

##關於Stable Code 3B 更詳細的技術報告會在之後發布,大家可以期待一下。

以上是Stability AI發布了支援本地運行且無需GPU的穩定程式碼3B模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!