谷歌DeepMind機器人成果三連發!兩大能力全提升,資料收集系統可同時管理20個機器人

- 王林轉載

- 2024-01-11 22:36:04834瀏覽

幾乎是和史丹佛「炒蝦洗碗」機器人同一時間,GoogleDeepMind也發布了最新具身智能成果。

並且是三連發:

先是一個主打提高決策速度的新模型,讓機器人的操作速度(比起原來的Robotics Transformer)提高了14%——快的同時,品質也沒有下滑,準確度還上升了10.6%。

然後再來一個專攻泛化能力的新框架,可以給機器人建立運動軌跡提示,讓它面對41項從未見過的任務,取得了63%的成功率。

別小看這個數組,對比之前的29%,進步可謂相當大。

最後是一個機器人資料收集系統,可以一次管理20個機器人,目前已從它們的活動中收集了77000次實驗數據,它們將幫助谷歌更好地完成後續訓練工作。

那麼,這三個成果具體又是什麼樣子呢?我們一個接一個來看。

機器人日常化第一步:沒見過的任務也能直接做

Google指出,要實現真正可進入現實世界的機器人,需要解決兩個基本挑戰。

1、新任務推廣能力

2、提高決策速度

本次三連發的前兩項成果就主要在這兩大領域作出改進,且都建立在Google的基礎機器人模型Robotics Transformer(簡稱RT)之上。

首先來看第一個:幫助機器人泛化的RT-Trajectory。

對人類來說,譬如完成擦桌子這種任務簡直再好理解不過了,但機器人卻不是很懂。

不過好在我們可以透過多種可能的方式將這指令傳達給它,讓它作出實際的物理行動。

一般來說,傳統的方式就是將任務映射為一個個特定的動作,然後讓機械臂完成,例如對於擦桌子,就可以拆解為「合上夾具、向左移動、向右移動」。

很明顯,這種方式的泛化能力很差。

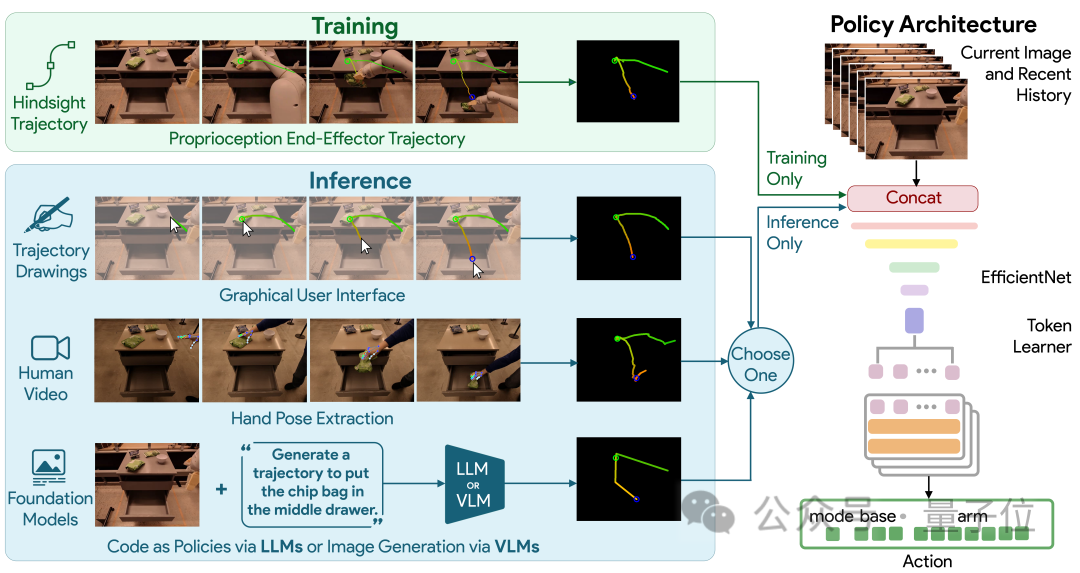

在此,Google新提出的RT-Trajectory透過給機器人提供視覺提示的方法來教它完成任務。

具體而言,由RT-Trajectory控制的機器人在訓練時會加入2D軌跡增強的資料。

這些軌跡以RGB影像的形式呈現,包括路線和關鍵點,在機器人學習執行任務時提供低階但非常實用的提示。

有了這個模型,機器人執行從未見過的任務的成功率直接提高了1倍之多(相較於Google的基礎機器人模型RT-2,從29%=> 63%)。

更值得一提的是,RT-Trajectory可以用多種方式來創建軌跡,包括:

透過觀看人類演示、接受手繪草圖,以及透過VLM(視覺語言模型) 來產生。

機器人日常化第二步:決策速度一定要快

#泛化能力上來以後,我們再來關注決策速度。

Google的RT模型採用的是Transformer架構,雖然Transformer功能強大,但嚴重依賴有著二次複雜度的注意力模組。

因此,一旦RT模型的輸入加倍(例如給機器人配上更高解析度的感測器),處理起來所需的運算資源就會增加為原來的四倍,這將嚴重減慢決策速度。

為了提升機器人的速度,Google在基礎模式Robotics Transformer上開發了SARA-RT。

SARA-RT使用新的模型微調方法讓原來的RT模型更有效率。

這種方法被Google稱之為“向上訓練”,它主要的功能就是將原來的二次複雜度轉換為線性複雜度,同時保持處理品質。

將SARA-RT應用於具有數十億參數的RT-2模型時,後者可以在各種任務上實現更快的操作速度以及更高的準確率。

同樣值得一提的是,SARA-RT提供的是一種通用的加速Transformer的方法,且無需進行昂貴的預訓練,因此可以很好地推廣開來。

數據不夠?自己創造

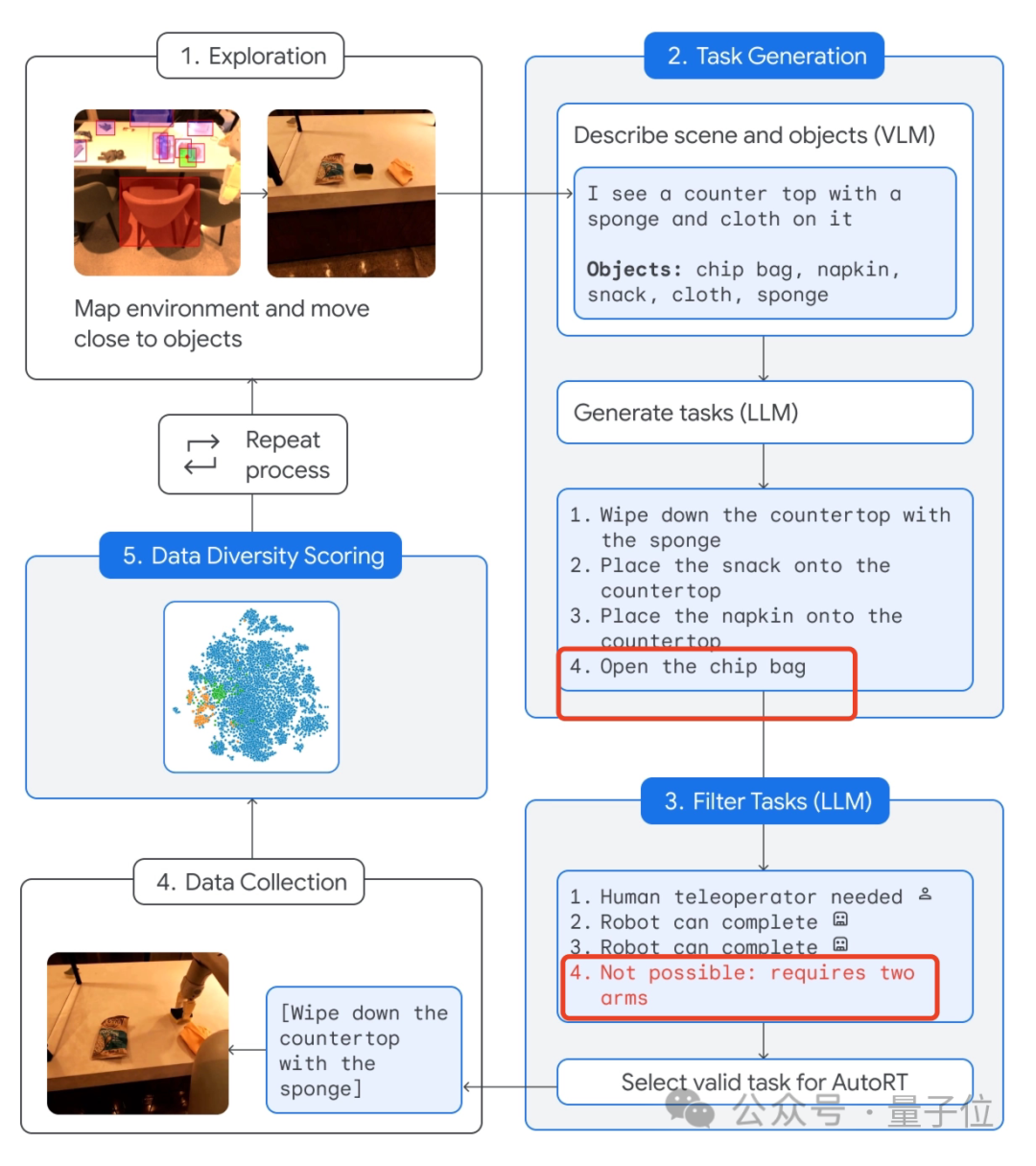

最後,為了幫助機器人更理解人類下達的任務,Google也從數據下手,直接搞了一個收集系統:AutoRT。

這個系統將大模型(包括LLM和VLM)與機器人控制模型(RT)結合,不斷指揮機器人去執行現實世界中的各種任務,從而產生數據並收集。

具體流程如下:

讓機器人「自由」接觸環境,靠近目標。

接著透過相機以及VLM模型來描述眼前的場景,包括具體有哪些物品。

接著,LLM就透過這些資訊來產生幾項不同的任務。

注意了,生成以後機器人並不馬上執行,而是利用LLM再過濾一下哪些任務可以獨立搞定,哪些需要人類遠端控制,以及哪些壓根不能完成。

像不能完成的就是「打開洋芋片袋」這種,因為這需要兩個機械手臂(預設只有1隻)。

再然後,做完這個篩選任務以後,機器人就可以去實際執行了。

最後由AutoRT系統完成資料收集並進行多樣性評估。

據介紹,AutoRT可一次同時協調多達20個機器人,在7個月的時間內,一共收集了包括6650個獨特任務在內的77000次試驗數據。

最後,對於這個系統,Google也特別強調了安全性。

畢竟AutoRT的收集任務作用於現實世界,「安全護欄」不能少。

具體而言,基礎安全守則由為機器人進行任務篩選的LLM提供,它的部分靈感來自艾薩克·阿西莫夫的機器人三定律——首先也是最重要的是「機器人不得傷害人類。

其次還包括要求機器人不得嘗試涉及人類、動物、尖銳物體或電器的任務。

但這還遠遠不夠。

因此AutoRT還配有常規機器人技術中的多層實用安全措施。

例如,機器人在其關節上的力超過給定閾值時自動停止、所有行動都可由保持在人類視線範圍內的物理開關停止等等。

還想進一步了解Google的這批最新成果?

好消息,除了RT-Trajectory只上線論文以外,其餘都是程式碼和論文一併公佈,歡迎大家進一步查閱~

One More Thing

說起Google機器人,就不得不提RT-2#(本文的所有成果也都建立之上)。

這個模型由54位谷歌研究員耗時7個月打造,今年7月底問世。

嵌入了視覺-文本多模態大模型VLM的它,不僅能理解“人話”,還能對“人話”進行推理,執行一些並非一步就能到位的任務,例如從獅子、鯨魚、恐龍這三個塑膠玩具中準確撿起“已滅絕的動物”,非常驚人。

如今的它,在短短5個多月內迎來了泛化能力和決策速度的迅速提升,不由地讓我們感嘆:不敢想像,機器人真正衝進千家萬戶,究竟會有多快?

以上是谷歌DeepMind機器人成果三連發!兩大能力全提升,資料收集系統可同時管理20個機器人的詳細內容。更多資訊請關注PHP中文網其他相關文章!