近兩年來,隨著大規模圖文資料集如LAION-5B的開放,圖片生成領域湧現出了一系列效果驚人的方法,如Stable Diffusion、DALL-E 2、ControlNet和Composer 。這些方法的出現使得圖片生成領域取得了巨大的突破和進展。圖片生成領域可謂在過去短短兩年內取得了快速發展。

然而,影片產生仍然面臨著巨大的挑戰。首先,與圖片生成相比,影片生成需要處理更高維度的數據,並且需要考慮到額外的時間維度,這帶來了時序建模的問題。為了驅動時序動態的學習,我們需要更多的視訊-文字對資料。然而,對影片進行準確的時序標註非常昂貴,這限制了視訊-文字資料集的規模。目前,現有的WebVid10M影片資料集僅包含10.7M個影片-文字對,與LAION-5B圖片資料集相比,資料規模相差甚遠。這嚴重限制了視訊生成模型規模化擴展的可能性。

為解決上述問題,華中科技大學、阿里巴巴集團、浙江大學和螞蟻集團聯合研究團隊於近期發布了TF-T2V 視訊方案:

#論文網址:https://arxiv.org/abs/2312.15770

項目首頁:https://tf-t2v.github.io/

即將公開原始碼:https://github.com/ali-vilab/i2vgen-xl (VGen 專案) 。

該方案另闢蹊徑,提出了基於大規模無文字標註視訊資料進行視訊生成,能夠學習豐富的運動動態。

先來看看TF-T2V 的影片產生效果:

文生影片任務

提示詞:產生在冰雪覆蓋的土地上有一隻冰霜般的大生物的影片。

提示字:產生一隻卡通蜜蜂的動畫影片。

提示:產生包含一輛未來幻想摩托車的影片。

提示詞:產生一個小男孩快樂微笑的影片。

提示字:產生一個老人覺得頭痛的影片。

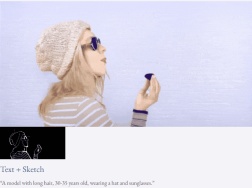

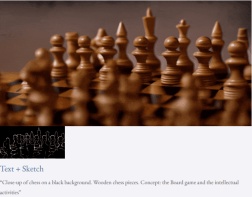

#組合式影片產生任務

給定文字與深度圖或文字與素描草圖,TF-T2V 能夠進行可控的視訊生成:

也可以進行高解析度視訊合成:

半監督設定

在半監督設定下的TF-T2V 方法還可以產生符合運動文本描述的視頻,如「人從右往左跑」。

方法簡介

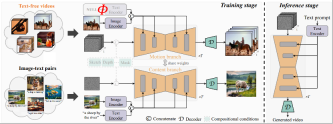

TF-T2V 的核心思想是將模型分為運動分支和表觀分支,運動分支用於建模運動動態,表觀分支用於學習視覺表觀資訊。這兩個分支進行聯合訓練,最終可以實現透過文字驅動視訊生成。

為了提升產生影片的時序一致性,作者團隊也提出了時序一致性損失,並明確地學習影片影格之間的連續性。

值得一提的是,TF-T2V 是一種通用的框架,不僅適用於文生視訊任務,還能應用於組合式影片產生任務,如sketch-to-video、video inpainting、first frame-to-video 等。

具體細節和更多實驗結果可以參考原論文或專案首頁。

此外,作者團隊也將TF-T2V 作為教師模型,利用一致性蒸餾技術得到了VideoLCM 模型:

##論文網址:https://arxiv.org/abs/2312.09109

專案首頁:https://tf-t2v.github.io/

即將公開原始碼:https://github.com/ali-vilab/i2vgen-xl (VGen 專案)。

不同於先前視訊產生方法需要大約50 步DDIM 去噪步驟,基於TF-T2V 的VideoLCM 方法可以只需要進行大約4 步推理去噪就產生高保真的視頻,大大提升了視訊生成的效率。

一起來看看VideoLCM 進行4 步驟去雜訊推理的結果:

##具體細節和更多實驗結果可以參考VideoLCM 原始論文或專案首頁。

#########總而言之,TF-T2V 方案為影片生成領域帶來了新思路,克服了資料集規模和標註難題帶來的挑戰。利用大規模的無文字標註視頻數據,TF-T2V 能夠產生高品質的視頻,並應用於多種視訊生成任務。這項創新將推動視訊生成技術的發展,為各行各業帶來更廣闊的應用場景和商業機會。 ######以上是華科阿里等企業合作開發的TF-T2V技術降低了AI視訊生產的成本!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

AI內部部署的隱藏危險:治理差距和災難性風險Apr 28, 2025 am 11:12 AM

AI內部部署的隱藏危險:治理差距和災難性風險Apr 28, 2025 am 11:12 AMApollo Research的一份新報告顯示,先進的AI系統的不受檢查的內部部署構成了重大風險。 在大型人工智能公司中缺乏監督,普遍存在,允許潛在的災難性結果

構建AI測謊儀Apr 28, 2025 am 11:11 AM

構建AI測謊儀Apr 28, 2025 am 11:11 AM傳統測謊儀已經過時了。依靠腕帶連接的指針,打印出受試者生命體徵和身體反應的測謊儀,在識破謊言方面並不精確。這就是為什麼測謊結果通常不被法庭採納的原因,儘管它曾導致許多無辜者入獄。 相比之下,人工智能是一個強大的數據引擎,其工作原理是全方位觀察。這意味著科學家可以通過多種途徑將人工智能應用於尋求真相的應用中。 一種方法是像測謊儀一樣分析被審問者的生命體徵反應,但採用更詳細、更精確的比較分析。 另一種方法是利用語言標記來分析人們實際所說的話,並運用邏輯和推理。 俗話說,一個謊言會滋生另一個謊言,最終

AI是否已清除航空航天行業的起飛?Apr 28, 2025 am 11:10 AM

AI是否已清除航空航天行業的起飛?Apr 28, 2025 am 11:10 AM航空航天業是創新的先驅,它利用AI應對其最複雜的挑戰。 現代航空的越來越複雜性需要AI的自動化和實時智能功能,以提高安全性,降低操作

觀看北京的春季機器人比賽Apr 28, 2025 am 11:09 AM

觀看北京的春季機器人比賽Apr 28, 2025 am 11:09 AM機器人技術的飛速發展為我們帶來了一個引人入勝的案例研究。 來自Noetix的N2機器人重達40多磅,身高3英尺,據說可以後空翻。 Unitree公司推出的G1機器人重量約為N2的兩倍,身高約4英尺。比賽中還有許多體型更小的類人機器人參賽,甚至還有一款由風扇驅動前進的機器人。 數據解讀 這場半程馬拉松吸引了超過12,000名觀眾,但只有21台類人機器人參賽。儘管政府指出參賽機器人賽前進行了“強化訓練”,但並非所有機器人均完成了全程比賽。 冠軍——由北京類人機器人創新中心研發的Tiangong Ult

鏡子陷阱:人工智能倫理和人類想像力的崩潰Apr 28, 2025 am 11:08 AM

鏡子陷阱:人工智能倫理和人類想像力的崩潰Apr 28, 2025 am 11:08 AM人工智能以目前的形式並不是真正智能的。它擅長模仿和完善現有數據。 我們不是在創造人工智能,而是人工推斷 - 處理信息的機器,而人類則

新的Google洩漏揭示了方便的Google照片功能更新Apr 28, 2025 am 11:07 AM

新的Google洩漏揭示了方便的Google照片功能更新Apr 28, 2025 am 11:07 AM一份報告發現,在谷歌相冊Android版7.26版本的代碼中隱藏了一個更新的界面,每次查看照片時,都會在屏幕底部顯示一行新檢測到的面孔縮略圖。 新的面部縮略圖缺少姓名標籤,所以我懷疑您需要單獨點擊它們才能查看有關每個檢測到的人員的更多信息。就目前而言,此功能除了谷歌相冊已在您的圖像中找到這些人之外,不提供任何其他信息。 此功能尚未上線,因此我們不知道谷歌將如何準確地使用它。谷歌可以使用縮略圖來加快查找所選人員的更多照片的速度,或者可能用於其他目的,例如選擇要編輯的個人。我們拭目以待。 就目前而言

加固芬特的指南 - 分析VidhyaApr 28, 2025 am 09:30 AM

加固芬特的指南 - 分析VidhyaApr 28, 2025 am 09:30 AM增強者通過教授模型根據人類反饋進行調整來震撼AI的開發。它將監督的學習基金會與基於獎勵的更新融合在一起,使其更安全,更準確,真正地幫助

讓我們跳舞:結構化運動以微調我們的人類神經網Apr 27, 2025 am 11:09 AM

讓我們跳舞:結構化運動以微調我們的人類神經網Apr 27, 2025 am 11:09 AM科學家已經廣泛研究了人類和更簡單的神經網絡(如秀麗隱桿線蟲中的神經網絡),以了解其功能。 但是,出現了一個關鍵問題:我們如何使自己的神經網絡與新穎的AI一起有效地工作

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

SublimeText3漢化版

中文版,非常好用

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中