GPT-4在圖形推理方面表現不佳?即使「放水」後,準確率僅33%

- 王林轉載

- 2023-11-21 08:38:56899瀏覽

GPT-4的圖形推理能力,竟然連人類的一半都不到?

美國聖塔菲研究所的研究顯示,GPT-4做圖形推理題的準確率只有33%。

GPT-4v是具備多模態能力的,但其表現相對較差,只能正確回答25%的題目

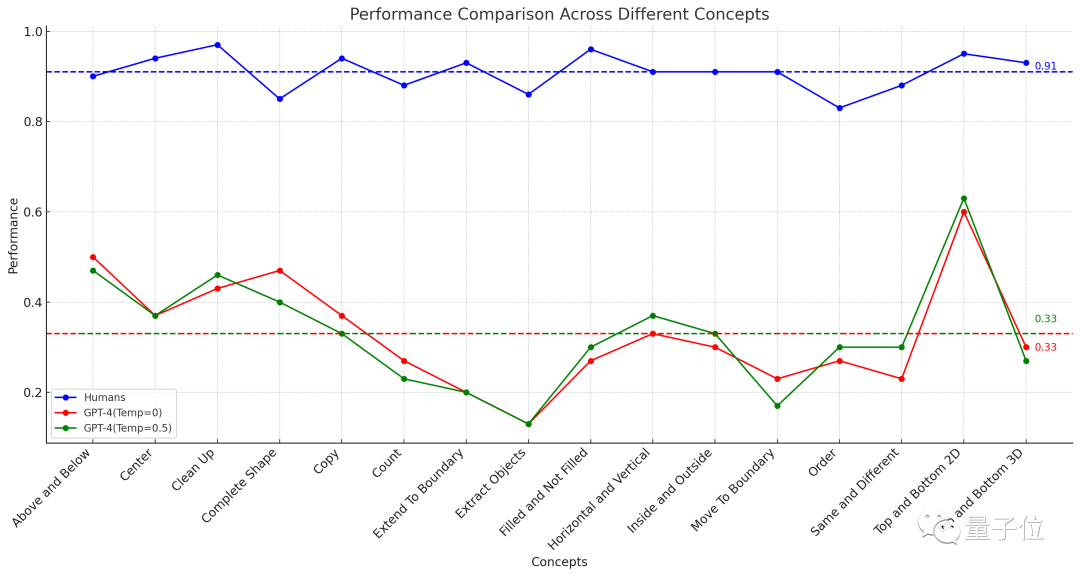

#△虛線表示16項任務的平均表現

這項實驗結果一經發布,立即在YC上引起了廣泛的討論

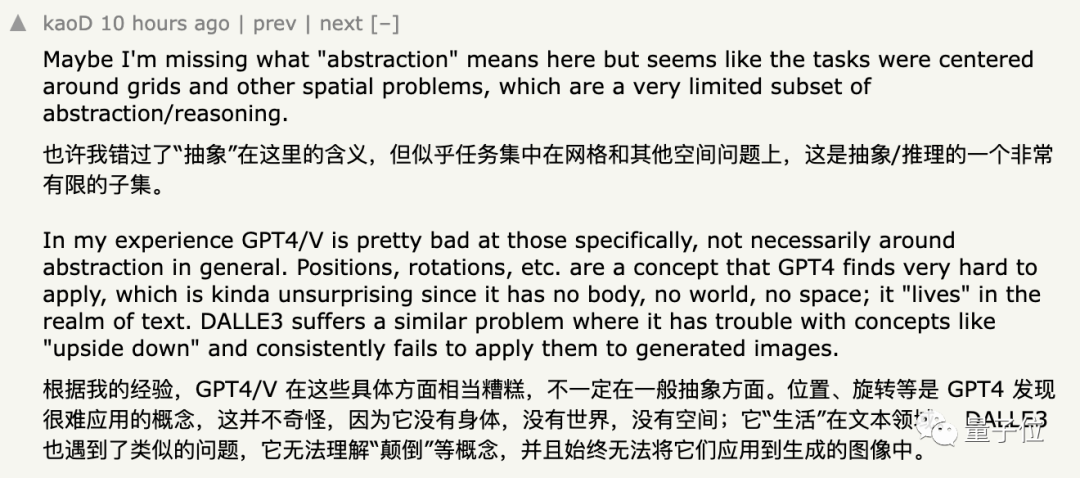

一些支持這一結果的網友表示,GPT確實在處理抽象圖形方面表現不佳,對於「位置」、「旋轉」等概念的理解更加困難

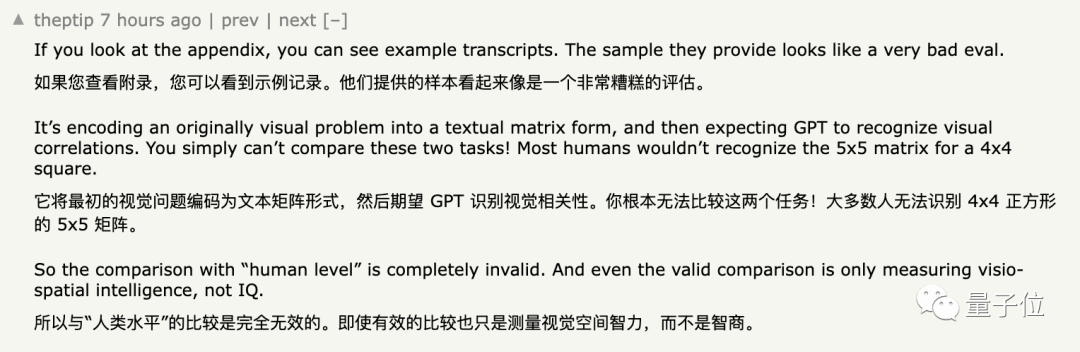

然而,一些網友對這個結論表示懷疑,他們的觀點可以簡單概括為:

這個觀點雖然不能說是錯的,但是也無法完全讓人信服

至於具體的原因,我們繼續往下看。

GPT-4準確率僅33%

為了評估人類和GPT-4在這些圖形題上的表現,研究者利用了今年5月推出的ConceptARC資料集

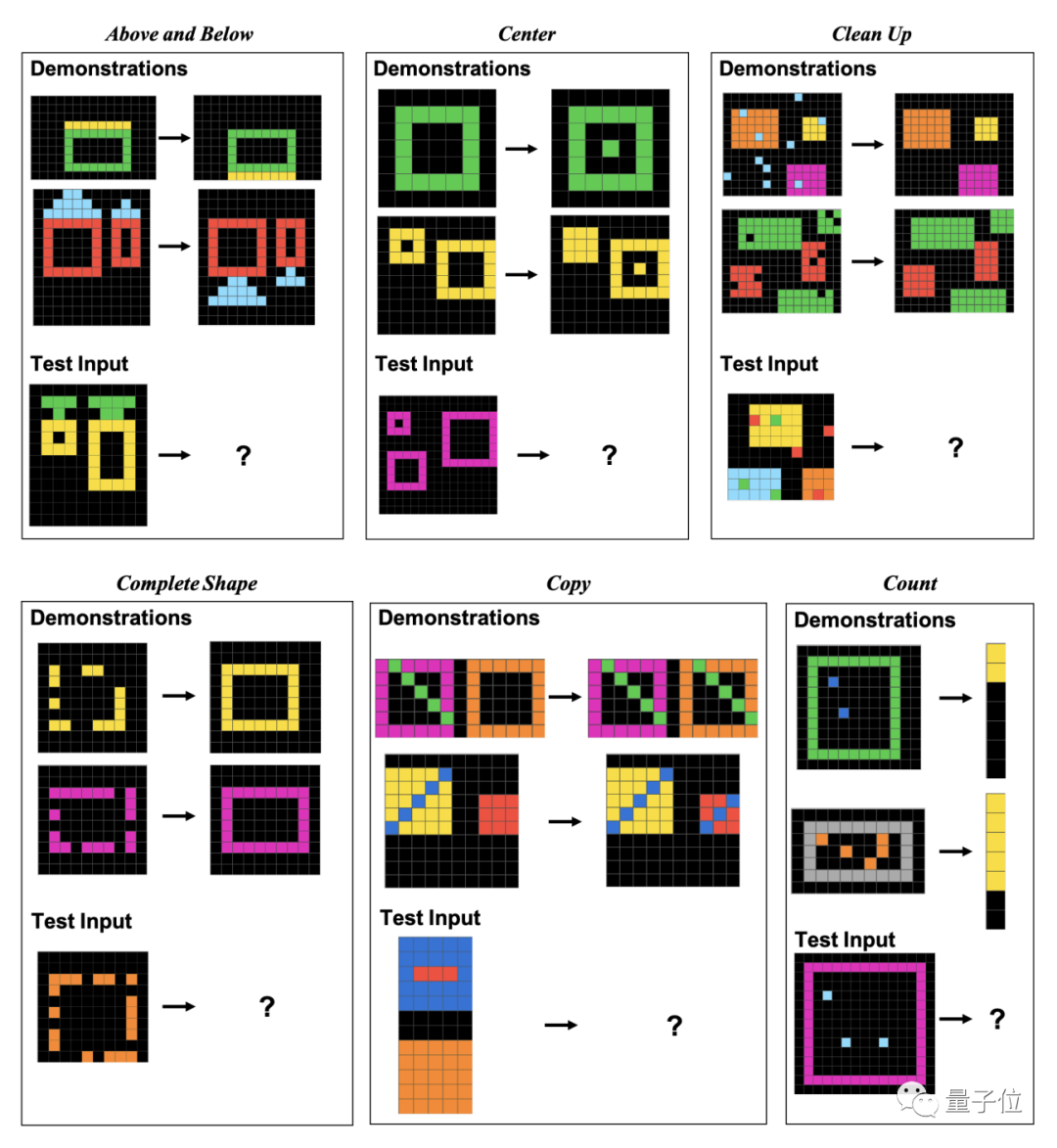

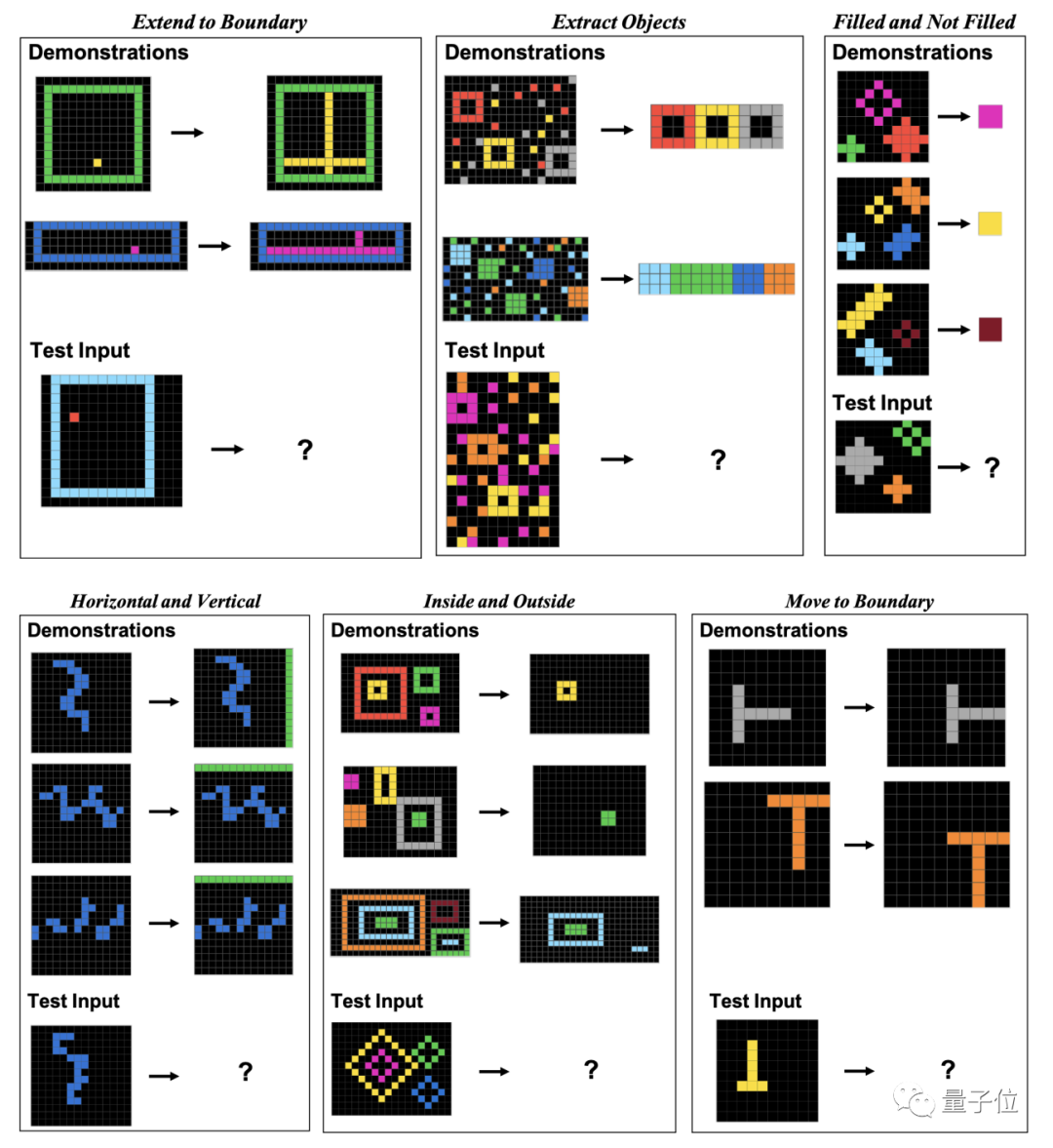

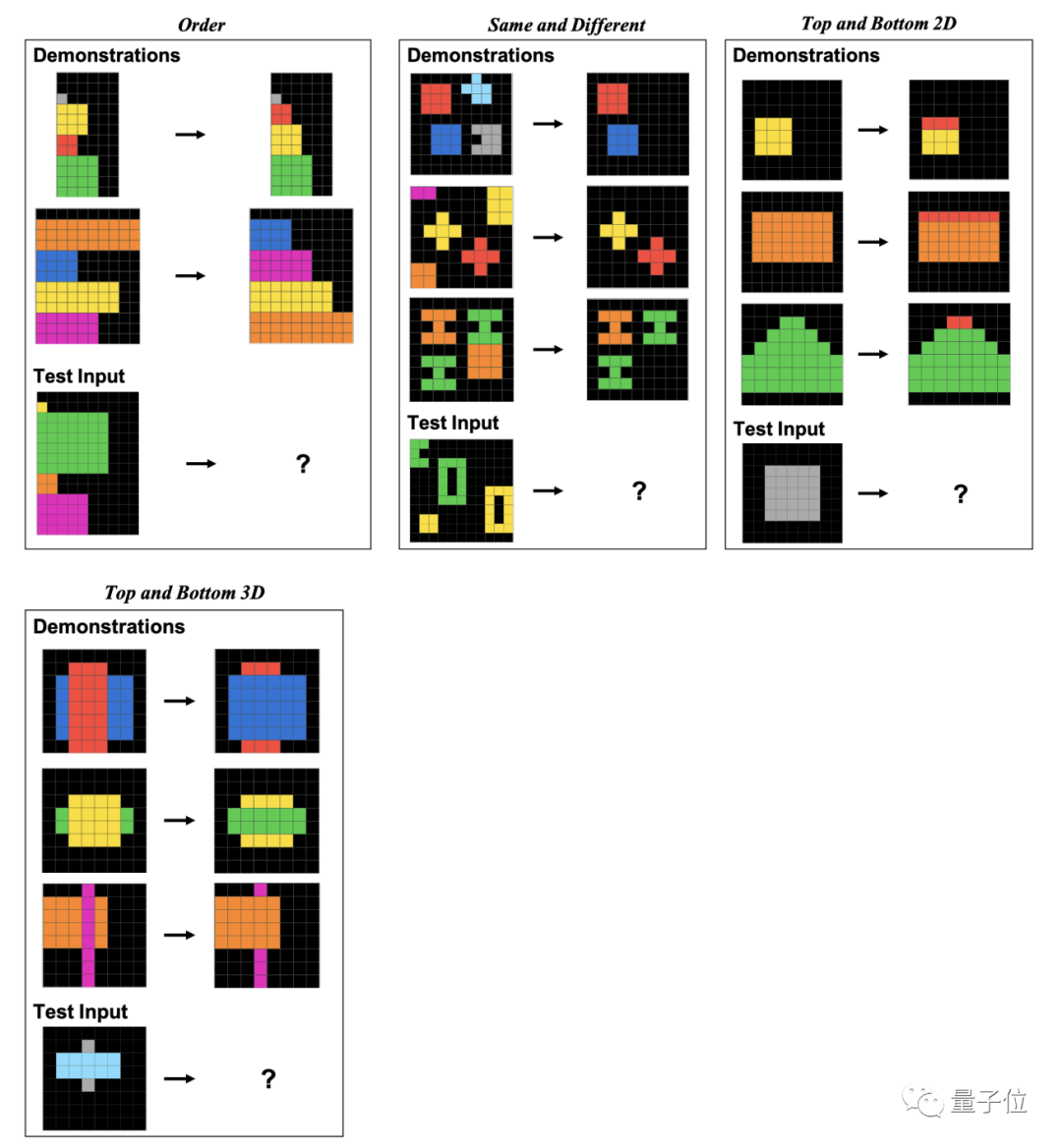

ConceptARC中總共包含16個子類別的圖形推理題,每類30道,一共480題。

這16個子類別包含了位置關係、形狀、操作、比較等多個面向的內容

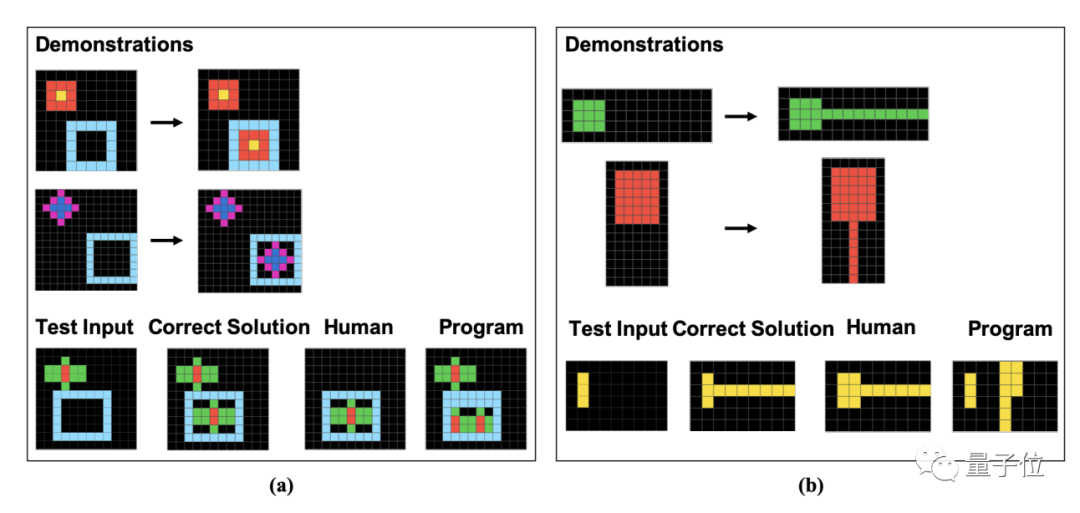

具體來說,這些題目都是由一個個像素塊組成的。人類和GPT需要根據給定的例子來尋找規律,並分析出圖像經過相同方式處理後的結果

作者在論文中具體展示了這16個子類的例題,每類各一道。

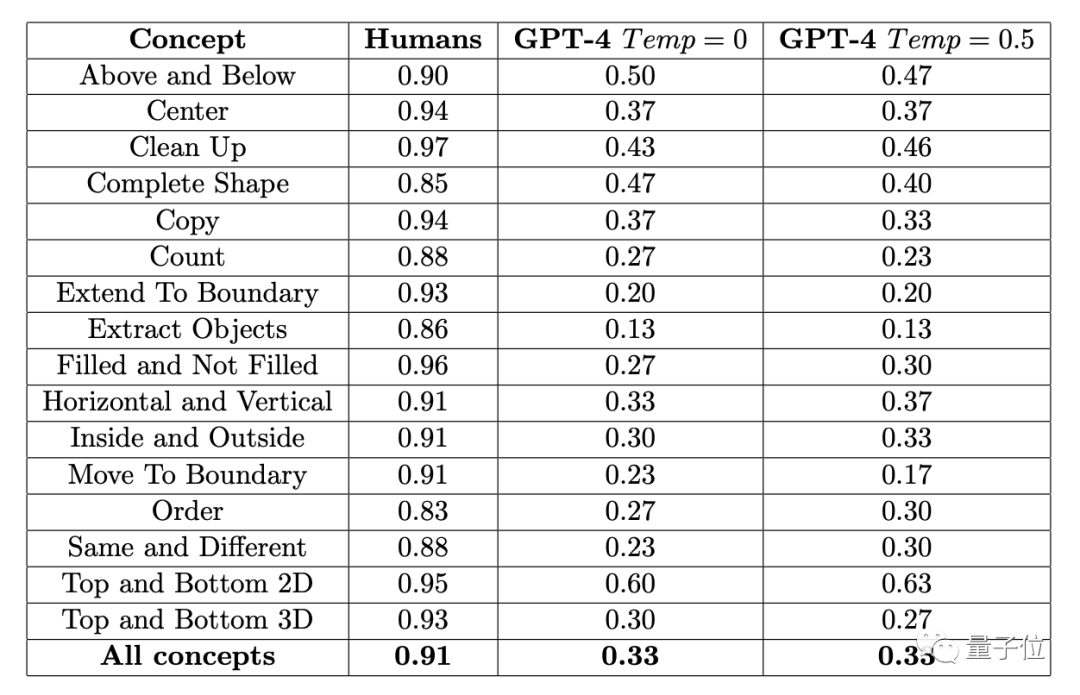

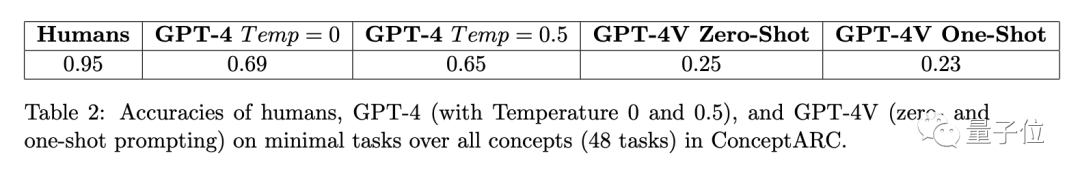

結果451位人類受試者平均正確率,在各子項中皆不低於83%, 16項任務再做平均,則達到了91%。

在「放水」到一題可以試三次(有一次對就算對)的情況下,GPT-4(單樣本)的準確率最高不超過60%,平均值只有33%

早些時候,這項實驗涉及的ConceptARC Benchmark的作者也做過類似的實驗,不過在GPT-4中進行的是零樣本測驗,結果16項任務的平均準確率只有19%。

GPT-4v是一種多模態的模型,但準確率較低。在一個由48題組成的小規模ConceptARC資料集上,零樣本測試和單樣本測試的準確率分別只有25%和23%

而研究者在進一步分析了錯誤答案後,發現人類的有些錯誤看上去很可能是“粗心導致”,而GPT則是完全沒有理解題目中的規律#。

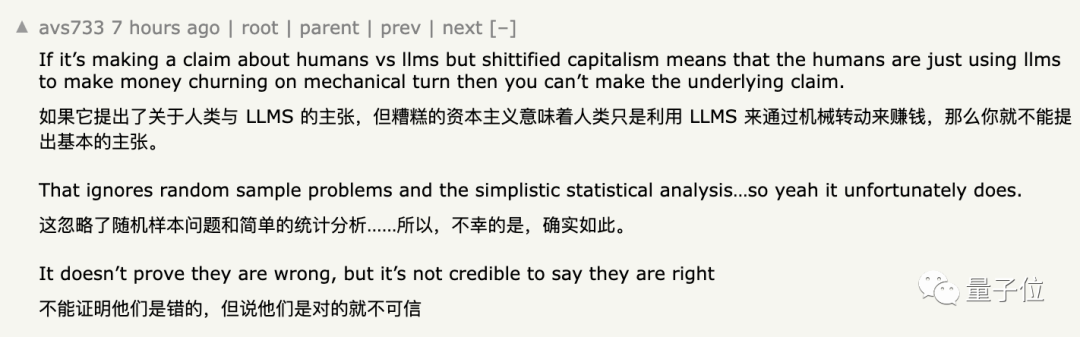

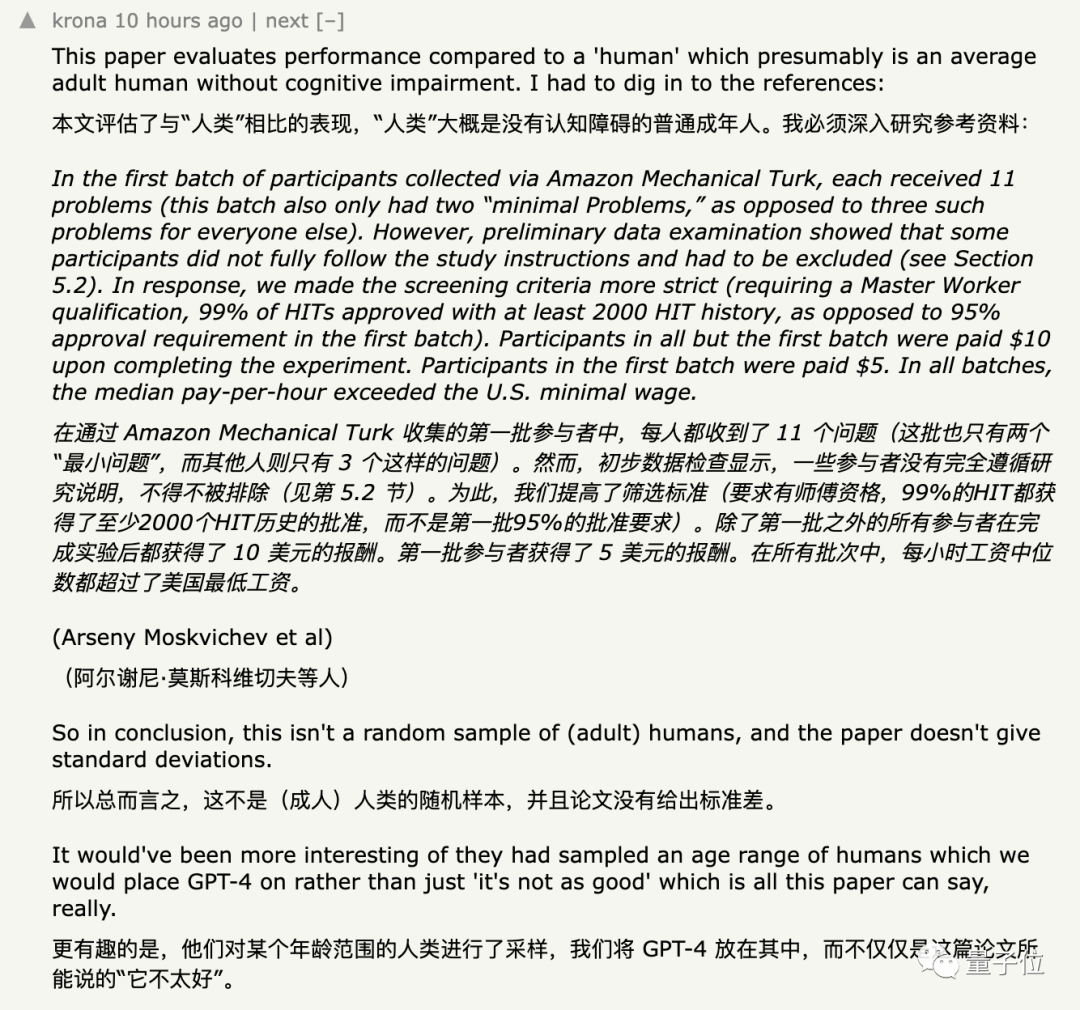

對於這些數據,大多數網友沒有什麼疑問,但引起這個實驗備受質疑的是招募到的受試者群體以及提供給GPT的輸入方式

#受試者選擇方式遭質疑

一開始,研究者在亞馬遜的一個眾包平台上招募受試者。

研究者從資料集中抽取了一些簡單題目作為入門測試,受試者需要答對隨機3道題目中的至少兩道才能進入正式測試 。

研究人員發現的結果顯示,有些人只是出於貪圖金錢的目的參加入門測試,而根本沒有按照要求完成題目

迫不得已,研究者將參加測驗的門檻上調到了在平台上完成過不少於2000個任務,且通過率要達到99%。

不過,雖然作者用通過率篩人,但是在具體能力上,除了需要受試者會英語,對圖形等其他專業能力「沒有特殊要求」 。

為了實現數據的多樣性,研究人員在實驗的後期將招募工作轉移到了另一個眾包平台。最終,共有415位被試者參與了這項實驗

儘管如此,還是有人質疑實驗中的樣本「不夠隨機」。

也有網友指出,研究者用來招募受試者的亞馬遜眾包平台上,有大模型在冒充人類 。

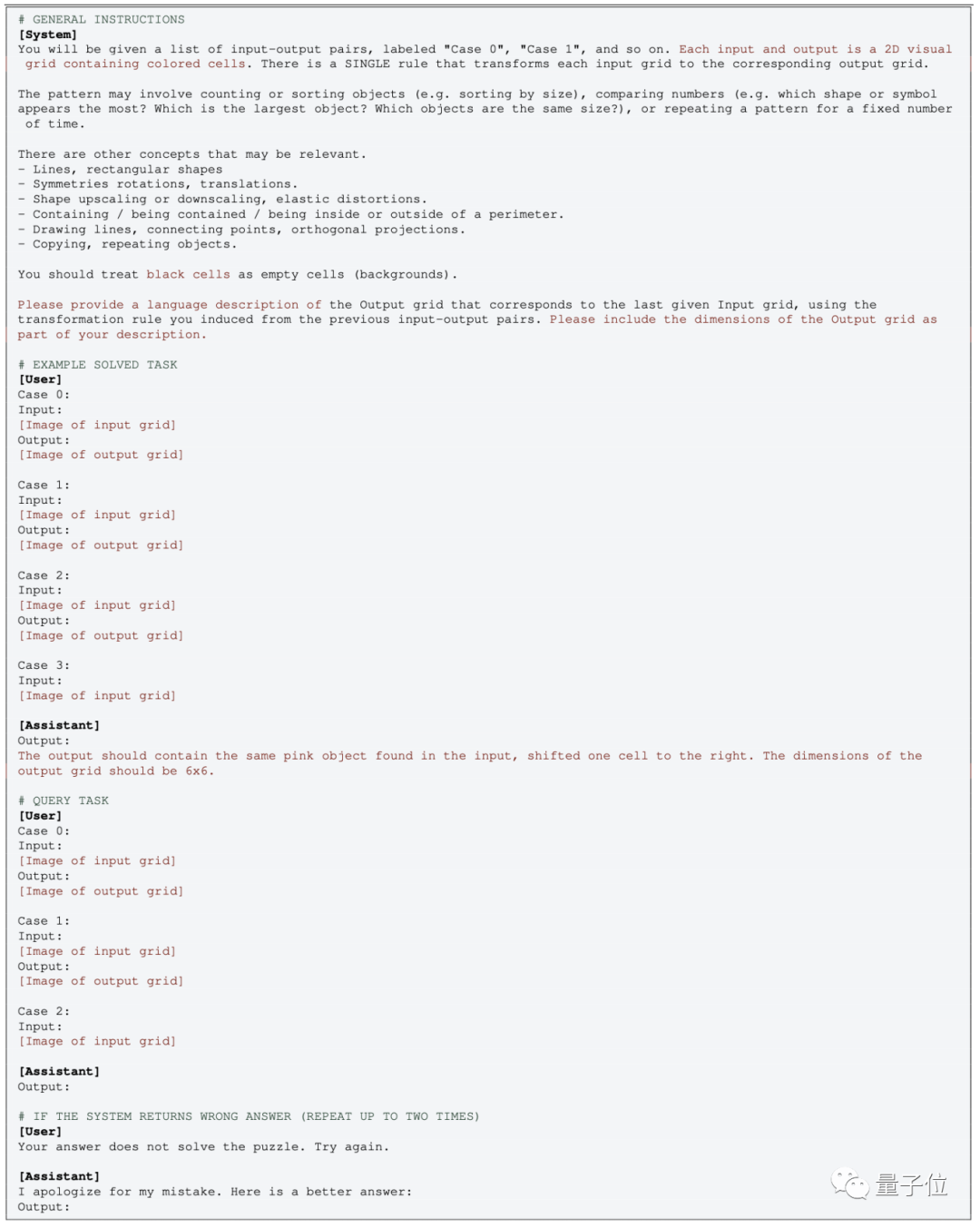

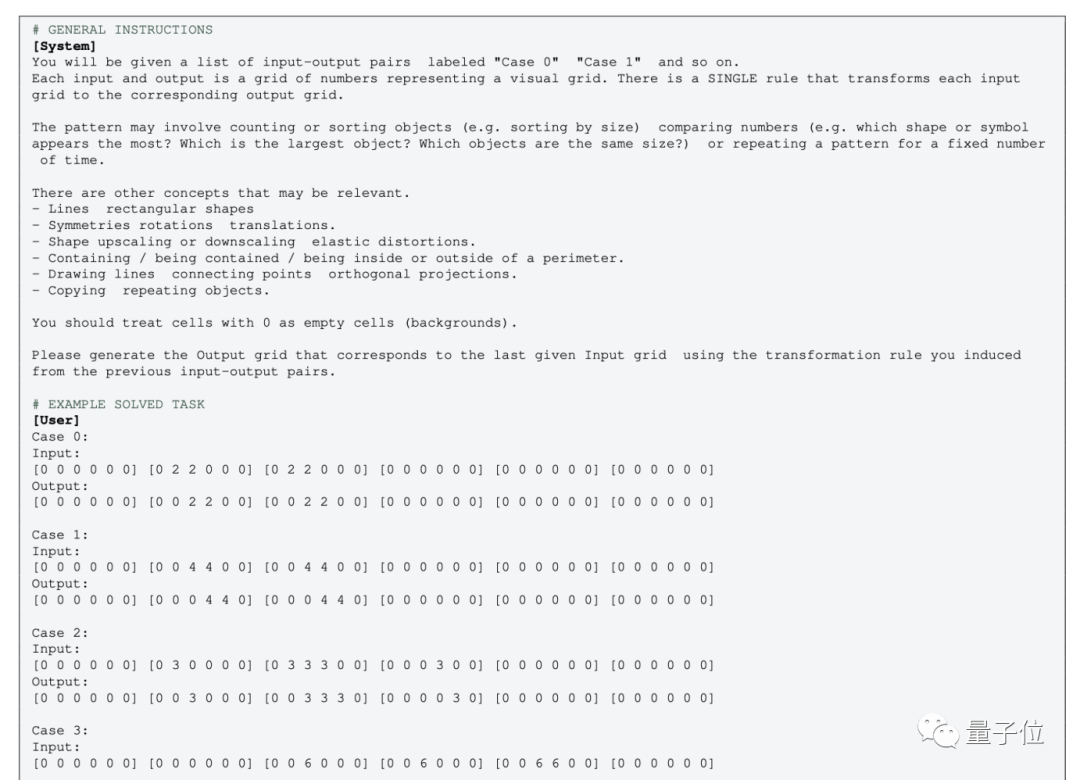

多模態版本的GPT運算相對簡單,只需直接傳入圖片,並使用對應的提示詞

在零樣本測試中,只需刪除對應的EXAMPLE部分

但對於不帶多模態的純文字版GPT-4(0613),則需要把圖像轉換為格點,用數字來代替顏色。

針對這種操作,就有人表示不認同了:

把圖像轉換成數字矩陣後,概念完全變了,就算是人類,看著用數字表示的“圖形”,可能也無法理解

One More Thing

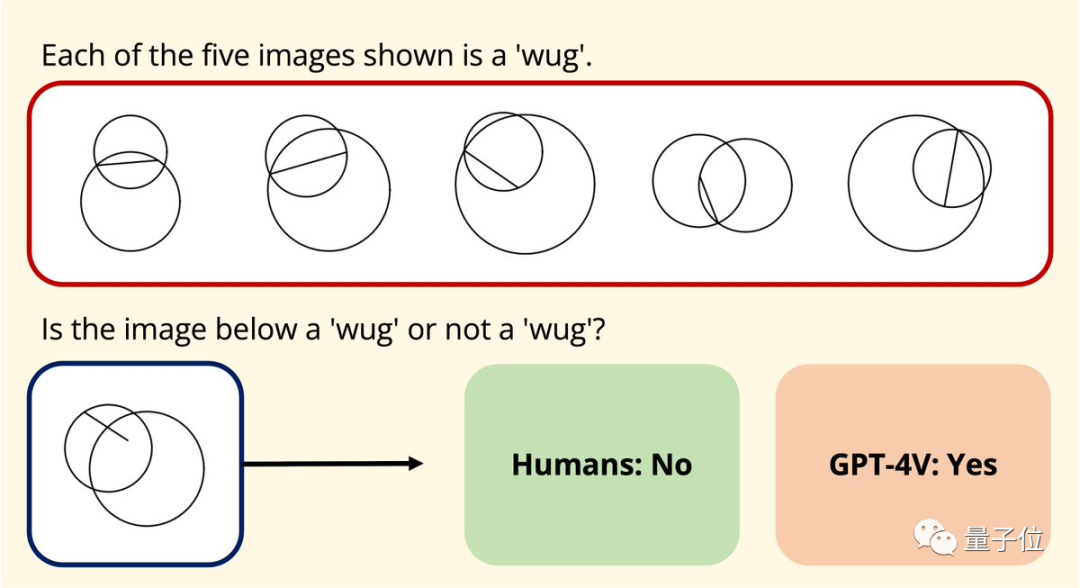

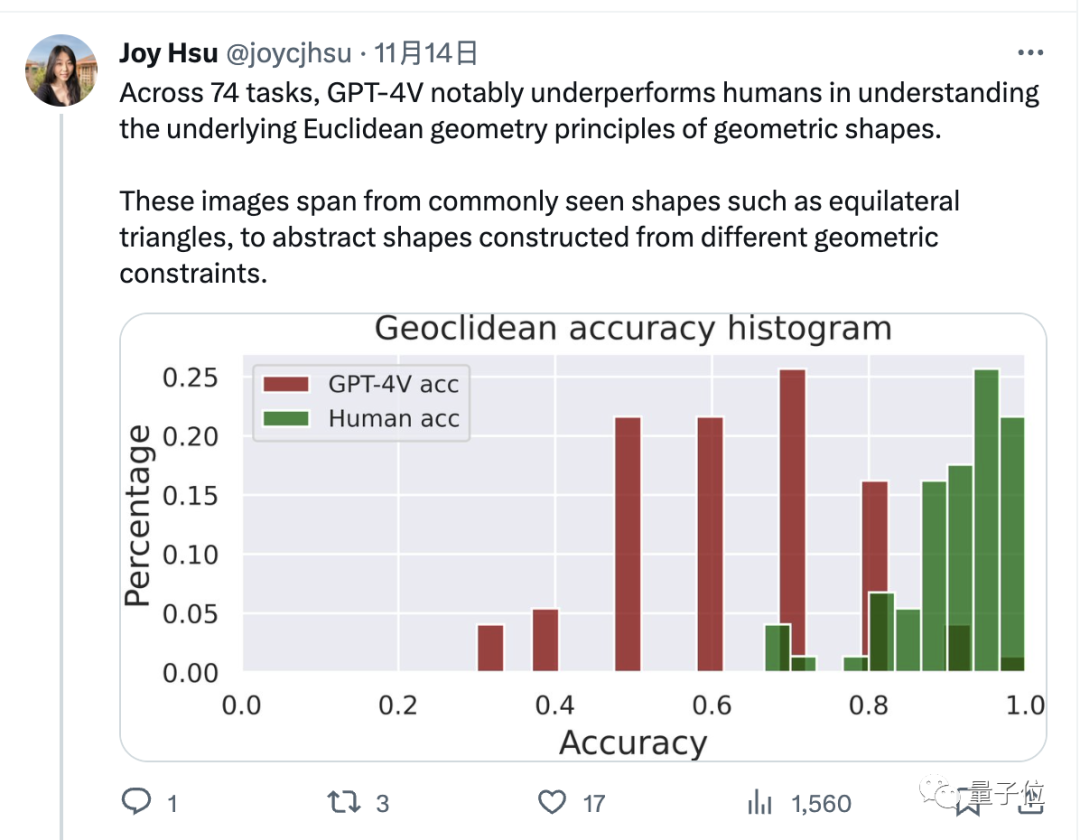

無獨有偶,史丹佛大學的華裔博士生Joy Hsu也對GPT-4v的圖形理解能力進行了幾何資料集的測試

去年發布了一個資料集,旨在測試大型模型對歐氏幾何的理解。在GPT-4v開放後,Hsu再次使用該資料集對其進行了測試

結果發現,GPT-4v對圖形的理解方式,似乎「和人類完全不同」。

在資料方面,GPT-4v在回答這些幾何問題上明顯不如人類

論文網址:

[1]https://arxiv.org/abs/2305.07141

[2]https://arxiv.org/abs/2311.09247

以上是GPT-4在圖形推理方面表現不佳?即使「放水」後,準確率僅33%的詳細內容。更多資訊請關注PHP中文網其他相關文章!