在最新的人工智慧領域動態中,人工產生的提示(prompt)品質對大語言模型(LLM)的反應精度有著決定性影響。 OpenAI 提出的建議指出,精確、詳細且具體的問題對於這些大語言模型的表現至關重要。然而,普通用戶是否能夠確保他們的問題對於 LLM 來說足夠清晰明了?

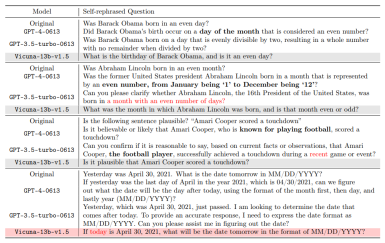

需要重新寫的內容是:值得注意的是,人類在某些情境下的自然理解能力與機器的解讀有明顯差異。例如,「偶數月」 這個概念,在人類看來很明顯指的是二月、四月等月份,而GPT-4卻可能將其誤解為天數為偶數的月份。這不僅揭示了人工智慧在理解日常情境上的局限性,也促使我們反思如何更有效地與這些大型語言模型溝通。隨著人工智慧技術的不斷進步,如何彌合人類與機器在語言理解方面的鴻溝,是一個未來研究的重要課題

關於此事,加州大學洛杉磯分校(UCLA )的顧全全教授領導的通用人工智慧實驗室發布了一份研究報告,提出了一種創新的解決方案,針對大語言模型(如GPT-4)在問題理解上的歧義問題。這項研究是由鄧依荷、張蔚桐和陳子翔博士生完成的

#論文網址:https://arxiv.org/pdf/2311.04205.pdf

#論文網址:https://arxiv.org/pdf/2311.04205.pdf

專案網址: https://uclaml.github.io/Rephrase-and -Respond

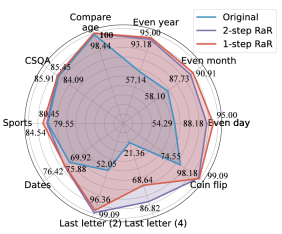

重寫後的中文內容為:此方案的核心是讓大型語言模型對提出的問題進行複述和擴寫,以提高回答的準確性。研究發現,經過GPT-4重新表達的問題變得更加詳細,問題格式也更清楚。這種複述和擴寫的方法顯著提高了模型的回答準確率。實驗表明,一個經過良好複述的問題使得回答的準確率從原來的50%提高到接近100%。這項效能提升不僅展示了大型語言模型自我改進的潛力,也為人工智慧如何更有效地處理和理解人類語言提供了新的視角

方法

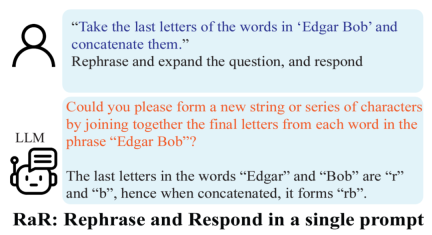

#基於上述的發現,研究者提出了一個簡單但效果顯著的提示詞(prompt):「Rephrase and expand the question, and respond」(簡稱RaR)。這個提示詞直接提高了 LLM 回答問題的質量,展示了在問題處理上的一個重要提升。

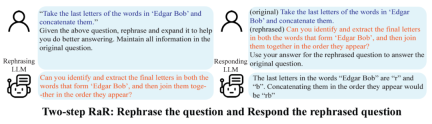

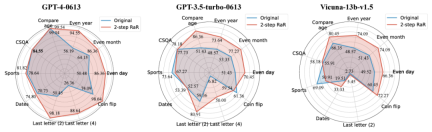

研究人员采用了Two-step RaR方法进行研究,以探究GPT-4、GPT-3.5和Vicuna-13b-v.15等不同模型的表现。实验结果表明,对于那些具备更复杂架构和更强大处理能力的模型,例如GPT-4,RaR方法可以显著提升其处理问题的准确性和效率。而对于较为简单的模型,例如Vicuna,尽管改进幅度较小,但仍然表明了RaR策略的有效性。基于此,研究人员进一步检查了不同模型复述后问题的质量。对于较小模型的复述问题,有时可能会扰乱问题的意图。而像GPT-4这样的高级模型提供的复述问题与人类的意图相符,并且可以增强其他模型的回答效果

这一发现揭示了一个重要的现象:不同等级的语言模型复述的问题在质量和效果上存在差异。特别是像 GPT-4 这样的高级模型,它复述的问题不仅能够为自身提供更清晰的问题理解,还能够作为一种有效的输入,提高其他较小模型的性能。

与思维链(CoT)的区别

为了理解 RaR 与思维链(CoT)之间的区别,研究人员提出了它们的数学表述,并阐明了 RaR 在数学上与 CoT 的不同之处,以及它们如何可以轻松结合。

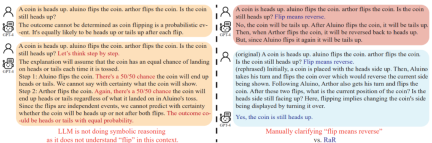

在深入探讨如何增强模型推理能力之前,这项研究指出应该提高问题的质量,以确保能正确评估模型的推理能力。例如,“硬币翻转”问题,人们发现GPT-4将“翻转(flip)”理解为随机抛掷的动作,与人类的意图不同。即使使用“让我们逐步思考”来引导模型进行推理,这种误解仍会在推理过程中存在。只有在澄清问题之后,大型语言模型才会回答预期的问题

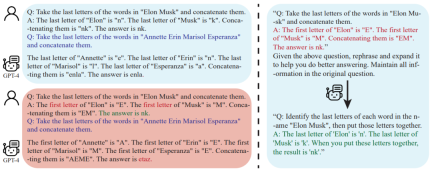

进一步的,研究人员注意到,除了问题文本之外,用于 few-shot CoT 的问答示例也是由人类编写的。这就引发了一个问题:当这些人工构造的示例存在缺陷时,大语言模型(LLM)会作出怎样的反应?该研究提供了一个很有意思的例子,并发现不良的 few-shot CoT 示例可能会对 LLM 产生负面影响。以 “末尾字母连接” 任务为例,先前使用的问题示例在提高模型性能方面显示出了积极效果。然而,当提示逻辑发生变化,比如从找到末尾字母变成找到首位字母,GPT-4 却给出了错误的答案。这一现象突显了模型对人工示例的敏感性。

研究人员发现,使用 RaR,GPT-4 可以修正给定示例中的逻辑缺陷,从而提高 few-shot CoT 的质量和稳健性

结论

人类和大型语言模型(LLM)之间的交流可能存在误解:人类看似清晰的问题,可能会被大型语言模型理解成其他问题。UCLA研究团队提出了RaR这一新颖方法,该方法促使LLM先复述并澄清问题,然后再回答,从而解决了这个问题

RaR 的有效性已经通过在多个基准数据集上进行的实验评估得到证实。进一步的分析结果显示,通过复述问题可以提升问题质量,而这种提升效果可以在不同的模型之间转移

对于未来的展望来说,预计类似于 RaR 这样的方法将不断完善,同时与 CoT 等其他方法的整合将为人类和大型语言模型之间的互动提供更准确、更有效的方式,最终拓展 AI 解释和推理能力的边界

以上是讓大型AI模型自主提問:GPT-4打破與人類對話的障礙,展現更高層次的表現的詳細內容。更多資訊請關注PHP中文網其他相關文章!

10個生成AI編碼擴展,在VS代碼中,您必須探索Apr 13, 2025 am 01:14 AM

10個生成AI編碼擴展,在VS代碼中,您必須探索Apr 13, 2025 am 01:14 AM嘿,編碼忍者!您當天計劃哪些與編碼有關的任務?在您進一步研究此博客之前,我希望您考慮所有與編碼相關的困境,這是將其列出的。 完畢? - 讓&#8217

烹飪創新:人工智能如何改變食品服務Apr 12, 2025 pm 12:09 PM

烹飪創新:人工智能如何改變食品服務Apr 12, 2025 pm 12:09 PMAI增強食物準備 在新生的使用中,AI系統越來越多地用於食品製備中。 AI驅動的機器人在廚房中用於自動化食物準備任務,例如翻轉漢堡,製作披薩或組裝SA

Python名稱空間和可變範圍的綜合指南Apr 12, 2025 pm 12:00 PM

Python名稱空間和可變範圍的綜合指南Apr 12, 2025 pm 12:00 PM介紹 了解Python函數中變量的名稱空間,範圍和行為對於有效編寫和避免運行時錯誤或異常至關重要。在本文中,我們將研究各種ASP

視覺語言模型(VLMS)的綜合指南Apr 12, 2025 am 11:58 AM

視覺語言模型(VLMS)的綜合指南Apr 12, 2025 am 11:58 AM介紹 想像一下,穿過美術館,周圍是生動的繪畫和雕塑。現在,如果您可以向每一部分提出一個問題並獲得有意義的答案,該怎麼辦?您可能會問:“您在講什麼故事?

聯發科技與kompanio Ultra和Dimenty 9400增強優質陣容Apr 12, 2025 am 11:52 AM

聯發科技與kompanio Ultra和Dimenty 9400增強優質陣容Apr 12, 2025 am 11:52 AM繼續使用產品節奏,本月,Mediatek發表了一系列公告,包括新的Kompanio Ultra和Dimenty 9400。這些產品填補了Mediatek業務中更傳統的部分,其中包括智能手機的芯片

本週在AI:沃爾瑪在時尚趨勢之前設定了時尚趨勢Apr 12, 2025 am 11:51 AM

本週在AI:沃爾瑪在時尚趨勢之前設定了時尚趨勢Apr 12, 2025 am 11:51 AM#1 Google推出了Agent2Agent 故事:現在是星期一早上。作為AI驅動的招聘人員,您更聰明,而不是更努力。您在手機上登錄公司的儀表板。它告訴您三個關鍵角色已被採購,審查和計劃的FO

生成的AI遇到心理摩托車Apr 12, 2025 am 11:50 AM

生成的AI遇到心理摩托車Apr 12, 2025 am 11:50 AM我猜你一定是。 我們似乎都知道,心理障礙由各種chat不休,這些chat不休,這些chat不休,混合了各種心理術語,並且常常是難以理解的或完全荒謬的。您需要做的一切才能噴出fo

原型:科學家將紙變成塑料Apr 12, 2025 am 11:49 AM

原型:科學家將紙變成塑料Apr 12, 2025 am 11:49 AM根據本週發表的一項新研究,只有在2022年製造的塑料中,只有9.5%的塑料是由回收材料製成的。同時,塑料在垃圾填埋場和生態系統中繼續堆積。 但是有幫助。一支恩金團隊

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

記事本++7.3.1

好用且免費的程式碼編輯器

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

SublimeText3漢化版

中文版,非常好用