近年來,圖像生成領域取得了巨大的進步,尤其是文字到圖像生成方面取得了重大突破:只要我們用文字描述自己的想法,AI 就能產生新奇又逼真的圖像。

但其實我們可以更進一步- 將腦中的想法轉化為文本這一步可以省去,直接透過腦活動(如EEG(腦電圖)記錄)來控制圖像的生成創作。

這種「思維到圖像」的生成方式有著廣闊的應用前景。例如,它能極大地提高藝術創作的效率,並幫助人們捕捉稍縱即逝的靈感;它也有可能將人們夜晚的夢境進行可視化;它甚至可能用於心理治療,幫助自閉症兒童和語言障礙患者。

最近,來自清華大學深圳國際研究生院、騰訊AI Lab 和鵬城實驗室的研究者們聯合發表了一篇「思維到圖像」的研究論文,利用預訓練的文字到影像模型(例如Stable Diffusion)強大的生成能力,直接從腦電圖訊號產生了高品質的影像。

圖片

圖片

論文網址:https://arxiv.org/pdf/2306.16934.pdf

#專案地址:https://github.com/bbaaii/DreamDiffusion

#方法概述

近期一些相關研究(例如MinD-Vis)嘗試基於fMRI(功能性磁振造影訊號)來重建視覺資訊。他們已經證明了利用腦活動重建高品質結果的可行性。然而,這些方法與理想中使用腦訊號進行快速、高效的創作還差得太遠,這主要有兩點原因:

首先,fMRI 設備不便攜,並且需要專業人員操作,因此捕捉fMRI 訊號很困難;

其次,fMRI 資料收集的成本較高,這在實際的藝術創作中會很大程度地阻礙該方法的使用。

相比之下,EEG 是一種非侵入性、低成本的腦電活動記錄方法,並且現在市面上已經有獲得 EEG 訊號的便攜商用產品。

但實現「思維到圖像」的生成還面臨兩個主要挑戰:

1)EEG 訊號通過非侵入式的方法來捕捉,因此它本質上是有噪音的。此外,EEG 數據有限,個體差異不容忽視。那麼,如何從如此多的約束條件下的腦電訊號中獲得有效且穩健的語意表徵呢?

2)由於使用了 CLIP 並在大量文字 - 影像對上進行訓練,Stable Diffusion 中的文字和影像空間對齊良好。然而,EEG 訊號具有其自身的特點,其空間與文字和圖像大不相同。如何在有限且有雜訊的 EEG - 影像對上對齊 EEG、文字和影像空間?

為了解決第一個挑戰,該研究提出,使用大量的 EEG 資料來訓練 EEG 表徵,而不是僅用罕見的 EEG 影像對。研究採用掩碼訊號建模的方法,根據上下文線索預測缺失的 token。

不同於將輸入視為二維影像並屏蔽空間資訊的MAE 和MinD-Vis,該研究考慮了EEG 訊號的時間特性,並深入挖掘人類大腦時序變化背後的語義。研究隨機屏蔽了一部分 token,然後在時間域內重建這些被屏蔽的 token。透過這種方式,預先訓練的編碼器能夠對不同個體和不同腦部活動的 EEG 資料進行深入理解。

對於第二個挑戰,先前的解決方法通常直接對 Stable Diffusion 模型進行微調,使用少量雜訊資料對進行訓練。然而,僅透過最終的影像重建損失對 SD 進行端到端微調,很難學習到腦訊號(例如 EEG 和 fMRI)與文字空間之間的準確對齊。因此,研究團隊提出採用額外的 CLIP 監督,以幫助實現 EEG、文字和圖像空間的對齊。

具體而言,SD 本身使用 CLIP 的文字編碼器來產生文字嵌入,這與先前階段的遮罩預訓練 EEG 嵌入非常不同。利用 CLIP 的圖像編碼器提取豐富的圖像嵌入,這些嵌入與 CLIP 的文字嵌入很好地對齊。然後,這些 CLIP 影像嵌入被用於進一步優化 EEG 嵌入表徵。因此,經過改進的 EEG 特徵嵌入可以與 CLIP 的圖像和文字嵌入很好地對齊,並更適合於 SD 圖像生成,從而提高生成圖像的品質。

基於上述兩個精心設計的方案,研究提出了新方法 DreamDiffusion。 DreamDiffusion 能夠從腦電圖(EEG)訊號中產生高品質且逼真的影像。

圖片

圖片

具體來說,DreamDiffusion 主要由三個部分組成:

1)遮罩訊號預先訓練,以實現有效且穩健的EEG 編碼器;

2)使用預訓練的Stable Diffusion 和有限的EEG 影像對進行微調;

3)使用CLIP 編碼器,對齊EEG、文字和圖像空間。

首先,研究人員利用大量雜訊的 EEG 數據,採用掩碼訊號建模,訓練 EEG 編碼器,提取上下文知識。然後,得到的 EEG 編碼器透過交叉注意力機制被用來為 Stable Diffusion 提供條件特徵。

圖片

圖片

為了增強EEG 特徵與Stable Diffusion 的兼容性,研究人員進一步透過在微調過程中減少EEG 嵌入與CLIP 影像嵌入之間的距離,進一步對齊了EEG、文字和影像的嵌入空間。

實驗與分析

與Brain2Image 比較

##研究人員將本文方法與Brain2Image 進行比較。 Brain2Image 採用傳統的生成模型,即變分自編碼器(VAE)和生成對抗網路(GAN),用於實現從 EEG 到影像的轉換。然而,Brain2Image 僅提供了少數類別的結果,並沒有提供參考實作。

有鑑於此,該研究對 Brain2Image 論文中展示的幾個類別(即飛機、南瓜燈和熊貓)進行了定性比較。為確保比較公平,研究人員採用了與 Brain2Image 論文中所述相同的評估策略,並在下圖 5 中展示了不同方法產生的結果。

下圖第一行展示了 Brain2Image 產生的結果,最後一行是研究人員提出的方法 DreamDiffusion 產生的。可以看到 DreamDiffusion 產生的影像品質明顯高於 Brain2Image 產生的影像,這也驗證了本文方法的有效性。

圖片

圖片

#消融實驗

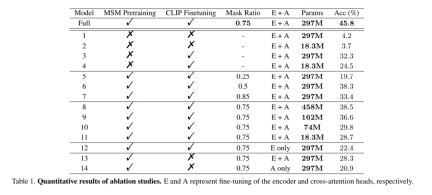

:為了證明大規模EEG 資料預訓練的有效性,該研究使用未經訓練的編碼器來訓練多個模型進行驗證。其中一個模型與完整模型相同,而另一個模型只有兩層的 EEG 編碼層,以避免資料過度擬合。在訓練過程中,這兩個模型分別進行了有 / 無 CLIP 監督的訓練,結果如表 1 中 Model 列的 1 到 4 所示。可以看到,沒有經過預先訓練的模型準確性有所降低。

mask ratio:本文也研究了以EEG 資料確定MSM 預訓練的最佳掩碼比。如表 1 中的 Model 列的 5 到 7 所示,過高或過低的遮罩比會對模型效能都會產生不利影響。當遮罩比為 0.75 達到最高的整體準確率。這項發現至關重要,因為這表明,與通常使用低遮罩比的自然語言處理不同,在對 EEG 進行 MSM 時,高遮罩比是一個較好的選擇。

CLIP 對齊

CLIP 對齊

以上是你大腦中的畫面,現在可以高清還原了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

優化您的組織與Genai代理商的電子郵件營銷Apr 13, 2025 am 11:44 AM

優化您的組織與Genai代理商的電子郵件營銷Apr 13, 2025 am 11:44 AM介紹 恭喜!您經營一家成功的業務。通過您的網頁,社交媒體活動,網絡研討會,會議,免費資源和其他來源,您每天收集5000個電子郵件ID。下一個明顯的步驟是

Apache Pinot實時應用程序性能監視Apr 13, 2025 am 11:40 AM

Apache Pinot實時應用程序性能監視Apr 13, 2025 am 11:40 AM介紹 在當今快節奏的軟件開發環境中,確保最佳應用程序性能至關重要。監視實時指標,例如響應時間,錯誤率和資源利用率可以幫助MAIN

Chatgpt擊中了10億用戶? Openai首席執行官說:'短短幾週內翻了一番Apr 13, 2025 am 11:23 AM

Chatgpt擊中了10億用戶? Openai首席執行官說:'短短幾週內翻了一番Apr 13, 2025 am 11:23 AM“您有幾個用戶?”他扮演。 阿爾特曼回答說:“我認為我們上次說的是每週5億個活躍者,而且它正在迅速增長。” “你告訴我,就像在短短幾週內翻了一番,”安德森繼續說道。 “我說那個私人

pixtral -12b:Mistral AI'第一個多模型模型 - 分析VidhyaApr 13, 2025 am 11:20 AM

pixtral -12b:Mistral AI'第一個多模型模型 - 分析VidhyaApr 13, 2025 am 11:20 AM介紹 Mistral發布了其第一個多模式模型,即Pixtral-12b-2409。該模型建立在Mistral的120億參數Nemo 12B之上。是什麼設置了該模型?現在可以拍攝圖像和Tex

生成AI應用的代理框架 - 分析VidhyaApr 13, 2025 am 11:13 AM

生成AI應用的代理框架 - 分析VidhyaApr 13, 2025 am 11:13 AM想像一下,擁有一個由AI驅動的助手,不僅可以響應您的查詢,還可以自主收集信息,執行任務甚至處理多種類型的數據(TEXT,圖像和代碼)。聽起來有未來派?在這個a

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

SublimeText3漢化版

中文版,非常好用

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能