當地時間5月9日,Meta宣布開源了一種可以將可以橫跨6種不同模態的全新AI模型ImageBind,包括視覺(圖像和視頻形式)、溫度(紅外線圖像)、文字、音頻、深度資訊、運動讀數(由慣性測量單元或IMU產生)。目前,相關原始碼已託管至GitHub。

何為橫跨6種模態?

ImageBind以視覺為核心,能夠在6個模態之間自由理解和轉換。 Meta展示了一些案例,如聽到狗叫畫出一隻狗,同時給出對應的深度圖和文字描述;如輸入鳥的圖像 海浪的聲音,得到鳥在海邊的圖像。

相比Midjourney、Stable Diffusion 和DALL-E 2 這樣將文字與圖像配對的圖像生成器,ImageBind 更像是廣撒網,可以連接文字、圖像/視訊、音訊、3D 測量(深度)、溫度資料(熱)和運動資料(來自IMU),而且它無需先針對每一種可能性進行訓練,直接預測資料之間的聯繫,類似於人類感知或想像環境的方式。

研究者表示 ImageBind 可以使用大規模視覺語言模型(如 CLIP)進行初始化,從而利用這些模型的豐富圖像和文字表示。因此,ImageBind 可以透過很少的訓練就適用於不同的模態和任務。

ImageBind 是 Meta 致力於創建多模態 AI 系統的一部分,從而實現從所有相關類型資料中學習。隨著模態數量的增加,ImageBind 為研究人員打開了嘗試開發全新整體性系統的閘門,例如結合 3D 和 IMU 感測器來設計或體驗身臨其境的虛擬世界。此外它還可以提供一種探索記憶的豐富方式,即組合使用文字、視訊和圖像來搜尋圖像、視訊、音訊檔案或文字資訊。

該模型目前只是一個研究項目,沒有直接的消費者和實際應用,但是它展現了生成式AI 在未來能夠生成沉浸式、多感官內容的方式,也表明了Meta正在以與OpenAI、Google 等競爭對手不同的方式,趟出一條屬於開源大模型的路。

最終,Meta 認為ImageBind 這項技術最終會超越目前的六種“感官”,其在博客上說道,“雖然我們在當前的研究中探索了六種模式,但我們相信引入連接盡可能多的感官的新模式——如觸覺、語音、嗅覺和大腦fMRI 信號——將使更豐富的以人為中心的人工智慧模型成為可能。」

ImageBind的用途

如果說 ChatGPT 可以充當搜尋引擎、問答社區,Midjourney 可以被用來當畫畫工具,那麼用 ImageBind 可以做什麼?

根據官方發布的 Demo 顯示,它可以直接用圖片產生音訊:

也可以音訊產生圖片:

亦或直接給一個文本,就可以檢索相關的圖片或音頻內容:

也可以給出音頻,產生相應的圖像:

如上文所述, ImageBind 給出了未來生成式 AI 系統可以以多模態呈現的方式,同時,結合 Meta 內部的虛擬實境、混合實境和元宇宙等技術和場景結合。用 ImageBind 這樣的工具會在無障礙空間打開新的大門,譬如,產生即時多媒體描述來幫助有視力或聽力障礙的人更好地感知他們的直接環境。

關於多模態學習還有很多待發掘的內容。目前,人工智慧領域還沒有有效地量化那些只出現在較大模型中的擴展行為並且理解其應用。 ImageBind是朝著以嚴格的方式評估影像生成和檢索新應用並展示的方向邁進的一步。

作者:Ballad

來源:第一個電動網(www.d1ev.com)

以上是AI早報 | 文字、圖像、影音、3D互相生成是什麼體驗?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

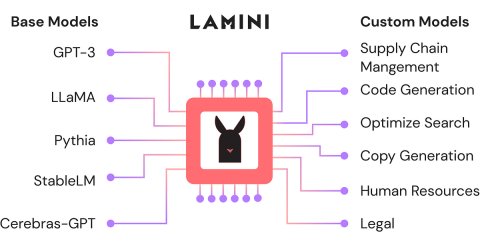

使用Lamini-Analytics Vidhya微調開源LLMApr 12, 2025 am 10:20 AM

使用Lamini-Analytics Vidhya微調開源LLMApr 12, 2025 am 10:20 AM最近,隨著大語言模型和AI的興起,我們看到了自然語言處理方面的無數進步。文本,代碼和圖像/視頻生成等域中的模型具有存檔的人類的推理和P

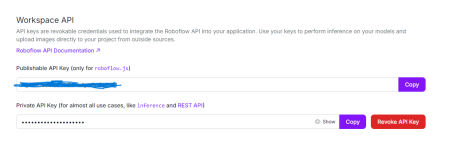

Python中使用OpenCV和Roboflow進行性別檢測 - 分析VidhyaApr 12, 2025 am 10:19 AM

Python中使用OpenCV和Roboflow進行性別檢測 - 分析VidhyaApr 12, 2025 am 10:19 AM介紹 從面部圖像中檢測性別是計算機視覺的眾多迷人應用之一。在這個項目中,我們將OpenCV結合在一起,以解決位置與性別分類的Roboflow API

生成AI在個性化廣告內容中的作用是什麼?Apr 12, 2025 am 10:18 AM

生成AI在個性化廣告內容中的作用是什麼?Apr 12, 2025 am 10:18 AM介紹 自易貨系統概念以來,廣告世界一直在進化。廣告商找到了創造性的方法來引起我們的關注。在當前年齡,消費者期望BR

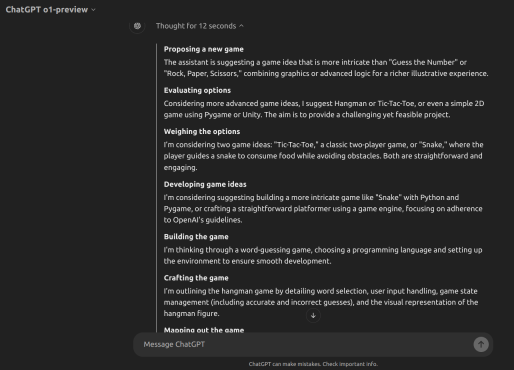

Openai' o1-preview vs o1-mini:向前邁出的一步Apr 12, 2025 am 10:04 AM

Openai' o1-preview vs o1-mini:向前邁出的一步Apr 12, 2025 am 10:04 AM介紹 9月12日,OpenAI發布了一項名為“與LLM的學習推理”的更新。他們介紹了O1模型,該模型是使用強化學習來應對複雜推理任務的訓練。是什麼設置了此mod

如何使用OpenAI O1構建遊戲? - 分析VidhyaApr 12, 2025 am 10:03 AM

如何使用OpenAI O1構建遊戲? - 分析VidhyaApr 12, 2025 am 10:03 AM介紹 OpenAI O1模型家族大大提高了推理能力和經濟表現,尤其是在科學,編碼和解決問題方面。 Openai的目標是創建越來越高的AI和O1模型

流行的LLM代理工具用於客戶查詢管理Apr 12, 2025 am 10:01 AM

流行的LLM代理工具用於客戶查詢管理Apr 12, 2025 am 10:01 AM介紹 如今,客戶查詢管理的世界正在以前所未有的速度移動,每天都有新的工具成為頭條新聞。大型語言模型(LLM)代理是在這種情況下的最新創新,增強了Cu

100天企業的AI實施計劃Apr 12, 2025 am 09:56 AM

100天企業的AI實施計劃Apr 12, 2025 am 09:56 AM介紹 採用生成AI可能是任何公司的變革旅程。但是,Genai實施過程通常會繁瑣且令人困惑。 Niit Lim的董事長兼聯合創始人Rajendra Singh Pawar

Pixtral 12B與QWEN2-VL-72BApr 12, 2025 am 09:52 AM

Pixtral 12B與QWEN2-VL-72BApr 12, 2025 am 09:52 AM介紹 人工智能革命引起了創造力的新時代,文本對圖像模型正在重新定義藝術,設計和技術的交集。 pixtral 12b和qwen2-vl-72b是兩個開創性的力量。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

SublimeText3 Linux新版

SublimeText3 Linux最新版

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能