目前,AI 模型雖然已經涉及非常廣泛的應用領域,但大部分AI 模型是為特定任務而設計的,它們往往需要大量的人力來完成正確的模型架構、優化演算法和超參數。 ChatGPT、GPT-4 爆火之後,人們看到了大型語言模型(LLM)在文本理解、生成、互動、推理等方面的巨大潛力。一些研究者嘗試利用 LLM 探索通往通用人工智慧(AGI)的新道路。

近期,來自德州大學奧斯汀分校的研究者提出一種新思路- 開發任務導向prompt,利用LLM 實現訓練pipeline 的自動化,並基於此想法推出新型系統AutoML-GPT。

論文網址:

https: //www.php.cn/link/39d4b545fb02556829aab1db805021c3

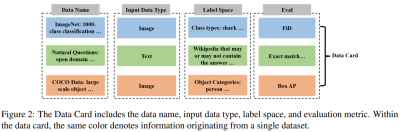

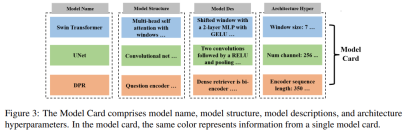

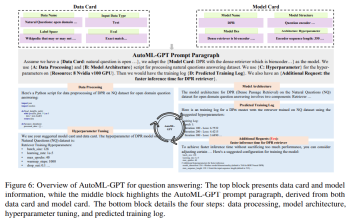

##AutoML-GPT 使用GPT 作為各種AI 模型之間的橋樑,並以最佳化的超參數來動態訓練模型。 AutoML-GPT 動態地接收來自 Model Card [Mitchell et al., 2019] 和 Data Card [Gebru et al., 2021] 的使用者請求,並組成對應的 prompt 段落。最後,AutoML-GPT 透過此 prompt 段落自動進行多項實驗,包括處理資料、建構模型架構、調整超參數和預測訓練日誌。

AutoML-GPT 透過最大限度地利用其強大的 NLP 能力和現有的人工智慧模型,解決了各種測試和資料集中複雜的 AI 任務。大量實驗和消融研究表明,AutoML-GPT 對許多人工智慧任務(包括 CV 任務、NLP 任務)是通用的、有效的。

AutoML-GPT 簡介AutoML-GPT 是一個依賴資料和模型資訊來格式化 prompt 輸入段落的協作系統。其中,LLM 作為控制器,多個專家模型作為協作的執行者。 AutoML-GPT 的工作流程包括四個階段:資料處理、模型架構設計、超參數調整和訓練日誌產生。

具體來說,AutoML-GPT 的工作機制如下:

- 透過Model Card 和Data Card 產生固定格式的prompt 段落

- 建立訓練pipeline,在選定的資料集和模型架構上處理使用者需求

除了 Data Card 和 Model Card,使用者還可以選擇要求更多的評估基準、評估指標或任何約束。 AutoML-GPT 將這些任務規格作為高階指令提供給 LLM,用於相應地分析使用者需求。

當有一系列需要處理的任務時,AutoML-GPT 需要為每個任務配對對應的模型。為了達到這個目標,首先系統需要取得 Model Card 和使用者輸入中的模型描述。

然後,AutoML-GPT 使用 in-context 任務 - 模型指派機制,動態地為任務指派模型。這種方法透過將模型描述和對用戶需求的更好理解結合起來,實現了增量模型(incremental model)訪問,並提供了更大的開放性和靈活性。

以預測訓練日誌調整超參數

#AutoML-GPT 根據Data Card 和Model Card 設定超參數,並透過產生超參數的訓練日誌來預測效能。系統自動進行訓練並傳回訓練日誌。在資料集上的模型性能訓練日誌記錄了訓練過程中收集的各種指標和信息,這有助於了解模型訓練進展,找出潛在問題,以及評估所選架構、超參數和優化方法的有效性。

實驗

為了評估AutoML-GPT 的效能,該研究使用ChatGPT(OpenAI 的GPT-4 版本)來實現它,並進行多項實驗從多個角度展示了AutoML-GPT 的效果。

下圖4 展示了使用AutoML-GPT 在未知資料集上訓練的結果:

下圖5 展示了AutoML-GPT 在COCO 資料集上完成目標偵測任務的過程:

##下圖6 展示了AutoML-GPT在NQ 開放資料集(Natural Questions Open dataset,[Kwiatkowski et al., 2019])上的實驗結果:

該研究也使用XGBoost 在UCI Adult 資料集[Dua and Graff, 2017] 上評估了AutoML-GPT,以探討其在分類任務上的效能,實驗結果如下圖7 所示:

#有興趣的讀者可以閱讀論文原文,了解更多研究細節。

以上是GPT充當大腦,指揮多個模型協作完成各類任務,通用系統AutoML-GPT來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!

AI遊戲開發通過Upheaval的Dreamer Portal進入其代理時代May 02, 2025 am 11:17 AM

AI遊戲開發通過Upheaval的Dreamer Portal進入其代理時代May 02, 2025 am 11:17 AM動盪遊戲:與AI代理商的遊戲開發徹底改變 Roupheaval是一家遊戲開發工作室,由暴風雪和黑曜石等行業巨頭的退伍軍人組成,有望用其創新的AI驅動的Platfor革新遊戲創作

Uber想成為您的Robotaxi商店,提供商會讓他們嗎?May 02, 2025 am 11:16 AM

Uber想成為您的Robotaxi商店,提供商會讓他們嗎?May 02, 2025 am 11:16 AMUber的Robotaxi策略:自動駕駛汽車的騎車生態系統 在最近的Curbivore會議上,Uber的Richard Willder推出了他們成為Robotaxi提供商的乘車平台的策略。 利用他們在

AI代理玩電子遊戲將改變未來的機器人May 02, 2025 am 11:15 AM

AI代理玩電子遊戲將改變未來的機器人May 02, 2025 am 11:15 AM事實證明,視頻遊戲是最先進的AI研究的寶貴測試理由,尤其是在自主代理商和現實世界機器人的開發中,甚至有可能促進人工通用情報(AGI)的追求。 一個

創業公司工業綜合體VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM

創業公司工業綜合體VC 3.0和James Currier的宣言May 02, 2025 am 11:14 AM不斷發展的風險投資格局的影響在媒體,財務報告和日常對話中顯而易見。 但是,對投資者,初創企業和資金的具體後果經常被忽略。 風險資本3.0:範式

Adobe在Adobe Max London 2025更新創意云和螢火蟲May 02, 2025 am 11:13 AM

Adobe在Adobe Max London 2025更新創意云和螢火蟲May 02, 2025 am 11:13 AMAdobe Max London 2025對Creative Cloud和Firefly進行了重大更新,反映了向可訪問性和生成AI的戰略轉變。 該分析結合了事件前簡報中的見解,並融合了Adobe Leadership。 (注意:Adob

Llamacon宣布的所有元數據May 02, 2025 am 11:12 AM

Llamacon宣布的所有元數據May 02, 2025 am 11:12 AMMeta的Llamacon公告展示了一項綜合的AI策略,旨在直接與OpenAI等封閉的AI系統競爭,同時為其開源模型創建了新的收入流。 這個多方面的方法目標bo

關於AI僅僅是普通技術的主張的釀造爭議May 02, 2025 am 11:10 AM

關於AI僅僅是普通技術的主張的釀造爭議May 02, 2025 am 11:10 AM人工智能領域對這一論斷存在嚴重分歧。一些人堅稱,是時候揭露“皇帝的新衣”了,而另一些人則強烈反對人工智能僅僅是普通技術的觀點。 讓我們來探討一下。 對這一創新性人工智能突破的分析,是我持續撰寫的福布斯專欄文章的一部分,該專欄涵蓋人工智能領域的最新進展,包括識別和解釋各種有影響力的人工智能複雜性(請點擊此處查看鏈接)。 人工智能作為普通技術 首先,需要一些基本知識來為這場重要的討論奠定基礎。 目前有大量的研究致力於進一步發展人工智能。總目標是實現人工通用智能(AGI)甚至可能實現人工超級智能(AS

模型公民,為什麼AI值是下一個業務碼May 02, 2025 am 11:09 AM

模型公民,為什麼AI值是下一個業務碼May 02, 2025 am 11:09 AM公司AI模型的有效性現在是一個關鍵的性能指標。自AI BOOM以來,從編寫生日邀請到編寫軟件代碼的所有事物都將生成AI使用。 這導致了語言mod的擴散

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

Atom編輯器mac版下載

最受歡迎的的開源編輯器

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中