單機訓練200億參數大模型:Cerebras打破新紀錄

- 王林轉載

- 2023-04-18 12:37:03877瀏覽

本週,晶片新創公司 Cerebras 宣布了一個里程碑式的新進展:在單一運算設備中訓練了超過百億參數的 NLP(自然語言處理)人工智慧模型。

由 Cerebras 訓練的 AI 模型體量達到了前所未有的 200 億參數,所有這些都無需橫跨多個加速器擴展工作負載。這項工作足以滿足目前網路上最火的文本到圖像 AI 生成模型——OpenAI 的 120 億參數大模型 DALL-E。

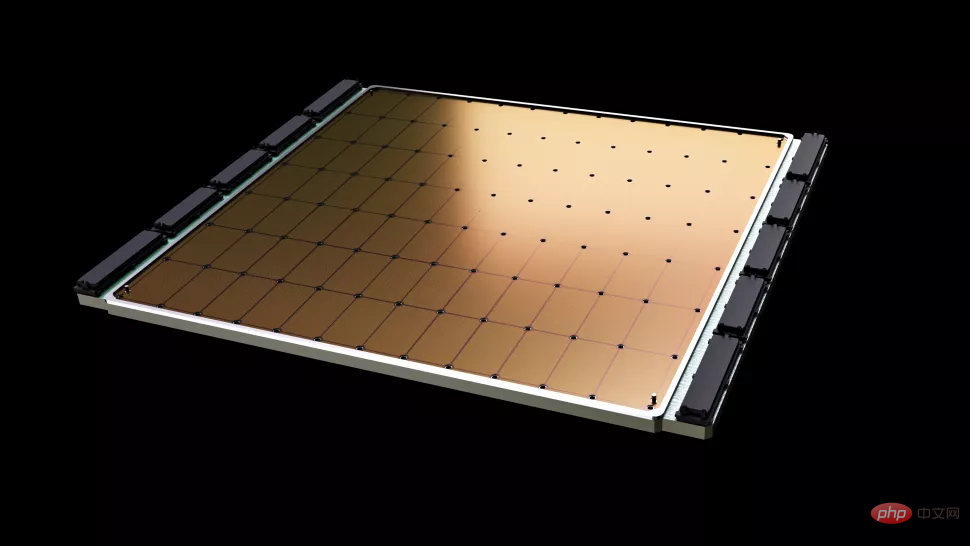

Cerebras 新工作中最重要的一點是對基礎設施和軟體複雜性的要求降低了。這家公司提供的晶片Wafer Scale Engine-2(WSE2)顧名思義,蝕刻在單台積電7 nm 製程的整塊晶圓上,該面積通常足以容納數百個主流晶片——具有驚人的2.6 兆個晶體管、85 萬個AI 計算核心和40 GB 整合緩存,封裝後功耗高達15kW。

接近晶圓大小的 Wafer Scale Engine-2,面積比 iPad 還大。

雖然Cerebras 的單機在體積上已經類似於超算了,但在單塊晶片中保留多達200 億個參數的NLP 模型仍然顯著降低了數千個GPU 的訓練成本,以及相關的硬體和擴展要求,同時消除了在它們之間分割模型的技術困難。 Cerebras 表示,後者是「NLP 工作負載中最痛苦的方面之一」,有時「需要幾個月才能完成」。

這是一個客製化的問題,不僅對每個正在處理的神經網絡,對於每個GPU 的規格以及將它們聯繫在一起的網絡都是獨一無二的——這些元素必須在第一次訓練開始之前提前設定好,而且也不能跨系統移植。

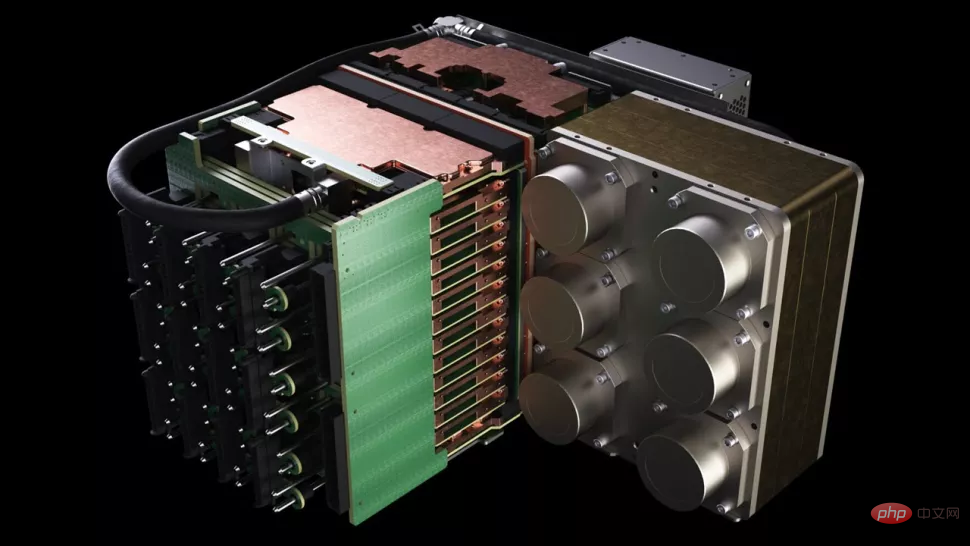

Cerebras 的CS-2 是一個獨立的超級運算集群,其中包括Wafer Scale Engine-2 晶片,所有相關的電源、記憶體和儲存子系統。

200 億的參數量大概是什麼等級?在人工智慧領域裡,大規模預訓練模型是最近各家科技公司和機構正在努力發展的方向,OpenAI 的GPT-3 是一種NLP 模型,它可以寫出足以欺騙人類讀者的整篇文章、做數學運算和翻譯,其具有驚人的1750 億個參數。 DeepMind 的 Gopher 於去年底推出,將參數量的紀錄提高到 2800 億。

最近一段時間,Google大腦甚至宣布訓練了一個超過兆參數的模型 Switch Transformer。

「在NLP 領域中,體積更大的模型被證明效果更好。但傳統上,只有極少數公司擁有足夠的資源和專業知識來完成分解這些大型模型,將其分散到數百或數千個圖形處理單元的艱苦工作,」Cerebras 執行長、聯合創始人Andrew Feldman 說。 「因此只有極少數公司可以訓練大型NLP 模型——這對於行業的其他人來說太昂貴、太耗時且無法使用。」

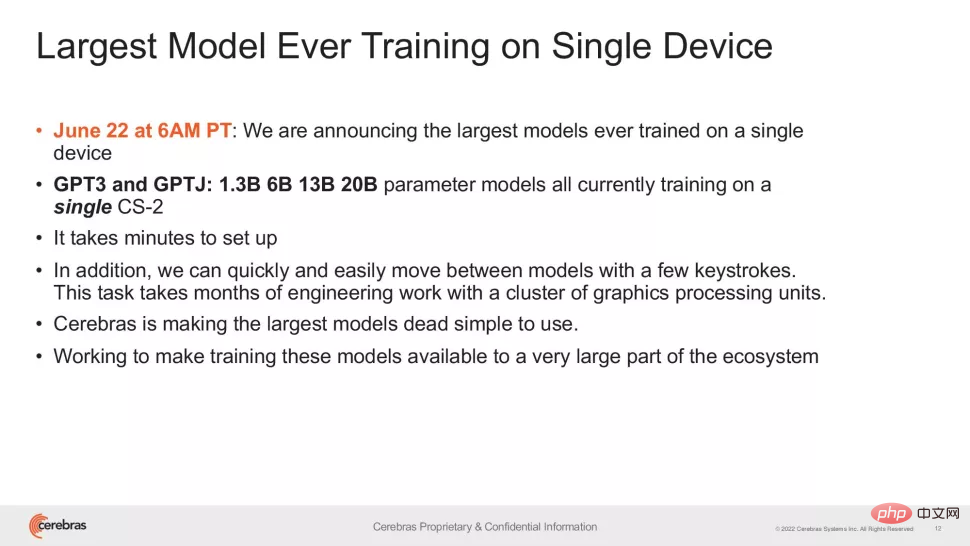

現在,Cerebras 的方法能夠降低GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B 和GPT-NeoX 20B 模型的應用門檻,使整個AI 生態系統能夠在幾分鐘內建立大型模型,並在單一CS-2 系統上訓練它們。

然而,就像旗艦級CPU 的時脈速度一樣,參數量只是大模型效能的其中一項指標。最近,一些研究在減少參數的前提下已經取得了更好的結果,例如 DeepMind 今年 4 月提出的 Chinchilla,只用 700 億個參數就在常規情況下超過了 GPT-3 和 Gopher。

這類研究的目標當然是更聰明的工作,而不是更努力地工作。因此Cerebras 的成就比人們第一眼看到的更為重要——該研究讓我們相信現有的晶片製程水平能夠適應日益複雜的模型,該公司表示,以特殊晶片為核心的系統具備了支撐「數千億甚至數萬億參數”模型的能力。

在單晶片上可訓練參數量的爆炸性成長需要依賴 Cerebras 的 Weight Streaming 技術。該技術可以將計算和記憶體佔用分離,根據 AI 工作負載中快速增長的參數量,允許記憶體進行任意量級的擴展。這使得設定時間從幾個月減少到幾分鐘,並且可以在 GPT-J 和 GPT-Neo 等型號之間切換。正如研究者所說:「只需要敲幾次鍵盤。」

「Cerebras 以低成本、便捷的方式向人們提供了運行大型語言模型的能力,開啟了人工智慧令人興奮的新時代。它為那些無法花費數千萬美元的組織提供了一個簡單而廉價的,參與到大模型競爭之中的方式,」Intersect360 研究公司的首席研究官Dan Olds 說道。 「當 CS-2 客戶在大量資料集上訓練 GPT-3 和 GPT-J 級模型時,我們非常期待 CS-2 客戶的新應用和新發現。」

#以上是單機訓練200億參數大模型:Cerebras打破新紀錄的詳細內容。更多資訊請關注PHP中文網其他相關文章!