人類沒有足夠的高品質語料給AI學了,2026年就用盡,網友:大型人類文本生成計畫啟動!

- PHPz轉載

- 2023-04-16 17:49:031439瀏覽

AI胃口太大,人類的語料數據已經不夠吃了。

來自Epoch團隊的一篇新論文表明,AI不出5年就會把所有高品質語料用光。

要知道,這可是把人類語言資料成長率考慮在內預測出的結果,換而言之,這幾年人類新寫的論文、新編的程式碼,就算全都餵給AI也不夠。

照這麼發展下去,依賴高品質資料提升水準的語言大模型,很快就要迎來瓶頸。

已經有網友坐不住了:

這太荒謬了。人類無需閱讀網路所有內容,就能高效訓練自己。

我們需要更好的模型,而不是更多的數據。

還有網友調侃,都這樣瞭不如讓AI吃自己吐的東西:

可以把AI自己生成的文本當成低品質數據餵給AI。

讓我們來看看,人類剩餘的資料還有多少?

文字和圖像資料「存貨」如何?

論文主要針對文字和圖像兩類資料進行了預測。

首先是文字資料。

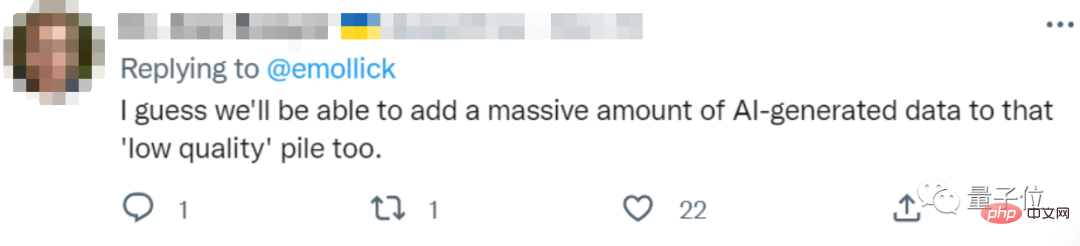

數據的品質通常有好有壞,作者們根據現有大模型採用的資料類型、以及其他數據,將可用文字資料分成了低品質和高品質兩部分。

高品質語料,參考了Pile、PaLM和MassiveText等大型語言模型所使用的訓練資料集,包括維基百科、新聞、GitHub上的程式碼、出版書籍等。

低品質語料,則來自Reddit等社群媒體上的推文、以及非官方創作的同人小說(fanfic)等。

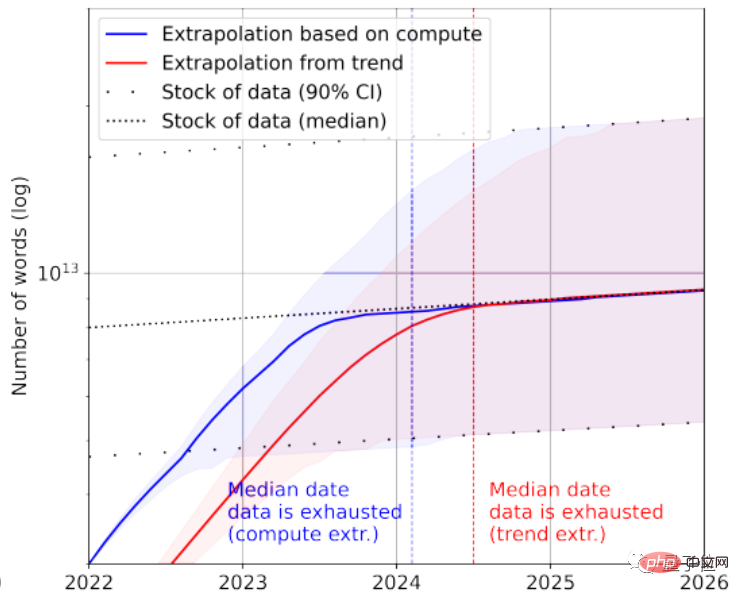

根據統計,高品質語言資料存量只剩下約4.6×10^12~1.7×10^13個單詞,相較於目前最大的文字資料集大了不到一個數量級。

結合成長率,論文預測高品質文本資料會在2023~2027年間被AI耗盡,預估節點在2026年左右。

看起來實在有點快…

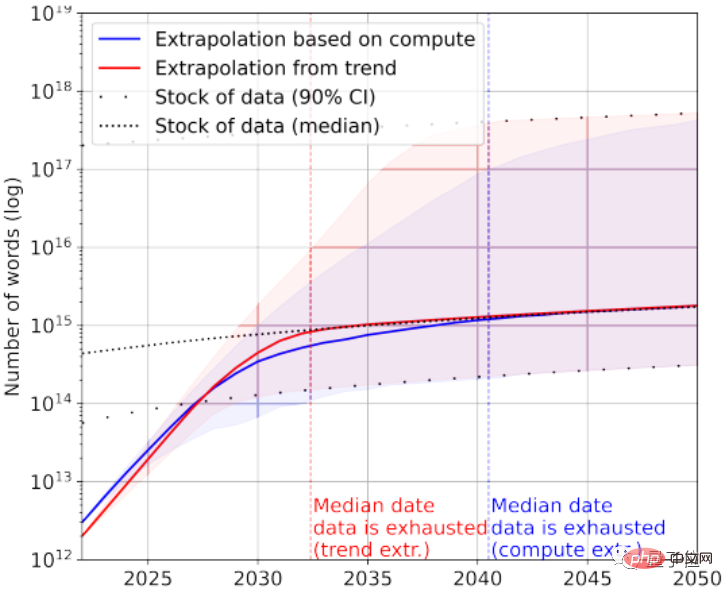

當然,可以再加上低品質文字資料來救急。根據統計,目前文字資料整體存量還剩下7×10^13~7×10^16個單詞,比最大的資料集大1.5~4.5個數量級。

如果對資料品質要求不高,那麼AI會在2030年~2050年之間才用完所有文字資料。

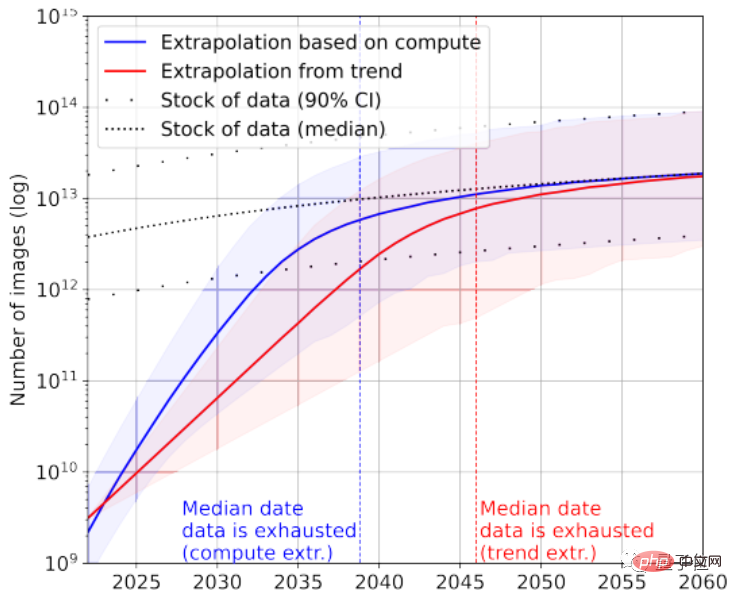

再看看圖像數據,這裡論文沒有區分圖像品質。

目前最大的影像資料集擁有3×10^9張圖片。

根據統計,目前圖片總量約有8.11×10^12~2.3×10^13張,比最大的影像資料集大出3~4個數量級。

論文預測AI會在2030~2070年間用完這些圖片。

顯然,大語言模型比圖像模型面臨更緊張的「缺少資料」情況。

那麼這結論是如何得出的呢?

計算網民日均發文量得出

論文從兩個角度,分別對文字影像資料產生效率、以及訓練資料集成長情況進行了分析。

值得注意的是,論文統計的不都是標註數據,考慮到無監督學習比較火熱,把未標註數據也算進去了。

以文字資料為例,大部分資料會從社群平台、部落格和論壇產生。

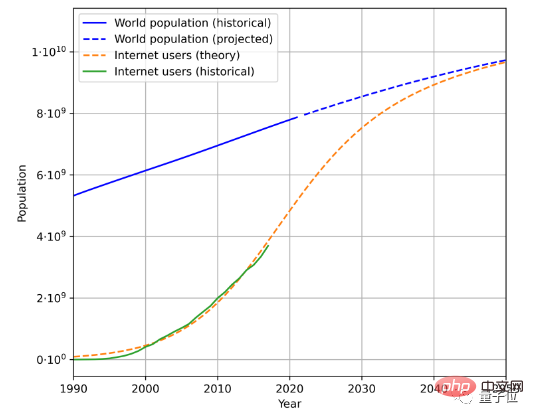

為了估計文字資料產生速度,有三個因素需要考慮,即總人口、網路普及率和網路使用者平均產生資料量。

例如,這是根據歷史人口資料和網路使用者數量,估計得到的未來人口和網路使用者成長趨勢:

再結合使用者產生的平均資料量,就能計算出生成資料的速率。 (由於地理和時間變化複雜,論文簡化了用戶平均生成數據量計算方法)

根據此方法,計算得出語言數據增長率在7%左右,然而這一增長率會隨著時間延長逐漸下降。

預計到2100年,我們的語言資料成長率會降低到1%。

同樣類似的方法分析影像數據,目前成長率在8%左右,然而到2100年影像數據成長率同樣會放緩至1%左右。

論文認為,如果資料成長率沒有大幅提升、或出現新的資料來源,無論是靠高品質資料訓練的圖像或文字大模型,都可能在某個階段迎來瓶頸期。

對此有網友調侃,未來或許會有像科幻故事情節一樣的事情發生:

人類為了訓練AI,啟動大型文本生成項目,大家為了AI拼命寫東西。

他稱之為一種「對AI的教育」:

我們每年給AI14萬到260萬單詞量的文字數據,聽起來似乎比人類當電池更酷?

你覺得呢?

論文網址:https://arxiv.org/abs/2211.04325

參考連結:https://twitter.com/emollick/status/1605756428941246466

#以上是人類沒有足夠的高品質語料給AI學了,2026年就用盡,網友:大型人類文本生成計畫啟動!的詳細內容。更多資訊請關注PHP中文網其他相關文章!