一顆GPU,秒出3D模型! OpenAI重磅新作:Point-E用文字即可產生三維點雲模型

- WBOY轉載

- 2023-04-15 08:58:02872瀏覽

席捲AI世界的下一個突破在哪裡?

很多人預測,就是3D模型產生器。

繼年初推出的DALL-E 2用天才畫筆驚艷所有人之後,週二OpenAI發布了最新的圖像生成模型“POINT-E”,它可通過文本直接生成3D模型。

論文連結:https://arxiv.org/pdf/2212.08751.pdf

相比競爭對手們(如Google的DreamFusion)需要幾個GPU工作數小時,POINT-E只需單一GPU便可在幾分鐘內產生3D影像。

經小編實戰測試,Prompt輸入後POINT-E基本上可以秒出3D影像,此外輸出影像也支援自訂編輯、儲存等功能。

#網址:https://huggingface.co/spaces/openai/point-e

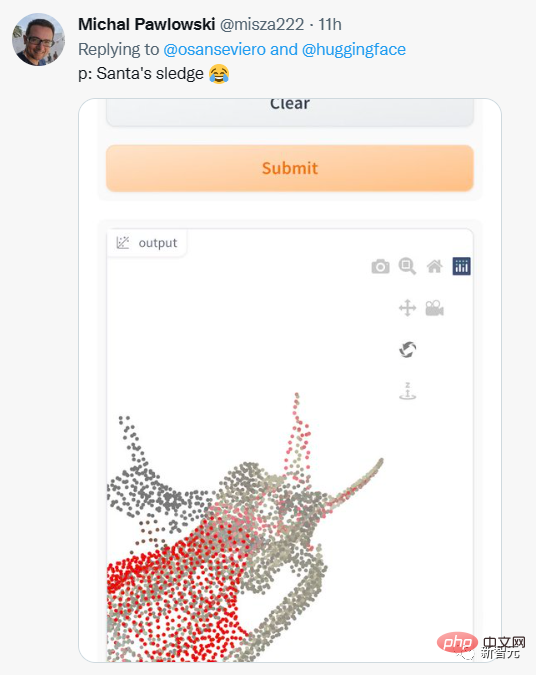

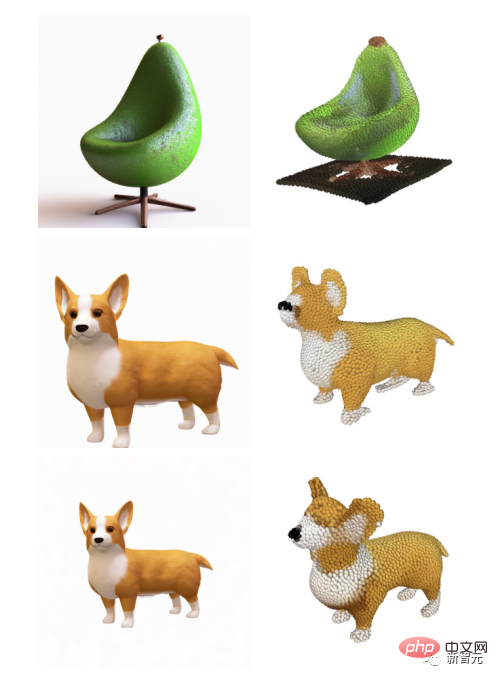

網友也開始嘗試不同的prompt輸入。

但輸出的結果並不都令人滿意。

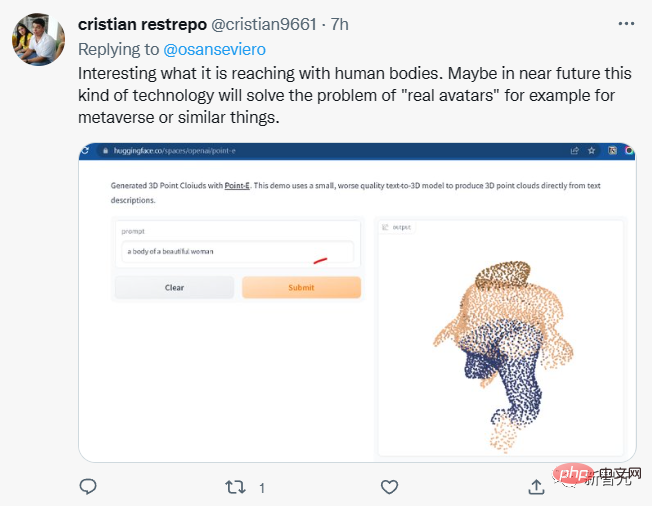

還有網友表示,POINT-E或許可以實現Meta的元宇宙願景?

要注意的是,POINT-E是透過點雲(point cloud),也就是空間中點的資料集來產生3D影像。

簡單來說,就是透過三維模型進行資料擷取以取得空間中代表3D形狀的點雲資料。

從運算的角度來看,點雲更容易合成,但它們無法捕捉物件的細膩形狀或紋理,這是目前Point- E的一個短板。

為解決這個限制,Point-E團隊訓練了一個額外的人工智慧系統來將Point-E 的點雲轉換為網格。

將Point-E點雲轉換為網格

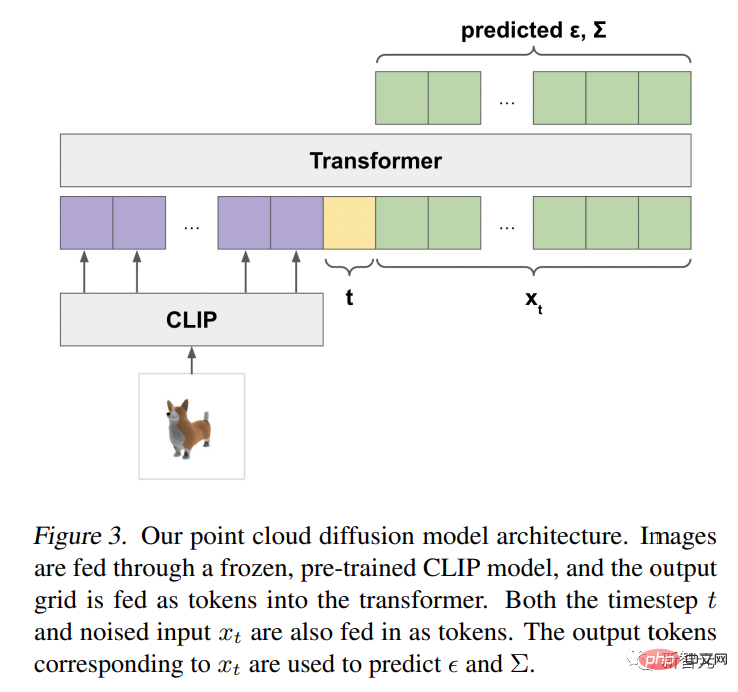

在獨立的網格生成模型之外,Point-E 由兩個模型組成:

一個文字圖像轉換模型(text-to-image model)和圖像轉換3D模型(image -to-3D model)。

文字影像轉換模型類似OpenAI的DALL-E 2和Stable Diffusion,在標記影像上進行訓練以理解單字和視覺概念間的關聯。

然後,將一組與3D物件配對影像輸入3D轉換模型,以便模型學會在兩者之間有效轉換。

當輸入prompt時,文字影像轉換模型會產生一個合成渲染對象,該物件被饋送到影像轉換3D模型,然後產生點雲。

OpenAI研究人員表示,Point-E經歷了數百萬3D物件和相關元資料的資料集的訓練。

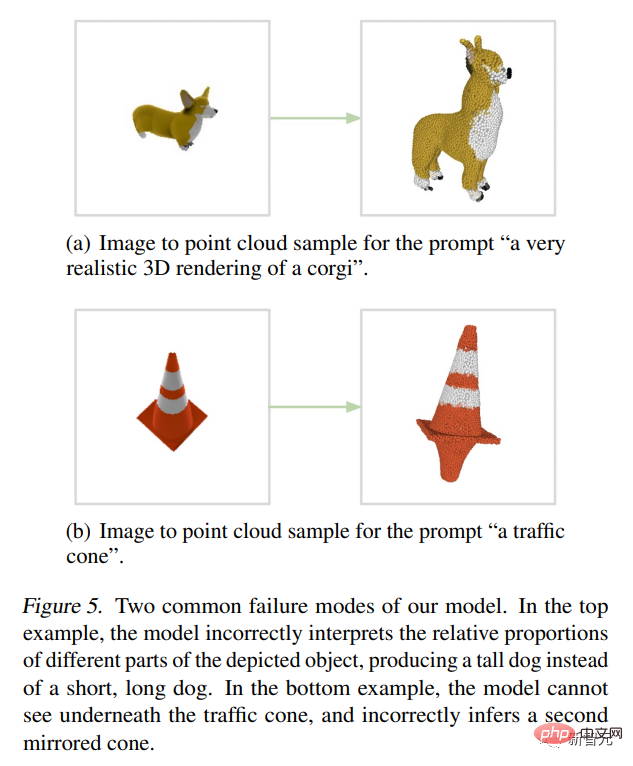

但它並不完美,Point-E 的圖像到 3D 模型有時無法理解文字到圖像模型中的圖像,導致形狀與文字提示不匹配。儘管如此,它仍然比以前的最先進技術快幾個數量級。

他們在論文中寫道:

雖然我們的方法在評估中的表現比最先進的技術差,但它只花了一小部分時間就可以產生樣本。這可以使它對某些應用程式更實用,並且發現更高品質的3D物件。

Point-E架構與運行機制

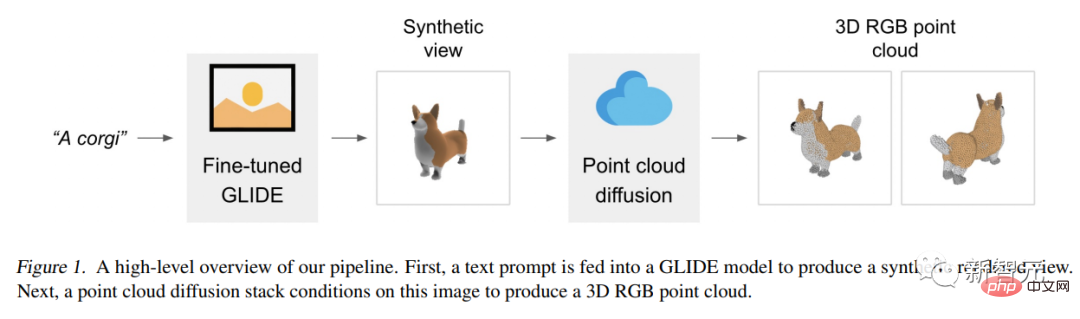

Point-E模型首先使用文字到圖像的擴散模型產生單一的合成視圖,然後使用第二個擴散模型產生一個三維點雲,該模型以產生的圖像為條件。

雖然該方法在取樣品質方面仍未達到最先進的水平,但它的取樣速度要快一到兩個數量級,為一些使用情況提供了實際的權衡。

下圖是該模型的一個high-level的pipeline示意圖:

##我們不是訓練單一生成模型,直接產生以文字為條件的點雲,而是將生成過程分為三個步驟。

首先,產生一個以文字標題為條件的綜合視圖。

接下來,產生⼀個基於合成視圖的粗略點雲(1,024 個點) 。

最後, 產生了⼀個以低解析度點雲和合成視圖為條件的精細點雲(4,096 個點)。

在數百萬個3D模型上訓練模型後,我們發現資料集的資料格式和品質差異很大,這促使我們開發各種後處理步驟,以確保更高的數據品質。

為了將所有的資料轉換為⼀種通用格式,我們使用Blender從20個隨機攝影機角度,將每個3D模型渲染為RGBAD影像(Blender支援多種3D格式,並附有優化的渲染引擎)。

對於每個模型,Blender腳本都將模型標準化為邊界立方體,配置標準照明設置,最後使用Blender的內建即時渲染引擎,匯出RGBAD影像。

然後,使用渲染將每個物件轉換為彩色點雲。首先,透過計算每個RGBAD影像中每個像素的點,來為每個物件建構⼀個密集點雲。這些點雲通常包含數十萬個不均勻分佈的點,因此我們也使用最遠點取樣,來建立均勻的4K點雲。

透過直接從渲染建立點雲,我們能夠避免直接從3D網格中採樣可能出現的各種問題,對模型中包含的點進行取樣,或處理以不尋常的文件格式儲存的三維模型。

最後,我們採用各種啟發式方法,來減少資料集中低品質模型的頻率。

首先,我們透過計算每個點雲的SVD來消除平面對象,只保留那些最小奇異值高於某個閾值的對象。

接下來,我們透過CLIP特徵對資料集進行聚類(對於每個對象,我們對所有渲染的特徵進行平均)。

我們發現,有些群集包含許多低品質的模型類別,而其他群集則顯得更加多樣化或可解釋。

我們將這些群集分到幾個不同品質的bucket中,並使用所得bucket的加權混合作為我們的最終資料集。

應用前景

OpenAI 研究人員指出,Point-E的點雲還可用於製造真實世界的物體,例如3D列印。

透過額外的網格轉換模型,該系統還可以進入遊戲和動畫開發工作流程。

雖然目前的目光都集中在2D藝術生成器上,但模型合成人工智慧可能是下一個重大的產業顛覆者。

3D模型廣泛應用於影視、室內設計、建築和各種科學領域。

當下3D模型的製造耗時通常需要幾個小時,而Point-E的出現正好彌補了這個缺點。

研究人員表示現階段Point-E還存在許多缺陷,例如從訓練資料中繼承的偏差以及對於可能用於創建危險物體的模型缺乏保護措施。

Point-E只是個起點,他們希望它能激發文本到3D合成領域的「進一步工作」。

以上是一顆GPU,秒出3D模型! OpenAI重磅新作:Point-E用文字即可產生三維點雲模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!