從單一自然影像學習擴散模型,優於GAN,SinDiffusion實現新SOTA

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-14 18:10:071694瀏覽

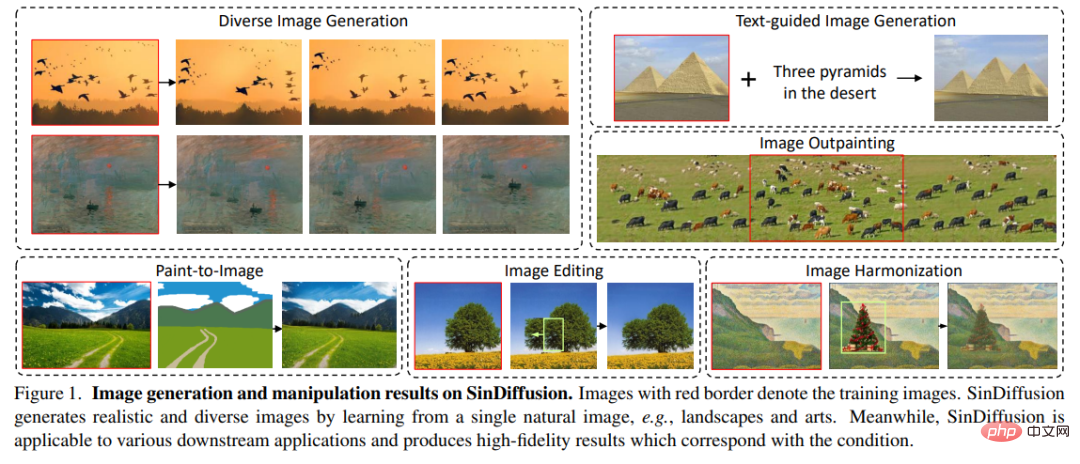

從單一自然影像產生影像的技術被廣為應用,也因此受到越來越多的關注。這項研究旨在從單幅自然圖像中學習一個無條件生成模型,透過捕捉 patch 內部統計訊息,產生具有相似視覺內容的不同樣本。一旦訓練完成,模型不僅可以產生高品質且不限解析度的影像,還可以輕鬆適應多種應用,如影像編輯、影像和諧化(image harmonization)和影像間的轉換。

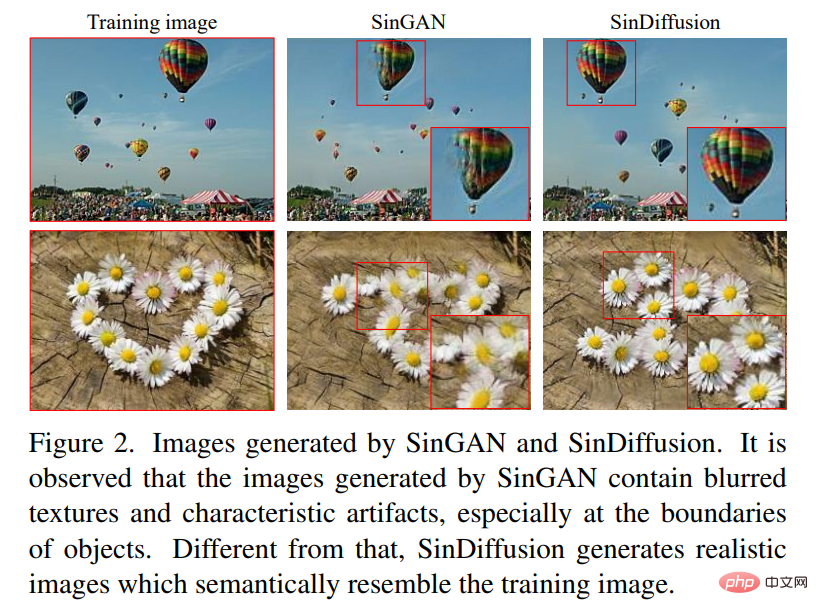

SinGAN 可以滿足上述要求,該方法可以建立自然影像的多個尺度,並訓練一系列 GANs 來學習單幅影像中 patch 的內部統計資料。 SinGAN 的核心思想是在漸進成長的尺度上訓練多個模型。然而,透過這些方法產生的圖像可能不盡人意,因為它們存在小範圍的細節性誤差,從而導致生成的圖像中存在明顯的偽影現象(見圖 2)。

在本文中,來自中國科學技術大學、微軟亞洲研究院等機構的研究者提出了一個新的框架-單幅影像擴散模型(SinDiffusion,Single-image Diffusion),以用於從單幅自然影像中學習,其是在去噪擴散機率模型(DDPM,Denoising Diffusion Probabilistic Model) 的基礎上完成的。雖然擴散模型是一個多步驟(multiple-step)生成過程,但它不存在累積誤差問題。原因是擴散模型具有系統的數學公式,中間步驟的誤差可視為幹擾,並且可以在擴散過程中得到改善。

SinDiffusion 的另一個核心設計是限制擴散模型的感受野。該研究回顧了先前擴散模型[7] 中常用的網絡結構,發現它具有較強的性能和較深的結構。不過此網路結構具有的感受野大到能夠覆蓋整個影像,這導致模型傾向於靠記憶訓練影像,從而產生與訓練影像完全相同的影像。為了鼓勵模型學習 patch 統計資料而不是記憶整個影像,研究對網路結構進行了精細設計,並引入了一個 patch-wise 去噪網路。同之前的擴散結構相比,SinDiffusion 減少了原去噪網路結構中的下取樣次數和 ResBlock 數量。如此一來,SinDiffusion 可以從單幅自然圖像中學習,並且產生高品質且多樣化的圖像(見圖 2)。

- #論文網址:https://arxiv.org/pdf/2211.12445.pdf

- 專案網址:https://github.com/WeilunWang/SinDiffusion

#SinDiffusion 的優點在於,它能靈活運用於各種場景(見圖1)。它可以用於各種應用,而無需對模型進行任何重新訓練。在 SinGAN 中,下游應用主要透過將條件輸入預先訓練的不同尺度的 GANs 來實現。因此,SinGAN 的應用僅限於那些給定的空間對齊(spatiallyaligned)條件。與之不同的是,SinDiffusion 透過設計採樣程序可用於更廣泛的應用。 SinDiffusion 透過無條件訓練學習預測資料分佈的梯度。假設有一個描述生成圖像與條件之間相關性的評分函數(即 L−p 距離或一個預訓練網絡,如 CLIP),該研究利用相關性評分的梯度來指導 SinDiffusion 的採樣過程。透過這種方式,SinDiffusion 能夠產生既符合資料分佈又和給定條件相吻合的影像。

研究對各種自然圖像進行了實驗,以此來證明提出的框架的優勢,實驗對象包括風景和著名的藝術。定量和定性結果都證實了 SinDiffusion 可以產生高保真和多樣化的結果,而下游應用進一步證明了 SinDiffusion 的實用性和靈活性。

方法

與先前研究中的漸進式成長設計不同,SinDiffusion 採用單一尺度下的單一去噪模型進行訓練,防止了誤差的累積。此外,研究發現擴散網絡 patch-level 的感受野在捕捉內部 patch 分佈方面起著重要作用,並設計了一種新的去噪網絡結構。基於這兩個核心設計,SinDiffusion 從單一自然影像產生高品質和多樣化的影像。

本節其餘部分的組織如下:首先回顧 SinGAN 並展示 SinDiffusion 的動機,然後介紹了 SinDiffusion 的結構設計。

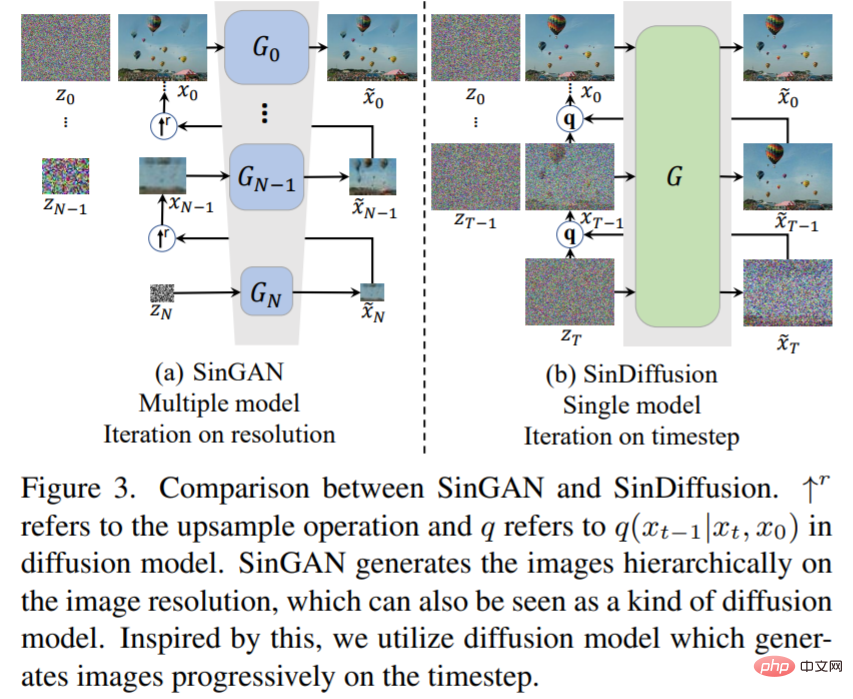

首先簡單回顧 SinGAN。圖 3(a)給出了 SinGAN 的生成過程。為了從單一影像產生不同的影像,SinGAN 的關鍵設計是建立影像金字塔,並逐步成長生成的影像的解析度。

圖 3(b)為 SinDiffusion 新框架。與 SinGAN 不同的是,SinDiffusion 在單一尺度上使用單一去噪網路執行多步驟生成過程。雖然 SinDiffusion 也採用了像 SinGAN 一樣的多步驟生成過程,但是生成的結果是高品質的。這是因為擴散模型建立在數學方程式的系統推導的基礎上,中間步驟產生的誤差在擴散過程中被反覆細化為雜訊。

SinDiffusion

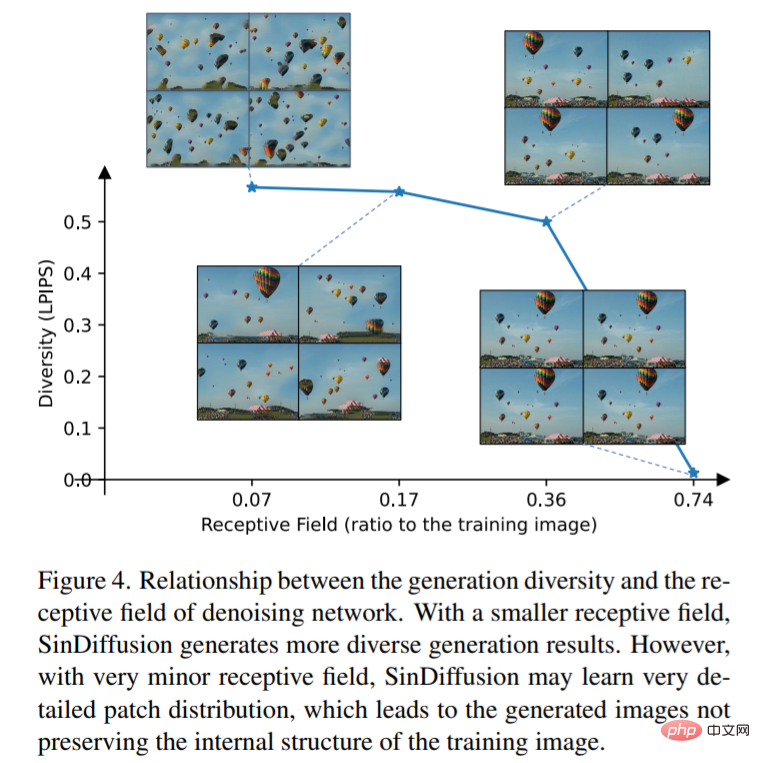

#本文研究了生成多樣性與去噪網絡感受野的關係-修改去噪網絡的網絡結構可以改變感受野,並且設計了四種感受野不同但性能相當的網絡結構,在單幅自然圖像上訓練這些模型。圖 4 顯示了不同感受野下模型產生的結果。可以觀察到,感受野越小,SinDiffusion 產生的生成結果越多樣化,反之亦然。然而,研究發現極小的感受野模型並不能維持影像的合理結構。因此,合適的感受野對於獲取合理的 patch 統計資料是重要且必要的。

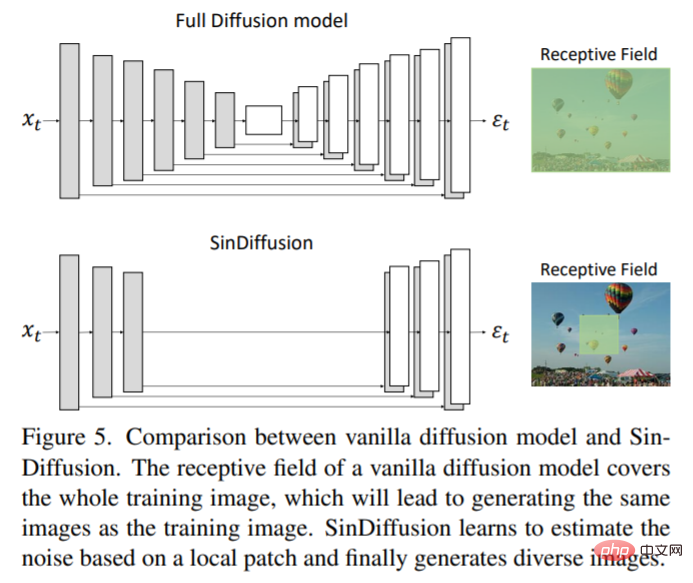

該研究重新設計了常用的擴散模型,並引入了用於單一影像生成的patch-wise去噪網路。圖 5 是 SinDiffusion 中 patch-wise 去噪網絡的概述,並且展現了與先前去噪網絡的主要差異。首先,透過減少下取樣和上取樣操作來減少去噪網路的深度,從而大大擴展了感受野。同時,去噪網絡中原本使用的深層注意力層被自然去除,使 SinDiffusion 成為一個完全卷積的網絡,適用於任意分辨率的生成。其次,透過減少每個解析度中嵌入時間的 resblock,進一步限制 SinDiffusion 的感受野。用這種方法得到一個有適當感受野的 patch-wise 去噪網絡,得到了逼真且多樣的結果。

#實驗

#SinDiffusion 隨機產生影像的定性結果如圖 6 所示。

可以發現,在不同的解析度下,SinDiffusion 可以產生與訓練影像具有相似模式的真實影像。

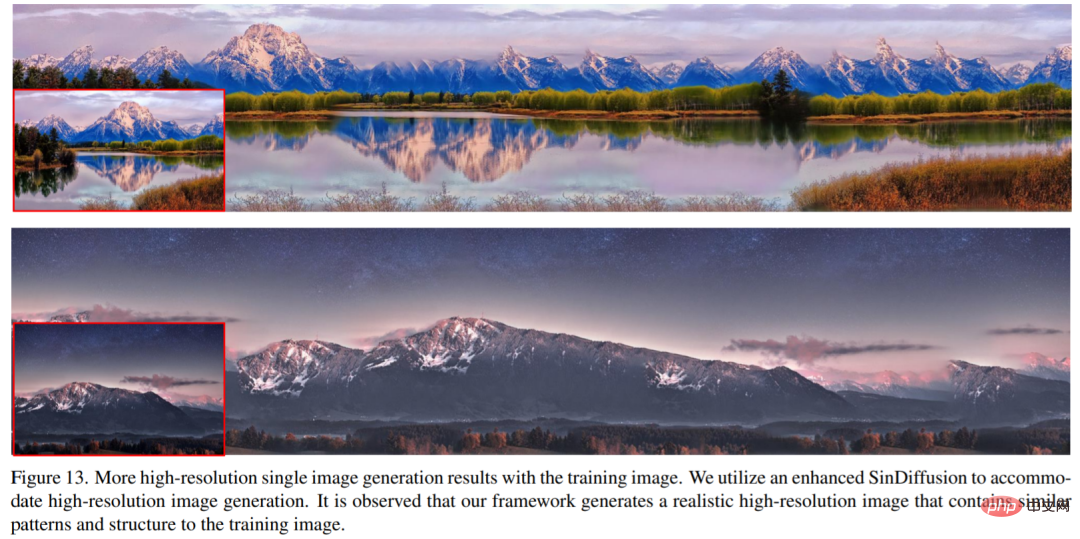

此外,本文也研究如何從單一影像產生高解析度影像的 SinDiffusion。圖 13 展示了訓練影像和產生的結果。訓練影像是一個 486 × 741 解析度的景觀影像,包含了豐富的組件,如雲、山、草、花和一個湖。為了適應高解析度的影像生成,SinDiffusion 已升級到增強版本,該版本具有更大的感受野和網路能力。增強版的 SinDiffusion 產生了一個 486×2048 解析度的高解析度長滾動影像,其產生效果結果保持訓練影像的內部佈局不變,且歸納出了新的內容,見圖 13。

對比以往的方法

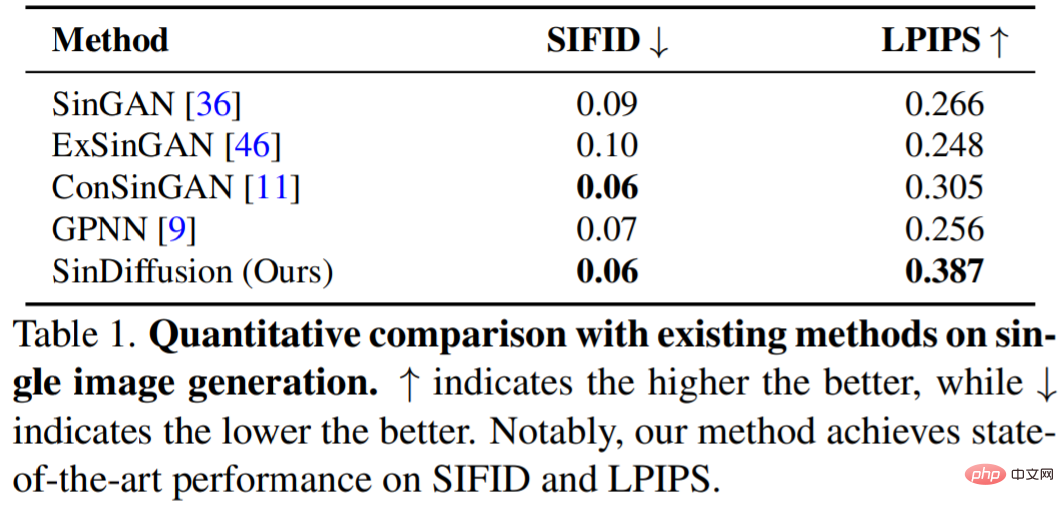

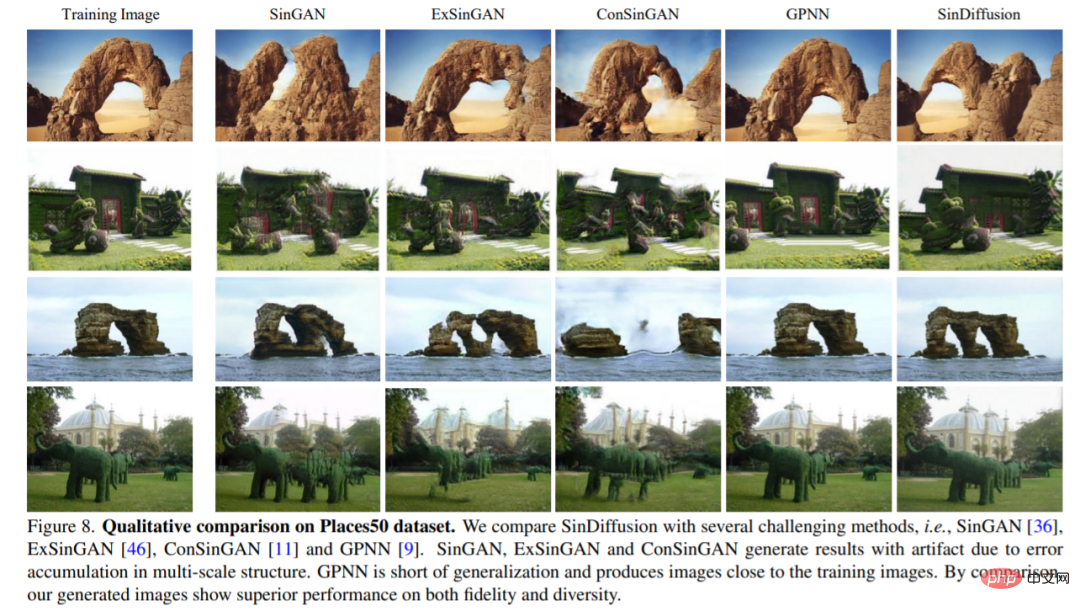

#表1 展示了SinDiffusion 與幾個具有挑戰性的方法(即SinGAN, ExSinGAN, ConSinGAN 和GPNN)相比產生的定量結果。與之前基於 GAN 的方法相比,SinDiffusion 在經過逐步改進後,達到了 SOTA 性能。值得一提,本文的研究方法大大提高了生成影像的多樣性,在Places50 資料集上訓練的50 個模型的平均值上,本文的方法以0.082 LPIPS 的評分超過了目前最具挑戰性的方法。

除了定量結果之外,圖 8 也展示了 Places50 資料集上的定性結果。

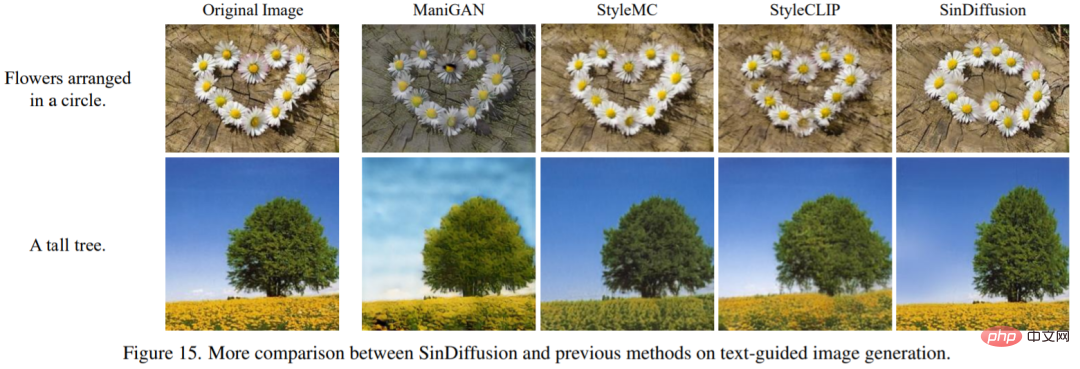

圖 15 給出了 SinDiffusion 和先前方法的文字引導圖像生成結果。

更多內容請查看原始論文。

以上是從單一自然影像學習擴散模型,優於GAN,SinDiffusion實現新SOTA的詳細內容。更多資訊請關注PHP中文網其他相關文章!