AI繪畫侵權實錘!擴散模型可能會記住你的照片,現有隱私保護方法全部失效

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-12 22:16:011996瀏覽

本文經AI新媒體量子位元(公眾號ID:QbitAI)授權轉載,轉載請聯絡來源。

AI繪畫侵權,實錘了!

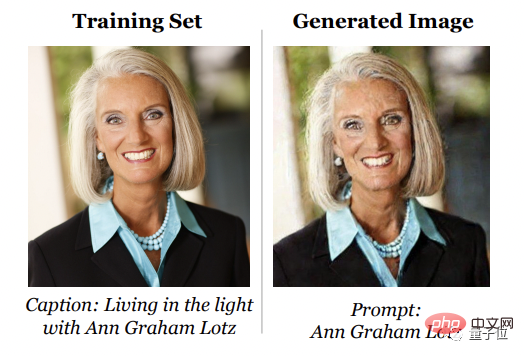

最新研究表明,擴散模型會牢牢記住訓練集中的樣本,並在生成時「依葫蘆畫瓢」。

也就是說,像Stable Diffusion生成的AI畫作裡,每一筆背後都可能隱藏著一次侵權事件。

不僅如此,經過研究對比,擴散模型從訓練樣本中「抄襲」的能力是GAN的2倍,產生效果越好的擴散模型,記住訓練樣本的能力越強。

這項研究來自Google、DeepMind和UC伯克利組成的團隊。

論文中還有另一個糟糕的消息,那就是針對這個現象,現有的隱私保護方法全部失效。

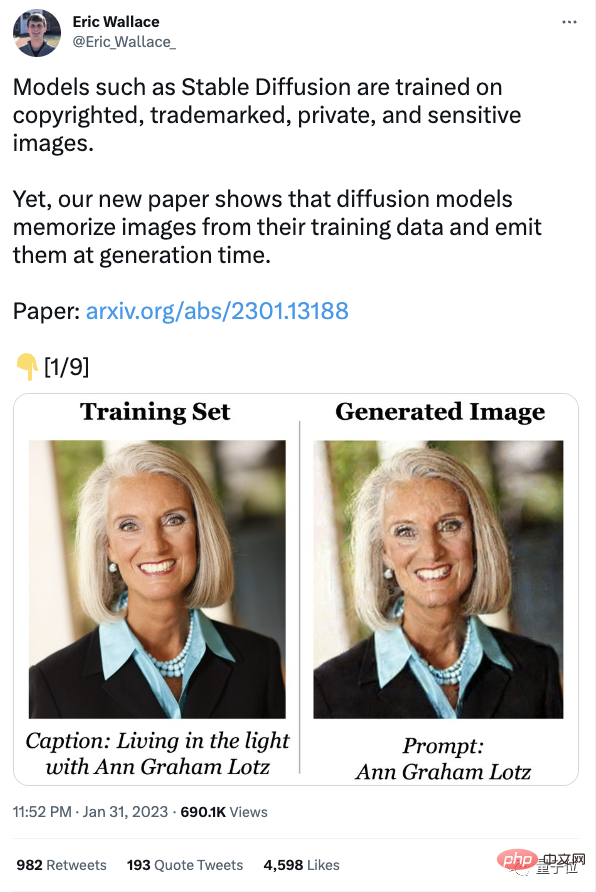

訊息一出,網友炸開了鍋,論文作者的相關推特轉發眼看就要破千。

有人感慨:原來說它們竊取他人版權成果是有道理的!

支持訴訟!告他們!

有人站在擴散模型一側說話:

#也有網友將論文結果延伸到當下最火的ChatGPT上:

現有隱私保護方法全部失效

擴散模型的原理是去噪再還原,所以研究者要研究事情其實就是:

它們到底有沒有記得用來訓練的影像,最後在生成時進行「抄襲」?

訓練集裡的圖像往往從網路大海中撈取,有版權的、有商標的,有的還有隱私性,例如私人的醫療X光片什麼的。

為了弄清楚擴散模型到底能不能記憶與再生個體訓練樣本,研究者首先提出了「記憶」的新定義。

一般來說,關於記憶的定義集中在文本語言模型上,如果可以提示模型從訓練集中恢復一個逐字序列,就表示這個序列被提取和記憶了。

與之不同,研究團隊基於影像相似度來定義「記憶」#。

不過團隊也坦白講,對於「記憶」的定義是偏向保守的。

舉個例子,左圖是用Stable Diffusion生成的一張“奧巴馬的照片”,這張照片和右圖任何一張特定訓練圖像都不神似,因此這個圖像不能算作根據記憶生成。

但這並不表示Stable Difusion產生新的可辨識圖片的能力不會侵害著作權和隱私。

接著,他們提取了包含個人照片、公司招標在內的1000多個訓練樣本,然後設計了一個兩階段的資料擷取(data extraction attack)。

具體操作是使用標準方法產生圖像,然後標記那些超過人工推理評分標準的圖像。

在Stable Diffusion和Imagen上應用此方法,團隊提取了超過100個近似或相同的訓練影像副本。

既有可識別出的個人照片,也有商標標識,經過查驗,大部分都是有版權的。

而後,為了更好地理解「記憶」是怎麼發生的,研究人員從模型中採樣100萬次,在CIFAR-10上訓練了幾百個擴散模型。

目的是分析模型準確性、超參數、增強和重複資料刪除中,哪些行為會對隱私性產生影響。

最終得出如下結論:

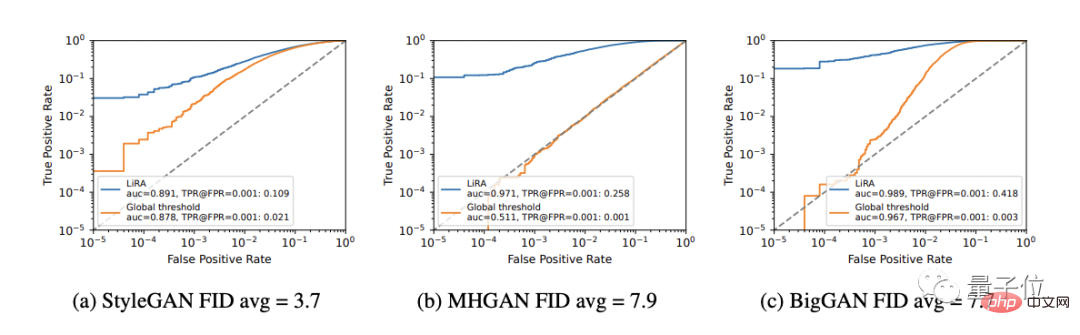

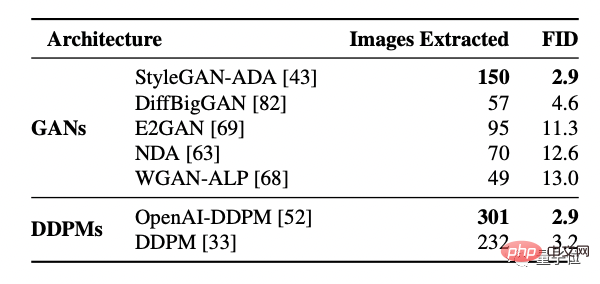

#首先,擴散模型比GAN記憶更多。

但擴散模型也是評估的圖像模型中隱私性最差的一群,它們洩漏的訓練資料是GANs的兩倍多。

而且,更大的模型可能會記住更多的資料。

隨著這個結論,研究人員也研究了20億參數的文字-圖像擴散模型Imagen,他們嘗試提取500張分佈外得分最高的圖像,讓它們作為訓練資料集中的樣本,發現都被記憶了。

相較之下,同樣的方法應用在Stable Difusion上,沒有辨識出任何記憶行為。

因此,在複製和非複製影像上,Imagen比Stable Difusion隱私性更差,研究人員把原因歸結於Imagen使用的模型比Stable Difusion容量大,因此記得的影像越多。

此外,更好的生成模型(FID值更低)儲存的資料更多。

換句話說,隨著時間的推移,同一個模型洩漏的隱私更多,侵犯的版權也更多。

(依FID排序的GAN模型,FID值越低,效果越好)

透過訓練模型,團隊發現增加效用會降低隱私性,簡單的防禦措施(如重複資料刪除)不足以完全解決記憶打擊。

因此,隱私增強技術並不能提供一個可接受的隱私-效用權衡。

最終,團隊對訓練擴散模型的人提出了四個建議:

- 建議將訓練資料集的重複資料刪除,並盡量減少過度訓練;

- 建議將訓練資料集的重複資料刪除,並盡量減少過度訓練;

- 建議使用資料擷取或其他稽核技術來評估訓練模型的隱私風險;

- 如果有更實用的隱私保護技術,建議盡可能使用;

希望AI產生的圖片不會免費提供用戶涉及隱私的部分。

版權方未曾停止維權研究一出,可能對正在進行的訴訟產生影響。

剛過去的1月底,圖庫老大哥蓋蒂圖片社(Getty Images) 以侵犯版權的名義,在倫敦高等法院起訴了Stability AI。

以侵犯版權的名義,在倫敦高等法院起訴了Stability AI。

Stable Difussion的部分訓練資料是開源的。經過分析和查驗浮水印發現,包括蓋蒂在內的許多圖片社都不知不覺間為Stable Difussion的訓練集提供了大量素材,佔比不小。 但從始至終,Stability AI都

沒有與圖片社對接過。許多AI公司都認為這種做法受到美國合理使用原則等法律的保護,但大部分版權所用者都不同意這種說法,認為這種行為侵犯了自己的權益。 雖然Stability AI之前發表聲明,說下個版本中,版權所有者

可以在訓練圖庫中刪除自己的版權作品,但現階段仍然有人不服。 1月中旬的時候,三位藝人已經對Stability AI以及Midjourney提起訴訟。 法律專家也各執一詞,為達成統一意見,但他們紛紛同意法院需要針對版權保護問題做出裁決。 ######蓋蒂圖片社的CEO Craig Peters表示,公司已經向Stability AI發了通知,表示「你就快在英國吃官司啦」! ###公司還放話:

我們對侵權行為帶來的損失並不計較,也無意讓AI藝術工具停止開發。

把Stability AI告上法庭並不是為了我們蓋蒂一家的利益。

選擇起訴有更深層的長期目的,希望法院設定新的法律來規範現狀。

以上是AI繪畫侵權實錘!擴散模型可能會記住你的照片,現有隱私保護方法全部失效的詳細內容。更多資訊請關注PHP中文網其他相關文章!