這段音頻火爆外網!文字、圖片一鍵產生逼真音效,音界AIGC來了

- 王林轉載

- 2023-04-12 18:25:041879瀏覽

近期AIGC 如同上了熱搜一般,火熱程度居高不下,當然除了名頭格外響亮,突破也是絕對斐然:輸入自然語言就可自動生成圖像、視頻甚至是3D 模型,你說意不意外?

但在音訊音效的領域,AIGC 的福利似乎還差了一些。主要由於高自由度音訊產生需要依靠大量文字 - 音訊對數據,同時長時波形建模還有許多困難。 為了解決上述困難,浙江大學與北京大學聯合火山語音,共同提出了一款創新的、文本到音頻的生成系統,即 Make-An-Audio。其可將自然語言描述作為輸入,且是任意模態(例如文字、音訊、圖像、視訊等)均可,同時輸出符合描述的音訊音效,廣大網友很難不為其可控性以及泛化性按讚。

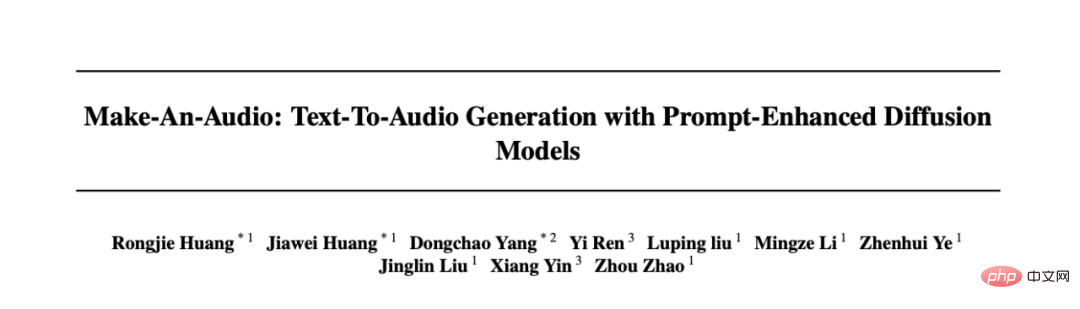

- #論文連結:https://arxiv .org/abs/2301.12661

- #專案連結:https://text-to-audio.github.io

#短短兩天,Demo 影片在Twitter 上獲得了45K 的播放量。

2023 年除夕後,以 Make-An-Audio、 MusicLM 等大量音訊合成文章湧現,48 小時內已經有 4 篇突破性的進展。

#網友評論1

廣大網友們紛紛表示,AIGC 音效合成將會改變電影、短片製作的未來。

#網友評論2

網友評論3

更有網友發出這樣的感嘆:「audio is all you need…」

網友評論4

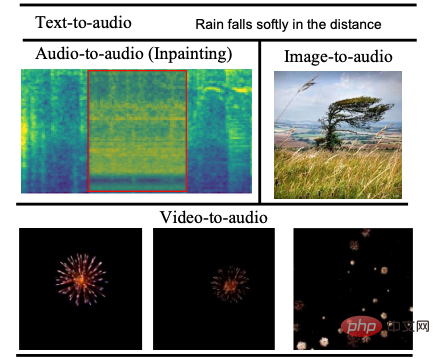

聽覺效果展示

#話不多說直接看效果,根據文字產生音效原來也可以如此便捷順暢。

文字1:a speedboat running as wind blows into a microphone

轉換音訊1音訊:00:0000:09

文字2:fireworks pop and explode

轉換音訊2音訊:00:0000:09

#是不是也曾一度因破損音訊修復而大傷腦筋? Make-An-Audio 模型一出,這事兒就變得簡單多了。

修正前

修正前音訊

修正前音訊音訊:##00:0000:09

#已修復後

修正後音訊

修正後音訊音訊:# 00:0000:09

透過理解圖片產生音效

,也不是不行。

#圖片1

#轉換音訊圖片轉換音訊音訊:

00:0000:09

圖片2轉換音訊#圖片轉換音訊2音訊:

#00:0000:09

#根據

影片內容產生對應音效

影片內容產生對應音效

影片1

轉換音訊

影片1音訊:

00:0000:09

#影片2轉換音訊

####影片2###音訊:########## #####00:0000:09############################模型內在技術原理

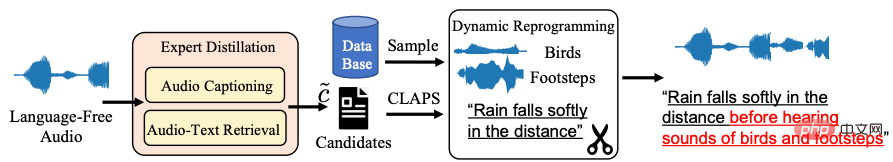

深度解析「網紅」模型的神奇內在,還要回到音訊- 自然語言對資料稀少的客觀問題上,對此浙大北大聯合火山語音團隊協同兩大高校共同提出了Distill-then-Reprogram 文字增強策略,即使用教師模型獲得音訊的自然語言描述,再透過隨機重組獲得具有動態性的訓練樣本。

具體來說,在Distill 環節中,使用音訊轉文字與音訊- 文字擷取模型,找到語言缺失(Language-Free) 音訊的自然語言描述候選(Candidate),透過計算候選文字與音訊的匹配相似度,在閾值下取得最佳結果作為音訊的描述。此方法具有強泛化性,且真實自然語言避免了測試階段的域外文本。 「在 Reprogram 環節中,團隊從額外的事件資料集中隨機取樣,並與目前訓練樣本結合,得到全新的概念組合與描述,以擴增模型對不同事件組合的穩健性。」 研究團隊表示。

#Distill-then-Reprogram 文字增強策略框架圖

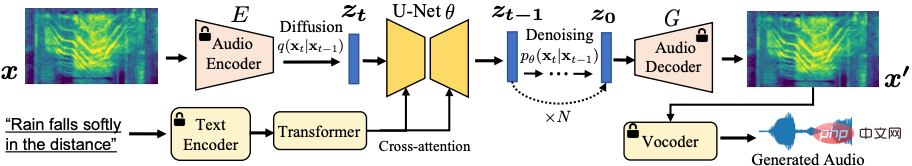

#如上圖所示,自監督學習已經成功將圖片遷移到音訊頻譜,利用了頻譜自編碼器以解決長音訊序列問題,並基於Latent Diffusion 生成模型完成對自監督表徵的預測,避免了直接預測長時波形。

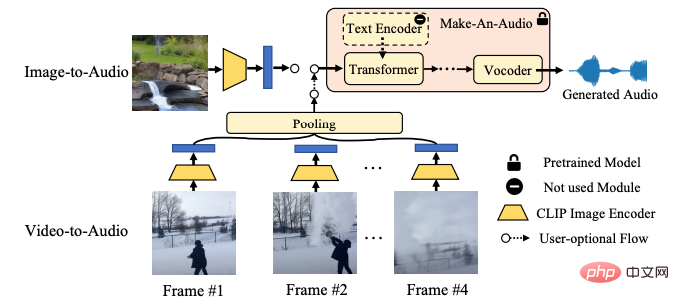

Make-An-Audio 模型系統框架圖

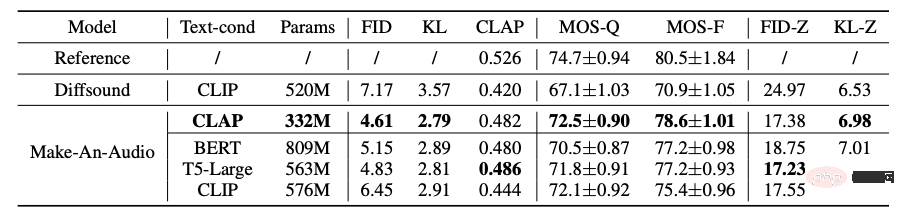

此外在研究中團隊也探索了強大的文本條件策略,包括對比式Contrastive Language-Audio Pretraining (CLAP) 以及語言模型(LLM) T5, BERT 等,驗證了CLAP 文本表徵的有效與計算友好性。同時也首次使用CLAP Score 來評估產生的音頻,可以用於衡量文字和生成場景之間的一致性;使用主、客觀相結合的評估方式,在benchmark 資料集測試中驗證了模型的有效性,展示了模型優異的零樣本學習(Zero-Shot) 泛化性等。

Make-An-Audio 與基準模型主客觀評測實驗結果

神奇模型的應用前景知多少?

總體來看,Make-An-Audio 模型實現了高品質、高可控性的音訊合成,並提出了「No Modality Left Behind」,對文字條件音訊模型進行微調( finetune),即能解鎖任意模態輸入的音訊合成(audio/image/video)。

Make-An-Audio 首次實現高可控X - 音訊的AIGC 合成,X 可以是文字/ 音訊/ 圖片/ 視訊

在視覺指導的音訊合成上,Make-An-Audio 以CLIP 文字編碼器為條件,利用其圖像- 文字聯合空間,能夠直接以影像編碼為條件合成音訊。

Make-An-Audio 視覺 - 音訊合成框架圖

可以預見的是,音頻合成AIGC 將會在未來電影配音、短視頻創作等領域發揮重要作用,而藉助Make-An-Audio 等模型,或許在未來人人都有可能成為專業的音效師,都可以憑藉文字、影片、影像在任何時間、任何地點,合成出栩栩如生的音訊、音效。但現階段Make-An-Audio 也並不是完美無缺的,可能由於豐富的資料來源以及不可避免的樣本品質問題,訓練過程中難免會產生副作用,例如生成不符合文字內容的音頻,Make-An- Audio 在技術上被定位是“輔助藝術家生成”,可以肯定的一點,AIGC 領域的進展確實令人驚訝。

火山語音,長期以來面向字節跳動各大業務線提供全球優勢的AI 語音技術能力以及全棧語音產品解決方案,包括音頻理解、音頻合成、虛擬數字人、對話互動、音樂檢索、智慧硬體等。自 2017 年成立以來,團隊專注於研發業界領先的 AI 智慧語音技術,不斷探索 AI 與業務場景的高效結合,以實現更大的用戶價值。目前其語音辨識和語音合成已經涵蓋了多種語言和方言,多篇技術論文入選各類AI 頂級會議,為抖音、剪映、飛書、番茄小說、Pico 等業務提供了領先的語音能力,並適用於短影片、直播、影片創作、辦公室以及穿戴式裝置等多樣化場景,透過火山引擎開放給外部企業。

以上是這段音頻火爆外網!文字、圖片一鍵產生逼真音效,音界AIGC來了的詳細內容。更多資訊請關注PHP中文網其他相關文章!