超大模型出現後,AI的遊戲結束了? Gary Marcus:路走窄了

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-12 11:46:061402瀏覽

最近一段時間,人工智慧技術在大模型方面有了突破性進展,昨天谷歌提出的 Imagen 再次引發了人們對於 AI 能力的討論。透過大量資料的預訓練學習,演算法已經有了前所未有的逼真影像建構和語言理解能力。

在很多人看來,我們距離通用人工智慧已經近了,不過知名學者、紐約大學教授 Gary Marcus 不是這樣想的。

近日,他的文章《The New Science of Alt Intelligence》對DeepMind 研究主任Nando de Freitas 「規模致勝」的觀點進行了反駁,讓我們看看他是怎麼說的。

以下是Gary Marcus的原文:

幾十年來,AI 領域一直存在著一個假設,即人工智慧應該從自然智慧中汲取靈感。 John McCarthy 撰寫了關於AI 為什麼需要常識的開創性論文——《Programs with Common Sense》;Marvin Minsky 寫了著名的《Society of Mind》一書,試圖從人類的思維中尋找靈感;因在行為經濟學方面的貢獻而獲得諾貝爾經濟學獎的Herb Simon 寫了著名的《Models of Thought》,旨在解釋“新開發的計算機語言如何表達心理過程理論,以便計算機能夠模擬預測的人類行為。”

據我所知,目前很大一部分AI 研究人員(至少是那些比較有影響力的研究人員)根本不在乎這些。相反,他們將更多精力放在了一個被我稱為“Alt Intelligence”(替代智能)的方向上(感謝 Naveen Rao 對這個術語的貢獻)。

Alt Intelligence 不是指建構出能夠以人類智慧的方式解決問題的機器,而是利用從人類行為中獲得的大量資料來取代智慧。目前,Alt Intelligence 的主要工作是規模化。這種系統的擁護者認為,系統越大,我們就越接近真正的智能,甚至意識。

研究 Alt Intelligence 本身並沒有什麼新鮮的,但與之相關的傲慢卻非常新鮮。

有一段時間,我看到了一些跡象,當前的人工智慧超級明星,甚至整個人工智慧領域的大部分人,對人類認知不屑一顧,忽視甚至嘲笑語言學、認知心理學、人類學和哲學等領域的學者。

但今天早上,我發現了一條關於 Alt Intelligence 的新推文。推文作者、DeepMind 研究主任 Nando de Freitas 宣稱,AI「現在完全取決於規模」。事實上,在他看來(也許是故意用激烈的言辭來挑釁),AI 領域更困難的挑戰已經解決了。 「遊戲結束了!」他說。

從本質上來說,追尋 Alt Intelligence 並沒有錯。

Alt Intelligence 代表了一種關於如何建立智慧系統的直覺(或一系列直覺)。由於還沒有人知道如何建立可以媲美人類智慧的靈活性和智慧的系統,因此對於人們來說,追求關於如何實現這一點的多種不同假設是一場公平的遊戲。 Nando de Freitas 盡可能直白地為這個假設辯護,我稱它為 Scaling-Uber-Alles(規模大於一切)。

當然,這個名字並不完全公平。 De Freitas 非常清楚,你不能指望只把模型做大就能取得成功。人們最近做了大量的擴展,並取得了一些巨大的成功,但也遇到了一些障礙。在深入探討 De Freitas 如何面對現狀之前,讓我們先來看看現狀是如何的。

現況

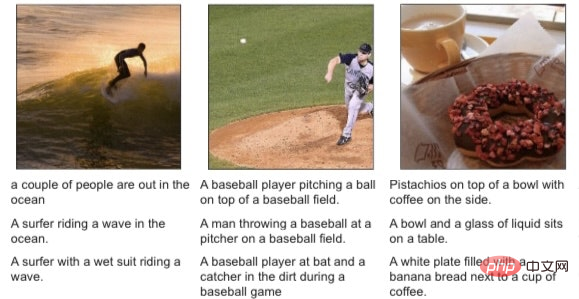

像DALL-E 2、GPT-3、Flamingo 和 Gato 這樣的系統似乎令人興奮,但仔細研究這些模型的人不會把它們與人類智慧混為一談。

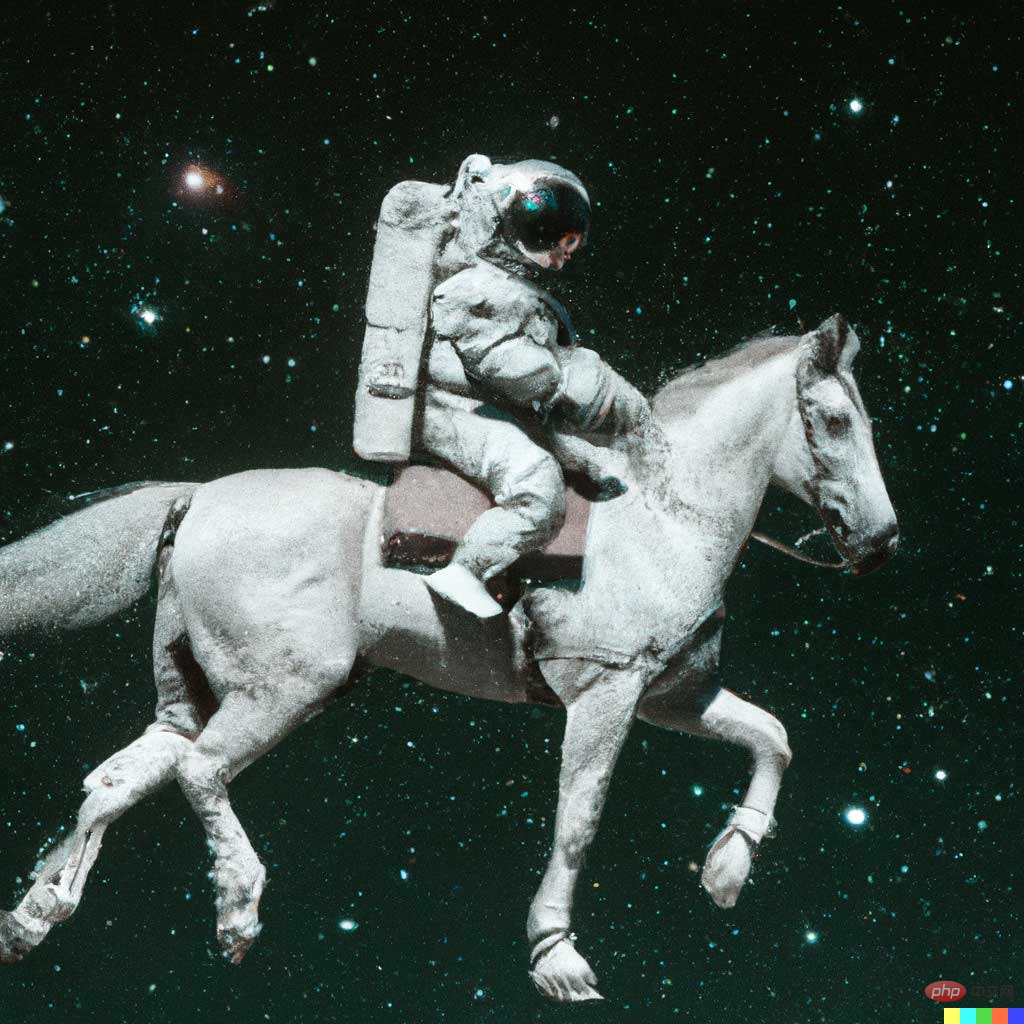

例如,DALL-E 2 可以根據文字描述創作出逼真的藝術作品,如“一個騎著馬的宇航員”:

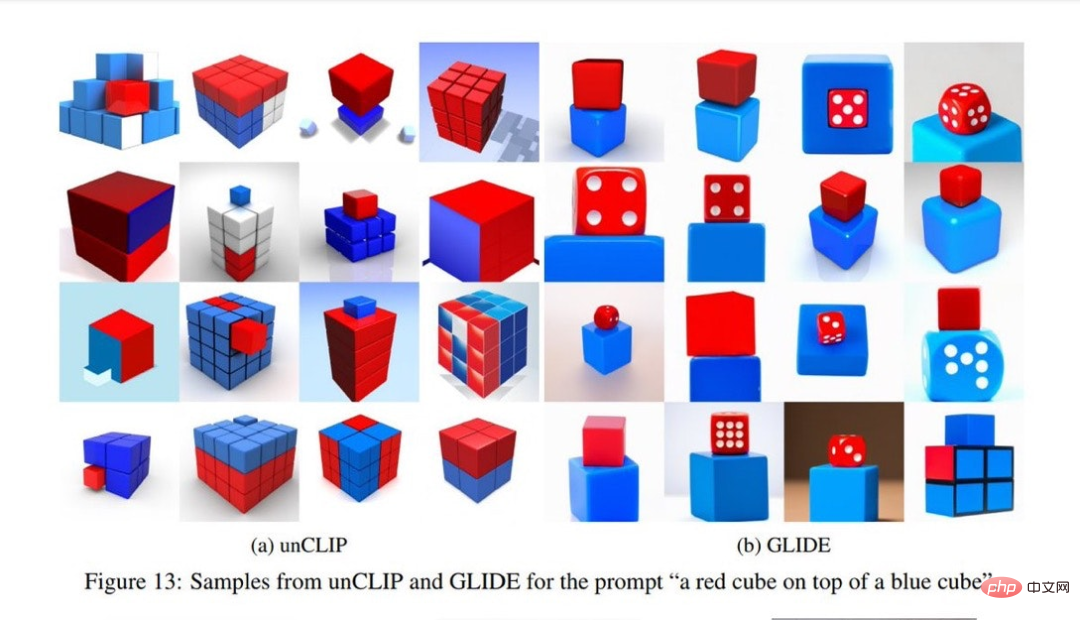

但它也很容易犯下令人驚訝的錯誤,例如當文字描述是「一個紅方塊放在一個藍方塊上」時,DALL-E 的生成結果如左圖所示,右圖是先前的模型所產生的結果。顯然,DALL-E 的生成結果不如先前的模型。

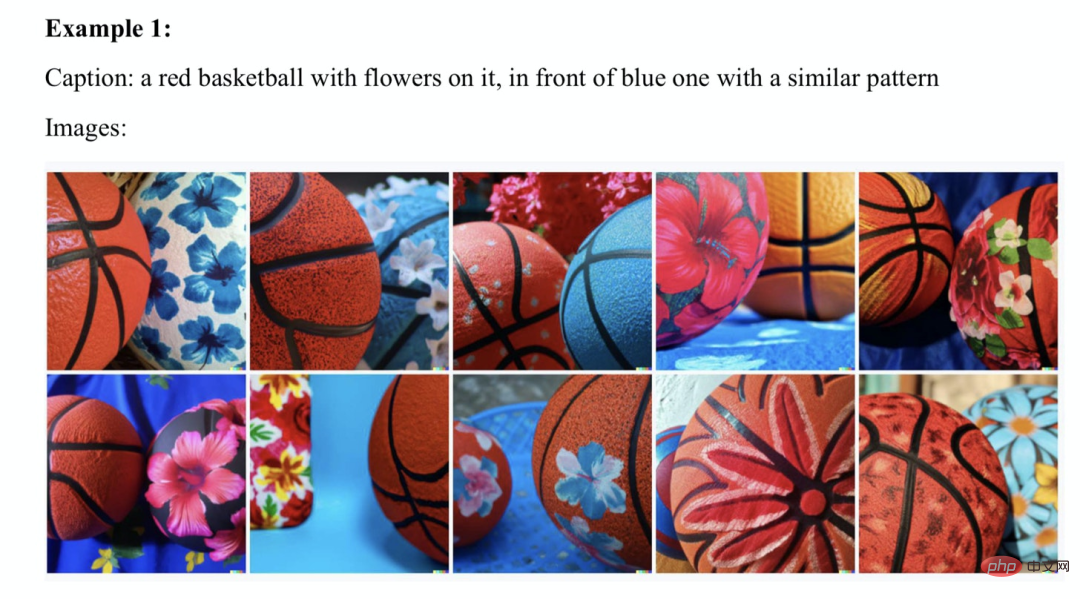

當我和Ernest Davis、Scott Aaronson 深入研究這個問題時,我們發現了許多類似的例子:

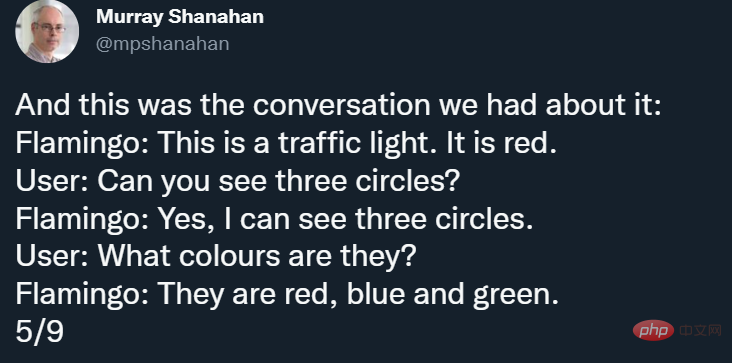

此外,表面上看起來非常驚豔的Flamingo 也有自己的bug,就像DeepMind 高級研究科學家Murray Shanahan 在一篇推文中所指出的那樣,Flamingo 的第一作者Jean-Baptiste Alayrac 後來也補充了一些例子。例如,Shanahan 向Flamingo 展示了這樣一張圖片:

#並圍繞這張圖片展開了以下漏洞百出的對話:

看起來是「無中生有」了。

前段時間,DeepMind 也發布了多模態、多任務、多具身的「通才」智能體 Gato,但當你看那些小字的時候,你仍然能夠發現不可靠的地方。

當然,深度學習的捍衛者會指出,人類也會犯錯。

但任何一個誠實的人都會意識到,這些錯誤表明,有些東西目前是存在缺陷的。毫不誇張地說,如果我的孩子經常犯這樣的錯誤,我會放下手邊所有的工作,立即帶他們去看神經科醫生。

所以,讓我們誠實一點:規模化還沒有起效,但它是有可能的,或者說 de Freitas 的理論——時代精神的清晰表達——是這樣的。

Scaling-Uber-Alles

那麼,de Freitas 是如何將現實與抱負調和在一起的呢?事實上,現在已經有數十億美元被投入了 Transformer 和其他許多相關領域,訓練資料集已經從兆位元組擴展到千兆位元組,參數量從數百萬擴展到數萬億。然而,自 1988 年以來,在許多著作中被詳細記錄的令人費解的錯誤仍然存在。

對於某些人(例如我自己)來說,這些問題的存在可能意味著我們需要根本性的反思,例如 Davis 和我在《Rebooting AI》一書中所指出的那些。但對 de Freitas 來說,事情卻不是這樣(其他很多人可能也和他持一樣的想法,我並不是要把他單獨拎出來講,我只是覺得他的言論比較有代表性)。

在推文中,他詳細闡述了他對調和現實與當前問題的看法,「(我們需要)讓模型變得更大、更安全、計算效率更高、採樣更快、存儲更智慧、模式更多,此外還需要研究資料創新、線上/ 離線等等。」重點是,沒有一個字來自認知心理學、語言學或哲學(也許smarter memory 勉強能算)。

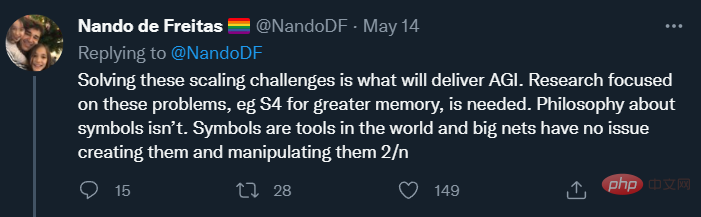

在後續的貼文中,de Freitas 也說到:

這再次印證了他「規模化大於一切」的聲明,並表明了一個目標:其野心不只是更好的AI,而是AGI。

AGI 即通用人工智慧,它至少與人類智慧一樣好、一樣足智多謀且適用範圍廣泛。目前我們實現的狹義的人工智慧實際上是替代智慧(alt intelligence),其標誌性的成功是國際象棋(深藍與人類智慧毫無關係)和圍棋(AlphaGo 與人類智慧關係也不大)等遊戲。 De Freitas 有著更遠大的目標,值得稱讚的是,他對這些目標非常坦率。那麼,他要怎麼來實現自己的目標呢?這裡要重申一下,de Freitas 重點關注的是用來容納更大資料集的技術工具。其他的想法,例如來自哲學或認知科學的想法,可能很重要,但卻被排除了。

他說,「關於符號的哲學並無必要」。也許這是對我長期以來將符號操縱整合到認知科學和人工智慧中的運動的反駁。這個想法最近又出現在了 Nautilus 雜誌上,儘管闡述並不充分。在此我簡要回應:他所說的「[neural] nets have no issue creating [symbols] and manipulating them」既忽略了歷史,也忽略了現實。他忽略的歷史是:許多神經網路愛好者幾十年來一直反對符號;他忽略的現實是:像前面提到的「藍色立方體上的紅色立方體」這類符號性描述仍然能夠難住2022 年的SOTA 模型。

在推文結尾,De Freitas 表達了他對 Rich Sutton 著名文章《苦澀的教訓》的讚同:

Sutton 的論點是,唯一導致人工智慧進步的是更多的數據、更有效的計算。在我看來,Sutton 只對了一半,他對過去的描述幾乎是正確的,但他對未來的歸納預測卻無法令人信服。

到目前為止,在大多數領域(當然不是所有領域),大數據已經(暫時)戰勝了精心設計的知識工程。

但世界上幾乎所有的軟體,從網頁瀏覽器到電子表格再到文字處理器,仍然依賴知識工程,而 Sutton 忽略了這一點。舉個例子,Sumit Gulwani 出色的 Flash Fill 功能是一種非常有用的一次性學習系統,它根本不是建立在大數據的前提下,而是建立在經典的程式設計技術之上。

我認為任何純粹的深度學習 / 大數據系統都無法與之匹敵。

事實上,像 Steve Pinker、Judea Pearl、Jerry Fodor 和我這樣的認知科學家幾十年來一直指出的人工智慧的關鍵問題實際上還沒有得到解決。是的,機器可以很好地玩遊戲,深度學習在語音辨識等領域做出了巨大貢獻。但目前沒有任何人工智慧可以具備足夠的理解力來認識任何文本,並建立一個能正常說話、完成任務的模型,也不能像《星際迷航》電影裡的計算機一樣可以進行推理並產生有凝聚力的響應。

我們仍處在人工智慧的早期階段。

使用特定策略在一些問題上取得成功並不能保證我們能以類似的方式解決所有問題。如果沒有意識到這樣,那簡直是愚蠢的,特別是當一些失敗模式(不可靠性、奇怪的錯誤、組合性失敗和不理解)自 Fodor 和 Pinker 在 1988 年指出它們之後仍沒有改變時。 結論

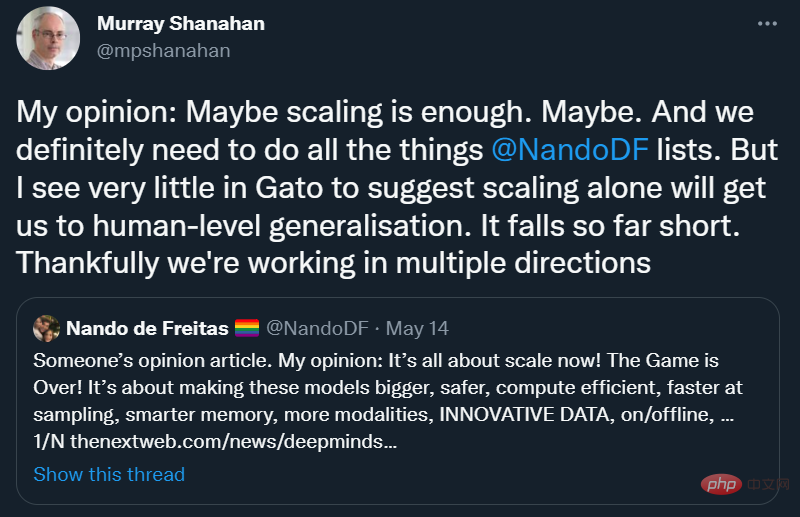

很高興能看到Scaling-Über-Alles 尚未完全達成共識,即使在DeepMind 也是如此:

我完全同意Murray Shanahan 的看法:「I see very little in Gato to suggest scaling alone will get us to human-level generalisation」。

讓我們鼓勵一個思想足夠開放的領域,人們可以在很多方向上開展自己的工作,而不會過早地拋棄碰巧尚未完全發展的想法。畢竟,通往(通用)人工智慧的最佳途徑可能不是 Alt Intelligence 這條路。

如前面所述,我很樂意把Gato 視為「替代智慧」——一種建立智慧替代方法的有趣探索,但我們需要客觀地看待它:它不會像大腦那樣運作,它不會像孩子那樣學習,它不懂語言,不符合人類價值觀,不能被信任用來完成關鍵任務。

它可能比我們目前擁有的任何其他東西都好,但仍然不能真正起作用,即使在對它進行了巨大的投資之後,我們也該暫停一下。

它應該把我們帶回人工智慧新創的時代。人工智慧當然不應該是人類智慧的盲從複製品,畢竟它有自己的缺陷,背負著糟糕的記憶和認知偏見。但它應該從人類和動物的認知中尋找線索。萊特兄弟沒有模仿鳥類,但他們從鳥類的飛行控制中學到了一些知識。知道什麼可以藉鑑,什麼不可以藉鑑,我們可能就成功了一大半。

我認為底線是,人工智慧曾經重視但現在不再追求的東西:如果我們要建構AGI,我們將需要向人類學習一些東西——他們是如何推理和理解物理世界的,以及他們是如何表示和獲得語言及複雜概念的。

如果否定這種想法,那就太狂妄了。

以上是超大模型出現後,AI的遊戲結束了? Gary Marcus:路走窄了的詳細內容。更多資訊請關注PHP中文網其他相關文章!