機器學習評估指標的十個常見面試問題

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 20:58:021710瀏覽

評估指標是用於評估機器學習模型表現的量化指標。它們提供了一種系統和客觀的方法來比較不同的模型並衡量它們在解決特定問題方面的成功程度。透過比較不同模型的結果並評估其性能可以對使用哪些模型、如何改進現有模型以及如何優化給定任務的性能做出正確的決定,所以評估指標在機器學習模型的開發和部署中發揮著至關重要的作用。所以評估指標是面試時常被問到的基礎問題,而本文整理了10個常見的問題。

1、你能在機器學習的背景下解釋精度和召回率之間的區別嗎?

#在機器學習模型中,精度和召回率是兩個常用的評估指標。精確度是衡量模型在所有正預測中做出的真正正預測的數量,表示模型避免假陽性預測的能力。

Precision = TP/TP FP

召回率是衡量模型在資料集中所有實際積極實例中所做的真正預測的數量。召回率表示模型正確識別所有正實例的能力。

Recall = TP/TP FN

精確性和召回率都是重要的評估指標,但兩者之間的權衡取決於要解決的特定問題的要求。例如,在醫學診斷中,召回率可能更重要,因為它對識別疾病的所有病例至關重要,即使這會導致更高的假陽性率。但在詐欺檢測中,精確度可能更重要,因為避免虛假指控至關重要,即使這會導致更高的假陰性率。

2、如何為給定的問題選擇合適的評估指標?

為給定的問題選擇適當的評估是模型開發過程的關鍵方面。在選擇指標時,考慮問題的性質和分析的目標是很重要的。需要考慮的一些常見因素包括:

問題類型:是二元分類問題、多類別分類問題、迴歸問題或其他問題?

業務目標:分析的最終目標是什麼,需要什麼樣的性能?例如,如果目標是最小化假陰性,召回率將是一個比精度更重要的指標。

資料集特徵:類別是平衡的還是不平衡的?資料集是大還是小?

資料品質:資料的品質如何,資料集中存在多少雜訊?

#基於這些因素,可以選擇一個評估指標,如accuracy、F1-score、AUC-ROC、Precision-Recall、均方誤差等。但一般都會使用多個評估指標來獲得對模型表現的完整理解。

3、你能介紹一下用F1 score嗎?

F1 score是機器學習中常用的評估指標,用於平衡精確度和召回率。精確度衡量的是模型所做的所有正面預測中正觀察的比例,而召回率衡量的是所有實際正觀察中正預測的比例。 F1分數是精確度和召回率的調和平均值,通常用作總結二元分類器效能的單一指標。

F1 = 2 * (Precision * Recall) / (Precision Recall)

在模型必須在精確度和召回率之間做出權衡的情況下,F1分數比單獨使用精確度或召回率提供了更細緻的性能評估。例如,在假陽性預測比假陰性預測成本更高的情況下,優化精確度可能更重要,而在假陰性預測成本更高的情況下,可能會優先考慮召回。 F1分數可用於評估模型在這些場景下的效能,並就如何調整其閾值或其他參數來最佳化效能給予對應的資料支援。

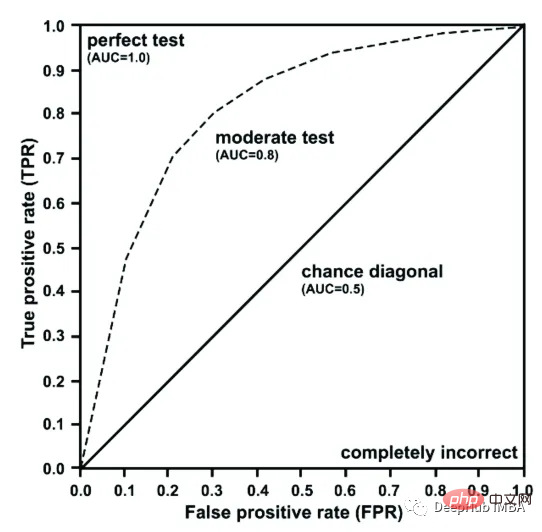

4、你能解釋在模型評估中使用ROC曲線的原因嗎?

ROC曲線是二元分類模型效能的圖形表示,該模型繪製真陽性率(TPR)與假陽性率(FPR)。它有助於評估模型的敏感性(真陽性)和特異性(真陰性)之間的權衡,並廣泛用於評估基於二元分類結果(如是或否、通過或失敗等)進行預測的模型。

ROC曲線透過比較模型的預測結果和實際結果來衡量模型的效能。一個好的模型在ROC曲線下有很大的面積,這意味著它能夠準確地區分正類和負類。 ROC AUC (Area Under the Curve,曲線下面積)用於比較不同模型的性能,特別是在類別不平衡時評估模型性能的好方法。

5、如何確定二元分類模型的最佳閾值?

二元分類模型的最佳閾值是透過找到在精確度和召回率之間平衡的閾值來確定的。這可以透過使用評估指標來實現,例如F1分數,它平衡了準確性和召回率,或者使用ROC曲線,它繪製了各種閾值的真陽性率和假陽性率。最佳閾值通常選擇ROC曲線上最接近左上角的點,因為這樣可以最大化真陽性率,同時最小化假陽性率。在實踐中,最佳閾值也可能取決於問題的特定目標以及與假陽性和假陰性相關的成本。

6、你能介紹以下模型評估中精確度和召回率之間的權衡嗎?

模型評估中精確度與召回率之間的權衡是指正確辨識正面實例(召回率)和正確識別僅正面實例(召回率)之間的權衡。高精確度意味著假陽性的數量低,而召回率高意味著假陰性的數量低。對於給定的模型,通常不可能同時最大化精確度和召回率。為了進行這種權衡,需要考慮問題的特定目標和需求,並選擇與它們一致的評估測量。

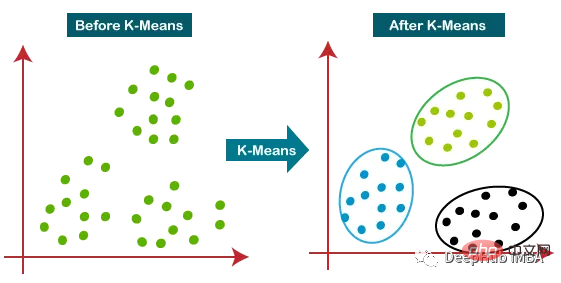

7、如何評估聚類模型的性能?

聚類模型的性能可以使用許多指標進行評估。一些常見的指標包括:

- Silhouette 分數:它衡量觀察到自己的簇與其他簇相比的相似性。分數範圍從 -1 到 1,數值越接近 1 表示聚類結構越強。

- Calinski-Harabasz指數:它測量的是簇間變異數與簇內變異數的比值。較高的值表示更好的聚類解決方案。

- Davies-Bouldin 指數:它衡量每個簇與其最相似的簇之間的平均相似性。較小的值表示更好的聚類解決方案。

- Adjusted Rand 指數:它測量真實類別標籤和預測聚類標籤之間的相似性,並根據機率進行調整。較高的值表示更好的聚類解決方案。

- 混淆矩陣:它可以透過將預測的聚類與真實的類別進行比較來評估聚類模型的準確性。

但選擇合適的評估指標也取決於特定問題和聚類分析的目標。

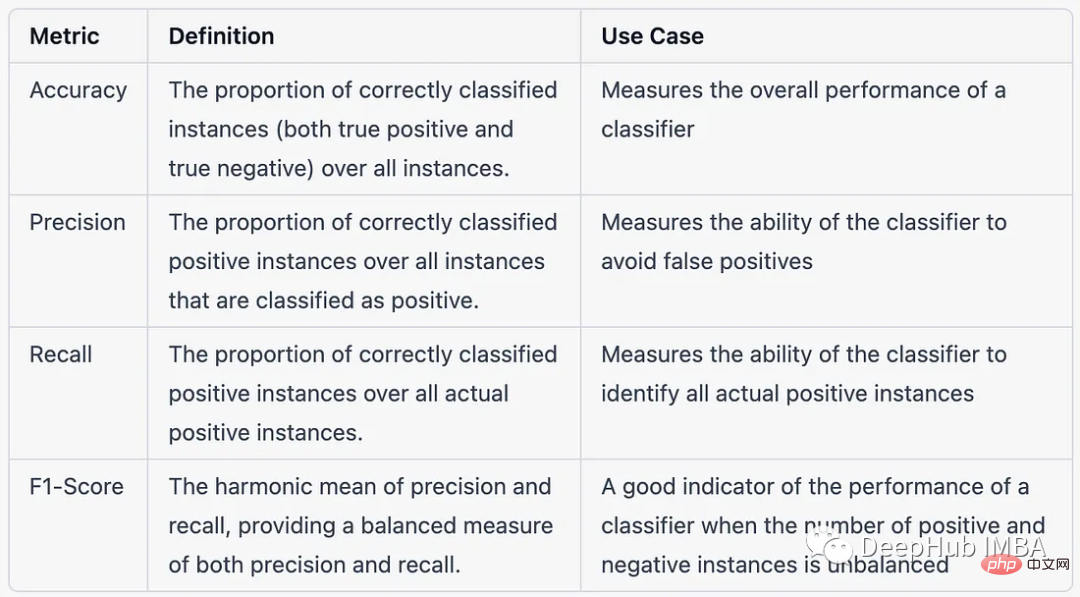

8、多類別分類問題的背景下,accuracy, precision, recall, and F1-score之間的區別

以下是在多類別分類問題的背景下,以表格形式比較accuracy, precision, recall, and F1-score:

9、如何評估推薦系統的效能?

評估推薦系統的效能包括衡量系統向使用者推薦相關項目的有效性和效率。一些常用的用於評估推薦系統效能的指標包括:

- Precision:與使用者相關的推薦項目的比例。

- Recall:系統建議相關項目的比例。

- F1-Score:精密度和召回率的調和平均值。

- Mean Average Precision (MAP):一個推薦系統的整體使用者的平均精確度的量測。

- Normalized Discounted Cumulative Gain (NDCG):衡量推薦項目的等級加權相關性。

- Root Mean Square Error (RMSE):對一組項目的預測評分和實際評分之間的差異進行測量。

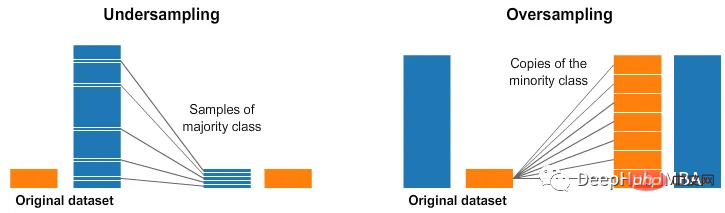

- 10、在評估模型效能時,如何處理不平衡的資料集?

為了在模型評估中處理不平衡的資料集,可以使用以下幾種技術:

- 重新取樣資料集:對少數類別進行過取樣或對多數類別進行過取樣,以平衡類別分佈。

- 使用不同的評估指標:精確度、召回率、F1-score和ROC曲線下面積(AUC-ROC)等指標對類別不平衡很敏感,可以更好地理解模型在不平衡數據集上的性能。

- 使用代價敏感學習:為不同類型的錯誤分類分配成本,例如為假陰性分配比假陽性更高的成本,以使模型對少數類別更敏感。

- 使用整合方法:透過組合多個模型的結果,可以使用bagging、boosting和stacking等技術來提高模型在不平衡資料集上的效能。

- 混合方法:上述技術的組合可用於處理模型評估中的不平衡資料集。

總結

評估指標在機器學習中發揮關鍵作用,選擇正確的評估指標並適當地使用它對於確保機器學習模型及其產生的見解的品質和可靠性至關重要。因為一定會被使用,所以這是在面試中常會被問的問題,希望這篇文章整理的問題對你有幫助。

以上是機器學習評估指標的十個常見面試問題的詳細內容。更多資訊請關注PHP中文網其他相關文章!