小紮下血本! Meta專為元宇宙搞了個AI模型

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 19:58:22917瀏覽

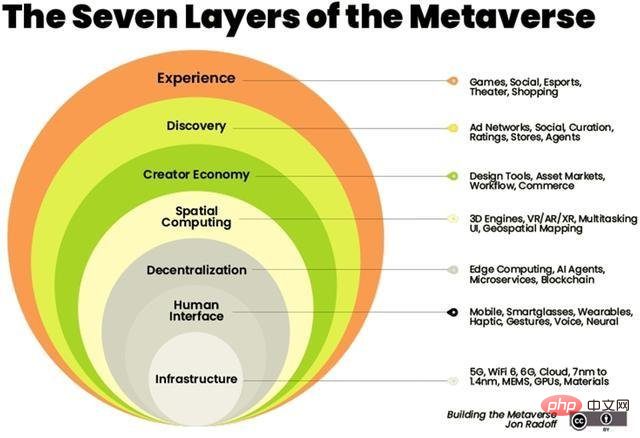

人工智慧將成為虛擬世界的支柱。

人工智慧可在元宇宙中與多種相關技術結合,如電腦視覺、自然語言處理、區塊鏈和數位雙胞胎。

2月,祖克柏在公司的第一個虛擬活動-Inside The Lab中展現了元宇宙的樣子。他說,該公司正在開發一系列新的生成式AI模型,用戶只需透過描述就可以產生自己的虛擬實境化身。

祖克柏宣布了一系列即將推出的項目,例如CAIRaoke項目,一項用於構建設備語音助理的完全端到端的神經模型,可幫助用戶更自然地與語音助理進行交流。 同時,Meta正努力建構一個通用語音翻譯器,可為所有語言提供直接的語音到語音翻譯。

幾個月後,Meta兌現了他們的承諾。 然而,Meta並不是唯一一家在遊戲中擁有皮膚的科技公司。英偉達等公司也發布了其自主研發的AI模型以提供更豐富的元宇宙體驗。

開源預訓練Transformer(OPT-1750億參數)

GAN verse 3D

#GANverse 3D由英偉達AI Research開發,是一種使用深度學習將2D圖像處理成3D動畫版本的模型,去年的ICLR和CVPR上發表的一篇研究論文中介紹了該工具,它可以用更低的成本更快地生成模擬。

此模型使用StyleGAN可自動從單一影像產生多個視圖。該應用程式可以作為NVIDIA Omniverse的擴展導入,以在虛擬世界中準確地渲染3D物件。 英偉達推出的Omniverse可協助使用者在虛擬環境中建立他們最終想法的模擬。

3D模型的製作已成為建構元宇宙的關鍵因素。耐吉和Forever21等零售商已經在元宇宙建立了他們的虛擬商店,以推動電子商務銷售。

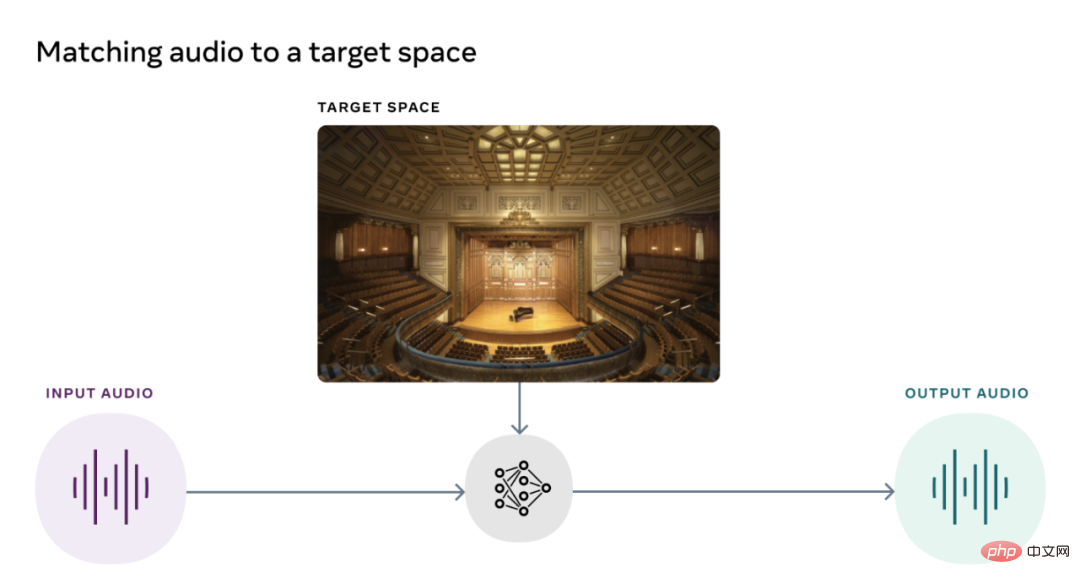

視覺聲學匹配模型(AViTAR)

#Meta的現實實驗室團隊與德克薩斯大學合作,建立了一個人工智慧模型,以改善元空間的聲音品質。該模型可幫助匹配場景中的音訊和視訊。它會對音訊片段進行轉換,使其聽起來像是在特定環境中錄製的。該模型在從隨機的線上影片中提取數據後使用了自我監督學習。 理想情況下,使用者應該能夠在他們的AR眼鏡上觀看他們最喜歡的記憶,並聆聽實際體驗中產生的確切聲音。

Meta AI發布了AViTAR的開源,同時也發布了其他兩個聲學模型,考慮到聲音是metaverse體驗中經常被忽視的部分,這是非常罕見的。

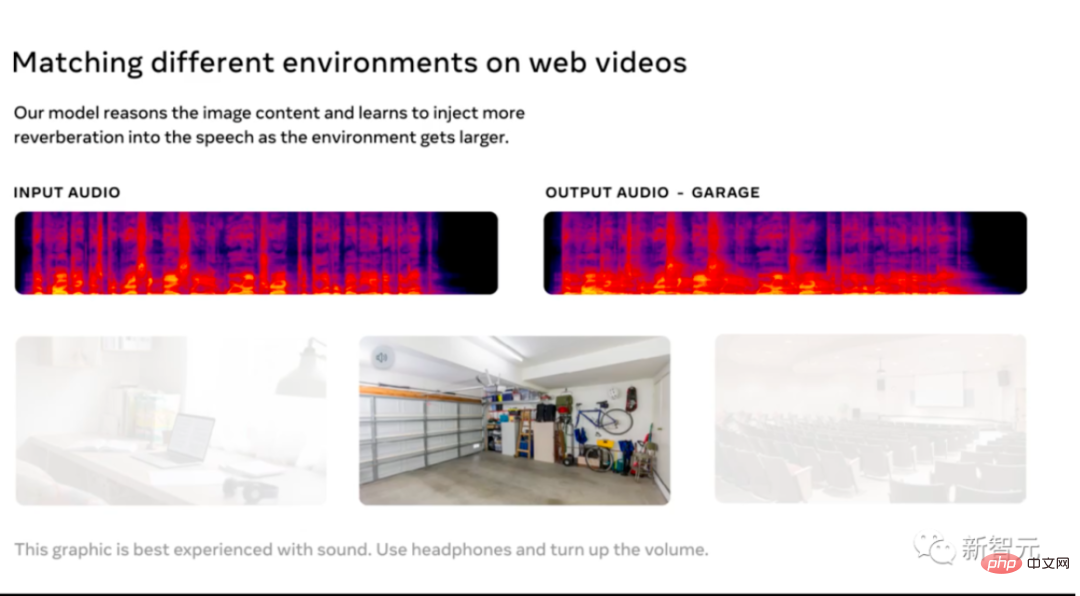

視覺影響的減震(VIDA)

Meta AI發布的第二個聲學模型被用來去除聲學中的混響。

該模型是在一個大規模的資料集上訓練出來的,該資料集有各種來自家庭三維模型的真實音訊渲染。混響不僅降低了音訊的質量,使其難以理解,而且還提高了自動語音辨識的準確性。

VIDA的獨特之處在於,它在使用視覺線索的同時也使用音訊方式進行觀察。在典型的僅有音訊的方法的基礎上進行改進,VIDA可以增強語音,並識別語音和說話者。

視覺語音(VisualVoice)

Meta AI發布的第三個聲學模型VisualVoice可以從視訊中提取語音。與VIDA一樣,VisualVoice也是根據未標記的影片中的視聽線索進行訓練。該模型已經自動分離了語音。

這個模型有重要的應用場景,如為聽障人士製作技術,增強穿戴式AR裝置的聲音,從環境吵雜的線上影片轉錄語音等。

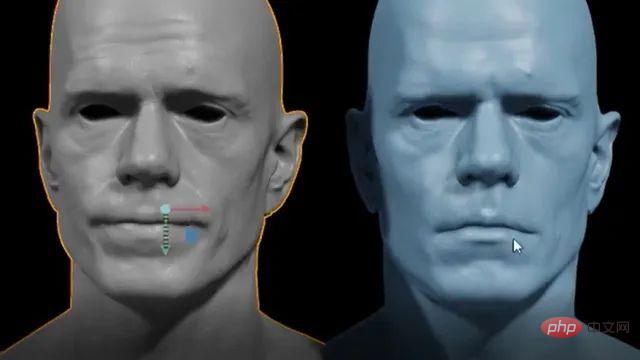

Audio2Face

去年,英偉達發布了Omniverse Audio2Face的開放測試版,以產生人工智慧驅動的臉部動畫,以匹配任何配音。該工具簡化了為遊戲和視覺效果製作動畫的漫長而繁瑣的過程。該應用程式還允許用戶以多種語言發出指令。

今年年初,英偉達發布了該工具的更新,增加了BlendShape Generation等功能,幫助用戶從一個中性頭像中創建一組blendhapes。此外,還增加了串流音訊播放器的功能,允許使用文字轉語音應用程式的音訊資料流。 Audio2Face設定了一個3D人物模型,可以用音軌做動畫。然後,音訊被送入一個深度神經網路。使用者還可以在後製中編輯角色,改變角色的表現。

以上是小紮下血本! Meta專為元宇宙搞了個AI模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!