深度學習中的拓樸美學:GNN基礎與應用

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-11 19:31:041524瀏覽

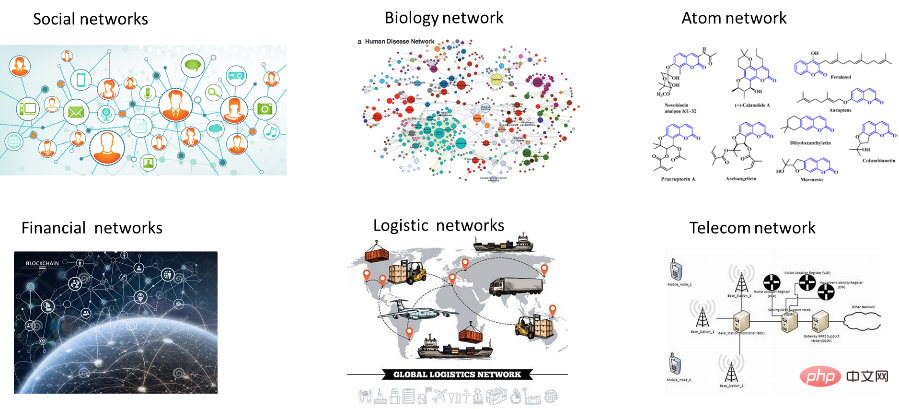

導讀:在真實世界中,許多資料往往以圖的形式出現,例如社群網路、電商購物、蛋白質互動關係等,過去幾年基於神經網路的圖數據分析與挖掘方式因其出色的性能受到了廣泛的關注,不僅一躍成為學術界的研究熱點同時也在多種應用中大放異彩。這篇文章主要結合相關文獻、領域專家的分享以及筆者淺薄經驗,所做的粗淺總結和歸納。雖然是知識的搬運但也參雜了個人的主觀判斷,偏頗以及疏漏難免,還請各位謹慎參考。修修補補停筆恰逢平安夜,也藉此契機祝大家新的一年所願皆所得,平安多喜樂。

1、圖神經網路發展綜述

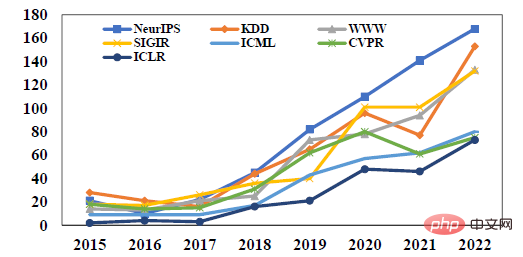

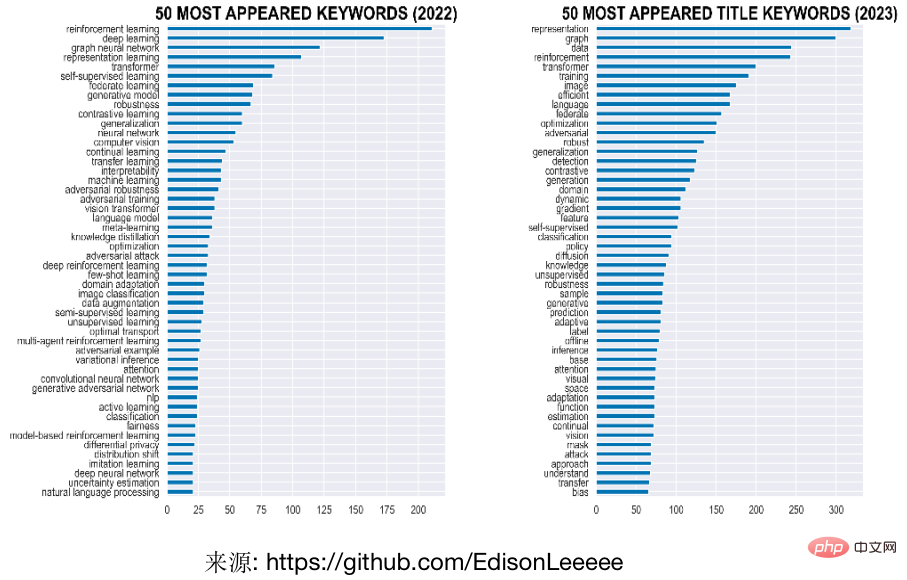

近年來使用建模分析圖結構的研究越來越受到關注,其中基於深度學習的圖建模方法的圖神經網路(Graph Neural Network, GNN),因其出色的表現成為學術界的研究熱點之一。例如下圖所示,圖神經網路在機器學習相關頂會上的論文數量持續攀升,以圖作為標題或關鍵字在近兩年表徵學習頂會ICLR的出現頻率是最熱門的字詞之一。另外今年多個會議的最佳論文獎均有圖神經網路的身影,例如資料探勘頂會KDD今年的最佳博士論文的冠亞軍均是頒發給了圖機器學習相關的兩位青年學者,最佳研究論文以及應用論文也分別是關於超圖上的因果學習以及聯邦圖學習。另一方面,圖神經網路在電商搜尋、推薦、線上廣告、金融風控、交通預估等領域也有許多的落地應用,各大公司也紛紛著力建構圖學習相關平台或是能力。

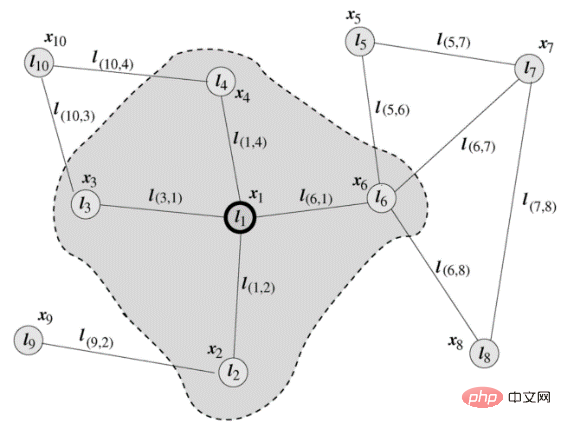

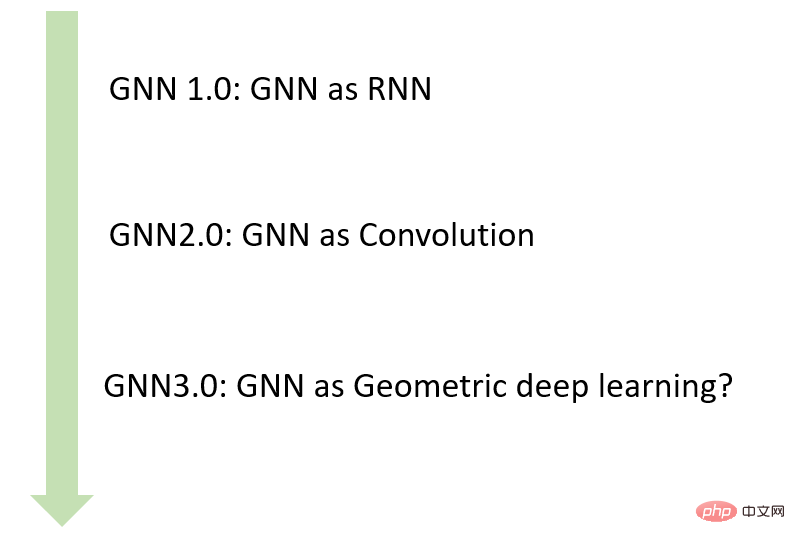

#雖然圖神經網路在近五年才開始成為研究熱點,但相關定義在2005就由義大利學者Marco Gori和Franco Scarselli等人提出。在Scarselli論文中典型的圖如下圖所示。早期階段的GNN主要是以RNN為主體框架,輸入節點鄰居資訊更新節點狀態,將局部轉移函數定義為循環遞歸函數的形式,每個節點以周圍鄰居節點和相連的邊作為來源資訊來更新自身的表達。

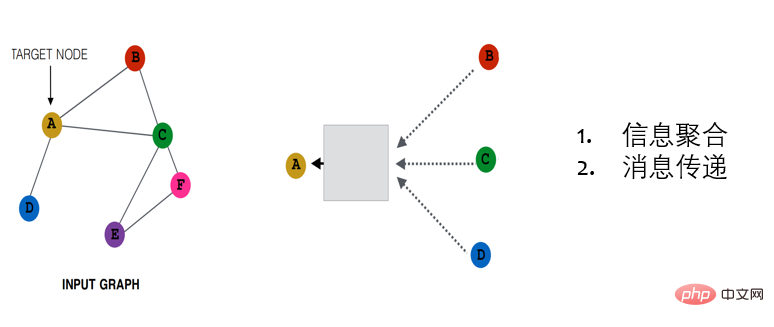

LeCun的學生Bruna等人2014年提出將CNN應用到圖上,透過對卷積算符巧妙的轉換,提出了基於頻域和基於空域的圖卷積網路兩種資訊聚合方式。基於頻譜的方法從圖訊號處理的角度引入濾波器來定義圖卷積,其中圖卷積操作被解釋為從圖訊號中去除雜訊。基於空間的方法則更契合CNN的範式將圖卷積表示為從鄰域聚合特徵資訊。此後幾年,雖然也有零星的一些新的模型的提出,但是依舊是較為小眾的研究方向。直到2017年圖模型三劍客GCN,GAT,GraphSage為代表的一系列研究工作的提出,打通了圖數據與卷積神經網路之間的計算壁壘,使得圖神經網路逐步成為研究的熱點,也奠定了目前基於訊息傳遞機制(message-passing)的圖神經網路模型的基本範式(MPNN)。

#典型的MPNN架構由幾個傳播層組成,基於鄰居特徵的聚合函數對每個節點進行更新。根據聚合函數的不同,可以將MPNN分為:資訊聚合(鄰居特徵的線性組合,權值僅依賴圖的結構,例如GCN)、注意力(線性組合,權值依賴圖結構和特徵,例如GAT)和訊息傳遞(廣義的非線性函數,例如GraphSAGE),下圖從左到右所示。

#從推理方式來看,還可以分為直推式(transductive,例如GCN)和歸納式(inductive,例如GraphSage)。直推式的方法會對每個節點學習到唯一確定的表徵, 但是這種模式的局限性非常明顯,工業界的大多數業務場景中,圖中的結構和節點都不可能是固定的,是會改變的,例如,用戶集合會不斷出現新用戶,用戶的關注關係集合也是不斷增長的,內容平台上的文章更是每天都會大量新增。在這樣的場景中,直推式學習需要不停地重新訓練,為新的節點學習表徵。歸納式的方法則是去學習節點鄰居特徵“聚合函數”,從而可以適用到更加靈活的場景,例如新節點的表示或圖上的結構發生變化等場景,因此會適用於實際場景中各種圖動態變換的場景。

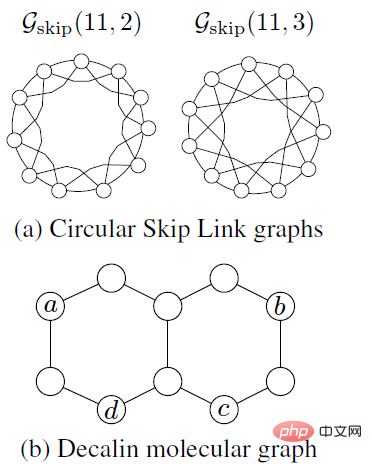

在圖神經網路發展的過程中,為了解決圖網路計算精度與可拓展問題,一代又一代的新模型被不斷提出。雖然圖神經網路在圖數據表徵能力毋庸置疑,但新的模型設計主要基於經驗直覺、啟發式方法和實驗試誤法。 Jure Leskovec組2019年的相關工作GIN(Graph Isomorphism Networks)中將GNN與圖同構檢測的經典啟發式演算法Weisfeiler Lehman(WL)建立了聯繫,並且從理論角度證明了GNN的表達能力上限值為1-WL(Jure目前是史丹佛大學電腦學院的副教授,他所領導的SNAP實驗室目前是圖網路領域最知名的實驗室之一,主講的CS224W《圖機器學習》是強烈推薦的學習資料)。然而WL演算法對於許多的資料場景表達能力十分有限,例如對於下圖中的兩個例子。對於(a)中的Circular Skip Link (CSL) Graphs, 1-WL會給兩個圖中的每個節點標記相同的顏色,換句話說這明顯兩個結構完全不同的圖,利用1-WL測試我們會得到一樣的標籤。第二例子是如(b)中所示的Decalin molecule,1-WL會給a和b染相同的顏色,給c和d染相同的顏色,使得在鏈路預測的任務中,(a,d )和(b,d)是無法進行區分的。

WL-test在存在三角或環狀結構的許多資料中都表現得差強人意,但是在生物化學等領域,環狀結構十分普遍也是非常重要,同時也決定了分子的相應性質,使得圖神經網路在相關場景的適用性被極大的限制。 Micheal Bostein等人提出當前圖深度學習方法「以節點和邊為中心」的思維方式具有極大的局限性,基於此,他們提出了從幾何深度學習的角度重新思考圖學習的發展以及可能的新範式(Micheal目前是是牛津大學的DeepMind人工智慧教授同時也是Twitter圖學習研究組的首席科學家也是幾何深度學習的推動者之一)。許多學者也紛紛從微分幾何、代數拓樸和微分方程等領域出發開啟了一系列新工具的研究,提出了等變圖神經網路、拓樸圖神經網路、子圖神經網路等一系列工作並且在諸多問題上取得矚目的效果。結合圖神經網路的發展脈絡我們可以做如下圖的簡單小結。

2、複雜圖模型

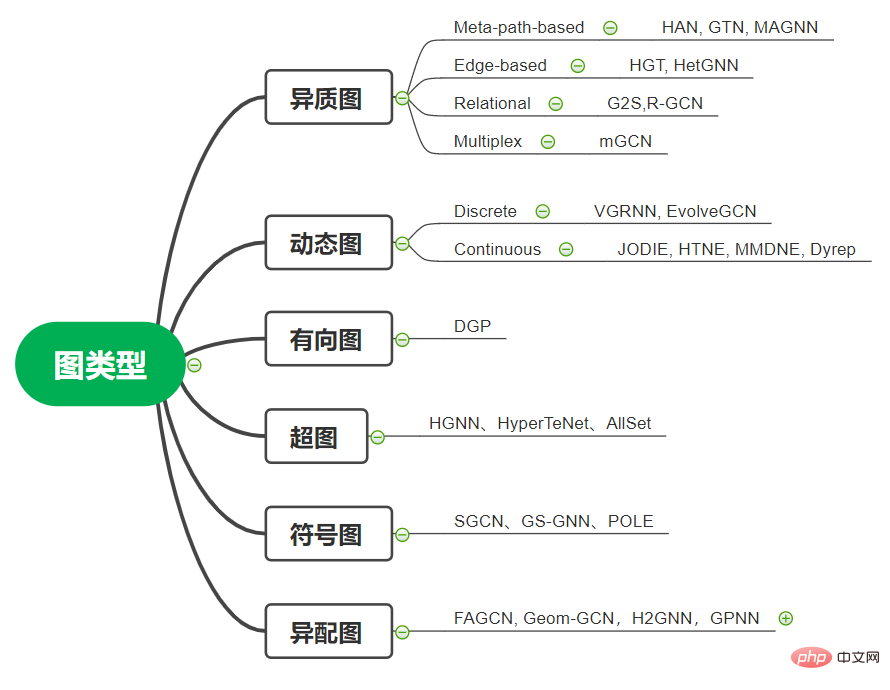

#上一節我們概述了圖神經網路的發展歷程,提及的相應的圖神經網路基本上都是設定在無向以及同質圖的場景,然而真實世界中的圖往往是複雜的,研究人員提出了針對有向圖、異構圖、動態圖、超圖、有符號圖等場景的圖神經網路模型,我們接下來分別對這幾種圖資料形態以及相關模型進行簡單的介紹:

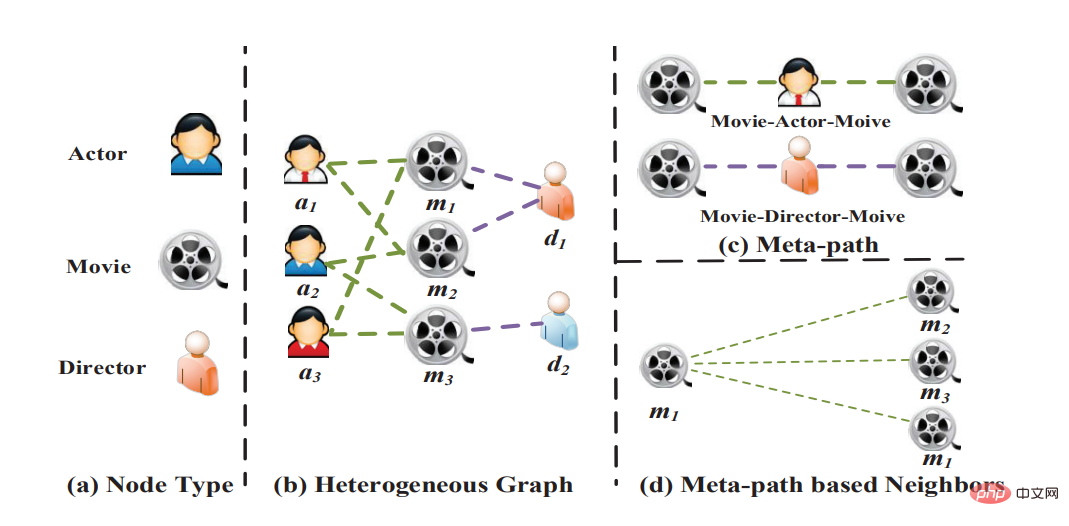

1. 異構圖:異構圖(Heterogeneous graph)是指節點和邊具有多種類別,存在多種模態時的場景。例如,在電商場景,結點可以是商品,店鋪,用戶等,邊類型可以是點擊,收藏,成交等。具體而言,在異構圖中,每個節點都帶有類型訊息,每條邊也帶有類型訊息,common GNN模型無法建模對應的異質訊息。一方面,不同類型的結點的Embedding維度就無法對齊;另一方面,不同類型的結點的Embedding位於不同的語意空間。最廣為使用的異構圖學習方法是基於元路徑的方法。元路徑指定了路徑中每個位置的節點類型。在訓練過程中,元路徑被實例化為節點序列,我們透過連結一個元路徑實例兩端的節點來捕捉兩個可能不直接相連的節點的相似度。這樣一來,一個異構圖可以被化簡為若干個同構圖,我們可以在這些同構圖上應用圖學習演算法。此外,還有一些工作提出了基於邊的方法處理異構圖,它們為不同的鄰居節點和邊使用不同的取樣函數、聚合函數。代表性的工作有HetGNN、HGT等。我們有時還需要處理關係圖,這些圖中的邊可能包含類別以外的信息,或者邊的類別數十分巨大,難以使用基於元路徑或元關係的方法。對於異構圖有興趣的小夥伴可以去關注北郵石川老師以及王嘯老師的系列工作。

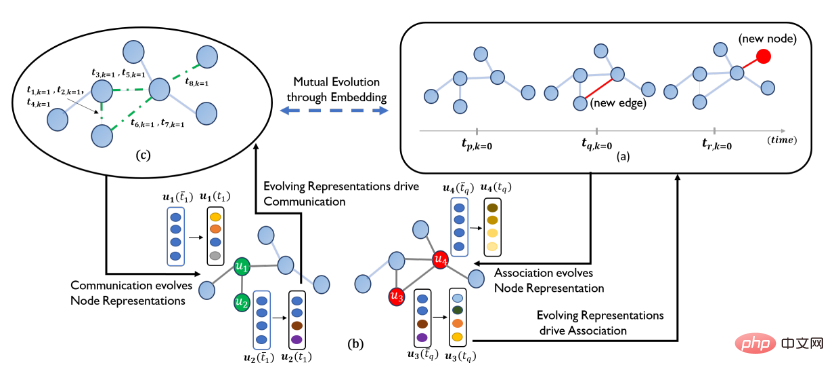

2. 動態圖:動態圖(Dynamic Graph)是指節點以及拓樸結構隨時間演化的圖數據,在實際場景中也是廣泛存在的。例如,學術引用網絡會隨時間不斷擴張,用戶與商品的交互圖會隨用戶興趣而變化,交通網絡,交通流量隨時間不斷變化。動態圖上的GNN模型旨在產生給定時間下的節點表示。根據時間粒度的粗細,動態圖可分為離散時間動態圖(也稱為snapshot based)和連續時間動態圖(event-based); 在離散時間動態圖中,時間被分割為多個時間片(例如以天/小時劃分),每個時間片對應一個靜態的圖。離散時間動態圖的GNN模型通常在每個時間片上單獨應用GNN模型,然後利用RNN來聚合節點在不同時間的表徵,代表性的工作有DCRNN、STGCN、DGNN、EvolveGCN等。在連續時間動態圖中,每條邊附有時間戳,表示互動事件發生的時刻。相較於靜態圖,連續時間動態圖中的消息函數也依賴給定樣本的時間戳記以及邊的時間戳記。此外,鄰居節點必須與時間有關,例如鄰居節點中不能出現時刻之後才出現的節點。從模型角度出發,點過程也常常應用於建模連續的動態圖,透過優化鄰域生成序列的條件強度函數來產生序列的達到率,這種方式也可以進一步預測事件發生的具體時刻(例如網絡中某條連結的消亡時間)。連續動態圖上的建模的代表性工作有JODIE、HTNE、MMDNE、Dyrep。

#來源:Dyrep

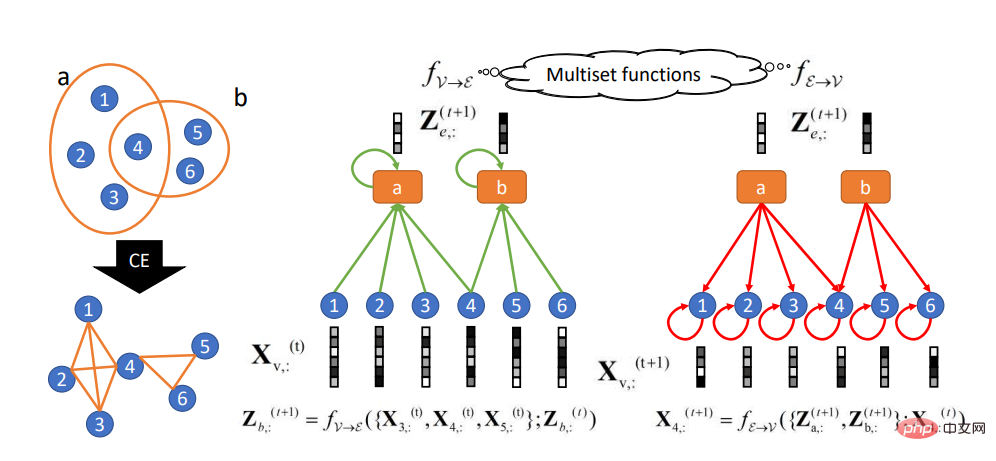

3. 超圖:超圖(Hypergraph)是一種廣義的圖,它的一邊可以連接任意數量的頂點。關於超圖的研究初期重要是在電腦視覺場景有相關的應用,近期也受到了圖神經網路領域的關注,主要的應用領域和場景是推薦系統,例如圖中的一對節點可以通過不同類型的多條邊相關聯。透過利用不同類型的邊,我們可以組織起若干層圖,每層代表一種類型的關係。代表性的工作有HGNN、AllSet等。

來源:AllSet

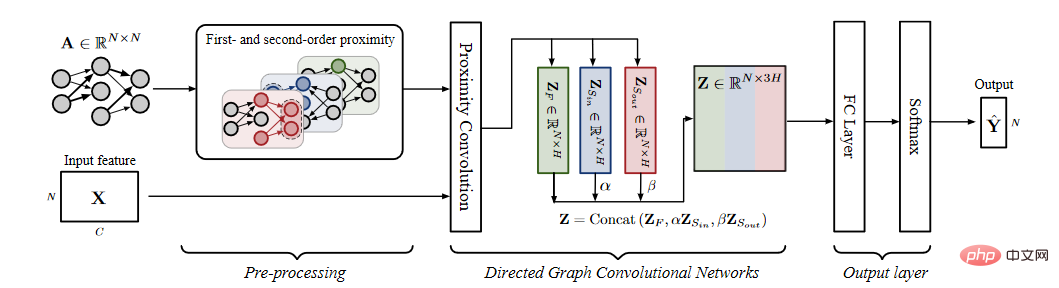

4.有向圖:有向圖(Directed graph)指的是節點的連結關係是有方向的,有向邊往往比無向邊包含更多的資訊。例如,在知識圖譜中,若頭實體是尾實體的父類,則邊的方向會提供這種偏序關係的資訊。對於有向圖的場景,除了簡單地在卷積操作中使用不對稱的鄰接矩陣,還可以分別對邊的兩個方向建模,獲得更好的表徵,代表性的工作有 DGP等。

來源:DGP

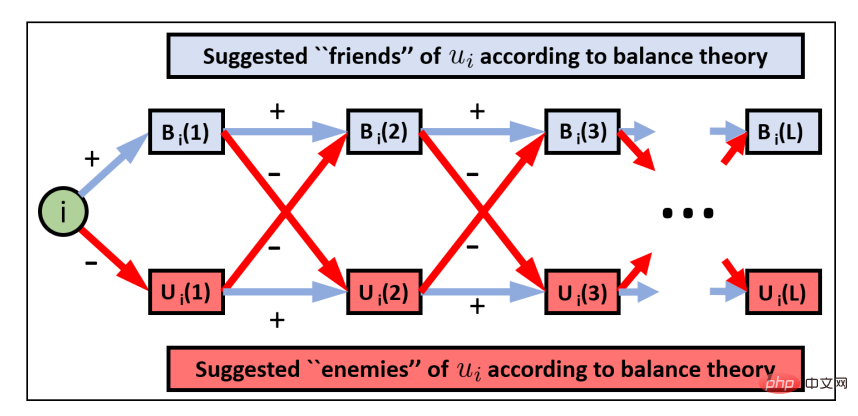

5.符號圖: 符號圖(Signed graph)指的圖中節點的關係包含正向以及反向等關係,例如社交網絡中,互動關係包含積極的關係,例如友誼、協議和支持,以及負面關係,如敵人、分歧和抵制等等,相較於普通圖,符號圖蘊含更豐富的節點互動關係。對於符號圖的建模首要解決的問題是如何對負向邊進行建模,同時如何對兩類邊的信息進行聚合,SGCN根據平衡理論的假設(朋友的朋友是朋友,敵人的朋友是敵人)定義了相應的平衡路徑從而進行相應的建模。除此之外,代表性的工作還有符號網路的極化嵌入模型POLE、二分符號圖神經網路模型SBGNN、基於k組理論的符號圖神經網路GS-GNN。

#

來源:SGCN

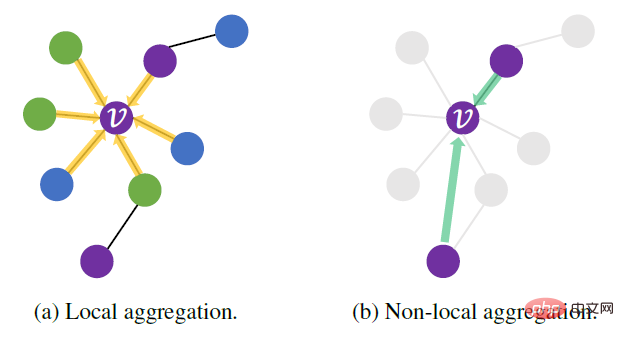

#6. 異配圖:和以上的其他幾種類型圖的定義稍有不同,異配性是描述圖資料特性的一種指標,所謂的異配圖(Heterophily graph)指的是圖上節點鄰居相似度比較低的數據類型。與異配性對應的是同配性也就是說連結的節點通常屬於同一類或具有相似的特徵(「物以類聚」)。例如,一個人的朋友和自己可能有相似的政治信念或年齡,一篇論文傾向於引用同一研究領域的論文。然而現實世界的網路並不是完全都符合同配性高的假設,例如蛋白質分子中,不同類型的胺基酸連結在一起。圖神經網路透過連結關係進行特徵的聚合以及傳播的機制即是基於數據的同配性的假設使得GNN在異配性比較高的數據上常出現效果不佳的現象。目前,已經有許多工作嘗試將圖神經網路泛化到異配圖場景,例如利用結構資訊為節點選擇鄰居的模型Geom-GCN、透過改進圖神經網路的消息傳遞機制來提升其表達能力的H2GNN、透過建構基於中心節點相關度重排序進行資訊聚合的指標網路GPNN(如下圖所示其中不同顏色代表不同的節點類型)、透過同時結合高頻訊號以及低頻訊號處理的FAGCN等。

來源:GPNN

3、圖神經網路應用程式

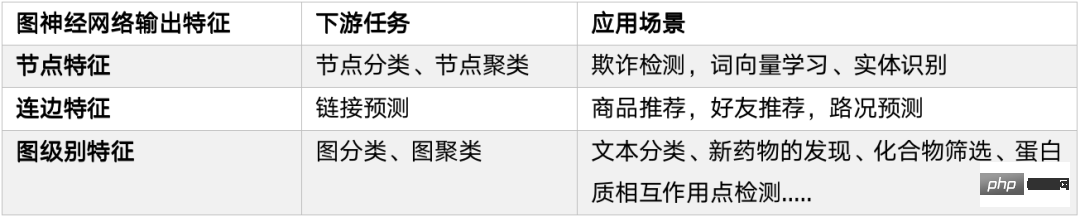

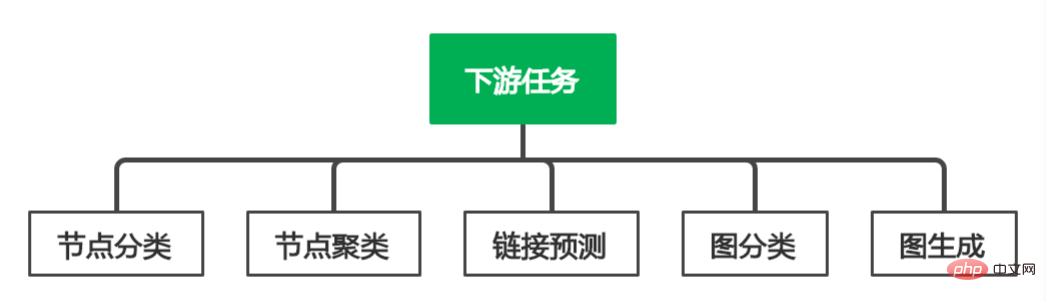

由於圖神經網路能夠較好地學習圖結構資料的特徵,因此在許多圖相關的領域有著廣泛的應用和探索。這節我們分別從下游任務以及應用的角度進行對應的分類與歸納。

1. 下游任務

#節點分類:#根據節點的屬性(可以是類別型、也可以是數值型)、邊的資訊、邊的屬性(如果有的話)、已知的節點預測標籤,對未知標籤的節點做類別預測。例如OGB的的ogbn-products資料集就是一個無向的商品購買網絡,節點代表的是在電商銷售的產品,兩個產品之間的邊表示這些產品被一起購買過,節點的屬性透過從產品描述中擷取詞袋特徵,然後進行主成分分析降維生成。對應的任務是預測產品缺失的類別資訊。

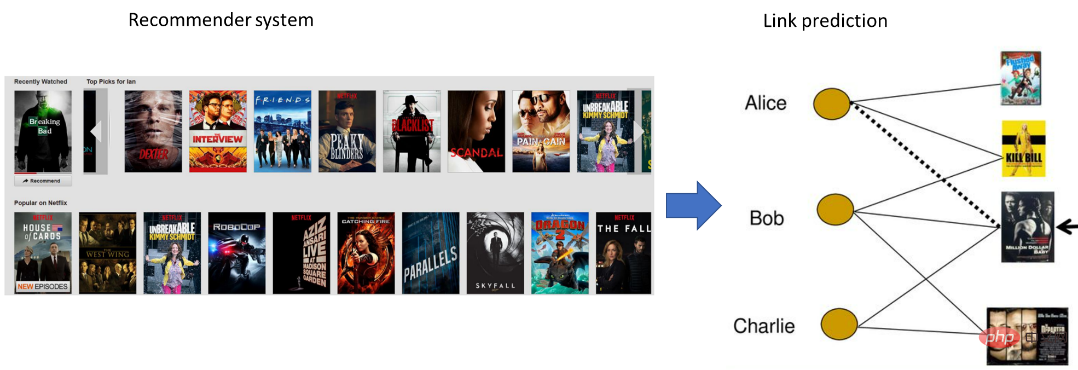

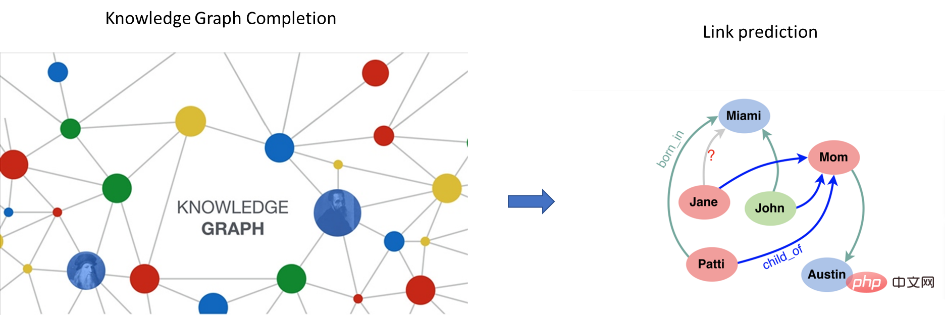

######連結預測:#########網路中的連結預測(Link Prediction)是指如何透過已知的網路節點以及網路結構等資訊預測網路中尚未產生連邊的兩個節點之間產生連結的可能性。這種預測既包含了未知連結的預測也包含了對未來連結(future links)的預測。鏈路預測在推薦系統、生化試驗等場景都有廣泛的應用,例如在商品推薦中在用戶和商品的二部圖中,如果用戶購買商品,則用戶和商品間存在鏈接,相似的用戶可能同樣會對該商品有需求,因此,預測用戶和商品之間是否可能發生“購買”、“點擊”等的鏈接,從而針對性地為用戶推薦商品,可以提高商品的購買率。除此之外,自然語言處理中的知識圖譜補全以及智慧交通中的路況預測都可以建模成連結預測的問題。 ##########圖分類:圖分類其實跟節點分類相似,本質就是預測圖的標籤。根據圖的特徵(比如圖密度、圖拓樸資訊等)、已知圖的標籤,對未知標籤的圖做類別預測,可見於生物資訊學、化學資訊學,例如訓練圖神經網路來預測蛋白質結構的性質。

圖產生:圖表產生目標是在給定一組觀察到的圖的情況下產生新的圖,例如在生物資訊中基於生成新的分子結構或是自然語言處理中基於給定的句子來產生語義圖或知識圖譜。

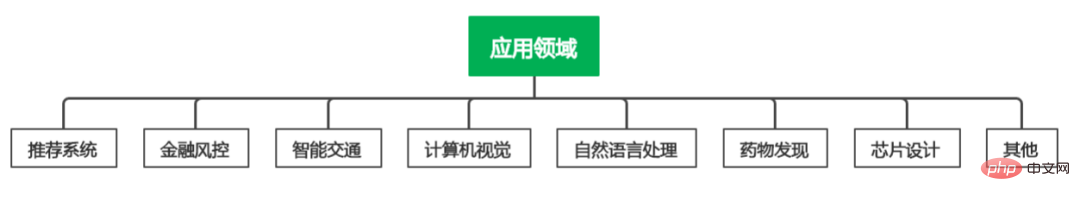

2. 應用領域

我們再對不同的應用場景進行對應的介紹。

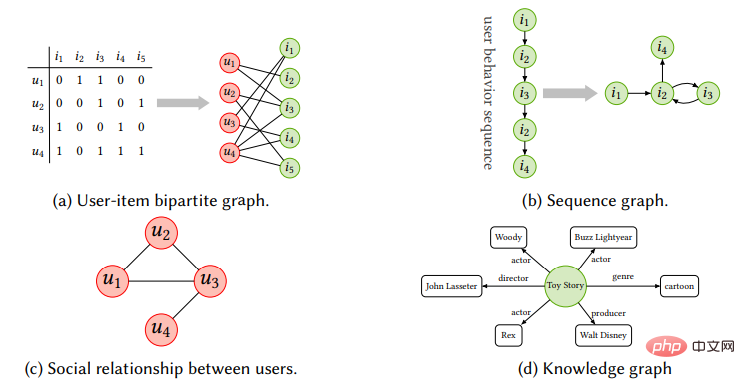

#推薦系統:行動互聯網的發展極大的推動了資訊檢索的快速發展。推薦系統作為其中最為重要方向,獲得了廣泛的關注。推薦系統的主要的目的是從歷史互動(historical interactions)和邊資訊(side information)中學習有效的使用者(user)和物品(item)表示,從而給使用者推薦其更可能傾向的物品(商品、音樂、錄影帶、電影等)。因此很自然的考量以物品和使用者為節點建構二部圖,從而可以將圖神經網路應用到推薦系統來提升建議的效果。 Pinterest基於GraphSAGE提出了第一個基於GCN的工業級推薦系統PinSage,支撐了30億節點,180 億條邊的大規模圖片推薦的場景,實際上線後Pinterest的Shop and Look產品瀏覽量提高了25% , 另外Alibaba,Amazon以及其他很多電子商務平台都使用GNN來去建立對應的推薦演算法。

除了user-item互動組成的二部圖(bipartite graph),推薦系統中社交關係、知識圖譜序列中的item轉移圖都是圖資料形式存在,另一方面,異質資料在推薦系統之中也是廣泛存在於電商場景,結點可以是Query,Item,Shop,User等,邊類型可以是點擊,收藏,成交等。透過利用專案與專案、使用者與使用者、使用者與專案之間的關係以及內容訊息,基於多源異質以及多模態圖模型,實現更高品質的推薦效果也在不斷的探索。除此之外,基於實際業務中用戶行為隨時間變化的序列化推薦以及新用戶以及商品加入導致節點引發的增量學習的訴求也為GNN模型發展帶來了新的挑戰和機遇。

自然語言處理:在自然語言處理中的許多問題和場景都是描述了關聯關係,因此可以很自然的建模成為圖資料結構。第一個直接的應用情境是知識圖譜(knowledge graph,KG)的補全以及推理,例如在Mila的研究人員提出的基於NBFNet將單跳推理問題建模成路徑表徵學習問題,從而實現知識圖譜的歸納推理。圖神經網路利用深度神經網路對圖資料中的拓撲結構資訊和屬性特徵資訊進行整合,進而提供更精細的節點或子結構的特徵表示,並能很方便地以解耦或端到端的方式與下游任務結合,滿足不同應用場景下的知識圖譜對學習實體、關係的屬性特徵和結構特徵的要求。

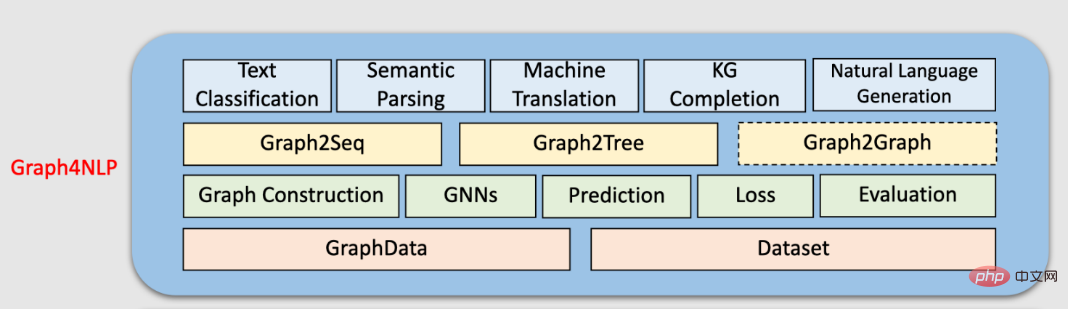

除此之外,圖神經網路在自然語言處理中許多問題例如文字分類、語意分析、機器翻譯、知識圖譜補全,命名實體辨識以及機器分類等場景上都有對應的應用,更多內容推薦大家參考吳凌飛博士的Graph4NLP的相關教學以及綜述。

來源:(https://github.com/graph4ai/graph4nlp)

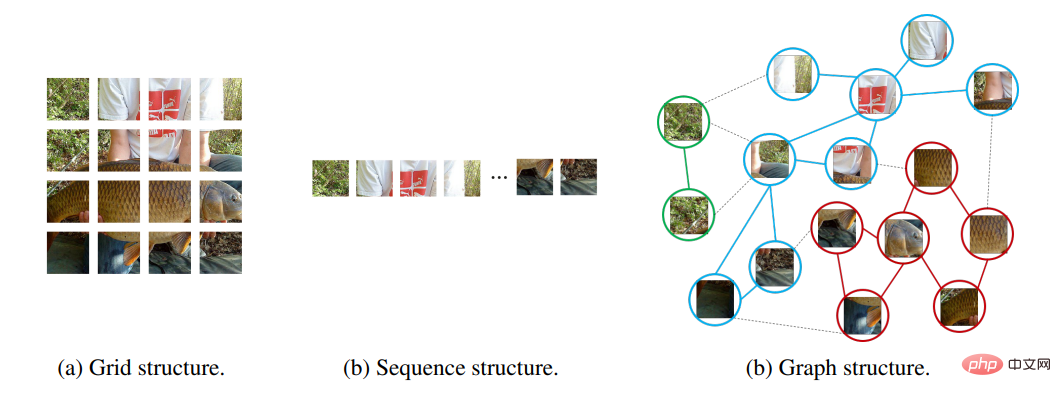

電腦視覺:電腦視覺是機器學習以及深度學習領域最大的應用場景之一,相較於推薦系統以及自然語言處理領域而言,圖神經網路在電腦視覺不算主流。原因在於GNN的優勢是關係建模和學習,而電腦視覺中的資料格式大多是規則的影像資料。在CV場景中使用GNN,關鍵在於graph如何建構:頂點及頂點特徵是什麼?頂點的連結關係怎麼定義?初期的工作主要用於一些直覺式易於進行圖結構抽象的場景。例如用於動態骨骼的動作辨識方法ST-GCN中,人體自然骨架自然的可以視為圖結構建構空間圖。在場景圖生成中,物件之間的語義關係有助於理解視覺場景背後的語義意義。給定一幅圖像,場景圖產生模型檢測和識別對象,並預測對象對之間的語義關係。在點雲分類和分割中,將點雲轉換為k-最近鄰圖或疊加圖從而利用圖網路進行相關任務的學習。近期,圖形神經網路在電腦視覺中應用的方向也不斷增加。一些研究人員在通用電腦視覺任務例如物體檢測進行相關探索以及嘗試。例如華為提出一種基於圖表示的新型通用視覺架構ViG中研究人員將輸入影像分成許多小塊,建立對應的節點圖,實驗結果顯示相比於矩陣或網格,圖結構能更靈活表示物件部件之間的關係,進而達到更理想的效果。

#來源:Vision GNN@NeurIPS 2022

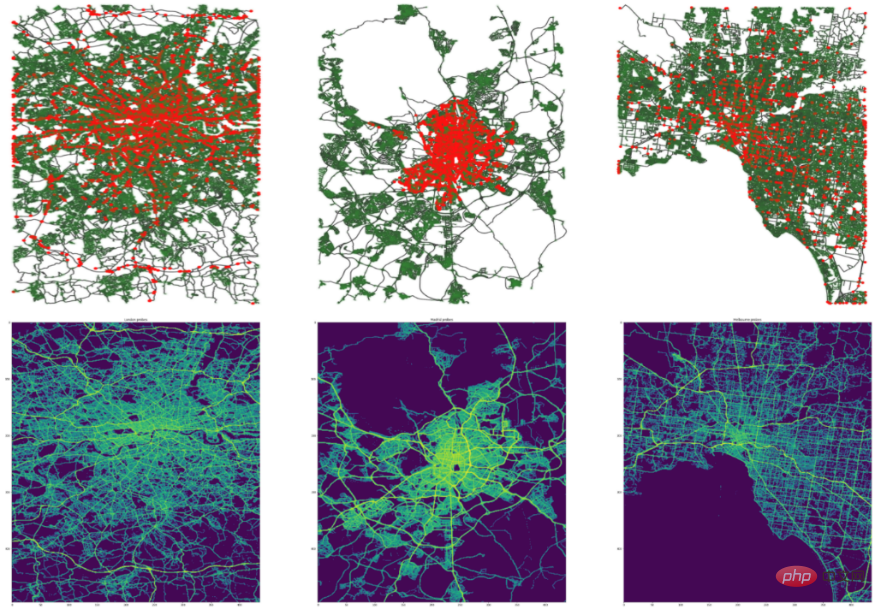

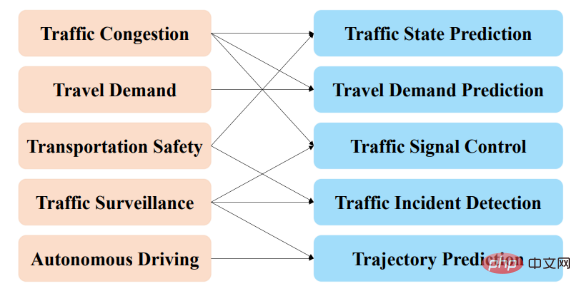

智慧交通:交通的智慧管理是現代城市的熱門議題。準確預測交通網路中的交通速度、交通量或道路密度,在路線規劃和流量控制中至關重要。由於交通流具有高度的非線性和複雜性特點,傳統機器學習方法難以同時學習空間和時間的依賴關係。網路出行平台以及物流服務的蓬勃發展為智慧交通提供了豐富的數據場景,如何利用神經網路來自動學習交通數據中的時空關聯性從而實現更好的交通流量分析以及管理成為研究的熱點。由於城市交通(如下圖)天然就是以不規則的網格形式存在,將圖神經網路用於智慧交通管理是非常自然的探索。

#來源:Traffic4Cast@NeurIPS 2022

例如經典的時空網路STGCN則是在每個時刻對每張交通流量圖使用GCN捕捉空間特徵,對於每個節點在時間維度透過卷積捕捉時序特徵,這兩種操作交叉混合並行,實現時空兩個維度的特徵的端到端學習。也有相應的工作透過利用多源資訊建構不同視角的節點關聯圖進行資訊的聚合來實現更準確的預測效果。除了流量預測以外,圖神經網路也被用在號誌燈管理,交通事件偵測,車輛軌跡預測,道路擁塞預測等多個面向。近幾年在KDD以及NeurIPS等頂會的相關比賽也均設有相應的交通預測的賽題,winner solution基本上都有圖神經的身影。由於同時存在時空動態性,不誇張的說智慧交通領域的相關應用訴求是時空圖神經網路發展最為重要的推手。

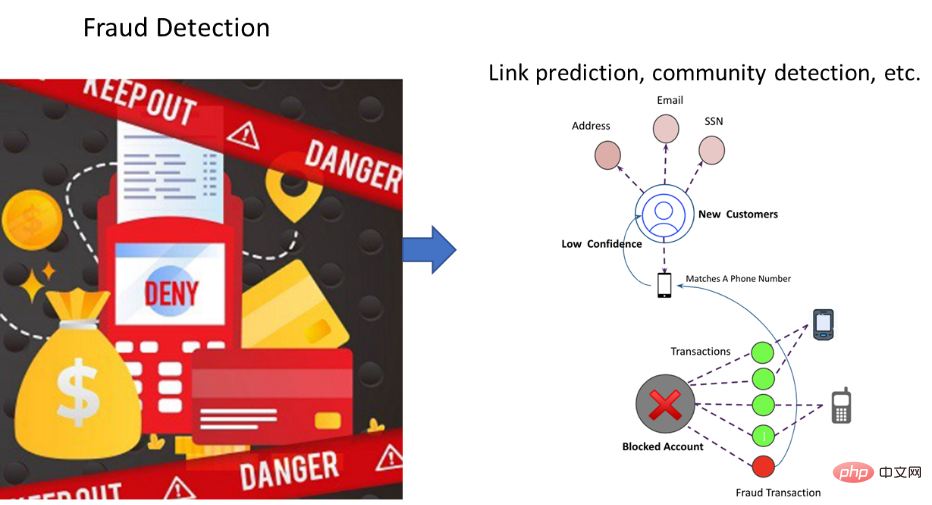

金融風控:隨著市場經濟的發展以及產業數位化的進程,大量傳統業務遷移到線上的同時,各類線上新產品和服務也與日俱增,海量的數據以及複雜的關聯關係,為金融交易以及相關審計帶來極大的挑戰。銀行信貸管理以及上市公司的風險管理等對於金融市場的秩序維護有著重要的作用。新興的支付寶、paypal等全球支付管理系統的推廣,為其保駕護航的支付風控系統在保護用戶資金安全,防止盜卡盜號,減少平台損失方面起著至關重要的作用。而傳統的演算法不足以解決具有關聯資訊的圖網絡數據的分析,得益於圖神經網路對圖數據的處理能力,一系列金融風控各個場景的實踐應運而生。例如交易流程中貸前貸中貸後的風險評估,虛擬帳號/水軍/詐欺偵測等。雖然圖深度學習技術應用在風控領域已證明是有效且必要的,但發展時間較短,整體進程還處在發展初期階段,由於行業數據的私密性,主要的技術創新還是以相應的公司為主導其中螞蟻金服以及亞馬遜較為突出。例如螞蟻金服提出的GeniePath演算法騙保識別問題,定義為一個帳戶的二分類問題,其提出的首個利用圖卷積進行惡意帳戶識別的GEM演算法主要使用於帳戶登入/註冊場景。資料的隱私性以及場景的多樣性,這也造成業界沒有統一的標準進行模型的對比驗證。最近信也科技聯合浙江大學發布的聯合發布大規模動態圖數據集DGraph提供了一個真實場景的大規模數據用於欺詐等異常檢測等場景的驗證,其中節點表示信也科技服務的金融借貸用戶,有向邊表示緊急聯絡人關係,每個節點包含脫敏後的屬性特徵,以及表示是否為金融詐騙用戶的標籤。雖然存在數據壁壘等問題,金融風控場景中普遍存在的數據不均,標籤難獲取,以及對模型可解釋性的訴求也為圖神經網路的發展帶來了新的思考和機會。

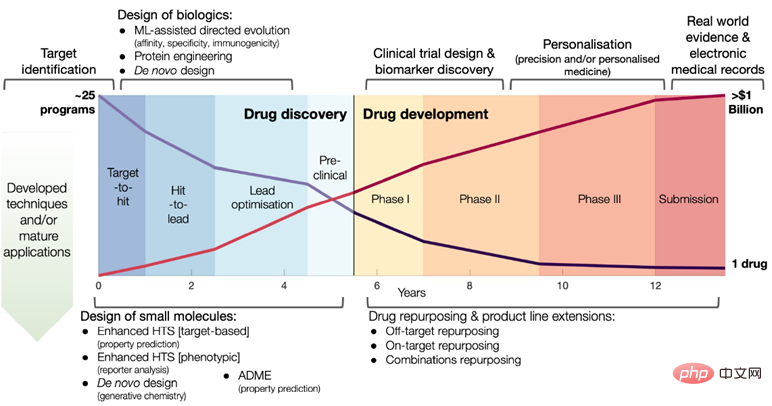

藥物發現:藥物開發是一個週期長、費用高且風險高的大工程,從最初的藥物設計、分子篩選,到後期的安全測試、臨床試驗,新藥研發週期大約需要花費10-15年,平均每一款藥的研發成本將近30億美金,在此過程中,1 /3的時間和費用都花在藥物發現的階段。特別是面對COVID-19等流行病的爆發,如何有效地利用深度學習模型,快速發現可能的、多樣化的候選分子,加速新藥的開發進程,引發許多研究人員的思考和參與。

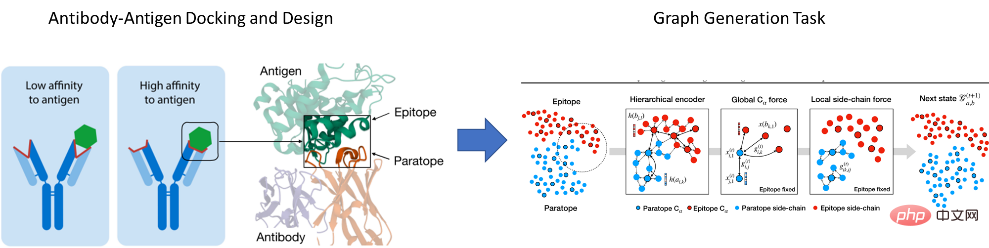

藥物研發中涉及的分子化合物、蛋白質等等物質天然是以圖結構存在。以分子為例,圖的邊可以是分子中原子之間的鍵或蛋白質中胺基酸殘基之間的相互作用。而在更大的範圍內,圖可以代表更複雜的結構(例如蛋白質,mRNA或代謝物)之間的相互作用。在細胞網絡中,結點可以表示細胞、腫瘤以及淋巴,邊表示他們之間的空間鄰近關係。因此將圖神經網路於分子特性預測,高通量篩選,新型藥物設計,蛋白質工程和藥物再利用等方面,具有廣泛的應用前景。例如麻省理工學院CSIAL的研究人員及其合作者發表在Cell(2020)的工作利用圖神經網路以預測分子是否具有抗生素特性。 同組人員今年提出基於圖生成方法建構基於抗原的條件生成模型來設計和特定抗原高度匹配的抗體等一系列工作。 Mila實驗室也是將圖學習應用於藥物發現的先驅者,最近也基於相應的探索開源了基於PyTorch的藥物發現機器學習平台TorchDrug。除此之外,各大科技公司近年來也在AI製藥方面進行佈局和探索,並有相應的突出成果,騰訊AI Lab“雲深”平台發佈業內首個藥物AI大型分佈外研究框架DrugOOD,以推動藥化場景中的分佈偏移(distribution shift) 問題研究,助力藥物研發產業發展。百度創辦人李彥宏發起創立的百圖生科,致力於將先進AI技術與尖端生物技術結合,建構獨特的標靶挖掘及藥物設計。

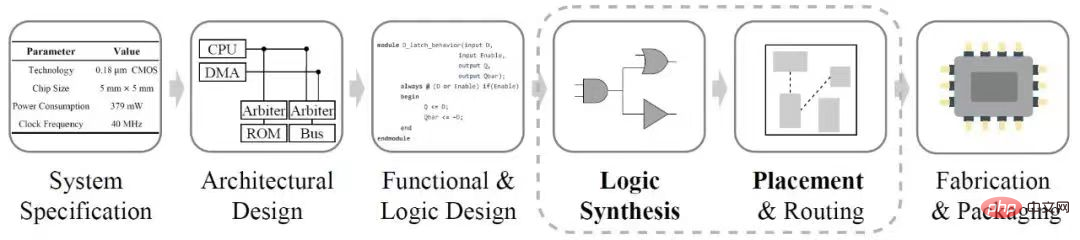

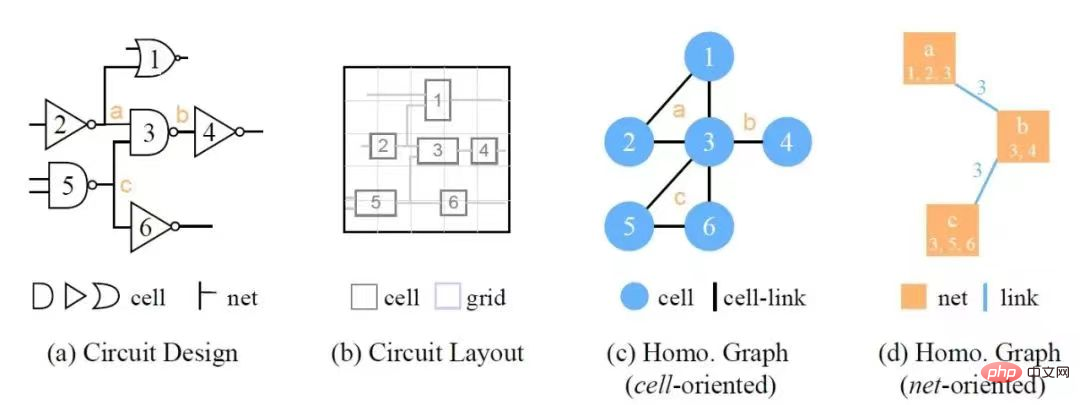

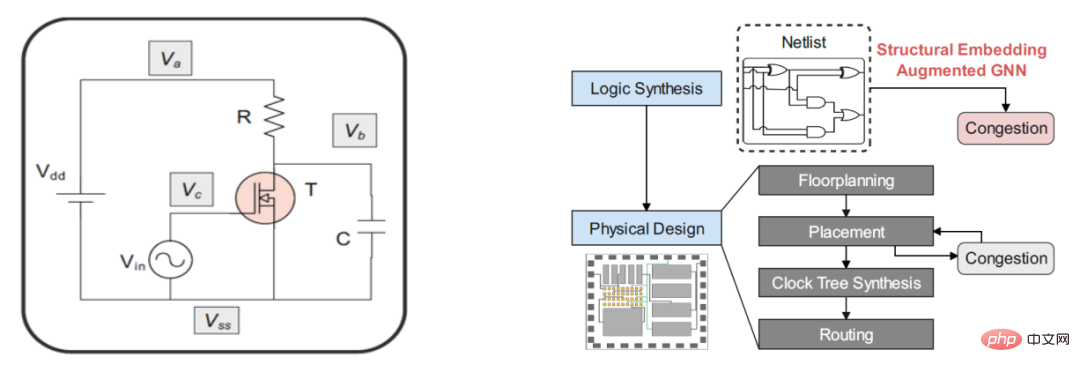

#晶片設計:晶片是數位時代的靈魂所在,也是資訊產業的三個要素之一。圖結構資料貫穿晶片設計的多個階段,例如在邏輯綜合(Logic Synthesis)階段,數位電路透過與非圖進行表示,在物理設計(Physical Design)階段,根據邏輯綜合產生的電路網表產生相關約束,工程師依照一定的密度和擁塞限制的要求,完成晶片的佈局佈線。

#隨著電路規模和複雜性的不斷增長,電子設計自動化(EDA)工具的設計效率和精度已成為一個至關重要的問題,這吸引了研究人員採用深度學習技術來輔助電路設計流程。如果能夠在晶片設計的早期階段預測電路品質和實用性,那麼晶片迭代的效率可以提升,同時設計成本也會降低。例如,在物理設計階段預測電路的擁塞可以幫助檢測其缺陷並避免產生缺陷晶片,如果可以在邏輯合成階段進行此類預測,則可以進一步節省晶片的設計生產週期。谷歌與史丹佛大學團隊將GNN成功用於硬體設計,結合強化學習,如Google TPU晶片塊的功耗、面積和性能的最佳化。針對晶片網表表徵中的多種異質訊息,華為與北京大學提出的Circuit GNN,透過整合拓樸和幾何資訊得以構圖,實現針對cell和net屬性預測的多種EDA任務性能的提升。

#除了以幾個領域外,圖神經網路也被探索應用於其他諸多問題,如程式驗證、社會影響預測、腦網路、事件偵測、模型模擬、組合最佳化問題解題。可以看出來,在科學和生活的多個領域,資料都是可以表示成圖結構。透過對結構資訊以及圖屬性資訊的有效捕捉,圖神經網路在各種圖任務上達到了較高的精度,成為解決圖相關問題的有效手段,我們相信在未來許多的領域以及場景都可以看到圖神經網路的身影。

#4、圖神經網路的可拓展性

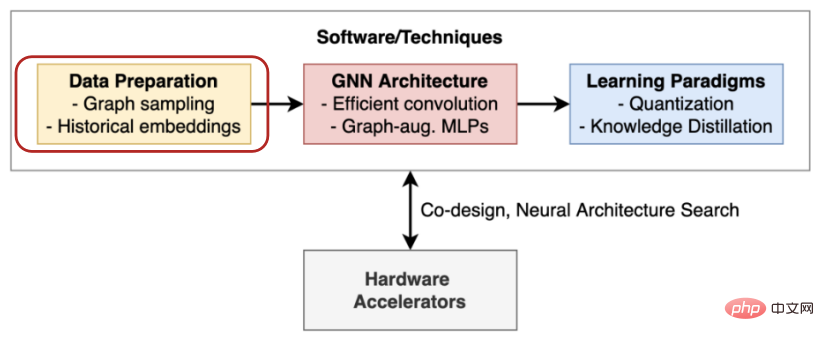

在前面的內容我們介紹了圖模型的一些基本範式以及相應的應用場景,我們可以看到圖神經網路作為一種新的深度學習架構,在社群網路、推薦系統、生物醫學發現等不同領域都大放異彩。然而實際的應用中,圖模型的擴展性以及可用性還是有許多的理論和工程挑戰。首先是記憶體限制。 GCN在設計之初其捲積操作是在全圖上進行,即每層的捲積操作都會遍歷全圖,在實際應用中,所需的內存和時間的開銷都是不可接受的。另外,在傳統的機器學習框架中,模型的損失函數可以分解為單一樣本的損失總和,因此可以使用mini batch和隨機最佳化來處理比GPU記憶體大得多的訓練集。然而,GNN的訓練中,與樣本獨立的機器學習標準資料集不同,網路資料的關係結構會在樣本之間產生統計依賴性。直接透過隨機採樣進行Mini-Batch訓練往往會導致模型效果大打折扣。然而,要確保子圖保留完整圖的語義以及為訓練GNN提供可靠的梯度並不是一件簡單的事情。其次是硬體限制。相對於圖像資料以及文字資料圖本質上是一種稀疏結構,因此需要利用其稀疏性來進行高效和可擴展的計算,但是目前的相應深度學習處理器以及相關硬體的設計都旨在處理矩陣上的密集運算。這節我們主要對圖模型的可拓展性做一些總結。參考劍橋大學在讀博士生 Chaitanya K. Joshi的總結相關工作可以歸納為資料預處理、高效的模型架構、新的學習範式以及硬體加速四個方面(如下圖所示)。

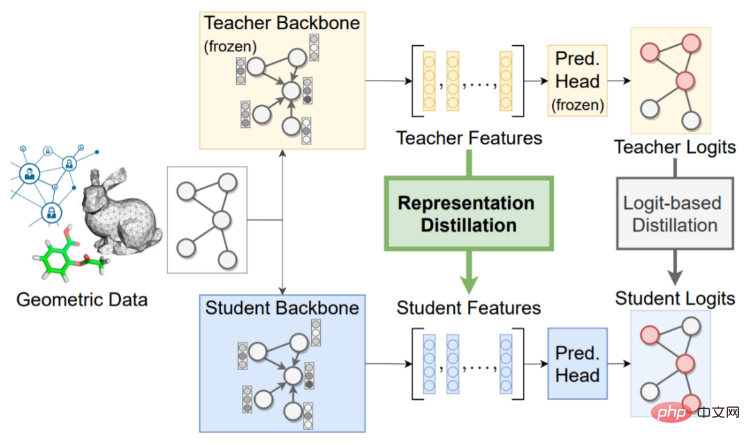

其中資料預處理一般是透過對原始資料進行取樣或簡化的方式實現大規模圖資料的計算(下面我們會再進一步展開)。新的架構的則是從一些特定任務或資料的角度出發,提出了一些新的更有效率簡潔的架構。例如LightGCN省去了相鄰節點間的內積部分從而實現運行速度的加速。一些工作也發現在節點特徵上運行 MLP 後利用標籤傳播方法也可以達到不錯的效果。除此之外,我們也可以透過一些輕量化的學習範式例如知識蒸餾或量化感知訓練,來提高 GNN 的表現並降低延遲。指的提的一點是,上述提及的幾種圖神經網路加速訓練的方式都是相互解耦的,這意味在實際場景中都是可以同時採取多種方法配合使用。

來源:G-CRD@TNNLS

相較於模型的最佳化以及新的學習範式等方式,資料預處理是更為通用以及適用性更強的方法,也是目前相對而言,我們這邊稍微展開進行分析和介紹。整體而言,資料預處理的方式都是透過一些取樣或圖簡化的方式來減少原圖的規模從而可以滿足記憶體的限制。

1、基於取樣的資料處理

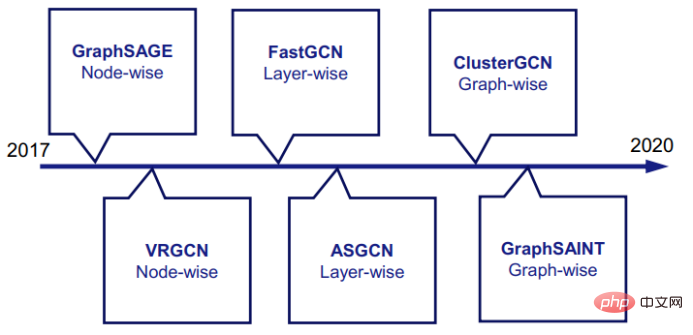

#基於取樣的方法可以分為三小類,Node -Wise Sampling,Layer-Wise Sampling和Graph-Wise Sampling。

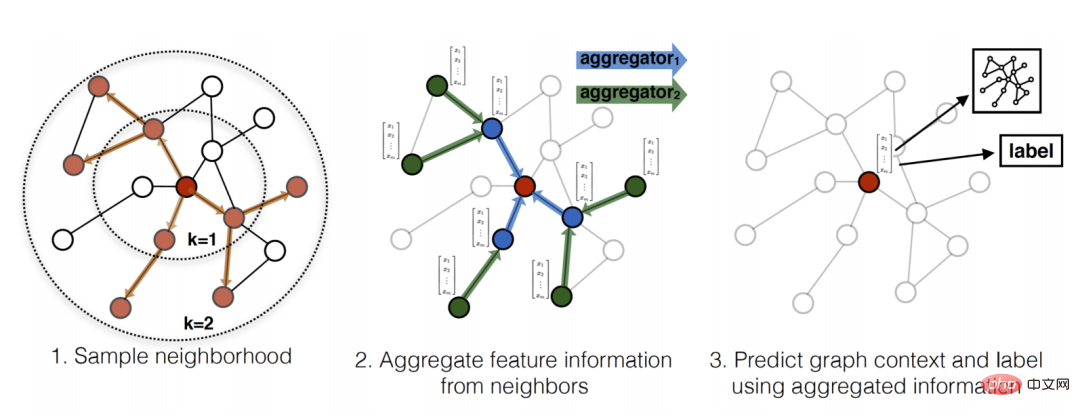

Node-Wise Sampling:由GraphSage首次提出,是一種比較通用有效以及應用得最多的方式。一層GraphSAGE 從1-hop 鄰居聚合訊息,疊加k 層GraphSAGE 就可以使得感受野增大為k- hop 鄰居誘導的子圖,同時對鄰居做均勻採樣,可以控制聚合操作的速度,更少的鄰居意味著更少的計算。不過要注意的是隨著層數的在增加,採樣到的鄰居數量也會指數增加最後仍然會等價於k-hop跳鄰居誘導的子圖上做消息聚合,時間複雜度並沒有實質性的改進。

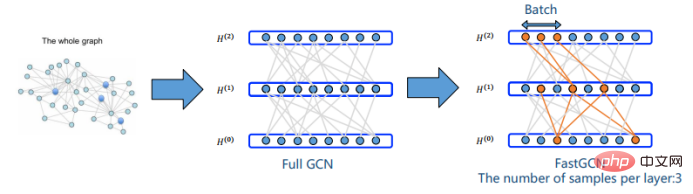

#Lay-Wise sampling:# #由Fast GCN首次提出,與GraphSAGE 不同,它直接限制了節點的鄰居採樣範圍,通過重要性採樣(importance sampling)的方式,從所有節點中採樣在一個小批次內GraphSAGE 的每個樣本節點的鄰居集合是獨立的,而Fast GCN 的所有樣本節點共享同一個鄰居集合,所以能夠把計算複雜度直接控製到線性級別,但是需要注意的是當我們待處理的圖是大而稀疏的時候,該方法採樣所得的相鄰層的樣本可能根本沒有關聯,導致無法學習。

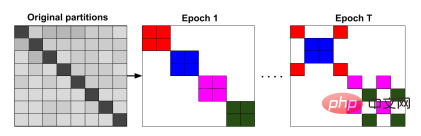

Graph-wise Sampling:與鄰居採樣的方法不同,圖採樣技巧是從原圖上採樣子圖,例如Cluster GCN 使用聚類的思想,把圖分成小塊進行訓練以實現圖採樣。圖聚類演算法(例如METIS)讓相似的節點分在一起,使得類別內的節點分佈和原圖的節點分佈有偏差。為了解決圖採樣帶來的問題,Cluster GCN 在訓練時同時抽取多個類別作為一個批次參與訓練,對節點分佈進行平衡。不過基於結構為基礎的採樣方法資訊損失較大, 大多數據上效果比full-batch的GNN差距大,每個epoch都需要進行採樣,時間開銷並不小。

除了取樣,透過一些圖簡化的方式(Graph reduction)縮小原圖的規模的同時保留關鍵的屬性以便後續的處理和分析也是可行的方向。圖簡化主要包含圖稀疏化(Graph Sparsification):減少圖中邊的數量和圖粗化(Graph coarsening):減少圖中頂點的數量。

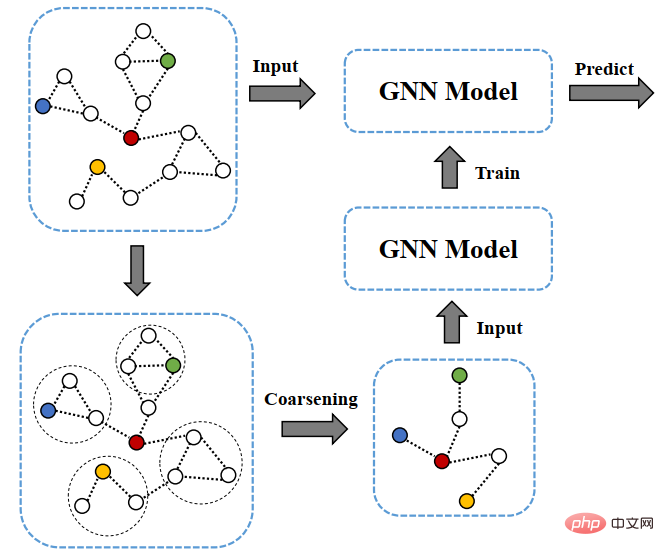

其中圖粗化(graph coarsening)通過」捏點」的方式把一些subgraph聚合成一個super- node從而實現原圖規模的化簡對於是一個合適的框架。將圖粗化用於GNN加速訓練的演算法首次在KDD 2021年的工作提出,流程如下圖所示:

首先使用圖粗化演算法(例如譜聚類粗化)把原圖進行粗化,並在粗化後的圖G′ 上進行模型訓練,從而實現圖神經網路訓練所需的參數的降低,以及減少訓練消耗時間和運行記憶體開銷。此方法通用簡單且具有線性的訓練時間和空間。作者的理論分析也表明,在譜聚類(spectral clustering)粗化後的圖上做的 APPNP 訓練,等價於在原圖上做受限的 APPNP 訓練。但是,和圖採樣方法一樣,基於圖粗化的方式也是需要對資料進行預處理,時間開銷和實驗效果和粗化演算法的選擇有關。 #

同樣的上述介紹的幾種基於採樣或者簡化的圖模型擴展方法同樣也是方法都是相互解耦的,這意味著可以同時採取多種方法配合使用,如Cluster GCN GraphSAGE。從本質上來說,在k-hop鄰居誘導的子圖上進行訊息的聚合是指數級的運算,在不損失資訊的情況下難以將基於節點採樣的演算法時間複雜度控制在線性級;而進行預處理將原圖降採樣是一個不錯的解決思路,因為如果能將整個圖都放入內存進行運算,GCN的時間複雜度就是線性的,但是預處理的成本是不能忽略的。天下沒有免費的午餐,對於圖神經網路的訓練加速其實還是在資訊損失和預處理開銷上做權衡,需要根據實際情況採用不同的方法進行分析。

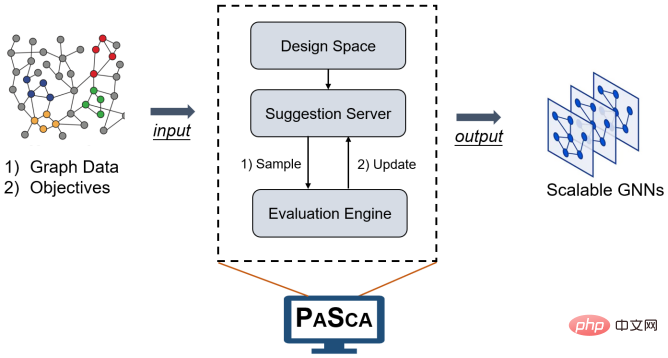

另外圖本質上是一種稀疏對象,因此在設計高效以及可拓展性的問題上應該更多從資料稀疏性的角度來進行思考。但這說來容易做來難,因為現代 GPU 旨在處理矩陣上的密集運算。雖然針對稀疏矩陣的客製化硬體加速器可以顯著提高 GNN 的及時性和可擴展性,但相關的工作還是處於發展的初期。另外面向圖運算通訊策略的設計也是最近備受關注的方向。例如VLDB2022以及Webconf 2022的Best research paper以及Best student paper award都頒給了圖模型加速處理的系統或者演算法。其中SANCUS@VLDB2022提出了一套的分散式訓練架構(SANCUS),以減少通訊量為目標,並採用去中心化的機制對圖神經網路的分散式訓練進行加速。文章不僅在理論上證明SANCUS的收斂速度接近全圖訓練,而且透過大量真實場景圖上的實驗驗證了SANCUS的訓練效率和精確度。 PASCA@Webconf2022的工作嘗試將訊息傳遞的框架中的消息聚合操作和更新操作分離,定義前處理-訓練-後處理的新範式從而實現分佈式場景下的通訊開銷。

# 來源:PASCA@Webconf2022

#5、圖神經網路設計及學習空間

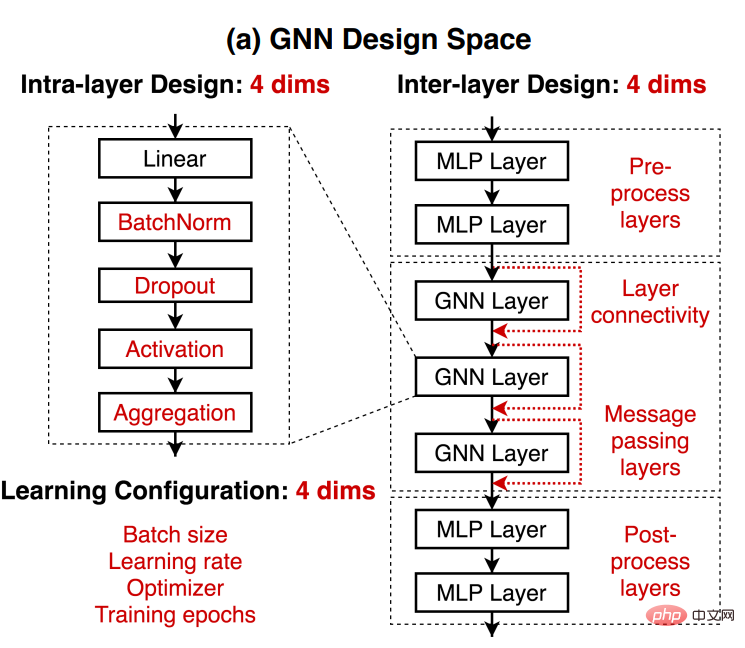

得益於運算資源的快速成長,以及深度神經網路強大的表徵能力,深度學習成為知識挖掘的重要工具。圖是一種通用的、功能強大的資料結構,它以簡潔的形式表示實體及其關係,在自然科學和社會科學的應用中無所不在。但是,現實世界中圖資料不管是結構、內容和任務上都千差萬,在某個任務上表現最佳的 GNN 網路以及架構設計可能對於另一個任務並不適用。對於一個給定的資料集和預測任務,如何能快速獲得到一個效果還不錯的模型不管對於研究人員還是應用演算法工程師都是非常有意義的一件事情。對於一個給定的資料集和預測任務,怎樣的神經網路架構是有效的?我們是否可以建立一種系統,從而自動預測出好的 GNN 設計?帶著這些思考, Jure Leskovec組2020年在他們的發表的圖神經網路設計空間的工作中根據從三個層次上定義了GNN的設計空間,這個工作也是為後續的圖自動機器以及圖模型的遷移學習奠定了基礎。

在給定某項任務、某個資料集的情況下我們可以先通過:

(1)層內設計:單獨某個GNN層的設計。

(2)層間設計:如何將GNN層連接起來。

(3)學習設定:如何進行機器學習的設定參數。

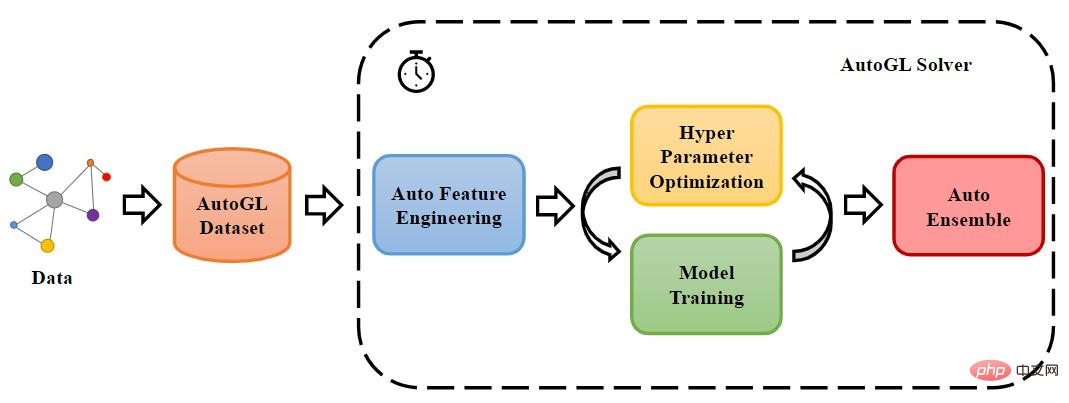

#三個方向建立對應的GNN設計空間,接著,透過對模型進行排序來量化它們在特定任務上的效能差異,從而可以了解給定資料下的最優模型設計。另外,對於新的任務以及數據,我們也可以透過簡單地計算新數據集與任務空間中已有收集的相似度,快速地識別出最相近的任務,並將其最佳模型遷移到新的數據集上進行訓練。透過這種方式,對於先前從未使用過的資料集上也可以較為快速的得到較優的模型。當然不管是圖上的自動機器學習以及圖模型的可遷移性,不管是學術研究或是工業應用中都是非常重要的問題,最近2年也是有非常多相關的一些探索和思考,這邊我們就不再展開,更多關於圖自動機器學習的工作建議大家可以關注學界清華朱文武老師組相關的綜述以及他們開源的自動學習工具包AutoGL以及業界第四範式的相關工作。

來源:AutoGL

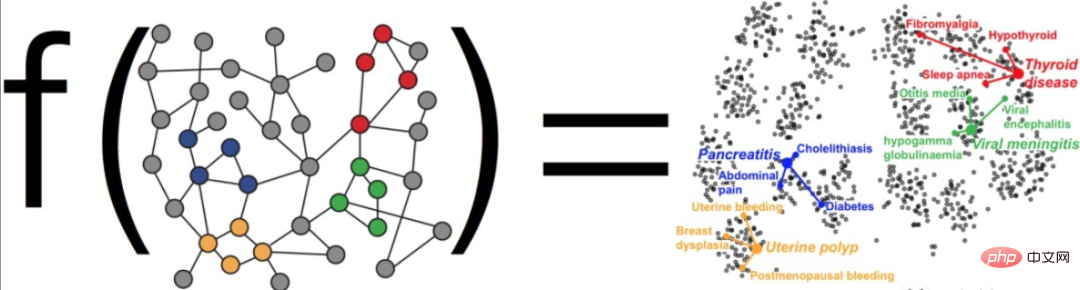

前提到的模型設計空間主要集中模型結構層面,但是還有另一個非常重要的維度是模型的表徵或學習空間也是非常有必要進行補充。圖機器學習作為圖資料上進行表徵學習的一種手段目標不是透過學習原始資料預測某個觀察結果,而是學習資料的底層結構(underlying structure),從而可以更好地對原始資料進行相應的特徵學習與表達,在下游任務上取得更好的效果。

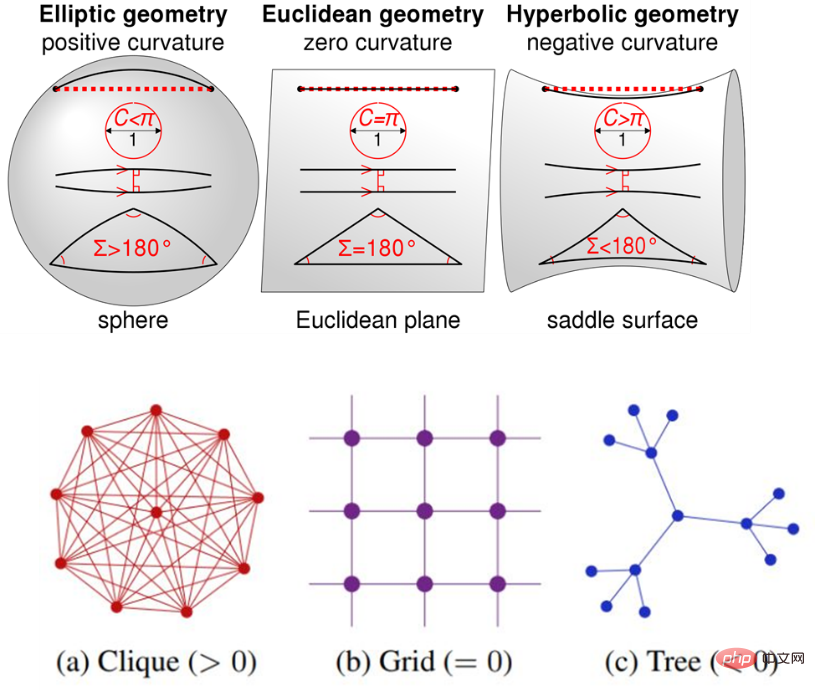

目前的大多數表徵學習都是在歐幾里德空間中進行的,因為歐幾里德空間是自然的概括我們的直覺友善的視覺空間同時具有很好的計算以及運算優勢。但是眾所周知,圖是非歐幾裡得結構的,例如複雜網絡領域的研究表明,現實的網絡數據(社交網絡,商品網絡,電信網絡,疾病網絡,語義網絡等)中大量存在著無標度性質( scale-free),意指現實中普遍存在著樹狀(tree-like)/層次結構。利用歐式空間作為表徵學習的先驗空間進行對應的建模必然會造成對應的誤差(distortion)。因此基於不同的曲率空間的表徵學習最近也引起了大家的注意。曲率是一個衡量空間彎曲程度的量,曲率越接近零,空間越平。在科幻小說《三體》中,人類正是利用空間曲率的變化建造出曲率飛船。如下圖所示, 歐氏空間各處均勻且平坦,具備各向同性及平移不變性,因此適合建模網格資料。具有正曲率的球面空間距離度量等價於角度度量,具有旋轉不變性,因此適合建模環狀資料或稠密均勻的圖形資料結構。而負曲率的雙曲空間距離度量等價於冪律分佈,適合建模無尺度網路或樹狀結構。

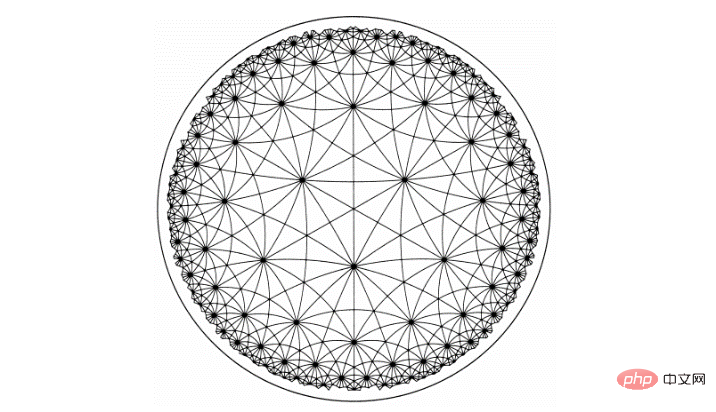

#由於現實的網路資料中大量存在著無標度性質(scale-free),意味著現實中普遍存在著樹狀(tree-like)/層次結構。其中,雙曲空間在傳統網路科學領域被視為樹狀/層次結構的連續表達形式,因此也更適合用於實際資料的建模,最近也是湧現出許多優秀的工作。另外相較於歐式空間,雙曲空間的容積隨著半徑指數級增長,因此具有更大的嵌入空間。與歐式空間不同的是,雙曲空間有多個模型可以刻畫,我們以下以Poincare Ball(龐加萊球)為例子簡單介紹一下。

龐加萊盤是透過將嵌入空間限制在單位球內的一種雙曲模型。在龐加萊球的雙曲線模型中,上面所有明暗相間的三角形都是相同大小的,而在我們歐式的角度去看,靠近邊緣區域的三角形相對較小。換一種理解的方式,如果以歐式的角度看,把上面圓的中心當作原點,隨著半徑的增加,三角形的個數是越來越多的

我們可以想像一下,使用雙曲空間建模就像「吹起一個氣球」。假設一個乾癟的氣球表面上有十億個節點,這會是非常緻密的狀態。隨著氣球逐漸充氣變大,氣球表面越來越“彎曲”,節點之間就分的越開。阿里媽媽技術團隊將曲率空間(Curvlearn)用於基於淘寶搜尋廣告場景,系統全量上線後,儲存消耗量降低 80%,用戶側請求匹配精準度相對提升15%。除了推薦系統外,雙曲圖模型在多種不同的場景上都展現了優異的效果,對相關內容感興趣的同學也可以參考我們今年在ECML-PKDD上雙曲圖表徵學習的相關教程(主頁傳送門:https://hyperbolicgraphlearning.github.io/ )或弗吉亞理工和亞馬遜等學者在WebConf的雙曲神經網路相關教學。

6、圖神經網路訓練系統、框架、基準平台

#圖神經網路演算法將深度神經網路的運算(如卷積、梯度計算)與迭代圖傳播結合在一起: 每個頂點的特徵都是由其鄰居頂點的特徵結合一組深度神經網路來計算。但是,現有的深度學習框架不能擴展和執行圖傳播模型,因此缺乏高效訓練圖神經網路的能力。另外現實世界中的圖資料規模龐大,且頂點之間具有複雜的依賴性,例如Facebook的社群網路圖包含超過20億個頂點和1兆條邊,這種規模的圖在訓練時可能會產生100 TB的數據,不同於傳統的圖演算法,平衡的圖分區不僅依賴分區內的頂點數量,還依賴分區內頂點鄰居的數量,多層圖神經網路模型中不同頂點多階鄰居的數量可能相差極大,並且這些分區之間需要頻繁的資料交換,如何對圖資料進行合理的分區來確保分散式訓練的性能是對於分散式系統的重大挑戰。另外圖資料是非常稀疏的,從而這會導致分散式處理中的頻繁的跨節點訪問,產生大量的訊息傳遞開銷。 所以如何針對圖的特殊性質減少系統開銷是提高系統效能的一大挑戰。工欲善其事,必先利其器。 為了支援圖神經網路在大規模圖上的應用,以及更複雜圖神經網路結構的探索,開發針對圖神經網路的訓練系統是十分必要的。首先要提的是最知名的兩個開源框架PyG (PyTorch Geometric)和DGL (Deep Graph Library),前者是主要由史丹佛大學以及多特蒙德工業大學共同開發的基於PyTorch的圖神經網路庫,含了許多GNN相關論文中的方法實現和常用數據集,並且提供了簡單易用的接口,後者則是由紐約大學以及亞馬遜研究院聯合主導開發的圖學習框架,作為最早的學術以及工業界開源框架,兩者都擁有活躍的社區支持。

除此之外很多公司根據自身業務特點,也紛紛建立自有的圖神經網路框架以及資料庫例如:NeuGraph、EnGN、PSGraph、AliGraph、Roc、AGL、PGL、Galileo、TuGraph、Angle Graph等。其中AliGraph由阿里巴巴運算平台和達摩院智慧計算實驗室開發的採樣建模訓練一體化的圖神經網路平台。 PGL (paddle graph learning)是由百度開發的基於PaddlePaddle的相應圖學習框架。 Angle Graph是騰訊TEG數據平台推出的大規模高效能圖運算平台。

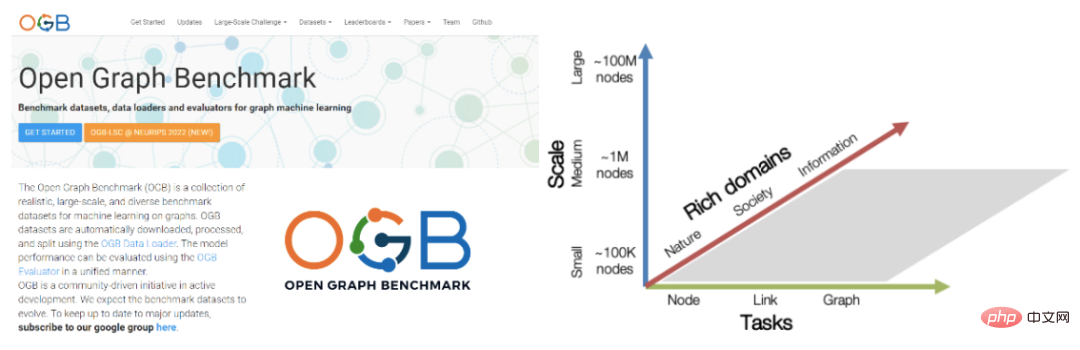

#我們再來聊聊基準平台的問題。在深度機器學習的核心研究或應用領域中,基準資料集以及平台都有助於識別和量化哪些類型的架構,原理或機制是通用的,並且可以推廣到實際任務和大型資料集。例如神經網路模型的最新革命都是由大規模的基準影像資料集ImageNet觸發的。相對於網格或序列數據,圖數據模型發展相對而言仍處於自由生長的階段。首先,資料集往往規模太小,與現實場景不符,這意味著我們很難可靠且嚴格地評估演算法。其次,評估演算法的方案不統一。基本上,每個研究工作論文都使用了自己的「訓練集/測試集」資料分割方式和效能評測指標。這意味著我們很難進行跨論文跨架構的效能比較。此外,不同的研究員往往在劃分資料集時採用傳統的隨機劃分方法。為了解決圖學習社區,資料、任務資料劃分方式以及評估方案不一致的問題,史丹佛大學的Jure Leskovec團隊在2020年推出了圖神經網路基準平台奠基性的工作Open Graph Benchmark(OGB)。

OGB包含一些可以現成使用的用於圖上的關鍵任務(節點分類、連結預測、圖分類等)的資料集,同時也包含了通用的程式碼庫,以及效能評測指標的實作程式碼,可以進行快速的模型評估和比較。此外,OGB還設有模型表現排行榜(leaderboard),可以方便大家快速的跟進相應的研究進展。另外,2021年,OGB聯合KDD CUP 與舉辦了第一屆OGB-LSC(OGB Large-Scale Challenge)比賽,提供來自真實世界的超大規模圖數據,來完成圖學習領域的節點分類、邊預測和圖回歸三大任務,吸引了包括微軟、Deepmind、Facebook、阿里巴巴、百度、位元組跳動、史丹佛、MIT、北京大學等眾多頂尖大學和科技公司參與。今年在NeurIPS2022的競賽track中,根據KDD杯的經驗,更新了相應的數據集並組織了第二屆OGB-LSC競賽,獲獎方案目前已經公開

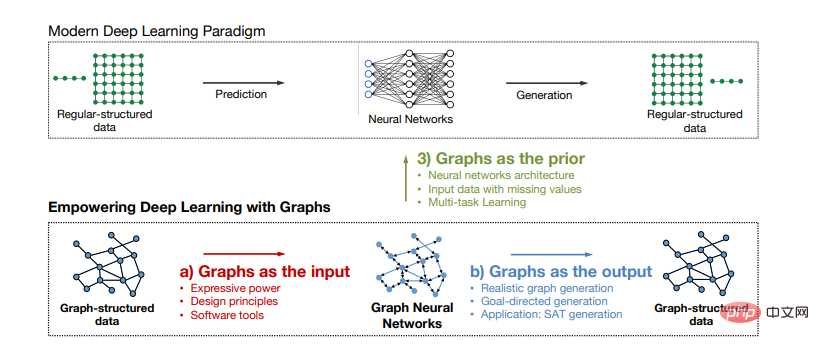

(快速熟悉一個領域的好方法是閱讀級實驗室剛畢業同學的博士論文,SNAP實驗室的Rex YING以及尤佳軒必須是要擁有姓名, 分別於2016年以及2017年開始在Jure Leskovec的指導下開始進行圖學習相關的研究,許多成果也成為了圖學習發展歷程路標性工作也分別在各自博士論文《Towards Expressive and Scalable Deep Representation Learning for Graphs》和《Empowering Deep Learning with Graphs》也是進性了相應的梳理。)

7、總結和展望

經過十幾年的發展以及最近各行業內產業落地的應用以及實驗室中理論的不斷迭代,圖神經網路在理論上和實踐上都被證實是對圖結構資料處理的有效方法和框架。圖作為一種通用簡潔以及強大的資料結構,不僅可以作為圖模型的輸入輸出來進行非歐結構資料的挖掘和學習,也可以作為一種先驗結構應用於歐式資料(文字以及圖片)的模型應用中。 從長遠來看,我們相信圖資料 神經網路將會從一個新興研究領域轉變為用於機器學習研究和應用的標準資料 模式範式賦能更多的產業與場景。

#(不能免俗做個展望)儘管GNN 近年來來在諸多領域取得了巨大的成功,但是隨著應用場景的擴展以及實際動態變化以及未知的開放環境,除了前文中提及過的諸多問題以及挑戰之外仍然有許多的方向值得進一步的探索:

#圖神經網路新場景以及新範式:在現實世界中,大到星球引力小到分子交互,幾乎萬物可以看做以某種關係連接起來,繼而都可以視為一個圖。從社交網路分析到推薦系統以及自然科學,我們看到了圖神經網路在各個領域的相關應用探索以及從應用問題中引發的模型發展,例如智慧交通中的時空交互,金融風控場景中的類別不平衡,生物化學領域中的分析結構區分問題等,因此如何在不同場景中自適應地學習與場景有關的特徵依舊是重要的方向。除此之外,一方面目前GNN的主要是基於訊息傳遞範式,利用訊息傳遞,訊息聚合,訊息更新三個步驟,如何讓訊息傳遞,聚合,更新變得更合理、更有效率對GNN是目前較為重要的工作;另一方面基於訊息傳遞框架以及同配性假設引起的資訊過平滑問題以及資訊瓶頸也會制約其在更複雜的資料以及場景下的效果。整體而言,大多數GNN總是藉鑒計算機視覺以及自然語言處理中的一些思路,但是如何打破借鑒的規則,基於圖數據的歸納性偏好設計更加強大的模型,給圖神經網絡注入專屬於它的靈魂,也會是領域研究者持續思考與努力的方向。

圖結構學習:圖神經網路和傳統神經網路的主要區別就是以圖的結構為指導,透過聚合鄰居訊息來學習節點表示。其中的應用實際上有個潛在的假設:圖結構是正確的,即圖上連接都是真實可信的。例如,社交圖中的邊暗示了真實的朋友關係。但是,實際上圖的結構並不是那麼的可靠,噪音連接和偶發連接都是普遍存在的。錯誤的圖結構加上GNN的擴散過程,會極大的降低節點表示及下游任務的表現(garbage in,garbage out)。因此如何更好的進行圖結構的學習以及不同資料場景如何建構更可信的圖結構是一個重要的方向。

可信任圖神經網路:由於訊息傳遞機制和圖資料non-IID的特點,GNNs對於對抗攻擊性十分的脆弱,容易被節點特徵和圖結構上的對抗性擾動影響。例如,詐騙犯可以透過創造和一些特定高信用用戶的交易來逃脫基於GNNs的詐騙檢測。所以研發穩健的圖神經網路對於一些安全風險較高的領域是十分有必要的。另一方面,隨著全社會對隱私保護日益重視的背景下,圖神經網路的公平性以及對於資料隱私保護也是最近研究的熱點。例如,阿里達摩院2022年針對圖資料的聯邦學習開源平台FederatedScope-GNN,今年也是獲得了KDD 2022的最佳應用論文。另外,如何讓訓練好的圖模型遺忘掉特定資料訓練效果/特定參數, 以達到保護模型中隱含資料的目的的遺忘學習(Graph unlearning)也是一個值得討論的方向。

可解釋性:深度學習模型雖然實現了許多任務上傳統方法望塵莫及的性能,但是模型的複雜性導致其可解釋性往往較為限制。然而,在生物資訊學健康以及金融風控等眾多高敏感度領域中,在評估計算模型和以及更好地理解潛在機制時,可解釋性非常重要。因此,設計具有可解釋性或可以更好地視覺化複雜關係的模型/架構最近也引起了較多的關注。目前已有的工作主要還是較多參考借鑑於文字和圖像中對於可以解釋性的處理方式。例如基於梯度變化或輸入擾動的方法(e.g GNNExplainer)。近期,一些研究人員嘗試利用因果篩選的方對可解釋性衡量框架進行探索,從而更好地引出基於不變學習的內在可解釋性的圖神經網路,也為圖模型的可解釋性提供了一些新的思路。

#分佈外泛化:一般的學習問題都是在一個訓練集上完成模型訓練,而後模型需要在一個新的測試集上給出結果,當測試資料分佈與訓練分佈呈現明顯不同時,模型的泛化誤差則很難被控制。目前大多數的圖神經網路(GNN)方法沒有考慮訓練圖和測試圖之間的不可知偏差,從而導致GNN在分佈外(OOD)圖上的泛化表現變差。然而現實中的許多場景要求模型與開放動態的環境進行交互,模型在訓練階段需要考慮未來新出現的實體或來自未知分佈的樣本,例如推薦系統中新出現的用戶/商品,在線廣告系統中新平台的使用者畫像/行為特徵,動態網路中新出現的節點或連邊關係等。因此如何利用有限的觀測數據,學習一個穩定的GNN模型,能夠泛化到未知或數據有限的新環境也是一個重要的研究方向。

圖資料預訓練以及通用模型:#預訓練範式在電腦視覺以及自然語言處理的領域取得革命性成功,在諸多任務中證明了其強大的能力。雖然GNN已經具備了一些相對成熟的模型以及成功的應用,但是當前仍囿於面向特定任務使用大量標註資料訓練模型的深度學習,當任務改變或標籤不足時往往效果就會差強人意。因此也自然引發大家對於在圖數據場景進行通用模型的探索與思考。預訓練的關鍵在於豐富的大量訓練資料, 可遷移的知識,強大的骨幹模型以及有效的訓練方法。相較於電腦視覺以及自然語言處理中較為明確的語義訊息,因為不同的圖資料結構千差萬別,圖中什麼知識是可遷移的仍然是一個較為開放的問題。另外,目前深層以及通用的GNN模型雖有研究但仍未帶來革命性的提升。幸運的是,圖機器學習社群已經累積了大規模的圖數據,並且已經發展出諸如圖重構的自我監督訓練方法。隨著後續深層GNN、表達能力更強的GNN以及圖自監督新範式等研究的進一步探索,相信最終實現泛用性強的通用模型。

軟硬體協同:隨著圖學習的應用和研究發展的推進, GNN肯定會更深入地整合到PyTorch, TensorFlow,Mindpsore等標準框架和平台中。進一步提高圖模型的可拓展性,更加硬體親和的演算法框架以及軟體協同的硬體加速方案是大勢所趨。雖然面向圖神經網路應用的專用加速結構慢慢湧現,為圖神經網路客製化計算硬體單元和片上儲存層次,優化運算和存取行為的專屬晶片已有一些成功,但是這些技術仍然處理早期的階段,面臨巨大的挑戰以及相應也是提供了許多的機會。

#以上是深度學習中的拓樸美學:GNN基礎與應用的詳細內容。更多資訊請關注PHP中文網其他相關文章!