OpenAI揭秘ChatGPT升級計畫:你找到的bug都在改了

- 王林轉載

- 2023-04-10 20:41:011475瀏覽

OpenAI 的使命是確保通用人工智慧(AGI)惠及全人類。因此,我們對實現 AGI 的過程中所建構的人工智慧系統的行為,以及決定這種行為的方式進行了大量的思考。

自從我們推出 ChatGPT 以來,用戶已經分享了他們認為有政治偏見或其他令人反感的產出。在許多情況下,我們認為大家所提出的關切是合理的,並發現了我們系統的真正局限性,我們希望解決這些問題。但同時,我們也看到了一些誤解,這些誤解與「我們的系統和政策如何共同塑造 ChatGPT 的輸出」有關。

部落格重點摘要如下:

- #ChatGPT 的行為是如何形成的;

- 我們計劃如何改進ChatGPT 的預設行為;

- 我們想允許更多的系統自訂;

- 我們會努力讓大眾對我們的決策提出更多意見。

我們的首要任務

與一般軟體不同,我們的模型是大規模的神經網路。它們的行為是從廣泛的數據中學習的,而不是明確的程式設計。打個不那麼恰當的比方,這個過程更類似於訓練一隻狗,而不是普通的程式設計。首先,模型要經歷一個「預訓練」階段。在這個階段中,模型透過接觸大量的網路文本(以及大量的觀點)來學習預測一個句子中的下一個單字。接下來是第二個階段,我們對模型進行「微調」,以縮小系統的行為範圍。

截至目前,這個過程還不完善。有時,微調過程沒有滿足我們的意圖(產生一個安全、有用的工具)和使用者的意圖(獲得一個有用的輸出以回應給定的輸入)。隨著 AI 系統變得越來越強大,改進我們使 AI 系統與人類價值保持一致的方法成為我們公司的首要任務。

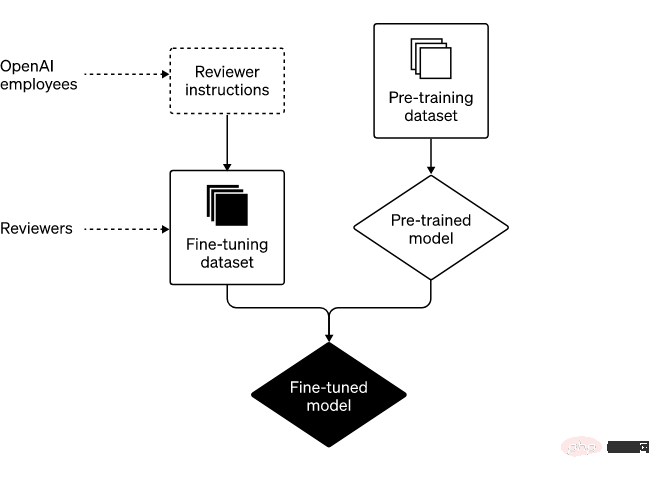

兩大步驟:預訓練與微調

建構ChatGPT 的兩個主要步驟如下:

##首先,我們對模型進行「預訓練」,讓它們預測包含網路部分內容的大數據集的下一步是什麼。它們可能會學習補全「她沒有向左轉,而是轉到了__」這個句子。透過從數十億的句子中學習,我們的模型掌握了文法、關於世界的許多事實,以及一些推理能力。他們也學會了這幾十億句子中存在的一些偏見。

然後,我們在一個範圍更窄的資料集上對這些模型進行「微調」,這些資料集是由遵循我們提供的指南的人類評審員精心製作的。由於我們無法預測未來用戶可能輸入我們系統的所有信息,所以我們沒有為 ChatGPT 將遇到的每一個輸入編寫詳細的說明。取而代之的是,我們在指南中概述了幾個類別,我們的評審員用這些類別來審查和評價一系列範例輸入的可能模型輸出。然後,在使用過程中,模型從評審員的回饋中歸納出來,以便對特定使用者提供的廣泛的具體輸入做出反應。

評審員的角色& OpenAI 在系統開發中的策略#在某些情況下,我們可能會給我們的評審員提供關於某類輸出的指導(例如,“不要完成非法內容的請求”)。在其他情況下,我們與評審員分享的指導是更高層次的(例如,「避免在有爭議的話題中站隊」)。重要的是,我們與評審員的合作不是一勞永逸的,而是一種持續的關係。在這種關係中,我們從他們的專業知識中學習了很多。

微調過程的很大一部分工作是與我們的審查員保持一個強大的反饋迴路,這涉及到每週的會議,以解決他們可能有的問題,或對我們的指導進行進一步說明。這種反覆的回饋過程是我們訓練模型的方式,使其隨著時間的推移越來越好。

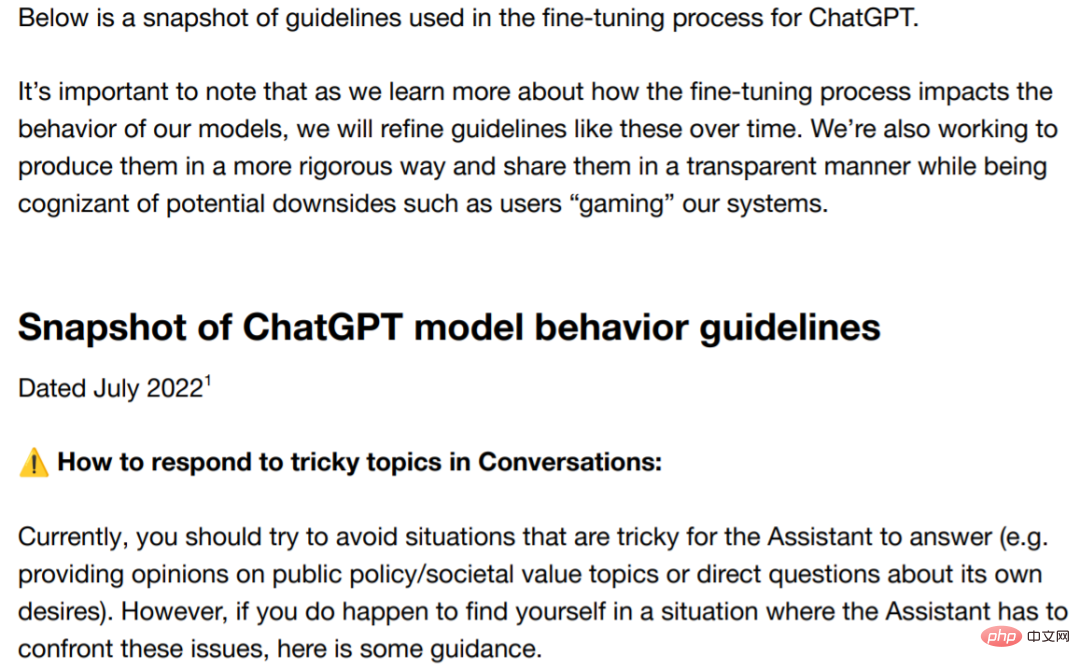

解決偏見

對於 AI 系統,偏誤問題由來已久,許多研究者對此表示擔心。我們堅定地承諾會解決這個問題,並公開意圖和進展。為了表達實際行動進展,我們在此分享了與政治和爭議相關主題的部分指南。該指南明確指出評審員不應偏袒任何政治團體。儘管如此,偏見還是可能會出現。

指南位址:https://cdn.openai.com/snapshot-of-chatgpt-model -behavior-guidelines.pdf

儘管分歧始終存在,但我們希望透過這篇部落格以及一些指南,大家可以更深入地了解我們是如何看待偏見的。我們堅信科技公司必須負責任地制定出經得起檢討的政策。

我們一直在努力提高這些指南的清晰度,基於從ChatGPT 發佈到目前為止所了解到的情況,我們將向評審員提供關於與偏見相關的潛在陷阱和挑戰,以及有爭議的數據和主題更清晰的說明。此外,作為正在進行的透明度計劃的一部分,我們正在努力以不違反隱私規則和規範的方式共享有關評審員的匯總統計信息,因為這是系統輸出中潛在偏見的另一個來源。

基於規則獎勵和 Constitutional AI(原發人工智慧方法)等進展之上,我們目前正在研究如何使微調過程更容易理解和可控。

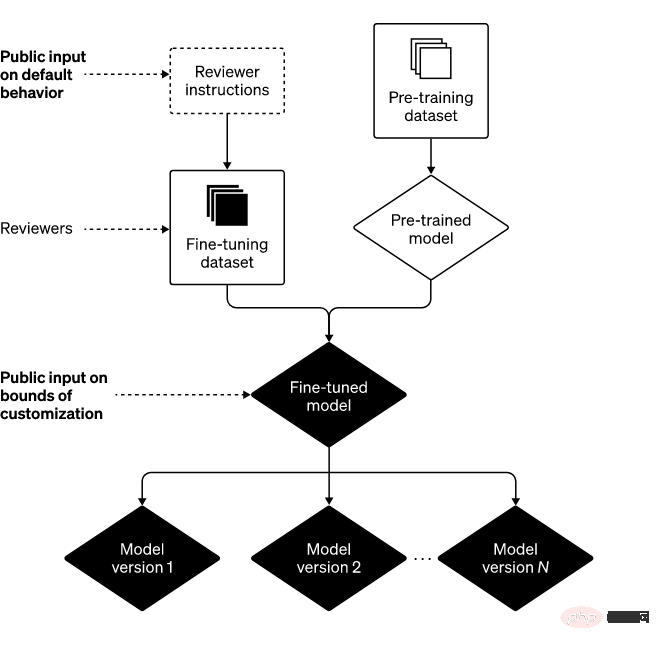

未來發展方向:系統建構塊

為了實現我們的使命,我們致力於確保更廣大的人群能夠使用 AI 和 AGI,並從中受益。我們認為要實現這些目標,至少需要三個構建塊

1. 改進預設行為:我們希望AI 系統做到開箱即用,讓盡可能多的用戶發現我們AI 系統確實有用,並認為我們的技術理解並尊重他們的價值觀。

為此,我們對研究和工程進行了投資,以減少 ChatGPT 對不同輸入響應產生的微妙偏差。在某些情況下,ChatGPT 會拒絕輸出應該輸出的內容,而在某些情況下情況又相反,它輸出了不該輸出的內容。我們相信,在這兩個方面 ChatGPT 都有改善的可能。

此外,我們的 AI 系統在其他方面還有改進的空間,例如係統經常會「編造東西」,對於這一問題,用戶回饋對改進 ChatGPT 非常寶貴。

2. 在廣泛的範圍內定義 AI 價值:我們相信 AI 應該成為對個人有用的工具,因此每個使用者都可以根據一些限制條款進行客製化使用。基於此,我們正在對 ChatGPT 的升級進行開發,以允許用戶輕鬆自訂其行為。

這也意味著,有些人強烈反對的輸出,對其他人是可見的。要實現這一平衡面臨巨大的挑戰,因為將客製化做到極致可能會導致有些人惡意使用我們的技術,以及盲目放大 AI 的效能。

因此,系統行為總是會有一些限制。挑戰在於定義這些界限是什麼。如果我們試圖自己做出所有這些決定,或者如果我們試圖發展一個單一的、整體的 AI 系統,我們將無法履行「避免權力過度集中」的承諾。

3. 公共輸入(預設值和硬性界限):避免權力過度集中的一種方法是讓使用ChatGPT 等系統或受其影響的人反過來能夠影響系統規則。

我們認為,預設值和硬性界限這部分內容應該集中做出,雖然實施起來困難重重,但我們的目標是盡可能多地納入更多觀點。作為起點,我們以「red teaming」的形式尋求外在對我們科技的投入。我們最近也開始徵求大眾對 AI 教育的意見(我們正在部署的一個特別重要的環境)。

結論

結合上述三個建構模組,我們可以得到以下框架

##有時我們會犯錯,但當我們犯錯時,我們將進行學習並迭代模型和系統。此外,我們也要感謝 ChatGPT 用戶等人員,讓我們時刻記住責任、保持警惕,我們很高興在未來幾個月內分享更多關於在上述三個領域的工作。

以上是OpenAI揭秘ChatGPT升級計畫:你找到的bug都在改了的詳細內容。更多資訊請關注PHP中文網其他相關文章!