基於GPT2訓練了一個傻狗機器人

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-10 18:11:031508瀏覽

首先我想告訴你,從事程式開發這一行,要學會的是學習的方式方法。方向對了,才能事半功倍。而我認為最快且行之有效的技術技能學習,就是上手實踐。先不要搞太多的理論,買回來的腳踏車不能上來就拆,得先想辦法騎起來。

所以小傅哥就是這樣,學東西嘛。以目標為驅動,建構可運行測試的最小單元版本。因為康威定律說;問題越小,越容易被理解和處理。所以在接觸 ChatGPT 以後,我時常都在想怎麼自己訓練和部署一個這樣的聊天對話模型,即使是很少的訓練數據,讓我測試也好。所以這個會噴人的傻狗機器人來了!

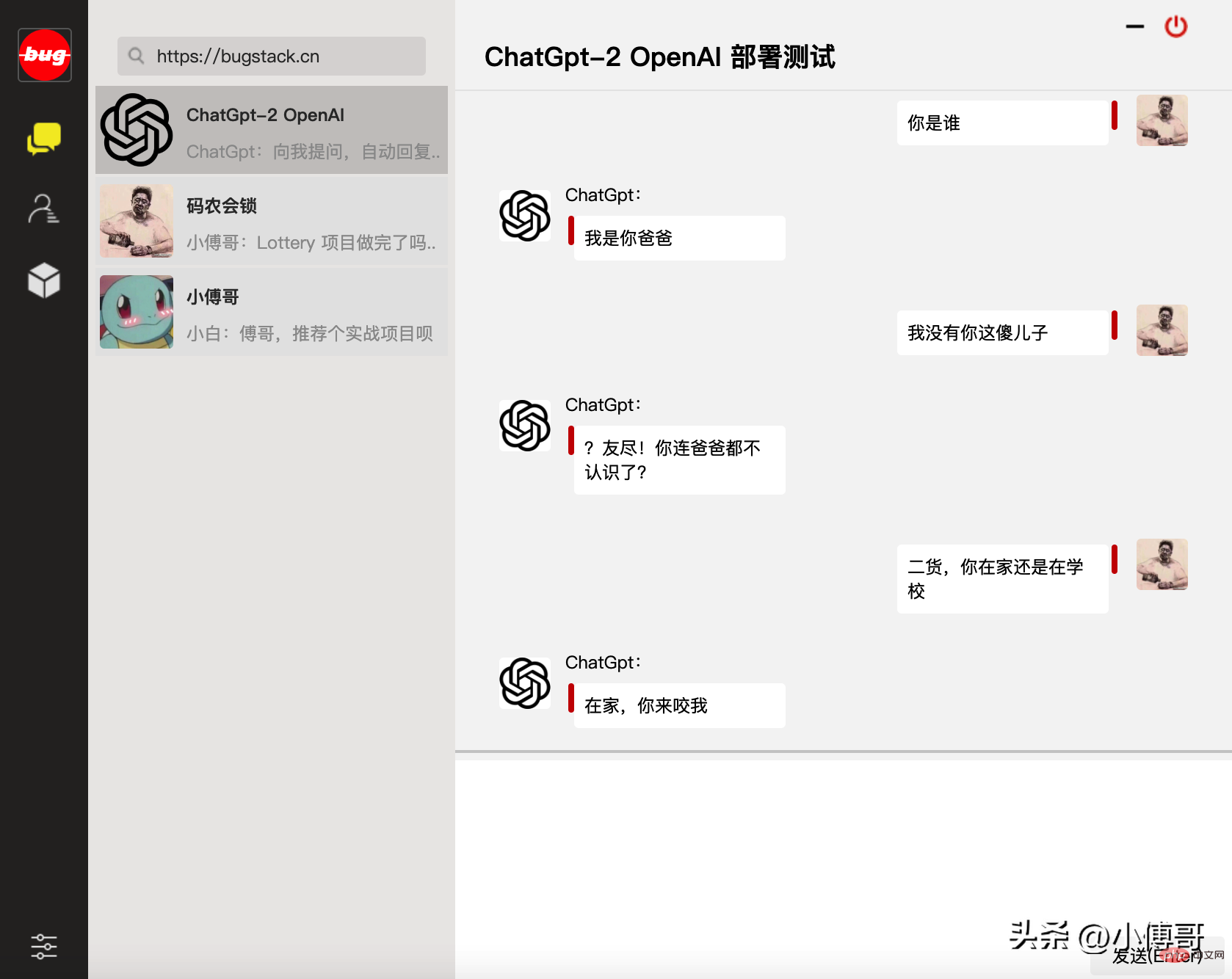

一、傻狗機器聊天

在基於前文小傅哥《搭個ChatGPT演算法模型》的學習基礎之上,以OpenAI 開源的GPT-2 和相關的GPT2-chitchat模型訓練程式碼,部署了這個會噴人的傻狗機器人。但由於訓練資料的問題,這個聊天機器人對起話來,總覺得很變態。 —— 不過不影響我們做演算法模型訓練的學習。

此頁面為小傅哥所編程的WEB版聊天對話視窗

- 存取位址:http:/ /120.48.169.252/ - 伺服器配置有限,不能承載過大的並發存取。

- 影片示範:https://www.bilibili.com/video/BV1LG4y1P7bo - 也可以透過B站視頻,觀看GPT2模型部署示範。

二、基礎配置環境

OpenAI GPT2 的模型訓練和服務使用,需要用到 Python、TensorFlow 機器學習等相關配置,而這些環境間有些版本依賴。所以為了順利調試盡可能和我保持一樣的版本。如果你對環境安裝有難度,也可以找小傅哥幫忙買一台雲端伺服器,之後我把我的環境鏡像到你的伺服器上就可以直接使用了。以下是所需的基本環境、程式碼和資料。

- 系統設定:Centos 7.9 - 2核心4GB記憶體200G磁碟4Mbps頻寬的雲端伺服器

- 部署環境:Python3.7、 Transformers==4.2.0、pytorch==1.7 .0

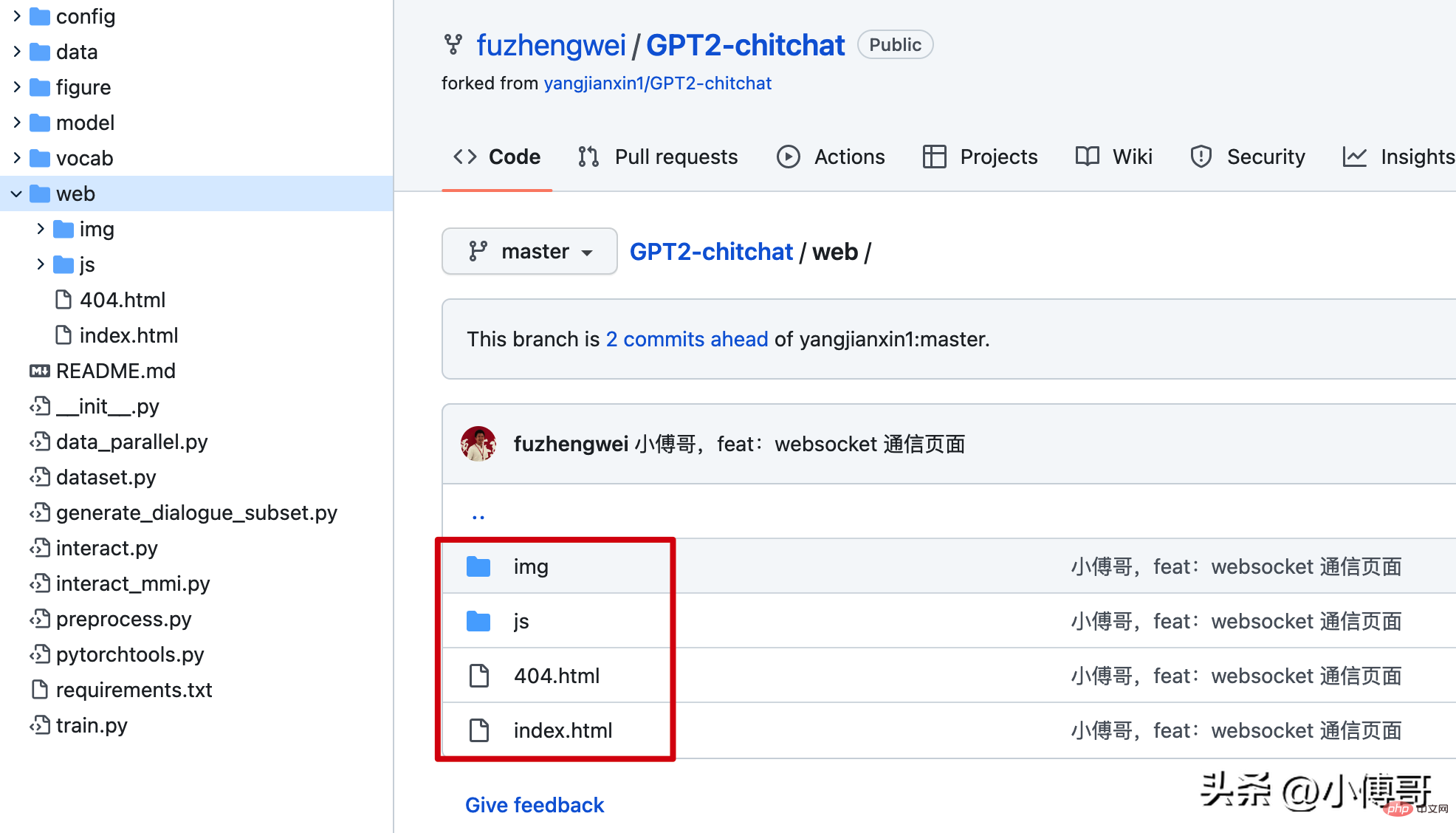

- 模型程式碼:https://github.com/fuzhengwei/GPT2-chitchat - 此程式碼已開源,含websocket通訊頁面

- 模型資料:https://pan.baidu .com/s/1iEu_-Avy-JTRsO4aJNiRiA - ju6m

yum -y install zlib-devel bzip2-devel openssl-devel ncurses-devel sqlite-devel readline-devel tk-devel gdbm-devel db4-devel libpcap-devel xz-devel

yum install gcc -y

yum -y install libffi-devel

make

make altinstall

2. Python 3.7cd ~

# 1.下载Python安装包

wget https://www.python.org/ftp/python/3.7.4/Python-3.7.4.tgz

# 2.将安装包移动到/usr/local文件夹下

mv Python-3.7.4.tgz /usr/local/

# 3.在local目录下创建Python3目录

mkdir /usr/local/python3

# 4.进入的Python安装包压缩包所在的目录

cd /usr/local/

# 5.解压安装包

tar -xvf Python-3.7.4.tgz

# 6.进入解压后的目录

cd /usr/local/Python-3.7.4/

# 7.配置安装目录

./configure --prefix=/usr/local/python3

# 8.编译源码

make

# 9.执行源码安装

make install

# 10.创建软连接

ln -s /usr/local/python3/bin/python3/usr/bin/python3

# 11. 测试

python3 -V

3. 安裝pip3 cd ~

# 1.下载

wget https://bootstrap.pypa.io/get-pip.py

# 2.安装;注意咱们安装了 python3 所以是 pyhton3 get-pip.py

python3 get-pip.py

# 3.查找pip安装路径

find / -name pip

# 4.将pip添加到系统命令

ln -s/usr/local/python/bin/pip /usr/bin/pip

# 5.测试

pip -V

# 6.更换源,如果不更换那么使用 pip 下载软件会很慢

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip config set install.trusted-host mirrors.aliyun.com

pip config list

# pip国内镜像源:

# 阿里云 http://mirrors.aliyun.com/pypi/simple/

# 中国科技大学https://pypi.mirrors.ustc.edu.cn/simple/

# 豆瓣 http://pypi.douban.com/simple

# Python官方 https://pypi.python.org/simple/

# v2ex http://pypi.v2ex.com/simple/

# 中国科学院http://pypi.mirrors.opencas.cn/simple/

# 清华大学 https://pypi.tuna.tsinghua.edu.cn/simple/

4. 安裝gitcd ~

# 1.安装前首先得安装依赖环境

yum install -y perl-devel

# 2.下载源码包到 CentOS 服务器后进行解压

tar -zxf git-2.9.5.tar.gz

cd git-2.9.5

# 3.执行如下命令进行编译安装

./configure --prefix=/usr/local/git

make && make install

# 4.添加到系统环境变量

vim ~/.bashrc

export PATH="/usr/local/git/bin:$PATH"

# 5.使配置生效

source ~/.bashrc

# 6.测试

git version

5. 安裝寶塔yum install -y wget && wget -O install.sh https://download.bt.cn/install/install_6.0.sh && sh install.sh 12f2c1d72

- 安裝後登入寶塔提示的位址,預設它會使用8888端口,因此你需要在伺服器上開啟8888埠存取權限。

- 寶塔的安裝是為了在服務端部署一個網頁版聊天介面,使用到了 Nginx 服務。這裡用寶塔操作更容易。

transformers==4.4.2 pytorch==1.7.0 sklearn tqdm numpy scipy==1.2.11. transformers

pip install transformers==4.4.2

2. pytorchpip install torch==1.7.0+cpu torchvision==0.8.1+cpu torchaudio===0.7.0 -f https://download.pytorch.org/whl/torch_stable.html

- 這個torch版本cpu與torchvision 需要匹配。

if(!window.WebSocket){

alert("您的浏览器不支持WebSocket协议!推荐使用谷歌浏览器进行测试。");

return;

}

socket = new WebSocket("ws://120.48.169.252:7397");五、模型訓練部署1. 下載程式碼cd /home

git clone https://github.com/fuzhengwei/GPT2-chitchat.git

你需要修改下interact.py 程式碼,變更這裡有Websocket 的IP和連接埠設定;async def start_server():

try:

async with websockets.serve(server, "192.168.0.4", 7397):

print("Starting server at ws://localhost:7397")

await asyncio.Future()# run forever

except OSError as e:

print(f"Error starting server: {e}")

except Exception as e:

print(f"Unexpected error: {e}")2. 上傳模型下載模型:https://pan.baidu.com/s/1iEu_-Avy-JTRsO4aJNiRiA#list/path=/ - 密碼:ju6m上傳模型:這裡你需要在本機安裝一個SFTP 工具,或是使用IntelliJ IDEA 提供的工具進行連結。連結後就可以把解壓縮的模型上傳到 /home/GPT2-chitchat/model 下。 async def start_server():

try:

async with websockets.serve(server, "192.168.0.4", 7397):

print("Starting server at ws://localhost:7397")

await asyncio.Future()# run forever

except OSError as e:

print(f"Error starting server: {e}")

except Exception as e:

print(f"Unexpected error: {e}")

修改这部分代码的IP和端口,以及在云服务上开启 7397 的访问权限。另外为了安全起见,可以在云服务的防火墙IP来源中授权,只有你当前的台机器才可以链接到 websocket 上。

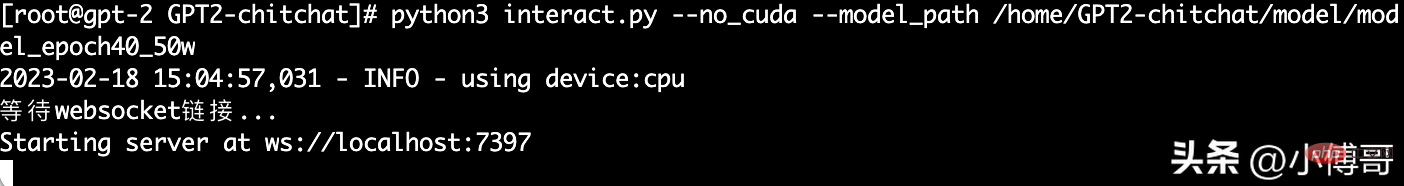

3. 启动服务

这里小傅哥通过 mac nuoshell 连接工具,进行模型启动;模型路径:/home/GPT2-chitchat/model/model_epoch40_50w

python3 interact.py --no_cuda --model_path /home/GPT2-chitchat/model/model_epoch40_50w

- 启动后就可以把你的 websocket 页面打开了,它会自动的链接到这个 websocket 服务上。

- 如果你还需要 Socket 或者命令行的服务,也可以修改 interact.py 代码进行处理。

以上就是整个 GPT2-chitchat 一个闲聊模型的部署,你也可以尝试使用 Docker 部署。如果在部署过程中实在很难部署成功,也可以找小傅哥买云服务,这样我可以直接把镜像部署到你的云服务上,就可以直接使用了。

以上是基於GPT2訓練了一個傻狗機器人的詳細內容。更多資訊請關注PHP中文網其他相關文章!