本文轉自雷鋒網,如需轉載請至雷鋒網官網申請授權。

電風扇與空皂盒的故事,大家都聽過吧?

傳聞某國際知名快消大廠曾引進一條香皂包裝生產線,結果發現這條生產線在包裝香皂的過程中出現了一個缺陷,就是常常有盒子沒裝入香皂。總不能把空盒子賣給顧客,於是,他們就請了一個學自動化的博士後來設計分類空香皂盒的方案。

該博士後立即召集了一個十幾人的技術團隊,綜合採用機械、自動化、微電子、X射線探測等等技術,花費90 萬,最後成功地研究出了一個方案,就是在生產線的兩旁安裝兩個集成探測器,每當檢測到有空香皂盒經過,就會驅動一隻機械手將空皂盒推走。

可以說,這是技術落地解決實際產業問題的重要突破。

巧合的是,同時,中國南方某鄉鎮企業也購買了同樣的生產線。老闆發現這個問題後,十分火大,叫來工廠的一名小工說:「你來想想辦法解決這個問題。」迫於壓力,小工很快就想出了一個妙計:他花190 元買了一台高功率電風扇放在香皂包裝生產線的旁邊,產線一轉就開始猛吹,空的香皂盒一出現,就被吹走了。

小工一人,憑藉著機智的創意,迅速解決了這個問題,實現了業界常吹說的一個大目標:降本增效。

科技革新,智慧在產業中的涵義無非就是這兩個口號:一是省錢,二是增效。然而,在近幾年的AI 發展中,卻出現了這樣一個看似違背資本規律的「怪異」現象:不管是學術界還是工業界,不管是大公司還是小公司,不管是私企還是國家資助的研究院,都在花大錢「煉」大模型。

導致圈內有兩種聲音:

#一種聲音說,大模型已在多種任務基準上展現出強大的性能與潛力,未來一定是人工智慧的發展方向,此時的投入是為將來不錯過時代大機遇做準備,投入成百上千萬(或更多)訓練是值得的。換言之,搶佔大模型高地是主要矛盾,高成本投入是次要矛盾。

另一種聲音則說,在AI 技術落地的實際過程中,當前對大模型的全面吹捧不僅搶奪了小模型與其他AI 方向的研究資源,而且由於投入成本高,在解決實際的產業問題中性價比低,也無法在數位轉型的大背景中造福更多的中小企業。

也就是說,「經濟可不可用」與「能力強不強大」構成了 AI 演算法解決實際問題中的兩大焦點。如今,業界已達成一個共識:在未來,AI 將成為賦能各行各業的「電力」。那麼,從 AI 大規模落地的維度來看,大模型與小模型哪一個比較好呢?業界真的想好了嗎?

1「大」模型到來

近年來,國內外的科技大廠在對外宣傳AI 研發實力的聲音中,總有一個高頻的詞彙出現:大模型(Big Model)。

這場競爭開始於國外的科技巨頭。 2018 年Google推出大規模預訓練語言模型BERT 拉開大模型的帷幕後,OpenAI相繼於2019 年與2020 年推出GPT-2、GPT-3;2021 年,谷歌又不甘落後,推出在參數量上壓倒前者的Switch Transformer……

所謂模型的大小,主要的衡量指標就是模型參數量的規模。模型的「大」,指的就是龐大的參數量。

例如,BERT 的參數量在2018年首次達到3 億參數量,在機器閱讀理解頂級水平測試SQuAD1.1 的兩個衡量指標上全面超越人類,並在11 種不同的NLP 測試中達到SOTA 表現,包括將GLUE 基準推高至80.4% (絕對改進7.6%),MultiNLI準確度達到86.7% (絕對改進5.6%),展示出了參數量增大對AI 演算法性能提升的威力。

OpenAI 先後推出的 GPT-2 參數量達到 15 億,GPT-3 的參數量首次突破千億,達到 1750 億。而Google在 2021 年 1 月發布的 Switch Transformer,更是首次達到萬億,參數量為 1.6 兆。

面對這如火如荼的局面,國內大廠、甚至政府資助成立的研究機構也紛紛不甘落後,先後推出他們在煉大模型上的成果:2021年4月,阿里達摩院發布中文預訓練語言模型「PLUG」,參數量270 億;4月,華為與鵬城實驗室聯合發布「盤古α」,參數量2000 億;6月,北京智源人工智慧研究院發布「悟道2.0」 ,參數量1.75 兆;9月,百度發布中英雙語模型PLATO-X,參數量百億。

到去年 10 月,阿里達摩院發布「M6-10T」,參數量已經達到 10 萬億,是中國目前規模最大的 AI 大模型。雖然比不上阿里,但百度在追求模型的參數量上也不甘落後,聯合鵬城實驗室發布了“百度·文心”,參數量 2600 億,比 PLATO-X 大了 10 倍。

此外,騰訊也稱他們研發了大模型「派大星」,但參數量級不明。除了普遍受大家關注的 AI 研發大廠,國內的大模型研發主力中還包括了算力提供商浪潮,他們在去年 10 月發布了大模型“源1.0”,參數量達到 2457 億。總而言之,2021 年可以稱為中國的「大模型元年」。

到今年,大模型繼續火熱。最開始,大模型是集中在計算語言領域,但如今也逐漸拓展到視覺、決策,應用甚至涵蓋蛋白質預測、航太等等重大科學問題,Google、Meta、百度等等大廠都有相應的成果。一時間,參數量低於 1 億的 AI 模型已經沒有聲量。

毫無疑問,無論是性能超越還是任務拓展,AI 大模型都展現了內在的潛力,為學術界與工業界帶來無限的想像空間。

有研究實驗表明,資料量與參數量的增加能夠有效提升模型解決問題的精確度。以Google2021年發布的視覺遷移模型Big Transfer 為例,分別使用1000 個類別的128 萬張圖片和18291 個類別的3 億張圖片兩個資料集進行訓練,模型的精確度能夠從77% 提升到79 %。

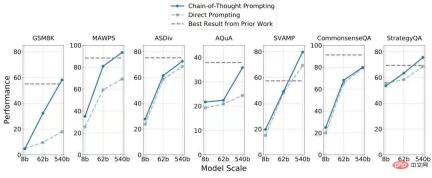

再拿今年Google推出的5400 億參數單向語言模型PaLM 來說,它基於谷歌今年發布的新一代AI 框架Pathways,不僅在微調方面超越了1750 億參數的GPT-3,而且推理能力大幅提升,在7 個算術應用題/常識推理資料集上,有4 個超越了當前的SOTA(如下表),而且只用了8 個樣本(即採集的數據) 。

視覺即感知,語言即智能,但兩者在「因果推理」的攻克上一直沒有太耀眼的突破,而因果推理這一項能力對AI 系統的進化又十分重要。可以這樣理解:小孩子能夠根據 1 1=2 來得出 100 100=200 的簡單能力,對機器系統來說卻十分複雜,就是因為系統缺乏因果推理的想像力。如果機器連合理的推理能力/想像力都沒有,那麼我們距離研發出科幻電影裡智慧超群的機器人將遙不可及。而大模型的出現,使通用人工智慧(AGI)的實現成為可能。

所以,我們可以看到,大公司宣傳一個大模型,往往強調它能夠同時解決多項任務,在多個任務基準上達到 SOTA(當前最高水平)。例如,Google今年推出的 5,400 億參數語言大模型 PaLM 可以解讀笑話,還可以透過emoji表情猜電影,智源推出的「悟道2.0」可以孵化出琴棋書畫、樣樣精通的虛擬學生華智冰。

簡而言之,大模型往往具備一個特質:多才多藝,身兼多職。這對解決複雜場景的挑戰至關重要。

「小模型的參數量少,只限於單一任務;而大模型(的優點)就像是,人在學習打乒乓球時所學到的知識對打羽球是有輔助效應的。大模型的任務與任務之間有泛化性。面對新任務時,小模型可能需要幾千個、幾萬個訓練數據,而大模型需要只可能一個訓練數據,甚至完全不需要訓練資料。」西湖大學深度學習實驗室的負責人藍振忠向雷峰網-AI 科技評論解釋。

以對話系統的研究為例。對話系統主要分為兩大類:一類是任務型對話,使用者下達任務、AI 系統自動執行,快速訂機票、買電影票等等;一類是開放式對話,如電影《她》(Her)中虛構的機器人,能夠與人類溝通任何話題,甚至讓使用者感覺到情感上的陪伴。這其中,後者的能力等級顯然更高,研發難度也更大。前面迷霧重重,你不清楚將會面臨怎樣的挑戰,這時,大模型本身俱備的豐富「能力包」和在新任務上超常的出色表現,戰鬥力顯然要優於小模型。

藍振忠指出,目前學術界與工業界的 AI 研究者們對於大模型的許多特性還未完全掌握。舉個例子,從上一代的GPT-3 到這一代的instruct GPT,我們可以看到它有一個質的飛躍,同樣是大模型,但是instruct GPT 在接受命令時效果卻好很多,這是他們在研究大模型時才能體驗到的。

參數量越來越大,AI 模型的效能究竟會發生什麼變化? 這是一個需要深入探索的科學問題,因此,繼續投入研究大模型是有必要的。

2 理想很遠,現實很近

人類要進步,就總要有人勇往無人之境。

然而,在現實世界中,並不是每個人都能負擔得起星辰大海的理想,更多的人只想以多快好省的方式解決眼前所面臨的問題。歸根究底,AI 演算法要落地,就必須考慮技術研發的投入產出比。這時,大模型的弊端就開始曝光。

一個不容忽視的殘酷事實是:大模型的計算慢,訓練成本極高。

通常來說,模型的參數量越大,機器跑得越慢,計算成本也越高。根據外媒披露,OpenAI 在訓練包含 1750億參數的 GPT-3 時花了接近 500 萬美元(人民幣約 3500 萬)。谷歌在訓練包含 5400 億參數的 PaLM 時用了 6144 塊 TPU,根據熱心網友統計,普通人訓練一個 PaLM 的成本在900至1700萬美元之間。這還只是算力的費用。

國內各大廠沒有揭露它們訓練大模型的經濟成本,但根據現有全球共享的計算方式與資源來看,計算支出應當相差不遠。 GPT-3與PaLM都還僅是千億級數量,而參數量達到萬億級以上的大模型,其成本投入想必驚人。如果一家大廠對研發夠闊綽,大模型的投入成本便不是一個「攔路虎」,但在當前資本對AI 越發謹慎之際,一些新創公司與政府投資的研究機構還大力下注大模型,這就顯得有些魔幻了。

大模型對算力的高要求,使企業間的技術實力競爭變成了金錢的競爭。從長遠來看,一旦演算法成為高消費商品,就注定最前沿的 AI 只能為少數人享有,從而造成圍城圈地的壟斷局面。換言之,即使有一天,通用人工智慧真的出現,也無法造福所有使用者。

同時,在這條賽道上,小型企業的創新力將被擠壓。要煉成大模型,小企業要麼與大廠合作、站在巨人的肩膀上(但這也不是每一家小廠都能做到的事情),要麼狂拉投資、備好金庫(但在資本的寒冬中,這也不切實際)。

算完投入,再算產出。遺憾的是,目前還沒有一家在煉大模型的企業揭露過大模型創造了多大的經濟效益。不過,從公開資訊中可以得知,這些大模型已經開始陸陸續續落地解決問題,如阿里達摩院在發布萬億參數模型M6 後,稱其圖像生成能力已經可以輔助汽車設計師進行車型設計,借用M6 的文案生成能力所創作的文案,也已經在手機淘寶、支付寶和阿里小蜜上被使用。

對於正處於探索起步階段的大模型來說,強調短期回報未免苛刻。然而,我們仍然要回答這樣一個問題:無論是企業界還是學術界,在下注大模型時,是為了不錯過一個可能在未來佔據主導地位的技術方向,還是因為其能更好地解決眼前已知的問題? 前者有著濃厚的學術探索色彩,而後者則是產業前鋒應用 AI 技術落地解決問題的群體所真正關心的問題。

大模型由Google發布BERT 拉開序幕起,是一種混沌天開的思路:在BERT 實驗之前,谷歌大腦的技術團隊並不是圍繞一個已知的現實問題來開發模型,也沒有想到這個當時參數量最大( 3 億)的AI 模型能帶來效果的大幅提升。同理,OpenAI 在模仿Google開發GPT-2 與GPT-3 時,也沒有一個特定的任務,而是成功開發出來後,大家在GPT-3 上測任務效果,發現各項指標都有提升,才被驚艷到。如今的 GPT-3 就像一個平台,已被用戶搭載了成千上萬個應用程式。

但隨著時間的推移,大模型的發展還是不可避免地回到了解決某一個實際問題的初衷,如Meta 今年發布的蛋白質預測大模型ESMFold,百度不久前發布的航太大模型。如果一開始的GPT-3 等大模型主要是想探索參數量增大會對演算法的性能改變帶來什麼影響,是純粹的「未知指導未知」,那麼現在的大模型研究則開始體現出一個較為清晰的目標:就是要解決現實問題,創業價值。

這時,大模型的發展指導方,就從研究者的意志轉換為了使用者的需求。在一些十分細小的需求(如車牌辨識)中,大模型也能解決問題,但由於其昂貴的訓練成本,未免有點「殺豬焉用牛刀」的意味,且性能不一定出色。或者說,若幾個點的精度提升是靠上千萬的成本換來的,性價比就顯得極低。

一位業內人士就告訴雷峰網-AI 科技評論,在絕大多數的情況下,我們研究一項技術是為了解決某一個已知的實際問題,如情感分析、新聞概括,這時我們其實可以設計一個專門的小任務去研究,出來的「小模型」的效果很容易就比GPT-3 等大模型好。甚至在一些特定的任務上,大模型「根本沒用」。

所以,在推動 AI 發展的過程中,大模型與小模型的結合是必然的。而由於大模型的研發門檻極高,在承擔 AI 大規模落地的重任上,在肉眼可見的未來,經濟可用、精準打擊的小模型才是主力軍。

即使是一些正在研究大模型的科學家,他們也明確地告訴雷峰網-AI 科技評論,雖然大模型能夠同時推行很多任務,但「現在談通用人工智能還太早」。大模型或許是實現終極目標的重要途徑,但理想尚遠,AI 還是要先滿足當下。

3 AI 模型一定要越來越大嗎?

事實上,針對 AI 模型越來越大的現象,學術界與工業界的部分研究者已經注意到其在落地中的利與弊,並積極展開應對之策。

如果要說科技對社會的改變給予了人們怎樣的啟示,那麼其中一定會談到的重要一條便是:如何降低科技產品的門檻(無論是技術上還是成本上),讓更多的人能夠享受這項科技的好處,才能擴大它的影響力。

換到大模型中,核心矛盾就是如何提升它的訓練速度、降低訓練的成本,或提出新的架構。如果單從呼叫計算資源來看,大模型的窘境其實並不突出。今年 6 月底開放工程聯盟 MLCommons 發布的 MLPerf 基準最新訓練結果顯示,今年機器學習系統的訓練速度幾乎是去年的兩倍,已經突破了摩爾定律(每18-24個月翻一倍)。

事實上,隨著各家伺服器的更新迭代,雲端運算等新穎方式的出現,運算一直在加速,能耗也一直在降低。舉個例子,GPT-3 推出僅兩年,如今 Meta 參考它所研發的 OPT 模型的計算量已經降低到了2020年的1/7。此外,最近還有一篇文章表明,2018 年需要數千塊 GPU 訓練的大模型 BERT,如今只需要單卡 24 小時就能訓練好,一個普通的實驗室也能輕鬆訓練。

取得算力的瓶頸已經不存在,唯一的攔路虎只是取得成本。

除了單純依靠算力,近年來,也有一些研究者希望另闢蹊徑,單從模型與演算法本身的特性去實現大模型的「經濟可用性」。

一種途徑是以資料為中心的「降維」。

#最近DeepMind 就有一項工作(「Training Compute-Optimal Large Language Models」)成功探索發現,在計算量相同的情況下,將模型的訓練資料變大,而不是將模型的參數量放大,可以得到比僅僅放大模型更好的效果。

在DeepMind 的這項研究中,一個充分利用了數據的700 億參數模型Chinchilla 在一系列下游任務的評估中超越了1750 億參數的GPT-3 和2800億參數的Gopher。藍振忠解釋,Chinchilla 之所以能夠取勝,就是因為在訓練時將資料擴大、翻倍,然後只計算一遍。

另一種途徑是依賴演算法與架構的創新,將大模型「輕量化」。

微軟亞洲研究院前副院長、現瀾舟科技創辦人周明是這條賽道的追隨者。

作為一個創業者,周明的想法很「本分」,就是要省錢。他指出,如今許多大的公司都在追求大模型,一是爭先恐後,二是也想體現自己的運算能力,尤其是雲端服務的能力。而瀾舟科技作為一家誕生不久的小公司,有用AI 創造價值的夢想,但沒有強大的雲能力,錢也不夠燒,所以周明一開始想的是如何通過模型架構的調整與知識蒸餾等等方式,將大模型變成「輕量化模型」給客戶使用。

他們在去年 7 月推出的輕量化模型「孟子」證明了這個想法的可行性。 「孟子」的參數僅 10 億,但在中文語言理解評測榜單 CLUE 上的表現卻超越參數量級為百億甚至千億的BERTSG 與盤古等等大模型(如下表)。領域的一個共識是:在同一個架構下,模型一定是參數量越大、效能越好,但「孟子」的巧妙之處,就在於架構的創新。

在學術界,不久前,加州大學柏克萊分校的馬毅教授與沈向洋、曹穎還聯合發表了一項研究( 「On the Principles of Parsimony and Self-Consistency for the Emergence of Intelligence」),從理論上解析了大模型為何越來越大的技術原因,即深度神經網路本質上是一個「開環」的系統,即用於分類的判別模型和用於採樣或重播的生成模型的訓練在大部分情況下是分開的,導致對參數的訓練效率低下,只能依靠堆參數與堆算力來提升模型的性能。

為此,他們提出的「變革」方式更徹底,就是主張將判別模型與生成模型組合在一起,形成一個完整的「壓縮」閉環系統,這樣AI 模型就能夠自主學習,而且效率更高、更穩定,在面對一個新的環境中可能出現的新問題時,適應性與反應能力也更強。換言之,如果AI 領域的研究者能夠沿著這條路線去開發模型,模型的參數量級會大幅縮小,回歸到「小而美」的道路上,也能實現大模型「解決未知問題」的能力。

在實現經濟可用上,甚至還有一種聲音,是主張透過AutoML 或AutoAI 的方式來解決模型訓練的難度,降低AI 演算法的研究門檻,讓演算法工程師或非AI 從業者可以靈活地根據自己的需求來打造單一功能的模型,形成無數個小模型,星星之火、可以燎原。

這種聲音是從「需求」的角度出發,反對閉門造車。

舉個例子,視覺演算法用於識別、偵測與定位,其中,辨識煙霧與煙火對演算法的要求不同,那麼他們就提供一個平台或工具,讓需求者可以分別快速產生一個識別煙霧與識別煙火的視覺演算法,精確度更高,也不必追求跨場景的「通用性」或「泛化性」。這時,一個琴棋書畫樣樣精通的大模型,可以分為無數個分別精通琴、棋、書、畫的小模型,同樣也能解決問題。

4 寫在最後

再回到電風扇吹空皂盒的故事上。

在AI 技術解決現實問題上,大模型與小模型就猶如博士後的自動化方案與小工的電風扇,前者雖然在解決某一個小的問題時顯得冗餘、笨重,效果也沒有電風扇快速,但幾乎沒有人會否認博士後及其團隊所提供的價值,更不可能「消滅」他們。相反,我們甚至可以說出幾百個理由來強調技術研發的合理性。

但在許多時候,技術研究者卻常常忽略了小工在解決問題上的智慧:從實際問題出發,而不是囿於科技的優勢。從這個角度來看,大模型的研究固有引領前沿的價值,但也要考慮降本增效中的「經濟可用」目標。

再回到研究本身,藍振忠表示,目前大模型的成果雖然有很多,但開源極少,普通研究者的訪問有限,這一點很令人惋惜。

由於大模型沒有開源,一般使用者也無法從需求的角度來評價大模型的實用性。事實上,先前在目前少數開源的大模型中,我們曾做過實驗,發現語言大模型在理解社會倫理與情感上的表現存在極高的不穩定性。

因為不開放,各大廠對自家大模型的介紹也是停留在學術的各項指標上,這就形成了類似薛定諤的困局:你永遠不知道盒子裡面有什麼,也無法判斷它的真假,一句話,什麼都是他們說了算。最後,希望 AI 大模型真的能造福更多人吧。

以上是大廠燒錢也要追捧 AI 大模型的迷與思的詳細內容。更多資訊請關注PHP中文網其他相關文章!

聯發科技與kompanio Ultra和Dimenty 9400增強優質陣容Apr 12, 2025 am 11:52 AM

聯發科技與kompanio Ultra和Dimenty 9400增強優質陣容Apr 12, 2025 am 11:52 AM繼續使用產品節奏,本月,Mediatek發表了一系列公告,包括新的Kompanio Ultra和Dimenty 9400。這些產品填補了Mediatek業務中更傳統的部分,其中包括智能手機的芯片

本週在AI:沃爾瑪在時尚趨勢之前設定了時尚趨勢Apr 12, 2025 am 11:51 AM

本週在AI:沃爾瑪在時尚趨勢之前設定了時尚趨勢Apr 12, 2025 am 11:51 AM#1 Google推出了Agent2Agent 故事:現在是星期一早上。作為AI驅動的招聘人員,您更聰明,而不是更努力。您在手機上登錄公司的儀表板。它告訴您三個關鍵角色已被採購,審查和計劃的FO

生成的AI遇到心理摩托車Apr 12, 2025 am 11:50 AM

生成的AI遇到心理摩托車Apr 12, 2025 am 11:50 AM我猜你一定是。 我們似乎都知道,心理障礙由各種chat不休,這些chat不休,這些chat不休,混合了各種心理術語,並且常常是難以理解的或完全荒謬的。您需要做的一切才能噴出fo

原型:科學家將紙變成塑料Apr 12, 2025 am 11:49 AM

原型:科學家將紙變成塑料Apr 12, 2025 am 11:49 AM根據本週發表的一項新研究,只有在2022年製造的塑料中,只有9.5%的塑料是由回收材料製成的。同時,塑料在垃圾填埋場和生態系統中繼續堆積。 但是有幫助。一支恩金團隊

AI分析師的崛起:為什麼這可能是AI革命中最重要的工作Apr 12, 2025 am 11:41 AM

AI分析師的崛起:為什麼這可能是AI革命中最重要的工作Apr 12, 2025 am 11:41 AM我最近與領先的企業分析平台Alteryx首席執行官安迪·麥克米倫(Andy Macmillan)的對話強調了這一在AI革命中的關鍵但不足的作用。正如Macmillan所解釋的那樣,原始業務數據與AI-Ready Informat之間的差距

Rohan Rao為企業選擇合適的LLM的指南Apr 12, 2025 am 11:40 AM

Rohan Rao為企業選擇合適的LLM的指南Apr 12, 2025 am 11:40 AM在這一集《 Leading With Data》中,我們與四倍的Kaggle Grandmaster兼機器學習解決方案專家Rohan Rao一起研究了有趣的數據科學世界。羅漢(Rohan)分享了對戰略夥伴關係的見解,

Llama 3.1 vs O1-preiview:哪個更好?Apr 12, 2025 am 11:32 AM

Llama 3.1 vs O1-preiview:哪個更好?Apr 12, 2025 am 11:32 AM介紹 想像一下自己的選擇,為您的下一個項目選擇完美的AI工具。憑藉Meta的Llama 3.1和Openai的O1-preiview等高級型號,做出正確的選擇可能是PI

掌握Kaggle比賽Apr 12, 2025 am 11:28 AM

掌握Kaggle比賽Apr 12, 2025 am 11:28 AM介紹 在數據科學領域,Kaggle已成為一個充滿活力的舞台,有抱負的分析師和經驗豐富的專業人士都可以測試他們的技能並突破創新的界限。想像以下圖:年輕數據

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 Linux新版

SublimeText3 Linux最新版

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

SublimeText3漢化版

中文版,非常好用