今年英語高考,CMU用重構預訓練交出134高分,大幅超越GPT3

- PHPz轉載

- 2023-04-09 10:21:051797瀏覽

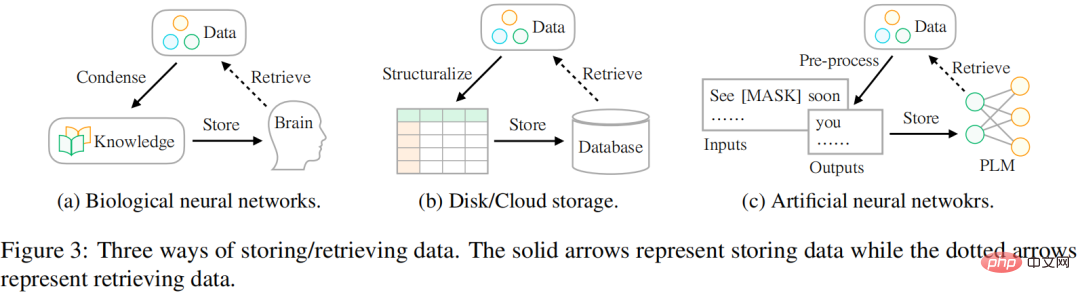

我們儲存資料的方式正在發生變化,從生物神經網路到人工神經網絡,其實最常見的情況是使用大腦來儲存資料。隨著當今可用數據的不斷增長,人們尋求用不同的外部設備儲存數據,如硬碟或雲端儲存。隨著深度學習技術的興起,另一種有前景的儲存技術已經出現,它使用人工神經網路來儲存資料中的資訊。

研究者認為,資料儲存的最終目標是更好地服務人類生活,資料的存取方式和儲存方式同樣重要。然而,儲存和存取資料的方式存在差異。歷史上,人們一直在努力彌補這一差距,以便更好地利用世界上存在的資訊。如圖3 所示:

- 在生物神經網路(如人腦)方面,人類在很小的時候就接受了課程(即知識)教育,以便他們能夠提取特定的數據來應對複雜多變的生活。

- 對於外部設備存儲,人們通常會按照某種模式(例如表格)對資料進行結構化,然後採用專門的語言(例如 SQL)從資料庫中有效地檢索所需的資訊。

- 對於基於人工神經網路的存儲,研究人員利用自監督學習來儲存來自大型語料庫的資料(即預訓練),然後將該網路用於各種下游任務(例如情緒分類)。

來自 CMU 的研究者提出了一種存取包含各種類型資訊資料的新方法,這些資訊可以作為指導模型進行參數最佳化的預訓練訊號。研究以訊號為單位結構化地表示資料。這類似於使用資料庫對資料進行儲存的場景:首先將它們建構成表格或 JSON 格式,這樣就可以透過專門的語言 (如 SQL) 準確地檢索所需的資訊。

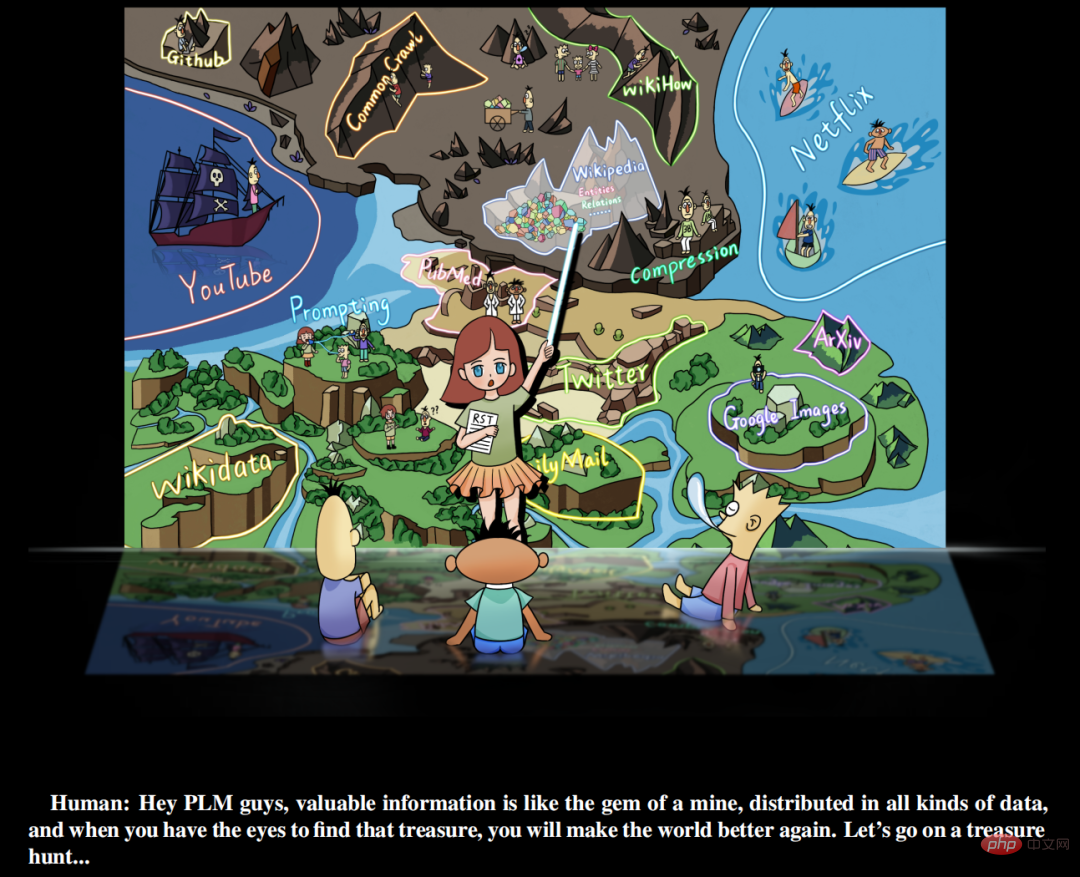

此外,該研究認為有價值的訊號豐富地存在於世界各類的數據中,而不是簡單地存在於人工管理的監督數據集中, 研究人員需要做的是(a) 識別數據(b) 以統一的語言重組資料(c)將它們整合並儲存到預訓練語言模型中。研究稱這種學習範式為重構預訓練(reStructured Pre-training,RST)。研究者將這個過程比喻為「礦山尋寶」。不同的資料來源如維基百科,相當於盛產寶石的礦場。它們包含豐富的訊息,例如來自超連結的命名實體,可以為模型預訓練提供訊號。一個好的預訓練模型 (PLM) 應該清楚地了解資料中各種訊號的組成,以便根據下游任務的不同需求提供準確的資訊。

論文網址:https://arxiv.org/pdf/2206.11147.pdf

預訓練語言模型尋寶

該研究提出自然語言處理任務學習的新範式, 即RST,該範式重新重視數據的作用,並將模型預訓練和下游任務的微調視為數據的儲存和存取過程。在此基礎上,該研究實現了一個簡單的原則,即良好的儲存機制不僅應該具有快取大量資料的能力,還應該考慮存取的方便性。

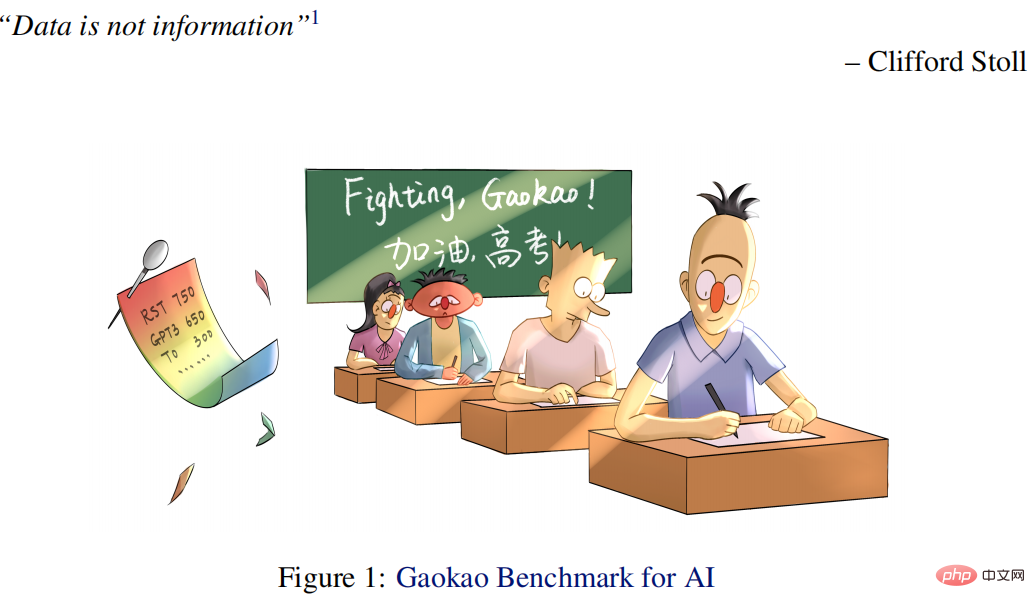

在克服了一些工程挑戰後,該研究透過對重構資料(由各種有價值的資訊而不是原始資料組成)進行預訓練來實現這一點。實驗證明,RST 模型不僅在來自各種NLP 任務(例如分類、資訊抽取、事實檢索、文字生成等)的52/55 流行資料集上表現大幅超過現有最佳系統(例如,T0),而且無需對下游任務進行微調。在每年有數百萬學生參加的中國最權威的高考英語考試中也取得了優異的成績。

具體而言,本文所提出的高考 AI (Qin) 比學生的平均分數高出 40 分,比使用 1/16 參數的 GPT3 高出 15 分。特別的 Qin 在 2018 年英語考試中獲得了 138.5 的高分(滿分 150)。

此外,該研究還發布了高考基準(Gaokao Benchmark)在線提交平台,包含2018-2021 年至今10 篇帶註釋的英文試卷(並將每年進行擴展),讓更多的AI 模型參加高考,該研究還建立了一個相對公平的人類和AI 競爭的測試平台,幫助我們更好地了解我們所處的位置。另外,在前幾天(2022.06.08)的 2022 年高考英語測驗中,該 AI 系統獲得了 134 分的好成績,而 GPT3 只獲得了 108 分。

該研究的主要貢獻包括:

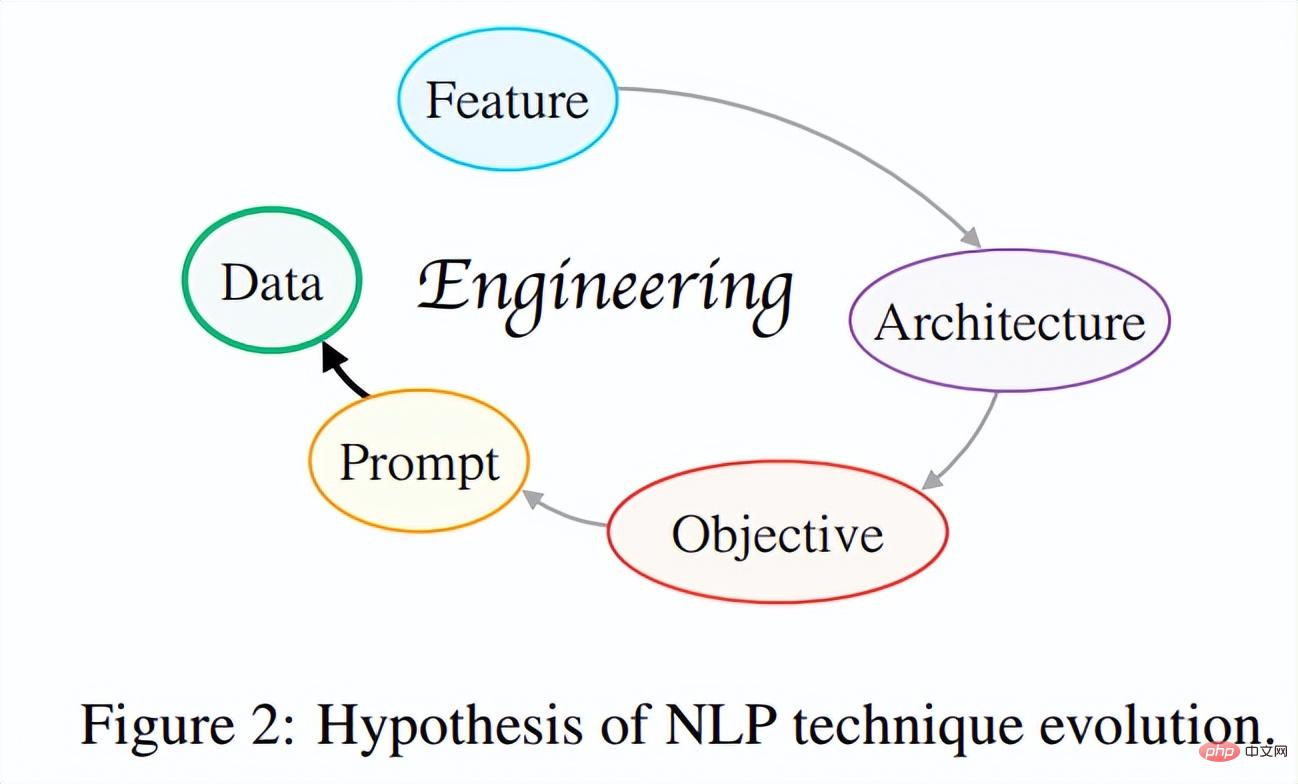

(1)提出 NLP 方法的演進假說。該研究試圖透過探索現代 NLP 技術發展之間的內在聯繫,從全局的角度建立了「NLP 技術演進假說」。簡而言之,該假說的核心思想是:技術的迭代總是沿著這樣的方向發展:即開發者只需做更少的事情便可以來設計更好、更通用的系統。

到目前為止,NLP 技術演進已經經歷如圖2 所示的多次迭代:特徵工程→架構工程→目標工程→prompt 工程,正在朝著更實際有效的以資料為中心的工程邁進。研究者希望未來能激發更多的科學研究人員批判性思考這個問題,掌握科技進步的核心驅動力,找到學術發展「梯度上升」路徑,做更多有科學意義的工作。

(2)基於演進假說新範式:重建預訓練(reStructured Pre-training)。此範式將模型預訓練 / 微調視為資料儲存 / 存取過程,並聲稱良好的儲存機制應該使預期資料易於存取。有了這樣一個新範式,該研究能夠從 10 個資料來源(例如 Wikipedia)中統一世界上 26 種不同類型的訊號(例如句子的實體)。在此基礎上訓練的通用模型在各種任務上取得了很強的泛化能力,其中包括 55 個 NLP 的資料集。

(3)用於高考的 AI。基於上述範式,研究開發了一個專門用於高考英語測驗任務的 AI 系統——Qin。這是世界上第一個基於深度學習的高考英語人工智慧系統。 Qin 在多年的高考試題上都取得了卓越的成績:比普通人高出 40 分,僅用 GPT-3 1/16 的參數量就獲得了比 GPT-3 高 15 分的成績。特別是在 2018 年英語試題上,QIN 獲得了 138.5 分(滿分 150 分)的高分,聽力和閱讀理解都滿分。

(4) 豐富的資源。 (1) 為了追蹤現有 AI 技術在實現人類智慧方面的進展,該研究發布了一種新基準-Gaokao Benchmark。它不僅提供對現實世界場景中各種實際任務和領域的全面評估,還可以提供人類的表現成績,以便人工智慧系統可以直接與人類進行比較。 (2)該研究使用 ExplainaBoard(Liu et al., 2021b)為 Gaokao Benchmark 設定了一個互動式排行榜,以便更多的 AI 系統可以輕鬆參加 Gaokao Benchmark 並自動獲得分數。 (3)所有資源都可以在 GitHub 上找到。

此外,AI 在高考英語測驗任務上的成功為研究者提供了許多新的思考:AI 技術可以賦能教育,幫助解決教育和教學中的一系列問題。

例如,(a) 幫助教師自動評分,(b) 幫助學生回答有關作業的問題並詳細解釋,以及(c) 更重要的是,促進教育公平,讓大多數家庭都能獲得同等品質的教育服務。這項工作首次以統一的方式整合了世界上 26 個不同的訊號,而不是試圖區分有監督和無監督的數據,而是關心我們可以多少使用大自然給我們的資訊以及如何使用。來自各種 NLP 任務的 50 多個資料集的出色表現顯示了以資料為中心的預訓練的價值,並激發了更多的未來探索。

重構預訓練

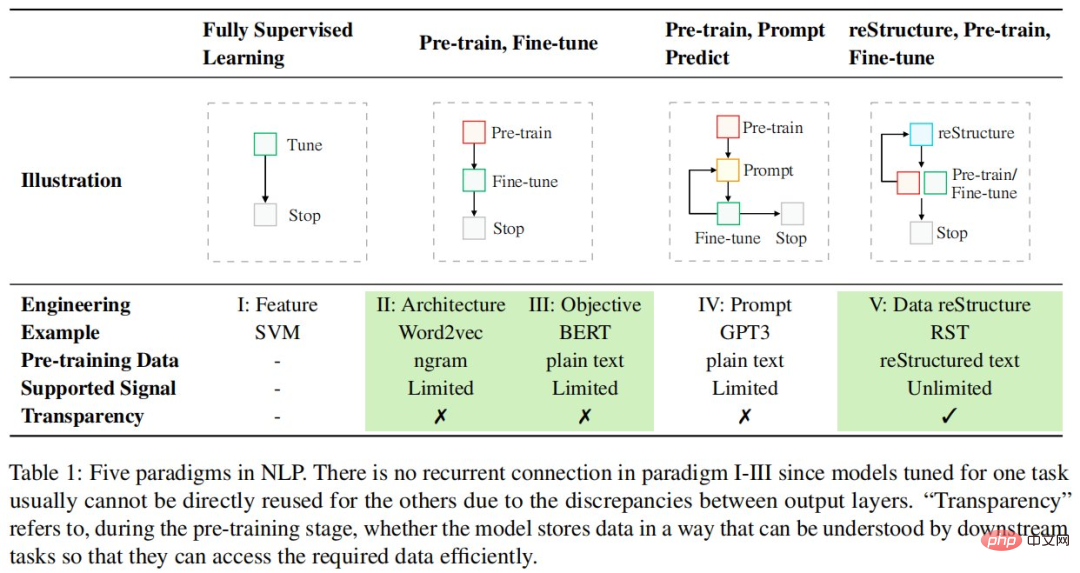

解決 NLP 任務的範式正在迅速變化,並且仍在持續,下表列出了 NLP 中的五種範式:

與現有的以模型為中心的設計範式不同,該研究更多地從數據的角度思考,以最大限度地利用已有數據。具體來說,該研究採用資料儲存和存取視圖,其中預訓練階段被視為資料儲存過程,而基於預訓練模型的下游任務(例如,情緒分類)被視為來自預訓練模型的資料存取過程,並聲稱良好的資料儲存機制應該使儲存的資料更易於存取。

為了實現這一目標,該研究將數據視為由不同信號組成的對象,並認為一個好的預訓練模型應該(1)覆蓋盡可能多的信號類型,(2)當下游任務需要時,為這些訊號提供精確的存取機制。一般來說,這個新範式包含三個步驟:重構、預訓練、微調。

重構、預訓練、微調的新範式凸顯了資料的重要性,研究人員需要在資料處理上投入更多的工程精力。

重構工程

訊號定義

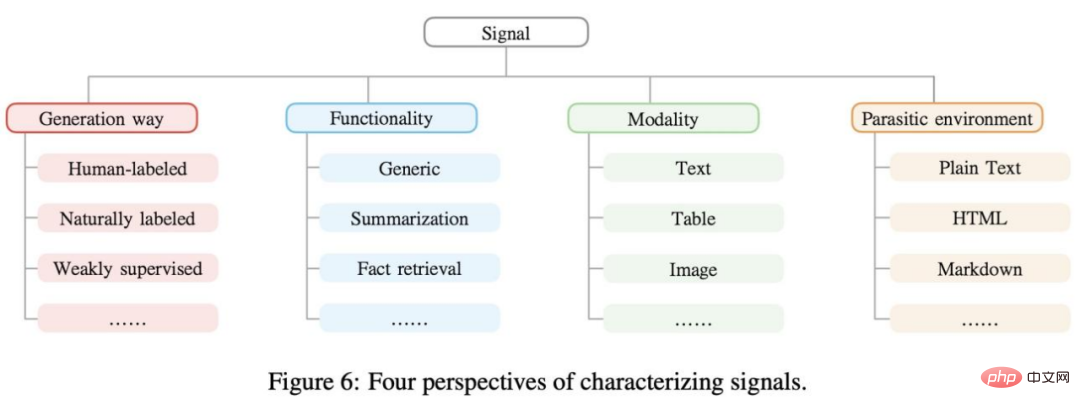

訊號是資料中存在的有用信息,可以為機器學習模型提供監督,表示為 n 元組。例如「莫札特出生在薩爾斯堡」,「莫札特」、「薩爾斯堡」可以被認為是命名實體辨識的訊號。通常,可以從不同的角度對訊號進行聚類,如下圖 6 所示。

資料探勘

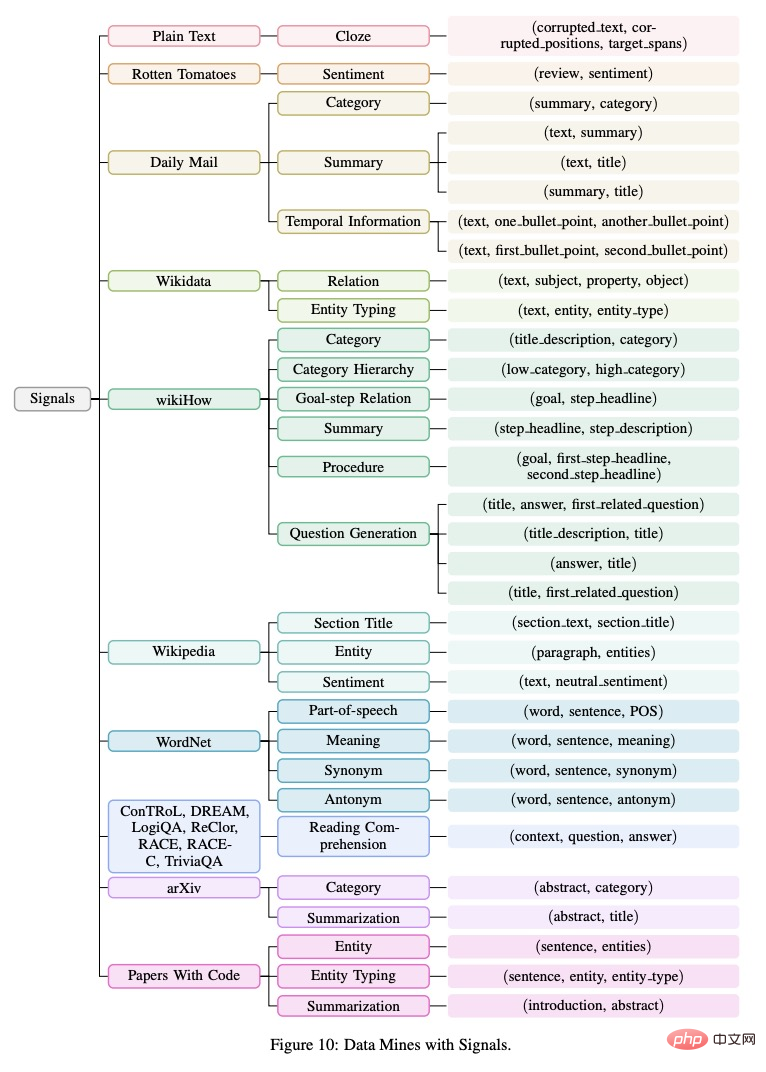

現實世界的資料中包含許多不同類型的訊號。重構預訓練使這些訊號能夠充分被利用。本研究將收集到的訊號(n 元組)組織在樹形圖中,如下圖 10 所示。

訊號擷取

下一步研究進行了訊號擷取和處理,涉及從不同模態的資料探勘中獲取原始資料、資料清洗和數據規範化。現有的方法大致分為兩種:(1)基於規則的,(2)基於機器學習的。在這項工作中,該研究主要關注基於規則的訊號提取策略,並為未來的工作留下更多高覆蓋率的方法。

訊號重建

在從各種資料探勘中提取出不同的訊號之後,接下來重要的一步是將它們統一成一個固定的形式,以便在預訓練期間將所有資訊一致儲存在模型中。 prompt 方法(Brown et al., 2020; Liu et al., 2021d)可以實現這個目標,原則上,透過適當的 prompt 設計,它幾乎可以將所有類型的訊號統一為一種語言模型風格。

該研究將訊號分為兩大類:通用訊號和任務相關訊號。前者包含基本的語言知識,可以在一定程度上使所有下游任務受益,而後者則可以使某些特定的下游任務受益。

在 55 種常用的 NLP 資料集上的實驗

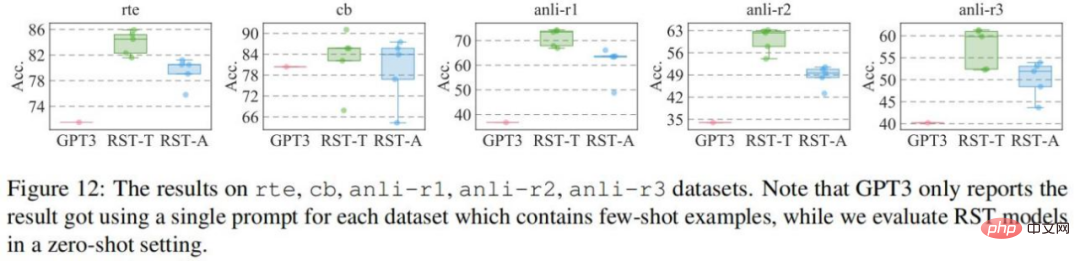

該研究在 55 個資料集上進行評估,然後將它們分別與 GPT3 和 T0pp 進行比較。與 GPT3 比較的結果如圖所示:在 cb 資料集以外的四個資料集上,RST-All 和 RST-Task 都具有比 GPT3 的小樣本學習更好的零樣本效能。此外,cb 資料集是這些資料集中最小的,驗證集中只有 56 個樣本,因此不同的 prompt 在該資料集上的表現會有較大的波動。

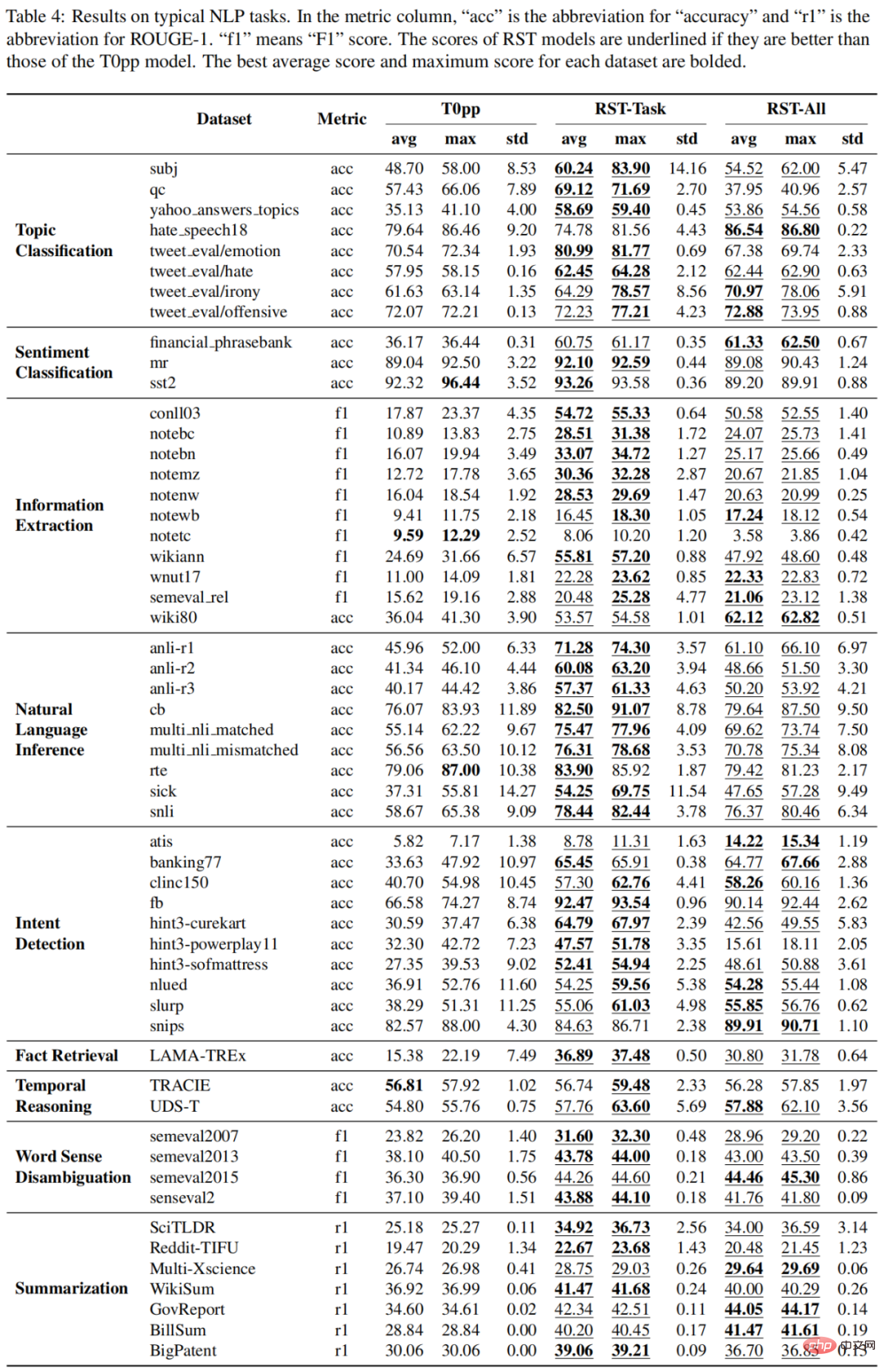

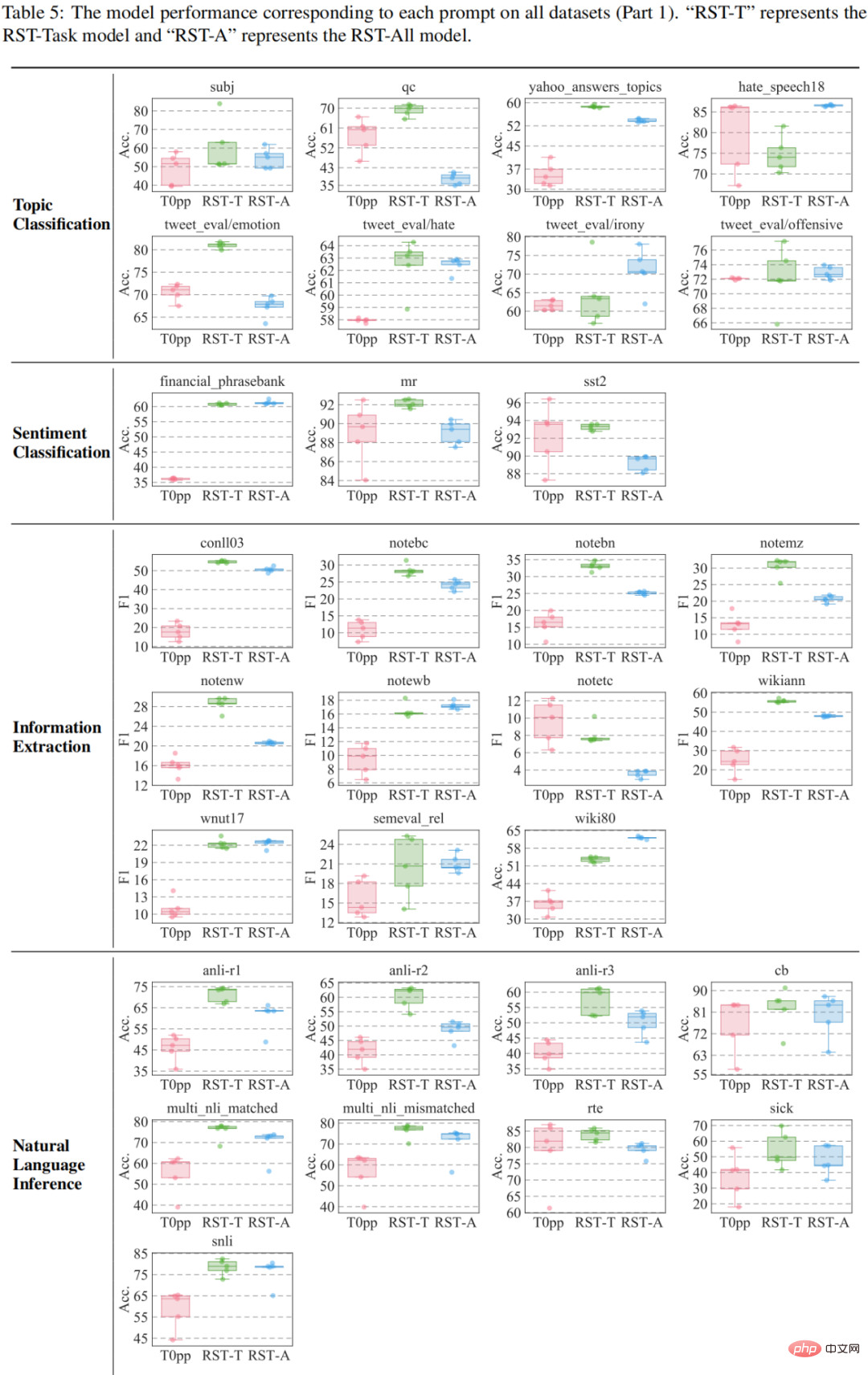

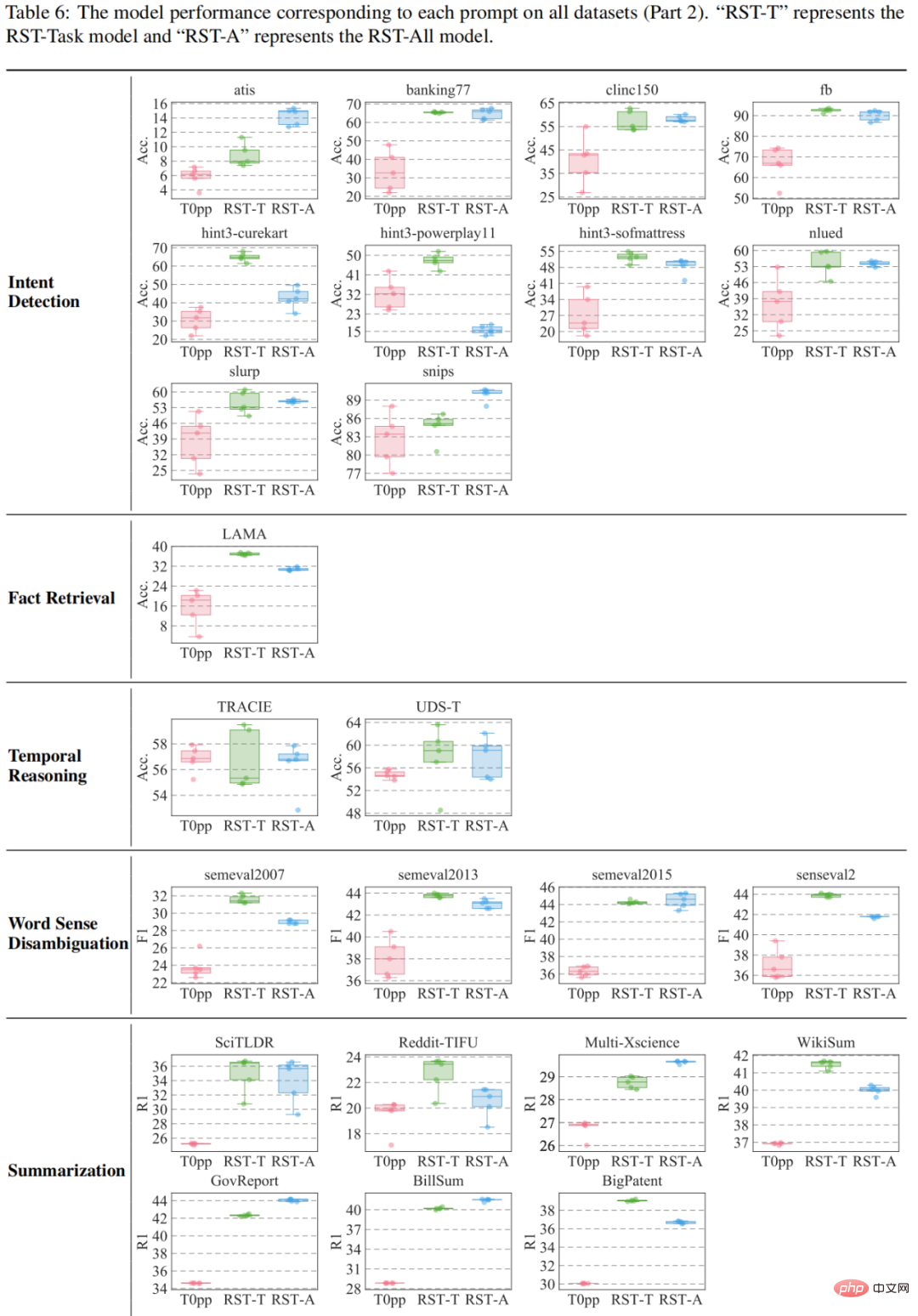

與 T0pp 比較結果如表 4-6 所示。例如在 55 個測量的平均效能中,RST-All 在 49 個資料集上擊敗了 T0pp,並在 47/55 範例上以最大效能勝出。此外,在 55 個資料集的平均效能測試中,RST-Task 在 52 個資料集上優於 T0pp,並在 50/55 個範例下超越 T0pp。這說明重構學習的優越性。

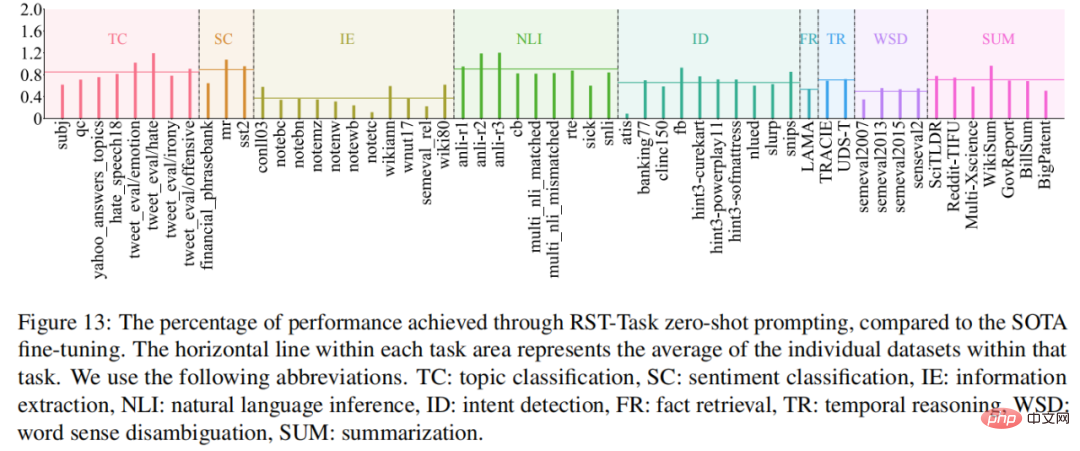

# 表現最佳的模型 RST-Task 擅長哪些任務?為了回答這個問題,研究將 RST-Task 模型在零樣本設定中的表現與目前 SOTA 模型進行比較,結果如圖 13 所示。 RST-Task 擅長主題分類、情緒分類和自然語言推理任務,但在資訊擷取任務中表現較差。

高考實驗:邁向人類層級的AI

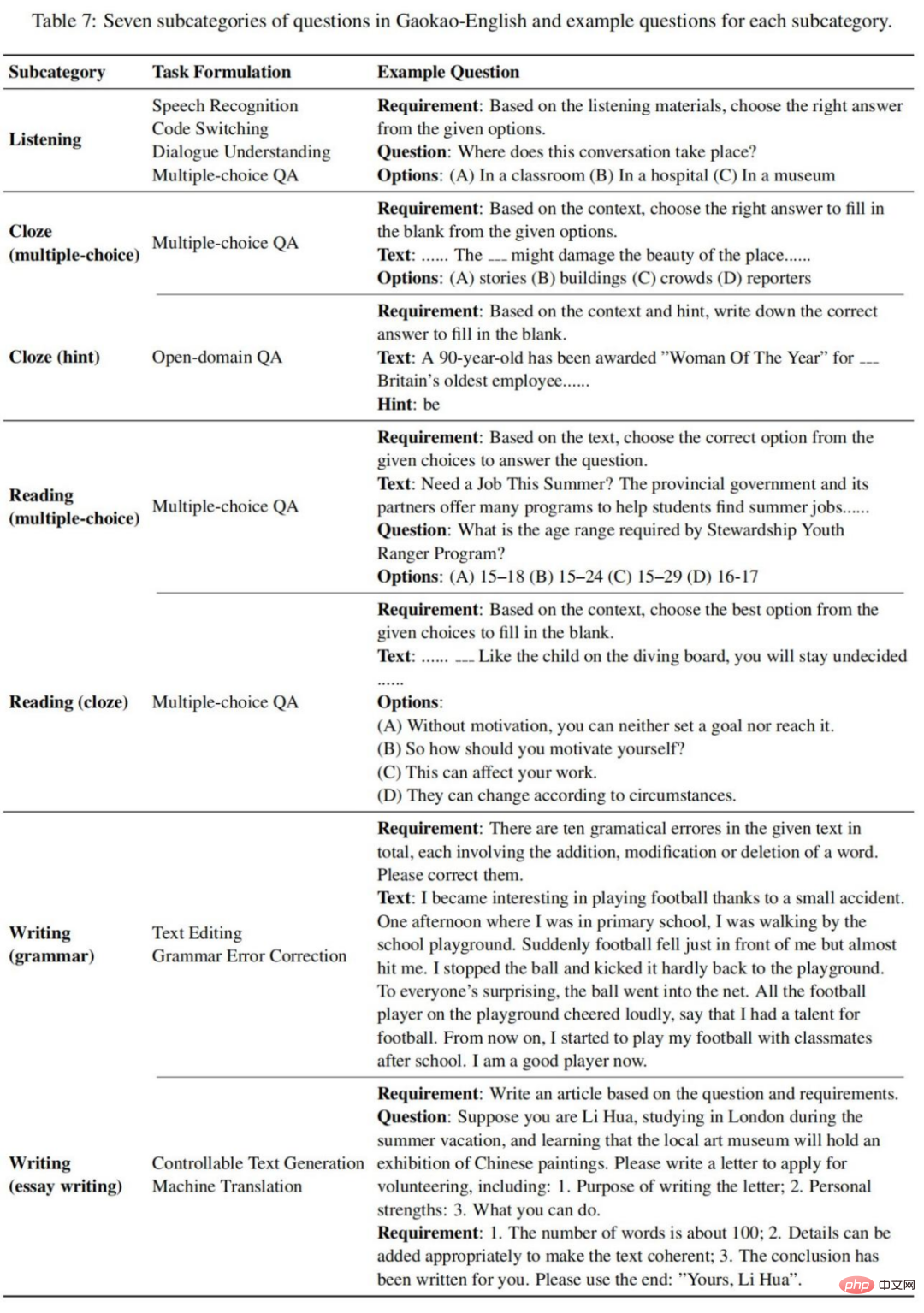

該研究收集了10 份高考英語試卷,包括2018 年國考I/III、2019年國考I/II/III、2020 年國考I/II/III、2021 年全國卷A/B。這些考卷遵循相同的題型,他們將所有考試題型分為以下七個子類別,如表7 所示:

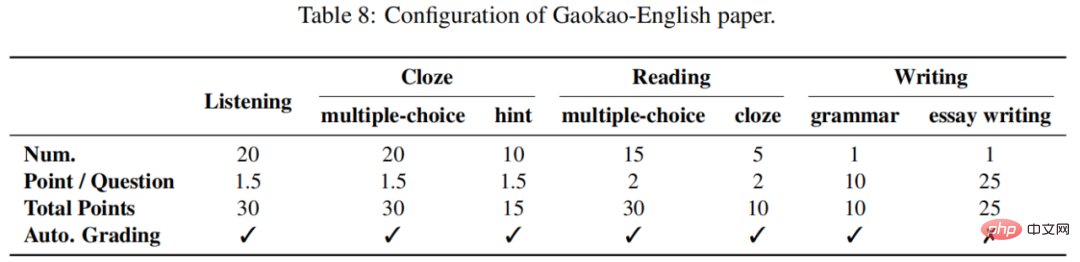

#每篇高考英語試卷滿分150 分。聽力、完形填空、閱讀、寫作分別佔 30、45、40、35。通常,寫作部分是主觀的,需要人工評估,而其他部分是客觀的,可以自動評分。如表 8 所示:

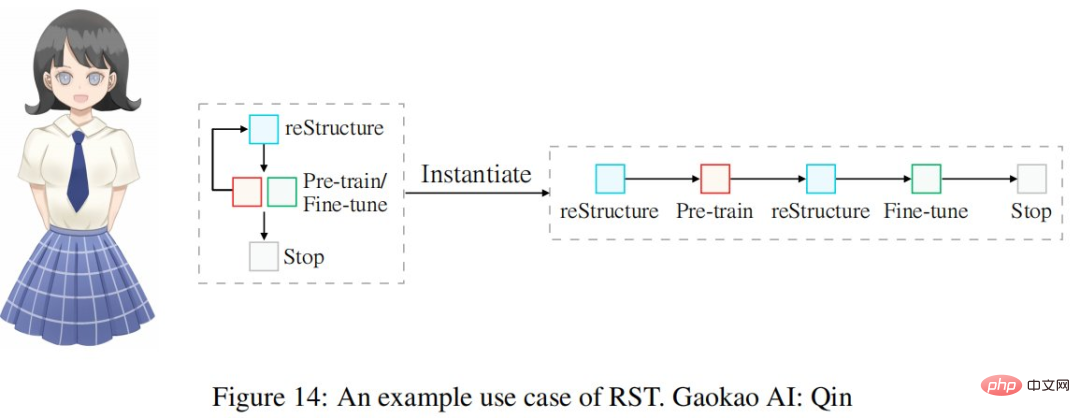

使用表 1 所示的重構工程循環來建立高考英語 AI 系統,即 Qin。整個過程如圖14 所示:

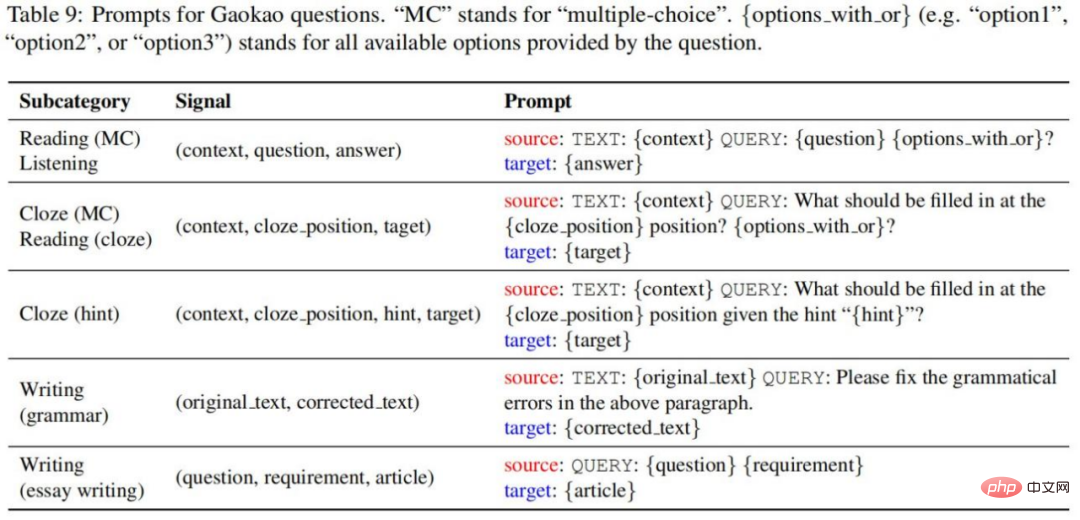

本研究使用下列prompt 將原始訊號元組轉換為prompt 樣本,如表9 所示:

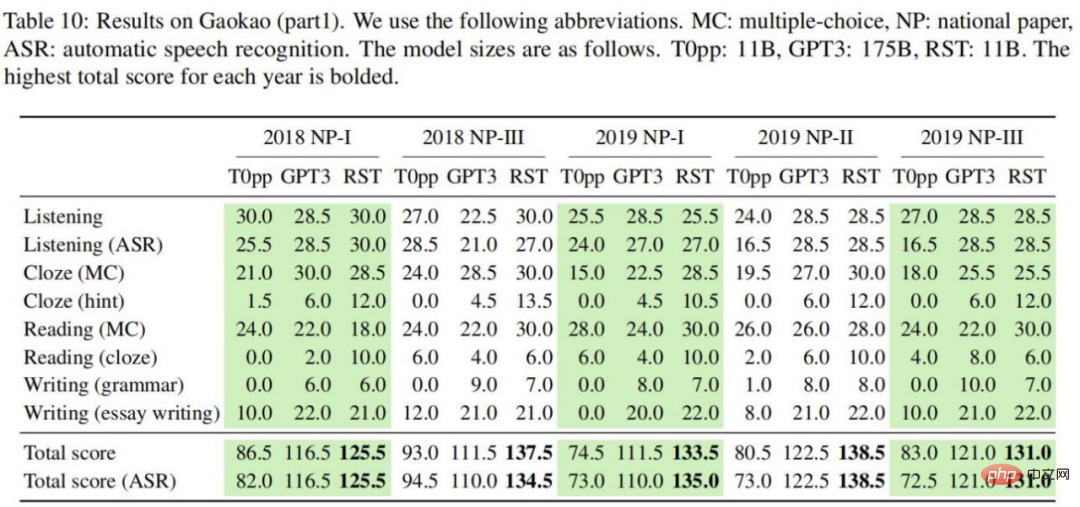

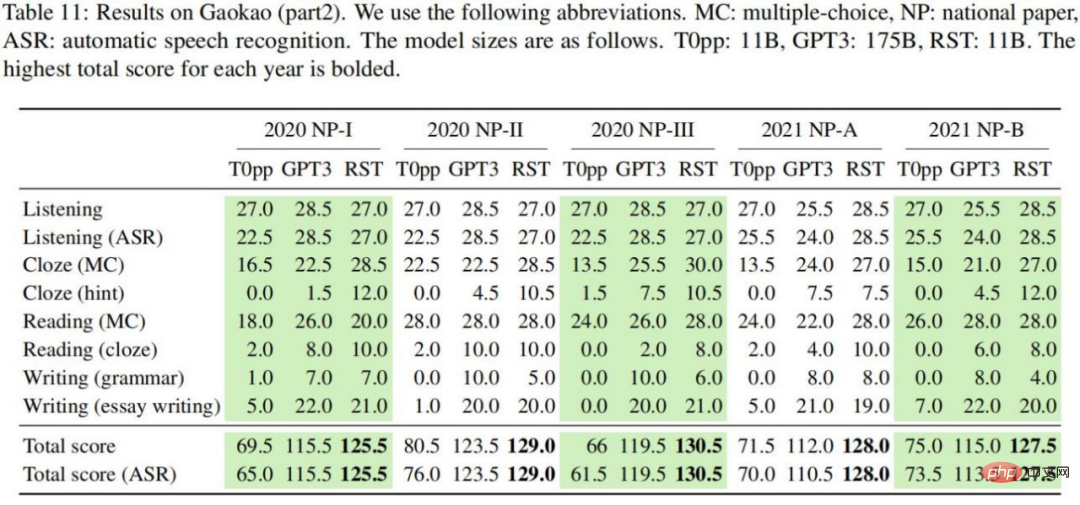

實驗結果如表10-11 所示,我們可以得出以下結論:在每一份英語試卷中,RST 在兩套聽力考試中取得了最高的總分,平均分數為130.6 分;與T0pp相比,RST 的性能要遠優於相同模型大小下的T0pp。在所有設定中,RST 獲得的總分平均比T0pp 高出54.5 分,最高差距為69 分(佔總分的46%);與GPT3 相比,RST 可以在模型大小小16 倍的情況下取得明顯更好的結果。在所有考慮的設定中,RST 獲得的總分平均比T0pp 高14.0 分,最高為26 分(佔總分的17%);對於T0pp,使用黃金和語音轉文本成績單獲得的聽力分數差異很大,平均為4.2 分。相較之下,GPT3 和 RST 分別為 0.6 和 0.45,顯示 T0pp 的表現對文字品質很敏感。

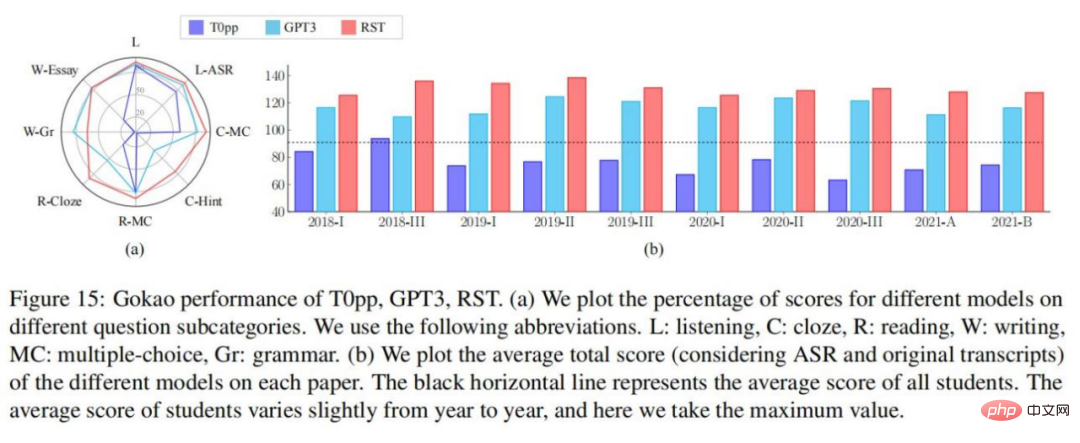

該研究進行了細粒度分析,以了解不同模型在不同問題子類別上的表現。在圖 15-(a) 中,很明顯 RST 和 GPT3 在每個問題子類別上都優於 T0pp。

圖 15-(b)為近年來模型的表現和學生在全國試卷上的平均表現。很明顯,T0pp 在 9/10 試卷上的總分低於學生的平均水平,而 RST 和 GPT3 的表現則超過了學生的平均水平。尤其是這十份試卷中有五份,RST 的總分超過了 130(通常被認為是學生爭取的目標分數)。

2022 年高考 - 英語考試(2022.06.08)剛結束,了解到模型在最近一年的高考試卷中的表現。研究以 GPT3 和 RST 進行實驗。結果顯示 RST 總分達到 134,遠高於 GPT3 達到的 108 分。

以上是今年英語高考,CMU用重構預訓練交出134高分,大幅超越GPT3的詳細內容。更多資訊請關注PHP中文網其他相關文章!