在機器人頂會 RSS 2024 上,中國的人形機器人研究斬獲最佳論文獎

- 王林原創

- 2024-07-22 14:56:45753瀏覽

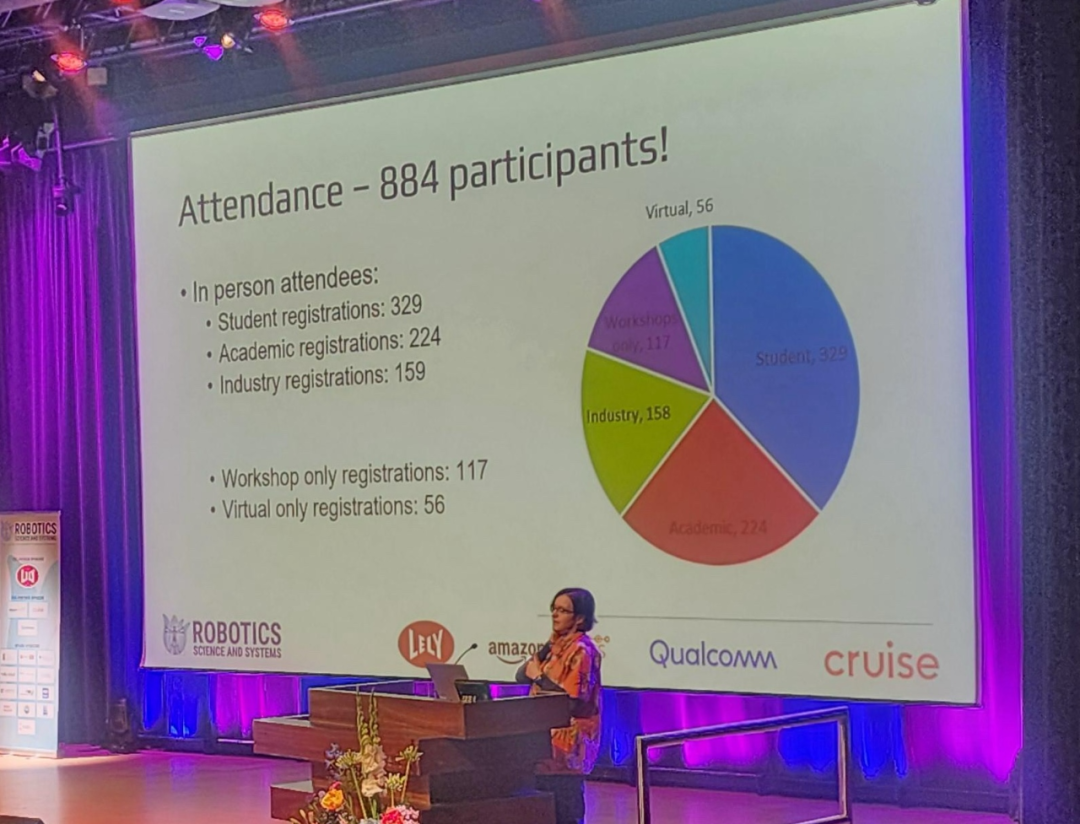

近日,機器人領域著名會議 RSS(Robotics: Science and Systems) 2024 在荷蘭代爾夫特理工大學圓滿落幕。

儘管會議規模與 NeurIPS、CVPR 等 AI 頂會無法比肩,但 RSS 在過去幾年中取得了長足的發展,今年的與會者人數接近 900 人。

在大會的最後一天,最佳論文、最佳學生論文、最佳系統論文、最佳 Demo 論文等多個獎項同時出爐。此外,大會還選出了「早期職業 Spotlight 獎」和「時間檢驗獎」。

值得注意的是,來自清華大學和北京星動紀元科技有限公司的人形機器人研究獲得了最佳論文獎,華人學者 Ji Zhang 獲得了本次時間檢驗獎。

以下是獲獎論文資訊介紹:

最佳Demo 論文獎

論文標題:Demonstrating CropFollow++: Robustol-Ccanod-conchukando eus Valverde Gasparino, Michael McGuire, Vitor Akihiro Hisano Higuti, M. Ugur Akcal, Girish Chowdhary

機構:UIUC、Earth Sense

論文連結:https://enriquecoronadozu.20.2320/pings20020/p pdf

在這篇論文中,研究者提出了一種基於經驗的魯棒性視覺導航系統,用於使用語義關鍵點的作物冠下農業機器人。

由於作物行間距較小(∼ 0.75 公尺)、多徑誤差導致 RTK-GPS 精度下降以及雜波過多導致雷射雷達測量產生噪聲,作物冠下的自主導航具有挑戰性。早期名為 CropFollow 的工作透過提出一種基於學習的端到端感知視覺導航系統來應對這些挑戰。然而,這種方法有以下限制:缺乏可解釋的表徵,以及由於置信度不夠缺乏在遮蔽期間對離群預測的敏感性。

本文系統 CropFollow++ 引入了模組化感知架構和學習的語意關鍵點表示法。與 CropFollow 相比,CropFollow++ 的模組化程度更高、可解釋性更強,並提供了檢測閉塞的置信度。 CropFollow++ 在具有挑戰性的晚季田間測試中的表現明顯優於 CropFollow,每個田間測試跨度達 1.9 千米,所需的碰撞次數為 13 次對 33 次。研究者也在不同的田間條件下,將 CropFollow++ 大規模部署在多個作物冠下覆蓋作物種植機器人中(總長 25 公里),並討論了從中汲取的主要經驗教訓。

論文標題:Demonstrating Agile Flight from Pixels without State Estimation

論文標題:Demonstrating Agile Flight from Pixels without State Estimation

作者:smail Geles, Leonard Bauersfeld, Angel Romero

作者:smail Geles, Leonard Bauersfeld, Angel Romero ronadozu .github.io/rssproceedings2024/rss20/p082.pdf- 四旋翼無人機是最敏捷的飛行機器人之一。儘管最近的一些研究在基於學習的控制和電腦視覺方面取得了進步,但自主無人機仍然依賴明確的狀態估計。另一方面,人類飛行員只能依靠無人機機載攝影機提供的第一人稱視角的視訊串流將平台推向極限,並在看不見的環境中穩健飛行。

本文展示了首個基於視覺的四旋翼無人機系統,該系統可在直接將像素映射到控制指令的同時,自主高速通過一連串門。與專業的無人機賽車手一樣,該系統不使用明確的狀態估計,而是利用與人類相同的控制指令(集體推力和身體速率)。研究者展示了速度高達 40km/h 且加速高達 2g 的敏捷飛行。這是透過強化學習(RL)訓練基於視覺的策略來實現的。使用非對稱的 Actor-Critic 可以獲得特權信息,為訓練提供便利。為了克服基於圖像的 RL 訓練過程中的計算複雜性,研究者使用門的內邊緣作為感測器抽象。在訓練過程中,無需渲染影像就能模擬這種簡單而強大的任務相關表示法。在部署過程中,研究者使用了基於 Swin Transformer 的閘偵測器。

本文方法可以利用標準的、現成的硬體來實現自主敏捷飛行。雖然演示側重於無人機競賽,但該方法的影響已經超出了競賽範圍,可以作為未來研究結構化環境中真實世界應用的基礎。

論文標題:Universal Manipulation Interface: In-The-Wild Robot Teaching Without In-The-Wild Robots

Cheng Chi, Zhenjia Xu, Chuer Pan, Eric Cousin

Cheng Chi, Zhenjia Xu, Chuer Pan, Eric Cousineau, Benjamin, Shusineau, Benjamin Song- 機構:史丹佛大學、哥倫比亞大學、豐田研究院

- 論文連結:https://arxiv.org/pdf/2402.10329

本文介紹了通用操縱 本文介紹了通用操縱

本文介紹了通用操縱

- 本文介紹了通用操縱資料收集和策略學習框架,可將野外人類演示的技能直接轉移到可部署的機器人策略中。 UMI 採用手持式抓手和精心的介面設計,可為具有挑戰性的雙臂和動態操縱演示提供便攜式、低成本和資訊豐富的資料收集。為了促進可部署的策略學習,UMI 採用了精心設計的策略介面,具有推理時間延遲匹配和相對軌跡動作表示功能。學習到的策略與硬體無關,可在多個機器人平台上部署。有了這些功能,UMI 框架就能釋放新的機器人操縱能力,只需改變每個任務的訓練數據,就能實現零樣本泛化動態、雙臂、精確和長視野行為。研究者透過全面的真實世界實驗證明了 UMI 的多功能性和有效性,在這些實驗中,透過 UMI 零射頻學習到的策略在不同的人類演示訓練中可泛化到新的環境和物體。

- 論文標題:Khronos: A Unified Approach for Spatio-Temporal Metric-Semantic SLAM in Dynamic Environments

- 作者:Lukas Schmid, Marcus Abate, Yun Chang, Luca Carlone

為了應對這一挑戰,這項研究定義了時空度量 - 語義 SLAM(SMS)問題,並提出了一個有效分解和解決該問題的框架。研究表明,所提出的因子化建議了一種時空感知系統的自然組織形式,其中一個快速進程追蹤活動時間窗口中的短期動態,而另一個慢速進程則利用因子圖表述對環境中的長期變化進行推理。研究者提供了一種高效的時空感知方法 Khronos,並證明它統一了對短期和長期動態的現有解釋,能夠即時建立密集的時空地圖。

論文提供的模擬和實際結果表明,Khronos 建構的時空地圖能夠準確反映三維場景的時間變化,而且 Khronos 在多個指標上都優於基線。

- 論文標題:Dynamic On-Palm Manipulation via Controlled Sliding

- 論文連結:https://arxiv.org/pdf/2405.08731

- 當前,對機器人執行非抓取性動作的研究主要集中在靜態接觸上,以規避滑動可能帶來的問題。但是,如果根本上消除了「手滑」的問題,即能控制接觸時的滑動,這將為機器人所能做的動作開闢新領域。

在這篇論文中,研究者提出了一項挑戰性的動態非抓取操作任務,該任務需要綜合考慮各種混合接觸模式。研究者採用了最新的隱式接觸模型預測控制(MPC)技術,幫助機器人進行多模式規劃,以完成各項任務。論文詳細探討如何將用於 MPC 的簡化模型與低階追蹤控制器相整合,以及如何使隱式接觸 MPC 適應於動態任務的需求。

令人印象深刻的是,儘管眾所周知,摩擦和剛性接觸模型往往不準確,但這篇論文的方法能夠對這些不準確性做出靈敏反應,同時快速完成任務。而且,研究者並沒有使用於常見的輔助工具,例如參考軌跡或運動基元輔助機器人完成任務,這進一步凸顯了此方法的通用性。這是隱性接觸 MPC 技術首次被應用於三維空間中的動態操作任務。

令人印象深刻的是,儘管眾所周知,摩擦和剛性接觸模型往往不準確,但這篇論文的方法能夠對這些不準確性做出靈敏反應,同時快速完成任務。而且,研究者並沒有使用於常見的輔助工具,例如參考軌跡或運動基元輔助機器人完成任務,這進一步凸顯了此方法的通用性。這是隱性接觸 MPC 技術首次被應用於三維空間中的動態操作任務。

論文標題:Agile But Safe: Learning Collision-Free High-Speed Legged Locomotion

-

作者:Tairan He Chong Zhang, Wenli Xia, Guan

:CMU、瑞士蘇黎世聯邦理工學院 - 論文連結:https://arxiv.org/pdf/2401.17583

- 四足機器人在雜亂的環境中穿行時,需要同時具備靈活性和安全性。它們需要既能夠敏捷地完成任務,又要避免與人或障礙物相撞。不過,現有的研究往往只注重其中一方面:要么是為了安全而設計速度不超過 1.0 米 / 秒的保守控制器,要么是追求靈活性卻忽略了可能致命的碰撞問題。

- 作者:Arbat, Martyitan)

機構:得克薩斯大學奧斯汀分校

論文連結:https://arxiv.org/pdf/2405.03666

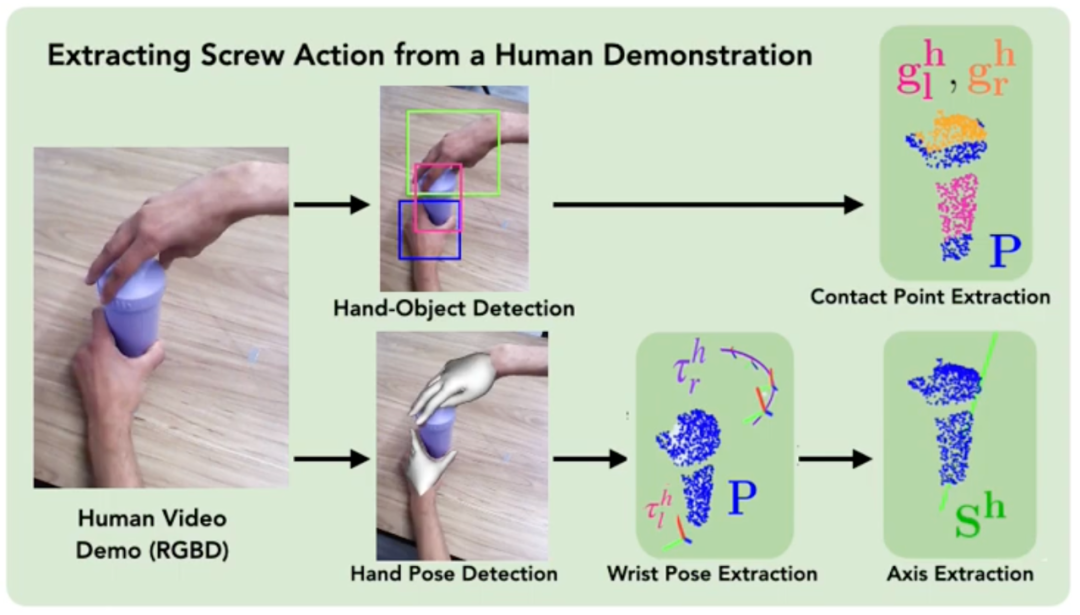

如果要教機器人如何用兩隻手同時做某件事情,例如同時打開一個盒子,實際上很困難。因為機器人需要同時控制很多關節,也要確保兩隻手的動作協調一致。對於人類,人們會透過觀察別人,學會新的動作,再自己嘗試並不斷改進。在這篇論文中,研究者參考人類學習的方法,讓機器人也能透過看影片學習新技能,並且在實踐中提升。

研究者們從心理學和生物力學的研究中得到靈感,他們把兩隻手的動作想像成一種特殊的鏈條,這種鏈條可以像螺絲一樣旋轉,稱之為「螺旋動作」。基於此,他們開發了一個名為 ScrewMimic 的系統。這個系統可以幫助機器人更好地理解人類的演示,並透過自我監督來改進動作。透過實驗,研究者發現 ScrewMimic 系統能幫助機器人從一段影片中學習到複雜的雙手操作技能,並在表現上超越了那些直接在原始動作空間中學習和改進的系統。

ScrewMimic 的方法中示意圖

ScrewMimic 的方法中示意圖論文標題:Advancing Humanoid Locomotion: Mastering Challenging Terrains with Denoising World Model Learning

作者:Xinyang Gu, Yen-Jen Wang, Xiang Zhu, Chengming Shi, Yanjiang Guo, Yichen Liu, Jianyu Chen

機構:北京星動紀元科技有限公司、清華大學

機構:北京星動紀元科技有限公司、清華大學

Lien papier : https://enriquecoronadozu.github.io/rssproceedings2024/rss20/p058.pdf

La technologie actuelle ne peut permettre aux robots humanoïdes de marcher que sur un sol plat et un terrain aussi simple. Cependant, il reste difficile de les laisser se déplacer librement dans des environnements complexes, comme de véritables scènes extérieures. Dans cet article, les chercheurs proposent une nouvelle méthode appelée apprentissage de modèle mondial de débruitage (DWL).

DWL est un cadre d'apprentissage par renforcement de bout en bout pour le contrôle des mouvements des robots humanoïdes. Ce cadre permet au robot de s'adapter à une variété de terrains inégaux et difficiles, tels que la neige, les pentes et les escaliers. Il convient de mentionner que ces robots ne nécessitent qu’un seul processus d’apprentissage et peuvent relever divers défis de terrain dans le monde réel sans formation spéciale supplémentaire.

Cette recherche a été réalisée conjointement par Beijing Xingdong Era Technology Co., Ltd. et l'Université Tsinghua. Fondée en 2023, Xingdong Era est une entreprise technologique incubée par l'Institut de recherche en informations croisées de l'Université Tsinghua qui développe des technologies et des produits d'intelligence incarnée et de robots humanoïdes généraux. Le fondateur est Chen Jianyu, professeur adjoint et directeur de doctorat à l'Institut de recherche en informations croisées de l'Université Tsinghua. , axé sur l'application de pointe de l'intelligence artificielle générale (AGI), s'engage dans le développement de robots humanoïdes universels capables de s'adapter à un large éventail de domaines, de scénarios multiples et d'une intelligence élevée.

Titre de l'article : Détection d'anomalies en temps réel et planification réactive avec de grands modèles de langage

Auteurs : Rohan Sinha, Amine Elhafsi, Christopher Agia, Matt Foutter, Edward Schmerling, Marco Pavone

Institution :Stanford University

Lien papier : https://arxiv.org/pdf/2407.08735

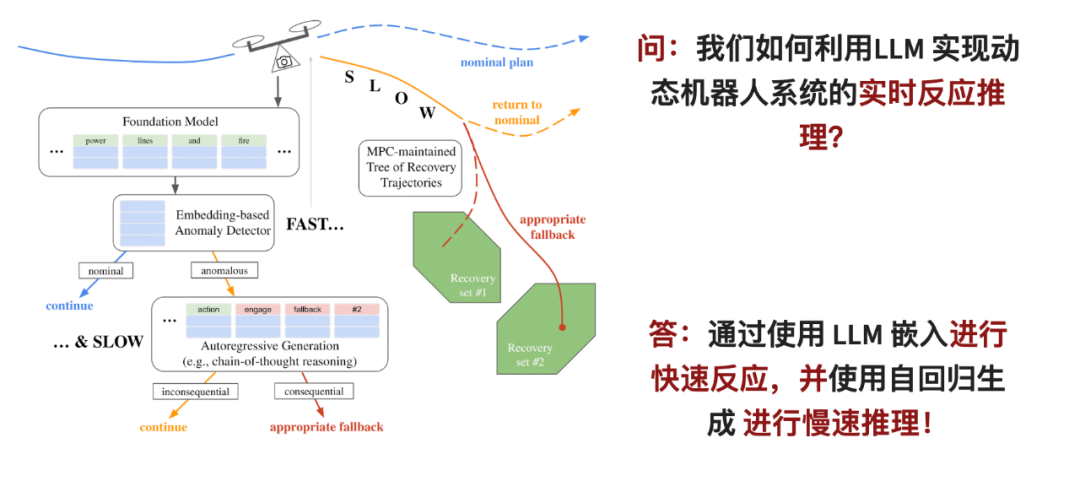

Les grands modèles de langage (LLM), dotés de capacités de généralisation sans tir, ce qui les rend prometteurs pour les robots de détection et d'exclusion. Techniques pour panne de distribution du système. Cependant, pour que les modèles de langage à grande échelle fonctionnent réellement, deux problèmes doivent être résolus : premièrement, LLM nécessite que de nombreuses ressources informatiques soient appliquées en ligne ; deuxièmement, le jugement de LLM doit être intégré dans le système de contrôle de sécurité du robot.

Dans cet article, les chercheurs ont proposé un cadre de raisonnement en deux étapes : pour la première étape, ils ont conçu un détecteur d'anomalies rapide qui peut analyser rapidement les observations du robot dans l'espace de compréhension du LLM si des problèmes sont détectés, la suivante ; l’étape de sélection alternative est entrée. À ce stade, les capacités d'inférence de LLM sont utilisées pour effectuer une analyse plus approfondie.

L'étape entrée correspond au point de branchement de la stratégie de contrôle prédictif du modèle, qui peut suivre et évaluer simultanément différents plans alternatifs pour résoudre le problème de latence des raisonneurs lents. Une fois que le système détecte une anomalie ou un problème, cette stratégie sera activée immédiatement pour garantir la sécurité des actions du robot.

Le classificateur d'anomalies rapide présenté dans cet article surpasse l'inférence autorégressive utilisant des modèles GPT de pointe, même lors de l'utilisation de modèles de langage relativement petits. Cela permet au moniteur en temps réel proposé dans l'article d'améliorer la fiabilité des robots dynamiques avec des ressources et un temps limités, comme dans les quadricoptères et les voitures sans conducteur.

Titre du papier: Configuration Espace Distance Fields for Manipulation Planning

author: Yiming Li, Xuemin Chi, Amirreza Razmjoo, Sylvain Calion

Institution: Suisse I Diap Institute, Lausanne, Institut fédéral de technologie de Suisse, Université du Zhejiang

Lien papier : https://arxiv.org/pdf/2406.01137

Le champ de distance signé (SDF) est une représentation de forme implicite populaire en robotique, qui fournit des informations géométriques sur objets et obstacles et peut être facilement combiné avec des techniques de contrôle, d’optimisation et d’apprentissage. SDF est généralement utilisé pour représenter les distances dans l'espace des tâches, ce qui correspond à la notion de distance perçue par les humains dans le monde 3D.

Dans le domaine de la robotique, SDF est souvent utilisé pour représenter l'angle de chaque articulation du robot. Les chercheurs savent généralement quelles zones de l'espace angulaire des articulations du robot sont sûres, c'est-à-dire que les articulations du robot peuvent pivoter vers ces zones sans collision. Cependant, ils n’expriment pas souvent ces zones de sécurité en termes de champs de distance.

In diesem Artikel schlagen die Forscher das Potenzial der Verwendung eines SDF zur Optimierung des Roboterkonfigurationsraums vor, den sie als Configuration Space Distance Field (kurz CDF) bezeichnen. Ähnlich wie die Verwendung von SDF bietet CDF eine effiziente Suche nach Gelenkwinkelabständen und direkten Zugriff auf Ableitungen (Gelenkwinkelgeschwindigkeiten). Normalerweise ist die Roboterplanung in zwei Schritte unterteilt: Zuerst wird geprüft, wie weit die Aktion vom Ziel im Aufgabenraum entfernt ist, und dann wird mithilfe der inversen Kinematik berechnet, wie sich die Gelenke drehen. Aber CDF vereint diese beiden Schritte in einem Schritt und löst das Problem direkt im Gelenkraum des Roboters, was einfacher und effizienter ist. In der Arbeit schlugen die Forscher einen effizienten Algorithmus zur Berechnung und Fusion von CDF vor, der auf jedes Szenario erweitert werden kann.

Sie schlugen außerdem eine entsprechende neuronale CDF-Darstellung unter Verwendung von mehrschichtigen Perzeptronen (MLPs) vor, um eine kompakte und kontinuierliche Darstellung zu erhalten und so die Recheneffizienz zu verbessern. Das Papier enthält einige konkrete Beispiele, um die Wirkung von CDF zu demonstrieren, z. B. das Ausweichen des Roboters vor Hindernissen in einem Flugzeug und das Ausführen einiger Aktionsplanungsaufgaben durch den 7-Achsen-Roboter Franka. Diese Beispiele veranschaulichen die Wirksamkeit von CDF.机 Der Roboterarm der CDF-Methode besteht aus einer Raising-Box-Aufgabe

Die Early Professional Spotlight-Konferenz hat auch den Early Professional Spotlight Award ausgewählt. Es handelt sich um die Navigation von Robotern unbekannte Umgebungen.

Stefan Leutenegger ist Assistenzprofessor (Tenure-Track) an der School of Computing, Information and Technology (CIT) der Technischen Universität München (TUM) und arbeitet mit dem Münchner Institut für Robotik und Maschinelle Intelligenz zusammen ( MIRMI) und das Munich Institute for Data Science (MDSI) sind mit dem Munich Center for Machine Learning (MCML) verbunden und waren Mitglied des Dyson Robotics Laboratory. Das von ihm geleitete Smart Robot Laboratory (SRL) widmet sich der Forschung an der Schnittstelle von Wahrnehmung, mobilen Robotern, Drohnen und maschinellem Lernen. Darüber hinaus ist Stefan Gastdozent am Department of Computing des Imperial College London.Er war Mitbegründer von SLAMcore, einem Spin-out-Unternehmen, das auf die Kommerzialisierung von Positionierungs- und Kartierungslösungen für Roboter und Drohnen abzielt. Stefan erhielt seinen Bachelor- und Masterabschluss in Maschinenbau von der ETH Zürich und promovierte 2014 mit einer Arbeit zum Thema „Unmanned Solar Aircraft: Design and Algorithms for Efficient and Robust Autonomous Operation“.

Test of Time Award

RSS Der Test of Time Award wird an den einflussreichsten Artikel verliehen, der vor mindestens zehn Jahren in RSS (und möglicherweise in seiner Zeitschriftenversion) veröffentlicht wurde. Einfluss kann unter drei Aspekten verstanden werden: zum Beispiel die Änderung der Art und Weise, wie Menschen über Probleme oder Roboterdesign denken, die Aufmerksamkeit der Community auf neue Probleme zu lenken oder die Schaffung neuer Methoden für Roboterdesign oder Problemlösung.

RSS Der Test of Time Award wird an den einflussreichsten Artikel verliehen, der vor mindestens zehn Jahren in RSS (und möglicherweise in seiner Zeitschriftenversion) veröffentlicht wurde. Einfluss kann unter drei Aspekten verstanden werden: zum Beispiel die Änderung der Art und Weise, wie Menschen über Probleme oder Roboterdesign denken, die Aufmerksamkeit der Community auf neue Probleme zu lenken oder die Schaffung neuer Methoden für Roboterdesign oder Problemlösung.

Mit dieser Auszeichnung hofft RSS, die Diskussion über die langfristige Entwicklung dieses Bereichs anzuregen. Der diesjährige Time Test Award geht an Ji Zhang und Sanjiv Singh für ihre Forschung „LOAM: LiDAR Ranging and Real-time Mapping“.

Link zum Papier: https://www.ri.cmu.edu/pub_files/2014/7/Ji_LidarMapping_RSS2014_v8.pdf

Diese zehn Jahre alte Arbeit schlägt eine Methode vor, um die 6-DOF-Bewegung von Doppel-A zu nutzen Echtzeitmethode zur Odometrie und Kartierung axialer Lidar-Odometriedaten. Der Grund dafür, dass dieses Problem schwer zu lösen ist, liegt darin, dass die Entfernungsdaten zu unterschiedlichen Zeiten empfangen werden und Fehler bei der Bewegungsschätzung zu einer Fehlregistrierung der resultierenden Punktwolke führen können. Kohärente 3D-Karten können mit Offline-Batch-Methoden erstellt werden, wobei häufig Schleifenschließungen zum Korrigieren zeitlicher Abweichungen zum Einsatz kommen. Die Methode in diesem Artikel erfordert keine hochpräzise Entfernungsmessung oder Trägheitsmessung und kann eine geringe Drift und einen geringen Rechenaufwand erzielen. Der Schlüssel zum Erreichen dieses Leistungsniveaus besteht darin, das komplexe Problem der gleichzeitigen Positionierung und Zuordnung in zwei Algorithmen aufzuteilen, um eine große Anzahl von Variablen gleichzeitig zu optimieren. Ein Algorithmus führt die Entfernungsmessung mit hoher Frequenz, aber geringer Genauigkeit durch, um die Lidar-Geschwindigkeit zu schätzen; der andere Algorithmus arbeitet mit einer um eine Größenordnung niedrigeren Frequenz für die Feinanpassung und Registrierung von Punktwolken. Die Kombination dieser beiden Algorithmen ermöglicht es der Methode, in Echtzeit zu zeichnen. Die Forscher bewerteten es anhand umfangreicher Experimente und des KITTI-Geschwindigkeitsbenchmarks. Die Ergebnisse zeigten, dass die Methode das SOTA-Genauigkeitsniveau von Offline-Batch-Methoden erreichen kann. Weitere Konferenz- und Preisinformationen finden Sie auf der offiziellen Website: https://roboticsconference.org/以上是在機器人頂會 RSS 2024 上,中國的人形機器人研究斬獲最佳論文獎的詳細內容。更多資訊請關注PHP中文網其他相關文章!