Rumah >Peranti teknologi >AI >Bentuk super berkembang Mamba menumbangkan Transformer dalam satu gerakan! A100 tunggal menjalankan konteks 140K

Bentuk super berkembang Mamba menumbangkan Transformer dalam satu gerakan! A100 tunggal menjalankan konteks 140K

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2024-03-29 15:11:18900semak imbas

Seni bina Mamba, yang sebelum ini meletupkan bulatan AI, telah melancarkan varian hebat hari ini!

Makmal unicorn kecerdasan buatan AI21 baru sahaja Jamba sumber terbuka, model besar Mamba gred pengeluaran pertama di dunia!

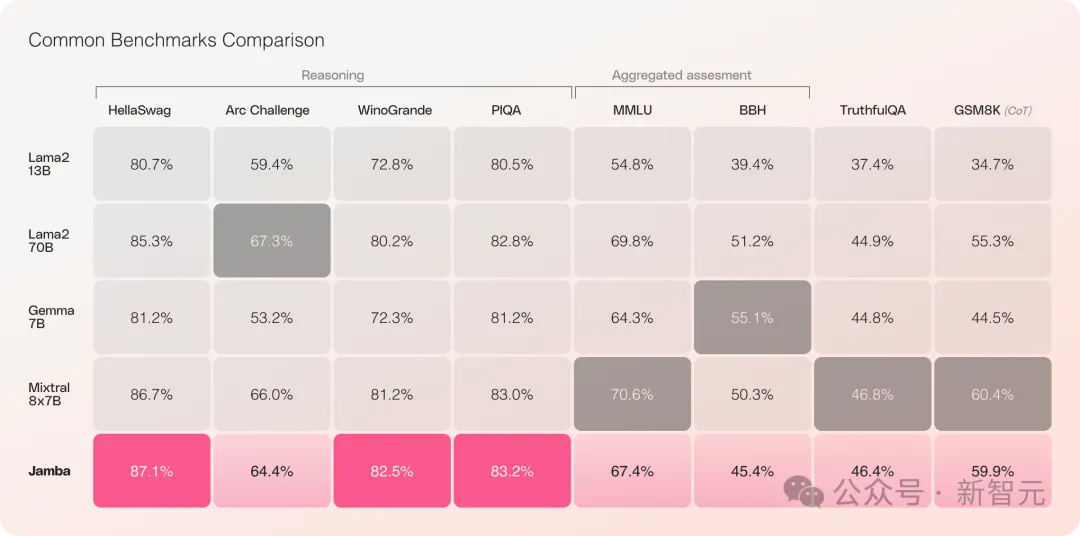

Jamba telah menunjukkan prestasi yang baik dalam berbilang ujian penanda aras, dan setanding dengan beberapa Transformer sumber terbuka terkuat pada masa ini.

Apatah lagi bila membandingkan Mixtral 8x7B yang mempunyai prestasi terbaik dan juga seni bina KPM, ada juga yang menang dan kalah.

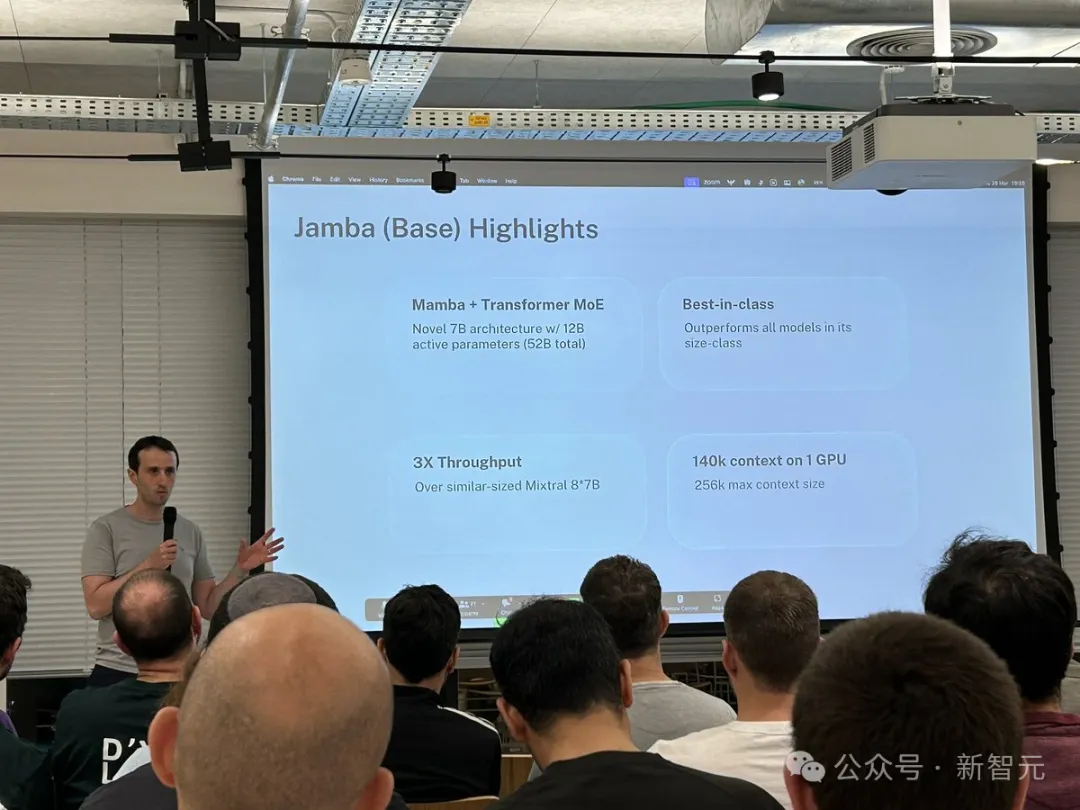

Secara khusus -

- ialah model Mamba gred pengeluaran pertama berdasarkan seni bina hibrid SSM-Transformer baharu

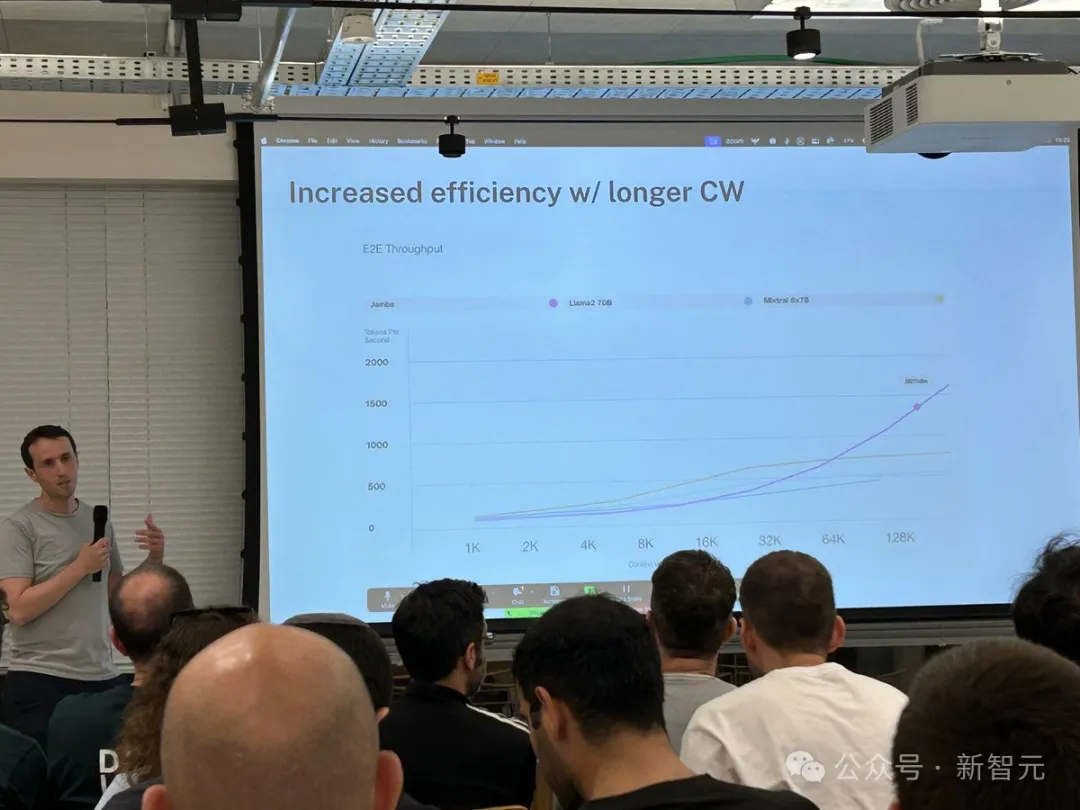

- Berbanding dengan Mixtral 8x7B, pemprosesan teks yang panjang 3 kali ganda melaluiput Mencapai tetingkap konteks ultra panjang 256K

- Ia adalah satu-satunya model skala yang sama yang boleh memproses konteks 140K pada satu GPU

- Dikeluarkan di bawah perjanjian lesen sumber terbuka Apache 2.0, dengan hak terbuka berat

Disebabkan pelbagai sekatan, Mamba sebelum ini hanya boleh mencapai 3B Ia juga dipersoalkan sama ada ia boleh mengambil alih sepanduk RWKV, Griffin, dan lain-lain, yang juga keluarga RNN linear, mempunyai sahaja diperluaskan kepada 14B.

Disebabkan pelbagai sekatan, Mamba sebelum ini hanya boleh mencapai 3B Ia juga dipersoalkan sama ada ia boleh mengambil alih sepanduk RWKV, Griffin, dan lain-lain, yang juga keluarga RNN linear, mempunyai sahaja diperluaskan kepada 14B.

——Jamba pergi terus ke 52B kali ini, membolehkan seni bina Mamba bersaing secara langsung dengan Transformer peringkat pengeluaran buat kali pertama.

Jamba adalah berdasarkan seni bina Mamba yang asli dan menggabungkan kelebihan Transformer untuk mengimbangi batasan yang wujud dalam model angkasa negeri (SSM).

Jamba adalah berdasarkan seni bina Mamba yang asli dan menggabungkan kelebihan Transformer untuk mengimbangi batasan yang wujud dalam model angkasa negeri (SSM).

Boleh dianggap ini sebenarnya seni bina baharu - hibrid Transformer dan Mamba, dan yang paling penting ia boleh berjalan pada satu A100.

Boleh dianggap ini sebenarnya seni bina baharu - hibrid Transformer dan Mamba, dan yang paling penting ia boleh berjalan pada satu A100.

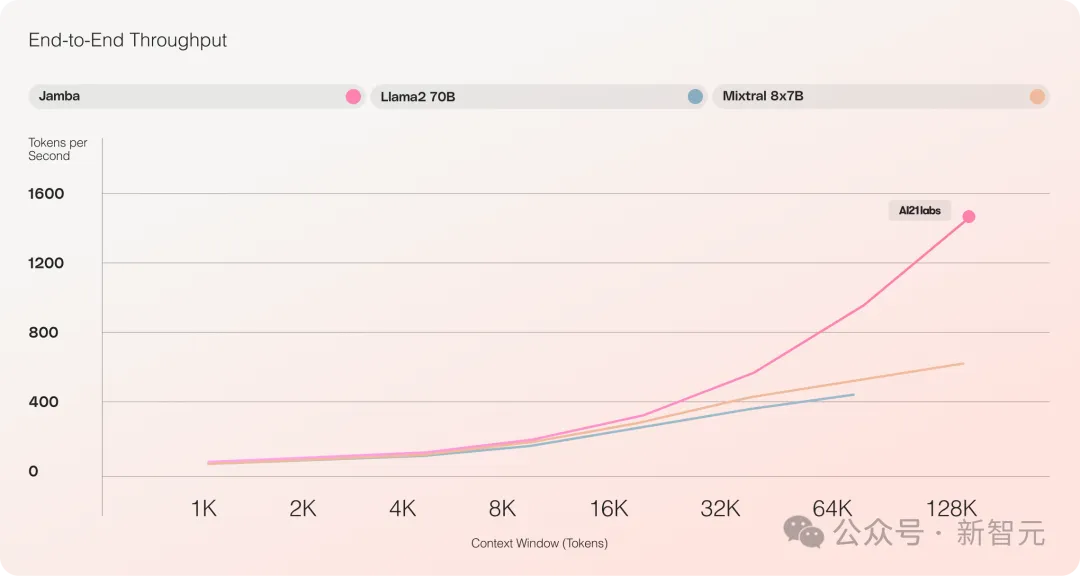

Ia menyediakan tetingkap konteks ultra panjang sehingga 256K, satu GPU boleh menjalankan konteks 140K, dan daya pemprosesan adalah 3 kali ganda berbanding Transformer!

Berbanding dengan Transformer, adalah sangat mengejutkan untuk melihat bagaimana Jamba menskala ke panjang konteks yang besar

Berbanding dengan Transformer, adalah sangat mengejutkan untuk melihat bagaimana Jamba menskala ke panjang konteks yang besar

Jamba menerima pakai penyelesaian MoE, 12B daripada 52B adalah parameter aktif pada masa ini di bawah Apache, dan model 2 dibuka pada masa ini Berat boleh dimuat turun dari huggingface.

Muat turun model: https://huggingface.co/ai21labs/Jamba-v0.1

Muat turun model: https://huggingface.co/ai21labs/Jamba-v0.1

Pencapaian LLM baharu

Penerbitan

dua batu penting untuk LLMPertama, ia berjaya menggabungkan Mamba dengan seni bina Transformer, dan kedua, ia berjaya meningkatkan bentuk model baharu (SSM-Transformer) kepada skala dan kualiti peringkat pengeluaran.

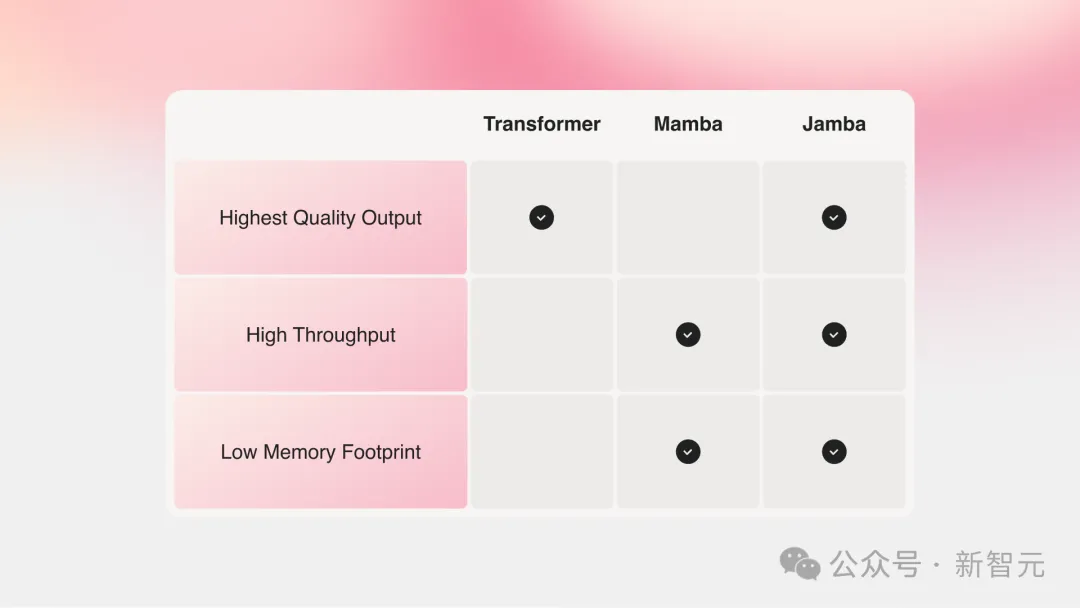

Model besar semasa dengan prestasi terkuat semuanya berdasarkan Transformer, walaupun semua orang juga menyedari dua kelemahan utama seni bina Transformer:

Jejak memori besar: Jejak memori Transformer berbeza mengikut panjang konteks Dan mengembang. Menjalankan tetingkap konteks yang panjang atau pemprosesan kelompok selari secara besar-besaran memerlukan banyak sumber perkakasan, yang mengehadkan percubaan dan penggunaan berskala besar.

Apabila konteks berkembang, kelajuan inferens akan menjadi perlahan: Mekanisme perhatian Transformer menyebabkan masa inferens berkembang secara tepat berbanding panjang jujukan, dan pemprosesan akan menjadi lebih perlahan dan perlahan. Kerana setiap token bergantung pada keseluruhan urutan sebelum itu, ia menjadi agak sukar untuk mencapai konteks yang sangat panjang.

Beberapa tahun lalu, dua orang besar dari Carnegie Mellon dan Princeton mencadangkan Mamba, yang serta-merta mencetuskan harapan orang ramai.

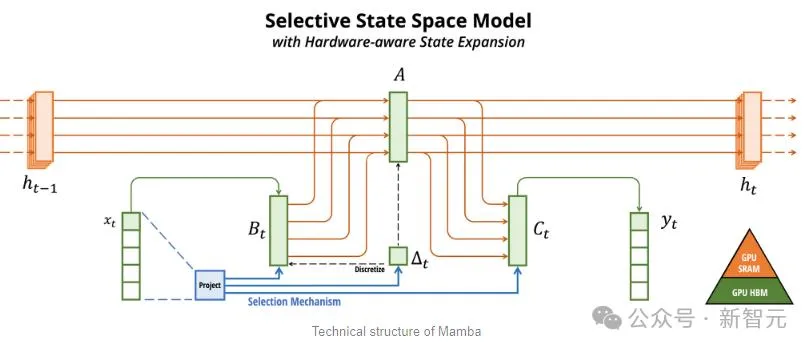

Mamba berasaskan SSM, menambah keupayaan untuk mengekstrak maklumat secara selektif, dan algoritma yang cekap pada perkakasan, menyelesaikan masalah Transformer dalam satu kejadian.

Bidang baharu ini serta-merta menarik sejumlah besar penyelidik, dan sejumlah besar aplikasi dan penambahbaikan Mamba muncul pada arXiv, seperti Vision Mamba, yang menggunakan Mamba untuk penglihatan.

Saya harus mengatakan bahawa bidang penyelidikan saintifik semasa adalah sangat rumit. Ia mengambil masa tiga tahun untuk memperkenalkan Transformer into Vision (ViT), tetapi ia hanya mengambil masa satu bulan untuk pergi dari Mamba ke Vision Mamba.

Walau bagaimanapun, panjang konteks Mamba asal adalah lebih pendek, dan model itu sendiri tidak diperbesarkan, jadi sukar untuk mengalahkan model SOTA Transformer, terutamanya dalam tugas yang berkaitan dengan penarikan balik.

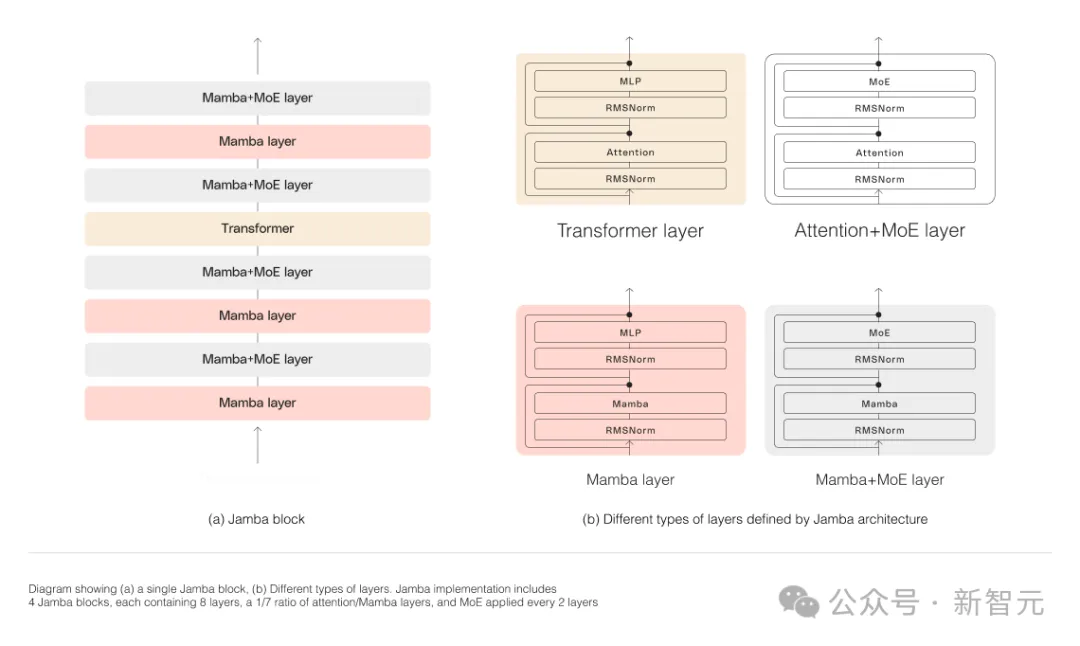

Jamba kemudian melangkah lebih jauh dan menyepadukan kelebihan Transformer, Mamba, dan Mix of Experts (MoE) melalui Seni Bina Perhatian Bersama dan Mamba, sambil mengoptimumkan memori, daya pemprosesan dan prestasi.

Jamba ialah seni bina hibrid pertama yang mencapai skala pengeluaran (parameter 52B).

Seperti yang ditunjukkan dalam rajah di bawah, seni bina Jamba AI21 menggunakan pendekatan blok-dan-lapisan, membolehkan Jamba berjaya mengintegrasikan kedua-dua seni bina.

Setiap blok Jamba terdiri daripada lapisan perhatian atau lapisan Mamba, diikuti oleh perceptron berbilang lapisan (MLP).

Ciri kedua Jamba ialah menggunakan KPM untuk menambah jumlah parameter model sambil memudahkan bilangan parameter aktif yang digunakan dalam inferens, dengan itu meningkatkan kapasiti model tanpa meningkatkan keperluan pengiraan.

Untuk memaksimumkan kualiti model dan daya pemprosesan pada satu GPU 80GB, penyelidik mengoptimumkan bilangan lapisan MoE dan pakar yang digunakan, meninggalkan memori yang mencukupi untuk beban kerja inferens biasa.

Berbanding dengan model berasaskan Transformer dengan saiz yang sama seperti Mixtral 8x7B, Jamba mencapai 3 kali pecutan pada konteks yang panjang.

Jamba akan ditambahkan pada direktori NVIDIA API tidak lama lagi.

Ada pemain baharu dalam konteks panjang

Baru-baru ini, syarikat utama melancarkan konteks yang panjang.

Model dengan tetingkap konteks yang lebih kecil cenderung melupakan kandungan perbualan baru-baru ini, manakala model dengan konteks yang lebih besar mengelakkan perangkap ini dan boleh memahami aliran data yang mereka terima dengan lebih baik.

Walau bagaimanapun, model dengan tetingkap konteks yang panjang cenderung kepada intensif pengiraan.

Model generatif permulaan AI21 Labs membuktikan bahawa ini tidak berlaku.

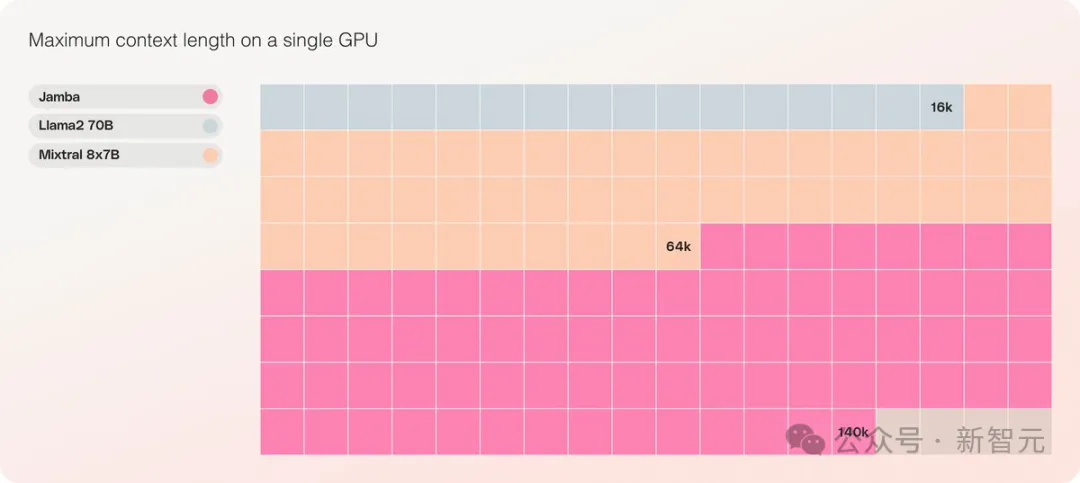

Jamba boleh mengendalikan sehingga 140,000 token apabila dijalankan pada satu GPU (seperti A100) dengan sekurang-kurangnya 80GB memori video.

Ini bersamaan dengan kira-kira 105,000 patah perkataan, atau 210 halaman, iaitu panjang novel sederhana panjang.

Sebagai perbandingan, tetingkap konteks Meta Llama 2 hanya mempunyai 32,000 token dan memerlukan 12GB memori GPU.

Mengikut piawaian hari ini, tetingkap konteks ini jelas sekali kecil.

Dalam hal ini, beberapa netizen segera mengatakan bahawa prestasi tidak penting ialah Jamba mempunyai konteks 256K Kecuali Gemini, tidak ada orang lain yang begitu panjang - dan Jamba adalah sumber terbuka.

Apa yang menjadikan Jamba benar-benar unik

Pada zahirnya, Jamba mungkin kelihatan sederhana.

Sama ada DBRX atau Llama 2, yang menjadi tumpuan semalam, kini terdapat sejumlah besar model AI generatif percuma dan boleh dimuat turun.

Keunikan Jamba tersembunyi di bawah model: ia menggabungkan dua seni bina model pada masa yang sama - Transformer dan model angkasa lepas SSM.

Di satu pihak, Transformer ialah seni bina pilihan untuk tugas penaakulan yang kompleks. Ciri penentu terasnya ialah "mekanisme perhatian." Bagi setiap bahagian data input, Transformer menimbang perkaitan semua input lain dan ekstrak daripadanya untuk menjana output.

Sebaliknya, SSM menggabungkan banyak kelebihan model AI terdahulu, seperti rangkaian saraf berulang dan rangkaian saraf konvolusi, jadi ia boleh memproses data jujukan panjang dengan kecekapan pengiraan yang lebih tinggi.

Walaupun SSM ada batasannya yang tersendiri. Tetapi beberapa wakil awal, seperti Mamba yang dicadangkan oleh Princeton dan CMU, boleh mengendalikan output yang lebih besar daripada model Transformer dan lebih baik dalam tugas penjanaan bahasa.

Dalam hal ini, Dagan, ketua produk AI21 Labs, berkata -

Walaupun terdapat beberapa contoh awal model SSM, Jamba ialah model gred komersial pertama pada skala pengeluaran.

Pada pandangan beliau, selain inovatif dan menarik untuk masyarakat mengkaji lebih lanjut, Jamba juga menyediakan kemungkinan kecekapan dan daya pengeluaran yang besar.

Pada masa ini, Jamba dikeluarkan di bawah lesen Apache 2.0, yang mempunyai lebih sedikit sekatan penggunaan tetapi tidak boleh digunakan secara komersial. Versi diperhalusi seterusnya dijangka akan dilancarkan dalam masa beberapa minggu.

Walaupun masih dalam peringkat awal penyelidikan, Dagan menegaskan bahawa Jamba sudah pasti menunjukkan janji hebat seni bina SSM.

"Nilai tambahan model ini - kedua-duanya disebabkan oleh saiz dan inovasi seni bina - boleh dipasang dengan mudah pada satu GPU

Atas ialah kandungan terperinci Bentuk super berkembang Mamba menumbangkan Transformer dalam satu gerakan! A100 tunggal menjalankan konteks 140K. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- java软件系统功能设计实战训练视频教程

- Pengumuman rasmi Pusat Pengkomputeran Super Haimo: model besar dengan 100 bilion parameter, skala data 1 juta klip dan pengurangan 200 kali ganda dalam kos latihan

- Peperiksaan Masuk Kolej Inggeris tahun ini, CMU menggunakan pra-latihan pembinaan semula untuk mencapai skor tinggi 134, dengan ketara mengatasi GPT3

- Kembali ke masa depan! Menggunakan diari zaman kanak-kanak untuk melatih AI, pengaturcara ini menggunakan GPT-3 untuk mencapai dialog dengan 'diri masa lalu'nya

- Gunakan penglihatan untuk menggesa! Shen Xiangyang mempamerkan model baharu Institut Penyelidikan IDEA, yang tidak memerlukan latihan atau penalaan halus dan boleh digunakan di luar kotak.