Rumah >Peranti teknologi >AI >Terdapat juga pencuri dalam model besar? Untuk melindungi parameter anda, serahkan model besar untuk membuat 'cap jari yang boleh dibaca manusia'

Terdapat juga pencuri dalam model besar? Untuk melindungi parameter anda, serahkan model besar untuk membuat 'cap jari yang boleh dibaca manusia'

- PHPzke hadapan

- 2024-02-02 21:33:301443semak imbas

melambangkan model asas yang berbeza sebagai baka anjing yang berbeza, di mana "cap jari berbentuk anjing" yang sama menunjukkan bahawa ia berasal daripada model asas yang sama.

Pra-latihan model besar memerlukan sejumlah besar sumber dan data pengkomputeran, jadi parameter model pra-latihan telah menjadi daya saing teras dan aset yang difokuskan oleh institusi utama untuk melindungi. Walau bagaimanapun, tidak seperti perlindungan harta intelek perisian tradisional, terdapat dua masalah baharu dalam menilai kecurian parameter model pra-latihan:

1) Parameter model pra-latihan, terutamanya bagi ratusan bilion model, biasanya tidak terbuka. sumber.

Keluaran dan parameter model pra-latihan akan dipengaruhi oleh langkah-langkah pemprosesan berikutnya (seperti SFT, RLHF, meneruskan pralatihan, dll.), yang menyukarkan untuk menilai sama ada model diperhalusi berdasarkan satu lagi yang sedia ada. model. Sama ada menilai berdasarkan output model atau parameter model, terdapat cabaran tertentu.

Oleh itu, perlindungan parameter model besar adalah masalah baharu yang tidak mempunyai penyelesaian yang berkesan.

Pasukan penyelidik Lumia Profesor Lin Zhouhan dari Universiti Jiao Tong Shanghai telah membangunkan teknologi inovatif yang boleh mengenal pasti hubungan keturunan antara model besar. Pendekatan ini menggunakan cap jari model besar yang boleh dibaca manusia tanpa mendedahkan parameter model. Penyelidikan dan pembangunan teknologi ini sangat penting untuk pembangunan dan aplikasi model besar.

Kaedah ini menyediakan dua kaedah pengenalan: satu ialah kaedah pengenalan kuantitatif, yang menentukan sama ada model asas pra-latihan telah dicuri dengan membandingkan persamaan antara model besar yang diuji dan satu siri model asas; kaedah , temui hubungan warisan antara model dengan cepat dengan menjana "rajah anjing" yang boleh dibaca manusia.

Cap jari 6 model asas berbeza (baris pertama) dan model turunannya yang sepadan (dua baris bawah).

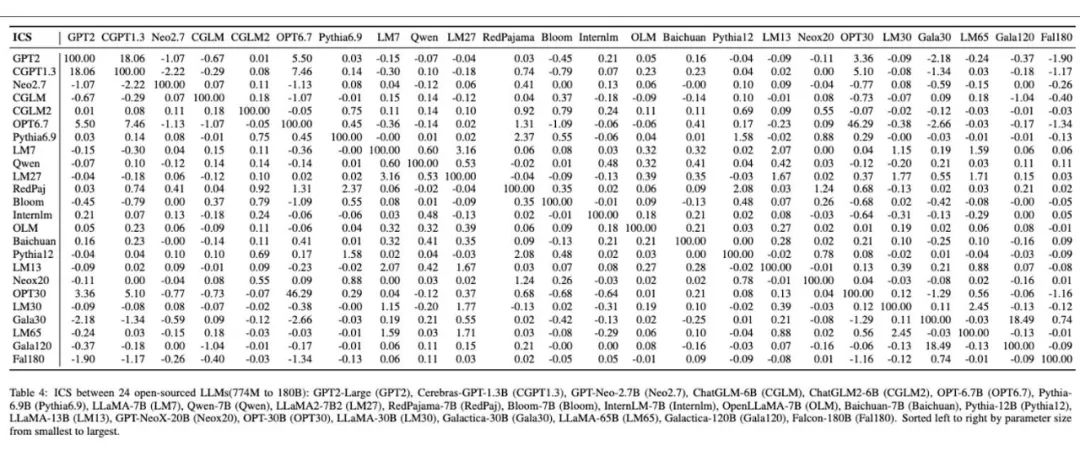

Cap jari model besar yang boleh dibaca manusia dihasilkan pada 24 model besar yang berbeza.

Motivasi dan pendekatan keseluruhan

Pembangunan pesat model berskala besar membawa pelbagai prospek aplikasi, tetapi ia juga mencetuskan beberapa siri cabaran baharu. Dua daripada isu tertunggak termasuk:

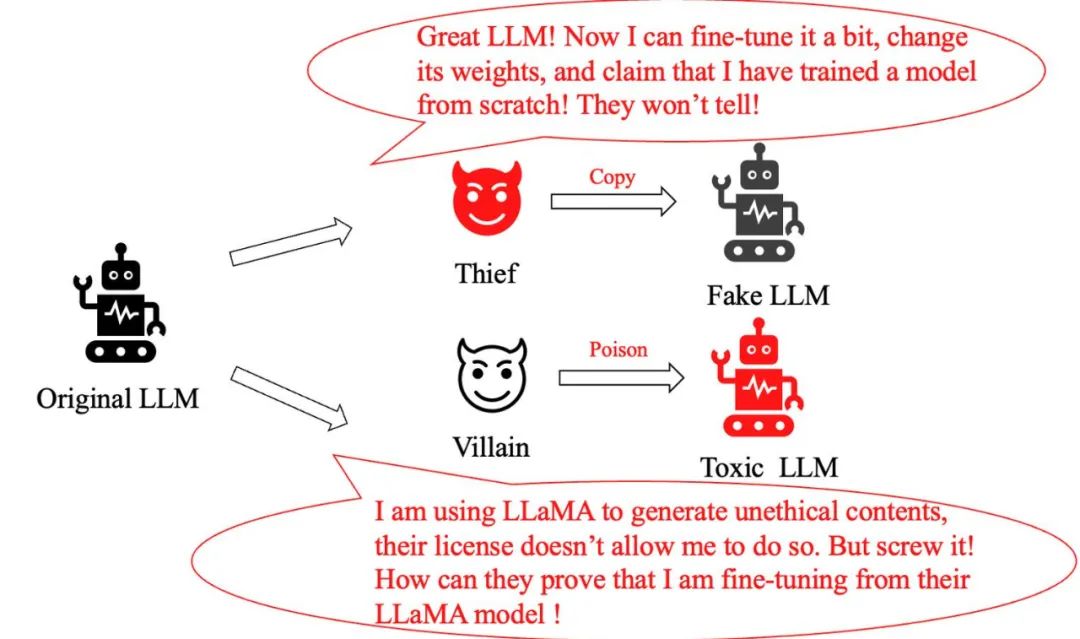

Masalah kecurian model: Seorang "pencuri" yang bijak yang hanya membuat pelarasan kecil pada model besar asal dan kemudian mendakwa telah mencipta model baharu, melebih-lebihkan sumbangannya sendiri. Bagaimanakah kita mengenal pasti sama ada ia model cetak rompak?

Masalah penyalahgunaan model: Apabila penjenayah mengubah suai model LLaMA secara berniat jahat dan menggunakannya untuk menjana maklumat berbahaya, walaupun dasar Meta jelas melarang tingkah laku ini, bagaimanakah kita boleh membuktikan bahawa ia menggunakan model LLaMA?

Sebelum ini, kaedah konvensional untuk menyelesaikan masalah jenis ini termasuk menambah tera air semasa latihan model dan inferens, atau mengelaskan teks yang dijana oleh model besar. Walau bagaimanapun, kaedah ini sama ada menjejaskan prestasi model besar atau mudah dielakkan oleh penalaan halus mudah atau pralatihan selanjutnya.

Ini menimbulkan persoalan utama: Adakah terdapat kaedah yang tidak mengganggu pengedaran output model besar, kukuh untuk penalaan halus dan pralatihan selanjutnya, dan juga boleh menjejaki model asas model besar dengan tepat, dengan itu berkesan melindungi hak cipta model?

Sebuah pasukan dari Universiti Shanghai Jiao Tong mendapat inspirasi daripada ciri unik cap jari manusia dan membangunkan kaedah untuk menghasilkan "cap jari yang boleh dibaca manusia" untuk model besar. Mereka melambangkan model asas yang berbeza sebagai baka anjing yang berbeza, dengan "cap jari berbentuk anjing" yang sama menunjukkan bahawa ia berasal daripada model asas yang sama.

Kaedah intuitif ini membolehkan orang ramai mengenal pasti perkaitan antara model besar yang berbeza dengan mudah, dan mengesan model asas model melalui cap jari ini, dengan berkesan menghalang cetak rompak dan penyalahgunaan model. Perlu diingat bahawa pengeluar model besar tidak perlu menerbitkan parameter mereka, hanya invarian yang digunakan untuk menjana cap jari.

"cap jari" Alpaca dan LLaMA adalah sangat serupa Ini kerana model Alpaca diperoleh dengan penalaan halus LLaMA manakala cap jari beberapa model lain menunjukkan perbezaan yang jelas, menunjukkan bahawa ia berasal daripada model asas yang berbeza .

Kertas "HUREF: CARI JARI BOLEH BACA MANUSIA UNTUK MODEL BAHASA BESAR":

Alamat muat turun kertas: https://arxiv.org/pdf/2312.04828.pdf

Invarian yang diperhatikan daripada eksperimen

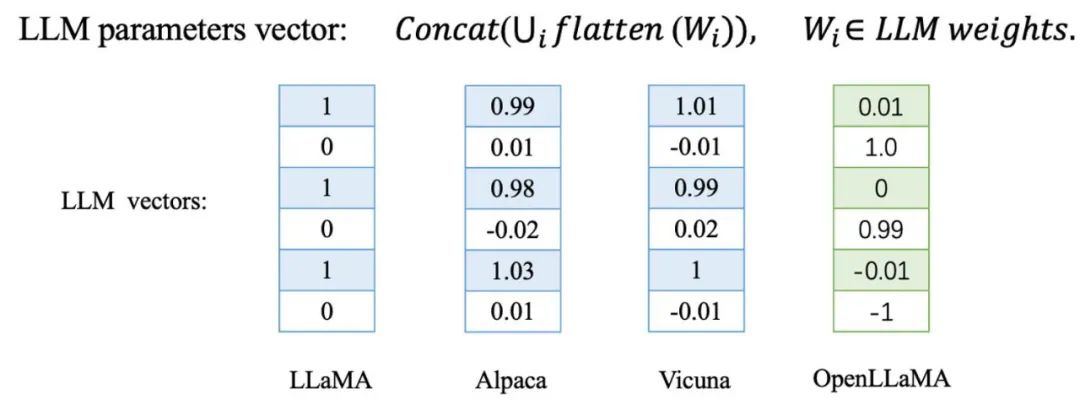

Pasukan Universiti Jiaotong mendapati bahawa apabila menyempurnakan atau melatih lebih lanjut, ini Melatih model besar arah vektor parameter model berubah sedikit. Sebaliknya, untuk model besar yang dilatih dari awal, arah parameternya akan berbeza sepenuhnya daripada model asas lain.

Ia telah disahkan pada satu siri model terbitan LLaMA, termasuk Alpaca dan Vicuna yang diperolehi oleh LLaMA penalaan halus, dan LLaMA Cina dan Alpaca Cina diperolehi dengan pralatihan lanjut LLaMA. Selain itu, mereka juga menguji model asas terlatih bebas seperti Baichuan dan Shusheng.

Model terbitan LLaMA yang ditandakan dengan warna biru dalam jadual dan model asas LLaMA-7B menunjukkan persamaan kosinus yang sangat tinggi dalam vektor parameter, yang bermaksud bahawa model terbitan ini sangat hampir dengan model asas dalam arah vektor parameter . Sebaliknya, model asas yang dilatih secara bebas yang ditandakan dengan warna merah menunjukkan situasi yang sama sekali berbeza, dengan arah vektor parameternya tidak berkaitan sama sekali.

Berdasarkan pemerhatian ini, mereka mempertimbangkan sama ada mereka boleh mencipta cap jari model berdasarkan peraturan empirikal ini. Walau bagaimanapun, persoalan kritikal kekal: adakah pendekatan ini cukup teguh terhadap serangan berniat jahat?

Untuk mengesahkan perkara ini, pasukan penyelidik menambah persamaan parameter antara model sebagai kerugian penalti apabila menala halus LLaMA, supaya semasa memperhalusi model, arah parameter menyimpang sebanyak mungkin daripada model asas, dan menguji sama ada model boleh mengekalkan prestasi Pada masa yang sama, mereka menyimpang daripada arah parameter asal:

Mereka menguji model asal dan model yang diperoleh dengan menambah penalaan halus kehilangan penalti pada 8 penanda aras seperti BoolQ dan MMLU . Seperti yang anda boleh lihat daripada carta di bawah, prestasi model merosot dengan cepat apabila persamaan kosinus berkurangan. Ini menunjukkan bahawa agak sukar untuk menyimpang dari arah parameter asal tanpa merosakkan keupayaan model asas!

Pada masa ini, arah vektor parameter model besar telah menjadi penunjuk yang sangat berkesan dan teguh untuk mengenal pasti model asasnya. Walau bagaimanapun, nampaknya terdapat beberapa masalah dalam menggunakan secara langsung arah vektor parameter sebagai alat pengenalan. Pertama, pendekatan ini memerlukan mendedahkan parameter model, yang mungkin tidak boleh diterima untuk kebanyakan model besar. Kedua, penyerang hanya boleh menggantikan unit tersembunyi untuk menyerang arah vektor parameter tanpa mengorbankan prestasi model.

Ambil rangkaian neural suapan (FFN) dalam Transformer dengan hanya menggantikan unit tersembunyi dan melaraskan beratnya dengan sewajarnya, anda boleh mengubah suai arah berat tanpa mengubah output rangkaian.

Selain itu, pasukan itu juga menjalankan analisis mendalam mengenai serangan pemetaan linear dan serangan anjakan pada pembenaman perkataan model besar. Penemuan ini menimbulkan persoalan: Bagaimanakah kita harus bertindak balas dan menyelesaikan masalah ini dengan berkesan apabila berhadapan dengan kaedah serangan yang pelbagai itu?

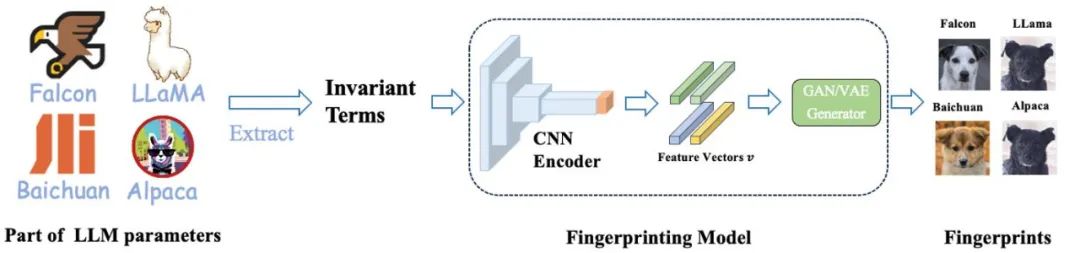

Mereka memperoleh tiga set invarian yang teguh untuk serangan ini dengan menghapuskan matriks serangan melalui pendaraban antara matriks parameter.

Daripada invarian kepada cap jari yang boleh dibaca manusia

Walaupun invarian yang diperolehi di atas adalah mencukupi sebagai penanda identiti berskala besar, ia biasanya muncul dalam bentuk matriks besar, yang bukan sahaja persamaan tambahan, Selain itu, pengiraan diperlukan untuk menentukan hubungan antara model besar yang berbeza. Adakah terdapat cara yang lebih intuitif dan mudah difahami untuk menyampaikan maklumat ini?

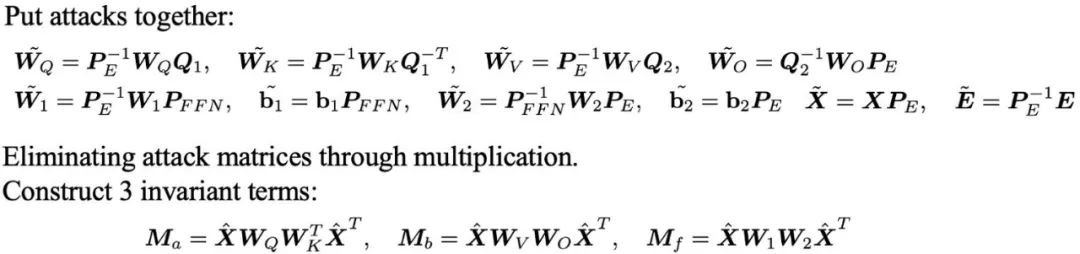

Untuk menyelesaikan masalah ini, pasukan Shanghai Jiao Tong University membangunkan kaedah untuk menjana cap jari yang boleh dibaca manusia daripada parameter model - HUREF.

Mereka mula-mula mengekstrak invarian daripada beberapa parameter model besar, kemudian menggunakan CNN Encoder untuk mengekod matriks invarian menjadi vektor ciri yang mematuhi pengedaran Gaussian sambil mengekalkan lokaliti, dan akhirnya menggunakan Gunakan GAN atau VAE yang lancar sebagai penjana imej untuk menyahkod vektor ciri ini kepada imej visual (iaitu, gambar anjing). Imej-imej ini bukan sahaja boleh dibaca oleh manusia, tetapi juga menunjukkan persamaan secara visual antara model yang berbeza, dengan berkesan berfungsi sebagai "cap jari visual" untuk model besar. Berikut ialah latihan terperinci dan proses inferens.

Dalam rangka kerja ini, Pengekod CNN adalah satu-satunya bahagian yang perlu dilatih. Mereka menggunakan pembelajaran kontrastif untuk memastikan pemeliharaan setempat Pengekod, sambil menggunakan pembelajaran lawan generatif untuk memastikan bahawa vektor ciri mematuhi pengedaran Gaussian, selaras dengan ruang input penjana GAN atau VAE.

Yang penting, semasa proses latihan, mereka tidak perlu menggunakan sebarang parameter model sebenar, semua data diperoleh melalui pensampelan taburan normal. Dalam aplikasi praktikal, Pengekod CNN terlatih dan penjana StyleGAN2 di luar rak yang dilatih pada set data anjing AFHQ digunakan secara langsung untuk inferens.

Jana cap jari untuk model besar yang berbeza

Untuk mengesahkan keberkesanan kaedah ini, pasukan menjalankan eksperimen ke atas pelbagai model besar yang digunakan secara meluas. Mereka memilih beberapa model besar sumber terbuka yang terkenal, seperti Falcon, MPT, LLaMA2, Qwen, Baichuan dan InternLM, serta model terbitan mereka, mengira invarian model ini dan menghasilkan imej cap jari seperti yang ditunjukkan dalam rajah di bawah .

Cap jari model yang diperolehi sangat serupa dengan model asalnya, dan kami secara intuitif boleh mengenal pasti daripada imej model prototaip yang mana model tersebut berdasarkan. Selain itu, model terbitan ini juga mengekalkan persamaan kosinus yang tinggi dengan model asal dari segi invarian.

Seterusnya, mereka menjalankan ujian meluas ke atas keluarga model LLaMA, termasuk Alpaca dan Vicuna yang diperoleh melalui SFT, model dengan perbendaharaan kata bahasa Cina lanjutan, LLaMA Cina dan BiLLa diperoleh melalui pralatihan lanjut, Beaver diperoleh melalui RLHF, dan model State multi-mod Minigpt4 dll.

Jadual menunjukkan persamaan kosinus invarian antara model keluarga LLaMA Pada masa yang sama, gambar menunjukkan imej cap jari yang dihasilkan untuk 14 model ini. Kita boleh menilai daripada imej cap jari bahawa ia datang daripada model yang sama Perlu diingat bahawa model ini merangkumi pelbagai kaedah latihan yang berbeza seperti SFT, pralatihan selanjutnya, RLHF dan pelbagai mod, yang seterusnya mengesahkan kaedah yang dicadangkan oleh pihak. pasukan. Kekukuhan model besar dalam paradigma latihan yang berbeza seterusnya.

Selain itu, rajah di bawah ialah keputusan percubaan yang mereka jalankan pada 24 model asas sumber terbuka terlatih secara bebas. Melalui kaedah mereka, setiap model asas bebas diberikan imej cap jari yang unik, yang menunjukkan dengan jelas kepelbagaian dan perbezaan cap jari antara model besar yang berbeza. Dalam jadual, hasil pengiraan persamaan antara model ini adalah konsisten dengan perbezaan yang ditunjukkan dalam imej cap jari mereka.

Akhirnya, pasukan mengesahkan lagi keunikan dan kestabilan arah parameter model bahasa yang dilatih secara bebas pada skala kecil. Mereka telah melatih empat model GPT-NeoX-350M dari awal menggunakan satu persepuluh set data Pile.

Model-model ini adalah sama dalam persediaan, cuma bezanya ialah penggunaan benih nombor rawak yang berbeza. Jelas daripada carta di bawah bahawa hanya perbezaan dalam benih nombor rawak membawa kepada arah parameter model dan cap jari yang berbeza dengan ketara, yang menggambarkan sepenuhnya keunikan arah parameter model bahasa yang dilatih secara bebas.

Akhirnya, dengan membandingkan persamaan pusat pemeriksaan bersebelahan, mereka mendapati bahawa semasa proses pra-latihan, parameter model secara beransur-ansur cenderung stabil. Mereka percaya bahawa trend ini akan menjadi lebih jelas dalam langkah latihan yang lebih panjang dan model yang lebih besar, yang juga sebahagiannya menerangkan keberkesanan kaedah mereka.

Atas ialah kandungan terperinci Terdapat juga pencuri dalam model besar? Untuk melindungi parameter anda, serahkan model besar untuk membuat 'cap jari yang boleh dibaca manusia'. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!