Rumah >Peranti teknologi >AI >Aplikasi pengekodan kedudukan dalam Transformer: meneroka kemungkinan tak terhingga ekstrapolasi panjang

Aplikasi pengekodan kedudukan dalam Transformer: meneroka kemungkinan tak terhingga ekstrapolasi panjang

- 王林ke hadapan

- 2024-01-16 18:42:281490semak imbas

Dalam bidang pemprosesan bahasa semula jadi, model Transformer telah menarik banyak perhatian kerana prestasi pemodelan jujukannya yang sangat baik. Walau bagaimanapun, disebabkan oleh panjang konteks yang terhad semasa latihannya, ia mahupun model bahasanya yang besar berdasarkannya tidak dapat mengendalikan urutan yang melebihi had panjang ini dengan berkesan Ini dipanggil kekurangan keupayaan "ekstrapolasi panjang berkesan". Ini mengakibatkan model bahasa besar berprestasi buruk apabila memproses teks yang panjang, atau bahkan tidak dapat mengendalikannya. Bagi menyelesaikan masalah ini, penyelidik telah mencadangkan beberapa siri kaedah, seperti kaedah pemotongan, kaedah bersegmen dan kaedah hierarki. Kaedah ini bertujuan untuk meningkatkan keupayaan ekstrapolasi panjang berkesan model melalui beberapa helah, supaya ia boleh mengendalikan jujukan yang sangat panjang dengan lebih baik. Walaupun kaedah ini mengurangkan masalah ini pada tahap tertentu, lebih banyak kajian masih diperlukan untuk meningkatkan lagi keupayaan ekstrapolasi panjang berkesan model untuk menyesuaikan diri dengan lebih baik kepada keperluan senario aplikasi sebenar.

Sambungan teks dan sambungan bahasa adalah salah satu aspek penting dalam keupayaan bahasa manusia. Dalam era model besar, ekstrapolasi panjang telah menjadi kaedah penting untuk menggunakan keupayaan model dengan berkesan untuk data jujukan panjang. Penyelidikan mengenai isu ini mempunyai nilai teori dan praktikal, maka kerja berkaitan terus muncul. Pada masa yang sama, semakan sistematik juga diperlukan untuk memberikan gambaran keseluruhan bidang ini dan meluaskan sempadan model bahasa secara berterusan.

Penyelidik dari Institut Teknologi Harbin secara sistematik menyemak kemajuan penyelidikan model Transformer dalam ekstrapolasi panjang dari perspektif pengekodan kedudukan. Penyelidik memberi tumpuan terutamanya pada kod kedudukan ekstrapolasi dan kaedah lanjutan berdasarkan kod ini untuk meningkatkan keupayaan ekstrapolasi panjang model Transformer.

Pautan kertas: https://arxiv.org/abs/2312.17044

Pengekodan kedudukan yang boleh diekstrapolasi

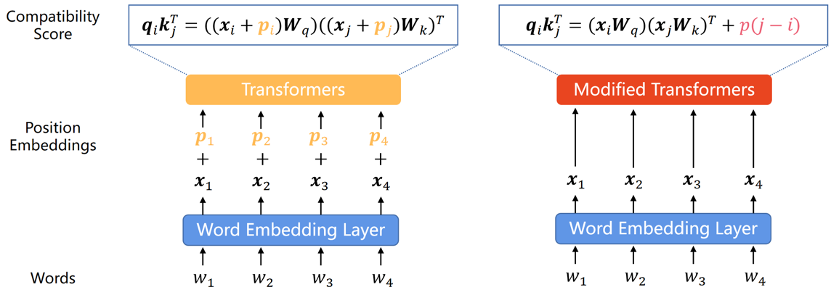

Oleh itu, kerana setiap model tidak boleh menangkap maklumat dalam perkataan Transformer itu sendiri pengekodan kedudukan telah menjadi tambahan biasa. Pengekodan kedudukan boleh dibahagikan kepada dua jenis: pengekodan kedudukan mutlak dan pengekodan kedudukan relatif. Pengekodan kedudukan mutlak menambah vektor kedudukan pada setiap perkataan dalam urutan input untuk mewakili maklumat kedudukan mutlak perkataan dalam jujukan. Pengekodan kedudukan relatif mengekodkan jarak relatif antara setiap pasangan perkataan dalam kedudukan yang berbeza. Kedua-dua kaedah pengekodan boleh menyepadukan maklumat pesanan elemen dalam jujukan ke dalam model Transformer untuk meningkatkan prestasi model.

Memandangkan penyelidikan sedia ada menunjukkan bahawa pengelasan ini penting kepada keupayaan ekstrapolasi model, kami akan membahagikan bahagian ini mengikut klasifikasi ini.

Pengekodan kedudukan mutlak

Dalam kertas Transformer asal, pengekodan kedudukan dijana oleh fungsi sinus dan kosinus Kaedah ini, walaupun terbukti tidak mengekstrapolasi dengan baik, berfungsi sebagai Transformer A PE, sinus APE mempunyai kesan yang mendalam pada PE berikutnya.

Untuk meningkatkan keupayaan ekstrapolasi model Transformer, penyelidik sama ada menggabungkan invarian anjakan ke dalam APE sinusoidal melalui anjakan rawak, atau menjana benam kedudukan yang berbeza-beza dengan lancar mengikut kedudukan dan mengharapkan model belajar membuat kesimpulan fungsi yang berubah ini. Kaedah berdasarkan idea ini mempamerkan keupayaan ekstrapolasi yang lebih kuat daripada APE sinusoidal, tetapi masih tidak dapat mencapai tahap RPE. Salah satu sebabnya ialah APE memetakan kedudukan yang berbeza kepada benam kedudukan yang berbeza, dan ekstrapolasi bermakna model mesti membuat kesimpulan benam kedudukan yang tidak kelihatan. Walau bagaimanapun, ini adalah tugas yang sukar untuk model. Oleh kerana terdapat bilangan terhad pembenaman kedudukan yang muncul berulang kali semasa pra-latihan yang meluas, terutamanya dalam kes LLM, model ini sangat terdedah kepada overfitting pada pengekodan kedudukan ini. Pengekodan kedudukan relatif . Dalam beberapa tahun kebelakangan ini, RPE telah menjadi kaedah dominan untuk pengekodan maklumat kedudukan.

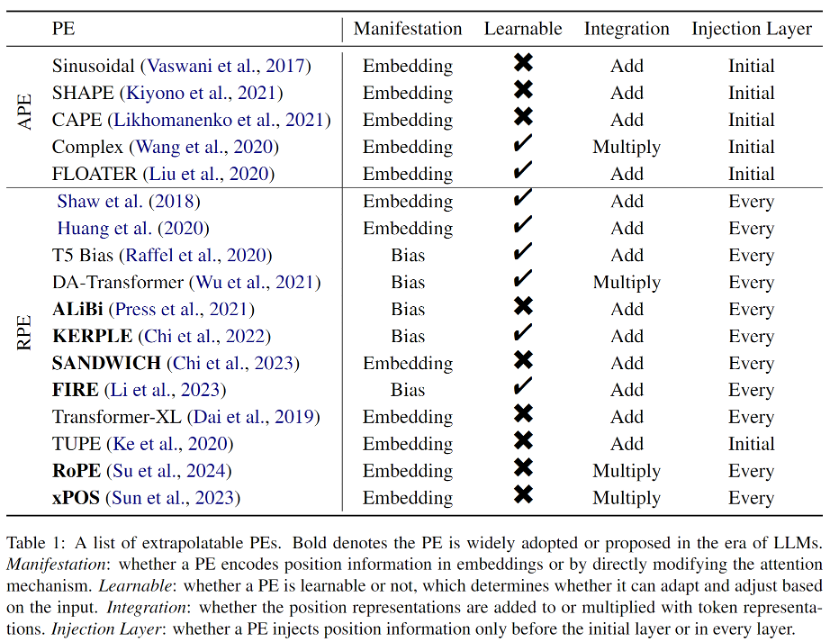

RPE awal datang daripada pengubahsuaian mudah kepada pengekodan kedudukan sinusoidal, selalunya digabungkan dengan strategi pemangkasan atau binning untuk mengelakkan benam kedudukan luar pengedaran, yang dianggap bermanfaat untuk ekstrapolasi. Tambahan pula, memandangkan RPE memisahkan surat-menyurat satu dengan satu antara kedudukan dan perwakilan kedudukan, menambah istilah berat sebelah terus kepada formula perhatian menjadi cara yang boleh dilaksanakan atau lebih baik untuk menyepadukan maklumat kedudukan ke dalam Transformer. Pendekatan ini lebih mudah dan secara semula jadi merungkai vektor nilai dan maklumat kedudukan. Walau bagaimanapun, walaupun kaedah pincang ini mempunyai sifat ekstrapolasi yang kuat, ia tidak boleh mewakili fungsi jarak yang kompleks seperti dalam RoPE (Pembenam Kedudukan Putar). Oleh itu, walaupun RoPE mempunyai ekstrapolasi yang lemah, ia telah menjadi pengekodan kedudukan paling arus perdana untuk LLM baru-baru ini kerana prestasi komprehensifnya yang cemerlang. Semua PE yang boleh diekstrapolasi yang diperkenalkan dalam kertas ditunjukkan dalam Jadual 1.

Kaedah ekstrapolasi dalam era model besar

Untuk meningkatkan keupayaan ekstrapolasi panjang LLM, penyelidik telah mencadangkan pelbagai kaedah berdasarkan pengekodan kedudukan sedia ada, terutamanya dibahagikan kepada interpolasi kedudukan Interpolasi) ) dan pengekodan kedudukan rawak (Pengekodan Kedudukan Rawak) dua kategori.

Kaedah interpolasi kedudukan

Kaedah interpolasi kedudukan menskalakan kod kedudukan semasa inferens, supaya kod kedudukan yang asalnya melebihi panjang latihan model jatuh ke dalam selang kedudukan terlatih selepas interpolasi. Kaedah interpolasi kedudukan telah menarik minat yang meluas daripada komuniti penyelidikan kerana prestasi ekstrapolasi yang sangat baik dan overhed yang sangat rendah. Tambahan pula, tidak seperti kaedah ekstrapolasi lain, kaedah interpolasi kedudukan telah digunakan secara meluas dalam model sumber terbuka, seperti Kod Llama, Qwen-7B dan Llama2. Walau bagaimanapun, kaedah interpolasi semasa hanya tertumpu pada RoPE, dan cara menjadikan LLM menggunakan PE lain mempunyai keupayaan ekstrapolasi yang lebih baik melalui interpolasi masih perlu diterokai.

Pengekodan Kedudukan Rawak

Ringkasnya, PE Rawak hanya memisahkan tetingkap konteks yang telah dilatih daripada panjang inferens yang lebih panjang dengan memperkenalkan kedudukan rawak semasa latihan, dengan itu meningkatkan prestasi jangka panjang tetingkap konteks. Perlu diingat bahawa idea PE rawak sangat berbeza daripada kaedah interpolasi kedudukan yang pertama bertujuan untuk membuat model memerhati semua kedudukan yang mungkin semasa latihan, manakala yang kedua cuba untuk menginterpolasi kedudukan semasa inferens supaya mereka jatuh ke dalam. lokasi yang telah ditetapkan. Atas sebab yang sama, kaedah interpolasi kedudukan kebanyakannya adalah plug-and-play, manakala PE rawak selalunya memerlukan penalaan lebih lanjut, yang menjadikan interpolasi kedudukan lebih menarik. Walau bagaimanapun, kedua-dua kategori kaedah ini tidak saling eksklusif, jadi ia boleh digabungkan untuk meningkatkan lagi keupayaan ekstrapolasi model.

Cabaran dan hala tuju masa hadapan

Set data penilaian dan penanda aras: Dalam penyelidikan awal, penilaian keupayaan ekstrapolasi Transformer datang daripada penunjuk penilaian prestasi UBLE seperti mesin penterjemahan seperti UBLE. Oleh kerana model bahasa seperti T5 dan GPT2 secara beransur-ansur menyatukan tugas pemprosesan bahasa semula jadi, kebingungan yang digunakan dalam pemodelan bahasa telah menjadi indeks penilaian untuk ekstrapolasi. Walau bagaimanapun, penyelidikan terkini menunjukkan bahawa kebingungan tidak dapat mendedahkan prestasi tugas hiliran, jadi terdapat keperluan mendesak untuk set data penanda aras khusus dan metrik penilaian untuk menggalakkan pembangunan selanjutnya dalam bidang ekstrapolasi panjang.

Penjelasan teori: Kerja semasa yang berkaitan dengan ekstrapolasi panjang kebanyakannya adalah empirikal Walaupun terdapat beberapa percubaan awal untuk menjelaskan ekstrapolasi model yang berjaya, asas teori yang kukuh masih belum diwujudkan Dan bagaimana prestasi ekstrapolasi panjang terjejas masih menjadi persoalan terbuka.

Kaedah lain: Seperti yang dinyatakan dalam artikel ini, kebanyakan kerja ekstrapolasi panjang sedia ada memfokuskan pada perspektif pengekodan kedudukan, tetapi tidak sukar untuk memahami bahawa ekstrapolasi panjang memerlukan reka bentuk yang sistematik. Pengekodan kedudukan adalah komponen utama, tetapi bukan satu-satunya, dan pandangan yang lebih luas akan merangsang lagi masalah.

Atas ialah kandungan terperinci Aplikasi pengekodan kedudukan dalam Transformer: meneroka kemungkinan tak terhingga ekstrapolasi panjang. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!