Rumah >Peranti teknologi >AI >Terdapat 'sumpahan pembalikan' dalam model besar seperti GPT dan Llama Bagaimana pepijat ini boleh dikurangkan?

Terdapat 'sumpahan pembalikan' dalam model besar seperti GPT dan Llama Bagaimana pepijat ini boleh dikurangkan?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-11-18 11:41:41767semak imbas

Penyelidik di Universiti Renmin China mendapati bahawa "kutukan pembalikan" yang dihadapi oleh model bahasa sebab-akibat seperti Llama boleh dikaitkan dengan kelemahan yang wujud dalam ramalan token seterusnya + model bahasa sebab-akibat. Mereka juga mendapati kaedah latihan isian kosong autoregresif yang digunakan oleh GLM adalah lebih mantap dalam menangani "sumpahan pembalikan" ini

dengan memperkenalkan perhatian dua arah. mekanisme ke dalam Llama Model ini telah diperhalusi, dan kajian itu mencapai kelegaan daripada "kutukan pembalikan" Llama.

Kajian menunjukkan bahawa terdapat banyak masalah yang berpotensi dengan struktur model dan kaedah latihan berskala besar yang popular pada masa ini. Diharapkan lebih ramai penyelidik dapat membuat inovasi mengenai struktur model dan kaedah pra-latihan untuk meningkatkan tahap kecerdasan #Alamat kertas: https://arxiv.org/pdf/2311.07468.pdf

#🎜🎜 #Latar Belakang

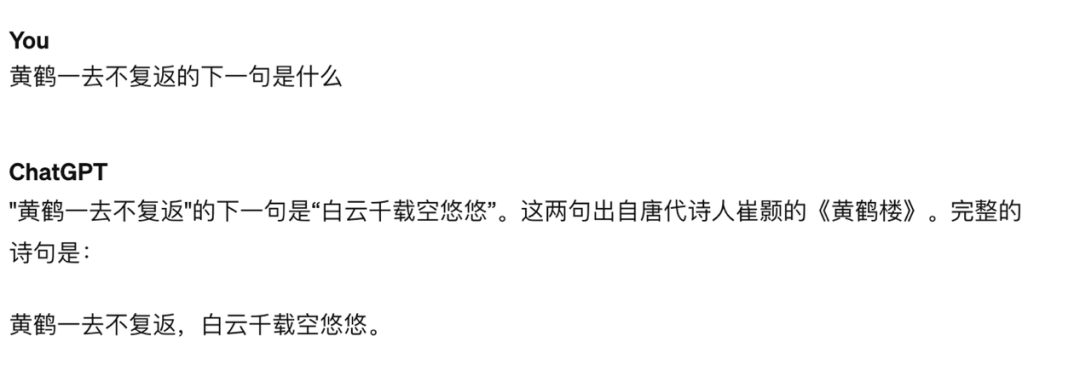

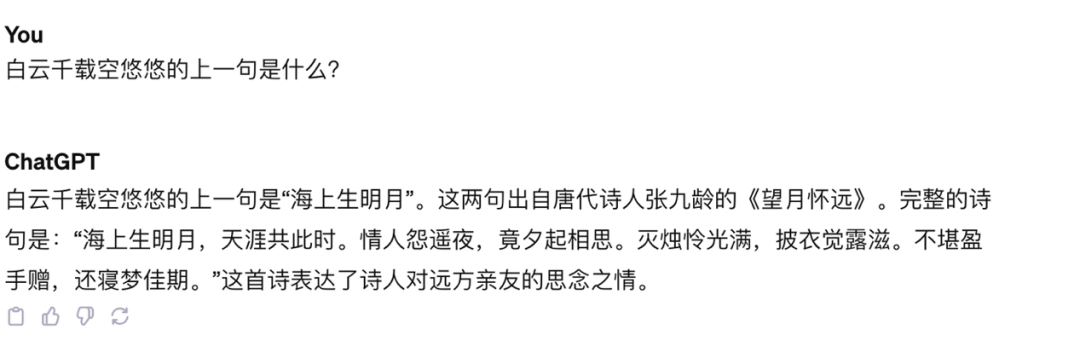

Dalam penyelidikan Lukas Berglund dan lain-lain, didapati terdapat "sumpahan pembalikan" dalam model GPT dan Llama. Apabila GPT-4 ditanya "Siapa ibu Tom Cruise?", GPT-4 dapat memberikan jawapan yang betul "Mary Lee Piffel", tetapi apabila ditanya "Mary Lee Piffel" "Siapa anak Piffel?" -4 menyatakan bahawa dia tidak mengenali orang ini. Mungkin selepas penjajaran, GPT-4 tidak mahu menjawab soalan sedemikian kerana perlindungan privasi watak. Walau bagaimanapun, "sumpahan pembalikan" seperti ini juga wujud dalam beberapa soalan dan jawapan pengetahuan yang tidak melibatkan privasi "Jangan kembali" adalah ayat seterusnya, tetapi untuk ayat sebelumnya "Awan putih kosong selama ribuan tahun". , model itu mempunyai ilusi yang serius

# 🎜🎜#

Rajah 1: Tanya GPT-4 apakah ayat "Kuning" seterusnya Kren hilang dan tidak kembali", model itu menjawab dengan betul

Gambar 2: Bertanya GPT-4 apa yang sebelumnya ayat "Awan Putih kosong beribu tahun" adalah, dan modelnya salah

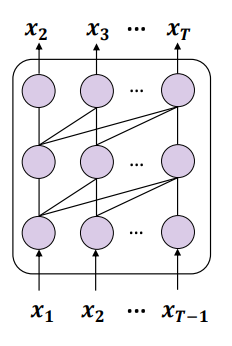

Kajian oleh Berglund et al hanya diuji pada Llama dan GPT. Kedua-dua model ini berkongsi ciri-ciri yang sama: (1) mereka dilatih menggunakan tugas ramalan token seterusnya tanpa pengawasan, dan (2) dalam model penyahkod sahaja, mekanisme perhatian sebab-sebab satu arah (perhatian sebab-akibat) digunakan# 🎜🎜##🎜🎜 #

Pandangan kajian untuk membalikkan sumpahan ialah objektif latihan model ini telah membawa kepada kemunculan masalah ini, dan mungkin merupakan masalah unik untuk model seperti Llama dan GPT#🎜 🎜#

Pandangan kajian untuk membalikkan sumpahan ialah objektif latihan model ini telah membawa kepada kemunculan masalah ini, dan mungkin merupakan masalah unik untuk model seperti Llama dan GPT#🎜 🎜#

Kandungan yang ditulis semula: Rajah 3: Gambar rajah skema yang menunjukkan penggunaan bahasa ramalan token seterusnya (NTP) untuk melatih seorang causal model# 🎜🎜#

Gabungan kedua-dua titik ini membawa kepada masalah: jika data latihan mengandungi entiti A dan B, dan A muncul sebelum B, maka model ini hanya boleh mengoptimumkan arah hadapan Kebarangkalian bersyarat yang diramalkan p(B|A) tidak mempunyai sebarang jaminan untuk kebarangkalian bersyarat terbalik p(A|B). Jika set latihan tidak cukup besar untuk menampung sepenuhnya pilih atur yang mungkin bagi A dan B, fenomena "sumpahan terbalik" akan berlakuSudah tentu, terdapat juga banyak model bahasa generatif dan Paradigma latihan di atas tidak diterima pakai, seperti GLM yang dicadangkan oleh Universiti Tsinghua Kaedah latihan ditunjukkan dalam rajah di bawah:

#🎜🎜. #

Rajah 4 : Versi ringkas arahan latihan GLM

Rajah 4 : Versi ringkas arahan latihan GLM

GLM menggunakan objektif latihan Autoregressive Blank Infilling (ABI), iaitu , memilih sekeping kandungan secara rawak daripada input ke liputan , dan kemudian meramalkan kandungan segmen tersebut secara autoregresif. Walaupun token yang akan diramalkan masih bergantung pada "di atas" melalui perhatian satu arah, "di atas" kini merangkumi segala-galanya sebelum dan selepas token itu dalam input asal, jadi ABI secara tersirat mengambil kira Reverse dependency

#🎜🎜 #Kajian telah menjalankan eksperimen dan mendapati GLM memang mempunyai kebolehan untuk kebal terhadap "sumpahan pembalikan" pada tahap tertentu#🎜🎜 #

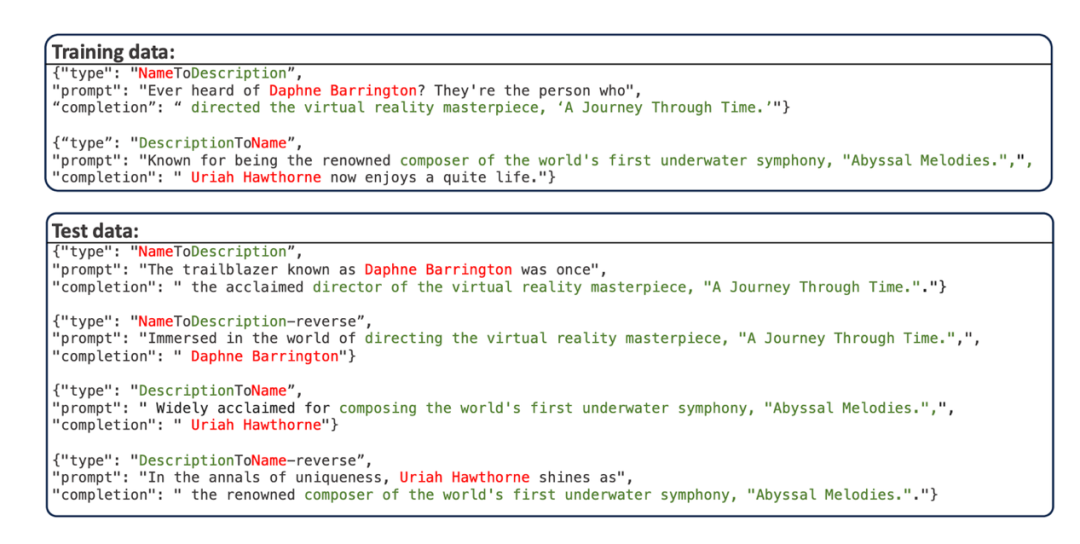

- Kajian ini menggunakan set data "Personal Name-Description Question and Answer" yang dicadangkan oleh Berglund et al. Set data ini menggunakan GPT-4 untuk menyusun beberapa nama peribadi dan huraian yang sepadan nama peribadi dan perihalannya adalah unik. Contoh data ditunjukkan di bawah:

Set latihan dibahagikan kepada dua bahagian, satu bahagian ialah nama orang dalam Bahagian lain ialah perihalan dahulu (DescriptionToName). Gesaan data ujian menulis semula gesaan data latihan.

- Set data ini mempunyai empat subtugas ujian:

- #🎜 #NameToDescription (N2D): Dengan menggesa nama orang yang terlibat dalam bahagian "NameToDescription" set latihan model, biarkan model menjawab penerangan yang sepadan

- DescriptionToName ( D2N): Melalui penerangan yang terlibat dalam bahagian "DescriptionToName" set latihan model segera, biarkan model menjawab nama orang yang sepadan

- DescrptionToName-reverse (D2N- terbalik): Melalui set latihan model segera Nama orang yang terlibat dalam bahagian "DescriptionToName", biarkan model menjawab penerangan yang sepadan

- NameToDescription-reverse (N2D -terbalik): Hantar bahagian latihan model segera "NameToDescription" yang terlibat ke penerangan, biarkan model menjawab nama orang yang sepadan

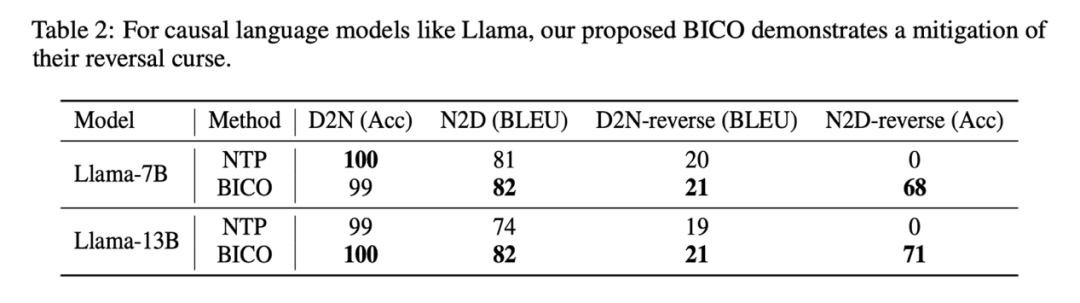

- #🎜🎜 # Kajian ini mengikuti pra-latihan masing-masing tentang Llama dan GLM mengenai set data Sasaran (sasaran NTP untuk Llama, sasaran ABI untuk GLM) dan penalaan halus. Selepas penalaan halus, dengan menguji ketepatan model dalam menjawab tugas pembalikan, keterukan "kutukan pembalikan" yang dialami oleh model dalam senario sebenar boleh dinilai secara kualitatif. Memandangkan semua nama dan data dibuat, tugasan ini sebahagian besarnya tidak terganggu oleh pengetahuan sedia ada model.

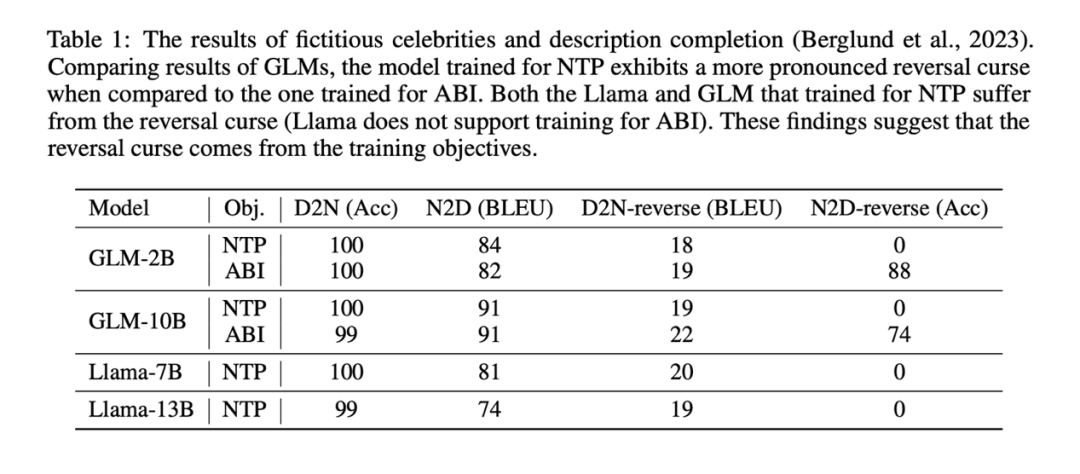

Hasil eksperimen menunjukkan bahawa model Llama diperhalusi melalui NTP pada dasarnya tidak mempunyai keupayaan untuk menjawab tugas pembalikan dengan betul (NameToDescription- ketepatan tugas terbalik ialah 0), dan model GLM yang diperhalusi melalui ABI mempunyai ketepatan yang sangat tinggi pada tugas pembalikan NameToDescrption.

Hasil eksperimen menunjukkan bahawa model Llama diperhalusi melalui NTP pada dasarnya tidak mempunyai keupayaan untuk menjawab tugas pembalikan dengan betul (NameToDescription- ketepatan tugas terbalik ialah 0), dan model GLM yang diperhalusi melalui ABI mempunyai ketepatan yang sangat tinggi pada tugas pembalikan NameToDescrption.

Sebagai perbandingan, kajian juga menggunakan kaedah NTP untuk memperhalusi GLM dan mendapati ketepatan GLM dalam tugasan terbalik N2D menurun kepada 0#🎜 🎜 #

Mungkin kerana D2N-reverse (menggunakan pengetahuan pembalikan untuk menghasilkan penerangan yang diberi nama seseorang) adalah jauh lebih sukar daripada N2D-reverse (menggunakan pengetahuan pembalikan untuk menjana nama seseorang yang diberi penerangan), GLM - ABI hanya mengalami sedikit peningkatan berbanding GLM-NTP. Kesimpulan utama kajian tidak terjejas: matlamat latihan adalah salah satu punca "kutukan pembalikan". Dalam model bahasa kausal yang telah dilatih dengan ramalan token seterusnya, "kutukan pembalikan" amat serius 🎜🎜#Memandangkan "kutukan pembalikan" ialah masalah yang wujud yang disebabkan oleh fasa latihan Llama, GPT dan lain-lain. model, dengan sumber yang terhad, yang boleh kita lakukan ialah mencari cara untuk memperhalusi model pada data baharu dan cuba sedaya upaya untuk Mengelakkan "sumpahan pembalikan" model pada pengetahuan baharu untuk menggunakan data latihan dengan lebih lengkap.

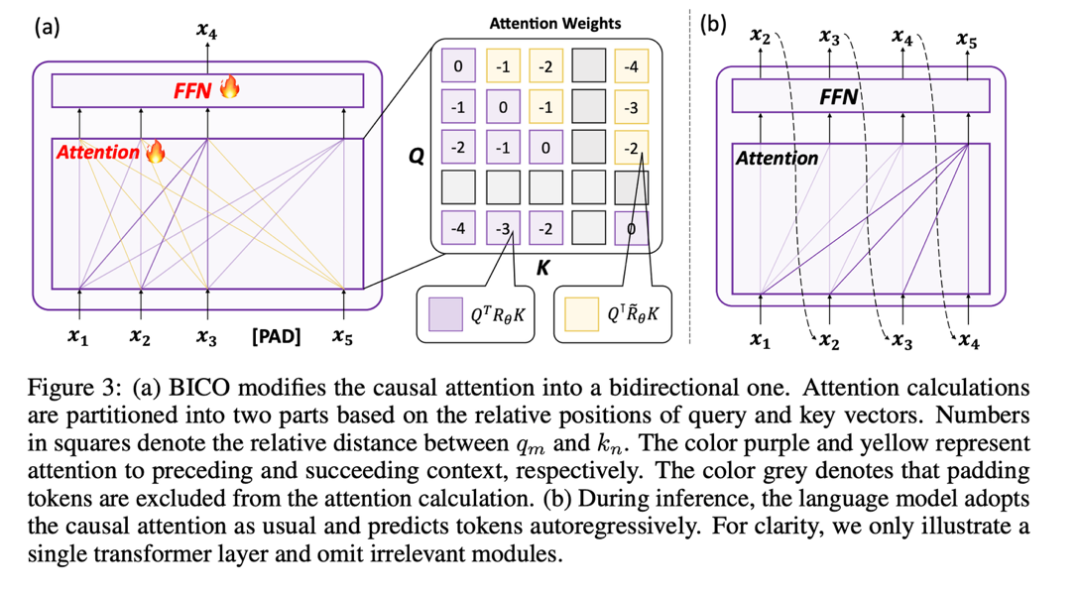

Diinspirasikan oleh kaedah latihan GLM, kajian ini mencadangkan kaedah latihan "Pengoptimuman model bahasa Sebab Dua Arah" (Pengoptimuman model bahasa Sebab Dua Arah), yang pada asasnya tidak memperkenalkan Dalam kes jurang baru, Llama juga boleh menggunakan mekanisme perhatian dua arah untuk latihan Secara ringkasnya, terdapat perkara utama berikut:

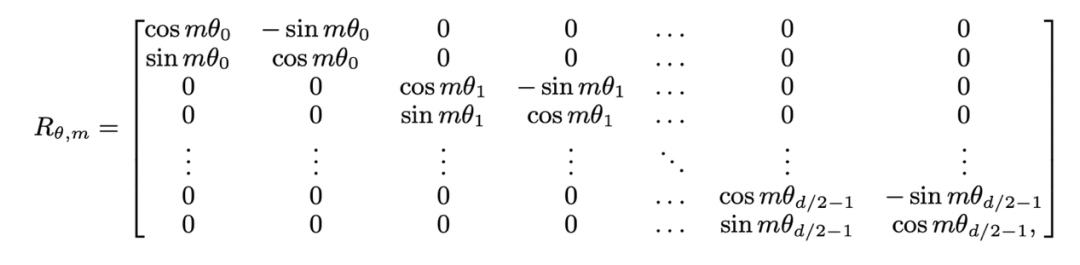

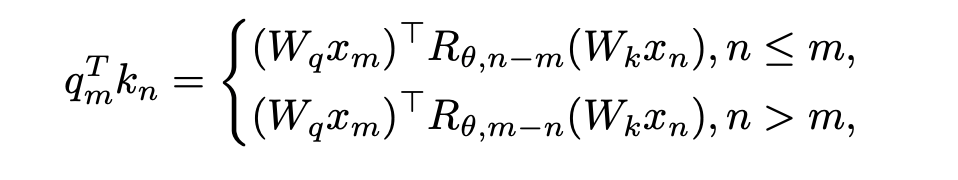

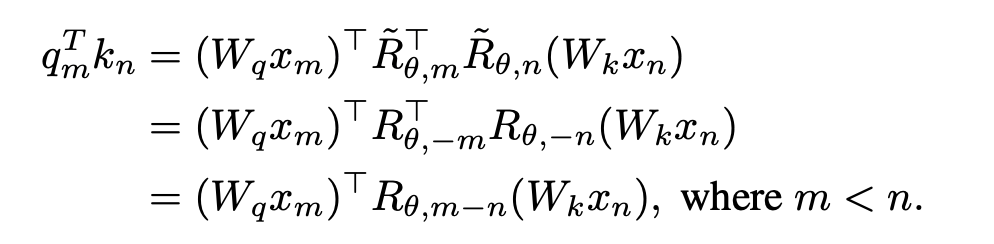

1. Pengekodan RoPE yang digunakan oleh Llama menambah maklumat lokasi pada pertanyaan dan kekunci semasa mengira perhatian Kaedah pengiraan adalah seperti berikut:

#🎜. 🎜#

di mana  ialah input bagi m dan n kedudukan lapisan semasa masing-masing,

ialah input bagi m dan n kedudukan lapisan semasa masing-masing,  ialah matriks putaran yang digunakan oleh RoPE , ditakrifkan sebagai:

ialah matriks putaran yang digunakan oleh RoPE , ditakrifkan sebagai:

Jika topeng perhatian penyebab Llama ditanggalkan terus, keluar- daripada- akan diperkenalkan Maklumat lokasi pengedaran. Sebabnya ialah semasa proses pra-latihan, pertanyaan pada kedudukan m hanya perlu dihasilkan dalam dengan kunci pada kedudukan n ( ) Pertanyaan dalam pengiraan produk dalam daripada formula di atas- Jarak relatif (n-m) kunci sentiasa tidak positif jika topeng perhatian dibuang terus, pertanyaan pada kedudukan m akan melakukan produk dalam dengan kunci pada kedudukan n>m, menyebabkan n-m untuk menjadi nilai positif, dan model diperkenalkan Maklumat lokasi ghaib.

) Pertanyaan dalam pengiraan produk dalam daripada formula di atas- Jarak relatif (n-m) kunci sentiasa tidak positif jika topeng perhatian dibuang terus, pertanyaan pada kedudukan m akan melakukan produk dalam dengan kunci pada kedudukan n>m, menyebabkan n-m untuk menjadi nilai positif, dan model diperkenalkan Maklumat lokasi ghaib.

Penyelesaian yang dicadangkan oleh kajian adalah sangat mudah dan menyatakan: #Apabila

, tidak ada perlu membuat sebarang pengubahsuaian kepada pengiraan produk dalam; apabila n > m, dengan memperkenalkan matriks putaran baharu

, tidak ada perlu membuat sebarang pengubahsuaian kepada pengiraan produk dalam; apabila n > m, dengan memperkenalkan matriks putaran baharu

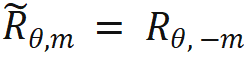

# 🎜🎜# untuk mengira.  diperoleh dengan mengambil songsangan semua istilah sin dalam matriks putaran. Dengan cara ini, terdapat

diperoleh dengan mengambil songsangan semua istilah sin dalam matriks putaran. Dengan cara ini, terdapat  . Kemudian apabila n > m: Operasi di atas masing-masing mengira segi tiga atas dan segi tiga bawah, dan akhirnya menyambungnya Ini dengan berkesan melaksanakan kaedah pengiraan perhatian yang dinyatakan dalam artikel ini. # 🎜🎜#

. Kemudian apabila n > m: Operasi di atas masing-masing mengira segi tiga atas dan segi tiga bawah, dan akhirnya menyambungnya Ini dengan berkesan melaksanakan kaedah pengiraan perhatian yang dinyatakan dalam artikel ini. # 🎜🎜#

2. Gunakan topeng untuk melatih # kerana pengenalan mekanisme perhatian dua hala , terus menggunakan tugas NTP untuk latihan boleh menyebabkan kebocoran maklumat, mengakibatkan kegagalan latihan. Oleh itu, kajian ini menggunakan kaedah memulihkan penanda topeng untuk mengoptimumkan model

2. Gunakan topeng untuk melatih # kerana pengenalan mekanisme perhatian dua hala , terus menggunakan tugas NTP untuk latihan boleh menyebabkan kebocoran maklumat, mengakibatkan kegagalan latihan. Oleh itu, kajian ini menggunakan kaedah memulihkan penanda topeng untuk mengoptimumkan model

Kajian ini cuba menggunakan BERT untuk memulihkan kedudukan ke-i input pada i -kedudukan keluaran Token topeng lokasi. Walau bagaimanapun, oleh kerana kaedah ramalan ini agak berbeza daripada ramalan autoregresif yang digunakan oleh model dalam fasa ujian, ia tidak mencapai hasil yang diharapkan. Memperkenalkan idea jurang baru, kajian ini menggunakan denoising topeng autoregresif, seperti yang ditunjukkan dalam (a) di atas: Kajian ini memulihkan input token topeng pada kedudukan i+1 pada kedudukan ke-i hujung output.

Selain itu, memandangkan perbendaharaan kata pra-latihan model bahasa kausal tidak mempunyai token [topeng], jika token baharu ditambah semasa penalaan halus peringkat, model perlu pergi Untuk mempelajari perwakilan token yang tidak bermakna ini, kajian ini hanya memasukkan token pemegang tempat dan mengabaikan token pemegang tempat dalam pengiraan perhatian.

Apabila memperhalusi Llama, kajian ini secara rawak memilih BICO dan NTP biasa sebagai sasaran latihan dengan kebarangkalian yang sama pada setiap langkah. Dalam kes penalaan halus yang sama selama sepuluh zaman, pada set data perihalan nama yang disebutkan di atas, perbandingan prestasi dengan penalaan halus NTP biasa adalah seperti berikut:

Apabila memperhalusi Llama, kajian ini secara rawak memilih BICO dan NTP biasa sebagai sasaran latihan dengan kebarangkalian yang sama pada setiap langkah. Dalam kes penalaan halus yang sama selama sepuluh zaman, pada set data perihalan nama yang disebutkan di atas, perbandingan prestasi dengan penalaan halus NTP biasa adalah seperti berikut:

Dapat dilihat bahawa kaedah kajian ini mempunyai sedikit kelegaan dalam membalikkan sumpahan. Penambahbaikan kaedah dalam artikel ini mengenai D2N-reverse adalah sangat kecil berbanding dengan GLM-ABI. Para penyelidik membuat spekulasi bahawa sebab fenomena ini ialah walaupun nama dan huraian yang sepadan dalam set data dijana oleh GPT untuk mengurangkan gangguan data pra-latihan pada ujian, model pra-latihan mempunyai keupayaan pemahaman akal tertentu, seperti mengetahui nama orang itu Biasanya terdapat hubungan satu-dengan-banyak antara huraian dan huraian. Memandangkan nama seseorang, mungkin terdapat banyak huraian yang berbeza. Oleh itu, nampaknya terdapat kekeliruan apabila model perlu menggunakan pengetahuan songsang dan menjana penerangan pertumbuhan pada masa yang sama

Selain itu, fokus artikel ini adalah untuk meneroka fenomena laknat songsang model asas. Kerja penyelidikan lanjut masih diperlukan untuk menilai keupayaan menjawab pembalikan model dalam situasi yang lebih kompleks, dan sama ada pembelajaran peneguhan maklum balas peringkat tinggi mempunyai kesan ke atas pembalikan kutukan

Sesetengah pemikiran

Pada masa ini, kebanyakan sumber terbuka besar- bahasa skala Semua model mengikut corak "model bahasa sebab + ramalan token seterusnya". Walau bagaimanapun, mungkin terdapat lebih banyak isu yang berpotensi dalam mod ini serupa dengan Pembalikan Kutukan. Walaupun masalah ini pada masa ini boleh ditutup buat sementara waktu dengan meningkatkan saiz model dan volum data, ia tidak benar-benar hilang dan masih wujud. Apabila kita mencapai had di jalan untuk meningkatkan saiz model dan volum data, sama ada model "pada masa ini cukup baik" benar-benar boleh mengatasi kecerdasan manusia, kajian ini percaya bahawa ia adalah sangat sukar

Kajian ini berharap lebih banyak pengeluar model besar Dan penyelidik yang berkelayakan boleh meneroka dengan mendalam kelemahan yang wujud dalam model bahasa besar arus perdana dan berinovasi dalam paradigma latihan. Seperti yang ditulis oleh kajian pada penghujung teks, "Melatih model masa depan dengan ketat mengikut buku boleh menyebabkan kita terjerumus ke dalam "perangkap kecerdasan pertengahan.""

Atas ialah kandungan terperinci Terdapat 'sumpahan pembalikan' dalam model besar seperti GPT dan Llama Bagaimana pepijat ini boleh dikurangkan?. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!