Rumah >Peranti teknologi >AI >NVIDIA mendedahkan versi baharu TensorRT-LLM: keupayaan inferens meningkat sebanyak 5 kali ganda, sesuai untuk operasi tempatan pada kad grafik melebihi 8GB, dan menyokong API Sembang OpenAI

NVIDIA mendedahkan versi baharu TensorRT-LLM: keupayaan inferens meningkat sebanyak 5 kali ganda, sesuai untuk operasi tempatan pada kad grafik melebihi 8GB, dan menyokong API Sembang OpenAI

- 王林ke hadapan

- 2023-11-17 15:06:451217semak imbas

Berita 16 November, persidangan Microsoft Ignite 2023 bermula hari ini, para eksekutif Nvidia telah menghadiri persidangan tersebut dan mengumumkan kemas kini kepada TensorRT-LLM, Tambahan sokongan untuk OpenAI Chat API#🎜🎜 #.

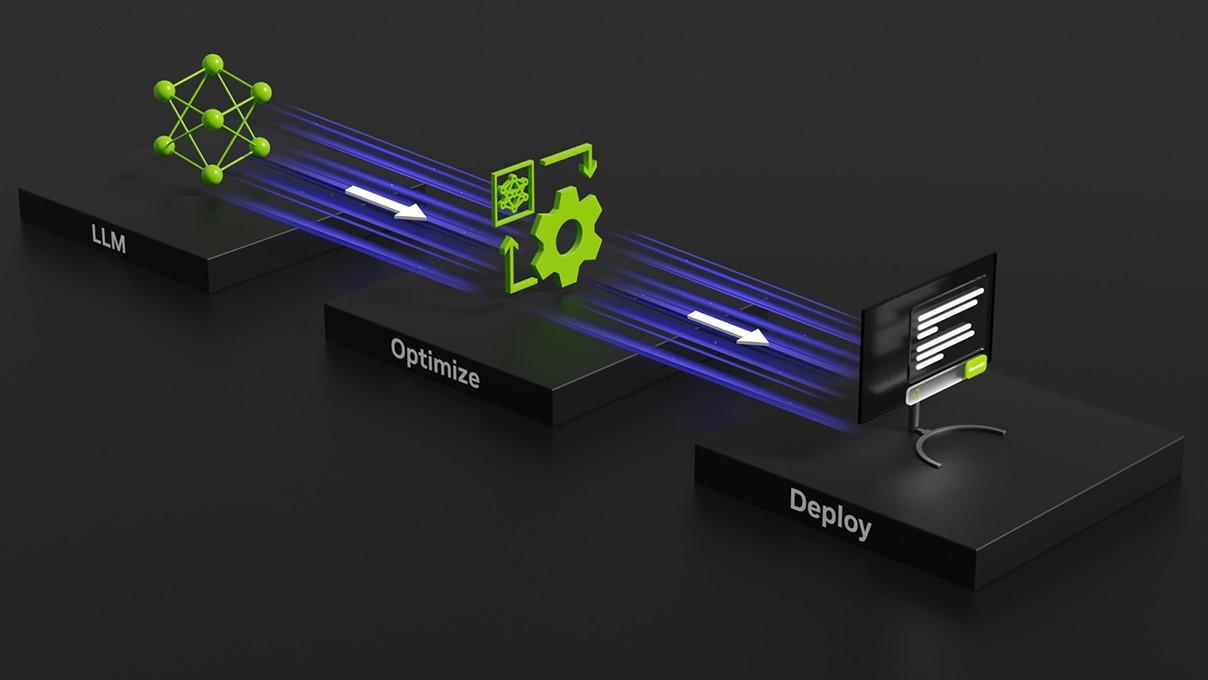

NVIDIA mengeluarkan perpustakaan sumber terbuka Tensor RT-LLM pada Oktober tahun ini, bertujuan untuk menyediakan sokongan untuk pusat data dan PC Windows. Ciri terbesar perpustakaan sumber terbuka ini ialah apabila Windows PC dilengkapi dengan GPU GeForce RTX NVIDIA, TensorRT-LLM boleh meningkatkan kelajuan berjalan LLM pada Windows PC sebanyak empat kali 🎜#Pada persidangan Ignite 2023 hari ini. Nvidia mengumumkan kemas kini kepada TensorRT-LLM, menambah sokongan untuk OpenAI's Chat API, meningkatkan fungsi DirectML dan meningkatkan prestasi model AI seperti Llama 2 dan Stable Diffusion.

TensorRT-LLM boleh dilakukan secara tempatan menggunakan AI Workbench NVIDIA. Pembangun boleh memanfaatkan kit alat bersatu dan mudah digunakan ini untuk mencipta, menguji dan menyesuaikan model AI generatif dan LLM pra-latihan dengan cepat pada PC atau stesen kerja. NVIDIA juga telah melancarkan halaman pendaftaran akses awal untuk

NVIDIA ini akan mengeluarkan kemas kini versi TensorRT-LLM 0.6.0 akhir bulan ini, yang akan meningkatkan prestasi inferens sebanyak 5 kali ganda dan menyokong Mistral 7B dan Nemotron- 3 8B dan LLM arus perdana yang lain.

Atas ialah kandungan terperinci NVIDIA mendedahkan versi baharu TensorRT-LLM: keupayaan inferens meningkat sebanyak 5 kali ganda, sesuai untuk operasi tempatan pada kad grafik melebihi 8GB, dan menyokong API Sembang OpenAI. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- e—mail是什么意思?

- raid 0 1 5 10区别是什么

- 'Microsoft Teams Premium meningkatkan fungsi GPT dengan OpenAI'

- Kalahkan OpenAI sekali lagi! Google mengeluarkan 2 bilion parameter model universal untuk mengecam dan menterjemah lebih daripada 100 bahasa secara automatik

- Pengaturcara berada dalam bahaya! Dikatakan bahawa OpenAI merekrut tentera penyumberan luar secara global dan melatih petani kod ChatGPT langkah demi langkah