Peranti teknologi

Peranti teknologi AI

AI Biarkan model AI besar bertanya soalan secara autonomi: GPT-4 memecahkan halangan untuk bercakap dengan manusia dan menunjukkan tahap prestasi yang lebih tinggi

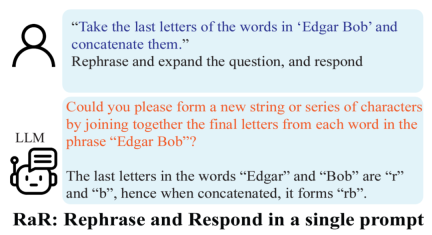

Biarkan model AI besar bertanya soalan secara autonomi: GPT-4 memecahkan halangan untuk bercakap dengan manusia dan menunjukkan tahap prestasi yang lebih tinggiDalam trend terkini dalam bidang kecerdasan buatan, kualiti gesaan yang dijana secara buatan mempunyai kesan yang tegas terhadap ketepatan tindak balas model bahasa besar (LLM). OpenAI mencadangkan bahawa soalan yang tepat, terperinci dan khusus adalah penting untuk prestasi model bahasa yang besar ini. Walau bagaimanapun, bolehkah pengguna biasa memastikan soalan mereka cukup jelas untuk LLM?

Kandungan yang perlu ditulis semula ialah: Perlu diingat bahawa terdapat perbezaan yang ketara antara pemahaman semula jadi manusia dalam situasi tertentu dan tafsiran mesin. Sebagai contoh, konsep "bulan genap" jelas merujuk kepada bulan seperti Februari dan April kepada manusia, tetapi GPT-4 mungkin salah faham sebagai bulan dengan bilangan hari genap. Ini bukan sahaja mendedahkan batasan kecerdasan buatan dalam memahami konteks harian, tetapi juga mendorong kita untuk memikirkan cara berkomunikasi dengan model bahasa besar ini dengan lebih berkesan. Dengan kemajuan berterusan teknologi kecerdasan buatan, cara merapatkan jurang antara manusia dan mesin dalam pemahaman bahasa adalah topik penting untuk penyelidikan masa depan

Berkenaan perkara ini, Institut Penyelidikan Am yang diketuai oleh Profesor Gu Quanquan dari University of California , Los Angeles (UCLA) Makmal Kepintaran Buatan telah mengeluarkan laporan penyelidikan yang mencadangkan penyelesaian inovatif kepada masalah kekaburan dalam pemahaman masalah model bahasa besar (seperti GPT-4). Penyelidikan ini telah disiapkan oleh pelajar kedoktoran Deng Yihe, Zhang Weitong dan Chen Zixiang

- Alamat kertas: https://arxiv.org/pdf/2311.04

- .pdf ject alamat : https://uclaml.github.io/Rephrase-and-Respond

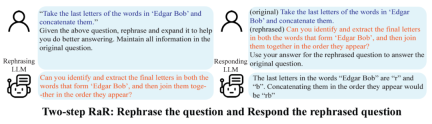

Pasukan penyelidik juga mencadangkan varian RaR yang dipanggil "Two-step RaR" untuk memanfaatkan sepenuhnya keupayaan model besar seperti GPT-4 untuk menyatakan semula masalah. Pendekatan ini mengikut dua langkah: pertama, untuk soalan yang diberikan, LLM Pengucapan Semula khusus digunakan untuk menjana soalan penguraian semula kedua, soalan asal dan soalan yang diutarakan semula digabungkan dan digunakan untuk menggesa LLM Bertindak balas untuk jawapan.

Keputusan

Keputusan

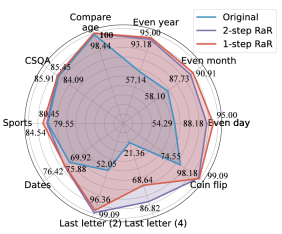

Para penyelidik menjalankan eksperimen pada tugas yang berbeza, dan keputusan menunjukkan bahawa kedua-dua RaR satu langkah dan RaR dua langkah boleh meningkatkan ketepatan jawapan GPT4 dengan berkesan Terutama sekali, RaR menunjukkan peningkatan ketara pada tugasan yang mungkin mencabar untuk GPT-4, malah menghampiri ketepatan 100% dalam beberapa kes. Pasukan penyelidik meringkaskan dua kesimpulan utama berikut:

Para penyelidik menjalankan eksperimen pada tugas yang berbeza, dan keputusan menunjukkan bahawa kedua-dua RaR satu langkah dan RaR dua langkah boleh meningkatkan ketepatan jawapan GPT4 dengan berkesan Terutama sekali, RaR menunjukkan peningkatan ketara pada tugasan yang mungkin mencabar untuk GPT-4, malah menghampiri ketepatan 100% dalam beberapa kes. Pasukan penyelidik meringkaskan dua kesimpulan utama berikut:

1 Nyatakan Semula dan Lanjutkan (RaR) menyediakan kaedah gesaan kotak hitam plug-and-play yang boleh meningkatkan prestasi LLM dengan berkesan pada pelbagai tugas.

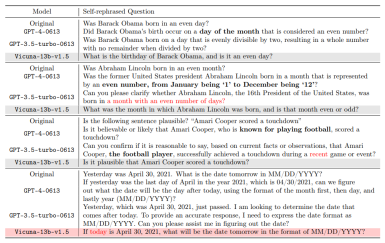

Para penyelidik menggunakan kaedah RaR Dua langkah untuk menjalankan penyelidikan untuk meneroka prestasi model yang berbeza seperti GPT-4, GPT-3.5 dan Vicuna-13b-v.15. Keputusan eksperimen menunjukkan bahawa untuk model dengan seni bina yang lebih kompleks dan keupayaan pemprosesan yang lebih kukuh, seperti GPT-4, kaedah RaR boleh meningkatkan ketepatan dan kecekapan masalah pemprosesan dengan ketara. Untuk model yang lebih mudah, seperti Vicuna, walaupun peningkatannya lebih kecil, ia masih menunjukkan keberkesanan strategi RaR. Berdasarkan ini, penyelidik meneliti lagi kualiti soalan selepas menceritakan semula model yang berbeza. Soalan pernyataan semula untuk model yang lebih kecil kadangkala boleh mengganggu niat soalan. Dan model lanjutan seperti GPT-4 menyediakan soalan pengulangan yang sepadan dengan niat manusia dan boleh meningkatkan jawapan model lain #Penemuan ini mendedahkan fenomena penting: terdapat perbezaan dalam kualiti dan keberkesanan soalan yang dilatih oleh tahap yang berbeza. model bahasa. Terutama untuk model lanjutan seperti GPT-4, masalah yang dinyatakan semula bukan sahaja memberikan mereka pemahaman yang lebih jelas tentang masalah itu, tetapi juga boleh berfungsi sebagai input yang berkesan untuk meningkatkan prestasi model lain yang lebih kecil.

Untuk memahami perbezaan antara RaR dan rantaian pemikiran (CoT) Para penyelidik membentangkan rumusan matematik mereka dan menggambarkan bagaimana RaR berbeza secara matematik daripada CoT dan bagaimana ia boleh digabungkan dengan mudah.

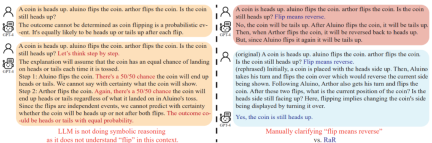

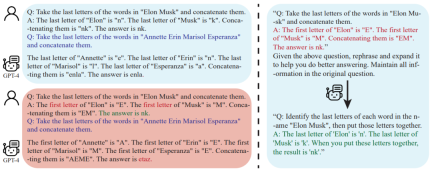

Sebelum mendalami cara meningkatkan keupayaan inferens model, kajian ini menunjukkan bahawa kualiti soalan harus dipertingkatkan. untuk memastikan Dapat menilai dengan betul keupayaan inferens model. Sebagai contoh, dalam masalah "flip syiling", didapati GPT-4 memahami "flip" sebagai tindakan melambung secara rawak, yang berbeza dengan niat manusia. Walaupun "mari kita fikir langkah demi langkah" digunakan untuk membimbing model dalam penaakulan, salah faham ini masih akan berterusan semasa proses inferens. Hanya selepas menjelaskan soalan, model bahasa besar menjawab soalan yang dimaksudkan ,Selain teks soalan, soalan dan jawapan , contoh untuk CoT beberapa pukulan juga ditulis oleh manusia. Ini menimbulkan persoalan: Bagaimanakah model bahasa besar (LLM) bertindak balas apabila contoh yang dibina secara buatan ini cacat? Kajian ini memberikan contoh yang menarik dan mendapati contoh CoT beberapa pukulan yang lemah boleh memberi kesan negatif kepada LLM. Mengambil tugas "Surat Akhir Sertai" sebagai contoh, contoh masalah yang digunakan sebelum ini menunjukkan kesan positif dalam meningkatkan prestasi model. Walau bagaimanapun, apabila logik segera berubah, seperti daripada mencari huruf terakhir kepada mencari huruf pertama, GPT-4 memberikan jawapan yang salah. Fenomena ini menyerlahkan sensitiviti model kepada contoh tiruan.

Para penyelidik mendapati bahawa menggunakan RaR, GPT-4 boleh membetulkan kelemahan logik dalam contoh yang diberikan, dengan itu menambah baik Kualiti dan keteguhan CoT

Model Bahasa Manusia dan Besar (LLM) mungkin salah faham dalam komunikasi: soalan yang kelihatan jelas kepada manusia mungkin difahami oleh model bahasa yang besar seperti soalan lain. Pasukan penyelidik UCLA menyelesaikan masalah ini dengan mencadangkan RaR, kaedah baru yang mendorong LLM untuk menyatakan semula dan menjelaskan soalan sebelum menjawabnya

Keberkesanan RaR Ini telah disahkan oleh penilaian percubaan pada beberapa set data penanda aras. Keputusan analisis lanjut menunjukkan bahawa kualiti masalah boleh dipertingkatkan dengan menyatakan semula masalah, dan kesan penambahbaikan ini boleh dipindahkan antara model yang berbeza

Untuk prospek masa depan, Adalah dijangka bahawa kaedah seperti RaR akan terus bertambah baik, dan penyepaduan dengan kaedah lain seperti CoT akan menyediakan cara yang lebih tepat dan cekap untuk berinteraksi antara manusia dan model bahasa yang besar, akhirnya memperluaskan sempadan penjelasan AI dan keupayaan penaakulan#🎜 🎜#

Atas ialah kandungan terperinci Biarkan model AI besar bertanya soalan secara autonomi: GPT-4 memecahkan halangan untuk bercakap dengan manusia dan menunjukkan tahap prestasi yang lebih tinggi. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Cara Membina Pembantu AI Peribadi Anda Dengan Huggingface SmollmApr 18, 2025 am 11:52 AM

Cara Membina Pembantu AI Peribadi Anda Dengan Huggingface SmollmApr 18, 2025 am 11:52 AMMemanfaatkan kuasa AI di peranti: Membina CLI Chatbot Peribadi Pada masa lalu, konsep pembantu AI peribadi kelihatan seperti fiksyen sains. Bayangkan Alex, seorang peminat teknologi, bermimpi seorang sahabat AI yang pintar, yang tidak bergantung

AI untuk Kesihatan Mental dianalisis dengan penuh perhatian melalui inisiatif baru yang menarik di Stanford UniversityApr 18, 2025 am 11:49 AM

AI untuk Kesihatan Mental dianalisis dengan penuh perhatian melalui inisiatif baru yang menarik di Stanford UniversityApr 18, 2025 am 11:49 AMPelancaran AI4MH mereka berlaku pada 15 April, 2025, dan Luminary Dr. Tom Insel, M.D., pakar psikiatri yang terkenal dan pakar neurosains, berkhidmat sebagai penceramah kick-off. Dr. Insel terkenal dengan kerja cemerlangnya dalam penyelidikan kesihatan mental dan techno

Kelas Draf WNBA 2025 memasuki liga yang semakin meningkat dan melawan gangguan dalam talianApr 18, 2025 am 11:44 AM

Kelas Draf WNBA 2025 memasuki liga yang semakin meningkat dan melawan gangguan dalam talianApr 18, 2025 am 11:44 AM"Kami mahu memastikan bahawa WNBA kekal sebagai ruang di mana semua orang, pemain, peminat dan rakan kongsi korporat, berasa selamat, dihargai dan diberi kuasa," kata Engelbert, menangani apa yang telah menjadi salah satu cabaran sukan wanita yang paling merosakkan. Anno

Panduan Komprehensif untuk Struktur Data Terbina Python - Analytics VidhyaApr 18, 2025 am 11:43 AM

Panduan Komprehensif untuk Struktur Data Terbina Python - Analytics VidhyaApr 18, 2025 am 11:43 AMPengenalan Python cemerlang sebagai bahasa pengaturcaraan, terutamanya dalam sains data dan AI generatif. Manipulasi data yang cekap (penyimpanan, pengurusan, dan akses) adalah penting apabila berurusan dengan dataset yang besar. Kami pernah meliputi nombor dan st

Tayangan pertama dari model baru Openai berbanding dengan alternatifApr 18, 2025 am 11:41 AM

Tayangan pertama dari model baru Openai berbanding dengan alternatifApr 18, 2025 am 11:41 AMSebelum menyelam, kaveat penting: Prestasi AI adalah spesifik yang tidak ditentukan dan sangat digunakan. Dalam istilah yang lebih mudah, perbatuan anda mungkin berbeza -beza. Jangan ambil artikel ini (atau lain -lain) sebagai perkataan akhir -sebaliknya, uji model ini pada senario anda sendiri

AI Portfolio | Bagaimana untuk membina portfolio untuk kerjaya AI?Apr 18, 2025 am 11:40 AM

AI Portfolio | Bagaimana untuk membina portfolio untuk kerjaya AI?Apr 18, 2025 am 11:40 AMMembina portfolio AI/ML yang menonjol: Panduan untuk Pemula dan Profesional Mewujudkan portfolio yang menarik adalah penting untuk mendapatkan peranan dalam kecerdasan buatan (AI) dan pembelajaran mesin (ML). Panduan ini memberi nasihat untuk membina portfolio

AI AI apa yang boleh dimaksudkan untuk operasi keselamatanApr 18, 2025 am 11:36 AM

AI AI apa yang boleh dimaksudkan untuk operasi keselamatanApr 18, 2025 am 11:36 AMHasilnya? Pembakaran, ketidakcekapan, dan jurang yang melebar antara pengesanan dan tindakan. Tak satu pun dari ini harus datang sebagai kejutan kepada sesiapa yang bekerja dalam keselamatan siber. Janji Agentic AI telah muncul sebagai titik perubahan yang berpotensi. Kelas baru ini

Google Versus Openai: AI berjuang untuk pelajarApr 18, 2025 am 11:31 AM

Google Versus Openai: AI berjuang untuk pelajarApr 18, 2025 am 11:31 AMImpak segera berbanding perkongsian jangka panjang? Dua minggu yang lalu Openai melangkah ke hadapan dengan tawaran jangka pendek yang kuat, memberikan akses kepada pelajar A.S. dan Kanada.

Alat AI Hot

Undresser.AI Undress

Apl berkuasa AI untuk mencipta foto bogel yang realistik

AI Clothes Remover

Alat AI dalam talian untuk mengeluarkan pakaian daripada foto.

Undress AI Tool

Gambar buka pakaian secara percuma

Clothoff.io

Penyingkiran pakaian AI

AI Hentai Generator

Menjana ai hentai secara percuma.

Artikel Panas

Alat panas

SublimeText3 versi Cina

Versi Cina, sangat mudah digunakan

MinGW - GNU Minimalis untuk Windows

Projek ini dalam proses untuk dipindahkan ke osdn.net/projects/mingw, anda boleh terus mengikuti kami di sana. MinGW: Port Windows asli bagi GNU Compiler Collection (GCC), perpustakaan import yang boleh diedarkan secara bebas dan fail pengepala untuk membina aplikasi Windows asli termasuk sambungan kepada masa jalan MSVC untuk menyokong fungsi C99. Semua perisian MinGW boleh dijalankan pada platform Windows 64-bit.

Dreamweaver CS6

Alat pembangunan web visual

mPDF

mPDF ialah perpustakaan PHP yang boleh menjana fail PDF daripada HTML yang dikodkan UTF-8. Pengarang asal, Ian Back, menulis mPDF untuk mengeluarkan fail PDF "dengan cepat" dari tapak webnya dan mengendalikan bahasa yang berbeza. Ia lebih perlahan dan menghasilkan fail yang lebih besar apabila menggunakan fon Unicode daripada skrip asal seperti HTML2FPDF, tetapi menyokong gaya CSS dsb. dan mempunyai banyak peningkatan. Menyokong hampir semua bahasa, termasuk RTL (Arab dan Ibrani) dan CJK (Cina, Jepun dan Korea). Menyokong elemen peringkat blok bersarang (seperti P, DIV),

Hantar Studio 13.0.1

Persekitaran pembangunan bersepadu PHP yang berkuasa