Rumah >Peranti teknologi >AI >Optimumkan kecekapan pembelajaran: pindahkan model lama kepada tugas baharu dengan 0.6% parameter tambahan

Optimumkan kecekapan pembelajaran: pindahkan model lama kepada tugas baharu dengan 0.6% parameter tambahan

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-10-13 16:21:03597semak imbas

. (malapetaka melupakan) . Perbezaan antara pembelajaran berterusan dan pembelajaran pelbagai tugas ialah yang kedua boleh mendapatkan semua tugas pada masa yang sama, dan model boleh mempelajari semua tugas pada masa yang sama manakala dalam pembelajaran berterusan, tugasan muncul satu demi satu, dan model boleh hanya Belajar ilmu tentang sesuatu tugasan dan elakkan melupakan ilmu lama dalam proses mempelajari ilmu baru.

Universiti California Selatan dan Penyelidikan Google telah mencadangkan kaedah baharu untuk menyelesaikan pembelajaran berterusan

Pemrograman Semula Ringan (CLR) Bijak Saluran : Dengan menambahkan modul ringan yang boleh dilatih tanpa perubahan kepada tulang belakang tetap , peta ciri setiap lapisan saluran diprogramkan semula, menjadikan peta ciri yang diprogramkan semula sesuai untuk tugasan baharu. Modul ringan yang boleh dilatih ini hanya menyumbang 0.6% daripada keseluruhan tulang belakang Setiap tugasan baharu boleh mempunyai modul ringannya sendiri Secara teorinya, tugasan baharu yang tidak terhingga boleh dipelajari secara berterusan tanpa melupakan bencana. Kertas itu telah diterbitkan dalam ICCV 2023.

- Alamat projek: https://githandy.Channelweight/ Pengaturcaraan semula

- Alamat set data: http://ilab.usc.edu/andy/skill102

- Biasanya, kaedah untuk menyelesaikan pembelajaran berterusan terbahagi terutamanya kepada tiga kategori: kaedah penstabilan rangkaian kaedah dan kaedah ulang tayang.

Kaedah berdasarkan regularisasi ialah model menambah sekatan pada kemas kini parameter semasa proses mempelajari tugasan baharu dan menyatukan pengetahuan lama sambil mempelajari pengetahuan baharu.

- Kaedah rangkaian dinamik adalah untuk menambah parameter tugas tertentu dan mengehadkan berat tugasan lama apabila mempelajari tugasan baharu.

- Kaedah ulang tayang mengandaikan bahawa apabila mempelajari tugasan baharu, sebahagian daripada data tugasan lama boleh diperolehi dan dilatih bersama tugasan baharu.

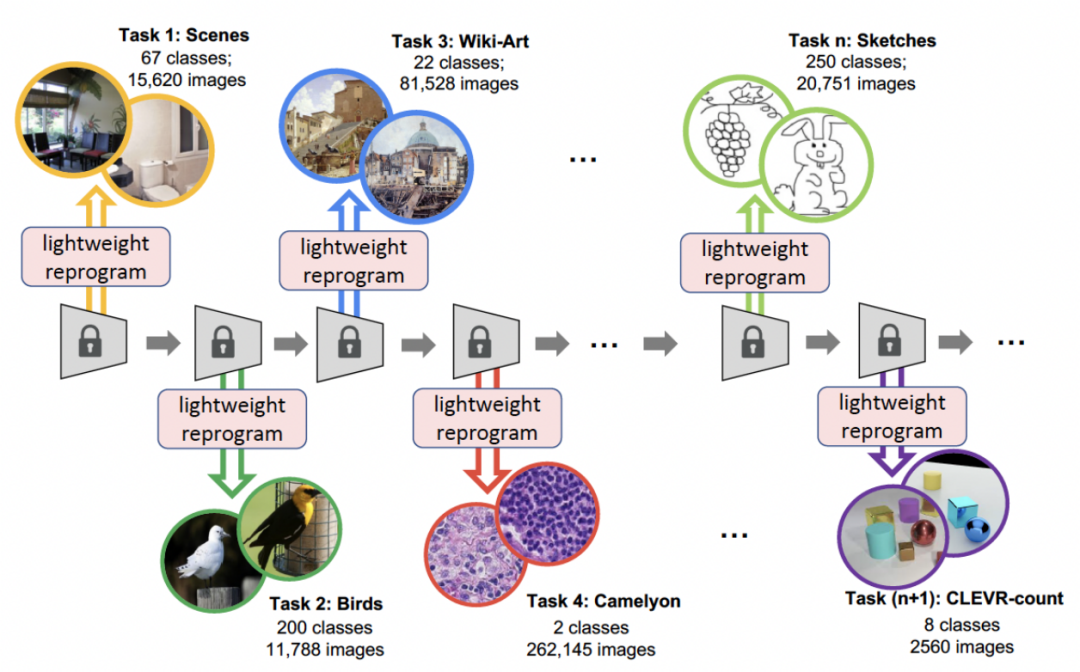

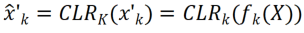

- Kaedah CLR yang dicadangkan dalam artikel ini ialah kaedah rangkaian dinamik. Rajah di bawah mewakili aliran keseluruhan proses: penyelidik menggunakan bahagian tidak boleh ubah bebas tugas sebagai parameter khusus tugas dikongsi dan menambah parameter khusus tugas untuk mengekod semula ciri saluran. Pada masa yang sama, untuk meminimumkan jumlah latihan parameter pengekodan semula untuk setiap tugasan, penyelidik hanya perlu melaraskan saiz kernel dalam model dan mempelajari pemetaan linear saluran daripada tulang belakang kepada pengetahuan khusus tugasan untuk melaksanakan pengekodan semula. . Dalam pembelajaran berterusan, setiap tugasan baru boleh dilatih untuk mendapatkan model ringan ini memerlukan parameter latihan yang sangat sedikit Walaupun terdapat banyak tugas, jumlah parameter yang perlu dilatih adalah sangat kecil berbanding model yang besar. . Kecil, dan setiap model yang ringan boleh mencapai hasil yang baik

Motivasi penyelidikan

Pembelajaran berterusan memfokuskan kepada masalah pembelajaran daripada aliran data, iaitu, mempelajari tugasan baharu dalam susunan tertentu, Teruskan mengembangkan pengetahuan yang diperolehnya sambil mengelak daripada melupakan tugas-tugas terdahulu, jadi bagaimana untuk mengelakkan pelupaan bencana adalah isu utama dalam penyelidikan pembelajaran berterusan. Penyelidik mempertimbangkan tiga aspek berikut:

- Guna semula daripada belajar semula: Pengaturcaraan Semula Adversarial [1] ialah kaedah "pengekodan semula" dengan mengganggu ruang input tanpa mempelajari semula parameter rangkaian Rangkaian yang telah dilatih dan dibekukan untuk diselesaikan tugas baru. Para penyelidik meminjam idea "pengekodan semula" dan melakukan pengaturcaraan semula yang lebih ringan tetapi lebih berkuasa dalam ruang parameter model asal dan bukannya ruang input.

- Transformasi saluran boleh menyambung dua kernel berbeza: Pengarang GhostNet [2] mendapati bahawa rangkaian tradisional akan mendapat beberapa peta ciri yang serupa selepas latihan, jadi mereka mencadangkan Rangkaian baharu seni bina, GhostNet, dibangunkan: menjana lebih banyak peta ciri dengan menggunakan operasi yang agak murah (seperti perubahan linear) pada peta ciri sedia ada untuk mengurangkan memori. Diilhamkan oleh ini, kaedah ini juga menggunakan transformasi linear untuk menjana peta ciri bagi meningkatkan rangkaian, supaya ia boleh disesuaikan untuk setiap tugas baharu pada kos yang agak rendah.

- Parameter ringan boleh menukar pengedaran model: BPN [3] mengalihkan pengedaran parameter rangkaian daripada satu tugas kepada tugas yang lain dengan menambahkan bias gangguan yang bermanfaat dalam lapisan yang disambungkan sepenuhnya kepada tugas lain. Walau bagaimanapun, BPN hanya boleh mengendalikan lapisan yang bersambung sepenuhnya, dengan hanya satu pincang skalar bagi setiap neuron, dan oleh itu mempunyai keupayaan terhad untuk menukar rangkaian. Sebaliknya, penyelidik mereka bentuk mod yang lebih berkuasa untuk rangkaian neural konvolusi (CNN) (menambah parameter "pengekodan semula" pada kernel konvolusi) untuk mencapai prestasi yang lebih baik dalam setiap tugas baharu.

Penerangan kaedah

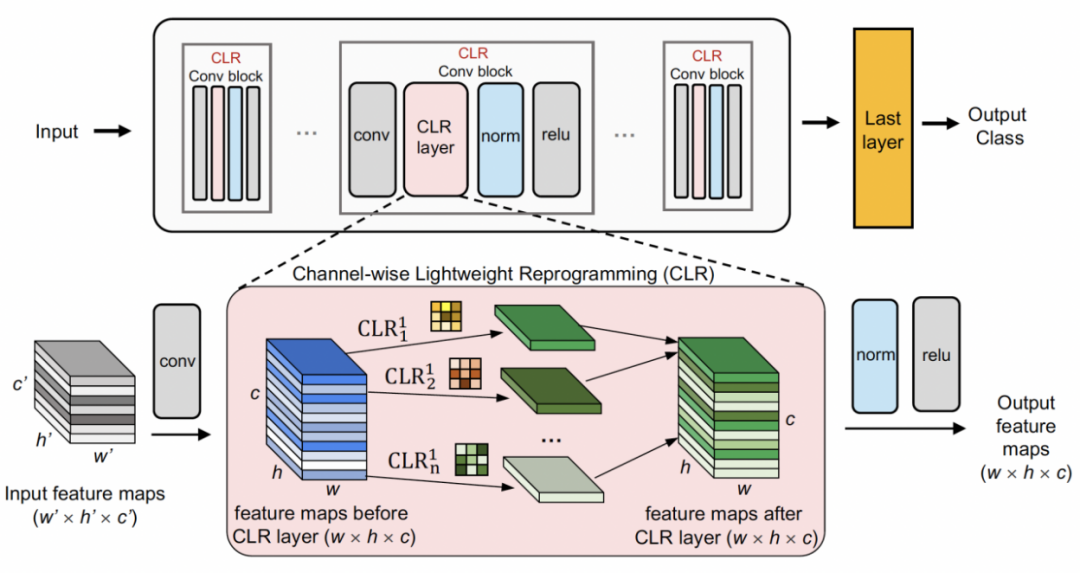

#🎜#-🎜🎜#Channel ringan gaya #Pertama gunakan tulang belakang tetap sebagai struktur perkongsian tugas, yang boleh menjadi pra-latihan untuk pembelajaran diselia pada set data yang agak pelbagai (ImageNet-1k, Pascal VOC) Model ini juga boleh model pembelajaran penyeliaan sendiri (DINO, SwAV) yang belajar mengenai tugas ejen tanpa label semantik. Berbeza daripada kaedah pembelajaran berterusan yang lain (seperti SUPSUP menggunakan struktur tetap yang dimulakan secara rawak, CCLL dan EFT menggunakan model yang dipelajari daripada tugas pertama sebagai tulang belakang), model pra-latihan yang digunakan oleh CLR boleh menyediakan pelbagai ciri visual, tetapi ini ciri visual Ciri memerlukan lapisan CLR untuk pengekodan semula pada tugasan lain. Khususnya, penyelidik menggunakan transformasi linear mengikut saluran untuk mengekod semula imej ciri yang dijana oleh kernel lilitan asal.

Penyelidik mula-mula membetulkan tulang belakang pra-latihan, dan kemudian menambah lapisan pengaturcaraan semula ringan jenis saluran selepas lapisan lilitan dalam setiap blok lilitan tetap ( lapisan CLR) ke melakukan perubahan linear seperti saluran pada peta ciri selepas kernel lilitan tetap.

Diberi gambar X, untuk setiap kernel lilitan Rangkaian dinamik: PSP, SupSup, CCLL, Confit, EFTs

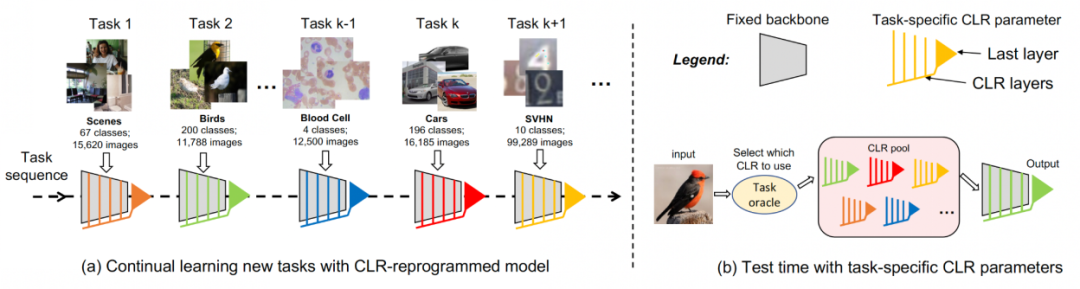

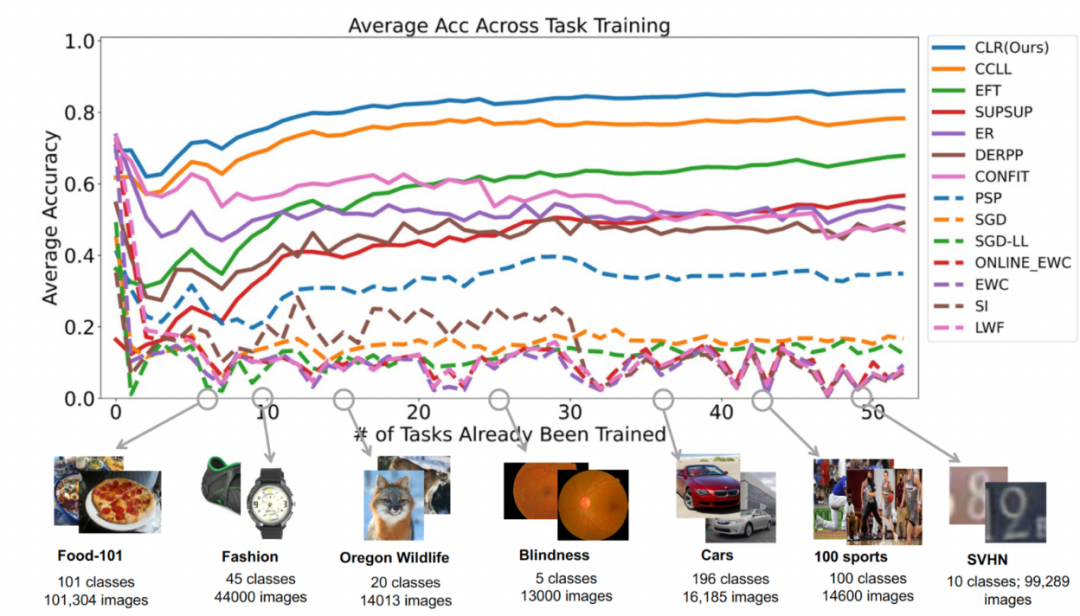

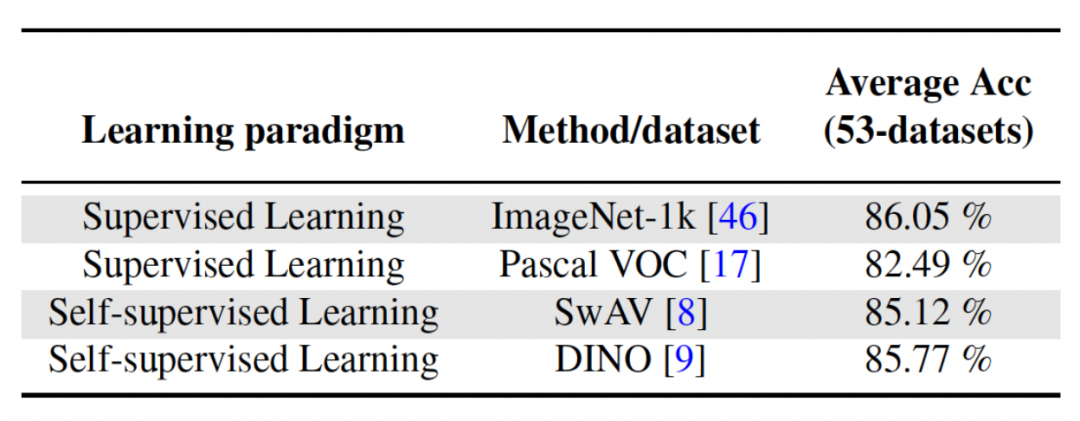

Percubaan kedua: purata pembelajaran ketepatan selepas menyelesaikan semua tugasan Rajah di bawah menunjukkan ketepatan purata semua kaedah selepas mempelajari semua tugasan. Ketepatan purata mencerminkan prestasi keseluruhan kaedah pembelajaran berterusan. Memandangkan setiap tugasan mempunyai tahap kesukaran yang berbeza, apabila tugasan baharu ditambah, ketepatan purata merentas semua tugasan mungkin meningkat atau menurun, bergantung pada sama ada tugasan tambahan itu mudah atau sukar. Pertama, mari analisa parameter dan kos pengiraan Untuk pembelajaran berterusan, walaupun sangat penting untuk mendapatkan ketepatan purata yang lebih tinggi, algoritma tambahan yang baik juga berharap untuk memaksimumkan keperluan parameter rangkaian dan kos pengiraan. "Tambah parameter tambahan untuk tugas baharu" mewakili peratusan amaun parameter tulang belakang asal. Artikel ini menggunakan kos pengiraan SGD sebagai unit, dan kos pengiraan kaedah lain dinormalisasi mengikut kos SGD. Kandungan yang ditulis: Analisis kesan rangkaian backbone yang berlainan Kaedah dalam artikel ini melatih model pra-terlatih dengan menggunakan pembelajaran yang diselia atau pembelajaran diri yang diselia pada set data yang agak pelbagai sebagai parameter invarian bebas daripada tugas. Untuk meneroka kesan kaedah pra-latihan yang berbeza, kertas kerja ini memilih empat model pra-latihan bebas tugas yang berbeza yang dilatih menggunakan set data dan tugasan yang berbeza. Untuk pembelajaran diselia, penyelidik menggunakan model pra-latihan pada ImageNet-1k dan Pascal-VOC untuk klasifikasi imej untuk pembelajaran penyeliaan kendiri, penyelidik menggunakan model pra-latihan yang diperoleh melalui dua kaedah berbeza, DINO dan SwAV. Jadual berikut menunjukkan ketepatan purata model pra-latihan menggunakan empat kaedah yang berbeza Dapat dilihat bahawa keputusan akhir mana-mana kaedah adalah sangat tinggi (Nota: Pascal-VOC adalah set data yang agak kecil, jadi ketepatannya secara relatif. rendah. titik) dan teguh kepada tulang belakang pra-terlatih yang berbeza.  , kita boleh mendapatkan peta ciri Untuk menukar secara linear setiap saluran Penyelidik memulakan CLR konvolusi kernel kepada yang sama bertukar kernel (iaitu, untuk 2D convolution kernel, hanya parameter tengah ialah 1, dan selebihnya adalah 0),

, kita boleh mendapatkan peta ciri Untuk menukar secara linear setiap saluran Penyelidik memulakan CLR konvolusi kernel kepada yang sama bertukar kernel (iaitu, untuk 2D convolution kernel, hanya parameter tengah ialah 1, dan selebihnya adalah 0),  kerana ini boleh menjadikan tulang belakang tetap asal dijana semasa permulaan latihan Ciri-ciri adalah sama seperti yang dihasilkan oleh model selepas menambah lapisan CLR. Pada masa yang sama, untuk menyimpan parameter dan mengelakkan pemasangan berlebihan, penyelidik tidak akan menambah lapisan CLR selepas kernel lilitan Lapisan CLR hanya akan bertindak selepas kernel lilitan. Untuk ResNet50 selepas CLR, parameter boleh dilatih yang meningkat hanya menyumbang 0.59% berbanding tulang belakang ResNet50 tetap.

kerana ini boleh menjadikan tulang belakang tetap asal dijana semasa permulaan latihan Ciri-ciri adalah sama seperti yang dihasilkan oleh model selepas menambah lapisan CLR. Pada masa yang sama, untuk menyimpan parameter dan mengelakkan pemasangan berlebihan, penyelidik tidak akan menambah lapisan CLR selepas kernel lilitan Lapisan CLR hanya akan bertindak selepas kernel lilitan. Untuk ResNet50 selepas CLR, parameter boleh dilatih yang meningkat hanya menyumbang 0.59% berbanding tulang belakang ResNet50 tetap.

Untuk pembelajaran berterusan, model yang menambah parameter CLR boleh dilatih dan tulang belakang yang tidak boleh dilatih boleh mempelajari setiap tugas secara bergilir-gilir. Semasa menguji, penyelidik menganggap bahawa terdapat peramal tugas yang boleh memberitahu model tugas mana yang dimiliki oleh imej ujian, dan kemudian tulang belakang tetap dan parameter CLR khusus tugasan yang sepadan boleh membuat ramalan akhir. Memandangkan CLR mempunyai ciri pengasingan parameter mutlak (parameter lapisan CLR yang sepadan dengan setiap tugas adalah berbeza, dan tulang belakang yang dikongsi tidak akan berubah), CLR tidak akan terjejas oleh bilangan tugas

Untuk pembelajaran berterusan, model yang menambah parameter CLR boleh dilatih dan tulang belakang yang tidak boleh dilatih boleh mempelajari setiap tugas secara bergilir-gilir. Semasa menguji, penyelidik menganggap bahawa terdapat peramal tugas yang boleh memberitahu model tugas mana yang dimiliki oleh imej ujian, dan kemudian tulang belakang tetap dan parameter CLR khusus tugasan yang sepadan boleh membuat ramalan akhir. Memandangkan CLR mempunyai ciri pengasingan parameter mutlak (parameter lapisan CLR yang sepadan dengan setiap tugas adalah berbeza, dan tulang belakang yang dikongsi tidak akan berubah), CLR tidak akan terjejas oleh bilangan tugas Hasil eksperimen

Hasil eksperimen Set Data: Para penyelidik menggunakan klasifikasi imej sebagai tugas utama Makmal mengumpul 53 set data klasifikasi imej, dengan kira-kira 1.8 juta imej dan 1584 kategori. 53 set data ini mengandungi 5 matlamat klasifikasi berbeza: pengecaman objek, klasifikasi gaya, klasifikasi pemandangan, pengiraan dan diagnosis perubatan.

Set Data: Para penyelidik menggunakan klasifikasi imej sebagai tugas utama Makmal mengumpul 53 set data klasifikasi imej, dengan kira-kira 1.8 juta imej dan 1584 kategori. 53 set data ini mengandungi 5 matlamat klasifikasi berbeza: pengecaman objek, klasifikasi gaya, klasifikasi pemandangan, pengiraan dan diagnosis perubatan.  Para penyelidik memilih 13 garis dasar, yang boleh dibahagikan secara kasar kepada 3 kategori

Para penyelidik memilih 13 garis dasar, yang boleh dibahagikan secara kasar kepada 3 kategori

: Semula dalam talian

Atas ialah kandungan terperinci Optimumkan kecekapan pembelajaran: pindahkan model lama kepada tugas baharu dengan 0.6% parameter tambahan. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- microsoft solitaire collection可以卸载吗

- Pengumuman rasmi Pusat Pengkomputeran Super Haimo: model besar dengan 100 bilion parameter, skala data 1 juta klip dan pengurangan 200 kali ganda dalam kos latihan

- Terkejut! Selepas 70,000 jam latihan, model OpenAI belajar merancang kayu dalam 'Minecraft'

- Kembali ke masa depan! Menggunakan diari zaman kanak-kanak untuk melatih AI, pengaturcara ini menggunakan GPT-3 untuk mencapai dialog dengan 'diri masa lalu'nya

- Adakah data sintetik akan memacu masa depan latihan AI/ML?