Rumah >Peranti teknologi >AI >ICCV 2023 mengumumkan: Kertas popular seperti ControlNet dan SAM memenangi anugerah

ICCV 2023 mengumumkan: Kertas popular seperti ControlNet dan SAM memenangi anugerah

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBke hadapan

- 2023-10-04 21:37:011384semak imbas

Persidangan Antarabangsa mengenai Penglihatan Komputer (ICCV) dibuka di Paris, Perancis minggu ini

Sebagai persidangan akademik terbaik dunia dalam bidang penglihatan komputer, ICCV diadakan setiap dua tahun.

Kepopularan ICCV sentiasa setanding dengan CVPR, menetapkan tahap tertinggi baru berulang kali

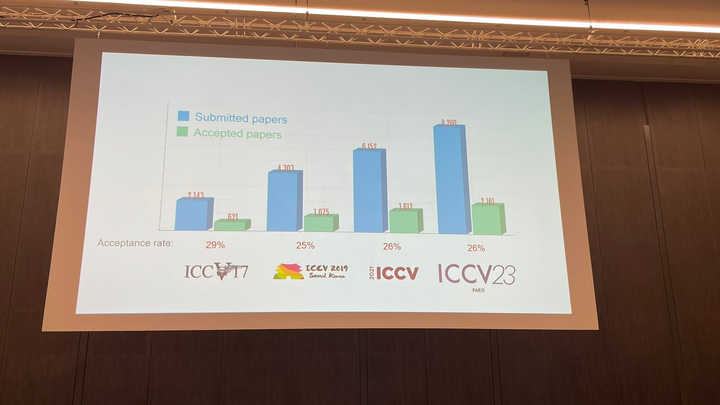

Pada majlis perasmian hari ini, ICCV secara rasmi mengumumkan data kertas tahun ini: sejumlah 8068 penyerahan telah diserahkan kepada ICCV tahun ini, di mana 2160 telah diterima kadar penerimaan ialah 26.8%, iaitu lebih tinggi sedikit daripada kadar penerimaan ICCV 2021 sebelumnya iaitu 25.9%

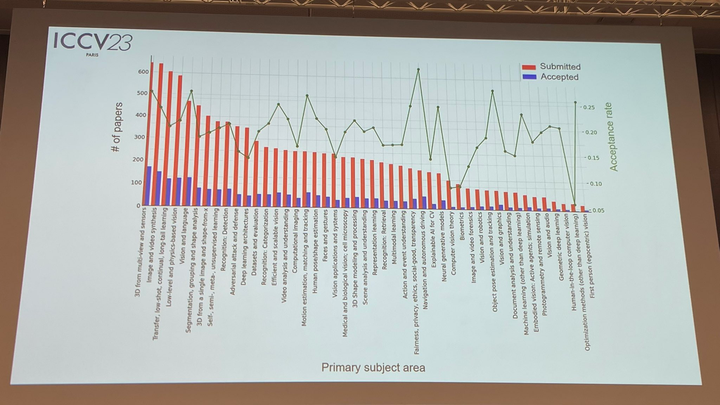

Dari segi topik kertas, pegawai itu juga mengumumkan data yang berkaitan: teknologi 3D dengan pelbagai perspektif dan sensor adalah yang paling banyak. popular

Bahagian paling penting dalam majlis perasmian hari ini sudah pasti penyampaian anugerah. Seterusnya, kami akan mengumumkan pemenang kertas terbaik, pencalonan kertas terbaik dan kertas pelajar terbaik satu demi satu

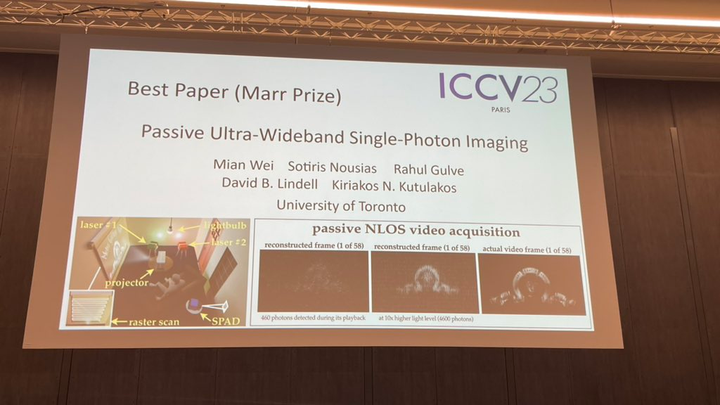

Anugerah Kertas-Marr Terbaik

Kertas terbaik tahun ini (Anugerah Marr) mempunyai dua kertas memenangi Anugerah anugerah

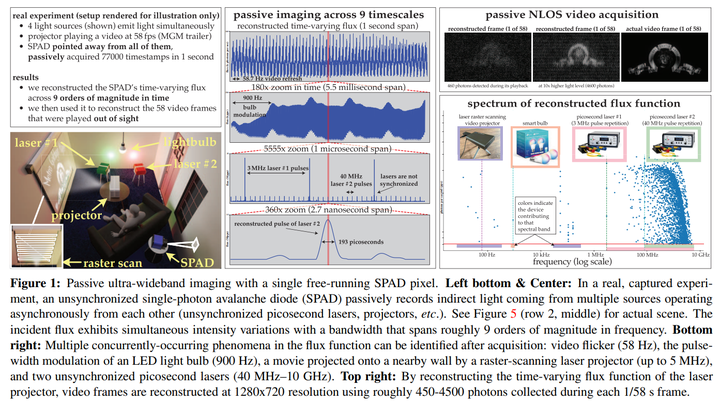

Kajian pertama dijalankan oleh penyelidik dari University of Toronto

https://arxiv.org/pdf/2302.05543.pdf

https://arxiv.org/pdf/2302.05543.pdfPenulis: Zhang Lumin, Rao Anyi

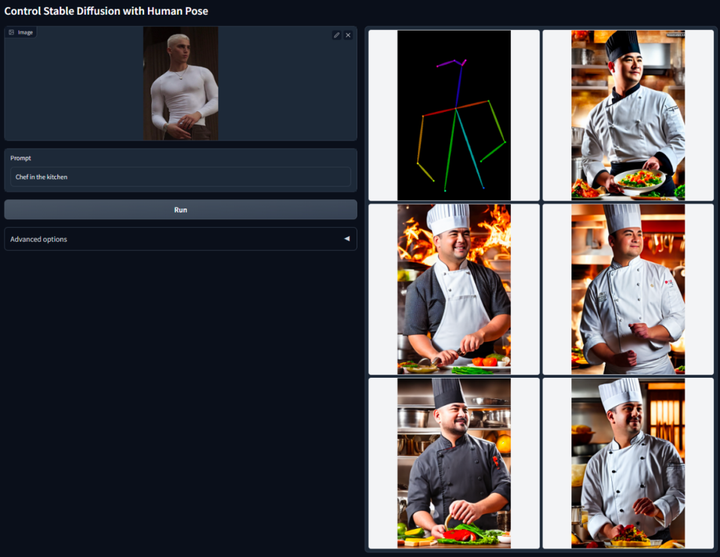

Maneesh Institusi: Universiti StanfordAbstrak: Makalah ini mencadangkan seni bina rangkaian saraf hujung ke hujung ControlNet, yang boleh mengawal model resapan (seperti Resapan Stabil) dengan menambah syarat tambahan untuk meningkatkan kesan penjanaan graf dan Ia boleh menjana sepenuhnya -mewarnakan imej daripada lukisan garisan, menjana imej dengan struktur kedalaman yang sama, dan mengoptimumkan penjanaan tangan melalui mata kunci tangan.Idea teras ControlNet adalah untuk menambah beberapa syarat tambahan pada perihalan teks untuk mengawal model resapan (seperti Resapan Stabil), dengan itu mengawal pose watak, kedalaman, struktur gambar dan maklumat lain imej yang dihasilkan dengan lebih baik.

Ditulis semula sebagai: Kami boleh memasukkan syarat tambahan dalam bentuk imej untuk membolehkan model melakukan pengesanan tepi Canny, pengesanan kedalaman, segmentasi semantik, pengesanan garis transformasi Hough, pengesanan tepi bersarang keseluruhan (HED), pengecaman postur manusia, dsb. operasi dan mengekalkan maklumat ini dalam imej yang terhasil. Menggunakan model ini, kami boleh terus menukar lukisan garisan atau grafiti kepada imej berwarna penuh dan menghasilkan imej dengan struktur kedalaman yang sama Pada masa yang sama, kami juga boleh mengoptimumkan penjanaan tangan watak melalui mata kunci tangan

Sila. rujuk laporan pengenalan terperinci di laman web ini: Pengurangan dimensi AI mencecah pelukis manusia, graf Vincentian diperkenalkan ke ControlNet, dan maklumat kedalaman dan kelebihan digunakan semula sepenuhnya

Pencalonan kertas terbaik: SAM

Pada bulan April tahun ini, Meta mengeluarkan kertas yang dipanggil "Separate Everything (SAM)'s AI model, yang boleh menjana topeng untuk objek dalam mana-mana imej atau video. Teknologi ini mengejutkan penyelidik dalam bidang penglihatan komputer, malah ada yang menggelarkannya "CV tidak wujud lagi"

Kini, kertas berprofil tinggi ini telah dicalonkan untuk kertas terbaik. . Yang pertama ialah pembahagian interaktif, yang boleh digunakan untuk membahagikan mana-mana kelas objek tetapi memerlukan manusia untuk membimbing kaedah dengan menapis topeng secara berulang. Yang kedua ialah pembahagian automatik, yang boleh digunakan untuk membahagikan kategori objek khusus yang dipratentukan (seperti kucing atau kerusi), tetapi memerlukan sejumlah besar objek beranotasi secara manual untuk latihan (seperti beribu-ribu atau bahkan berpuluh-puluh ribu contoh kucing tersegmen) . Kedua-dua kaedah ini tidak menyediakan kaedah segmentasi universal dan automatik sepenuhnya

Sila rujuk laporan tapak ini untuk butiran: CV tidak lagi wujud? Meta mengeluarkan model AI "Split Everything", CV mungkin menyambut detik GPT-3

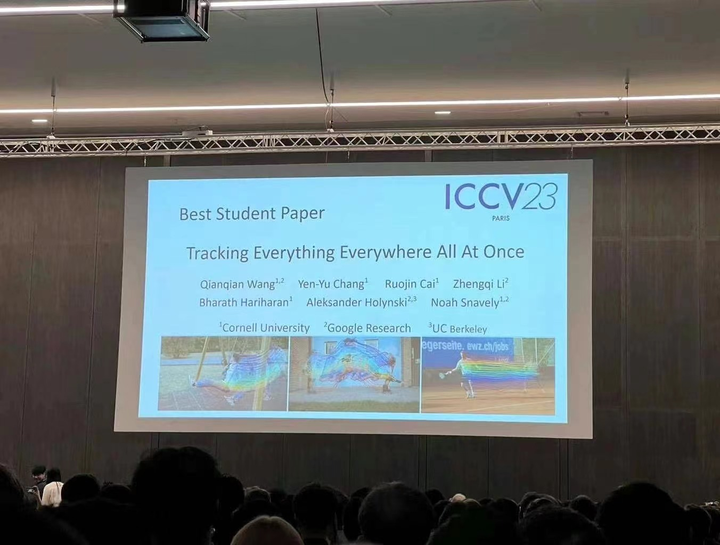

Kertas Pelajar Terbaik

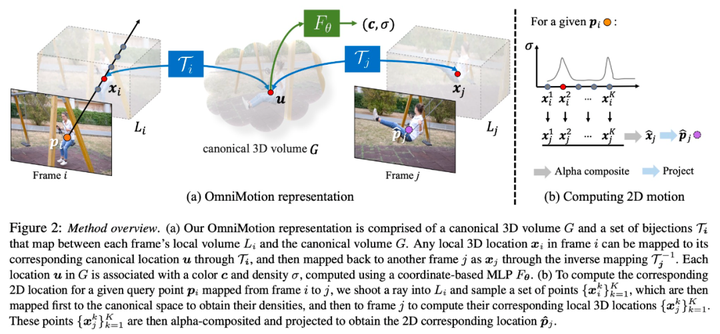

Penyelidikan telah disiapkan bersama oleh penyelidik dari Cornell University, Google Research dan UC Berkeley, dengan seorang pengarang It's Qianqian Wang, pelajar PhD dari Cornell Tech. Mereka bersama-sama mencadangkan OmniMotion, perwakilan gerakan yang lengkap dan konsisten di peringkat global, dan mencadangkan kaedah pengoptimuman masa ujian baharu untuk melaksanakan anggaran gerakan yang tepat dan lengkap bagi setiap piksel dalam video. Alamat kertas:https://arxiv.org/abs/2306.05422

Laman utama projek:https://omnimotion.github.io/

- ialah dua jenis Kaedah anggaran gerakan yang biasa digunakan: penjejakan ciri jarang dan aliran optik padat. Walau bagaimanapun, kedua-dua kaedah mempunyai beberapa kelemahan. Penjejakan ciri jarang tidak dapat memodelkan gerakan semua piksel, manakala aliran optik padat tidak dapat menangkap trajektori gerakan untuk jangka masa yang lama

-

OmniMotion ialah teknologi baharu yang dicadangkan oleh penyelidikan yang menggunakan volum kanonik kuasi-3D untuk mencirikan video. OmniMotion dapat menjejaki setiap piksel melalui bijection antara ruang tempatan dan ruang kanonik. Perwakilan ini bukan sahaja memastikan konsistensi global dan penjejakan gerakan walaupun objek tertutup, tetapi juga membolehkan pemodelan mana-mana gabungan gerakan kamera dan objek. Percubaan telah membuktikan bahawa kaedah OmniMotion adalah jauh lebih baik daripada kaedah SOTA sedia ada dalam prestasi

Untuk pengenalan terperinci, sila rujuk laporan di tapak ini: Jejaki setiap piksel pada bila-bila masa, di mana-mana, walaupun ia disekat, Algoritma video "jejaki segalanya" Di sini kami datang

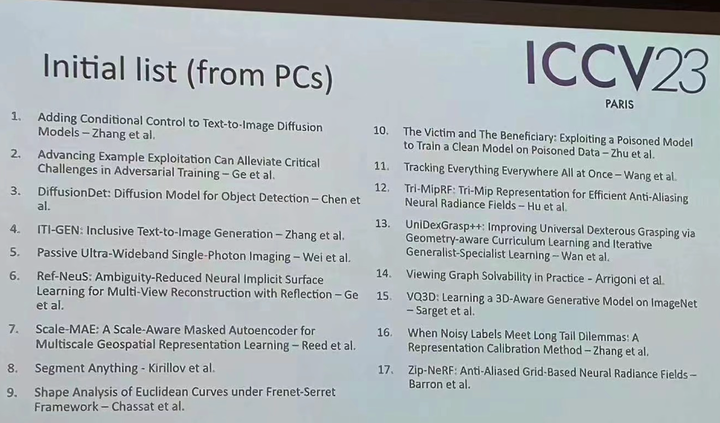

Sudah tentu, sebagai tambahan kepada kertas kerja yang memenangi anugerah ini, terdapat banyak kertas kerja cemerlang dalam ICCV tahun ini yang patut diberi perhatian anda. Akhir sekali, berikut ialah senarai awal 17 kertas yang memenangi anugerah.

Atas ialah kandungan terperinci ICCV 2023 mengumumkan: Kertas popular seperti ControlNet dan SAM memenangi anugerah. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Artikel berkaitan

Lihat lagi- Peraturan baharu untuk bulan Oktober ada di sini! Melibatkan papan tanda lalu lintas jalan baharu, industri kecerdasan buatan, dsb.

- Kementerian Sains dan Teknologi: Memberi sokongan padu kepada kecerdasan buatan sebagai industri baru yang strategik

- Ronglian Cloud telah dipilih ke dalam Peta Industri AI Generatif Global 2023

- Antara muka otak-komputer bersinar menjadi realiti! Kementerian Perindustrian dan Teknologi Maklumat akan menumpukan usaha untuk memupuknya pada masa hadapan.